Вы видите копию треда, сохраненную 27 сентября 2018 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

В этом треде культурно обсуждаем презентацию, радуемся достижениям нвидии и новым технологиям. Срёмся и кидаем друг в друга говном в специально предназначенном для этого месте Старом паскале-треде. Давайте тепло и лампово скоротаем ожидание тестов и продаж!

Горячая сводка:

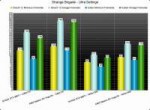

Нвидия разъяснила о производительности карт в играх без RTX:

>https://blogs.nvidia.com/blog/2018/08/22/geforce-rtx-60-fps-4k-hdr-games/?linkId=100000003301637

Если верить данной публикации, RTX2080 будет быстрее на 50-60% нынешней GTX1080, а значит, быстрее нынешней 1080Ti на 20-30%. Стандартный прогноз, который абсолютно соответствует предварительным прогнозам /hw.

>The fourth leak for today is showcasing Turing shading performance. This is a relative comparison versus Pascal. If this chart stands true, then each Turing core could be ~50% faster than Pascal core in applications such as 3DMark. This might be very fruitful information for further comparisons.

RTX - не проприетарная технология. RTX - аппаратный ускоритель рейтрейсинга, который работает и DXR и с Vulkan рейтрейсингом

https://www.youtube.com/watch?v=rQXJGSN0LEo.

https://www.youtube.com/watch?v=543YChpixTw

https://www.youtube.com/watch?v=VeqtrlLBbt4

Так же, если верить словам девелопера нвидии и ребят из про-хай-теч - RT-core работают отдельно от Cuda ядер, никак не влияя на них, тоесть, не влияют на фреймрейт.

Расклад таков:

RTX 2080Ti, 4352cc, 11gb@14GHz vram, 352bit, 260w, 10 GIGARAYS, 1000$ MSRP

RTX 2080, 2944сс, 8gb@14GHz vram, 256bit, 225w, 8 GIGARAYS, 700$ MSRP

RTX 2070, 2304cc, 8gb@14GHz vram, 256bit, 180w, 6 GIGARAYS, 500$ MSRP

спеки окончательные. Первые тесты - 14 сентября!

Ближайшие игры с поддержкой RTX и DLSS:

Metro Exodus, Battledield 5, Shadow of theTomb Raider, Assetto Corsa, Atomic Heart, PUBG, Final Fantasy XV, HITMAN 2, Ark: Surbvival Evolved, Control, Dauntless, In Death, Enlisted, The Forge Arena, Fractured Lands, Justice, JX3, Mechwarrior V, Remnant from the Ashes, Serious Sam 4, We happy Few, Resident evil 2 remake

Battlefield 5 с RTX - фреймрейт в порядке, а картинка собранная с использованием технологии RTX чертовски красива:

https://www.youtube.com/watch?v=7_VhGvUzA2k&feature=youtu.be

Enlisted выдает 90fps 4k с RTX через Vulkan

>twitter.com/Enlistnow/status/1032360932155043841

https://youtu.be/AvXra6yqEZs

Приглашаю всех пройти опросы от любознательного анона:

https://www.strawpoll.me/16308559/

https://www.strawpoll.me/16308557/

Новости и цитаты:

Особенности RTX Founders Edition

К сильным сторонам карт GeForce RTX дизайна Founders Edition компания также относит мощную подсистему питания. В случае GeForce RTX 2080 она насчитывает 13 фаз и при оверклокинге способна выдать до 280 Вт. К слову, штатное энергопотребление предварительно разогнанной новинки равно 225 ваттам.

Наличию заводского разгона карты Founders Edition в первую очередь обязаны мощной системе охлаждения. Радиатор новинок состоит из массива алюминиевых пластин и монструозной испарительной камеры, покрывающей всю поверхность печатной платы. Пара 90-мм вентиляторов, как утверждает Nvidia, издаёт в пять раз меньше шума, нежели «турбина» эталонных карт GeForce GTX 10-й серии, а рабочие температуры новинок оказываются на 10°C ниже.

Самый младший представитель семейства Nvidia Turing — GeForce RTX 2070, согласно доступным в Сети изображениям, не получил разъёма NVLink и следовательно не может использоваться в тандеме с аналогичной видеокартой. В пользу этого также свидетельствует тот факт, что на официальном сайте Nvidia поддержка моста NVLink заявлена только для видеокарт GeForce RTX 2080 и RTX 2080 Ti.

Обнародован график поступления в продажу видеокарт GeForce RTX

На днях администрация интернет-портала WCCFTech пообщалась с одним представителем крупного AIB-парнера Nvidia, пожелавшего остаться неизвестным. Среди прочей полезной информации инсайдер рассказал о сроках поступления в продажу недавно представленных адаптеров GeForce RTX.

Первой на прилавки магазинов попадет видеокарта GeForce RTX 2080. Данное событие намечено на 20 сентября. Перед этим в районе 10 сентября будет отгружена небольшая начальная партия. Источник использовал словосочетание «очень большая» для описания основной партии, так что, скорее всего, именно GeForce RTX 2080 станет самым массовым решением новой линейки в первое время после начала продаж.

GeForce RTX 2080 Ti поступит в розницу через неделю после GeForce RTX 2080, а именно 27 сентября. Количество отгруженных флагманов будет значительно меньше, чем GeForce RTX 2080. Это выглядит вполне логично, учитывая цену и позиционирование GeForce RTX 2080 Ti. Кроме того, инсайдер уточнил, что основная часть предварительных заказов на данную видеокарту не будет обрабатываться до начала октября.

GeForce RTX 2070 появится в свободной продаже не ранее первых чисел ноября. В принципе, такой прогноз полностью соответствует предыдущим утечкам. В качестве одной из причин задержек выпуска GeForce RTX 2070 источник называет прямую конкуренцию последней со старшими решениями GeForce GTX 10-й серии !, которые будут продаваться до истощения складских запасов.

новости с overclockers.ua некоторые фото так же спизженны с overclockers.ua

Предыдущий:

>>3076445 (OP)

521 Кб, 1503x1128

521 Кб, 1503x1128Я жду, а что?

Я всё что было перевёл в доллары по 58 рублей, в рублях сейчас только 200к на самые оперативные нужды

хочу наконец взять ему нормальную БУшку, или совсем без питания, или максимум с 4pin, если такие сейчас существуют

что есть годного на авито и за какую цену стоит брать

460/560 стоит рассматривать, или только 1050? а 1050ти с питанием от PCI были, или это опасно?

> С 11 по 18 сентября в Origin будет раздаваться бесплатный доступ Premium Pass для БФ1

ХАЛЯВА

он не особо играет, просто встройка в 3220 совсем говно, там даже fhd кинцо может тупить, а так будет годная пекаренка для сёрфа и лёгких квестов

Бате 55 лет

> сессионки для спиномозговых задротов

Зато на гиперпне летает

А ты дальше заноси бабки своим маркетолухам

А лучше купи бате туда зеон-ш7, за эти же деньги. Видео лагать перестанет (что не факт что произойдет с покупкой видеокарты)

>В таком случае 1050, или 1030 которая

А красный дьявол хуже? 560, например на 4гб

По старым тестам чуть хуже, но может уже новые драйвера завезли, и памяти 4гб, вроде на больше лет хватит

Факт. В браузерах уже давно аппаратное ускорение запилили. А вот какой-нибудь VP9 или H265 на процессоре играть - это идея дерьмовая.

Этот калыч не нужен и забесплатно. Карты есть, игор нет. Я жду ларку, пососина и фулаут 76. Ларка дня на 3, пососин на неделю максимум, судьба фулаута под вопросом, потом буду метро ждать

>А вот какой-нибудь VP9 или H265 на процессоре играть - это идея дерьмовая

Схуя? Не факт что аппаратное ускорение подхватится это раз. Кодеки меняют постоянно это два, и на H265 например вроде уже нет на максвеллах и младших поколениях. Завтра выкат новый кодек, и останется лысый батя хуй сосать без аппаратного ускорения. А приличный Ш7 без проблем будет декодировать 1080р-4к видео

Нормальный проходняк, и системные требования старые как раз для моего ждунского пека

>Из-за таких как ты игорь тонет

забудь, мы слишком стары для этого дерьма, я уже смирился с тем, что самые хардкорные игры такие как блядскиекостры для нас являются проходняком за 3 дня, а игр уровня морровинд и фоллаут2 больше никогда не будет, так как школьники не могут думать, им нужно готовое решение с понятным выбором

>игр уровня морровинд и фоллаут2

Скок там в своё время продали копий морровинда и фоллаута 2 по фуллпрайса, не знаешь? Ну и вообще морровинд это оказуаливание по сравнению с даггерфолом, а фоллаут 2 это петросянство и проёб духа пустоши из первой части.

>фоллаут 2 это петросянство и проёб духа пустоши из первой части

ах ты щенок, ну всё блять сейчас ты огребёшь

Да, потому что кормить уебанов, которые клепают конвеерную хуету - это уберговноедство.

А что, в этом поколении было что-то ещё помимо конвеерной хуеты? Ну есть инди-хуинди, но для игры в это не нужна топовая пека.

>Не факт что аппаратное ускорение подхватится это раз.

Факт. Оно либо есть для кодека, либо нет.

>Кодеки меняют постоянно это два

Нет, не постоянно. С момента анонса H265 до его внедрения прошло больше 4 лет. Как и со всеми стандартами. Следующий кодек, вроде, в 2021 появится. Не помню название. Ну и да - уже сейчас на FHD стриме твича 4 ядра 8 потоков 4790K пердят на 50-70%, ни о каком запасе там речи не идет.

А чем это нас конвеер не устраивает? Мы что, хипсторы? Я знаю, что я получу от конвеера, это будет 15+ часов отборной жопы ларки, прыгающей по стенкам и 30+ часов увлекательнейших покатушек на галере с перерывами на опиздюливание тысяч болванчиков копьем/посохом и луком в слоумо а также опять же жопы кассандры, прыгающей по стенкам. Потом меня ждут 2 эпичнейших симулятора бомжа на помойке в декорациях сшп и рашки, каеф.

Ну это просто говно.

Я прошу прощения за политоту, но это как проголосовать за питуна, потому что ШТАБИЛЬНАСТЬ

https://www.youtube.com/watch?v=Srb8ufOfnJ0

Ну у пыни стабильность фальшивая, а конвейерам нестабильными быть реально невыгодно, иначе не сожрут.

Один раз в гирьках4 нормально сделали, но все остальные игры это лютый статтерящий сблев. Нахуй вообще его добавляют, если от него никакого толку?

https://www.youtube.com/watch?v=o5tQp0k5Wv0

Проиграл. А графон на лоу не такое и говно на самом деле. Даче что-то сомневаюсь надо ли мне 2070. Может 2060 подождать, хех.

Походу именно с такими настройками работала демка батлы с РТХ лол.

он же показывает что рендеринг 50% от нативного разрешения уставновлен, так что АПСКЕЙЛ

37 Кб, 904x523

37 Кб, 904x523Да кому нужны суперкостыли для теней и отражений, у нас тру лучи!

А ведь лучи должны будут через DX12 работать, кроме 3,5 тайтлов с лучами на вулкане, то есть получается ты берёшь видюху за 1к ради статтерящего пиздеца.

Почему ты такой долбоёб и пиздобол? Пошёл сейчас проверил твои слова. х3440 сток, 2.5ггц, 6600GT, никакого аппаратного ускорения. Без проблем играет твич 1080р - 30-40% загрузка камня, 1080р на ютубе - 10-15% загрузка камня, и 4к на ютубе - 40-50% загрузка камня.

Я повторю - это х3440 сток. Зевончик на ивике на больших частотах этой нагрузки вовсе не заметит.

Там же асик заместо видеокарты и древний восьмипоточник

Еще один винчик с лучами грядет

да. и 4 гига не лишние.

>The tensor cores in the RTX 2000 series is actually some next-gen shit to finally break up the monotony of the video card treadmill... and folks are shitting all over it because they don't understand it.

>The problem is... nVidia's marketing and demos for it have royally sucked.

>I'm in data science, so I understand what the tensor core is capable of, and me and a lot of other folks in here are shitting ourselves at a consumer-grade neural net chip hitting the market. But, that's because we've been in the trenches of shader coding and understand what this thing can do. It opens the door to a lot of fantastic possibilities.

>But, that's the problem... us high-tech eggheads understand what's going on, but Nvidia hasn't dumbed down and shown good examples to joe avg consumer to make them understand why this stuff is truly next-gen / cutting edge, and why it costs so much.

>Tensor cores are basically render farms on a chip, neural net chips, etc.

>To understand what that means, you have to understand computer graphics pipeline.

>Traditional GPU is basically like having a colony of ants. You have a bunch of little tiny brains all working at once (they work in parallel with each other, so you can have thousands of little processors all working on tiny chunks of code at the same time) but they're dumb as rocks. All they can do is really just do what they're told, b/c they suck at logic-branching. And I think even recently they're still awful at integer math (they use floating point math to simulate integer math).

>The moment you try to tell them to make a decision about something (e.g.: have two branches in the shader code and it has to decide which branch to take), they stand around and seem like they're going "um... duh... uh... what do I... uh... " becuse what they're really doing is RUNNING ALL BRANCHES OF THE CODE and then deciding which to do afterwards.

>So, unlike a CPU, where logic-branching can save the CPU from over-processing shit, the GPU just over-processes shit anyways. So you try to solve this in one of two ways...

>1) you have the CPU work over-time by trying to do this logic / decision-making first and then telling the GPU's which shader chunks to run (when the CPU is already working hard on game AI's, physics and other stuff)

>or

>2) you just have generic shaders and let the dumb ants do all the work even if it won't be used in the end-result. E.g.: a tiny processor grinds through some vertex or pixel shader code just to find out at the end that the alpha on the pixel makes it completely transparent... which means it wasted its time running those calculations.

>They've tried to fix this problem by using a balancing act between the CPU(s) and GPU(s), by making the CPU pre-calc generic globals variables (e.g.: wind speed), pass it to the GPUs, GPUs crank out vertexes, then pass back to CPU that checks to see if things are showing on z-axis (to see if something's blocking another, and if so, no need to process pixels for it... so cull it from the frame), then pass to GPU to process each pixel, then send it back to CPU for final frame build, then back to GPU for whole-frame post-processing effects, then finally serve it up as a frame. Lots of back-n-forth.

>Tensor Core is basically like having a bunch of smart ants... like having a bunch of tiny CPUs instead of GPUs... they're good at logic-branching and making decisions ... and integer math. They're real neural networks, not faux ones like previous GPUs.

>While your big-ass 2.8GHz multi-core CPU's are King-Kong'ing away on stuff, the tensor cores act like a shit-ton of little tiny 40MHz (guessing here) little ants all hammering away on tiny code snippets in parallel. And you have shit-tons of these guys. And they're great at making decisions.

>So, you can feed them shader code that would require logic branching... and they will actually be MORE EFFICIENT, because they can finally make decisions and follow the branch that's needed instead of processing it all. And that also means you can tell it to do some tests in the middle of the shader to go "yeah, this pixel is too transparent to keep going, so just end processing here and move on" (pixel culling was often an expensive operation in traditional GPU's, and thus it was better to just let it keep processing and then let pixel culling happen in the pipeline afterwards... which sucks ass).

>Since the "little ants" are really good at logic-branching and integer math, they can do real-time, life-like lighting physics now instead of all the hack tricks we've been doing in the industry up to this point. They're also ideal for AI / machine learning work. Instead of your CPU trying to do AI in series with threading, you could have tons of tiny AI operations running on the tensor core, so you can have much more robust AIs.

>This is some next-gen shit finally hitting the graphics card industry... it's able to real-time render frames that used to take a server farm an hour to do.

>The price is high right now, because it's truly next-gen shit, and every next step in a product development goes through the "Early Adoption" phase of marketing... where it's high-priced, low-impact (not much going on with it right now).

>But, in a couple years we're going to see more games and software leveraging this stuff... and if the OS world keeps chugging along the way it's going (where it's trying to push more AI into OS) then eventually these tensor core chips will be useful for more then just fancy gaming stuff.

>I just wish nVidia's marketing on this stuff was better then it's been. Because all joe avg consumer is seeing is "gee, these cards are like 2x the price, and I don't see anything really special about them". But, there really is something special about them. They're not just some over-clocked or slightly tweaked upgrade being sold as a next-gen card. They're truly next-gen.

>The tensor cores in the RTX 2000 series is actually some next-gen shit to finally break up the monotony of the video card treadmill... and folks are shitting all over it because they don't understand it.

>The problem is... nVidia's marketing and demos for it have royally sucked.

>I'm in data science, so I understand what the tensor core is capable of, and me and a lot of other folks in here are shitting ourselves at a consumer-grade neural net chip hitting the market. But, that's because we've been in the trenches of shader coding and understand what this thing can do. It opens the door to a lot of fantastic possibilities.

>But, that's the problem... us high-tech eggheads understand what's going on, but Nvidia hasn't dumbed down and shown good examples to joe avg consumer to make them understand why this stuff is truly next-gen / cutting edge, and why it costs so much.

>Tensor cores are basically render farms on a chip, neural net chips, etc.

>To understand what that means, you have to understand computer graphics pipeline.

>Traditional GPU is basically like having a colony of ants. You have a bunch of little tiny brains all working at once (they work in parallel with each other, so you can have thousands of little processors all working on tiny chunks of code at the same time) but they're dumb as rocks. All they can do is really just do what they're told, b/c they suck at logic-branching. And I think even recently they're still awful at integer math (they use floating point math to simulate integer math).

>The moment you try to tell them to make a decision about something (e.g.: have two branches in the shader code and it has to decide which branch to take), they stand around and seem like they're going "um... duh... uh... what do I... uh... " becuse what they're really doing is RUNNING ALL BRANCHES OF THE CODE and then deciding which to do afterwards.

>So, unlike a CPU, where logic-branching can save the CPU from over-processing shit, the GPU just over-processes shit anyways. So you try to solve this in one of two ways...

>1) you have the CPU work over-time by trying to do this logic / decision-making first and then telling the GPU's which shader chunks to run (when the CPU is already working hard on game AI's, physics and other stuff)

>or

>2) you just have generic shaders and let the dumb ants do all the work even if it won't be used in the end-result. E.g.: a tiny processor grinds through some vertex or pixel shader code just to find out at the end that the alpha on the pixel makes it completely transparent... which means it wasted its time running those calculations.

>They've tried to fix this problem by using a balancing act between the CPU(s) and GPU(s), by making the CPU pre-calc generic globals variables (e.g.: wind speed), pass it to the GPUs, GPUs crank out vertexes, then pass back to CPU that checks to see if things are showing on z-axis (to see if something's blocking another, and if so, no need to process pixels for it... so cull it from the frame), then pass to GPU to process each pixel, then send it back to CPU for final frame build, then back to GPU for whole-frame post-processing effects, then finally serve it up as a frame. Lots of back-n-forth.

>Tensor Core is basically like having a bunch of smart ants... like having a bunch of tiny CPUs instead of GPUs... they're good at logic-branching and making decisions ... and integer math. They're real neural networks, not faux ones like previous GPUs.

>While your big-ass 2.8GHz multi-core CPU's are King-Kong'ing away on stuff, the tensor cores act like a shit-ton of little tiny 40MHz (guessing here) little ants all hammering away on tiny code snippets in parallel. And you have shit-tons of these guys. And they're great at making decisions.

>So, you can feed them shader code that would require logic branching... and they will actually be MORE EFFICIENT, because they can finally make decisions and follow the branch that's needed instead of processing it all. And that also means you can tell it to do some tests in the middle of the shader to go "yeah, this pixel is too transparent to keep going, so just end processing here and move on" (pixel culling was often an expensive operation in traditional GPU's, and thus it was better to just let it keep processing and then let pixel culling happen in the pipeline afterwards... which sucks ass).

>Since the "little ants" are really good at logic-branching and integer math, they can do real-time, life-like lighting physics now instead of all the hack tricks we've been doing in the industry up to this point. They're also ideal for AI / machine learning work. Instead of your CPU trying to do AI in series with threading, you could have tons of tiny AI operations running on the tensor core, so you can have much more robust AIs.

>This is some next-gen shit finally hitting the graphics card industry... it's able to real-time render frames that used to take a server farm an hour to do.

>The price is high right now, because it's truly next-gen shit, and every next step in a product development goes through the "Early Adoption" phase of marketing... where it's high-priced, low-impact (not much going on with it right now).

>But, in a couple years we're going to see more games and software leveraging this stuff... and if the OS world keeps chugging along the way it's going (where it's trying to push more AI into OS) then eventually these tensor core chips will be useful for more then just fancy gaming stuff.

>I just wish nVidia's marketing on this stuff was better then it's been. Because all joe avg consumer is seeing is "gee, these cards are like 2x the price, and I don't see anything really special about them". But, there really is something special about them. They're not just some over-clocked or slightly tweaked upgrade being sold as a next-gen card. They're truly next-gen.

два чаю этому

На вторичке

>ТЕКСТ НА АНГЛЕЙСКАМ ЗНАЧЕТ ТАМ ЧТО-ТА УМНАЕ

Ясно.

>лучики-хуючики в актуальном (2160р) разрешении на этом поКАЛении можно забыть в нахуй, ибо даже в 1080р стабильные 60 кадров не держат, Ти ещё может дотащат дровами до порога, а вот с хх70/хх80 гарантированно в пролёте

Ты это по альфадемкам решил? Так там нет почти оптимизации и разрабы получили только за 2 недели железо, в той же батле даже аппаратное ускорение лучей не работало асинхронно с растеризацией. Ну и конечно 70-80 определенно в пролёте, раз даже в прошлом поколении 1080ti не смогла вытащить стабильные 60 фпс на максималках в 4К в большинстве тайтлов, то и в этом они вряд-ли выдадут.

914 Кб, webm,

914 Кб, webm,640x364, 0:08

>ТЕКСТ НА АНГЛЕЙСКАМ ЗНАЧЕТ ТАМ ЧТО-ТА УМНАЕ

Нет блядь, надо было для тебя перевести это на русский в свободном изложении и обязательно сказать что это Я так считаю и это моё личное мнение.

>Ты это по альфадемкам решил?

Да.

Да, паук вабще печальное зрелище. Поглядел кадры из игры - мёртвый город, пастгенграфин, и в целом напоминает первых смотри-собак почему то.

>Поглядел кадры из игры

А тут надо не на пожатый ютубчик смотреть, а на игру на плойке, там всё заебись.

Наоборот, заебись, эта хуйня красиво выглядит в динамике, ты в какой попенворлд игре вообще видел интерьер в окнах, пускай и такой костыльный?

600 Кб, 936x825

600 Кб, 936x825Ща ещё следующим патчем ещё МОУШИН БЛЮРА подвезут и вообще станет всё ахуенчик.

Да я то может и посмотрю, когда это говно будет стоить рублей 500 за авито. Платить деньги за этот пастген я ебал. Провал года - смотрисобаки 1 с перемещением по вертикали, более мёртвым городом, и обрезаным соснольным графином. Мда

и че? че с ними не так? их и не видно почти на видосе. комната кривая, видно что автоматом их штамповали, обычный глюк.

>симметричный ответ от амд

Лол. АМД сделает очередную парашу на CGN и ее сразу сгребут майнеры, потому как CGN весьма ебовая RISC-числодробилка.

Да-да, и раньше жи отражения были!

ок, 40 фпс

Что-то изменилось с тех пор? Нет? Я так и думал.

Ты осознаешь, что содержимое комнаты к рейтрейсингу никакого отношения не имеет, верно?

В смысле, что с ним ничего бы не изменилось, даже будь он на сосноли.

Я хоть и не любитель комиксопараши и человека паука в частности, но насчет провала года можешь нахуй сходить. Геймплей в игре видно что сделан очень качественно, с простенькой, но очень вариативной и отзывчивой боевкой, с отзывчивым и динамичным перемещением. Я собственно после Ratchet and Clank понял почему именно им доверили эту игру делать, потому что insomniac в этом жанре как рыба в воде

Хорошо, ты прав. В любом случае - баз аппаратного ускорения в 2018 будет сидеть только умственно неполноценный.

Прости.

да нахуй оно не надо. Кодеки меняют постоянно - хуйсвелы и кеплеры брали в 2014 году - они тогда поддерживали все актуальные кодеки. И хули? 4 года прошло, а для аппаратного ускорения уже паскаль подавай.

С другой стороны декодирование на процессоре, тем более относительно мощном Ш7, не приносит никакого абсолютно дискомфорта.

Эх, вот бы сейчас лысому бате докупить дискретку к ш3, вместо нормального прцоессора!

>С другой стороны декодирование на процессоре, тем более относительно мощном Ш7, не приносит никакого абсолютно дискомфорта.

Забавно то, что тот же 4790К вполне себе декодирует видео и с ютубов, и с твичей.

К чему зивон - не ясно.

Ну и да, про кодеки я тебе уже сказал.

>вместо нормального прцоессора!

батя не лысый, это 1, а 2, нахуй ему лучше, если он почти не играет, а смотрит кинцо и может пройти пару старых квестов, но 90% это кинцо, а ш3 просто тупо лагает

опять же, старая мать, старый проц, а на что меня, на зивон? Пирдолинг ради пирдолинга?

Проще найти видюху, а через года 3-4 отдать свою ПК ему

>85 градусов в стоке

Подкрутишь профиль, будет меньше.

У меня тишка турбина до такого состояния не греется.

хуй знает, у меня там много ачивок уже, платин штук 20 собрал

Вот 1080 кто на сколько гнал?

Ебаный пердолинг не нужен, для аутистов поехавших.

Да какие 100 ватт, когда 80-90ваттный процессор будет загружен на 10-30%? Ну что ты несёшь

>>8581

>батя не лысый, это 1, а 2, нахуй ему лучше, если он почти не играет, а смотрит кинцо и может пройти пару старых квестов, но 90% это кинцо, а ш3 просто тупо лагает

>опять же, старая мать, старый проц, а на что меня, на зивон? Пирдолинг ради пирдолинга?

>Проще найти видюху, а через года 3-4 отдать свою ПК ему

Ебать ты дебил. Просто ахуеть. Ну докупай видеокарту, хули. Просто конченый дегенерат, слов нет

Да ну нет, покупка видеокарты бате, который НЕ ИГРАЕТ - вот это решение проблемы. Эх, вот бы сейчас в 2018 году на ш3 сендике сидеть

Ему похуй - мамка платит за свет!

Ватт 20 в лучшем случае. Ты сейчас допиздишься - я пойду замерять ток при просмотре видео на зеоне - и ты снова соснёшь

сам посиди на ш3, потом попизди, изверг блять. На батю лысого похуй, на ш3 сидеть заставляешь, ахуеть такое чадо взрастить

https://www.youtube.com/watch?v=7MexPB9SZzI

https://www.youtube.com/watch?v=i234FNCiZCs

что там тебе не хватает?

Мда, это провал года. Вы только посмотрите на этот графин, на этот геймплей. Просто полный провал

Графон норм, в каких играх для тебя топовый графон, наверно таких вообще нет.

Геймплей заебись.

361 Кб, 1922x1080

361 Кб, 1922x1080Просто посмотрите на это, лул, где тут тени, почему земля плоская, что с машиной? просто ужасно

ПИДЕР-МАН

Да, заебись, нелепый стелс, когда ты бежишь сталкивая стулья на своём пути а тебя никто не слышит, поиск и перепрограммирование электрощитков, битвы с болванчиками, унылое покачивание по городу на паутине. Вот ПРОСТО пиздец. А я ведь эту игру ждал

>в каких играх для тебя топовый графон

Самый топ для меня BF1 хотя я в неё и не играю и Hunter Call Of the wild. В большинстве тайтлов графин просто приличный, а вот тут - просто омерзительный, что-то уровня хбокс360

> В большинстве тайтлов графин просто приличный, а вот тут - просто омерзительный, что-то уровня хбокс360

Ты это по ютубчику определил? Покажи хоть одну игру с хбокса с такой же графикой и посмотри как выглядят упомянутые тобой BF1 и хантер в ютубе с хуевым ютубобитрейтом. Графоний норм, детализация для опен-ворлда, который к тому же работает на консоли с хуевым процем, топчик, то что там нет каких-то теней это хуйня, чем-то приходится жертвовать. Зато в спуди пиздатая анимация и катсцены с детализированными героями, а в хантере вообще людей нет, сделать огромный лес гораздо проще чем правдоподобных людей с нормальной анимацией.

Нормального фреймтайма, даже твои видосы лагают, но может быть ты медленно соображаешь и поэтому не замечаешь статтеры, но далеко не все такие как ты.

Да блять, не об играх речь. Это говно даже в операционке и в браузере лагает, не справляется с проигрыванием видео. Причём тут игры?

да там нихуя нет, полигонов мало, тени отрисовываются в метре, освещение просто ублюдское. Неважно где смотреть в данном случае, на ютубе или на телевизоре с плойки - тени на плойке не появятся

Это еще и стриминг

Пруфай свой 16к

16k\HDR64\480hz само собой

>Бате 55 лет

А чего он сам не купит ? Не так уж и стар. Подойдет к тебе и скажет: Сын у меня оболтус, 1050 и ту помочь купить не может, пол года ебусь не встройке, а он так до сих пор даже подсказать не может.

Тебе так пичот оттого, что 900р это твоя основная машина, а не ноутбук 2011 года? ))

оно тебе все равно сильно не даст разогнать, там лимиты ущербные и я честно говоря не ебу как заставить свою 1070 работать на максимальном 1.093 вольтаже, вроде надо как то температуру держать ниже 60, а это надо вентиляторы на максимум крутить что не очень комфортно. А так 2100-2150 в бусте если очень повезет, но какой смысл если и так почти каждая карта бустится до 2 кеков? Память - лотерея.

210 Кб, 2283x1665

210 Кб, 2283x1665>900р

Шутишь? Я о таком разрешении только в этом треде узнал.

Нищие всегда меня развлекали своей находчивостью на самом деле. Сейчас вот ты развлекаешь.

хороший гой

Да нет же, знаю про квадраты, про недоразрешения типа 1366х768, но о таком говноразрешении для нищих впервые тут узнал.

Думал, 1080р нынче минимум, а оно вон как оказывается. Впрочем, сегодня уже даже на телефонах больше, так что...

33 Кб, 429x459

33 Кб, 429x459>September 14th — Turing architecture

>September 17th — GeForce RTX 2080 reviews

>September 19th — GeForce RTX 2080 Ti reviews

https://videocardz.com/newz/nvidia-geforce-rtx-2080-reviews-go-live-on-september-17th

>DICE to Dial Back Ray-tracing Eye-candy in Battlefield V to Favor Performance

https://www.techpowerup.com/247365/dice-to-dial-back-ray-tracing-eye-candy-in-battlefield-v-to-favor-performance

2,6 Мб, 4080x1720

2,6 Мб, 4080x1720Да ты прав, но может быть в следующей жизни мне повезет и у меня будет фуллхд монитор.

695 Кб, 1600x900

695 Кб, 1600x900Зачем мечтать, когда вместо этого можно насладиться классикой в классическом разрешении.

Ну, можно конечно, но только если игра не поддерживает разрешения выше.

Я вроде даже в первый рим играл на большем разрешении, точно не вспомню уже.

В натив 4К все выглядит охуенно. Не все идет, правда.

236 Кб, 480x503

236 Кб, 480x503 508 Кб, 1600x900

508 Кб, 1600x900Я так и не могу понять отчего ты горишь с разрешения ноутбука 2011 года. У тебя личная обида какая-то?

До выхода новых соснолей графон не изменится, потому вам и пухают говнолучи вместо 4к 120 фпс.

Ты можешь не включать лучи и у тебя будет больше фпс, чем было бы на паскале.

![The.Walking.Dead.S08E02.WEB-DL.720p.LostFilm.mkvsnapshot28.[...].png](/hw/big/thumb/3078389/15361471163720s.jpg) 1 Мб, 1280x720

1 Мб, 1280x720заткнись

Нет, потешаюсь над нищим с 900p.

Где хуйня-то? Хуйня - это стримить 900p на ноутбук, если уж на то пошло.

Да 1066 в фулл хд тащит все на ультра-высоких. Да и на самом деле качество графония не растет нихуя. До новых консолей уж точно ничего не будет толкового.

Вон выше тест на встройке 2400г. Даже на лоу там вполне приятный графон.

ты не здоров, если тебя так волнует кто на чем играет. а то что потешаешься выдает в тебе синдром показного потребления. ты просто днина зомбированная.

Ты хочешь чтобы я свой 4К телек и 30 килограммовый гроб на работу таскал, лол? Тебя так задело, что кто-то ПОСМЕЛ постримить на ноут?

>Впрочем, сегодня уже даже на телефонах больше, так что...

А хорошо тебя маркетологи промыли.

Скоро побежишь за сгибаемым телефоно, а не то...

Нищий, плиз.

>>8743

Нет, меня это не задело, меня это развеселило. Ты что, читать не умеешь? Если окажется, что не умеешь, это меня заденет.

>>8742

Это типа я принес тут скриншоты с тем, как я охуенно "играю" в стрим на ноутбуке с i3? ВРоде не так всё было.

>>8745

Нет, сгибаемый мне не нужен, жду 1440р или больше с большим аккумулятором. Пока приходится таскаться с китаеговном за 15к и заряжать его по три раза на дню, лол

>невклид

Что еще за "неликвид"? Ты что, в технику вкладываешься, или не знаешь значение слова?

Нахуя тебе на телефоне разрешение больше 400ppi?

Ты случайно не болен, чел? Сколько твой 4к моник дюймов?

Мимо

>Это типа я принес тут скриншоты с тем, как я охуенно "играю" в стрим на ноутбуке с i3? ВРоде не так всё было.

если я принесу свои скрины в 640х480 ты снова подорвешься?

160 Кб, 1209x605

160 Кб, 1209x605 18 Кб, 200x200

18 Кб, 200x200 731 Кб, 1600x900

731 Кб, 1600x900>Это типа я принес тут скриншоты с тем, как я охуенно "играю" в стрим на ноутбуке с i3? ВРоде не так всё было.

А так вот с чего ты подгорел, лол. Так это ЮМОР был, богатей. Не нужно на сосаке все всерьез воспринимать. Ты же понимаешь, что для того чтобы играть в 4к стримы на 900р ноуте, мне нужно откуда-то это стримить. Я думал это была очевидная шутка.

Я? Подгорел? Зачем ты опять фантазируешь?

Я просто пошел посмотреть, где начал над тобой смеяться, и нашел это в итоге, о чем и написал.

>Причём тут разрешающая способность печати принтеров и матрица мониторов?

За умного пытаешься сойти? Не получится, прости. Можешь еще во всех моих постах пробежаться и заменить "е" на "ё", ее я тоже при печати не использую.

>Many resources, including the Android developer guide, use the terms DPI and PPI interchangeably.

>>8775

>И чем тебя не устраивает сокращение от pixels per inch?

Тем, что оно ничего не говорит о разрешении, которые ты собрался со мной обсуждать. А я не собираюсь обсуждать курс валют с человеком, который меряет свои доходы бочками с салом. Capiche?

Ну если моник больше 24', то нужно уже 2к. Правда 4к в мониках нахуй не нужен, если ты не дизайнер. Под 32' 2к вполне за глаза.

У меня лично 3440x1440 на 34', но он у меня растянутый, а так в высоту как 27'.

Хотя судя по высерам этого 4к-долбоёба, он обычная потреблядь, раз путает понятия "пиксель на дюйм" и "точек на дюйм".

большее разрешение при потреблении видеоконтента обычно еще и гарантирует больший битрейт

а не позорные 16 мегабит которые даже на фхд экранах выглядят как говно

>пикрил

что тебе не так, тот анон хоть и употребил слово неверно, но разрешающая способность и плотность пикселей прямолинейно связаны, так как все смартфоны имеют диагонали в диапазоне от 5 до 6 дюймов

У\Давай гипотетически: разрешение моего смартфона 600 DPI. Жду от тебя разрешение моего телефона.

А если 400? Ты же диагональ не знаешь, дебил, поэтому и ответа знать не можешь

104 Кб, 1750x507

104 Кб, 1750x507>Хотя судя по высерам этого 4к-долбоёба, он обычная потреблядь, раз путает понятия "пиксель на дюйм" и "точек на дюйм".

Но ведь обоссался в итоге ты:

https://docs.microsoft.com/en-us/windows/desktop/win7devguide/high-dpi

https://docs.microsoft.com/en-us/windows/desktop/hidpi/high-dpi-desktop-application-development-on-windows

https://en.wikipedia.org/wiki/Pixel_density

Красава. Мое почтение.

ты наебал меня, таких дисплеев нет

у топовых сосунгов 570

400 - это fhd на 6 дюймах например

300- hd у пятидюймовых

потому что зная только значение число из последовательности "диагональ, разрешение экрана, dpi\ppi" ты не можешь узнать остальные

а значит он не может (зная разрешение 1440p) знать ppi\dpi телефона

То есть простыми словами, Хуанг вернул взад то что у АМД было уже как годы ACE, а у НВ в поколении карт с 8800 до 580 HW Scheduler и все ради того чтобы научить гпу в логические и целочисленные операции как цпу?

Именно это я и сделал (написал гипотетически, причем).

Вот так и получается, что зная DPI экрана моего смартфона ты не можешь знать ни разрешение, ни диагональ.

Понимаешь, к чему претензии?

>видел интерьер в окнах, пускай и такой костыльный

Потерянные технологии 2008го года

http://www.humus.name/index.php?page=3D&ID=80

>только значение число из последовательности

только одно значение из последовательности

запозадло починил

ты говоришь, что хочешь 1440, анон спрашивает зачем тебе больше 400ppi(а меньше быть и не может, потому что таких решений нет)

ты вместо ответа начал загонять какую-то дичь

осознаешь?

Если человек считает, что фхд для 6 дюймов тоже слишком много, то мне нечего с ним обсуждать.

Еще раз, для даунов: PPI и DPI - это не разрешения. Full stop.

Отвечаю на твой и его вопрос постом анона:

>>8789

>большее разрешение при потреблении видеоконтента обычно еще и гарантирует больший битрейт

>а не позорные 16 мегабит которые даже на фхд экранах выглядят как говно

охуенный скрин, если растянуть на весь экран, то будто вернулся в середину 90ых, надо попробовать на 320х240 запустить, сирисли, выглядит топ

Гугл тоже использует DPI. Такова реальность.

DPI и PPI - взаимозаменяемы. О чем я написал в первом же ответе доебавшемуся.

Ты вводишь в гугл "high dpi monitor" или просто "hiDPI" и видишь тонны мануалов от всяких арчей, бубунт, шинд и андроидов.

Но я не спорю, лол. Зачем мне спорить с долбоёбом, который не понимает разницу между пикселями и точками?

Ну а на dpi майки перешли правильно, так-то все технологии плавненько перекатываются на технологии квантовых точек, а раз принято считать, что 1dpi = 1ppi, то похуй. Правда, появляются такие долбоёбы, которые прочитать-прочитали, а понять не поняли.

У этого долбоёба ещё битрейт связан с разрешением. Это просто пиздец, я даже отвечать ему не хочу больше.

400 Кб, 1154x1542

400 Кб, 1154x1542А ты еще тупее, чем я думал! Не знать, что ютуб пережимает видео и не даст тебе залить, например, 100 мбит в фхд?

Да, не утруждайся больше отвечать, если ничего не понимаешь в вопросе. Кстати, про разрешение и битрейт писал не я.

Просвещайся: http://lmgtfy.com/?q=youtube+bitrate

И причём тут ютуб и битрейт в фуллхд? Или ты хочешь сказать, что ты купил 4к моник что бы смотреть видео на ютубе с БОЛЬШИМ битрейтом?

Сначала у тебя на очереди майкрософт, арчлинукс и гугл за DPI.

Как с ними разберешься, тогда можешь переходить к адептам "2К"

>Или ты хочешь сказать, что ты купил 4к моник что бы смотреть видео на ютубе с БОЛЬШИМ битрейтом?

Нет, мы же говорим о телефонах.

накатил рут

правишь build.prop

???

Профит

хоть 8к смотри с телефона

Вообще высокие разрешения переоценены для потребления кинца(здравствуй 24фпс в 2018) и игр и больше нужны для статичных объектов

>>???

Все приложения крашатся при запуске и единственное, что ты можешь нажать - это "ок" на очередном сообщении о том, что приложение завершено. Классный гайд.

>высокие разрешения переоценены для потребления кинца(здравствуй 24фпс

Разрешение не связано с фпсом...

Ладно, ты прав, нам пора заканчивать, твое непонимание темы разговора начинает меня триггерить.

но графон то ккд в тыщу раз лучше все равно, даже с таким разрешением это отлично видно

Что ты кидаешь мне, долбоёб? Ты хочешь сказать, что к 1080p может быть максимум 2 метра битрейта в секунду и всё, не битом меньше\больше?

битрейт какой хочешь можешь ставить. просто ютуб подогнал его под норм качество с данными разрешениями и все.

>подогнал его под норм качество с данными разрешениями

Об этом я и говорю, дебилы. Ютуб решает, какой битрейт ты получишь. И зависит он от разрешения.

а ютуб тут причем?

ты реально контуженный

>Разрешение не связано с фпсом

ты откуда это выстрал?

Или ты не согласен что в кино и сериалах 24фпс?

И битрей нихую тебя не спасет для потребления подобного контента, качественный скачек будет только на высокогерцовых дисплеях при наличие контента для них.

у ютуба на сервере валяются автоматически пожатые им под каждое разрешение видеофайлы полученные из мастера

ты получаешь тот который соответствует твоему

Хочешь я принесу тебе 1080p видос у которого будет меньше 500кбит\с битрейт? Только после этого ты навсегда съебёшь с этой борды.

Все просто: я навсегда покину этот тред, как только ты мне принесешь видео на ютубе, которое я скачаю и:

1) битрейт у FHD будет таким же, как и у 1440Р или 4К

2) битрейт у FHD будет больше, чем у 1440P или 4К

Don't let the door hit you on your way out, овощ.

63 Кб, 598x550

63 Кб, 598x550Этого леса больше нет.

богоподобное освещение.

ладно ладно, дрочи дальше на консьюмерский 1440 60герцовый телефончик в мечтах о еба качестве ютубороликов с ДОСТАТОЧНЫМ битрейтом

я надеюсь у тебя хотя бы такой телефон

https://www.razer.com/mobile/razer-phone

иначе что-то не клеится

![The.Walking.Dead.S08E03.WEB-DL.720p.LostFilm.mkvsnapshot10.[...].png](/hw/big/thumb/3078389/15361522434390s.jpg) 1,9 Мб, 1280x720

1,9 Мб, 1280x720Нахуя мне твой ютуб, псина? Твой первый пост, где ты высрал что-то про битрейт: при потребления видеоконтента у фуллхд битрейт 16 мбит\с

После этого пошли высеры про зависимость разрешения и битрейта. Ты либо долбоёб и когда понял, что обосрался, то начал маняврировать, либо у тебя настолько говно в голове, что ты даже сформулировать мысль не можешь.

Хорошо, сейчас я тебе отрендерю 1080p видос с битрейтом в 50 мбит\с, этого сойдёт?

Я переоценил битрейт днищеразрешения, делов-то.

Хотя я уже понял, что ты в лез в разговор, даже не прочитав о чем идет речь.

Пошел отсюда нахуй, мудак, можешь не возвращаться без видео с ютуба, где битрейт у фхд будет хотя бы таким же, как у больших разрешений.

Это чё, судя по отсутствию теней, человекпаук с ПС4? Фу гавно пиздец.

о шарпах поди и не слышал, школяр?

но нет, ты плохо читаешь, без контента это не имеет смысла. Пока только на печи есть компромиссные 240тнки

и шутаны, чтобы оправдать их приобретение.

для работы они не годятся из-за низких расширений и небольших размеров

Речь поначалу не шла о ютубе, а о видео-контенте в целом. Вот первый пост, где пошла речь про битрейт: >>8770

Это ответ на мой пост про разрешение экрана. И тут какой-то долбоёб начал проводить зависимость между разрешением и битрейтом в секунду. Речь о ютубе пошла уже, когда этот обосрышь после обсёра с dpi и ppi начал маневрировать задницей во все стороны и завёл с каких-то хуёв разговор про ютуб и его стандарты.

>для работы они не годятся из-за низких расширений и небольших размеров

Они годятся только чтобы тешить самолюбие жертв маркетинга, сидящих без контента на своих говнобойницах без цветов, зато с герцовкой.

Если это кино, то качаю блюрей рипы, у них самый адекватный битрейт, ну а если на ютубе и у меня есть выбор между 1080\2к\4к, то при мониторе с разрешением в 1440p я выбираю в настройках очивидные 4к и получаю лучшую по качеству картинку за счёт более высокого битрейта.

>большее разрешение при потреблении видеоконтента обычно еще и гарантирует больший битрейт

>обычно

Больше 80 или 90% потребления видеоконтента приходится на ютуб, нетфликс и твитч. Точно не помню, можно погуглить.

Все они отдают отдельные потоки с разным битрейтом и разрешением.

Чем больше разрешение, тем больше битрейт.

Все верно.

А то, что ты смотришь только сериалы, скачанные с лостфильма никого не волнует. Вас таких ничтожное количество. И еще раз: обычно битрейт зависит от разрешения. От кодека тоже конечно, но это другой вопрос. Ты можешь пожать 8К в 1 мегабит, только это издевательство.

>качаю блюрей рипы

не бесит так долго ждать? какой у них битрейт? 100 мбит\с хватит чтобы смотреть сразу после начала скачивания?

>то при мониторе с разрешением в 1440p я выбираю в настройках очивидные 4к

И получаешь гору артефатов (в частности лесенки), потому что не догадался использовать нестандартный виндовый\телефонный даунскеил. Ты не догадался, я гарантирую.

Читай: https://www.reddit.com/r/Monitors/comments/1jdwom/watching_4k_on_1440p/

>Но я не спорю, лол. Зачем мне спорить с долбоёбом, который не понимает разницу между пикселями и точками?

>Ну а на dpi майки перешли правильно, так-то все технологии плавненько перекатываются на технологии квантовых точек

Пиздец у тебя каша в башке. Квантовые точки блять.

>ну а если на ютубе

ну а если на ютубе, то тебе вообще не положено копротивляться против того что анон пишет про ютуб

Двачую, особенно учитывая что майки на DPI перешли еще на XP (может даже раньше).

Квантовые точки, лул.

![The.Walking.Dead.S08E03.WEB-DL.720p.LostFilm.mkvsnapshot18.[...].png](/hw/big/thumb/3078389/15361536556510s.jpg) 1,7 Мб, 1280x720

1,7 Мб, 1280x720Это omnifrequency radiocity model, Кожанка еще просто не начал его рекламировать, поэтому он хуже, чем RTX.

Разный, но 1080 обычно с 40.

>>8963

Держи в курсе.

>>8966

И что не так? Я открою для тебя секрет, но пиксели у нас квадратные. Поэтому использование DPI по отношению к мониторам не правильно с технической точки зрения.

>>8968

>Идея использования квантовых точек в качестве источника света впервые была разработана в 1990-х годах

>релиз xp 25 октября 2001

НАЧАЛЬНИК БЛЯДЬ! ЭТОТ ПИДОРАС СНОВА ОБОСРАЛСЯ!

>Идея использования квантовых точек в качестве источника света впервые была разработана в 1990-х годах

>РРРРРЯЯЯЯ МАЙКИ ЗНАЛИ ЧТО СКОРО БУДУТ МОНИТОРЫ НА КВАНТОВЫХ ТОЧКАХ! НУ И ЧТО ЧТО 18 ЛЕТ ПРОШЛО С РЕЛИЗА ЭКСПИ? У МАЙКОВ ОНИ УЖЕ ТОГДА БЫЛИ, ОНИ ВСЕ ЗНАЛИ!

Ишь как завертелся, как уж на сковороде.

С такими маневрами тебе надо было идти в ВВС, был бы пилотом-асом.

69 Кб, 519x1030

69 Кб, 519x1030>не бесит так долго ждать? какой у них битрейт?

Зависит от кодека, самые упоротые делают под 40, но это лишнее.

4K H265 бывают даже меньше весят, чем упоротые FHD-рипы, и имеют меньший битрейт. Но как я уже сказал, это от кодека зависит.

У меня интернет пол-гига, качается быстро. Впрочем, я обычно ставлю последовательно скачивание и начинаю смотреть через минуту.

![The.Walking.Dead.S08E03.WEB-DL.720p.LostFilm.mkvsnapshot20.[...].png](/hw/big/thumb/3078389/15361540563040s.jpg) 1,9 Мб, 1280x720

1,9 Мб, 1280x720пушенция нах. я за это платил что ли? сделайте мне красиво епт, и отражения чтоб везде были. и тени, мягкие. савсем охуели, меня не наебать.

> Поэтому использование DPI по отношению к мониторам не правильно с технической точки зрения.

DPI и PPI это на 100% взаимозаменяемые понятия.

>Даун, квантовые точки это всего лишь подсветка.

То что сосунг сейчас назвали квантовыми точками - это подсветка, да. Так будет справедливо.

Не, это тени и освещение лучше, просто у хаунга железки пока такое не тянут, поэтому на твоем скрине неосвещенное говно.

Охуеть, адекват на сосаче? Я уже отчаялся. Только один мелкобуквенный анон меня пока поддерживал.

Вера в человечество потихоньку начинает возвращаться.

ох щит. у меня столько места на харде нет. ну и практически впритык для 100 мбит. да и хард не осилит такой битрейт даже, потому что ноутбучный 5200рпм. кароче неюзабельная хрень еще лет 10.

![The.Walking.Dead.S08E03.WEB-DL.720p.LostFilm.mkvsnapshot21.[...].png](/hw/big/thumb/3078389/15361545022610s.jpg) 1,9 Мб, 1280x720

1,9 Мб, 1280x720как не тянут? я такое на пс2 видел. меня не наебешь! где мои тени и отражения сука.

Эй псина с сажей, ты вообще пост читать полностью умеешь, ебло? Я для таких долбоёбов как ты написал: принято считать 1ppi = 1dpi

Вот только dpi по началу применяли только по отношению к принтерам, а ppi к мониторам. Потом, для таких долбоёбов, как ты, эти значения усреднили, что, честно говоря, не всегда есть правда. С принтерами там есть свои заморочки.

>>8980

>это полупроводниковые нанокристаллы, которые светятся, когда подвергаются воздействию тока или света

Чуешь суть, тупорылая псина? И да, самсунг с их кьюледом это маркетинговая параша.

>>8992

>>8988

>>8977

Хуя как один долбоёб обрадовался появлению другого долбоёба.

> Я для таких долбоёбов как ты написал: принято считать 1ppi = 1dpi

А сколько было постов о том, что DPI это принтеры... Эх... Все зря, приходится отказываться от слов и маняврировать.

>псина огрызнулся на мой пост где я написал "ppi"

>спустя пару постов понял, что обосрался и начал маняврировать

Не, говно, хуй ты тут перефорсишь свой обсёр.

Для мониторов 1 DPI=1 PPI ВСЕГДА. Нахуй ты сманяврировал на принтеры?

Любой из этих терминов для обозначения плотности пикселей для монитора будет верным.

Пидорас, ты ведь даже ветку не читал. Нахуя ты высрался тут, говно?

Ну да, если бы телек был во всю стену, тогда можно было бы тратить время на скачку 50Гб, а так с двух метров на 60 дюймовой письке разница между блюреем и онлайн кинотеатром 1080р не стоит тех заморочек.

Ишь как ловко ты себя ставишь на мое место, ух!

Жаль мои посты еще висят, как и твой позор!

Мои:

>Many resources, including the Android developer guide, use the terms DPI and PPI interchangeably.

>DPI и PPI - взаимозаменяемы. О чем я написал в первом же ответе доебавшемуся.

>Ты вводишь в гугл "high dpi monitor" или просто "hiDPI" и видишь тонны мануалов от всяких арчей, бубунт, шинд и андроидов.

Твои:

>Причём тут разрешающая способность печати принтеров и матрица мониторов?

>Хотя судя по высерам этого 4к-долбоёба, он обычная потреблядь, раз путает понятия "пиксель на дюйм" и "точек на дюйм".

Я сижу в 1,5 перед 55" и прекрасно вижу разницу.

Хотя возможно это профессиональная деформация, потому что у меня работа связана с видео, порой даже с 8К, лол. Знаю, куда смотреть, чтобы ее увидеть и страдаю.

1,7 Мб, webm,

1,7 Мб, webm,1280x1280, 0:07

EA-DICE, in an interview with Tom's Hardware, put out some juicy under-the-hood details about the PC release of "Battlefield V." The most prominent of these would be that the commercial release of the game will slightly dial back on the ray-tracing eye-candy we saw at NVIDIA's GeForce RTX launch event demo. DICE is rather conservative about its implementation of ray-tracing, and seems to assure players that the lack of it won't make a tangible difference to the game's production design, and will certainly not affect gameplay (eg: you won't be at a competitive disadvantage just because a squeaky clean car in the middle of a warzone won't reflect an enemy sniper's glint accurately).

"What I think that we will do is take a pass on the levels and see if there is something that sticks out," said Christian Holmquist, technical director at DICE. "Because the materials are not tweaked for ray tracing, but sometimes they may show off something that's too strong or something that was not directly intended. But otherwise we won't change the levels-they'll be as they are. And then we might need to change some parameters in the ray tracing engine itself to maybe tone something down a little bit," he added. Throughout the game's levels and maps, DICE identified objects and elements that could hit framerates hard when ray-tracing is enabled, and "dialed-down" ray-tracing for those assets. For example, a wall located in some level (probably a glass mosaic wall), hit performance too hard, and the developers had to tone down its level of detail.

sauce: https://www.techpowerup.com/247365/dice-to-dial-back-ray-tracing-eye-candy-in-battlefield-v-to-favor-performance

> мегги в ее классную попку

Обычная рожавшая тян, у всех тней после родов жопа становится такой

Дело не в том что ее нет, а в том, что лично мне разница между блюреем и онлайнкинотеатром при просмотре фильма не так важна как заморочка с поиском, скачкой и хранением файла. Если будет потоковый 8К кинчик, ясен хер воткну его, а если уж захочу ощутить на кончиках пальцев, то я лучше в имах схожу на фильм.

На пека не завезли((((9

>For example, a wall located in some level (probably a glass mosaic wall), hit performance too hard, and the developers had to tone down its level of detail.

сука, а я говорил ведь что ртх пердит на сложных поверхностях и теперь будет откат на 10 лет в графоне. вот и пруфы что я прав. поэтому новая ларка такая мыльная. вместо кожи мыльное говно, геометрия уровней проще намного и т.д.

Кубическая тень прямо как в гта5.

Ну тут все просто: ставишь скачиваться фильм, включаешь последовательное скачивание, после 30% начинаешь смотреть. Посмотрел? Удалил.

В общем-то все твои проблемы это должно решить. Проблемы с поиском... Есть некоторые. В основном все релизят на тапочках, а там надо платить

are you sure about that?

Это было очевидно. Нас просто наебали, пытаясь продать ненужный оверпрайс.

Там речь шла в контексте рейтрейса, даун, лучи будут сбавлять а не саму игру даунгрейдить ради 3,5 РТХ-господ.

> For example, a wall located in some level (probably a glass mosaic wall), hit performance too hard, and the developers had to tone down its level of detail.

туповатый как твоя мамка

А ВЕДЬ ОН ГОВОРИЛ АААА, ОН ПРЕДУПРЕЖДАЛ ВЕЛИКИЙ ПРОРОК СВОГИ ГОВОРИЛ А МЫ НЕ СЛУШАЛИ ЛАПКА МЫЛЬНАЯ ЛУЧИ НАЕБКА ПРОСТИ НАС СВОГИ ВЕЛИКИЙ ПРОРОК

>Throughout the game's levels and maps, DICE identified objects and elements that could hit framerates hard when ray-tracing is enabled, and "dialed-down" ray-tracing for those assets. For example, a wall located in some level (probably a glass mosaic wall), hit performance too hard, and the developers had to tone down its level of detail.

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

>and "dialed-down" ray-tracing for those assets

Ну а может у журналиста язык в жопе. Сначала спизданул одно, а потом сказал отдельно про детализацию стеклянной стены.

52 Кб, 500x374

52 Кб, 500x374прощаю

>про детализацию стеклянной стены.

Про детализацию рейтрейсинга на стеклянной стены*

Она сейчас явно избыточна, даже рейтрейс с разрешением в 720p (или в шахматных 1080p) даст гораздо более лучшую картинку чем любой костыль.

И что не так в этом посте? Послал тебя читать про DPI, который в контексте разговора про мониторы значит PPI. Хочешь - прочитай сначала про принтеры, я тебе не мешаю.

>Она сейчас явно избыточна, даже рейтрейс с разрешением в 720p (или в шахматных 1080p) даст гораздо более лучшую картинку

А если подальше отсесть то и 240p хватит

1,3 Мб, webm,

1,3 Мб, webm,1280x720, 0:24

Ну и вообще рейтрейс не нужен, смотри какие отражения умеют делать разрабы через костыли!

>даже рейтрейс с разрешением в 720p (или в шахматных 1080p) даст гораздо более лучшую картинку чем любой костыль.

блять ты щас серьезно? лучшую картинку поделенную на производительность сегодня дает именно что костыль. кроме отражений разве что, хотя есть планары.

Это SVOGI.

тебе так они нужны? планары заебенить и будет все равно быстрее ртха. но пс4 с ее 7850 уже не потянет.

Пиздец, какой же ты долбоёб. Ладно, я разжую для тебя всё по полочкам:

>речь идёт о телефоне с экраном в разрешении 1440р

>на вопрос "нахуя тебе в телефоне разрешение с больше плотностью чем 400ppi" начинаешь что-то кукарекать про мат часть разрешения и dpi.

>Послал тебя читать про DPI, который в контексте разговора про мониторы значит PPI

Вот так манявр!

Просто сониговно потянуло только пререндер кубмапу. А можно было отрендерить еще раз что за спиной и получить зеркало полностью аналогичное лучам поноса.

>Послал тебя читать про DPI, который в контексте разговора про мониторы значит PPI

С чем в этом предложении ты не согласен? Ты же в прошлом посте буквально распинался, что ты не споришь, что DPI = PPI. Передумал? Снова тебя обоссать за это?

Ладно, мой рабочий день закончен, так что снова макать лицом в твою ссанину мне лень.

размылить до 720р и будет летать

Ну и пошел отсюда, знаток.

Уже каждый тебя в треде обоссал наверное, я как минимум 5 насчитал.

Знатный мы тебе гэнгбенг устроили, да?

Просто я отец тугосери и моей жена стала точно такая же жопа после родов, погугли, я вангую, что она просто рожавшая

Ну и вообще можешь погуглить бёдра рожавших тней

Ну так это любительская модификация на своги, чего ты хотел.

![The.Walking.Dead.S08E04.WEB-DL.720p.LostFilm.mkvsnapshot00.[...].png](/hw/big/thumb/3078389/15361580052550s.jpg) 1,3 Мб, 1280x720

1,3 Мб, 1280x720Да не, это РТХ, с ССР такое невозможно сделать, мне хуанг сказал. И бля посмотри какое мыльцо, это потому что разрешение лоурезное, как в зеркалах в батле с РТХ.

Не слушай этого шизика, кости таза никуда не расходятся

>the lack of it won't make a tangible difference to the game's production design

Вся суть. Эта хуйня значения иметь не будет, так как разрабы и художники сцены будут делать без специального расчета на то чтобы наиболее ярко и выгодно эту технологию обыграть в сцене. Когда ртх будет работать на всех затычках, тогда и наступит эра рейтрейсинга в играх. А сейчас это как виар и вполне возможно высокая цена наоборот навредит привитию технологии для массовой аудитории (на которую разработчики всегда ориентируются). Ну и само собой, это должно появиться в консольках, а это будет не скоро и не с амуде видеокартами.

![The.Walking.Dead.S08E04.WEB-DL.720p.LostFilm.mkvsnapshot01.[...].png](/hw/big/thumb/3078389/15361584541070s.jpg) 1,7 Мб, 1280x720

1,7 Мб, 1280x720че ты мне заливаешь. где мои мягкие тени бля, че за хуйня уровня дх8

I7 8700 без к

Gskill 16 гб

Sonic gold 650w

Я ЖДАЛ, не сосну, если еще столько же въебу на кусок видеокарты? В любом случае будущее за турингом. Как бы не сказали квадры покупать для 60 фпс

Сори, я про 2080 без ти. Рупь охуевает. Они ебанулись там в думе

Говно, ты?

>>9221

Give 'em the old razzle dazzle

Razzle Dazzle 'em

Give 'em an act with lots of flash in it

And the reaction will be passionate

Give 'em the old hocus pocus

Bead and feather 'em

How can they see with sequins in their eyes?

What if your hinges all are rusting?

What if, in fact, you're just disgusting?

Razzle dazzle 'em

And they;ll never catch wise!

Give 'em the old Razzle Dazzle

Razzle dazzle 'em

Give 'em a show that's so splendiferous

Row after row will crow vociferous

Give 'em the old flim flam flummox

Fool and fracture 'em

How can they hear the truth above the roar?

Throw 'em a fake and a finagle

They'll never know you're just a bagel,

Razzle dazzle 'em

And they'll beg you for more!

Give 'em the old double whammy

Daze and dizzy 'em

Back since…

>>9221

Give 'em the old razzle dazzle

Razzle Dazzle 'em

Give 'em an act with lots of flash in it

And the reaction will be passionate

Give 'em the old hocus pocus

Bead and feather 'em

How can they see with sequins in their eyes?

What if your hinges all are rusting?

What if, in fact, you're just disgusting?

Razzle dazzle 'em

And they;ll never catch wise!

Give 'em the old Razzle Dazzle

Razzle dazzle 'em

Give 'em a show that's so splendiferous

Row after row will crow vociferous

Give 'em the old flim flam flummox

Fool and fracture 'em

How can they hear the truth above the roar?

Throw 'em a fake and a finagle

They'll never know you're just a bagel,

Razzle dazzle 'em

And they'll beg you for more!

Give 'em the old double whammy

Daze and dizzy 'em

Back since…

>нет, хуанг это стив джобс от мира видеокарт

Стив джобс делал технику для людей. Если в интерфесе что-то лагало - ебал без смазки пока не исправят. А хуянгу похуй какая производительность с его технологиями без задач.

Уже лучше мошенник которой хоть что-то выпускает чем долбоебы из амуды которые обосрались что с rx серией, что с вегой. Ни дравйверов как всегда, ни карт, а те что есть по бешеным ценам. Видимо нужно только подождать до того момента как амуда что-то высрет.

Что случилось? чёт не охота разгребать очередной срач. Думаю, надо просто спакойно ждать тестов, пускай паскалечмоньки бесятся

Так и есть! Сто чаёв тебе анончик!

Да и хуй с ним.jpg

Любую, какая понравится за эти деньги!

>долбоебы из амуды которые обосрались что с rx серией, что с вегой

в твоем промытом манямирке разве что

Тишечку няшечку, либо ЖДАТЬ.

Я вот, значится, смотрю. Смотрю я такой, смотрю, и в общем у него в главном меню игры есть ниггер и пиздоглазая кореянка. А у меня в главном меню показывает только белых ребят и странного чувака в маске.

может быть дайсы таки свою толерастию будут по регионам прививать, а для регионов где на толерастию всем срать в игре будут нормальные персонажи а не анальные клованы? Тогда я, наверное, смог бы в это поиграть

GTX 1080Ti господин

RTX!

и теперь представь что у тебя такой же фпс при такой же картинке, только в 1080р, с ртх

>может быть дайсы таки свою толерастию будут по регионам прививать, а для регионов где на толерастию всем срать в игре будут нормальные персонажи а не анальные клованы? Тогда я, наверное, смог бы в это поиграть

бред. тогда бы прививали по аккаунтам. вначале игры спросили бы как относитесь и все дела. тогда бы все были бы довольны.

Ты маневровые-то выключай и сделай скрин такой же лужи в лесу.

ты ваще про какую вегу то говоришь? где она дешевле?

ебать у тебя там ад какой то. у тебя видяха горелая что ли? или ты там сам траллишь с шейдерами воды? такие глюки просто не могут быть.

А смысл, если все прекрасно знают какие страны толерантны, а какие нет?

5,7 Мб, mp4,

5,7 Мб, mp4,1600x900, 0:06

24,1 Мб, mp4,

24,1 Мб, mp4,1600x900, 0:26

8,5 Мб, mp4,

8,5 Мб, mp4,1600x900, 0:08

16,3 Мб, mp4,

16,3 Мб, mp4,1280x720, 0:26

> такие глюки просто не могут быть.

Конечно, ведь эта игра прославилась своим невероятным качеством.

Это игра выдаёт графику уровня Морровинд/Обливион, но при этом упарывает мид и топ процы и видюхи я ебал как так оптимизировать могут

125 Кб, 1440x900

125 Кб, 1440x900кончай пиздеть, бесишь пиздлявая мразь. смотри на нормальную лужу. и это средние настройки. выкини свое хуангоговно на помойку, если оно показывает такие мыльные отражения.

> 1440x900

> 25 фпс

> средние настройки

> смотри на нормальную лужу

Я смотрю на лужу которая у тебя под ногой.

ты слепой ебанат или что?

20 Кб, 413x395

20 Кб, 413x395Мда, киндомпомои выглядят конечно ужасно. Всегда с улыбкой вспоминаю шизика топившего за графин в киндомпараше

у меня 7770 1гб. и графика лучше чем у этого недоноска, что не так?

185 Кб, 298x349

185 Кб, 298x349Киндомкало-даун закономерно обосрался и взбесившись начал кукарекать на мимокрокодилов уличая в семёнстве

ну там глюков хватает. но с мыльной водой я такого не видел ни разу

я тебе показал уже с дохдой лошадью. вот у тебя такой же должен быть. это глюк или ты спецом так портишь.

Как только сосака сможет загружать ролики по 500Мб, буду скидывать в 4к.

отражения в воде у тебя сломаны, это факт. или в дровах глюки или в видяхе. или шейдеры на минималках. не знаю что еще с таким адом может быть.

379 Кб, 1280x800

379 Кб, 1280x800вот нормальные шейдерные отражения, даун. а не то глючное мыло что у тебя

ты ебанат со своей горелкой которая так жестко глючит. перемайнил уже ее и сжег нахуй?

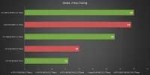

>The Raytracing Global Lighting is very impressive, as it is much more detailed and accurate than the regular lighting in Metro Exodus. The GI is obviously also very demanding, in fact Metro is: Exodus maybe even the most power-hungry example among the RTX demos. For while the regular exhibition demo ran on the Geforce GTX 1080 Ti in Ultra HD with largely pleasant liquid frame rates, the performance in the RTX demo in Full HD with a Geforce RTX 2080 Ti was still just playable, but not for a shooter more really supple range of estimated maximum 40 fps - tendency rather lower. This was quite clear from the high input rate, which was already in the unpleasant for us area.

https://translate.google.com/translate?hl=en&sl=auto&tl=en&u=http://www.pcgameshardware.de/Metro-Exodus-Spiel-61050/News/Hands-On-Test-Preview-Gamescom-Raytracing-Geforce-RTX-2080-Ti-1263978/

Сука игра 2018 года выглядит как игра 2006

у тебя видюха просто сгорела сука!11

Ничего удивительного, по мнению хуянга видяхи слишком производительные стали. Надо бы замедлить их какой-нибудь хуетой без задач.

ты вытекаешь

>NVIDIA будет разделять кадр на участки с разной детализацией. В зависимости от уровня детализации, некоторые участки будут обрабатываться шейдерами более точно, в то время как у остальных точность будет снижена.

Хуянг даже с приростом производительности наебал - это чисто софтовая оптимизация в дровах будет. Без нее было бы вообще +10% фпс при +100% цены.

> NVIDIA будет разделять кадр на участки с разной детализацией.

А почему на паскалях этого нет?

И не будет. Хуангу нужно продавать тьюринги.

Потому что на паскалях весь кадр будет детализирован максимально четко.

Почему DX12 медленнее? Там есть какие-то эксклюзивные для него эффекты или его впихнули чтобы было и обосрались с оптимизацией?

Второе.

![1536163403645[1].jpg](/hw/big/thumb/3078389/15361722216310s.jpg) 88 Кб, 639x628

88 Кб, 639x628> его впихнули чтобы было и обосрались с оптимизацией

Покажи мне хоть одну игру, кроме гирек4, где разрабы НЕ обосрались с дх12.

Ну хоть к 2030му начнут в играх лучи использовать, вот тогда туринг себя покажит

А как же ашеос оф зе сингулярити? Если ты не знал, это игра, а не бенчмарк.

DX12 игр до факту не существует. Есть DX11 игры запакованные во враппер DX12, который ресурсы системы отъедает.

DX12 оказался слишком сложным и дорогим для говноделов и затраты на его внедрение в отдельной игре сравнимы с затратами на создание ещё одной игры/порта, так что он им нахуй не нужен

Мб DX13 будет эффективней и проще для девелоперов, но пока что у DX12 нету будущего

Вот что тебе не так? Я спросил совета. У меня подозрение,, что ты амудедауан и местечко тебе приготовлено там, у параши, хуеплет

>затраты на его внедрение в отдельной игре сравнимы с затратами на создание ещё одной игры/порта

схуяли ты это взял

ну и может быть вулкан попроще будет?

>схуяли ты это взял

Я на ютубе и твиче много раз от девелоперов слышал их ответы почему нет DX12 игр

>ну и может быть вулкан попроще будет?

Вулкан да, он проще, но ещё проще и низкоуровней это API от Sony, так что игры изначально под приставки разрабатываются, а потом под ПК портируются

>DX12 оказался слишком сложным и дорогим

Дело не в этом. Дело в том что оптимизация в случае дх12/вулкана целиком ложится на разрабов. Хуанг уже ничего подкрутить в дровах не может. Ну и так как разрабы не знают, да и не хотят знать, как нужно оптимизировать, чтобы получить оптимальную производительность на каждом вендоре, мы и имеем хуевый фпс.

Короче решение создать низкоуровневые апи для пука было фейлом.

С самого начала блыло 95 990

83 Кб, 903x493

83 Кб, 903x493Закрытие медведей ниже 4к, вот пока на уровне 3к не окажемся роста не будет, можете скринить

Почему? Потому, так как прошлая коррекция 4ой волны была на уровне 4к

right here

ага

я первую купил БУ, без дополнений за 400р и даже не попробовал играть

Стоит попробовать?

Можно взять фри подписку на 14 дней

забей на того зелёного дебича, я все равно планирую взять 560 на 4гб, или 460 и прошить в 560

Просто ищу на авито ценник повкуснее, да и бате пока не горит, пока тепло он все выходные проводит на рыбалке

>Стоит попробовать?

В общем я сначала не вкурил, но немного приигравшись залип капитально. Если друзья есть - то вабще шик, мне поиграть особо не с кем. Пару миссий прошёл с рандомами против боссов - было очень круто. Огромного механизирвоанного паука ебашили втроём наверное часа 2 - он был сильно выше нас левелом.

Вторую часть очевидно лучше играть на компе - ибо я ебал на мыловарне во что-то кроме эксклюзивов играть - малоиграбельно

Но раз уж бесплатно - можно и на мыловарне поиграть, ибо на пекарню её за бесплатно нет, а если и была бы - не работал бы кооп.

Ларка, странная бригада... На 3д ньюс был тест еще с кучей игор, ищи.

Еще и в первой батле жуткие статтеры в дх12. Это пиздец. Че эти долбоебы там творят?

Кста сегодня открытый бета тест для всех, вкатываемся и ищем отражения.

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

>>3079752 (OP)

если разрабы не могут осилить дх12 - то они дерьмо и не должны вообще быть в игроиндустрии.

Вы видите копию треда, сохраненную 27 сентября 2018 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

![The.Walking.Dead.S08E03.WEB-DL.720p.LostFilm.mkvsnapshot11.[...].png](/hw/big/thumb/3078389/15361524841440s.jpg)

![The.Walking.Dead.S08E03.WEB-DL.720p.LostFilm.mkvsnapshot26.[...].png](/hw/big/thumb/3078389/15361550372860s.jpg)

![The.Walking.Dead.S08E03.WEB-DL.720p.LostFilm.mkvsnapshot29.[...].png](/hw/big/thumb/3078389/15361552718410s.jpg)

![1536148005600[1].webm](/hw/big/thumb/3078389/15361553810260s.jpg)

![The.Walking.Dead.S08E03.WEB-DL.720p.LostFilm.mkvsnapshot29.[...].png](/hw/big/thumb/3078389/15361553856590s.jpg)

![The.Walking.Dead.S08E04.WEB-DL.720p.LostFilm.mkvsnapshot02.[...].png](/hw/big/thumb/3078389/15361586519350s.jpg)

![The.Walking.Dead.S08E04.WEB-DL.720p.LostFilm.mkvsnapshot03.[...].png](/hw/big/thumb/3078389/15361588207120s.jpg)

![The.Walking.Dead.S08E04.WEB-DL.720p.LostFilm.mkvsnapshot06.[...].png](/hw/big/thumb/3078389/15361591280760s.jpg)

![The.Walking.Dead.S08E04.WEB-DL.720p.LostFilm.mkvsnapshot12.[...].png](/hw/big/thumb/3078389/15361595657380s.jpg)

![The.Walking.Dead.S08E04.WEB-DL.720p.LostFilm.mkvsnapshot13.[...].png](/hw/big/thumb/3078389/15361597484920s.jpg)

![Купить видеокарты серии GeForce GTX 20 NVIDIA - Mozilla Fir[...].png](/hw/big/thumb/3078389/15361820686600s.jpg)