Вы видите копию треда, сохраненную 10 августа 2018 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Тут мы решаем ультраважные вопросы о том, как правильно хранить динамические атрибуты сущностей: в полях или в строках,

Рассказываем, как работаем аналитиками и мечтаем стать разработчиками,

Строим АНАЛИТИЧЕСКИЕ отчеты в экселе, выгружая по миллиону строк, а потом фильтруя,

Дружно не понимаем, ЗОЧЕМ ЖИ НУЖИН ОЛАП, ЕСЛИ И ТАК ВСЕ РАБОТАЕТ ЗАЕБИСЯ,

Ищем ошибки в аббривиатурах MDX DMX XMLA,

Доебываемся до эс - ку - элей наших же потенциальных конкурентов

>Select id from tbl_table_with_id where id = (select max(id) from tbl_table_with_id)

>ЧТО НЕ ТАК-ТО У МЕНЯ?

Удивляемся, как за знания, приобретаемые за 4 месяца на sql-ex, могут платить по 100к, и бугуртим, что ниасилили и 100к не получаем.

А так же:

Постгре или постгрес?

Май эс ку эль или мускуль?

Эс ку эль или сиквел?

В общем, это очередной баз данных тред, поехали!

Награда светит не посмертною медалью, отнюдь

Это храм старого формата, так предали огню

И скоптили небо старики, что слышны с Невской реки

Мы видим дым от костра - "Да здравствуют базовики!"

ПРЕДЫДУЩИЙ: >>1086747 (OP)

#sql #бд #базы данных

Найс блядь обосрался с перекатом. Не умеешь - не берись.

Иди нахуй.

Короче, второй день читаю информацию на эту тему, сравниваю варианты репликации и уже реально запутался. Кто-ндь наставит на путь истинный?

Вдогонку: есть ли способ относительно безболезненно обновиться с 9.3 на 10 без промежуточных этапов?

Это называется StandBy. Гугли книги администратора postgres на рутрекере. Настрой сначала архивлоги, а потом с этого пляши. Научись эти логи синмать раз в полчаса, например, а после дополни конфиг на стэндбай.

Чтобы безболезненно перейти на новую веосию читай ман про апгрейд, или делай бэкап и разворачивай потом на десятку

37 Кб, 800x410

37 Кб, 800x410Как мне сделать таблицу эту по нормальному? Но если я сделаю как на пике, мне придется каждый раз писать insert into Группа - и вводить каждый раз имя группы, каждый раз количество и менять только айдишник студента.

Это нормальный подход?

Это ты так не смешно шутишь?

Продолжаю вкатываться, хочу устроиться для начала джуном в бекенд на Питоне. Дошел в своем обучении до баз данных. Что прочитать по ним? Database systems Сиджея и Learning sql ? Или это не то совсем? Что тогда надо?

Алан Бьюли, Том Кайт.

Связь студент-группа должна быть в отдельной таблице, в этой таблице также должны храниться дата начала членства студента в группе и дата окончания оной (null - если дата окончания неизвестна)

13 Кб, 300x188

13 Кб, 300x188Чтобы добавить ограничение на колонку нужно выполнить такой запрос:

ALTER TABLE products ADD CONSTRAINT some_name UNIQUE (product_no);

(источник: http://postgresql.ru.net/manual/ddl-alter.html )

Как я понял product_no является названием колонки или нескольких колонок для которых мы добавляем ограничение, а чем тогда является some_name ?

Как-то так:

student_group_id number

student_id number

group_id number

student_group_date_start date

student_group_date_end date

Это самый простой вариант. Можно добавить ссылки на документы, на основании которых осуществлялось включение/исключение в группу, добавить комментарий.

Кстати, количество человек в группе хранить в таблице не надо.

Оно рассчитывается в зависимости от даты.

Например, на первом курсе было 20 человек, к пятому осталось 8. Тебе нужно узнать, сколько человек отчислилось на третьем курсе, или сколько пришло из академки на четвертом. С такой промежуточной таблицей-связью это легко сделать.

Но ведь при создании таблицы я могу сделать вот так:

CREATE TABLE products (

name text,

id integer UNIQUE

);

Так вот, где здесь указывается имя ограничения?

Точно! Спасибо тебе большое, что уделил на меня время.

Взял

28 Кб, 1256x139

28 Кб, 1256x139Ну, если впадлу делать что, можешь мою взять с триггерами.

Нужно разработать и реализовать триггеры для операций INSERT, UPDATE, DELETE для проверки сложных ограничений, накладываемых на схему предметной области (не менее двух триггеров для каждого типа операции).

Не менее трех триггеров (любого типа) должны выполнять действия компенсирующего типа в связанных таблицах.

По одному триггеру для каждой операции должны быть триггерами instead of (триггеры должны содержать логику обработки данных - например, выполнение компенсирующих операций, расчетные данные, обработку сложного удаления или обновления данных).

В этом случае имя генерится субд и оно не очень удобное. Не знаю как в постгресе, а в Оракле это что-то вроде sys_12343123.

По ссылке, которую ты выше приводил:

Чтобы удалить ограничение, вам необходимо знать его имя. Если вы сами давали ему имя, то все просто. В противном случае, СУБД назначило автоматически сгенерированное имя, которое нужно найти. В этом может помочь команда \d tablename в psql; другие интерфейсы также могут предоставлять способ инспектирования подробностей таблиц. Затем выполняется команда:

ALTER TABLE products DROP CONSTRAINT some_name;

(Если вы выполняете команду с указанием такого имени ограничения как $2, не забудьте, что вам понадобится заключить имя в двойные кавычки, чтобы имя было воспринято как правильный идентификатор.)

понял, принял. Спасибо

Благодарю. Обновление уже сделал, проблем вроде не было.

Насчет StandBy не нашел ничего толкового, логи и бекапы есть, как я понял все-таки нужна потоковая/логическая репликация.

Помимо этого, наткнулся на вариант кластера высокой доступности средствами самой винды: https://www.postgresql.org/message-id/006c01cd8c6f$bd274ba0$3775e2e0$@devshock.com (правда слабо понял, как это реализовать, сейчас усилено гуглю).

Что думаете об этом? Стоит ли пробовать (учитывая, что серваки надо было запустить уже на этой неделе, а я - простая вебмакака без опыта администрирования чего либо)?

DataGrip

DBeaver.

Ты серьёзно? Твои друзья вот эти три дядьки:Bartolini G., Ciolli G., Riggs S.

Есть же годные доки на сайте postgresql.

Первым делом читай про Wall-Ahead Logs ( они же archvie logs) параграф 29.2. Если ты не разберёшься с технологией Standby то можешь налепить скрипт, который на второй машине будет применять эти логи. Да и приятно, когда у тебя бэкап каждый день, а архивлоги делаются каждые 15 минут. Это позволит восстановить сервер если упадёт стэндбай и кто-то повредит базу например на 18:06(а бэкап у тебя в 00:00)

Сама технология Standby основана на передачи redo-журналов по сети другой машине, и там уже применение. Standy это 25.5.

Есть краткий ман по настройки Standby вот тут : https://wiki.postgresql.org/wiki/Hot_Standby

но по сути настроив wal ты вполне легко настроишь standby. Чтобы понять как всё работает и посмотреть все настройки тебе нужно postgresql.conf , и забэкапь этот файл, чтобы если сломаешь его, то сможешь восстановить.

По сути если у тебя есть виртуалка, то просто копируешь машину, а потом делаешь из одной main сервер, другой standby. И выпроси хранилище для бэкапов, даже если кто-то заебашит raid-5 тебе будет это нужно.

Работаю ETL-разрабом в развитии DWH полтора года. Oracle + Informatica. Мне норм, как тебе будет хуй знает. Лично мне платят хуево, собираюсь в ближайшее время перекатываться в другое место.

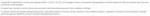

12 Кб, 479x395

12 Кб, 479x395В оракле, если не ошибаюсь, NULL определяется как строка в блоке с значением длины 0.

>>168073

Есть такая профессия, даже не обязательно Data science. Если ты делаешь хуйню для который нужна база, то это типичная задача бэкэнд-разработчика на язык-нейм.

Если ты делаешь с нуля или развиваешь ебическую, нетривиальную по объему и нагрузке базу на основе которой будут работать разные хуйни, то это отдельная профессия.

8 Кб, 198x255

8 Кб, 198x255у меня вторая есть как отдельная задача, лол.

Проектировка БД. Причём приходится всасывать дохуя документации и иногда недокументируемые возможности, но я вообще программист-архитектор по профессии.

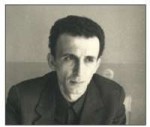

15 Кб, 771x175

15 Кб, 771x175Как мне создать триггер на удаление всех записей у которых одно поле равно удаляемому значению?

Спасибо, анон, за подробное разъяснение! Вообще с английским не очень дружу, то есть читаю, понимаю, но это занимает раза в 3 больше времени и сил, чем та же инфа на русском. Но книга реально крутая, буду разбираться.

Была мысль поднять по виртуалке на каждом сервере, основа - Дебиан, гостевая - Windows Server 2012 R2, но идея мне кажется дико костыльной, причем хз, можно ли ОЕМ-ключи к винде использовать на виртуалке.

ну вот мне надо таких запросов послать 12 штук за один раз, при этом разница в них будет только в DateTime - по два часа, то есть первый запрос с DateTime равным 00:00:00, второй 2:00:00 и так далее. И вот чего, как это можно оптимизировать?

Ну эта, сморя чо те надо сделать.

Запросы-то не ради самих запросов отправляются, верно?

Если ты хочешь получить какую-то информацию за сутки, тебе и надо отправлять один запрос на сутки плюс группировка по 2 часа.

Планирую начать использовать MongoDB, чтобы объединить в одном месте несколько больших наборов данных со множеством столбцов, где в случае SQL пришлось бы делать много таблиц.

Вот тут пишут, что из MongoDB неудобно делать запросы по типу SQL

https://habrahabr.ru/post/222083/

Если это так, то что, кроме упоминаемого Asterix, можно взять в качестве No SQL базы, чтобы можно было использовать команды, схожие с SQL ? Желателен модуль для Python.

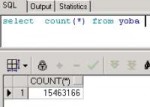

147 Кб, 629x901

147 Кб, 629x901Нет, в зеленом госбанке заебись платят, говорят.

>Если ты хочешь получить какую-то информацию за сутки, тебе и надо отправлять один запрос на сутки плюс группировка по 2 часа.

Да неужели получить результат за сутки, а потом выколупывание данных за каждые два часа будет быстрее?

>>170869

>Используй динамический sql

Это что такое? Как мне поможет?

это например такая конструкция

yoba:=ti

select * from you.pidor where you.youba=:yoba

когда ты делаешь это динамично, то план составление и исполнения запроса выполняется 1 раз на дохуя данных. То есть ты берёшь и меняешь yoba на что-то другое, например yoba:=mamka. Время на данный select тратится в разы меньше, ведь ты уже делал такую же выборку, анон, да ведь?

Дальше каждая норм СУБД имеет расширенный sql, можешь написать функцию или materialezed view.

Вообще если ты регулярно делаешь такие вопросы, то почему ты не подумал ещё о partition table?

>>Да неужели получить результат за сутки, а потом выколупывание данных за каждые два часа будет быстрее?

Ты не поверишь, но да. Можешь сделать вьюху с этими данными, а потом из перебирать. Вьюха это не только удобство, но и скорость.

блин, это интересно, но мне не ясно, сработает ли в моем случае, я просто задачу упростил, дабы анонов не грузить. Я на шарпе пишу отчеты и тащу данные вот таким запросом

SELECT * FROM OPENQUERY(INSQL, 'SELECT

aL1_1_2\value, aL1_6_2\value, aL6_1_2\value, aL6_2_2\value, aL7_4_1\value, aP1_1_1\value, aP1_2_2\value, aP1_6_1\value, aP11_1\value, aP2_1_1\value, aP2_1_13\value, aP2_1_3\value,

aP2_1_5\value, aP2_2_1\value, aP2_2_13\value, aP2_2_3\value, aP2_2_5\value, aP3_1\value, aP7_8_7\value, aP7_8_8\value, aT1_2_1\value, aT2_1_12\value, aT2_2_12\value, aT24_4\value,

aT3_2\value, aT7_8_6\value, aV2_1_7_1\value, aV2_1_7_2\value, aV2_2_7_1\value, aV2_2_7_2\value

FROM WideHistory

WHERE DateTime = ""FinishTime""');

где в цикле заменяю FinishTime на нужное мне время 12 раз. Вот такое говно как то можно оптимизировать?

Мм, вьюху делай

>Да неужели получить результат за сутки, а потом выколупывание данных за каждые два часа будет быстрее?

Зависит от структуры базы(особенно индексов) и природы данных. В общем случае так лучше и правильнее.

Если же мелкие запросы предпочтительнее, так тоже может оказаться, то их надо делать с bind переменными.

Даже если не дойдешь до вьюшки или хранимки, сделай bind переменные. Сейчас у тебя самый хуевый вариант из возможных.

>bind переменные

а чо, а как? я просто в ms sql не очень (только на уровне простых запросов и Entity Framework). В двух словах с небольшим примером можно? А то в гугле только про mysql нашел биндинг.

Если ты используешь bind-переменные для запроса , который вызвается несколько раз, то СУБД гораздо, гораздо быстрее разберет и выполнит второй и следующие запросы, используя данные из кэша. Если ты формируешь запрос простой строкой, то с точки зрения субд каждый запрос - уникальный и возникают дополнительные расходы на парсинг и построение плана, кэш не используется. Если таких уникальных запросов много, то ДБА тебе руки не пожмут.

Если ты используешь openquery, то там нельзя просто так использовать bind-переменные, вот же говно, не ожидал.

На твоем месте я бы попробовал сделать хранимую процедуру и вызывал бы ее с подставленным в цикле значением (но сначала попробовал бы все-таки группировки. Опять же, зависит насколько часто твой отчетник дергает базу)

https://social.msdn.microsoft.com/Forums/en-US/5da9950d-c526-4afe-a6d7-30488db2fb26/calling-sp-using-open-query-in-sql-server?forum=transactsql

Aqua data studio, на рутрекере есть крякнутая

8 Кб, 471x307

8 Кб, 471x307Задание: 1 ($erges: 2008-06-21)

Дима и Миша пользуются продуктами от одного и того же производителя.

Тип Таниного принтера не такой, как у Вити, но признак "цветной или нет" - совпадает.

Размер экрана Диминого ноутбука на 3 дюйма больше Олиного.

Мишин ПК в 4 раза дороже Таниного принтера.

Номера моделей Витиного принтера и Олиного ноутбука отличаются только третьим символом.

У Костиного ПК скорость процессора, как у Мишиного ПК; объем жесткого диска, как у Диминого ноутбука; объем памяти, как у Олиного ноутбука, а цена - как у Витиного принтера.

Вывести все возможные номера моделей Костиного ПК.

Есть идеи как такое решить?

изи же. Но знаешь, sql-ex и ты идут на хуй.

>Есть идеи как такое решить?

А у тебя? Хоть строчку написал? Где твои собственные соображения? М?

Джойнов нет, селектов нет.

Там используются RDF, RDFS, SPARQL, OWL, SWRL, ну и CYPHER.

Что это такое - смотри в интернете. Логика совершенно другая.

Возьми OrientDB и попробуй, првда там sql даже очень далек от 92. Но есть возможность запилить граф.

Если хочешь область применения - социальные сети. Там это оптимально в отличии от реляционной, и вот подумай почему.

Индекс (англ. index) — объект базы данных, создаваемый с целью повышения производительности поиска данных.

Что это за объект? В каком формате хранится? Как связан с таблицей?

>Что это за объект

СУБД содержит разные объекты - таблицы, индексы, хранимые процедуры, триггеры, вьюшки. Т.е. индекс - это объект, отличающийся от таблицы.

Самая простая аналогия - предметный указатель терминов в конце учебника.

По этому указателю ты можешь быстро найти нужную страницу. Например, мануале по автомобилю написано: Топливный фильтр, стр. 30, 55, 100. Если такого указателя нет, то тебе бы пришлось просмотреть все страницы, а с индексом-указателем ты сразу получаешь конкретные номера.

В СУБД одна таблица может иметь много индексов - для разных колонок, содержать внутри функции от содержимого колонок. таким образом есть возможность быстро выгребать записи по самым главным атрибутам. Быстрее всего работают уникальные индексы - для одного значения индекса существует ровно одна запись и СУБД находит такую запись очень быстро. Индексы, для значения которых существуют много записей, работают медленнее (очевидно). При создании индексов нужно учитывать природу данных, примерное количество записей и характер джойнов, чтобы создать ровно столько индексов, сколько нужно, т.к. индексирование полей по которым никогда не будет поиска или джойна - пустая трата места на диске и времени на обновление этого индекса при операциях вставки, удаления, редактирования.

>В каком формате хранится

На данном этапе (да и на следующих) тебе это без разницы. Напрямую с индексами при написании запросов не работают, максимум, ты можешь указать индекс в хинте, чтобы СУБД его точно подхватила (может и не подхватить, если он по ее мнению не нужен)

>Как связан с таблицей?

Индекс создается на одну или несколько колонок определенной таблицы.

Короче, сделал Hot Standby, слейв льет данные с мастера и доступен на чтение. Но как, и, главное, когда делать слейв мастером и наоборот! Читал про варианты с pgpool, достаточно удобно, но третий сервер для него мне никто не даст. Остается вариант постоянной проверки на слейве доступности мастера и, в случае его недоступности, продвижения слейва до мастера. И наоборот. Пока думаю решить это с помощью наколеночных батников, но вообще не уверен, будет ли это решение приемлимо работать. Очень большое желание вообще забить на все и уволиться, ибо знаний катастрофически не хватает, а процесс настройки затянулся уже более чем на две недели. Есть ли выход из тупика?

Есть система мониторинга в фирме?

Просто пилишь в нее тесты, и когда сервер 100% падает, тл перекатываешься на другой. Напиши батники для переключения серверов и кинь на каждую машину. На всякий случай научись быстро отключать слейвы и мастеры, если один из них накроется. И настрой бэкапы на слейве, но не юзай их без необходимости.

>Есть система мониторинга в фирме?

"А что это?" Серьезно, только 2 сервака с Windows Server 2012 r2 на борту. Ну там pgAdmin, но не думаю, что он чем-то поможет.

Основная проблема: ок, слейв переключился в мастер. Но когда мастер вновь поднимется, неизвестно же. То есть на момент запуска сдохшего мастера у нас параллельно два мастера. Как его вовремя задемоутить, чтобы не похерить базу? Запускать при загрузке службу только после проверки роли второго сервера? Это за гранью моего понимания.

Бекапы есть на мастере. Настроить на слейве точно так же, вроде, не проблема, это пока даже не горит.

Вообще это моя первая сколько-нибудь серьезная работа в IT, до этого только писал сайтики на вордпрессе и админил локалхосты в гос. учреждении. К понедельнику надо уже предоставить готовый отказоустойчивый кластер, и у меня все сильнее поджимает. Это вообще нормально тупить по 2 недели на таких задачах?

Выпроси сервер на который ты поставишь Zabbix тебе нужно сделать пару вещей, поставить модули забикса на эти серваки, и заставить их общаться. Если понимаешь, что один сервер ебанулся и не отвечает минут 5: то лезешь на машину и включаешь батник, чтобы слейв стал мастером. В это время, если у тебя есть доступ к мастеру, то гасишь деятельность сервера и переводишь его уже в слейв( обычно такое не работает, так как у тебя сеть/отказ системы/подыхание хардов) .

Далее план таков: система мастера воскрешается, если разницы в redo мало, и какой-то уебан не переключился на него во время его отключки и не внес изменения - догоняешь его со слейва, если внес - ищешь scn переключения, откатываешься на него и дожираешь redo со слейва.)

Если все очень плохо - ты же делаешь бэкапы? )

Тебе надо будет восстановить до слейва( поэтому я и написал про включение wal+backup на слейве), а потом поменять их с мастером.

спасибо

База данных postgresql 10.

Делаю селект в psql, получаю такую ошибку.

>[22021] ERROR: invalid byte sequence for encoding "UTF8": 0xf0 0xe5 0xec 0xee

При выгрузке дампа и попытке его импортировать та же самая ошибка.

Посему несколько вопросов:

1) Как non-utf8 текст вообще попал в базу? Postgres при вставке не проверяет кодировку или не конвертирует в server_encoding?

2) Как это можно исправить на текущей бд?

3) Как это можно воспроизвести? Как вставить non-utf8 байты в базу? Я нихуя не понимаю. Это нужно будет чтобы протестировать исправление.

4) Как сделать так, чтобы это больше не повторилось?

Спасибо. А без внешнего сервера - никак? (сервер не выделят, потому что их просто нет, будет мифическая "циска", о которой никакой информации пока нет). Слейв сам может мониторить доступность мастера? Я вижу это так: тот же батник с автоматическим пингованием сервера (или проверкой доступности бд на нем, но это сложнее). Если пинг не проходит некоторое время, то все - становимся мастером. На клиенте (или на "циске", если такое возможно) можно тупо обращаться ко второму серверу, если первый не отвечает. Конечно, он может быть пока еще слейвом и не принять запрос, но это лучшее, что я пока придумал. В общем, мозгов у меня решительно не хватает, походу так и передам начальству.

Ну, клиенту надо как-то проверять доступность. У тебя нет брокера, поэтому есть системы мониторинга, которым можно прописывать сценарий.

Вот клиент ебашит на бд, а потос как он узнает, что бд упала и перешла на слейв? Поэтому ставят либо брокера, либо систему мониторинга.

В оракл к примеру на клиенте есть tnsnames в который можно писать куда конектится, если мастер упал.

И то у тебя должна быть недоступность мастера, чтобы кто-то не нашкодил. Если есть такой механизм, то все гуд и тебе лишь надо ловить момент когда падает мастер.

Как клиент проверяет доступность: пишет запрос, если он не выполняется, пингует сервак (или что-то там еще), если тот не отвечает, пишет запрос на другой сервак (сервака два, айпишники захардкожены). Это я сам только что придумал, но, думаю, реализовать будет несложно.

Насчет недоступности мастера не понял. Механизма такого, скорее всего, нет, если это не описанный мой выше бред.

Огромное спасибо, что тратишь время на меня. Но, походу, проебу я все-таки эту работу. Не помещается все это у меня в голове.

Мастер не должен пинговаться, дибо он должен усиленно всем показывать что он не мастер.

Чувак, нахуй ты за это взялся? Ты там на должность администратлра бд устроился?

Помоги с етой хуйней, Анон

Инженер-программист официально ) Месяц назад пришел, ну и скинули на новичка то, что сами не знают, как делать. В любом случае, поговорил с начальством, если вообще не будет получаться, наймем какого-ндь крутого ДБА для настройки.

Вот, кстати, на такую интересную штуку наткнулся:

https://habrahabr.ru/post/308950/

Там даже исходник есть. Надеюсь, завтра это решит все мои проблемы )

Set client_encoding to unicode

По умолчанию стоит.

Просто не копируй селекты из интернета в консоль. Он просит у тебя юник, а ты, блядь, кидаешь ему поганный 1251

Если и не так, то никакая база не декодирует в свою кодировку.

Смотря какой язык юзаешь, чтобы не мучаться в винде есть ATL конвертеры.

У тебя просто какой-то чувау может вводит данные в вин1251

В базе есть функции ascii, decode , encode. Последние для битовых данных.

initdb -E encodename

Автоматическая конверсация из пскл \encode win1251

Если есть прослойка то настрой libpq в приложении

а можешь привести пример?

есть таблица - id, имя, фамилия, отчество, год рождения и т.д. и она привязана через id к таблице техника сотрудника, где поля такие:

id техники, тип, модель, марка, серийный номер, номер ЦСО. Как индексация здесь может, что либо оптимизировать?

Сотрудников у тебя, положим, будет десять тысяч человек.

У каждого будет по десятку девайсов - итого в таблице девайсов 100 тыс. записей.

Допустим, у тебя есть условный сотрудник Сычев. Ты хочешь найти для него всю технику.

Без индекса тебе придется перебрать все 100 тыс. записей в поисках техники именно Сычева.

100 тыс. ради 10 записей. А если базу постоянно теребят даже несколько десятков человек, то все будет очень медленно. А если нужно получить список сотрудников с девайсами, то будет еще медленнее. А если таблица не помещается в память, то добавятся издержки дисковых операций.

Теперь создаем индекс для техники по ид сотрудника.

В общем случае строки в таблицах хранятся неупорядоченно, а индекс отсортирован (обновление происходит при каждом изменении автоматически).

На отсортированном наборе данных поиск происходит очень быстро.

Например, чтобы найти двоичным поиском на отсортированном наборе из 1000 записей одну, нужно просмотреть не более 10 значений, а на 100000 - не более 17.

Т.е. вместо просмотра n записей ты просматриваешь log (n) записей.

В СУБД используются более сложные алгоритмы, чем двоичный поиск, но они тоже работают за логарифмическое время.

Итак, мы нашли кусок в индексе, который отвечает за технику Сычева. Теперь СУБД перебирает найденные значения индекса и вытаскивает оттуда указатели на физическое расположение строк в таблице девайсов. Т.е. не нужно перебирать 100 тыс. записей, а берем конкретный блок данных и берем конкретные записи в нем. Доступ к данным проходит на низком уровне, очень быстро.

Так же индекс помогает при удалении Сычева из таблицы сотрудников - нам ведь надо удалить или пометить null все его девайсы и других операциях с изменениями данных.

Воте еще очень простой пример, есть дом на 250 квартир и тебе нужно найти квартиры, в которых есть белая собака. Ты можешь обойти все квартиры, спрашивая, есть ли у вас собака. А с индексом у тебя изначально есть список квартир, в которых есть собака допустим их 20 (это если у нас индекс только по виду животного, кошка-собака-крыса-хомячок-попугайчик, а еще можно добавить в него цвет). Среди 20 квартир ты довольно быстро найдешь белых собак.

Сотрудников у тебя, положим, будет десять тысяч человек.

У каждого будет по десятку девайсов - итого в таблице девайсов 100 тыс. записей.

Допустим, у тебя есть условный сотрудник Сычев. Ты хочешь найти для него всю технику.

Без индекса тебе придется перебрать все 100 тыс. записей в поисках техники именно Сычева.

100 тыс. ради 10 записей. А если базу постоянно теребят даже несколько десятков человек, то все будет очень медленно. А если нужно получить список сотрудников с девайсами, то будет еще медленнее. А если таблица не помещается в память, то добавятся издержки дисковых операций.

Теперь создаем индекс для техники по ид сотрудника.

В общем случае строки в таблицах хранятся неупорядоченно, а индекс отсортирован (обновление происходит при каждом изменении автоматически).

На отсортированном наборе данных поиск происходит очень быстро.

Например, чтобы найти двоичным поиском на отсортированном наборе из 1000 записей одну, нужно просмотреть не более 10 значений, а на 100000 - не более 17.

Т.е. вместо просмотра n записей ты просматриваешь log (n) записей.

В СУБД используются более сложные алгоритмы, чем двоичный поиск, но они тоже работают за логарифмическое время.

Итак, мы нашли кусок в индексе, который отвечает за технику Сычева. Теперь СУБД перебирает найденные значения индекса и вытаскивает оттуда указатели на физическое расположение строк в таблице девайсов. Т.е. не нужно перебирать 100 тыс. записей, а берем конкретный блок данных и берем конкретные записи в нем. Доступ к данным проходит на низком уровне, очень быстро.

Так же индекс помогает при удалении Сычева из таблицы сотрудников - нам ведь надо удалить или пометить null все его девайсы и других операциях с изменениями данных.

Воте еще очень простой пример, есть дом на 250 квартир и тебе нужно найти квартиры, в которых есть белая собака. Ты можешь обойти все квартиры, спрашивая, есть ли у вас собака. А с индексом у тебя изначально есть список квартир, в которых есть собака допустим их 20 (это если у нас индекс только по виду животного, кошка-собака-крыса-хомячок-попугайчик, а еще можно добавить в него цвет). Среди 20 квартир ты довольно быстро найдешь белых собак.

Мех. Немножко не так. Будет у тебя 100 сотрудников - будет 100 таблиц?

В таблицу техники добавляется айди того, кому она принадлежит.

Это проще апдейтить.

Чтобы запилить индекс тебе нужны уникальные айди, которые часто вызываются, но не равны 70% таблицы.

Давай такой пример.

У тебя есть таблица с документами и есть битовый признак обработки документа(1). Допустим у тебя 70% обработано и 30% нет.

Как ускорить таблицу? Инвертируешь признак обработки, то есть 0 - обработан, а индекс делаешь по оставшимся 30% .

То что ты описываешь скорее всего предпологает индекс-таблицу. Т.е. ты сортируешь данные по ключам. В твоем случае лучше делать ключи связанные с айди техники. Это лучший вариант, да и по айди техники тоже.

Но то что ты описал похоже на вложенную таблицу. То ест столбцы , а потом связанный по айди список техники, аля ообд.

Либо просто сделать первичный ключ по айди сотрудника, во второй бд первичныц по айди техникт, вторичный айди сотрудника

извините, что туплю. Белая собака в моем примере - это как определенный вид техники, да? То есть будет разумно создать индекс, например, для принтеров LaserJet p9313, чтобы узнать у кого такие принтеры?

>Просто не копируй селекты из интернета в консоль.

Ват.

>Он просит у тебя юник, а ты, блядь, кидаешь ему поганный 1251

Я нихуя не понел почему ты подумал, что я что-то откуда-то копирую. Просто делаю выборку на рабочей базе. Сама база на серваке под CentOS 7. Подключаюсь по ssh.

>>172316

Алсо почему вы думаете, что это именно win1251?

Да, это как определенный вид техники.

Если говорить о второй части вопроса, то индекс создается для колонки, а не для ее конкретных значений. Т.е. если у нас в колонке есть принтеры, сканеры, ксероксы и ноутбуки, то индекс будет содержать все эти типы. Можно, конечно, сделать функциональный индекс вида case when device_name = 'LaserJet1488' then 1 else 0 end но это довольно редкий прием - на каждый вид девайса индексов не напасешься.

Может помочь индекс по виду (принтер, ноутбук, сканер), по фирме-производителю, а можно сделать индекс по модели девайса (точнее, по upper(device_name)) или составной по нескольким полям, поставив более селективные поля вперед. Тут уже нужно смотреть по месту, как и что у тебя хранится и какие запросы наиболее характерны.

Допустим, сделали индекс по upper(device_name), тогда в запрос будем передавать введенную строку поиска в верхнем регистре и получаем набор записей для владельцев девайсов. А чтобы быстро расшифровать ид владельцев в их фио, поможет индекс по ид сотрудников - он будет уникальным и поэтому очень быстрый.

спасибо, друже, просветил

19 Кб, 584x175

19 Кб, 584x175Есть таблицы на пикриле. Допустим в таблице users такие записи:

1 | Peter

2 | Fedor

3 | Vasily

В таблице stuff такие записи:

1 | 1 | shirt

2 | 1 | hat

3 | 1 | shoes

4 | 2 | gloves

5 | 2 | coat

6 | 3 | dress

Нужно составить запрос который вернул бы такой результат:

1 | Peter | shirt, hat, shoes

2 | Fedor | gloves, coat

3 | Valisy | dress

Я так понимаю тут нужно использовать агрегатную функцию и конкатенация, но как именно не могу сообразить.

Разобрался, GROUP_CONCAT() нужна.

- построчное резервирование

- хранимая поцiдура с проверкой значений

- журнал «кто что и когда делал с данными в таблице»

Тут в каждой субд будет разная функция для этого.

45 Кб, 381x604

45 Кб, 381x604Я не батя, но:

>построчное резервирование

Нахуя, в чем задача? Нихуя не понятно. Скорее всего ты имеешь ввиду триггер.

>хранимая поцiдура с проверкой значений

Тоже непонятно в чем подводный камень и зачем.

>журнал «кто что и когда делал с данными в таблице»

Через триггер. На практике, если такое нужно сделать, то заказчик наглухо ебанутый. Нужно сделать не журнал, а отдельные поля и все это должно заполнятся фронтом. В остальных случаях это бессмысленно. Если тебе нужен аудит юзеров с правами на DML, то ты лох, пидор и нахуй из профессии.

>На практике, если такое нужно сделать, то заказчик наглухо ебанутый.

Что плохого в том, чтобы знать историю изменений записи?

> Нужно сделать не журнал, а отдельные поля и все это должно заполнятся фронтом. В остальных случаях это бессмысленно.

Поясни идею с полями, причем тут фронт-енд и тезис о бессмысленности, почему так?

>Если тебе нужен аудит юзеров с правами на DML

Что ты тут подразумеваешь?

Эй еба-ораклист, ты бд то свою знаешь?

1) локи же есть. Ты просто избалован, так как у оракла это в ядре.

2) через триггер всегда делается

3) аудит средствами оракла, тебе про такое никогда не говорили?

Я не он, можешь объяснить, какое отношение имеет триггер к проверке параметров хранимой процедуры?

18 Кб, 446x280

18 Кб, 446x280То, что вы на заводилова, дрочите —

ПИШИТЕ БЛЯДЬ, ЗУБАРЮ!!!

И запрашивайте, данные.

>Скорее всего ты имеешь ввиду триггер.

Вот и пиши триггер.

>Тоже непонятно в чем подводный камень и зачем.

Игорь, если я ещё раз такую хуйню, услышу — я запишу все расходы на комплексе — на вашу группу. Вы у меня штаны последние продадите.

>Нужно сделать не журнал, а отдельные поля и все это должно заполнятся фронтом.

Чо блядь у вас, дерьмократия?! Забудьте нахуй о дерьмократии. Пока у вас каждый кладовщик знает SQL, тут везде тоталитаризм, будет!

>>173428

Нет потенции — сваливай нахуй, с рынка!!!

>>173501

ПРОСРАЛИ ВСЕ ПОЛИМЕРЫ!!!

ВЫ ПРОСРАЛИ БЛЯДЬ!!!1111ы

>Что плохого в том, чтобы знать историю изменений записи?

>Поясни идею с полями, причем тут фронт-енд и тезис о бессмысленности, почему так?

Само по себе ничего, ее и хранить в ней можно, но звучит как: "Есть важный ручной справочник и мне нужно знать какая именно макака его заполняющая накосячит, чтоб лишить ее премии". Заполнение пользователем справочника через dml говорит о незрелости процесса. В самой таблице должны быть заполняемые автоматически, скрытые для пользователя поля(кто добавил запись, время добавления итд.), за этим и нужен фронт, АРЕХ, например.

>>173485

>аудит средствами оракла, тебе про такое никогда не говорили?

Говорили, но >Если тебе нужен аудит юзеров с правами на DML, то ты лох, пидор и нахуй из профессии.

К тому же эта штука медленная и базу нагружает.

>локи же есть. Ты просто избалован, так как у оракла это в ядре.

Я вообще задачи не понял. Зачем нужно построчное резервирование(репликация что ли?) и причем тут локи?

Apex это фронт? Что же тогда бэк?

Штатное редактирование справочников dml? Это где такое есть? Все только через бизнес логику, и неважно где она- в хранимках или на сервере приложений.

Да и коннект пользователей в бд под уникальными логинами имхо анахронизм.

>В самой таблице должны быть заполняемые автоматически, скрытые для пользователя поля

Не в той же таблице. А в отдельной схеме (schema), с другими правами доступа, создаётся точная копия каждой таблицы.

>Да и коннект пользователей в бд под уникальными логинами имхо анахронизм.

Андрей Орлов, «Записки автоматизатора».

Читать до окончательного просветления.

Книга хорошая, читал, хотя и не самую последнюю версию.

Если что я говорю про то, что коннект в бд происходит под одним логином, но имя пользователя (например, доменная УЗ) при этом передается и обрабатывается.

>>построчное резревирование

Том Кайт, штудируй.

>>аудит DML

Фейербах, Прибыл. Есть безопасность на уровне строк.

Плюс кто тебе не позволяет анализировать undo/redo? Аудит можно хранить не на этой же бд, обычно так и делают.

Если есть проблема что какое-то говно срет в систему организуешь сбор доказательств включая выборочно аудит скриптов. Если конечно этот ебушка не срет анонимными блоками.

То что ты не можешь оптимизировать аудит, это пиздец твои проблемы.

Ты можешь сохранять все инсерты/апдейты из системных схем, и переносить их на спец.серверы или во внешний файл, а потом анализировать.

>построчное резревирование

>Том Кайт, штудируй.

Ты объясни что это или напиши как называется на английском.

>Фейербах, Прибыл. Есть безопасность на уровне строк.

Хуербах, блять! Если ты не можешь выстроить ролевую модель и процессы так, чтоб тебе не понадобился аудит, то иди нахуй. Придумай хотя бы один кейс где это действительно нужно.

>>173540

Зачем?

>>173538

Есть такая штука как контекст.

>Да и коннект пользователей в бд под уникальными логинами имхо анахронизм.

Хуясе, поясни.

>>172906

Что это за прикольная картинка? Мне сказали учить MySQL и там кроме командной строки нихуя нет.

аноны, есть книга где примеры наsql server 2000, у меня спермерка. что можно ставить, чтобы осваивать sql?

>Да и коннект пользователей в бд под уникальными логинами имхо анахронизм.

>Хуясе, поясни.

Провокационное высказывание получилось, выше писал:

>>173642

Речь идет о конечных пользователях, например Светлана Ивановна из бухгалтерии или Аня из кадров. Удобно, если для всех задач они используют единую УЗ. Особенно это удобно если приходится работать с несколькими разнородными БД.

105 Кб, 1080x1080

105 Кб, 1080x1080>1174725

Спасибо тебе, на добром слове анончик

106 Кб, 225x225

106 Кб, 225x225какой должен быть минимальный набор для освоения SQL?

имею спермерку или Linux.

Ставить Microsoft, Postgre, MySQL?

Блед. Я тебе говорю, у тебя построчное резервирование уже в бд есть. Допустим у тебя постят две пидорашки в одну таблицу, и у тебя ебучий айди генерится сам без задвоений. Кайт приводит, что этот пиздец не в каждой бд был и есть, и он охуел, когда узнал что в оракле это есть, а он сам это пилил.

По вторлму пункту. Это нужно, когда у тебя система может быть скомпрометирована, или какой-то мудень решил пошатать целостность. Буквально если ты работаешь в банках, то там в 90% случаях есть бд, которая копит аудит по абс, чтобы ты оптимизировал затраты и смотрел, чтобы пидорашко-программист правильно инсертил или апдейтил справочники.

То на что я тебя сослал это RLS. Допустим у тебя есть база клиентов общая, и каждое структурное отделение должно видеть только своих клиентов. Что сделать неуч? Создаст пол каждое подразделение вьюху, а ораклист ебанет RLS. Это простейшие политики безопасности. Позволяет так же следит за аудитом избранных юзеров, а не всех. Просто добавив им еще одну политику. Чтобы не быть голословным пакет dbms_rls.

бамп

Ищи платные гайды в свободном доступе.

Как ты обобщил джойны и дистинкт? джойны объединяют таблицы. Дистинкт в результатах выборки отсекает повторяющиеся значения в пределах стоблца, в котором он указан.

мне плоха

137 Кб, 900x900

137 Кб, 900x900>Допустим у тебя постят две пидорашки в одну таблицу, и у тебя ебучий айди генерится сам без задвоений.

ПОСТРОЧНОЕ РЕЗЕРВИРОВАНИЕ, БЛЯТЬ! Это называется изоляция транзакций. И как минимум REPEATABLE READ есть в любой современной СУБД. Хотя иногда даже READ UNCOMMITTED включают ради производительности.

Б

>Буквально если ты работаешь в банках, то там в 90% случаях есть бд, которая копит аудит по абс, чтобы ты оптимизировал затраты и смотрел, чтобы пидорашко-программист правильно инсертил или апдейтил справочники.

Такое у всяких диасовтовских абс на сайбейсе, у оракла ни разу не видел отдельной базы под аудит(и можно ли такое вообще сделать?). В абс макаки инсертят через фронт. У разработчика вообще максимум права на селект должны быть проде и препроде. Такой способ защиты может помочь только от дба.

>Что сделать неуч? Создаст пол каждое подразделение вьюху, а ораклист ебанет RLS.

Лучше вообще никого в базу не пускать и ебануть отчет в BI, чтоб тетя срака не джойнила таблицу саму с собой десять раз и не вешала базу.

прошу прощения за оффтоп

а для рашки зп в полтора косаря уе - это норма или хуйня для итшника или для обычного рабочего?

Пошел работать в 21 учась на пятом курсе.

В 24 имею достойную ЗП, нашел годное место, счастлив, продолжаю расти как специалист

Причем тут питон?

Что тебя смущает? Если у тебя разовая загрузка, и все работает за устраивающее тебя время, то все норм.

То что не каждую запись коммитишь - правильно.

И что у тебя за БД?

Например, в Орагле есть специальная утилита для загрузки данных, которая на низком уровне хуячит гораздо быстрее, чем DML. В твоей БД есть такое? Если да, до парси XML до csv например и его скармливай загрузчику.

Под виндовс 7 ставятся все sql серверы вплоть до 2014го.

В какой СУБ это реализовано? В MS SQL можно разве что разрешить группе пользователей ОС входить в SQL, и каждый из них может подключаться под логином винды как trust connection.

>Причем тут питон? Что тебя смущает?

Наверное проблема в том что я не до конца понимаю session'ы и вообще "архетектуру" SQLAlchemy.

>То что не каждую запись коммитишь - правильно.

Окай.

>И что у тебя за БД?

PostgreSQL, только пару дней назад не без труда впервые накатил на винду.

>В твоей БД есть такое?

633 Кб, 1282x592

633 Кб, 1282x592 11,2 Мб, webm,

11,2 Мб, webm,631x420, 4:33

>>176804

>Причем тут питон? Что тебя смущает?

Наверное проблема в том что я не до конца понимаю session'ы и вообще "архитектуру" SQLAlchemy.

>То что не каждую запись коммитишь - правильно.

Окай.

>И что у тебя за БД?

PostgreSQL, только пару дней назад не без труда впервые накатил на винду.

>В твоей БД есть такое?

Я не хочу пока лезть во всякие тулзы, мне бы базово разобраться с реляционными СУБД и SQLAlchemy. Хотя похоже SQLAlchemy не очень подходит для такого переноса базы, но я продолжу пердолиться.

Аноны, такая задача:

мне нужно собирать показания с прибора, ~200 цифровых значений каждые несколько минут.

Я уже начал гуглить и сравнивать БД для хранения временных рядов, но наткнулся на один пост в инете и задумался:

"А так ли нужна мне БД для этой задачи? Могу ли я обойтись файловой системой?". Вот смотрите:

1) Изменять данные не требуется, только записывать и (надеюсь когда-нибудь) читать.

2) Как именно, какими кусками и в какой последовательности данные будут читать я хз, на данный момент сказать сложно.

3) Я могу раскидать файлы по папкам, разделив, например, по месяцам и дням, т.е поиск не станет большой проблемой.

Внимание вопрос: какие подводные?

С многопоточностью проблем вроде быть не должно.

Если идея с ФС звучит норм, то какой формат данных подойдёт для моей задачи? csv + gzip (bzip2?), hdf5?

Ещё, возможно не по теме, но хочется хранить данные минимум в 2 местах, какую распределённую ФС можно выбрать под эту задачу? Какие вообще используются? Гуглёж показал что существует несколько вариков, да и я сталкивался поверхностно с HDFS, но не хотелось бы лезть в хадуп инфрастракчер.

7 Мб, webm,

7 Мб, webm,316x420, 3:21

А то я никак не могу запомнить эти три буквы, блять.

Как версионировать структуры?

Объекты понятно. Хез_мэни вержнс и создаем копию.

А что делать со структурами, когда, например, есть конкурс, который состоит из этапов, которые состоят из испытаний. У всего есть свои свойства, последовательность и т.п. Короче структура. И вот она со временем эволюционирует, меняется состав, порядок и сами сущности. При этом есть прошлое, в котором проходили соревнования по старым версиям и есть уже запланированное настоящее, которое хочется при выпуске новой версии тоже проапдейтить.

Вот как это блять изящно версионировать? Я понимаю, что ответ достаточно очевидный - копировать и поддерживать целостность. Но может существуют какие-то практики и я просто не знаю.

Спасибо, Анон, буду копать глубже эту тему. А есть опыт работы с этой связкой, или это теоретическая рекомендация? Никогда просто о таком не слыхивал ранее! (тем ценнее рекомендация)

>>176986

Можешь развернуть свою мысль? У меня была похожая как только сея идея посетила мою голову, но потом она перестала казаться мне такой уж тупой, ведь из всех ништяков настоящих БД мне нужна по сути только репликация.

>Что за криворукие ублюдки ее делали?

Вот этот ублюдок накосячил :

>>176941

На самом деле тебе нужно задать явный формат даты для загрузки в твоем скрипте, а не думать, что СУБД сама догадается.

Это из разряда good practice. СУБД может разные настройки, а скрипт должен работать всегда.

Поэтому распиши преобразование из строки в дату с явным форматом.

Я генерирую данные в другой ИДЕ и просто вставляю. Ну ок, но скорее всего погуглю как правильно формат делать, и просто попытаюсь в кавычки вставить

Ты совсем дурак, бля? Ты не мог даже чуть-чуть теорию почитать? Будешь с каждым вопросом сюда приходить? Иди на хуй пидорас

91 Кб, 460x666

91 Кб, 460x666pg_ctl службу запускает или нет?

Так зайди в список служб и проследи, хули ты как этот

Все зависит от того для чего ты хранишь данные и какие задачи будешь решать. По твоему описанию может подойти все что угодно.

>все что угодно

а чо там выбирать? NoSQL вместо выбора ФС и key+value вместо выбора формата данных, ведь для снятия статистики творческого мигания светодиода на ардуинке постгрес в его случае нинужен

6 Кб, 205x200

6 Кб, 205x200>>117755

Ты Ванга? откуда ты знаешь что нужно в его случае?

>~200 цифровых значений каждые несколько минут

Ардуина будет генерировать ~овер 6*10^8 значений в год. Если нужен какой-нибудь Ad hoc-анализ "что за хуйня произошла позвачера", то лучше всего запилить выгрузку csv-лога с ротацией.

Если нужен анализ с машинлернигом и всей хуйней за 100 лет, то Hadoop. Если за год, то Python + csv-лог в фс.

Если нужен отчет в котором будет динамика скорости мигания светодиода в разбивке по датам, то RDBMS-name.

Если на основе основе данных ардуины нужна какая-нибудь операционная хуйня с огромным количеством чтений, то key-value(самый невероятный вариант).

> А есть опыт работы с этой связкой, или это теоретическая рекомендация?

Есть опыт в разных ситуациях и конфигурациях.

> перестала казаться мне такой уж тупой

Сама по себе перестала, видимо, потому что ты её не обдумывал.

Смотри:

> Как именно, какими кусками и в какой последовательности данные будут читать я хз, на данный момент сказать сложно

То есть тебе еще сложно сказать, как у тебя все на базовом уровне будет организовано, но ты уже с каких-то хуёв решил, что с ФС тебе будет лучше работать. Далее ты несешь про какое-то разбивание по папкам, и эту хуйню просто лень комментировать.

Мой тебе совет: бери хоть реляционку, хоть нереляционку, и делай свою хуйню, стараясь не выебываться.

в JSON пердоль, чо как не пердоля?

{"Lat":"123","Lon":"231"}

Суть в том, что мне нужно сделать из неё jsonb, но так, чтобы значения были нумерик, а не текст. Обычный alter, который set type jsonb using col::jsonb переводит в обычный текст (значения в кавычках), а мне нужно от этих кавычек избавиться. Как быть?

>сиквел

Сиквел (англ. «sequel» [siːkwəl], от лат. «sequella» — «продолжение», «приложение») — книга, фильм или любое другое творческое повествование, по сюжету являющееся продолжением какого-либо произведения.

Ты ваще о чём?

Ну главное то, что ты дартаньян, да.

> ПРОСТА ТАК, БЕЗ СВЯЗЕЙ

Главный вопрос тут такой: зачем вообще брали РСУБД? Господи, сколько я подобных быдлобаз переделал — не сосчитать.

> нельзя удалить юзера какого-нибудь, если не удалил его высеры на форуме например

ON DELETE CASCADE. СУБД следит за целостностью данных, а разработчик при создании таблицы не указал политики удаления данных.

> связи они главное в голове и в коде

Когда перестанешь делать гостевухи, поймешь, что был неправ. Ну или же если будешь работать не один.

> мб я что-то упускаю или не понимаю?

Упускаешь и не понимаешь. Смысла вот только пояснять нет, ибо ты уже выразил скепсис, не разобравшись в теме абсолютно. Либо ты понимаешь, что делаешь, либо нет.

И никто тут особо не против нереляционщины, бородатых адептов Кодда в треде нет. Просто такие ребята и в Монге такую хуету городят, что глаза на лоб лезут.

Попробуй найти примеры открытия одной бд, потом остальные так же открываешь и аппендишь, что-ли.

>в вебе

>в небольших проектах

Тебе не нужно искать ответы на свои вопросы, потому что ты веб-макака — пародия на разработчика. Оставь реляционную алгебру специалистам совершенно другого уровня квалификации и продолжай пилить говносайты за мелкий прайс.

Вот тут то и проблема, не могу найти годный пример для этого. Да и я не особо это все понимаю, мне бы вот литературы какой или туторчиков на ютубе что бы с нуля все делать.

А почему именно делфи? Чем богоизбранный быдлер на плюсах не угодил?

Восстановление, переводы.

Гугли ADO компоненты в Delphi (не ADO.NET, это другое). Сейчас уже не помню подробности, но все необходимое имеется. Можно, например, сделать комбо-бокс с выбором таблицы и отображением результатов в гриде. Можно вывести в грид результаты запроса или хранимой процедуры. И не нужно ничего дополнительно устанавливать (как в BDE), все уже встроено в винду.

10 Кб, 527x130

10 Кб, 527x130Во всяких dwh вообще нет связей. Такие базы очень больше, со связями кучу задач просто не решить. Связи - это инструмент, использовать его или нет решать тебе.

144 Кб, 873x948

144 Кб, 873x948Ньюфаг с платиной и ms-sql на связи.

Как вы работаете с дохуя количеством данных в интерфейсе?

Вот например есть абстрактное овердохуя количество записей (с байтмасивами) и если я попытаюсь сделать просто

>select * from zhopa

ляжет прога.

Так вот, следовательно, максимум пока что я придумал - поставить юзверю 2 поля - с какого поля и до какого поля вывести записи с таблицы, а там он уже сам разбереться.

Как вообще это на практике выглядит и как делают местные олдфаги?

Есть какой-то сайт с платиновых процедур?

Нужна процедура которая выдает таблицу с н-ного начала и до н-ного конца.

Есть ли в таблице конкретно № записи, не поле-айдишник, а именно № записи (чтобы циклом в процедуре выше пройти)?

Или я слишком заморочился?

Ты вообще хуево структурировал базу, переделывай. Столбцы в таблицу добавлять — не такое же рутинное мероприятие, как добавление строк.

Нихуя не понял, причем тут структура базы, я ее вообще не упоминал и не за это спрашивал.

у тебя говно намешано на уровне бд, раз в бд столько столбцов, которые не нужны конечному пользователю.

Обычно конечный не должен видеть лишнего, либо делай вьюшку, либо еби конём свою структуру.

Как вам доки к 18?

Есть у кого книга про advanced tuning от Бурлесона?

И вообще есть ли аналоги данной книги?

> я ее вообще не упоминал

Это не значит, что я не имел возможности понять, какой пиздец у тебя там творится.

> не за это спрашивал

Тебе нужно решить проблему, я тебе говорю, куда нужно смотреть. Костылями и изолентой можно сделать то, что ты хочешь, но это один из самых тупорылых вариантов. Переделывай, тебе нужно твои дохуя столбцов вынести в отдельную таблицу. Совета конкретнее дать при таких данных нельзя.

>>182341

Сём, блять, нормально же блять вроде вопросы сформулировал.

Какие нахуй блять столбцы ты себе нафантазировал, какая блять впизду вьюшка?

Я не за выборку спрашиваю, я спрашиваю за отображение записей в конечном графическом интерфейсе для околоадмина/заказчика и как лучше/правильнее с этим совладать, кроме как выгрузить сразу всю базу, а то на что ты отвечаешь это уже совсем другой вопрос.

Или это такой местный тролинг тут?

Ты не разбираешься в самых азах. Всю базу выгрузить для интерфейса — вообще лхуительные истории.

САП ДВАЧ, Я НЬЮФАГ, КАК НАПИСАТЬ ХЕЛОУ ВОРЛД

@

-СХОДИ В КАЧАЛКУ И ПСИХОЛОГУ, ПОБРЕЙСЯ, ПОЧИСТИ ЗУБЫ И КЛЕЙ ТЯНОЧЕК НА УЛИЦЕ

@

НО Я ВЕДЬ Я ЭТО НЕ УПОМИНАЛ

@

-ЭТО НЕ ЗНАЧИТ ЧТО Я НЕ ИМЕЛ ВОЗМОЖНОСТИ ПОНЯТЬ ЧТО У ТЕБЯ ПРОБЛЕМЫ С ТЯНКАМИ

@

НЕ ЗА ЭТО Я СПРАШИВАЛ

@

-ТЕБЕ НУЖНО РЕШИТЬ ПРОБЛЕМУ, Я ТЕБЕ ГОВОРЮ КУДА СМОТРЕТЬ

Тащемта я вообще не ожидал что мне тут даже отпишут, лучше чем ничего.

Ты хуйню несешь и никакой конкретики не даешь.

САП ДВАЧ, Я НЬЮФАГ, НО У МЕНЯ ЕСТЬ ЕБАНУТЫЙ ВОПРОС И ЕБАНУТОЕ ПОНИМАНИЕ СУТИ ПРОБЛЕМЫ

@

НЕ ДЕЛАЙ ХУЙНЮ, СДЕЛАЙ НОРМАЛЬНО И ПРОБЛЕМЫ НИКАКОЙ НЕ БУДЕТ

@

ТЫ ХУЙНЮ НЕСЕШЬ, ЖДУ ДРУГИХ СОВЕТОВ

@

НЕ ДЕЛАЙ ХУЙНЮ, ПОДУМАЙ

@

ТУПЫЕ АНОНЫ ОПЯТЬ ПЫТАЮТСЯ МЕНЯ ЗАТРОЛЛЕТЬ

Скинешь схему БД — поясним конкретно.

> Вот например есть абстрактное овердохуя количество записей (с байтмасивами) и если я попытаюсь сделать просто

> select * from zhopa

Почитай описание селекта в документации. Там есть ключевые слова LIMIT и OFFSET. Никто никакую базу никуда не загружает, если не совсем долбоеб. Гугл на твой вопрос за секунду ответит.

Одну. Ты не понимаешь, что делаешь. Пиздуй читать статьи для ньюфагов. Тебе абсолютно бесполезно отвечать на данном этапе.

Так ладно, попытаюсь по другому пояснить:

Мне надо (все столбцы блжад) конкретную таблицу (из которых может выбрать пользователь) вывести для просмотра. Сейчас у меня затычкой в программе стоит

> select * from zhopa

но, так как записей в будущем может быть теоретически дохуя, я резоно подметил что мое конечное говноприложение может лагать при загрузке/просмотре.

И поэтому все что я пока изобрел либо загружать в мою прогу допустим по 1к записей из таблицы либо дать возможность пользователю выбрать по какому-то фильтру (например загрузить с 40 по 1200 запись).

И поэтому спрашиваю как выводят таблицу для просмотра местные гуру-аноны.

Либо пагинация используется, либо запрашивается для листинга минимум данных, а при необходимости запрашивается уже и остальное. Никто всё в памяти не держит, это типичная ошибка мудаков, которым лень статьи для самого начального уровня почитать.

https://doc.qt.io/archives/qq/qq07-big-tables.html

Вот так вот и сразу, спасибо

>Никто всё в памяти не держит

Отобразить же мне как-то нужно изначально

> Отобразить же мне как-то нужно изначально

Это не требует того, чтобы все в памяти держать. Насколько я понимаю, у тебя там сишарпопараша, наверняка ASP.NET, поэтому кури пагинацию, как у всех остальных. Если все же под десктоп пилишь что-то, то просто таблица нужна, держущая в памяти только определенное «окно» (видимая часть плюс еще по N строк выше-ниже; только не ручками говнокодь, а приложи усилия и изучи гугл на эту тему, чтобы нормальную обертку написать).

если ты хочешь заебаться, то можешь сделать подгрузку, как в крутых TOAD/Workbench.

грузишь первые 500, когда пользователь пролистал до 500, то подгружаешь ещё 500.

Но если твой заказчик такой мудак, что хочет за раз 10к записей без фильтров, то тебе пиздец.

99 Кб, 264x225

99 Кб, 264x225http://www.itprotoday.com/microsoft-sql-server/logical-query-processing-clause-and-joins

А, понял, у него там иннер жойн и аутер жойн выдавали один и то же результат, даже когда были non-matches, потому что он не там ON поставил.

Пользователю дохуя записей в интерфейсе не нужно. Для того, чтобы получить вменяемое количество записей нужны фильтры.

Если же все-таки ты думаешь, что тебе нужно таскать из базули тысячи записей для отображения в интерфейсе (на самом деле нет), то посмотри что такое пейджинация.

>овердохуя количество записей

>с какого поля и до какого поля вывести записи с таблицы

Ты не путаешь поля со строками? Полагаю, что путаешь, потому что динамически выбирать поля для большого списка - крайне сомнительная и странная затея.

Как я понял тебе нужно вытаскивать данные большого объема. Поскольку ты сразу выбираешь сотни записей, то и байтмассивы твои не нужно вытаскивать, пока на то не будет явной необходимости. Т.е процедура для списка должна показать тебе только те поля, которые дают общее представление о записи, а уж потом, когда пользователь выберет конкретную запись - подгрузить объемные данные.

Если у тебя можно бегать по записям стрелками вверх и вниз, то есть смысл сделать загрузку дополнительных данных после того, как пользователь постоял на записи 0.2 - 0.5 секунд. Ну или явно по нажатию кнопки подгружать.

Тут не сайт платиновых процедур нужен, а элементарный здравый смысл. Если ты тащишь тысячи записей, то пользователю все сразу, в один момент их никак не обработать.

438 Кб, 570x585

438 Кб, 570x585>Оператор левого внешнего соединения LEFT OUTER JOIN соединяет две таблицы. Порядок таблиц для оператора важен, поскольку оператор не является симметричным.

>Порядок таблиц для оператора важен, поскольку оператор не является симметричным.

Серьёзно, блять?

Абсолютно серьёзно. Левый внешний выдаст строки из левой таблицы, которым нет соответствия в правой.

8,4 Мб, mp4,

8,4 Мб, mp4,482x360, 3:11

Так же вдруг оказалось, что я как еблан поставил MySQL 5.Х вместо последней восьмой версии. Скачал ее, а она предлагает обновить shell и connector, но не сервер. Это нормально? Сервер с 5 до 8 версий не менялся вообще что ли?

25 Кб, 642x461

25 Кб, 642x461консолька оказалась лучше всех gui

Окей, начал вкатываться. Почему я могу использовать alias balance в order clause, но не могу в where clause? Так и должно быть или я чего-то не понимаю?

Так и должно быть.

order by в последнюю очередь выполняется, ему уже доступны алиасы.

Чтобы в where можно было использовать нужен селект из селекта:

select balance

from (select avail_balance as balance

from account whre status = 'ACTIVE' and avail_balance > 2500)

where balance > 300000

Алан Бьюли, Том Кайт... и практика, практика, практика.

И готовься к тому, что на собеседованиях там спрашивают хитрый джойн таблицы с ней же самой, да ещё и с группировкой :-(

Хорошо. Спасибо

Спасибо

Книги хорошо читать как дополнение к практике.

Задачки по SQL можно решать на

sql-ex.ru

если совсем с нуля, то раздел Arcade->SQL на codefighting.

Тебе нужно запросы к этим JSON'ам обрабатывать или там они будут просто валяться?

Для этого лучше постгрес взять, там полная поддержка JSON со всеми индексами без костылей. Ну или же документоориентированное что-то, конечно.

Найдется решение в один запрос, конечно, но по эффективности у двух селектов оно будет сосать.

Так оно и делается. Если есть возможность на стороне приложения кэшировать в какой-нибудь redis крайние значения, то это будет самый лучший вариант. Если нет, то делай вьюху. Еще лучше — материализованную, но для неё нужно будет с триггерами и процедурками поебаться, так как искаропки нет их, кажется. Будешь просто при необходимости обновлять значения в ней. Впрочем, с индексами первое и последнее значение все равно не дорого получать.

Охуеть, все дело оказалось в distinct. Интересно, что у них за проверочная база такая, у которой есть зачем-то одинаковые записи в Laptop таблице.

Спасибо за ответ.

429 Кб, 603x593

429 Кб, 603x593Как правильно хранить вектора большой длины (несколько сотен минимум) в БД при условии, что по этим векторам нужно будет осуществлять поиск?

10 Кб, 472x121

10 Кб, 472x121oracl

c#

мне нужно подключить базу данных к вижуал студио

когда я пытаюсь это сделать, вылезает ошибка

что делать? как исправить?

вообще говоря, нужно ли над базой данных производить еще какие-нибудь действия, кроме ее наполнения и написания всяких запросов и триггеров?

импортировать каким нибудь образом?

я полный профан очень нужен ваш совет

SQLite наверное?, потому как будет несколько независимых друг от друга наборов таких векторов и к ним должен быть доступ из мобильного приложения без интернета.предполагается, что пользователь скачивает сразу весь набор и пользуется ими

Мне кажется мы друг друга не поняли.

Сущность, хранимая в базе, имеет следующий вид:

x,y,z, feature_vector(500)

В ходе работы с базой мне нужно будет выполнять запросы типа

select * from entities where x = x_value+- error, y = y_value+=error...

Так для всех трёх координат и для каждого элемента вектора.

У меня стоит несколько вопросов:

1. Хули делать с вектором? Делать 500+3 столбцов кажется странной затеей, как обычно такую проблему решают?

2. Подойдёт ли для этого SQLite в плане производительности? Есть ли альтернативы?

Понял. Тебе тогда лучше две таблицы сделать, наверное, и unique повесить на (x, y, z). У тебя тут классический one to many будет. Если в feature_vector не предусмотрена перестановка мест элементов, то можешь при селекте сортировать по PK, в противном случае придется еще одну колонку для порядка городить. В принципе, если тебе так удобно, ты можешь свой список сериализовать и обрабатывать его в приложении, чтобы с реляционками не ебаться, если тебе не интересно это. Будет всего одна таблица, не нужно будет с джойнами разбираться и все такое.

> Подойдёт ли для этого SQLite в плане производительности?

Еще не знает история случая, когда бы на Андроиде производительность в SQLite упиралась. Ты же не бэкенд для хайлоада делаешь, ну.

А что даст уникальность x, y, z?

А с сериализацией неплохая идея, я правда хуй знаю, хорошая ли идея постоянно строки разбивать и конвертировать. Надо будет потестить, может лучше окажется в bytearray в блоб засунуть.

Спасибо за помощь.

> А что даст уникальность x, y, z?

Отсутствие подводных камней с дублированием объектов плюс индексы.

> хорошая ли идея постоянно строки разбивать и конвертировать

Видно, что ты с реляционками почти не знаком и сделаешь хуйню. Так ты сделаешь меньше хуйни. Потом всегда будет возможность разобраться в технологии поглубже, но пока что ты будешь хуйней маяться вместо решения задачи. Добра.

38 Кб, 512x512

38 Кб, 512x512>То чувство, когда, работая веб-макакой в довольно мелком проекте, половину рабочего времени тратишь на индексы и дрочь на снижение total cost запроса с 1000 до 950

Да.

Пилишь потоки, маппинги всякие в ETL-инструменте, консультируешь аналитиков, оптимизируешь скрипты. Плюс еще куча всяких связанных задач. Что конкретно тебя интересует?

Чье рабочее время ты собираешься учитывать? В каком контексте? Какие задачи должны быть решены?

>Чье рабочее время ты собираешься учитывать?

Просто регистрировать время ухода и прихода работников.

>Какие задачи должны быть решены?

Учёт рабочего времени: сколько часов в день, неделю месяц, год по отдельным сотрудникам и целым отделам, а так же опозданий и ранних уходов.

Первая очевидная мысль - таблица с периодами, привязанная к работникам, с парой таймстемпов или tsrange.

Какой ид повторяется?

Очевидно, что ид сотрудников не должны быть уникальными. Потом по ним дергаешь все рабочие сессии и уже их обрабатываешь, как хочешь.

23 Кб, 667x322

23 Кб, 667x322И почему в этом упражнении правильный ответ - создать индекс на пару (дата_транзакции, количество), а не на все 4 колонны вместе, как делается индекс на все используемые колонны в предыдущих картинках.

>Потом по ним дергаешь все рабочие сессии и уже их обрабатываешь, как хочешь.

А примерно, как должна выглядеть такая БД?

48 Кб, 1354x393

48 Кб, 1354x393Мне вот подкинули ТЗ на йобо-фитнесс-приложение и там довольно интересная схема таблиц выходит и что бы не запутаться и контактировать с другими разрабами думаю перенести мысли по БД в графическую среду.

Под руку попадаются лишь сомнительные онлайн сервисы, а есть ли что-то десктопное и мощное?

P.s. планируем юзать postgresql+mongodb

пиши схемы в виде текста, а визуализация пусть происходит автоматически какой-нибудь тулзой.

Вот меня и интересуют тулзы для такой визуализации текста

Турникет понимает, в какую сторону прошел человек - вход или выход?

Поля Начало, Конец обязательными делать нельзя - у тебя он даже просто войти не позволит, будет ругаться на то, что Конец пустой. Но это не все - допустим, у тебя выключили свет с утра , всех пустили в обход турникета, люди выходят вечером - никого выпустить не можем.

Я бы хранил так (навскидку, не претендую на абсолютную истину):

Таблица pass --Факты входа - выхода

pass_id number --Уникальный идентификатор факта прохода через турникет

device_id number --Идентификатор терминала

card_id number --Идентификатор карточки пропуска

pass_date date --Момент прохода через турникет

pass_direction number --Направление прохода (0/1)

pass_status number --Статус (ошибка, успешно)

Таблица рабочих сессий work_session:

work_session_id --Уникальный идентификатор сессии

employee_id number --Сотрудник

work_session_begin date --Момент начала сессии

work_session_end date --Момент окончания сессии

begin_pass_id number --Ссылка на факт прохода для начала сессии (может быть пустой)

end_pass_id number -- Ссылка на факт прохода для окончания сессии (может быть пустой)

work_session_begin_user varchar --Кто проставил начало - нужно продумать

work_session_end_user number varchar--Кто проставил окончание - нужно продумать

work_session_begin_reason_id --Причина начала работы nullable

work_session_begin_reason_id --Причина окончания работы nullable

Тут нужно оставить возможность заполнять моменты начала и окончания работы вручную и автоматически (на основе базового режима работы сотрудника)- на случай отказа турникета.

Разумеется, если время прописалось турникетом, то изменять его уже нельзя.

Т.е. если система видит, что условный Алеша Сычев пришел на работу 5 июня, а до этого он пришел 3 июня в 7 утра и с тех пор не выходил, то она должна свериться с дефолтным режимом работы (допустим 8 часов) и автоматом проставить что Алеша 3 июня закончил работать в 15 часов.

У определенной группы пользователей должна быть возможность редактировать эти данные, естественно, с ведением аудита - кто, что и когда менял.

Можешь добавить причины начала и окончания сессий - если тебе нужно будет потом отличить отгулы на полдня от прогулов.

Как должна выглядеть БД - вопрос странный.

У тебя должны быть таблички фактов прохода сотрудников через турникет, реестр турникетов, реестр карточек, табличка привязок карточек к сотрудникам (с учетом актуальности), реестр сотрудников, реестр отделов, реестр связи сотрудника и отдела. Плюс служебные таблички для статусов, причин и т.п.

Турникет понимает, в какую сторону прошел человек - вход или выход?

Поля Начало, Конец обязательными делать нельзя - у тебя он даже просто войти не позволит, будет ругаться на то, что Конец пустой. Но это не все - допустим, у тебя выключили свет с утра , всех пустили в обход турникета, люди выходят вечером - никого выпустить не можем.

Я бы хранил так (навскидку, не претендую на абсолютную истину):

Таблица pass --Факты входа - выхода

pass_id number --Уникальный идентификатор факта прохода через турникет

device_id number --Идентификатор терминала

card_id number --Идентификатор карточки пропуска

pass_date date --Момент прохода через турникет

pass_direction number --Направление прохода (0/1)

pass_status number --Статус (ошибка, успешно)

Таблица рабочих сессий work_session:

work_session_id --Уникальный идентификатор сессии

employee_id number --Сотрудник

work_session_begin date --Момент начала сессии

work_session_end date --Момент окончания сессии

begin_pass_id number --Ссылка на факт прохода для начала сессии (может быть пустой)

end_pass_id number -- Ссылка на факт прохода для окончания сессии (может быть пустой)

work_session_begin_user varchar --Кто проставил начало - нужно продумать

work_session_end_user number varchar--Кто проставил окончание - нужно продумать

work_session_begin_reason_id --Причина начала работы nullable

work_session_begin_reason_id --Причина окончания работы nullable

Тут нужно оставить возможность заполнять моменты начала и окончания работы вручную и автоматически (на основе базового режима работы сотрудника)- на случай отказа турникета.

Разумеется, если время прописалось турникетом, то изменять его уже нельзя.

Т.е. если система видит, что условный Алеша Сычев пришел на работу 5 июня, а до этого он пришел 3 июня в 7 утра и с тех пор не выходил, то она должна свериться с дефолтным режимом работы (допустим 8 часов) и автоматом проставить что Алеша 3 июня закончил работать в 15 часов.

У определенной группы пользователей должна быть возможность редактировать эти данные, естественно, с ведением аудита - кто, что и когда менял.

Можешь добавить причины начала и окончания сессий - если тебе нужно будет потом отличить отгулы на полдня от прогулов.

Как должна выглядеть БД - вопрос странный.

У тебя должны быть таблички фактов прохода сотрудников через турникет, реестр турникетов, реестр карточек, табличка привязок карточек к сотрудникам (с учетом актуальности), реестр сотрудников, реестр отделов, реестр связи сотрудника и отдела. Плюс служебные таблички для статусов, причин и т.п.

Спасибо за развернутый ответ.

>Поля Начало, Конец обязательными делать нельзя - у тебя он даже просто войти не позволит, будет ругаться на то, что Конец пустой. Но это не все - допустим, у тебя выключили свет с утра , всех пустили в обход турникета, люди выходят вечером - никого выпустить не можем.

Там сетевой контроллер, который не видит разницу между входом и выходом, только факт срабатывания считывателя (очень древняя технология древних).

>Как должна выглядеть БД - вопрос странный.

И если честно, мне нужен учёт времени и хранение полученных результатов (по дням, месяцам, годам) и отделам, с учётом того, что люди могут выходить из здания по делам и возвращаться обратно в течение смены. Не хранить же для каждого сотрудника таблицу в 365 дней и рабочими датами?

4 Кб, 228x164

4 Кб, 228x164Если у тебя просто срабатывание датчика, то тогда колонка с направлением движения не нужна - ты ее не сможешь заполнить.

Учет времени и хранение у тебя будет по определению. СУБД для того и нужна - хранить.

Если у тебя всего одно здание, то какой поток в день? 1000? 2000? Это все очень маленькие количества записей.

Для каждого сотрудника будет несколько записей на день, да, это нормально. СУБД справится, не переживай.

2,8 Мб, webm,

2,8 Мб, webm,480x360, 1:28

>Учет времени и хранение у тебя будет по определению. СУБД для того и нужна - хранить.

А вот как лучше всего это реализовать - я без понятия. Важно же не только хранить, но и получать доступ к хранимой информации.

>Если у тебя всего одно здание, то какой поток в день? 1000? 2000? Это все очень маленькие количества записей.

500 примерно.

Какие инструменты? Че несешь? Уже с timestamp'ом без мокрописек совладать не можешь?

Да я про разные. Например как при подсчёте общего времени учитывать только будние дни?

https://dev.mysql.com/doc/refman/5.5/en/date-and-time-functions.html

> DAYOFWEEK

Это называется документацией.

Я же не прошу сделать за меня базу данных, просто спрашиваю как люди решали эту проблему.

Ты еще даже со схемой не определился. Чтобы с тобой говорить, нужно её самому за тебя сделать, а потом примеры запросов показывать. Повторяю, никто этим заниматься не будет. Задача у тебя простейшая, за время, прошедшее с создания твоего вопроса здесь, ты бы её уже худо-бедно решил.

>Ты еще даже со схемой не определился.

Так мне нужна идея, как это реализовать правильно, а не сами запросы (пока что). Пока что есть идея при создание нового пользователя создавать отдельную таблицу, где один столбец будет общим временем за день, второй - датой этого времени.

> при создание нового пользователя создавать отдельную таблицу

Иди, блядь, читай, идеи свои охуительные отбрось и хоть немного разберись в теме. Потом поймешь, как мне тяжело сдерживаться и не покрывать тебя хуями. Ты свое время проебываешь и нихуя не делаешь. Пиздуй, блядь, читать. У тебя задача самого вводного уровня, соберись.

>Иди, блядь, читай, идеи свои охуительные отбрось и хоть немного разберись в теме.

Так где можно почитать про учёт времени через sql?

гугли opensource СКУД системы. если получится, то молодец.

Вообще что тебе нужно.

1) сделать опозанание где вход, а где выход.

2) Если человек не вышел, то ставить время 00:00, например.

3) додумать закрытие для случая два, если он вышел в 00:00.

Если ты не можешь спроектировать бд, то пиздец, блядь, купи готовое решение.

Вот это круто, на каждую запись новую табличку. Дейтом теперь только подтереться можно, нормальные формы, отношения, кортежи, муть какая-то.

Так и делай, анон, потом покажешь, что получилось. Думаю, получится отличное решение, тиражируемое и масштабируемое.

Похоже ты совсем нулевой. Почитай хотя бы как вообще БД используются, хотя бы простейшие примеры как делается список сотрудников. Если ты думаешь, что таблички - это типа как файлики, то спешу разочаровать, это не так. Я тебе даже примеры таблиц написал, но судя по всему ты это вообще не воспринял. Иди на sql-ex.ru, читай все с нуля, тред сохрани, потом (если) осилишь саму идею РСУБД перечитаешь. Пока что тебе особого смысла нет объяснять, у тебя нет элементарных знаний.

Вообще, мне нужен СКУД, мне нужно хранение данных о времени, что бы в любой момент можно было запросить то, сколько часов человек работал в мае 2018 года.

>>189493

>Вот это круто, на каждую запись новую табличку.

Ну так назови альтернативу, что бы можно было хранить данные по каждому дню у каждого сотрудника.

хуле ты такой тупой то?

хранишь id сотрудника timestamp тип события(вход, выход)

а потом селекты нормально составляешь.

64 Кб, 704x645

64 Кб, 704x645>Назвал уже, перечитывай пока не поймешь:

И я уже писал: проблема не в контроле доступом, а в хранение результатов полученных результатов.

>хранишь id сотрудника timestamp тип события(вход, выход)

Работник может и 15 раз за день выйти.

Колонки:

id (сессии; автоинкремент, PK), id_сотрудника, время_начала, время конца. Мудак ты ленивый, ты бы уже после первого же тутора для детей понял, как это хранить можно. Но ты всё ждешь, когда за тебя все тебе в рот положат и разжуют.

Нет, у тебя идиотская идея. Никуда время не добавляется. Начинается новая сессия, запросом уже просуммируешь продолжительности сессий, но делать ты это будешь сам.

>Нет, у тебя идиотская идея. Никуда время не добавляется. Начинается новая сессия, запросом уже просуммируешь продолжительности сессий, но делать ты это будешь сам.

Так ведь вопрос был и в этом: куда суммировать время так, что бы потом можно было его легко и просто достать.

390 Кб, 488x446

390 Кб, 488x446Еще раз почитай. Там все ключевые моменты есть, но могу еще раз повторить - анализируй сырые данные с девайса и заполняй таблицу рабочих интервалов.

Единственная сложность - это то, что данные с девайса не дают тебе 100% данных для учета, в случае, если девайс на время выйдет из строя, тебе нужно предусмотреть возможность как автоматически, на основе каких-то правил или режимов работы, так вручную, с помощью клиентского приложения, разрулить входы без выходов, выходы без входов и ударную работу по 36 часов во время авралов.

Один из возможных вариантов дальнейших действий: выбираешь стек технологий - СУБД, платформу для бизнес-логики и для клиентских приложений с учетом желаемой архитектуры - простой клиент-сервер или трехзвенка

Рисуешь схему данных, создаешь таблички.

Пишешь бизнес-логику, она же бэк-энд, прикручиваешь к ней клиентские приложения.

Никаких вопросов про тонкости обработки дат в SQL быть не должно. Это все разжевано в документации к БД.

Я спорить не буду. Порекомендую тебе съебаться из треда и начать что-то делать, но если останешься, то с удовольствием понаблюдаю за тобой.

Небось ещё по IP пробиваешь.

А ты прям мастер хуястер. Здесь вообще никого нормального нет.

ты тупой? Ты настолько ленив, что не можешь считать суммы в процедурах?

ебать ты.

Я мог бы тебе написать всё это, но бабла у тебя конечно же нихуя нет, как и мозга

Подскажите какой нибудь sql учебник для самых маленьких.

>select * from ... where sale = @idSale

А где гарантии, что у тебя там одна запись по этому условию?

117 Кб, 569x434

117 Кб, 569x434Есть одна таблица в которой требуется найти дубли по двум столбцам и сгрупировать их. Так вот есть один запрос, выделен на пикче, нужно его оптимизировать-перепилить.

Дубли должны находится по колонке CommunicationType и SearchNumber, как и делает мой запрос. Однако, как на выходе не получать лишних "групп"? Например, на пикче есть две группы, но нужно что-бы была только одна т.к. первая полностью входит во вторую, но есть условие что в группе не может быть меньше 2х записей. сори за качество пикчи

Очень нужна помощь HALP PLZ

62 Кб, 886x439

62 Кб, 886x439Что убрать? Или оставить как есть?

Мартин Грубер Понимание SQL.

Дейт - Введение в СУБД.

В процессе чтения обязательно задрачивай тысячи запросиков - на sql-ex.ru или на codefight.com в разделе Arcade -> SQL

Нет, это ненормально, а очень и очень плохо.

Связи на картинках не будут нормально работать. Допустим, ты завел 2 типа упражнений с десятком подтипов в каждом, запустил систему, в табличке упражнений появились десятки тысяч записей. Затем ты меняешь в табличке типов название - и у тебя все перестает работать, т.к. записи в Exercise и ExerciseSubType будут ссылаться на несуществующее значение. Запросы вернут 0 записей.

Связи должны быть по первичному ключу - то есть по %table_name%_id.

Кстати, рекомендую называть колонку с первичным ключом по такому шаблону, потом удобнее джойнить будет. Добавь primary_key по этим колонкам и сделай ссылки на ExerciseTypeId, ExerciseSubTypeId и т .д.

Эти колонки должны заполняться из уникальной последовательности, т.е. если у тебя была запись с Id = 100, потом ты ее удалил и добавил новую, то новая запись должна иметь Id = 101, даже если предыдущая запись получится Id = 99 и эти Id у записей никогда и никем не должны изменяться.

Также нужно проставить для колонок-ссылок внешние ключи на таблицы-источники, построить по ним индексы и определить политику при удалении.

Вот тогда с точки зрения связей все будет правильно.

Но есть еще один вопрос - в Exercise есть ссылка на подтип и на тип одновременно, причем подтип может иметь только один тип. То есть, хранить ссылку на тип - избыточно, ты ее всегда можешь вычислить из подтипа.