Вы видите копию треда, сохраненную 17 июля 2018 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Продолжаем выяснять, кто двигает ноуку: толпы смузихлёбов или фундаментальные деды.

FAQ:

Я ничего не понимаю, что делать? Либо в тупую import slesarflow as sf по туториалам, либо идти изучать математику. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/ | https://www.general-ai-challenge.org/ | https://corp.mail.ru/ru/press/events/452/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: персептроны и прочий мусор середины прошлого века действительно не работает на серьёзных задачах.

Архивач:

https://arhivach.org/thread/340653/

https://arhivach.org/thread/355442/

Там же можно найти треды 2016-2017 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

Предыдущий тред: >>1162357 (OP)

Бишоп же.

70 Кб, 947x946

70 Кб, 947x946аноны, можно ли делать предсказания по временным рядам на дипленинхе или нет?

нет времеи въезжать в регрессии все как всегда

Я в самом начале прошлого треда пояснял, почему диплернинх в этом деле не может быть кардинально лучше какой-нибудь arima, хоть 100500 слоёв сделай и насилуй амазоновский кластер с 100500 gpu.

>Ну надо же, самого Маэстро на оп-пик поставили

А ведь когда-то давно он всегда там стоял, заметил такую тенденцию

1) Кто то видит новую технологию и создает тред с базовыми вопросами, подтягиваются новички

2) Аноны из треда матереют, тред обрастает подробной шапкой, кто-то даже находит работу

3) Т.к. вопросов становится мало начинается тупой срач, типа, какую картиночку поставить в шапку, тред постепенно загнивает, знающие аноны больше не заглядывают и он умирает

4) Вернись к пункту один

>Пиздежь же, ну. Я только за последний год не помню уже сколько раз пытался пояснить, как на типизированной лямбде вымутить растущее адаптивное ядро

Лол, а нахуя ты пытался пояснить? Не похоже, чтобы у его величества нарцисса были бы какие-то проблемы с реализацией. Взял датасет, те же ряды с форекса, написал, предсказал, что, что можно, разбил всех в пух и прах и получил почет и уважение. Однако этого не происходит. Поэтому на самом деле происходит следующее.

Лет десять-пять назад на бордах были такие же петушки как ты, только дрочили на хаскель и лисп. Ничего хорошего не писали, одни короткие программы с какими-то ебическими концепциями. Чуваки эти были днищем - один даже разъебал стекло в подъезде дома в рамках борьбы с системой, но в собственном манямирке они были величайшими хуями на свете. А так как реальность больно бьет по тому факту, что на деле никакого величия нет, то самое время закопаться в какую-нибудь антимейнстримную хуйню и из нее кукарекать.

В конце концов пришло новое поколение, придумало мем "борщехлебы", и хаскель-петушки испарились. На бордах вообще таких фриков дохуя, в любом разделе.

Ну и вот в этой атмосфере родился ты. Возразить тебе сходу не о чем, потому что для этого нужно читать те же рандомные статьи, что читал ты. Сам ты не делаешь ошибок, потому что нихуя не делаешь на публике. Даже с системных ученых, с которыми ты состоишь в переписке, ты считаешь говном, ведь они не читали те же рандомные статьи, а рандомных статей в интернете дохуя.

>>76320 (OP)

>Либо в тупую import slesarflow as sf по туториалам

Это как и что?

Таких фриков в интернете толпы. Поехавших по темам квантмеха, теории относительности, различных тем в математике можно найти сотни сходу. Они все абсолютно одинаковые, пытаться вразумлять их бессмысленно и негуманно. У тебя и самого синдром "в интернете кто-то неправ". Какое тебе дело до нечеткого петуха, чо ты его вразумляешь? Ты думаешь, он сейчас такой скажет, мол, а ведь действительно, ты прав чувак, я кретин и постил тут пять (или сколько?) лет подряд ежедневно полную чушь?

А у тебя какое дело до меня? Хочу и вразумляю. Ты же знаешь, фриков в интернете толпы.

Я не знаю о каких "рандомных статьях" ты говоришь, я если что-то упоминаю, то это достаточно общеизвестные вещи.

>>76437

> Ты думаешь, он сейчас такой скажет, мол, а ведь действительно, ты прав чувак, я кретин и постил тут пять (или сколько?) лет подряд ежедневно полную чушь?

Если бы это была чушь, я бы об этом знал. Или как минимум, это можно было бы доказать. Однако, ничего из этого я не увидел за все время, что тут сижу. Чья-то батрушка это не доказательство.

> нечеткого петуха,

Я давно уже говорю, что нечёткие множества это будущее в т.ч машобчика. И вот, выясняется что квантовая логика (основа квантовых вычислений, за которыми будущее) выразима в терминах нечёткой. И выходим на два стула - использовать готовый математический аппарат, или изобретать полностью равнообьемный ему велосипед. Очевидно, что второе - абсолютно бесполезная потеря времени и сил, т.к все нужное давно существует.

>нечёткие множества это будущее

>квантовых вычислений, за которыми будущее

Мамкин оракул в треде

> Аноны из треда матереют

я прям чувствую как я матерею здесь. Узнал что такое сумма. Ну а если серъёзно то зря вы на анона агритесь. Он хорошие вещи говорит за регрессии. И объясняет круто. Хороший он человек короче.

А я думаю, что он засирает мой уютный тред своей тупостью. Двойные стандарты такие двойные стандарты - тебе критиковать можно, а мне нет.

Его просто еще не успели изговнякать

После изучения питона тебе потребуется минимум 6 месяцев, чтобы полноценно вкатиться в нейронные сети. Наверное хотя бы iq 100 нужен, но лучше больше, там так много логики.

https://www.youtube.com/watch?v=hb7tjqhfDus

Ты правда тупой или тупостью троллить решил? В обоих случаях дегрод, конечно, просто если правда веруешь в то, что написал, тебе самому должно быть стыдно.

Ну смотри, есть нейрофизиология. Опровергнуть ее не сможет никто, т.к. это объективные данные. Всякая веруйня же на раз опровергается любой другой веруйней, т.к. одно слово против другого такого же. Ты даже смысла слова "каргокульт" не понимаешь, с чего ты решил, что понимаешь что-то более сложное?

>Опровергнуть ее не сможет никто, т.к. это объективные данные.

Кокие данные? Если ебнуть там бабахнет здесь? Связь между мышлением и мозгом притянута за уши. Они могут сказать, что на какие то раздражители, будет активна какая то часть мозга, а может и не будет. И каргокульт очень даже подходит, особенно к адептам нейронных сетей.

он просто думает что мышление живой материи это настолько уникально что её ничем нельзя обьяснить

Ценное мнение рандомного клоуна с мейлру никому не интересно. Ты просто не знаком с темой, потому что мозгов не хватит, вот и несешь хуйню.

Кококо, врети111 Мозг черный ящик и ни один вменяемый нейробиолог не скажет, что он знает как это работает. А вот матанопеткшня подменяет факты и хайпит нейронные сети, которые никакого оношения к биологическим нейронам не имеют. По факту, получается, что однозначно связывают нейроны и мышление, люди которые далеки от биологической тематики.

Ну почему, как насчет того, что живое существо является тонким клиентом, а весь процесс мышления лежит в ноосфере? Мозг только осуществляет связь.

>Кококо, врети111 Мозг черный ящик и ни один вменяемый нейробиолог не скажет, что он знает как это работает. А вот матанопеткшня подменяет факты и хайпит нейронные сети, которые никакого оношения к биологическим нейронам не имеют. По факту, получается, что однозначно связывают нейроны и мышление, люди которые далеки от биологической тематики.

>

Концепция простая есть входы и выходы, и нейронная сеть учится что-то делать, у живых существ много данных поступает, потому и ведут себя лучше чем нейронносеточные роботы.

> у живых существ много данных поступает

Это не как не объясняет связи нейрон-мышление.

>нейронная сеть учится что-то делать

Нет, она сохраняет состояние на основе статистики и рендомной магии.

Ох нихуя, мамкин школотрон ворвался в тренд, высрал пару постов шизопоноса, и всех подебил. Круто, а? Учитесь у школотрона!

> Нет, она сохраняет состояние на основе статистики и рендомной магии.

нет, она не сохраняет состояние, а настраивает пропускную способность синопсисов. Это стало возможным благодаря тому что синопсисы стало возможно записывать на магнитные носители. Это твой ответ больше походит на рандом. А вообще жаль конечно что ты такой толстый.

> не как не

В ряду хим элементов пополнение

Нет никакого мышления, ты только реагироват на раздражители умеешь и делать то чему научился по сто раз, точно как нейронная сетка

пиздец а если это правда... и мы всего лишь движущиеся камни, собранные высшими существами и развивающиеся по программе

>нет, она не сохраняет состояние, а настраивает пропускную способность синопсисов.

И в чем отличие от сохранения состояния и пропускной способностью?

> записывать на магнитные носители

И что? Ты можешь восстановить из надроченных манясинапсиах данные на которых они обучались?

>В ряду хим элементов пополнение

ну марявановна, ну пазязя

>>77745

>ты только реагироват на раздражители умеешь и делать то чему научился по сто раз

утверждаешь, что разумное существо не примет решение в ситуации с которой он никогда не сталкивался и не обучался?

Форумы там, группы вк на крайний случай. Просто посыл на почту к какому-нибудь чуваку. Буду рад всему.

>Откровения Преподобного Васяна

всякое связное, односвязное, компактное трехмерное многообразие без края гомеоморфно сфере S3

Читал Бурбаки?

-----

Кремация состоится в субботу, 23 ноября 1968 в 15 часов на «Кладбище случайных величин», станции метро Марков и Гёдель. Сбор состоится перед баром «У прямых произведений», перекрёсток проективных резольвент, бывшая площадь Косуля.

Согласно воле покойного месса состоится в соборе «Богоматери универсальных конструкций», месса будет проведена кардиналом Алефом I в присутствии представителей всех классов эквивалентностей и алгебраически замкнутых тел. За минутой молчания будут наблюдать ученики Высшей нормальной школы и классов Чэня.

Поскольку Бог есть компактификация Александрова для Вселенной — Евангелие от Гротендика, IV,22

Не, я знаю статистику. Ну так, что проблем не возникает. Знаю вводные в биг дату, хадуп и пару алгоритмов. Максимум чято там используется это умножение матриц, что даже не линейная алгебра, нормы, просто определение, основы тервера, причем совсем простого и основы статистики, причем даже не какие-то оценки и прочее, а просто идея построения гипотез, даже не общих. И это я уже давно пытаюсь что-то откопать, а это вся математика, что мне встретилась.

>а это вся математика, что мне встретилась.

ну так это так и есть. Хотя зависит от сортов бигдаты, вот поисковые машины тоже бигдата, но там основной упор на обработку текста и его хранение/поиск, а статистика дело десятое.

>персептроны действительно не работает

Выходить, нет смысла их изучать?

Что тогда изучать вместо них?

Спасибо, конечно, за анализ, но есть что-то более общее? В смысле между основами и поисковыми машинами. Что читать и где?

>матанопетушню

Ты кокой-то мамкин маняпитух, даже разговаривать нормально не умеешь. Поссал на тебя.

почитай поковыряй sklearn. Всякое желание дальше ковырять тему биг даты пропадёт. И придёшь к нам в нейроночки

нету. это очень задротская тема

Бигдата начинается там, где заканчивается оперативка. Только и всего. Речь о данных, которые не влезут в имеющуюся оперативу. Остальное ничем не отличается от небигдаты, алгоритмы работы с этим зависят от того, что за дата. Если текст, то NLP итд.

55 Кб, 700x525

55 Кб, 700x525Я очень часто встречаю в этом треде слово nlp и очень редко , скажем кластаризация.

Еще раз, я понял что такое биг дата, да я и знал впрочем, с определением про оперативку не согласен, важнее время выполнения, а это не совсем одно и то же.

И самое главное, че читать то, куда идти, по каким запросам гуглить. Пока имею только вот это >>77792 но автор грозится, что это отобьет всякое желание вообще.

По этому запросу меня выкенет на склуль и прочие непотребства, что мне придется знать, но улубляться в чем я совершенно не хочу.

77 Кб, 240x240

77 Кб, 240x240> Пока имею только вот это >>77792 но автор грозится, что это отобьет всякое желание вообще.

Склерн это просто пистоновская либа с алгоритмами типа SVM итд. Ничего специфического для бигдаты там нет. Ты скажи ты скажии че те надо, че те надо, может дам может дам че ты хошь у тебя задачи какие? Если бигдата как вещь в себе, то всякие хадупы кури, если что-то конкретное, то что именно? Кластеризация? Тогда склерн, ну или карты Кохонена, но векторное квантование сейчас не в моде, хипстеры на коворкинге засмеют.

бигдата работает с данными, а их где то нужно хранить, хранят их в сортах ов БД, вот и думай.

ну да непосредственно биг дату он рассматривает как часть обучения, когда даты сильно дохера и она занимает всю оперативку чтобы сфитить модель. И там предлагается некие стратегии как всё-таки всё содержимое твоего винта скормить модели. мимо нуб

на тебе, типичная биг дата с кучей всего, чего ты не осилишь:

https://github.com/Maxime2/dataparksearch

>ты скажии че те надо

Найти призвание в жизни и заниматься им.

Мне нравится эта тема и я хочу работать в этой области.

>>77810

Еще раз, по запросу базы данных я стану мастером скуля, носкуля, еще какого говна, но ни на йоту не приближусь к большим данным. Машины тоже на бензине ездят, но гонщики почему-то на скаважины не ездят обучаться.

Это же не обучающие материалы.

> Найти призвание в жизни и заниматься им.

> Мне нравится эта тема и я хочу работать в этой области.

Ну если так глобально, иди на либген и качай что там есть по бигдате. Из пары десятков книжек всяко что-то заинтересует.

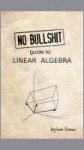

Слушай больше всяких ебанашек. Перцептроны работают, только это очень неоптимальная хуйня, поэтому на сколько-нибудь сложной задаче встают раком. Ответ на вопрос "что изучать?" прямо вытекает из ответа на вопрос "что тебе надо?". Если машобчик как явление - то все подряд и изучай. ISLR, Бишоп, дальше сам разберешься что нужно, что нет.

80 Кб, 400x546

80 Кб, 400x546Окей, а какие именно серии комиксов нужно прочитать?

Это ты не в тренде. Просвещайся: https://ru.wikipedia.org/wiki/Нооскоп

Занимается этим не кто-нибудь, а барин лично: https://ru.wikipedia.org/wiki/Вайно,_Антон_Эдуардович

Так что ты лучше того, варежку закрой, пока не обнаружил себя сидящим на бутылке.

Ссылки бы вставлять научился. Что там? Богоскоп Лайно? Пиздуй с этой дурью на /по/рашу, к машобу это говнишко никакого отношения не имеет.

А где можно пройти курсы по вставке ссылок на мейлач? Мне на русском надо.

>Богоскоп Лайно?

Он самый.

>дурью

Ты на кого батон крошишь, раб? Совсем рамсы попутал, черт. Твой хозяин сказал, что это надо.

>к машобу это говнишко никакого отношения не имеет.

Сказал так, будто хоть один пост ИТТ имеет какое-то отношение к машобу.

> Что такое гиперпараметры? Почему они гипер, а не просто параметры?

Гипер потому что это параметры, задаваемые пользователем (например, коэффициент обучения, число слоёв в нейроночке), а не настраиваемые самим алгоритмом (например синаптических веса) в процессе обучения. Т.е это параметры алгоритма, находящиеся над ним. Естественно, то что является гиперпараметром в одной модели, может быть параметром в другой, если он настраивается уже самой моделью.

>> которое бы не аппроксимировало, а точно представляло задачу любой сложности через суперпозицию наиболее подходящих в данном случае функций

Дебил иди учи уроки, по конечной выборке нельзя ничего точно предсказать, между точками может быть что угодно. PAC методы лучшее, что есть на данный момент, включает неронки. Сходимость по вероятности - это максимум на что можно рассчитывать.

Он видимо хочет добиться охуительного оверфитинга, и типа вот, УНИВЕРСАЛЬНЫЙ АППРОКСИМАТОР.

Оно не решение принимает а реагирует на раздражитель, человек ничего не изобрел с нуля, все создавалось с помошью уже имеющегося опыта.

>Слушай больше всяких ебанашек

Сука, в оп-посте под спойлером и написано, что для сложной хуйни это говно не работает.

спасибо. Пойду позову.

11 Кб, 470x156

11 Кб, 470x156>PAC методы

Ну и каково это, сначала кукарекать против Вапника, а затем ссылаться на сорта его теории? Шизики ебучие.

>Ну и каково это, сначала кукарекать против Вапника

Кто посмел оскорбить Бога нашего шизика, кто совершил такое святотатство?

>>78034

>по конечной выборке нельзя ничего точно предсказать, между точками может быть что угодно.

Между точками не может быть "что угодно". Там может быть то же, что и в точках - в случае стохастического процесса / процессов - распределение вероятности этих процессов, причем в худшем случае - в виде суперпозиции в общем случае неизвестных случайных процессов. По конечной выборке их восстановить можно только в случае, если все эти процессы детерминированные, разумеется. Чего в реальности не бывает. Однако, их можно аппроксимировать не рандомной функцией, которая само собой не работает даже на минимальной эстраполяции, а суперпозицией функций, наиболее близких к реальному распределению.

scala (обычно ее используют), hadoop, h20, spark, kaffka, kubernetes и книжки издательства орайли (oreilly) по данным предметам, для нейронок часто используют всякие обертки на docker + какой-нибудь пакет для машоба (tensorflow, mxnet, pytorch)

185 Кб, 827x727

185 Кб, 827x727>This basic book has been used at the middle schools in Shanghai, China for more than 10 years. The book presents carefully-selected contents in order to achieve the roles of enlightenment and popularization.

Вот поэтому Китай в области машобчика в обозримом будущем обгонит пиндосов.

НЕЙРОНОЧКИ И МАШОБ ТРЕД. Новости.

В Китае обнаружена жежешечка артемия лебедева первая ферма по выращиванию нечётких петухов. Местный нечёткий петух уже ведёт переговоры с правительством Китая о поставках серийных петухов прямо в наш уютный тред. Мы будем следить за развитием событий.

>> Между точками не может быть "что угодно". Там может быть то же, что и в точках - в случае стохастического процесса / процессов

Очень сильное предположение относительно просто выданной обучающей выборки.

>> их можно аппроксимировать не рандомной функцией, которая само собой не работает даже на минимальной эстраполяции, а суперпозицией функций, наиболее близких к реальному распределению.

Это типа перебрать гиперпараметры (семейство функций) по сетке и по CV замерить качество и выбрать лучший? Тогда зачем лямбда, которая здесь является лишней сущностью?

>Очень сильное предположение относительно просто выданной обучающей выборки.

Почему? Все равно любой процесс либо заметно влияет на выборку и т.о. его как минимум можно выявить, либо не влияет и т.о. в самой выборке никак не отражен.

>Это типа перебрать гиперпараметры (семейство функций) по сетке и по CV замерить качество и выбрать лучший? Тогда зачем лямбда, которая здесь является лишней сущностью?

Лямбда затем, чтобы эти внешние для модели гиперпараметры стали настраиваемыми параметрами модели, как в случае ядер в SVM. И чтобы структура нужной функции / суперпозиции функций подбиралась сама, а не выбиралась из чего-то априори заданного таблицами итд.

Потому что это бессмысленное задротство ради жестяных кубков и циферок на малоизвестном сайте.

>Потому что это бессмысленное задротство ради жестяных кубков и циферок на малоизвестном сайте.

Как ты сейчас точно описал весь нейронодроч на MNIST-е.

1) Гуглокапчу для того и ввели, 2) средний двощер не осилит ничего сложнее программы с большой кнопкой "сделать заебись", 3) надо собирать тренировочный сет, 4) возможно, для массивного вайпа это не подойдёт из-за доп. нагрузки на систему (хотя, наверное, зависит от реализации), 5) все охуевшие ловят бан подсети, остальные сидят и не вякают.

Чтобы школьники не вайпали, допетрив до скрипта постинга говна в цикле. Более же взрослым людям нахуй не всралось тратить время на вайп мочана.

>искажённых данных

наркоман, где там искаженные? на развороте страницы при сканировании больше смещение

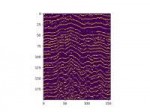

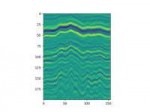

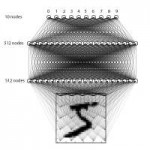

Исходные данные - вторая пикча. Мне, по сути, надо распознать горизонтальные кривые линии на изображении. Подкиньте идей, вообще не пойму с чего начать.

На первом пике выделены "локальные максимумы" столбцов второго изображения.

Математика, наверное.

+15

У меня почему-то выдаёт только одну мышь.

ЧЯДНТ

https://yadi.sk/d/SJhYyKs_3UjRCb

Чтоб для самых маленьких и тупых. Мой бэкграунд: школа.

Не нужно.

Ты бы погуглил что-нибудь типа "game industry revenue", что ли. Или ты очередной илитист с пхд по серьёзности с двача?

мимохуй, не играющий в игры

Почему-то не выдерживаю её взгляда. Про оригинальное видео вообще молчу, мне стыдно это смотреть.

ИИ для игорь это что то на уровне ясель

Теперь живем, мой милый на луа пишет, могу нейроночки приделывать!

Всё в этом посте неправильно. Не программируй никогда.

Сам сделай, хули. Всего то надо на силуэт натянуть модельку голой тёлки.

да тут больше инженерная задача. имхо есть смысл поэксперементировать с процессами и расшаренной паматью. например вкатываешься в питон, делаешь сервак в котором крутится модель. Игруля птшется на любом языке и просто имеет апи через который взаимодействует с процессом которым управляет змеиный интерпритатор. Еще сейчас намечается тенденция глобализации в програмаче. неисключено что популярные игровые фрйемворки выкатят некие инструменты по компилированию моделей из питоновсеих либ в свои экоситьемы. Так что если всерьез думаешь об ии начинать имеет смысл с питона ввиду большего количества обучалок и документации от сообщества

Гугли LSTM и GRU.

диплернингбук и ссылки из нее.

Там коротко и про то, что градиенты нужно клипать, и немного других базовых вещей.

attention is all you need

можно ли натренировать нейронку на датасете из 15 картинок?

Короче бля, тебе дают массив весов размером 3 на 3, ты умножаешь на эти веса область данных 3 на 3, суммируешь, в среднюю записываешь результат. Так как ядер свёртки разное количество и всё это пуляется и прогоняется ещё раз, а потом ещё и накрывается посносвязным слоем, такие значения в итоге подают на нейроны как-то невъебенно перекодированную информацию об расположении значений, об их последовательностях.

Смотря какие картинки и что распознавать. Но вообще наврятли, скорее обучишь её распознавать эти 15 картинок.

Да, можно.

Надо просто напихать побольше слоев, и сделать все нейроны линейными для ускорения обучения и избежания оверфитинга

Ты недооцениваешь интеллект ребенка. Он вполне сможет сделать вывод, что все что выглядит как живое и не является человеком, является животным.

Перед этим ребенку нужно запомнить человека и окружающую среду, чтобы все незнакомые движущиеся объекты, методом исключения, отнести к живым.

нейросеть такой возможности не имеет.

Поэтому твоя аналогия не корректна.

спасибо! Какие еще будут инструкции?

Теперь старушка-препод сказала, чтобы я описал нейронную сеть и описал сколько там слоев и нейронов.

А что теперь делать? Так и сказать, что у меня 12 слоев с тремя тысячами нейронов?

>Можно ли научить тебя распознавать класс "животное", если тебе покажут только кота, ворону, жопу осла, и дохлую рыбину?

Да.

Я выше написал для дегенератов - сравнение с другими известными образами и классификация методом исключения не считается.

>> Так и сказать, что у меня 12 слоев с тремя тысячами нейронов?

Да, построй еще графики ф-ии потерь на валидации и трейне и покажи бабуле, что не переобучился.

>пытался сделать 3-5 слоев с десятками нейронов. Нихуя не вышло, тогда я психанул и сделал 12 слоев и в каждом по нескольку сотен нейронов. Всё вышло охуенно

Вся суть диплернинга же.

См. работы по метаобучению. Популярный датасет omniglot, например, содержит всего несколько примеров для каждого класса.

Никогда не поверю, что это какая-то военная тайна и на каждом углу (слесарьплов, керас, ...) нет конкретных примеров. Сдается мне мил человек, это тебя обучать как-то надо, а не эту нейрон очку.

Тащемта правда тайна. Найти можно только абстрактную хуйню про то, что нужно все веса по одному значению считать или что это возможно только с генетическими алгоритмами.

Ребята, не стоит вскрывать эту тему. Вы молодые, шутливые, вам все легко. Это не то. Это не Чикатило и даже не архивы спецслужб. Сюда лучше не лезть. Серьезно, любой из вас будет жалеть. Лучше закройте тему и забудьте, что тут писалось. Я вполне понимаю, что данным сообщением вызову дополнительный интерес, но хочу сразу предостеречь пытливых - стоп. Остальные просто не найдут.

Имейте в виду, короче, конкуренция растёт.

Есть смысл юзать только для последовательностей входных данных, и то периодически, например, в данных с финансовыми кривыми, иногда лучше использовать 1D свёрточные. А можно комбинировать.

Обучение просто работает через backprop in time, та же самая херня как с обычным backprop (Chain rule), только распространяется на время.

Но там трабл в том, что есть Vanishing gradient проблема, то есть если нейронов много, то градиент пидорасит и нейронка перестаёт вообще понимать, что происходит в этой ёбаной жизни. И для фикса этой проблемы юзают GRU\LSTM, которые с помощью специфичной реализации контроля запоминания\забывания входных данных могут блочить всякую ненужную инфу, которая в них попадает, при том ещё и запоминая далеко отстоящие связи.

Итого:

Гугли backprop in time, vanishing gradients. По ЛСТМам на архиве есть статья неплохая, вроде бы, с участием Bengio, но там довольно жоска, если не читал другой литературы.

Мдауш.

Знающий Си знает все языки программирования априори, ему ничего не стоит изучить новый, разве нет?

47 Кб, 512x680

47 Кб, 512x680Вот ты думаешь, что умный, раз Канта запостил, а на самом деле ты еблан, и я это докажу. ЦНС человека не с нуля появилась, а в ходе миллионов лет эволюции. И возможность априорных суждений это свойства ЦНС. Нейровизуализацией показано, что априорные интуиции пространства и времени зависят от предсуществующих структур в rIPC, нижней префронтальной коре. Да, все это работает у новорожденных и опыта не требует, вот только новорожденный это продукт взаимодействия геномов своих родителей, а не собранный с нуля биоробот. А вот веса нейрон очки это именно взятые более менее с потолка значения и не зависят от предсуществующих нейроночек. Поэтому сравнивать такие вещи с человеком это глупость либо толстота.

>все создавалось с помошью уже имеющегося опыта.

>возможность априорных суждений это свойства ЦНС.

Так априорные синтетические суждения возможны или нет? Почему ты противоречишь сам себе?

Как тогда люди учатся водить машины, допустим? Ведь у предков людей их не было. Точно так же могу сказать про чтение, письмо, сложение-вычитание, да и вообще про способность абстрактно мыслить - это уникально для человека, за исключением пары других видов у которых это развито примитивно.

Плюс, твои утверждения в корне ошибочны, ибо по твоей логике каждый человек по дефолту способен на все то на что способны другие люди, что в корне неверно. Ребенок выросший в лесу слабо похож на своих сверстников.

То что ты говоришь касается лимбической системы, допустим, она не осознана и выполняется в нашем мозгу как программа свернутая в трей, и формируется она еще со времен динозавров, но, так сказать, уровень сознания у каждого человека уникален, в т.ч потому-что для каждого индивида эволюция мозга своя, и каждый индивид проживает уникальную жизнь, только в общих чертах похожую на жизнь всех остальных.

> Так априорные синтетические суждения возможны или нет?

Возможны. Только они представляют собой не то, что ты думаешь.

> Почему ты противоречишь сам себе?

Это ты думаешь, что противоречу. На самом деле противоречия тут нет.

>>80457

> Как тогда люди учатся водить машины, допустим? Ведь у предков людей их не было.

Потому что кроме безусловнорефлекторной деятельности есть ещё условнорефлекторная.

> То что ты говоришь касается лимбической системы,

Нет, конечно же.

> Плюс, твои утверждения в корне ошибочны, ибо по твоей логике каждый человек по дефолту способен на все то на что способны другие люди, что в корне неверно.

Во-первых, это не мои утверждения, а данные нейровизуализации. Во-вторых, это твоя, а не моя логика, я ничего подобного не утверждал, и из приведенных мной фактов ничего подобного не следует.

Но ведь всей этой писанины можно было избежать, ведь канта пидор...

Не является ли bagging более продвинутым алгоритмом (хотя он и проще) хотя бы потому что он не может уйти в редкие цепочки вида (A>N1)&(B<N2)&(B>=N3)&(...) ? Покрывает ли boosting всё алгебраическое множество, когда положительные результаты в диаметрально противоположных углах пространства? Например (A>0.95)&(B>0.95) и (A<0.05)&(B<0.05) ?

Вот это научпоп.

771 Кб, 857x1200

771 Кб, 857x12002) Как и чем лучше крутить ручки гиперпараметров? Стоит ли использовать что-то кроме RandomizedSearchCV? Как лучше определять в какую строну крутить?

3) Есть ли механизм нахождения важности фич менее топорный чем считать mean фичи и заменять им весь столбик чтобы проверить насколько упадет аккураси?

Дяденьки матаноняши, не набрасывайтесь на меня, как только научусь пользоваться тем что есть, так сразу ударюсь в теорию чтобы раздвигать горизонты самостоятельно.

1) Зачем? Нейронка сама определит, какие фичи важные, а какие нет, если собрана архитектурно адекватно. Если ты про диплёрнинг, конечно.

Если ты про простые модели, то тут очень важно тщательно продумывать, что нужно пихать в нейронку, а без чего можно обойтись.

! Вообще совет насчёт датасетов. Вникай в задачу логически как человек. С чем и что может объективно коррелировать. И там уже отбирай нужные фичи, выкидывай ненужные.

2) Уточни вопрос. Я, конечно, могу почитать эту тему, но скайкитом я не пользуюсь, поэтому быстрее будет, если ты объяснишь это абстрактно.

3) Логически думаешь, что важно, а что нет. Матлаб автоматически, например, пытается исключать определённые фичи и даже предлагает это вручную делать.

3) В датасетах с которыми я работаю какая-то часть фич вообще не интерпретируется, а влияние остальных невозможно предсказать логически, разве что объеденив в группы, которым я хочу задать разные веса.

1) Особенность задачи и то что я хочу предварительно натренировать нейронку на немного других данных.

2) Это то же самое что перебирать комбинации гиперпараметров из таблицы (как в GridSearchCV), только в RandomizedSearchCV ты задаешь количество комбинаций и можешь вводить параметры диапазонами.

Суть в том что находились статьи где описывались методы умнее чем тупо перебор без оптимизации поиска, но на практике никто (в статьях и коде на гитхабе не топ-уровня-такого-что-я-не-пойму) их не применяет.

Ну на самом деле как ты понимаешь, суть формирования модели это подгонка весов под некоторую оптимальную комбинацию.

Не знаю, есть ли что-то такое в скайките, но в Керасе\Тензоре можно настроить нетренируемость слоёв определённых. Если попробуешь поизвращаться с кодом на тензоре или будешь писать нейронку с фундамента, то сможешь залочить какие-то параметры после некоторого числа итераций.

Есть ещё опция с тем, что можно задать самому какие-то веса заранее, а можно вообще загрузить из некоторой стадии обучения.

1) Если хочешь на других данных - очень сильно зависит от типа нейронки, уточни. Потому что для тех же CNN можно какое-то число первых слоев свёртки и макс-пула оставить нетренируемыми после обучения на другом датасете, так как они содержат фильтры примитивов на картинке. А дальнейшие слои перетренировать, чтобы более специфичные для задачи паттерны выделить.

С теми же RNN это так скорее всего не сработает, но попытаться можно, маловероятно.

2) На самом деле всякие оптимизации по параметрам довольно сложно вычленять. Честно говоря это в основном приходит с опытом, видишь одну фичу на плоте - понимаешь, что то-то и то-то может быть проблемой. Обычно здесь говорят так: "Прочекайте основные логичные предположения, потом перебирайте"

Можешь почитать что-нибудь вроде книжки от создателя Кераса по МЛ, там есть пару фич. Или курс на курсере от Ынга глянуть, он тоже некоторые такие признаки выдаёт, что и где подкручивать.

Если признаки не помогают, то обычно тут помогает только тык с отсылками на логику задачи.

3) Можешь привести пример данных, которые нельзя интерпретировать? (Желательно ещё контекст задачи) Если хочешь разделить на несколько весовых групп, то попробуй просто в ручную загрузить веса с некоторой рандомизацией в каждый из твоих условных блоков. Только обязательно регуляризацию сделай, а то эффективность может люто упасть.

> Гиперпараметры потому так и называются, что нет алгоритма для их эффективного подбора.

Это проблема функции потерь на самом деле. Если использовать полтора стандартных варианта ,известных хипстерам, то да, задача не то чтобы нерешаема, просто решение скажем не будет поражать качеством. Нужны более комплексные оценки качества решения задачи, чтобы не только среднеквадратичные отклонения считал, но и устойчивость решения на экстраполяциях итд. Что-то по типу комбинированных критериев Ивахненко. Но это для хипстров сложна.

Ну и как тебе более другая функция оценки качества решения поможет подобрать значения десятков гиперпараметров, таких как количество слоев, типов слоев, нейронов в слоях (и это мы еще даже не затрагиваем более экзотические архитектуры, не укладывающиеся в концепцию слоев), типы нелинейных преобразований, проценты дропаута, тип оптимизатора и его параметры, вид схемы инициализации весов сети и ее параметры? Установи любой из этих гиперпараметров неправильно, и вообще ничего не натренируется.

> Ну и как тебе более другая функция оценки качества решения поможет подобрать значения десятков гиперпараметров, таких как количество слоев, типов слоев, нейронов в слоях (и это мы еще даже не затрагиваем более экзотические архитектуры, не укладывающиеся в концепцию слоев)

Очевидно, что все это говнишко не нужно, все равно там одно шаманство, для которого даже vc-размерность не найдешь. Можно взять простую модель, скажем SVM, и усложнять только ядро, так чтобы оно возможно более точно представляло функции идентифицируемой системы. С другой стороны, если человек с опытом может подобрать гиперпараметры нейроночки, значит это алгоритмически разрешимая задача и решается подходящими эвристиками (а не тупо брутфорсом).

2,2 Мб, 1400x1000

2,2 Мб, 1400x1000С таким функционалом как я хочу попробовать, кажется, проще действительно переписать модели самостоятельно.

1) В моем случае нейронка тоже гиперпараметр, вот попробую и посмотрю что взлетит.

2) Кажется, в тех случаях что ты написал все советы можно свести к тому чтобы построить гистрограммы метрики каждой фичи по хистори поиска гиперпараметров и если максимальное значение не в середине - то раздвинуть поиск в нужном направлении. Тоесть, если подбирается 5 гиперпараметров, то рассматривается каждый отдельно и если для какой-то условной С = [0.01, 0.1, 1, 10, 100] выше всего значения метрик были не при С = 1, а при С = 100, то добавить еще С = 1000 и С = 10000, затем повторить наблюдение.

3) Например, нельзя интерпретировать хеши. Были какие-то строки разного размера, по которым я специальным алгоритмом строю бинарные репрезентации длинной ровно N бит. Теперь нельзя сказать что означает значение какого-то конкретного бита. Плюс к этим хешам добавляются еще варианты репрезентаций тех же строк, какие-то я считаю более важными, какие-то менее, но все же необходимыми. Плюс, я знаю что нейронка вероятно будет забивать на какую-то часть фич, потому что она разделяет данные не так явно (на начальных этапах), поэтому нужно реализовать например дропаут сильной части фич, чтобы модель училась и на слабой.

>>80929

Про алгоритм я понимаю, но может быть можно как-то оптимизировать процесс чисто инженерными решениями, например, тот же GridSeachCV из dask-ml возможно работает быстрее чем из sklearn. Таким образом, мой вопрос сводится к тому какую функцию какой библиотеки выбрать для того чтобы находить гиперпараметры в моем манкикоде.

>>80944

Знаешь почему хипстеры заполонили? Потому что когда кто-то новенький пытается вкатиться, он не идет сразу на арксив читать последние фундаментальные исследования, он хочет попробовать написать что-то по понятным инструкциям, повторить с какими-то незначительными вариациями для своих данных что-то подробно описанное. И когда он ищет эти инструкции, ими оказываются исключительно хипстерские поделки от реддита до видосиков на ютубе где школьник поясняет за шмот и то как напихать слоев чтобы получился диплернинг. Знаешь что тогда делает ньюфаг? Он повторяет хипстеркий подход и тут же описывает свой опыт в бложеке чтобы остальные могли повторить. Матаноняш, я какое-то время слежу за тредом и ты никому не помог и не написал ни одного гайда по которому можно было бы вкатиться в твою религию.

Пожалуйста, напиши что-то конструктивное чтобы помогло и работало (например, что делать со страшной SVM кроме хипстерского перебора гиперпараметров из вариантов в sklearn, хотя бы как найти нужное ядро), или начни подписываться чтобы тебя можно было скрыть.

А вообще я хочу чтобы хоть кто-то меня учил, а не только показывал насколько больше знает чем я. Или хотя бы чтобы учился вместе со мной.

2,2 Мб, 1400x1000

2,2 Мб, 1400x1000С таким функционалом как я хочу попробовать, кажется, проще действительно переписать модели самостоятельно.

1) В моем случае нейронка тоже гиперпараметр, вот попробую и посмотрю что взлетит.

2) Кажется, в тех случаях что ты написал все советы можно свести к тому чтобы построить гистрограммы метрики каждой фичи по хистори поиска гиперпараметров и если максимальное значение не в середине - то раздвинуть поиск в нужном направлении. Тоесть, если подбирается 5 гиперпараметров, то рассматривается каждый отдельно и если для какой-то условной С = [0.01, 0.1, 1, 10, 100] выше всего значения метрик были не при С = 1, а при С = 100, то добавить еще С = 1000 и С = 10000, затем повторить наблюдение.

3) Например, нельзя интерпретировать хеши. Были какие-то строки разного размера, по которым я специальным алгоритмом строю бинарные репрезентации длинной ровно N бит. Теперь нельзя сказать что означает значение какого-то конкретного бита. Плюс к этим хешам добавляются еще варианты репрезентаций тех же строк, какие-то я считаю более важными, какие-то менее, но все же необходимыми. Плюс, я знаю что нейронка вероятно будет забивать на какую-то часть фич, потому что она разделяет данные не так явно (на начальных этапах), поэтому нужно реализовать например дропаут сильной части фич, чтобы модель училась и на слабой.

>>80929

Про алгоритм я понимаю, но может быть можно как-то оптимизировать процесс чисто инженерными решениями, например, тот же GridSeachCV из dask-ml возможно работает быстрее чем из sklearn. Таким образом, мой вопрос сводится к тому какую функцию какой библиотеки выбрать для того чтобы находить гиперпараметры в моем манкикоде.

>>80944

Знаешь почему хипстеры заполонили? Потому что когда кто-то новенький пытается вкатиться, он не идет сразу на арксив читать последние фундаментальные исследования, он хочет попробовать написать что-то по понятным инструкциям, повторить с какими-то незначительными вариациями для своих данных что-то подробно описанное. И когда он ищет эти инструкции, ими оказываются исключительно хипстерские поделки от реддита до видосиков на ютубе где школьник поясняет за шмот и то как напихать слоев чтобы получился диплернинг. Знаешь что тогда делает ньюфаг? Он повторяет хипстеркий подход и тут же описывает свой опыт в бложеке чтобы остальные могли повторить. Матаноняш, я какое-то время слежу за тредом и ты никому не помог и не написал ни одного гайда по которому можно было бы вкатиться в твою религию.

Пожалуйста, напиши что-то конструктивное чтобы помогло и работало (например, что делать со страшной SVM кроме хипстерского перебора гиперпараметров из вариантов в sklearn, хотя бы как найти нужное ядро), или начни подписываться чтобы тебя можно было скрыть.

А вообще я хочу чтобы хоть кто-то меня учил, а не только показывал насколько больше знает чем я. Или хотя бы чтобы учился вместе со мной.

2) Да, можно сделать в таком духе.

3) Думаю, что можно попробовать сделать две нейронки сходной архитектуры, в одну впихнуть важные параметры, в другую те, что ты считаешь менее важными. Потом присоедить эти две нейронки к общему слою и вывести.

Так будет проще искусственно подогнать веса в нейронке с важными параметрами, возможно даже искусственно сможешь их просто домножать при попадании в выходную нейронку. Такой подход позволит наверняка выделить то, что тебе важно, если ты подобрал "важность фич" корректных образом.

2) В таком духе работает не лучшим образом, это самый примитивный подход который получилось реализовать.

3) У меня есть какое-то подсознательное чувство что это кисленькое решение. Еще нужно подумать что делать с классическими моделями вроде SVM и лесов.

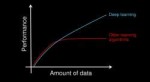

SVM слишком вычислительно сложный для большого (а по нынешним меркам крошечного) количества данных, как говорит Ын, и сложное ядро тоже дорого вычислять, а если дорого, - значит это не работает, и поэтому сразу все ушли с SVM на нейроночки, несмотря на все их минусы

>подобрать гиперпараметры эффективно нельзя

>нет можно, надо другую функцию потерь

>как?

>гиперпараметры нинужны!

Жду очередной порции нелепых кривляний нечеткого петуха в оправдание своей никчемности.

> Жду очередной порции нелепых кривляний нечеткого петуха в оправдание своей никчемности.

Мань, я ж написал про эвристики. Если это может сделать человек, то может и алгоритм.

>>81059

> SVM слишком вычислительно сложный для большого (а по нынешним меркам крошечного) количества данных, как говорит Ын, и сложное ядро тоже дорого вычислять,

Негров распознавать? Да, для такого SVM малоприменимы. Но можно ограничиться временными рядами, лично мне это интереснее, чем негры и разрисованные под Пикассо котики.

185 Кб, 1013x800

185 Кб, 1013x800Я не буду расстраиваться только потому что нечетконяша меня проигнорировал.

Зато мною была разгадана тайна почему тебя не любят в треде. Задача плохая потому что твой любимый метод с ней не справляется? Серьезно? Можно ограничиться тем что у тебя получается делать? Все что не получается это ненужно и для хипстеров? Да ты же ограниченный!

Можно провести параллель с натренированной сетью в которой пользователю (вернее разработчику) предлагается самостоятельно натренировать последний слой на собственной выборке.

Ну и зачем нужны твои временные люди? Сверхчеловеки живут вне пространства и времени и смотрят на картины Пикассо с котиками-неграми.

> Задача плохая потому что твой любимый метод с ней не справляется? Серьезно?

Плохих задач нет, есть плохие подходы к решению. Всякое хипстерство с нейрон очками как раз из этой области.

> Ну и зачем нужны твои временные люди?

Чего? Временные ряды это задача, с которой ни один существующий подход не может справиться. Никакие хипстерские диплернинхи на топовых видюхах не дают качества заметно выше какой-нибудь arima из 80х. Ящитаю, это пиздец. А проблема только в том, что нет понимания этой задачи.

дак для временных рядов (я только про звук знаю и не очень хорошо) нейроночки тоже много где заменили svm, так как для svm для звука нужны всякие костыли вроде гауссовских смесей, которые являются довольно приближенной и грубой штукой, ну и для звука хорошо заходят сверточки и рекурсия, я не уверен, можно ли сделать для svm рекуррентное ядро (думаю, можно).

Ну, а для части временных рядов и марковских процессов хватит даже и логрегов.

Ну и основной хайп для потребителя в звуке.

Я имею в виду предсказания временных рядов, скажем финансовых. Хотя бы дальнейшего их направления при минимальной экстраполяции. Как пример, для бинарных опционов хватило бы правильного предсказания направления значения, т е будет ли цена выше или ниже текущей через минуту, с точностью хотя бы 30%, т.е чтобы не было больше 3-4 неправильных предсказаний подряд. Даже такие скромные требования не гарантирует любой алгоритм. Лично я вижу в этом всю суть нынешнего машобчика. А негров распознавать, да они мне в хуй не стучат. Как и котики.

Очевидно это индуктивная машинка, на нее подаются данные, она считает вероятность удачного исхода.

> Очевидно это индуктивная машинка, на нее подаются данные, она считает вероятность удачного исхода.

Ну байесовский вывод. В R дохуя такого. Только вся возможная неточность к вероятности не сводится, возможны и другие варианты. На основе большинства из которых системы вывода вообще никем и никогда не делались, поэтому невозможно сказать даже что из этого может оказаться полезным. Хипстеры в это не могут, так и живём.

Ты хоть что-то делаешь кроме того что ноешь? Покажи свой гитхаб или пейперы.

58 Кб, 848x480

58 Кб, 848x480Конечно! Как насчет дружеского совета? Свали.

> Чую это какой-то бесполезный подход к стратегии распознавания предметов

Распознавание нейрон очками так и работает. Берётся миллион фоток негров, тренируется сеть, затем сети предъявляется миллионпервый негр, сеть выдаёт ответ что это горилла, у негра попито бомбито whomst da fak faking gugle, my friends not a gorilla

ну с классификацией блять понятно. Меня сейчас дико интересует что именно на картинке в области 0х0х100х100 негр а 50х50х100х100 кот...

Оно само может в сегментацию. Поэтому если на картинке есть и негр и кот, распознаётся и то и другое.

Сделай нейроночку трёхканальной )))

А что не так, мань? Там определённо есть распределение (или некая суперпозиция распределений) отличное от нормального, т.е не чистый рандом , в чем очень легко убедиться (мартингейл не работает, а в случае нормального распределения заходил бы идеально).

>Там определённо есть распределение

Хуяпределение. А еще твое нейронное говно не поддается отладке.

> А еще твое нейронное говно не поддается отладку.

Тебе лет сколько? 12? Что ты сказать пытаешься, хуесос? Рюсське изика можешь, нихт? Или пиши по-человечески или иди нахуй уже.

87 Кб, 605x578

87 Кб, 605x578Пикча отклеилась

>не чистый рандом

Не, ты точно ебанутый. Т.е. ты считаешь, что возможно предсказать, например, что через минуту кто-нибудь по какому-нибудь инсайду от тёти Сраки начнёт распродавать свои активы? А для того, что ты выше написал, не нужно ничего, кроме макаки и графика курса - она такой же процент точности выдаст. И это тебе нихуя не даст, лол.

9 Кб, 211x239

9 Кб, 211x239>если человек с опытом может подобрать гиперпараметры нейроночки, значит это алгоритмически разрешимая задача

Ну посчитай количество повышений и количество понижений цены, если так непонятно... случайные там данные, ясно?

Мои варианты:

- разгадывание капч за 0.00005 копеек сразу нахуй

- покер-бот потратить несколько месяцев на обучение, а потом выяснить что он умеет играть только сам с собой, но не с людьми

- предсказания курсов валют/акций смущает что на уолл-стрит сидит куча профессоров-математиков с гигантскими саляри и до сих пор ни у кого не получилось

- конкурсы на kaggle опять же конкурировать с командами суперзадротов, а у меня бекграунд пара курсов по TF

Что скажете?

Продать и пропить.

> случайные там данные, ясно?

Пиздец ты тёмный. С москвасранска поди, лол. Я ещё раз скажу, при чистом рандома, т.е. нормальном распределении, наилучшая стратегия это мартингейл. Но, очень легко убедиться что это не так. Достаточно зарегаться на каком-нибудь биномо и слить тестовый счёт. Можно поумнее - посчитать для временных рядов сечение Пуанкаре и т.п вещи, по которым опять же, наглядно увидим, что там не рандом. Это же азы, кем надо быть чтобы не знать очевидного.

> предсказания курсов валют/акций смущает что на уолл-стрит сидит куча профессоров-математиков с гигантскими саляри и до сих пор ни у кого не получилось

Я уже писал, почему ни один диплернинх временные ряды не возьмёт. Можешь сам попробовать, архивы курсов валют есть на TrueFX с миллисекундным разрешением, попробуй на этой ферме и убедись, что нихуя не вышло.

Эх, на такой ферме почти ИИ можно обучать

Нужно быть матанодебилом вроде тебя чтобы полностью игнорировать саму предметную область задачи. Какой же ты тупой, весь тред загадил.

> Нужно быть матанодебилом вроде тебя

А, понятно, ты тот деградант, копротивляющийся против математики и здравого смысла. Так бы сразу и сказал, вопросов больше не имею.

Хуячить порн с селебами на заказ. Гугли deepfakes.

Ну да. Биржи зависят от скрытых факторов, которые ты физически не можешь для модели взять. У меня кореш из дойчебанка, он там какой хуйни только не вертел - в итоге никакого стабильного выигрыша, даже маленького.

>Биржи зависят от скрытых факторов, которые ты физически не можешь для модели взять.

Ты про теханализ не слышал? Так я тебе расскажу. Сколь угодно скрытые факторы, вплоть до секретных указаний аннунаков с Нибиру, либо отражаются на показателях рынка (т.к. приводят к каким-то действиям на рынке), либо не отражаются (и тогда физически не могут влиять на рынок). Не согласен? Тогда расскажи, как можно влиять на рынок, не влияя на его показатели.

>У меня кореш из дойчебанка, он там какой хуйни только не вертел - в итоге никакого стабильного выигрыша, даже маленького.

Я еще раз скажу. Ни в одном существующем методе задача не ставится так, как надо. Потому что мы имеем дело с суперпозицией неизвестной структуры неизвестных же распределений. С простой аппроксимацией тут и делать нечего, нужны методы "развернуть" эту суперпозицию без априорных знаний об ее структуре. Такая задача в машобчике вообще не ставилась никем кроме Ивахненко, но он соснул, т.к. не имел достаточных вычислительных мощностей + не учитывал того, что эта задача с вероятностью 146% некорректнопоставленная + предлагал довольно деревянные методы подбора суперпозиций т.н. "полиномов Ивахненко", хотя сама структура этих его полиномов, как и метод представления через них полного степенного VKG полинома Вольтерры-Колсогорова-Габора, это очевиднейший вин. Я тут описывал, как эти ограничения можно попытаться обойти - вместо таблиц полиномов Ивахненко использовать генетическое программирование с типизированной лямбдой, вместо обычных лоссов использовать комбинированные критерии Ивахненко, а вместо OLS взять SVM.

https://www.vedomosti.ru/technology/news/2018/04/02/755633-kotirovki-intel

>отображаются

И как это предсказать? Получил инсайд от друга из апла - поднял шекелей, не получил и решил закупиться прямо перед падением - соснул хуйцов.

>Получил инсайд от друга из апла - поднял шекелей, не получил и решил закупиться прямо перед падением - соснул хуйцов.

Инсайд чего?

Ты кукарекаешь годами, но сам так ничего и не сделал.

Так а какого хуя ты ничего не делаешь, если у тебя в голове потенциальная идея на миллионы?

>>82006

Блять, иди ты нахуй. Ты же у нас спец по рынкам или нет? Это настолько детский вопрос, что просто охуеть.

>Ты про теханализ не слышал? Так я тебе расскажу

>подрубил менторский тон

>мозги не подрубил

>Ты же у нас спец по рынкам или нет? Это настолько детский вопрос, что просто охуеть.

Я не просто так спросил, ты не понимаешь, о чем говоришь. Рынок ты не развернешь за 1 секунду так,чтобы те, кто закупился уже через 2 секунды соснул. Такого даже в бинарных опционах не бывает. Задача - определить направление изменения рынка по изменениям основных показателей. Инсайд поможет разве что заработать больше шекелей, но не радикально всех переиграть.

>>82010

>какого хуя ты ничего не делаешь, если у тебя в голове потенциальная идея на миллионы?

Потому что во-первых, хуй знает как это реализовать, я даже R не настолько знаю, во-вторых, у меня идеи и получше есть.

Почему нет в шапке? Самое то для абсолютных нубов.

Для абсолютных нубов надо с арифметики начинать.

>алгебра, теорвер и матстат, базовый матан calculus многих переменных

С чего начать? Знаю только, что такое производная и как ее считать. Начать с mathprofi, а потом уже углубляться?

https://geektimes.com/post/300445/

Что-то вроде программы ELIZA, но способной к самообучению?

Ты хочешь, чтобы он возненавидел математику?

Напиши еще раз про временные ряды

Вроде все просто, импортим с пацанами из кераса и слесарьфлоу, радуемся жизни, но сам алгоритм не нравится мне. Этакий блек-бокс, который хуй знает какие закономерности ищет. Особенно cnn не люблю, люди как сильвер буллет себе их представляют.

Мне кажется нейронки хороший алгоритм наравне с другими(HMM, бустинги, svm), но на всех конкурсах, конфах и статьях нейроночки практически везде рвут "обычные" алгоритмы.

Неужели это и правда так, что старые модели больше не нужны?

Для грязных данных без структуры еще рулит ГБМ, см. тот же кагл где всякие предсказания кликов и прочая бурда. Все остальное - нейроночки.

мож захуярим че нить типа приложухи которая бут скачивать сет по тегам? тип слонёнок или обезьяна

Ты один проходишь или с кем-то общаешься на эту тему? Я, к сожалению, всю учёбу учил французский, сейчас вот на ходу вникаю в технический ? английский, возникают проблемы с пониманием смысла, хотя до 5 недели без проблем в одиночку дошёл.

Один. Английский понимаю хорошо, т.к. уже второй год как погрузился в чтение англонета и тех. литературы, просмотр фильмов в оригинальной озвучке. Пишу и говорю плохо потому что негде тренироваться.

Собственно вопрос, достаточно ли 6-8 месяцев для того чтобы вкатиться в нейрончики и написать по ним дипломную работу

Опыт в программировании есть, но с машинным обучением не сталкивался до этого. Хочется попробовать себя в этом направлении, но есть опасения что я просто не осилю за такой срок что то освоить на приемлемом уровне

>В чём разница между полносвязной и свёрточной сетью?

Очевидно же, сверточная - не полносвязная. Т.е. последующий слой связан не со всеми нейронами предыдущего. Перцептрон полносвязный, а в сверточной сети связи по типу зрительной коры кошки.

Не помогай откровенному быдлу.

а вот положим мы натренировали полносвязную сеть и свёрточную сеть. И просим распознать изображение. Время работы свёрточной сети будет меньше времени работы полносвязной? Или одинаково?

Нет.

Смотря что такое приемлемый уровень. Статьи читать не сможешь, не говоря уж о писать. Использовать керас для тренировки простых архитектур можно научиться.

Генерируй сам.

могу помочь с размечиванием. За день могу наразмечивать фоток 300 если затея стоящая

Идея распознавать рос и укр номера. Сначала с камеры находт табличку, потом пытается из вырезанного номера распознать символы.

Для дииплернинга хотя бы 10000 нужно.

>>82652

По-хорошему ты должен отлично разбираться в теме своего диплома, так что с нуля я бы не брался. Нейроночки на уровне современных исследований все равно слишком сложны для уровня бакалавра. Можешь прицелиться на магистрскую работу, как раз два года более-менее достаточный срок для нормального вката.

5,6 Мб, mp4,

5,6 Мб, mp4,1280x720, 0:50

>распознавать рос и укр номера. Сначала с камеры находт табличку, потом пытается из вырезанного номера распознать символы.

И если номер украинский, то владельцу, найденному по базе, на телефон скидывается пикрелейтед? Ты пограничник штоле? Сколько распилили на этом прожекте, если тебя отправили на мейлру искать халявных исполнителей?

разной компилируемой парашей

Специально обученный человек (обучение не так долго) может распознать вырезанный номер лучше.

russia-way

53 Кб, 326x500

53 Кб, 326x500>Напоминание ньюфагам: персептроны и прочий мусор середины прошлого века действительно не работает на серьёзных задачах.

Поясните ньюфагу, а что там принципиально нового появилось, кроме пердсертронов и "прочего мусора" ?

Если положить что любая комбинация или модификация персертрона тот же персертрон.

Ню-фагу читать нужно. Учиться, учиться и еще раз учиться, как завещал Великий Дедушка Ленин.

Во всей голосовой индустрии. ASR, SV, Spoofing.

Не говоря уж про картинки, там дефакто cnn стандарт.

> Поясните ньюфагу, а что там принципиально нового появилось, кроме пердсертронов и "прочего мусора" ?

Ничего. Функции активации поменяли, полносвязность выпилили, ещё косметические мелочи. Главные недостатки никуда не делись, данные все так же обрабатываются квадратно-гнездовым методом при том, что 90% из них вообще не участвуют в формировании решающих правил классификации итд., т.к не лежат на границах, разделяющих классы (для классификации опять же).

Это не ответ по существу.

Имеются в виду оригинальные сетки, без модификаций. Тут иногда проскакивают нюфани, которые плачут "накрутил миллиард линейных слоёв, ничего не работает, что делать".

> Тут иногда проскакивают нюфани, которые плачут "накрутил миллиард линейных слоёв, ничего не работает, что делать".

Зачем они это делают?

batch norm, ReLU, cross entropy loss вместо квадратичной, конволюции, resnet, рекуррентные сети, автоэнкодеры, attention механизмы, GAN

84 Кб, 350x486

84 Кб, 350x486>batch norm, ReLU, cross entropy loss вместо квадратичной, конволюции, resnet, рекуррентные сети, автоэнкодеры, attention механизмы, GAN

Но ведь это все мусор из средины прошлого века.

> Но ведь это все мусор из средины прошлого века.

Это не мусор. Это косметические изменения перцептрона. Которые не меняют уебищной сути обработки данных, при которых обсчитывается все оптом, хотя это не требуется для построения правил классификации итд.

Человекство

Будь добр, объясни тогда основной принцип доказательства простым языком.

Как мы переходим от «есть произведение n скобок (a+b)» к известной сумме комбинаций a и b с различными степенями и коэффициентами?

Да

X - входная строка для машины тьюринга

Y - что мт выдала на выход

Какие нейроночки такому обучатся (построят из своих слоев этот алгоритм) и будут хорошо предсказывать?

В такой формулировке безразлично, машина ли у тебя Тьюринга, программа на С++ или Вася с листочком бумаги и ручкой.

Естественно, все зависит от преобразования. Если у тебя там просто каждый второй символ удаляется из входа, то простейшая RNN сможет сделать. Если у тебя там какое-то шифрование, то никак. И полный спектр возможностей между этими двумя крайностями.

Хотя нет, с удалением символов тоже будет гемор, т.к. длина входа и выхода разная, лол. Нужна будет неограниченная память, что невозможно, либо какая-то нетривиальная схема для вывода.

> Какие нейроночки такому обучатся (построят из своих слоев этот алгоритм) и будут хорошо предсказывать?

Любые. Важно только чтобы датасет содержал все возможные входы и выходы. Можешь хоть линейную регрессию использовать, входы и выходы же полностью детерминированы и представляют собой правила МТ, даже аппроксимировать ничего не требуется.

Аноны, вот у меня есть очень шумные данные и классификатор.

Меряю его ф1 на случайном разбиении - получил, допустим, 0.9.

Меряю его на 2-fold, получаю условные mean = 0.9 (так же) и стандартное отклонение 0.05.

Меряю его на 100-fold и получаю тот же meam = 0.9, но стандартное отклонение 0.1

Есть ли метрика, которая определяет confidence level результатов? Для малошумных данных наверное это не так важно, но у меня все очень сильно зависит от того, как разбить сет на трейнинг и тест сеты.

Это не промышленное применение, а пруф оф концепт в научный журнал, рецензент на мажор ревижоне спрашивает, почему я для кросс валидации выбрал k=10. А мне похуй если честно какое выбирать, кросс-валидация в принципе нужна только для того, чтобы показать, что это у меня не ошибка переобучения, а классификатор в принципе работает.

>очень шумные данные

Попроси их не шуметь. В смысле denoising autoencoder наверни какой-нибудь.

>спрашивает, почему я для кросс валидации выбрал k=10

Ну так и шли его основы изучать.

Вообще, в том же sklearn, например, кросс-валидацию можно было разную получать, рандомно "тасуя" данные (shuffle). Но я точно не помню.

Чем больше фолдов, тем точнее оценка метрики, но при этом ее дисперсия растет, например LOO дает самую точную оценку, но при этом имеет наибольшую дисперсию

Ну рецензентов нельзя нахуй слать. Надо вылизать жопу и доказать со ссылкой на цитируемый источник почему я прав. А я хуй знает почему - тут обычно как инженер решил что норм, так и есть. На стекэксчейндже люди берут значения k потому что они привыкли и делали так раньше, но на это не сошлешься.

Мне бы в идеале методику по которой можно получить доверительные интервалы и аргументировать, мол, что выбрав к=10 я попал в 99 перцентиль, чего я и добивался.

Расшумливать данные на лету нельзя, расшумливать только тренировочную выборку можно, но мне если честно не хочется такие серьезные изменения делать сейчас, все картинки в статье переделывать придется и как-то объяснять рецензентам такие маневры.

Да, это я и понимаю. Но для этой точности есть ли какая-нибудь формальная методика? Доверительный интервал или что-то в таком духе.

Метрика*

А теперь представь, что данные очень шумные и нам охуенно повезло с разбиением и тестсетом. На другом тестсете ввиду шумности данных классификатор покажет худшую производительность.

Множество фолдов поможет этого избежать, на к=2 у меня низкое стд и на к=100 оно высокое.

Вот как мне доказать, какое к достаточно, чтобы в мин плюс/минус стд входил 99 перцентиль, условно говоря.

Я доказываю пруф оф концепт, в реальных применениях данные будут другими и классификатор придется обучать на них каждый раз.

Спасибо, анон. Это не то, что я реквестировал, но то, что мне надо.

насколько вообще питон реально подходит для сурового продакшена? У кого какой опыт? Имеет ли смысл разворачивать хадуп кластер, если данных относительно немного (десятки гигов, но не террабайты), но нужна надёжность/возможность раскидать вычисления на пару машин и сохранять результаты в HDFS, чтобы не бояться, что они умрут вместе с hdd? cloud storage не предлагать

Как в бэкпропогэйшн во времени определяется какие веса с какими ошибками нейрона перезаписи ячейки памяти и нейрона извлечения из ячейки памяти?

те имеет идти на форум тенсора, это уже попахивает инжиниренгом. Тут чисто матаноэлита

Попахивает тем, что кто-то не осилил базу и пытается прыгнуть выше головы. Похоже на многотредовую эпопею какого-то дауна (это не ты был?) несколько месяцев назад про "ну кок жи щитать гродент сверточной сити?????"

> Почему все только на обучении с учителем сосредоточены? А не на обучении с подкреплением?

Хипстеры только в этом году про уравнения Хебба узнали. Так что все будет, но не сразу.

Помню две работы: в одной погоду обсчитывали на нейроночке, вроде был выигрыш по сравнению со стандартными решателями дифуров, которые обычно там используются. В другой обсчитывали квантовое состояние какой-то сложной системы, которое напрямую было считать слишком долго. Вторая работа в нейчер была.

> Если ты такой умный, то где же тогда твои деньги?

А у Перельмана где деньги? Или Ашот с рынка на лексусе умнее? Что-то не сходится в твоей манятеории. Может быть то, что ты пытаешься пиндосскую поговорку использовать применительно к Африке со снегом?

Да хуйня поговорка, даже в Пиндостане. Можно быть невъебенно умным, просто в Пиндостане доедать хуйцы не будешь или будешь. Вон, сколько в Тесле инженеров, а богатеет только Маск.

>Перельман

Ой-вей, гои поверили, что наш человек будет жить на 15 тысяч и есть одну гречу. Гриша таки в Швеции программистом работал (и в Швейцарии до этого, если мне память не изменяет). Но ты продолжай верить в свои сверхсилы и нихуя не делать.

КРЯ жадные пидарасы

wij = wij + lerning_rateinput_valuesum(activation_value(1 - activation_value)sum(error*wjj+1))

бля вакаба

wij = wij + lerning_rate&input_value&sum(activation_value(1 - activation_value)&sum(error&wjj+1))

Сейчас мне кажется это просто ебучая формула прямого подсчёта на сколько эта хуйня возможно должна измениться. То есть тупо и прямо. Но градиент, который даёт чистое и правильное значение, я всё равно не понимаю.

Ну. Пусть тренирует на более важном сете больше раз

> wij = wij + lerning_rate&input_value&sum(activation_value(1 - activation_value)&sum(error&wjj+1))

Один из вариантов стохастической аппроксимации Роббинса-Монро. Собственно, как и в картах Кохонена. И чем вам в таком случае векторное квантование не нравится? А я скажу, вы просто не понимаете, чем занимаетесь.

> Как из мимокрокодила стать машоббоярином?

Читать, писать что-нибудь. Учиться, учиться и учиться но не коммунизму.

Пиздец, лучше останусь в своём уютном энтерпрайзе

Эта специализация от мфти и Яндекса - хороший вариант для вката неофиту?

Математику курю отдельно и глубже (там ее как-то совсем поверхностно дают).

>https://www.coursera.org/specializations/machine-learning-data-analysis

не знаю, нахер эта курсера вообще нужна? С матскилами вкатится ты можешь просто почитав старт гайд от sklearn, а дальше есть божественные статьи того же Стенфорта например и вообще материалов очень много. Вот например http://colah.github.io

Не, матскиллов у меня пока нет.

Правильно-ли понимаю что если знать заранее что с чем должно коррелировать то именно машинное обучение здесь это overkill?

смотри автокореляцию для ВР

Для таких случаев используют иерархический софтмакс (тогда обрабатывать приходится не дохулиард нейронов, а логарифмическое их количество от этого дохулиарда). Конкретные архитектуры - CBOW и skipgram, реализовано в word2vec, но все нужное есть и в слесарьплове. Если нужно именно для отдельных символов в словах, то SISG (subword information skipgram), есть в пейсбуковском fasttext.

Ещё кое что непонятно. При обучении RNN бэкпропогэйшн во времени ведь может моделировать ошибку до начала работы самой сети. Как на улететь в бесконечный зацикленный алгоритм в первой же итерации?

1,6 Мб, 2697x2672

1,6 Мб, 2697x2672червяков вообще анирал почситать

видево жи

Эти тоже кормовые, но тут мне скорее нужно контролировать их численность чтобы выкидывать лишнее. Оверпопуляция только ухудшает их положение - загрязнение подстилки и банки, нехватка корма личинкам.

ищи контуры, и попроси их не лезть друг на друга. тебе достаточно определить всего лишь олну дугу для детекта.

Я не занимаюсь машобом, я только дал прикладную задачу. Если кто-то хочет взяться, буду рад посодействовать. Если нет... то нет.

Ну считать ты их никак не посчитаешь через нейросеть. Можно их распознавать через нейросеть. Хотя, конечно, можно собрать ебенейшую архитектуру чтобы она считала через несколько, но легче взять картинку и распознавать где находится один жук, а в следующую итерациюпросто затирать это место на картинке белым цветом. Таким образом понадобится только одна маленькая сеть и пара функций обработки изображений.

Ты мне предлагаешь каждые 2-3 дня вылавливать каждого жука ради взвешивания? Я бы тогда их считал просто так.

неплохо

кучку взял и взвесил, можно с гнездом взвешивать, даже доставать не нужно. у тебя хуйня с постановкой задачи, 2 маленьких жука и один большой будут жрать как четыре маленьких, плюс большой даст им пизды и поебет самочек

правда в этом случае нужно найти очень маленькие фичерсы жука, как например клювик, или чтобы сеть могла определить заднюю и переднюю лапку жука (и посчитав между ними расстояние понять что это жук), потому что при таком подходе от низлежащих жуков будут оставаться только маленькие кусочки. Так же вопрос а если на картинке тысяча жуков как нейросеть из них выберет того единственного, которого она опознает?

Загон им из картонки сделай.

Да вообще без проблем. Говорит нам где жук - затираем его там и прибавляем ещё единичку в счётчик. Распознавать то всё зачем? Тут по пятнадцать свёрток в два слоя, полносвязку с выходом на координаты, этого хватит. Хотя этого много для такой простой жучары. Обучать на картинках в гигле, которые скачиваются специальными программами.

Есть 180 входов, 4 выхода и 1 tensorflow на питонах.

Помогите описать занесение входов и получение выходов. Обучение не нужно, веса задать случайными значениями.

weights = tf.variable((180,4))

x = tf.placeholder()

y = activation_function(какая-то хуйня я дальше не помню, но суть в том, что нужно перемножить все x со всей строкой весов и это суммировать)

sess = tf.session()

sess.run(опять забыл)

Оп-а, ситуация теперь прорисовывается. Спасибо больше. Если никто не распишет подробней, буду гуглить.

Короче, не гугли гайды на русском. Они все полнейшее говно. Нужно постараться чтобы сделать хуже, серьёзно. Лучше прочти документацию, даже через гугл переводчик если не знаешь ангельский.

С ангельским знаком, но на сайте tensor меня мучают или распознаванием по MNIST, или фотографиями ирисов(

Простого, для недалёких людей, не нашёл.

> Простого, для недалёких людей, не нашёл.

Хоспаде. Простое для недалёких макак это Keras. Не мучай себя брат макак.

output = []

x = tf.placeholder(dtype = tf.int32, shape = [None, 180])

w = tf.variable(tf.random_normal([180, 4]))

func = map(activation_function, matmul(x,w))

with tf.Session() as sess:

------output = sess.run(func)

Может сработает, а может нет, хуй знает, но тут множатся матрицы так что возможно форма стоит не в правильном порядке и строки нужно поменять со столбцами.

>>87019

А тебе хуй за шиворот.

Исходники открой и охуей, сколько там строчек кода. Это просто удобная либа.

103 Кб, 550x550

103 Кб, 550x550Да. Без обучения и с одним слоем. С обучением 9 будет, каждый слой +3 строки.

Лол, нет, это же полносвязка на фреймворке.

>9 будет, каждый слой +3 строки.

так, а в чем тогда еба? я могу и 12 строк написать, где мяготка, вы фреймворкоебы?

Дальше начинается вообще самый смак. Ты можешь написать в те же 6 строчек ультраклёвую сеть с одним слоем просто импортировав её оболочку из либы.

если все так просто, почему это не работает? где там вменяемые автономус вехикалс или окр?

ну в общем да. А чё еще надо? Модели валяются на гитхабе в екзамплах кераса. Там и анализ картинок, и лексика. Да блять я вот собрал модель из хеловорд туториала в три строки и до се ей пользуюсь для всего. Надеюсь, что когда нибудь пойму что она делает.

Ало, да потому что эти оболочки и фреймворки разрабатывают топовые учёные топовых корпораций. Нахуй ты меришь способность местных по докам кнопки нажимать как способность разработки передовых технологий?

ученые в говне моченые, оставим проблему распознования негров, а возьмем к примеру окр русских слов с ударением, файнридер виляет жопой и не монгут, тезеракт сосет с проглотом и без ударений, где ваша магия?

А, ну да, там фиддикт нужен. В сессию когда запускаешь нужно засунуть {x:[твоя хуйня]}

И при этом надо ещё указать что это аргумент feed_dict конечно.

Предпочитаю heptapod b.

Вот кстати, да. В туториалах это самое сложное.

То что ии так не делается. Никто сейчас не может высрать ничего лучше распознавания видео.

Можно наверное по бликам на панцырях детектить.

Это всё тупые хипстеры, лучше бы ватника навернули

Как вы на англопараше слушаете, это же не язык, это говно

Это не ИИ.

Мини задача, есть пользователь, который хочет посмотреть аниме. Каждую серию и каждый тайтл сопровождает 10 источников. Например 10 разных озвучек, или 10 переводов сабов от разных команд. Вот я хочу, чтобы пользователю не пришлось каждый раз выбирать озвучку, а построить список предпочитаемых пользователем источников (источник может включать в себя такие параметры как "команда озвучки", "разрешение видео", возможно что-то ещё). То есть на выходе должен быть тайтл с оптимальным параметрами для пользователя, без необходимости выбирать каждый раз вручную, смотреть ли в разрешении 1080р но озвучкой от васяна с мерзким голосом, или посмотреть 720 но в той озвучке, которую хочет пользователь. То есть необходима оценка приоритетов, что важнее для пользователя, любимая озвучка, или высокое разрешение, например.

Дело также в том, что не у каждого тайтла есть озвучка или Сабы от любимой команды, и нужно автоматически выбирать наиболее подходящий вариант на основе прошлых выборов. В общем такая задача, решил выбрать ее чтобы попробовать что такое машоб, если он подходит под эти задачи. Но ее нужно решить

В общем мне хотя бы сначала определить, является ли моя задача областью решения которой является машоб

Смотри все очень просто. Скачиваешь питон и керас (это такая библеотека). Читаешь официальный туториал, там все просто и примеры есть. Затем делаешь нейрал нетворк из слоев количеством примерно сколько у тебя бывает разных озвучек. Каждый слой состоит из н нейронов где н это байтовый размер озвучки. Потом ты просто прогоняешь сетку по всем озвучкам и получаешь ризультат.

Изи пизи, как говорил Линус тарвальдс

84 Кб, 350x486

84 Кб, 350x486Не могу заставить его работать.

Есть у кого удачные примеры?

Давайте назовём старые методы новыми именами для того, чтобы ими все пользовались.

Можно в 28 без вышки вкатиться в машоб?

Нет, не разрешаю.

Или там дела как и с капсульными НС ?

Щас бы 5 лет учится, что бы матанопетуханские каракули разбирать

В идеале хочу что то такое - https://habr.com/post/343222/ но не могу додуматься, как должны работать карты центров, и в гугле информации по ним нету.

Повтори, я не расслышал.

97 Кб, 400x400

97 Кб, 400x400а есть ли в этом профит? Почему нельзя просто сделать Dense и радоваться?

> Сверточным сетям на вход, как правило, подают картинки, а они двумерные

Тензоры, вообще-то. И они хоть сколько мерные, но в случае картинок обычно 3хмерные - R, G и B каналы. Пошто ж вы негр амотные такие, слесарьплов для вас же именно так назвали, что он тензоры считает. Ну в машобчике тензор не то же что в физике, в целом и скаляр, и вектор и матрица это тензоры, речь скорее про общий подход к массивам.

> 3хмерные - R, G и B каналы

Минуточку, 3 в данном случае это длинна последней размерности. лол

Под размерностью я имею ввиду длину самой формы массива.

например форма массива

[[211,211,211], [211,211,211]]

есть (2, 3), значит его мерность 2

>Тензоры, вообще-то

Я простой слесарь, для меня массив - это массив, а матанопетухи пусть как хотят его называют.

Так ты не слесарь тогда, ты макака. Разница огромная. Алсо, макакам ИТТ слово не давали.

Да я и так молчу, тут разговаривать не с кем, одни шизики-теоретики. Что вы вообще в /pr забыли, вам прямая дорога в /сцы

Что не отменяет, что реально.

А капснет тогда что?

> есть Слесарьплов.жс

И он полностью на жс, в браузере работает? Или просто обёртка для пистоновского слесарьплова?

Потому что как бы ты не подавал данные, преобразовываешь ты их согласно квадратному ядру.

Так это один массив нужен и цикл. Всё.

Прямоугольные же.

Пиздец блядь, такую громозкую хуйню делают только ради того, чтобы буковку s распознать, пиздец.

> Пишите предложения по шапке, господа.

Если что-то нехипстерское добавить, мало кто поймёт. А с хипстерского толку мало, после такого чтива поциент идёт сюда и спрашивает, хуле сотни слоёв не хватает для линейной регрессии. Лично мне неизвестны книжки, в которых и теория давалась бы нормально, и последние достижения. Скорее всего, таких просто нет. С одной стороны Вапник, который с первых страниц ебашит вариационное исчисление, с другой хуйня уровня import slesarplow as sp. С третьей вроде норм книшки, но написаны в 90е годы и про всякий диплернинх там нету.

Ну ты же циферку пять не распознал на картинке. Такую громоздкую хуйню родили, а она с такой простой задачей не справилась, пиздец.

>А с хипстерского толку мало, после такого чтива поциент идёт сюда и спрашивает, хуле сотни слоёв не хватает для линейной регрессии.

Согласен. Это какой-то пиздец. Прочитал статью какой-то тянки для макак об Convolution, бля лучшеб вообще не читал. Вот это мания писать просто о сложном иногда совершенно лишняя и уводит в неправильное понимание вещей.

Чё вы доебались до этой S. Тут вопрос нахуя нужны Conv слои? Когда Dense вполне справляются с битмапами расшейпенными до одномерного массива?

Дурень, блять, как же ты надоел.

>вполне справляются

Они вполне не справляются. Развернул ты картинку в строку - что там ловить? Даже свёртку после этого поставь с кернелом 1xn - нихуя фич не словишь. Свёртка с первого слоя видит целый кусок картинки, а не хуй пойми как расположенный.

спасибо