Вы видите копию треда, сохраненную 3 сентября 2018 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Продолжаем выяснять, кто двигает ноуку: толпы смузихлёбов или фундаментальные деды.

FAQ:

Я ничего не понимаю, что делать? Либо в тупую import slesarplow as sp по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/ | https://www.general-ai-challenge.org/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Архивач:

http://arhivach.cf/thread/340653/

http://arhivach.cf/thread/355442/

http://arhivach.cf/thread/360889/

http://arhivach.cf/thread/366809/

Там же можно найти треды 2016-2017 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

Предыдущий тред: >>1190173 (OP)

В ответе на этот пост можете предлагать исправления для шапки. inb4 оп - хуй, шапка - говно

420 Кб, webm,

420 Кб, webm,1280x720, 0:01

Оп, ты сам этот диплернинхпук читал? Это же пиздец натуральный. Чисто по приколу потыкал, с 9 главы про сверточные сетки у меня пикрелейтед реакция. Чего они там нахуевертили, суть этой хуитки в пару картинок можно пояснить, для кого они там развели бодягу? Хуй проссышь же, про начинающих вообще молчу.

грантогоспода получают бабосы

Читал немного. У меня мат. образование, мне норм было.

А как надо-то? Как хипсторы на медиумах, где "жмакните сюды, хуяк-хуяк, готово" и ничего совсем не объясняется? Да и не сказать, что там хардкор прям.

Я понял твой вопрос, но он настолько элементарный, что объяснять слишком долго, и толку от этого будет мало. У тебя нет базы, и пока ты нормально не изучишь матан и тервер, тебя будет ставить в тупик каждое уравнение. Тебе не нужен ответ, тебе нужно учиться, и ответ станет для тебя очевидным.

> Вопрос был про вывод формулы и применение правил суммирования и умножения из теорвера.

Хоспаде, да это первая глава любого учебника по теорверу, Вентцель, например. Разница только в том, что в твоем уравнении были векторы вместо скаляров, т.е. еще линейная алгебра впридачу.

Вопрос был о знаке звёздочки в макабе. Но маняматики не могли применить теорему Байеса для мысли. Читайте Гарри Поттер и методы рационального я сказал! Лучшие введения в диплернинг бубук! А китайцы уже давно кушают бамбук!

Да.

Это массив.

50 Кб, 960x492

50 Кб, 960x492> в моноидальной категории эндофункторов

В монголоидальной. К слову, на coq'е есть либа flocq, как раз для доказательства свойств алгоритмов, вычисляющих вещественные числа. Так что формализовать даже самые ебанутые нейроночки с нахуеверченными тысячами слоев и параметров можно уже сейчас, но хипстеры не могут в пруверы.

Да все подряд читай, что зайдет, то и лучше. Что-то полезное вынесешь из любого чтива. Я когда-то вообще начинал с Хайкина, лол.

Советую поступить на специальность и получить нормальное комплексное образование. Не в России, конечно.

Пока на границе в спину не стреляют, можешь забрать документы и поступить туда где твое образование будет признаваться международным сообществом.

Подайся на стипендии, попробуй на бюджет (в некоторых странах Европы), проси скидку у университета, для студентов из нищих стран вроде России могут сбросить больше половины (в Европе), как поступишь, будет много возможностей получить стипендии и гранты. Если ты самка, то тебя завалят деньгами множество фондов, поддерживающих девушек в STEM.

Серебряная пуля - заработай, тыжпрограммист, в коридорах постоянно будут шататься стервятники из всяких загонов для вебмакак.

Спасибо, но твой совет не релевантен.

7,2 Мб, 800x300

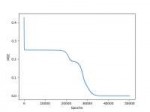

7,2 Мб, 800x300Нейроночка по одному кадру восстанавливает 3д сцену и рендерит ее с любой точки. Также это используется в обучении с подкреплением.

Ролик снят, бюджет освоен, все довольны.

345 Кб, 1366x2048

345 Кб, 1366x2048А оно только цылиндеры может рендерить, или по любой фотке может восстановить триде?

Только геометрические фигуры из тренировочного множества. В блоге посмотри, там много примеров.

>1209084

Вопрос к знатокам.

Хочу использовать colab не для обучения игрушечных моделей на mnist-е, а для чего-то более приближенного к реальности.

Соответственно, есть проблема: надо уместить датасет с фотографиями 224х224 в количестве около 2 миллионов в этот самый cloab...

Как это сделать?

На ум приходят только генеративные модели...

Насколько реально воспользоваться DCGAN-ом для генерации изображений для подачи на вход обучаемой модели?

Есть ли предобученные GAN-ы, которые могут выдать что-то вроде imagenet в разрешении 224х224?

На заре ГАНов люди пытались вроде просто на свалках картинок вроде CIFAR или imagenet обучать. Такой ГАН выдает обычно нагромождение цветных пятен и линий, простейшие текстуры. Если тебе подойдет такое, то тренируй. Предобученные вряд ли найдешь, ввиду их бесполезности.

Есть петпроектик по анализу веба, вот думаю, стоит ли туда вкрутить инс. Насколько это будет эффективно, и насколько готовые решения умеют в такого рода анализ.

>

>Что там? С тилибона не грузится.

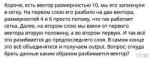

Ну, короч, в Гугле запилили LSTM-ку, которая дизайнит сверточные сети, обучили ее методом подкрепления, и Она выдала NasNET-A, который уделал на ImageNet топовые архитектуры, спроектированные человеками.

Ну там не только картиночки, какбе, там ешё мыниный перевод, чат-боты там всякие, имитатор твиттера трампа и т.д.

Ну, такое. Сто лет известно, что гиперпараметры одного алгоритма можно подсунуть другому в виде параметров.

На картиночках был первый прорыв, он же основной. Еще большой шаг был в распознавании речи (сейчас 100% этих систем на нейроночках, как и в картинках), обучении с подкреплением (хотя там речь тоже всегда идет о картиночках, так что трудно отделить одно от другого), генеративных моделях (с картиночками). Совсем без картиночек самое заметное достижение было в differentiable neural computer. В НЛП есть продвижения, но относительно небольшие.

Не знаю, что за анализ веба у тебя. Готовых решений никаких нет.

>сейчас 100% этих систем на нейроночках,

Не не пизди, нейронки там сосут как и везде

https://blog.neospeech.com/top-5-open-source-speech-recognition-toolkits/

Ты вообще понимаешь что такое архитектура свёрточной сети? Это хуя слой, хуяк сюда ещё один и хуяк пул между ними, а тут хуяк полносвязку на выход, заебись, Петрович, щас всех котов и собак посчитаем.

Сам сделал адово точную модель, собрал на свои деньги кластер из 50 1080ти, и прицепил веб-сервис и десктопную прогу.

Чтобы получить халявных фоток с сиськами

Чем выше получался скор на сифар 10, тем больше вознаграждение.

В итоге, нейросеть спроектировала модули круче, чем человек...

Из этих модулей составили несколько сетей, обучили на имаджнете, и уделали все, что до этого спртектировали жалкие людишки!!!

>уделали

>на один процент

>ценой значительного роста вычислительной сложности и числа параметров

>получили архитектуру с кучей логических ляпов и несуразностей

>теперь еще меньше понимаем, что происходит внутри сети

Да

Да там уже сто лет нет денежных компетишенов с картинками

Топ-1 выше на 1%, вычислительная слоюность на 28% ниже, чем было до.

Тебе че бомбить то так, шизик?

>неасимптотически

Какое тогда мерило эффективности алгоритма использовать, если не асимптотику?

На эту тему целая теория статистического обучения.

Анусопердолинговый коэффициент

Мохнатое О

То, что компуктер брутфорсом улучшил архитектуру сделанной человеком нейронки, означает лишь то, что человек пиздец как не понимает, как нейронки внутри работают. Это не прогресс, это шаг назад.

Да, и на сравнительные графики стоит добавить число параметров, а то память тоже не резиновая.

> брутфорсом улучшил

> человек пиздец как не понимает, как нейронки внутри работают

Опять ты на связь выходишь, мудило гороховое? Чем тут срать, лучше бы почитал что-то по теме, глядишь не выглядел бы полным дауном.

28 Кб, 280x280

28 Кб, 280x280А там и читать нечего, кроме ссаного пейпера. Конфигурацию слоев нейронки ищут с помощью другой нейронки, гоняя эту хуету на 500 GPU. В результате архитектура сети подгоняется под конкретный датасет (на другом надо делать все по новой).

Охуеть прорыв.

Зачем тебе это, когда уже генератор мемов сделали: https://arxiv.org/abs/1806.04510

Dank Learning: Generating Memes Using Deep Neural Networks

Abel L Peirson V, E Meltem Tolunay

(Submitted on 8 Jun 2018)

We introduce a novel meme generation system, which given any image can produce a humorous and relevant caption. Furthermore, the system can be conditioned on not only an image but also a user-defined label relating to the meme template, giving a handle to the user on meme content. The system uses a pretrained Inception-v3 network to return an image embedding which is passed to an attention-based deep-layer LSTM model producing the caption - inspired by the widely recognised Show and Tell Model. We implement a modified beam search to encourage diversity in the captions. We evaluate the quality of our model using perplexity and human assessment on both the quality of memes generated and whether they can be differentiated from real ones. Our model produces original memes that cannot on the whole be differentiated from real ones.

Какая же я чмоня, как же глубоко я себя ненавижу

Да.

Жди когда сделают сервис, где за биткоины можно будет купить рарные мемы. Для голов анимешных девочек уже сделали: https://crypko.ai/#/

void ToExpand(_u1 ٭ _flag, F_S_N<T, I> ٭ _F)

{

_u4 i0, i1, i2; _i4 nowd;

_F->root = root;

F_S_Ns<T, I> tmp0, tmp1, ٭tmp;

F_S_N<T, I> ٭FF;

_F->Space.Init(11);

_F->Dimensions.CopySet(&Dimensions);

_u1 dcross = 1; i0 = 0; while (i0 < Dimensions.now)

{

if (_flag[i0])

{

_flag[i0] = dcross++;

FF = root->F + Dimensions.D[i0].D;

i1 = 0; while (i1 < FF->Dimensions.now) _F->GetD(FF->Dimensions.D[i1++].D);

}

i0++;

}

Нет, это вспомнила анальная автозамена от гугла, когда я ввел СИФАР10.

Представь еще сколько трудов ушло на это. Скорее всего ради резюме старался чел, ну и надеялся на взлет как у https://www.cryptokitties.co/ , но забыл про вложения в рекламу. Вообще вся эта область это ад какой-то. Хотя может это мы старые и отсталые, не понимаем нового мира.

Юзал лет 7 назад, когда мне было еще не очевидно, что дотнет мертв, и нейроночки еще не взлетели.

>анализ изображений с помощью РСА и к-средних

А почему не на Фортране?

Есть другие простые способы уменьшить размерность вектора и кластеризовать данные?

Ссыль давай!

> Есть работающие.

Диплернинх? Ну вообще да, стыкованные аутоэнкодеры это могут, но они ж тоже не в моде, на коворкинге засмеют.

Что означает "базовая функция" в машинном обучении?

Мимо архи-ранняя птичка, пытавшаяся в машоб в 2007 и наткнувшаяся на стену непонимания

Ну мне сейчас неплохо, это скорее датасцаентисты на помоечке будут, если сравнивать.

Мантры это хорошо, помогают психике не сломаться.

Что там за параметры у тебя? Может, ты делаешь миллион слоев или тому подобный идиотизм.

Нет, когда не получилось с моделью которая нужна, попробовал самую простую - в один слой.

Вся суть. Вместо применения нескольких слоев пытаются изучать Вапника и делать всё на однослойном перцептроне.

Для тех кто читает мугичкой, однослойный перцептрон нужен чтобы потестить будет ли цикл переходить на следующую итерацию. Спойлер - не будет.

94 Кб, 705x609

94 Кб, 705x609У маняматиков всё по шаблону. Они даже не могут самостоятельно написать комментарий на дваче, не то что пейпер. Все мемы уже выучил?

>публичный бесплатный сервис для проверки рентгеновских снимков груди на наличие опухолей

Получит сгущёнки 100%

Код цикла выложи, гляну.

>Где работать? https://www.indeed.com/q-deep-learning-jobs.html

А в России? Хочу перекатиться в это.

Нужен фронтенд для нейроночек на блокчейне. Суть проста: пишешь лэндинг, пэйпэр и продаёшь свой смузикойн с инвестицией в нейронные сети.

Во-первых в рашке нет шансов; во-вторых кто в здравом уме хочет работать в рашке, если есть возможность работать вне ее?

>кому нахуй нужен

Если ты хочешь, чтобы тебя уговаривали, то этого не будет. Каждый сам за себя, нейронщик нейронщику волк!

Нет, ну это естественно, просто мне в такой вариант развития событий не особо верится. Есть где блоги или хотя-бы отдельные пасты про таких вкатывальщиков?

Леночка.

А почему бы не взять и просто без задней мысли получить профильное образование, PhD и перестать быть вкатывальщиком?

Его кегля: https://www.kaggle.com/iglovikov

>highest rank: 19

>1st, 3rd, 7th

Едрить он крутой

>Спецназ ВДВ. Медаль за Чечню. (2002-2004)

...

в европе много вузов бесплатно, еще и тебе будут платить выше средней по россии

>без задней мысли получить профильное образование, PhD

И сколько лет это займёт? Твои нейроночки уже неактуальны к тому времени будут.

Это у веб-макак все становится неактуальным через год, но куда вкатывальщикам понимать такое.

ПхД похоже на то, чтобы быть тяночкой и двигать тазом под научным руководителем, который за старания может поделиться тобой с друзьями.

Почему не споришь с Моим Величеством, не понял? :(

Да, память это да

Толко большинство этого не понимают. А может, и ты не обращал на это внимания, пока не прочитал пост.

Нейронов нафигачь побольше, начальные значения в интервале +-0.01, bias нужен обязательно. Ну и судя по твоему посту вероятность того, что ты набажил в градиентном спуске 95%.

83 Кб, 977x1024

83 Кб, 977x1024Пучкнул с этого деда.

Я сделал всё таки, проблема была в том что я долбоеб я ошибся в формуле дельты выходного нейрона.

У меня есть программа которая коллекционирует данные в текстовый файл. Нужно эти данные анализировать не самостоятельно. Общие, наиболее частые из этого файла. Как это делается правильно? Файл в вектор, вектор сортировать, отправить в следующий нейрон?

Пиздец, вместо того, чтобы учить анализ данных сразу МАШОБЧИК НЕЙРОНОЧКИ ИИ БЛОКЧЕЙН ДИПЛЁРНИНХ.

Анализировать чтобы получить какой результат? Если тебе нужно просто вывести статистику на моду, медиану и среднее значение встречающихся данных то это делается простыми функциями какого-то нумпая изкоробки.

Слесарьфлоу это огромная библиотека в которую вкладывается Корпорация Зла. Для С++ есть Caffe. Еще есть сишный Torch у которого врапперы под кучу языков, включая плюсы. Но судя по тому что ты несешь, тебе стоит почитать пару книг из шапки чтобы отбилось желание "вкатываться в тензорфлоу" и "вектор сортировать, отправить в следующий нейрон". Нейроночки это не хипстерский фреймворк для вебмакак, тут нужно глубокое знание матана и годы изучения матчасти.

Просто ты нам не нравишься.

Ну если три, то все ок.

Ну ниче, будешь меньше получать. Мне норм - все лучше 10 тыс. на завчике.

Как создать птицу, которая будет помогать наиболее чистые кастрюли? Ворота, автомобиль, готовка?

Тут проблема не в базе. Что не так с алгоритмом?

Потому что ущербная модель. Для таких четких снимков и ракурса можно хоть хаар-каскад натренировать.

Есть где-нибудь работы, где бы пытались повторить особенности человеческого глаза или пальцев, у которых в центре чувствительность больше?

Обычные сверточные и не только сетки я писать умею, интересно бы и такое ввести и посмотреть, насколько точнее сумеет распознавать.

Машиной Больцмана повторили мозги котиков.

Там про последовательности, правда. Но в изображениях тоже много где применяется, ищи по слову attention.

pandas вроде не особо популярная приблуда, хотя хорошая, если надрочиться с индексами и выборками. На питоне все нейроночки, без них никуда. На р больше статистики всякие работают, еще у них популярна эзотерика вроде САС. Смотря где ты будешь работать, может понадобиться что угодно из этого.

> На питоне все нейроночки, без них никуда. На р больше статистики всякие работают,

Как там в 2010? На R давно есть и слесарьплов и керас. + куча всего, чего никогда не было, нет и не будет на Пистоне.

Расценивай это как справочный материал в первую очередь, потом уже можно думать о механизмах и актуальности. А так хоть будешь знать, о чём гуглить и что спрашивать.

да я просто новенький, типа дип лёрнинг не нужно юзать в таких задачах или что?

бяки :C

Спасибо. Я правильно понимаю, что машинное обучение и нейронные сети предназначены для решения как практических, так и теоретических проблем?

ты уже все знаешь

Двачну, только ради нейронок выучил пидорский бейсик

На курсере всё есть.

https://www.youtube.com/watch?v=HP9S1Az8Tuw

Это понятно. Потом мы тренируем сетку теми партиями, в которых компьютер ходил случайно или по максимуму дерева с оценкой от нейросети. Непонятна вторая сеть с вероятностью поставить пешку в конкретном положении.

Вопрос сродни "зачем сороконожке столько ног когда можно вообще без ног как червяк ползать?" Да, ты чет не понимаешь (ничего). Не смотри никакие видосы, а читай основы (Саттона), потом ботай статьи, начиная с самых первых про альфаго. РЛ это передний край науки, на понимание уйдет 1-2 года, если ты уже спец по нейроночкам.

Когда я буду понимать алгоритм в общих чертах, то и книга легче пониматься будет. Первая модель гугловская вообще была не пойми как придумана с избыточностью данных, но она работала. Тут дело больше в опыте.

Я надеюсь, что в первом случае можно найти какие-то паттерны или сигнатуры. Сложность в том, что сигналы непериодичны и я не знаю длинну этих паттернов, которые я ищу.

До этого была похожая проблема, но там сигнал периодичный и все было просто - беру количество семплов, которые образуют период - это мои фичи, разделяю сигнал на (продолжительность/кол-во_фич) - это мои наблюдения. Если бы сигнал был непериодичный, но с известной длинной паттернов - то просто бы пустил скользящее окно известного размера. Но в моём случае сигнал не периодичный и размер паттернов я тоже не знаю.

Как правильно поступать в таких случаях?

Теоретически подходят рекуррентные нейроночки, но на практике неочевидную на глаз закономерность они не найдут. Я бы сверточную сеть пустил по фиксированному окну. Просто пробуй разные размеры.

> РЛ это передний край науки, на понимание уйдет 1-2 года, если ты уже спец по нейроночкам.

Че? Q-learning итп РЛ прост как 3 копейки, если знаком с уравнениями Хебба. Диплернинх во все это добавляет только сложность входных сигналов, вместо простых векторов это могут быть тензоры, соответствующие динамическим последовательностям кадров игры итд.

26 Кб, 644x800

26 Кб, 644x800Нейроночкодебилов с сойбойским диплернинхом не слушай. Я похожей хуйней занимался с целью анализа записи электрокожной активности. Короче, суть такова. Делишь сигнал окном подходящего размера, внутри окна считаешь минимум, максимум, стандартное отклонение, число пиков, и некоторые характеристики площади под кривой (area under curve), типа интегрирования. Алгоритм анализа EDA у меня был под матлаб, поэтому пришлось в нем корячиться с окном и фичами, могу код скинуть завтра, если интересно. Далее из фич собираешь векторы (вектор-строка - набор фич сигнала в пределах окна), из векторов собираешь датасет, помечаешь наблюдения и классифицируешь чем угодно, хоть svm. Если пометить нечем, то unsupervized что-нибудь юзаешь, например карты Кохонена.

Спасибо, чувак! Мне твой метод больше нравится, потому что он "наукоёмче" чем просто взять нейроночку и скормить её данные. В конце концов, мне не для реального применения, статью писать же.

Алгоритм не надо, я думаю его на гейтоне неализовать будет быстрее, чем разбираться с матлаб-кодом.

> Мурашки генерил?

Нет, там проводимость кожи в микросименсах. Проблема с этим сигналом в том, что у него нет внятных спектральных характеристик чтобы просто ебануть фастфурье преобразование. Просто известно, что что-то происходит в течение 5 сек после внешнего воздействия с фазической компонентой сигнала и в течение 20 сек с тонической. И это что-то как-то связано с состояниями ЦНС. Ни внятных паттернов сигнала, нихуя. Но вот наборы фич компонент сигнала таки можно классифицировать, правда точность 60-70%, но если использовать конфьюжнматрицу, то нормально. А со всякими реккурентными нейроночками даже не знаю, сколько бы ебался и был бы вообще результат. Вообще, диплернинх лучше классических подходов только на неграх и котиках, для нормальных задач анализа он и не нужон.

Софтмакс гасит градиенты

Попробовал запилить transfer learning, в качестве датасета - CIFAR-10, сверточная часть - NasNetMobile...

Сверху приделываю один полносвязный слой и получается какая-то хуйня: оно на может выдать точность выше 13,6% на валидации!

На нем же обычная сетка слоев из 4 обучается до точности в 75%!

ЯННП! ЧЯДНТ?

Набажил.

Разобрался, сам тупанул с количеством нейронов в слоях.

В плане бумажек они оба бесполезны. Не вздумай класть их в резюме - все знают что это курсы для даунов.

А как стартовать тогда? Освоить Энга и сразу на кегель собирать портфолио, попутно читая литературу?

Двачую вопрос.

Без задней мысли, видел такие хуйни в сауне, довольно прикольные ощущения.

> Как генетические алгоритмы связаны с нейросетями?

Никак. Однако, ничто не мешает делать из них гибридные модели, в которых параметры или гиперпараметры одного алгоритма настраиваются другим.

Посоны, объясните за TimeDistributed в keras:

import keras

from keras.models import Model

from keras.layers import Convolution2D, MaxPooling2D, ZeroPadding2D, GlobalAveragePooling2D

from keras.layers import Dropout, Flatten, Dense, Input

from keras.layers import TimeDistributed

i = Input(shape=(10, 224, 224, 3))

x = TimeDistributed(Convolution2D(64, (3, 3)))(i)

x = TimeDistributed(GlobalAveragePooling2D())(x)

x = TimeDistributed(Dense(128))(x)

m = Model(inputs=i, outputs=x)

opt = keras.optimizers.Adam(lr=0.0001, beta_1=0.9, beta_2=0.999, epsilon=None, decay=0.0, amsgrad=False)

m.compile(loss='mean_squared_error', optimizer=opt)

m.summary() #TimeDistributed "спрятал" слои

i = Input(shape=(224, 224, 3))

x = Convolution2D(64, (3, 3))(i)

x = GlobalAveragePooling2D()(x)

x = Dense(128)(x)

m = Model(inputs=i, outputs=x)

itd = Input(shape=(10, 224, 224, 3))

xtd = TimeDistributed(m)(itd)

mtd = Model(inputs=itd, outputs=xtd)

mtd.compile(loss='mean_squared_error', optimizer=opt)

mtd.summary() #TimeDistributed "спрятал" модель m

В результате выполнения примера я вижу:

Using TensorFlow backend.

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

input_1 (InputLayer) (None, 10, 224, 224, 3) 0

_________________________________________________________________

time_distributed_1 (TimeDist (None, 10, 222, 222, 64) 1792

_________________________________________________________________

time_distributed_2 (TimeDist (None, 10, 64) 0

_________________________________________________________________

time_distributed_3 (TimeDist (None, 10, 128) 8320

=================================================================

Total params: 10,112

Trainable params: 10,112

Non-trainable params: 0

_________________________________________________________________

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

input_3 (InputLayer) (None, 10, 224, 224, 3) 0

_________________________________________________________________

time_distributed_4 (TimeDist (None, 10, 128) 10112

=================================================================

Total params: 10,112

Trainable params: 10,112

Non-trainable params: 0

_________________________________________________________________

Почему эта ебанина "попрятала" внутренности?

Будет ли работать mtd?

Посоны, объясните за TimeDistributed в keras:

import keras

from keras.models import Model

from keras.layers import Convolution2D, MaxPooling2D, ZeroPadding2D, GlobalAveragePooling2D

from keras.layers import Dropout, Flatten, Dense, Input

from keras.layers import TimeDistributed

i = Input(shape=(10, 224, 224, 3))

x = TimeDistributed(Convolution2D(64, (3, 3)))(i)

x = TimeDistributed(GlobalAveragePooling2D())(x)

x = TimeDistributed(Dense(128))(x)

m = Model(inputs=i, outputs=x)

opt = keras.optimizers.Adam(lr=0.0001, beta_1=0.9, beta_2=0.999, epsilon=None, decay=0.0, amsgrad=False)

m.compile(loss='mean_squared_error', optimizer=opt)

m.summary() #TimeDistributed "спрятал" слои

i = Input(shape=(224, 224, 3))

x = Convolution2D(64, (3, 3))(i)

x = GlobalAveragePooling2D()(x)

x = Dense(128)(x)

m = Model(inputs=i, outputs=x)

itd = Input(shape=(10, 224, 224, 3))

xtd = TimeDistributed(m)(itd)

mtd = Model(inputs=itd, outputs=xtd)

mtd.compile(loss='mean_squared_error', optimizer=opt)

mtd.summary() #TimeDistributed "спрятал" модель m

В результате выполнения примера я вижу:

Using TensorFlow backend.

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

input_1 (InputLayer) (None, 10, 224, 224, 3) 0

_________________________________________________________________

time_distributed_1 (TimeDist (None, 10, 222, 222, 64) 1792

_________________________________________________________________

time_distributed_2 (TimeDist (None, 10, 64) 0

_________________________________________________________________

time_distributed_3 (TimeDist (None, 10, 128) 8320

=================================================================

Total params: 10,112

Trainable params: 10,112

Non-trainable params: 0

_________________________________________________________________

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

input_3 (InputLayer) (None, 10, 224, 224, 3) 0

_________________________________________________________________

time_distributed_4 (TimeDist (None, 10, 128) 10112

=================================================================

Total params: 10,112

Trainable params: 10,112

Non-trainable params: 0

_________________________________________________________________

Почему эта ебанина "попрятала" внутренности?

Будет ли работать mtd?

Гугли virtual environment под свой язык.

> Памяти купи.

У хипстеров от машобчика с производителями памяти гешефт какой-то? Тоже встречался с алгоритмом, не хватало памяти, там есть вариант работы с датасетами на диске. Сделал по примеру в документации, и что? Все равно всю оперативку сожрало и вывалилось с ошибкой "мемори хутю утютю", только не сразу, а спустя минут 20 яростного потрясения винтом. Вредительство самое настоящее.

>по примеру в документации

Пиши свой код. А то опять кто-то говна в жопу залил. Ещё небось сидишь на "4 ядра 4 гига для учёбы"

Ещё один. Бигдата это просто методы работы с тем, что не вылезает в оперативу. И эти методы начинаются ровно там, где оператива заканчивается. Хоть с 2 гигов. Школотронствуя в стиле

> <10050006000гиг

> бигдата

Ты показываешь ровно одно - непонимание термина.

Ты мейроночки им тренируешь? Тогда ответь "да, сэр, так точно, сэр". В любом случае нужно обосновать почему ты используешь его.

Мое обоснование - датасет небольшой, для гридсерча можно быстренько погонять lbfgs, а если так нужен sgd, то использовать уже с подобранными гиперпараметрами.

https://www.youtube.com/watch?v=8LccBQaoM3Y

В сиауте до стрелки - массив, после стрелки - резалт. Резал - что такое?

Ну какбе применимость (l)bfgs зависит от количества параметров, а не от размера датасета.

Хочешь лучше, чем просто градиентный спуск, - есть методы сопряженных направлений...

Хотя и они на больших задачах жирноваты.

Достаточно для того чтоб начать вкатываться знаний за первый курс мехмата нгу ?

http://mmf.nsu.ru/education/plan/1/2017-2018

Keras. Может быть OpenCV, зависит от задачи.

Очень просто, если что-то очень сложное в сетке намутили, для чего ещё нет алгоритма обучения, то тогда используют генетический алгоритм.

Всмысле распознавания образов? Слишком расплывчатое понятие. Картинки классифицировать на керасе ессесно, самое простое для нуфага.

Я ведь не спрашиваю что можно легко и как это сделать. Я спрашиваю про то, где анон не справился бы, но знает где.

Уже доказано, что это невозможно. А для закупок акций с отложенной выплатой и перевода средств в другую валюту не нужно ИИ.

Вроде были сервисы где платили центы за распознавание капчи. Хотя видеокарта наверно больше электричества сожрет как. Лучше уж майнинг тогда.

Нейросети анона по размеру с нейросеть насекомого в лучшем случае. Ищи в той нише, где может нафрилансить таракан.

Всё упирается в оптимизацию в таком случае. Не технология.

Дроч на статистику никгда не давал больше пары процентов. Я видел как работали сети с десятком эпох, так что не надо.

Я попытаюсь.

Научи openai gym/universe чему-то интереснее арканоида. Теоретически эта ебань может управлять хоть чем в браузере, если есть ощутимый результат её работы в очках, баллах итд. Можно посмотреть как оно справится со ставками на спорт или бинарными опционами.

нейросеть, имитирующая поведение человека в интернете при серфинге

и сразу же

нейросеть, отличающая серфинг бота от человека

Даже лень объяснять

![21e17d990a4c4cd384246e2d23f08ce2[1].jpg](/pr/big/thumb/1209084/15302678025110s.jpg) 447 Кб, 1920x1080

447 Кб, 1920x1080Обучение с подкреплением этим занимается. Но судя по твоему посту у тебя нет шансов заставить его работать.

Да.

>как нахуй по другому можно натренировать машинку, кроме как через генетический алгоритм и копирование поведения человека?

Никак. Это невозможно. Сам то поимаешь что просишь? Ты хочешь чтобы машинка каталась без эмпирического опыта или учителя? Такое возможно только есль у тебя нейросетть принимает гиперпараметры твоей игры, а не сама в ней существует.

Берёшь первый, умножаешь на второй. Только не перепутай

> Весь машобчик кроме нейроночек мертв?

Про него просто хипстеры не знают.

>>19822

> Никак. Это невозможно. Сам то поимаешь что просишь? Ты хочешь чтобы машинка каталась без эмпирического опыта или учителя?

А ведь ещё в нулевых гишпанцы подобное реализовывали на нечетких контроллерах. У них даже машинка была не нарисованная а реальная и софт для компиляции нечетких моделей в формат плисов на яве доступен свободно, xfuzzy. Фишка в том, чтобы расстояние до препятствия задать в виде нечеткого значения, исходя из которого можно правилом регулировать угол поворота колёс и скорость. Если при этом общее направление будет вперёд, то такая машинка вполне может ездить по круговой трассе, даже если перед ней расставлять новые препятствия. И никакого сойбойства с нейроночками, плисы и датчики расстояния до препятствия. Но кому это надо, на этом не заработаешь продажей видюх.

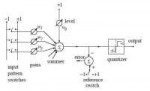

Ну там логические элементы имитируют нейроны и связи между ними. Что-то уровня сотни тысяч адалайнов пикрелейтед на одном чипе. Таких архитектур куча была разработана, даже на оптронике и оптических элементах. Смысла особого в них нет, т.к. все то же самое при желании можно сделать на ПЛИСах, что в разы дешевле, чем запускать целую аппаратную платформу, которая еще хуй знает как и когда окупится и окупится ли вообще. Алсо, даже и ПЛИСы это перебор, т.к. все работает на простых видюхах. Короче, технически это мб и интересно, но практической пользы никакой. Если интел и правда что-то такое раскрутит, ну респект им, че.

Все понял. Немного странно, что один процессор за столько нейронов отвечает, я думал, что каждому нейрону свой, как там памяти вообще хватает

А еще, удивлен подходу Интелов, они даже в 1-м процессоре аж вот так решили сделать, зачем, чтобы облегчить вычисления, разве так станет быстрее?

Ошибка в том что ты используешь винду и студию. Перейди на инструмены предназначенные для программирования.

на последнем датафесте рассказывали про хедшоты нейронками

https://youtu.be/YSQqHlQwQDY

хотя и не совсем то

а еще МММ! и другие финансовые пирамиды!!! ХОЧУ, ЧТОБЫ НЕЙРОНКА ПРЕДСКАЗЫВАЛА НЕПРЕДСКАЗЫВАЕМЫЕ ВРЕМЕННЫЕ РЯДЫ И СТАТЬ БАХАТЫМ, А ТО НЕГРОВ ПРЕДСКАЗЫВАЕТ, РАК ПРЕДСКАЗЫВАЕТ, ЛЮДЕЙ НА ПЕРЕХОДАХ ПРЕДСКАЗЫВАЕТ И СБИВАЕТ, А НАСТОЯЩИХ ЗАДАЧ НЕ ПРЕДСКЗЫВЫВАЕТ, ТО ЛИ ДЕЛО ВАПНИК, ВСЕ АЛГОРИТМЫ ПРЕДСКАЗАЛ - И БИНАРНЫЕ АПЦИОНЫ И ВСЕ ЭТО С ПОМОЩЬЮ НЕТОЧНОЙ ЛОГИКИ

согласен, поэтому искджибуст придумали только в 2016 году и уже успели от него отказаться в пользу lgbm

>>20280

Таблетки выпей, мань.

12 Кб, 202x599

12 Кб, 202x599y = 0,7x - 1414,79

А правильный ответ вот такой:

y = 0,51x + 142,9

Короче, я облажался. Скорее всего значения иксов и игреков надо как-то нормировать или стандартизировать. И лишь после этого получится правильный ответ. Ну либо правильный ответ на самом деле неправильный.

ПОДСКАЖИТЕ, ПОЖАЛУЙСТА, ГДЕ ПОСМОТРЕТЬ КАК НОРМИРОВАТЬ ИЛИ СТАНДАРТИЗИРОВАТЬ ПРАВИЛЬНО ДАННЫЕ ДЛЯ ПОДГОТОВКИ К ЛИНЕЙНОЙ РЕГРЕССИИ? Я ГУГЛИЛ, НО У ТУПОЙ И У МЕНЯ ВСЁ-РАВНО НЕ СОШЛОСЬ С ПРАВИЛЬНЫМ ОТВЕТОМ

>А правильный ответ вот такой

Проигрунькал. Ты бы хоть читал, что ты пишешь.

Очевидно, что тот кто писал правильный ответ использовал вместо иксов какую-то хуйню. Т.к. максимальный элемент игриков 90.7, а в правильной модели прибавляют 142.9. Т.е. там иксы должны быть отрицательными.

Спасибо большое, пробую перевести и попробую применить эти вещи и посмотреть результат.

>>20678

>>20789

Видимо, годы не принято подставлять как есть 1994, наверное, их как-то преобразуют чтобы они нормализовались, нормировались или стандартизировались. Но пока я не нашёл решения как принято года конвертировать в пригодные для линейной регрессии значения.

И игреки, их, наверное, тоже надо преобразовать как-то.

>максимальный элемент игриков 90.7

Что-то мне кажется, что игреки тоже надо изменить. И там будет не 90.7, а какое-нибудь другое преобразованное значение.

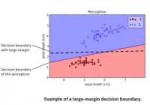

30 Кб, 550x332

30 Кб, 550x332 63 Кб, 500x352

63 Кб, 500x352> Объясните эту картинку. Что обозначают синим и красными цветами? Граница что обозначает?

Синий и красный линейноразделимые классы, пунктиром - оптимальная граница, разделяющая классы (например, такую бы построила svm), сплошная линия - граница, построенная перцептроном.

ВСЕ СЛЕДСТВИЕ ЕВКЛИДОВСКОЙ МАТЕМАТИКИ11111 ОН ВСЕ ОПИСАЛ В СВОЕЙ МОНОГРАФИИ, ДОБАВЬТЕ В ОП-ПОСТ

Все, что нужно знать человеку, сказал Платон. Эвклид и его шайка сойбоев, куколдов и хипстеров просто жевали собственные бороды, запивая их смузи.

49 Кб, 480x380

49 Кб, 480x380Чувак, потише в этом треде. Во-первых, последний пост мой, я лишь пародирую шизика (нечеткого петуха, он же сойбой/куколд/хипстер). Во-вторых, нечеткий петух тут отвечает почти на каждый пост, из чего следует, что около половины постов во всех нейротредах его авторства. Увы, де-факто это его собственные, персональные треды, хоть он их и не создает. Это происходит годами. Я делал перерыв в тредах в несколько месяцев, когда сюда набежал шизик из /ссы и зафлудил все квалиа-бредом. Шизик из /ссы ушел в туман, а сойбой остался. Он как клоп, его никак не выжить. Остается смиренно ждать его смерти от естественных причин (мои уговоры совершить самоубийство не подействовали). Таков наш крест. Я с этим смирился, и тебе советую. Будем надеяться, он скоро начнет пить (судя по всему он подходит к питейному возрасту), тогда ему станет не до нас.

Во избежании неконтролируемого роста обсуждения персоны куколда, нужно соблюдать одно простое правило: никогда ему ничего не отвечай, вообще игнорируй его существование, как будто его постов нет. Отличить их очень просто. Даже на этот пост не отвечай. Хипстер ответит, а ты молчи. Тренируй силу воли.

> Будем надеяться, он скоро начнет пить (судя по всему он подходит к питейному возрасту), тогда ему станет не до нас.

По бате своему судишь? Мне-то зачем пить, я ж не русич какой и не финно-монголоид. По делу от тебя и тебе подобных внятной критики пока не поступало, только шиза и кукареканья.

Keras и python.

Лекции оторваны от практики, будут дрочить абстрактную хуйню и теорему Каруша-Куна-Таккера. В практических заданий много технических проблем.

По-моему такие курсы только отобьют желание что-то дальше в этой области делать.

490 Кб, 660x475

490 Кб, 660x475 241 Кб, 350x263

241 Кб, 350x263Или я к примеру хочу идентифицировать по лицам всех людей на групповой фотографии. В этом случае ведь тоже, наверное, нужно найти непосредственно лица на фотографии, а потом уже пытаться их идентифицировать? Или как это вообще делают в реальном мире?

9,3 Мб, 480x270

9,3 Мб, 480x270Боты рвут атцов в кваку на рандомно сгенерированных картах.

https://www.youtube.com/watch?v=dltN4MxV1RI&feature=youtu.be

А когда для каэсочки такое будет, с этого можно что-то поиметь? Ну там удаленно соревнование выиграть?

Шутерок набросали на быструю руку, какая разница какой в нем графен? Теперь можно прикрутить хоть кваку, хоть каэсочку, хоть что-угодно подобное.

разница не в графоне

13 Кб, 640x480

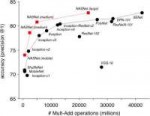

13 Кб, 640x480Забыл еще вот прикрепить график средкв. ошибки. Собсна по ординате сама ошибка, по абсциссе кол-во эпох.

Собрал. Что дальше?

В личку мне их скинь, я тебе напишу сканнер дла книг.

10 Кб, 640x480

10 Кб, 640x480А вот при одном слое в 8 нейронов.

Интересные у тебя пикчи, анон, это откуда?

Где? У меня нет такого

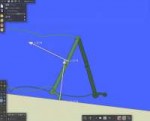

Интересует создание походки и анимаций для виртуальных существ произвольной формы. Алсо, какие алгоритмы обучения нейронных сетей лучше всего подходят для этой задачи, кроме Генетического?

>как выбирать правильное количество слоёв

Чем больше, тем лучше.

>какие алгоритмы

Reinforcement learning.

>походки

Это много кто делал, в общем случае довольно трудно для 3д, для 2д ок.

>анимаций

Тут непонятно как ты оценивать будешь.

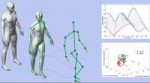

314 Кб, 831x676

314 Кб, 831x676>анимаций

>Тут непонятно как ты оценивать будешь.

Анимаций имелось в виду готовая анимация походки например.

>Чем больше, тем лучше.

А сколько нейронов в каждом слое? Где вообще можно узнать хоть какую-то инфу про то, насколько количество слоёв и нейронов в них влияет на скорость и качество результата?

Например если я сделаю 1 скрытый слой с тысячью нейронов, в чем он будет лучше/хуже сеть с 4 слоями по 10 нейронов в каждом?

Где-то можно примеры посмотреть как количество слоев или количество нейронов в слое влияет на результат.

> Где вообще можно узнать хоть какую-то инфу про то, насколько количество слоёв и нейронов в них влияет на скорость и качество результата?

Нигде, это чистое шаманство, т.е. гиперпараметры, зависящие от поставленной задачи. Еще у Хайкина написано, что это больше искусство, чем точное знание.

Инпут изображение в виде vector, из нейронки что выходит? На выходе тоже vector. Как это там хранится? Как достать границы каждого совпадения?

Это все сильно зависит от задачи и данных. В целом сеть не может быть слишком большой. Пробуй разные варианты.

С одним элементом работает. С несколькими не работает.

С картинкой самолета скопированной несколько раз на одном изображении результат был веб страница и дверь. Один самолет нормально детектит.

Ты взял одну из моделей, предназначенных для исследования нейроночек, а не для использования. Она натренирована на данных, где всегда один объект в кадре, и только на таких данных она будет работать.

Тебе уже сказали - бери YOLO.

хорошая ли книга?

Писать логику планирую на Scala и Java, Питун не желателен, ибо будет Спарк, который любит JVM,

Не устарела ли эта pdf ка?

http://opencarts.org/sachlaptrinh/pdf/27976.pdf

Стоит ли потратиться на бумажную версию на русском?

Хорошая книга в шапке. Про твою не знаю.

Все можно. Есть варианты с т.н. конденсацией, или сжатием нейроночек, которые из большой делают маленькую и, соответственно, быструю. Но это уже все самому надо делать.

1,3 Мб, 1140x672

1,3 Мб, 1140x672Почему всегда при загрузке программы занимает >900 mb в оперативной памяти? Не важно вход с камеры, видеофайл или одна картинка. Весь вес сразу загружается? Из-за этого? Это маленький пак. А если большой делать?

>Почему результат разный?

хуёвый алгоритм.

> Почему одну картинку не распознала?

хуёвый алгоритм.

> Почему всегда при загрузке программы занимает >900 mb в оперативной памяти? Не важно вход с камеры, видеофайл или одна картинка. Весь вес сразу загружается? Из-за этого? Это маленький пак. А если большой делать?

хуёвый алгоритм.

хуёвый алгоритм.

хуёвый алгоритм.

хуёвый алгоритм.

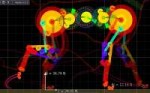

104 Кб, 924x575

104 Кб, 924x575>Это все сильно зависит от задачи и данных.

Я же описал задачу - походка для виртуального существа произвольной формы.

>Нигде, это чистое шаманство, т.е. гиперпараметры, зависящие от поставленной задачи

Для задачи генерации походки для трехмерного/двухмерного персонажа. Есть какой-нибудь сайт, на котором можно найти примеры нейронных сетей для подобных задач, чтобы посмотреть какие сети успешно использовались для этой задачи?

если на пальцах, если добавишь много слоев, до градиенты будут в ноль уходить просто из-за школьной арифметики, так как много дробей умножаешь друг на друга. Также, когда много слоев, легче переобучиться, нужен добавлять больше регуляризации. Плоские сети вычислительно сложные (просто больше нейронов-функций). И на философском уровне (как обычно показывают на картинках) сложно выделить составные фичи из предыдущих нейронов (XOR). Еще в разных задачах бывает полезно делать узкие места, где последующий слой меньше предыдущего, мол уменьшаем размерность, приходится нейронке выделять фичи, а не запоминать просто вход. Так, как на другой известной картинке, лучше всего делать столько слоев, сколько можешь, пока оно не переобучается. Добавляешь регуляризацию. Так и добавляешь слои, пока не достанешь до неба и даже Аллаха. Длины слоев я бы, скорее, по размерности входа ориентировал. Реинфорсемент лернинг никогда не делал вообще, там много своих камней.

В РЛ, если ты не гугл, делают сети поменьше обычно. В атари, ЕМНИП, стандарт 1 небольшая свертка и 3-4 слоя по 100-200 нейронов. Одна из мегафишек альфазеро была в том, что они умудрились натренировать в РЛ огромную сеть (затратив какие-то миллионы процессорных лет).

56

Knight moves

8

Underpromotions

9

Поясните, зачем так много плоскостей для описания ходов королевы? Нельзя ли одну плоскость только юзать?

Можно все что угодно, вопрос в том что работает лучше. Скорее всего, много плоскостей работают лучше, т.к. сети не приходится тратить усилия на расшифровку входных сигналов.

>линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных

В каком порядке это все изучать?

Умею находить производную, знаю что такое матрица и предел.

поступаю в вуз на математическую специальность, хочу узнать совета

Того, что тебе на первом/втором курсе расскажут, вполне хватит для начала.

Если ты чисто на математика поступаешь, то сложности скорее с программированием будут. Но его в вузе нормально всё рано не дадут, так что учи сам.

80 Кб, 699x523

80 Кб, 699x523> Ты про старый компьютер из 80-х годов прошлого столетия?

Нет, он про игры для атари, которые традиционно используются для тестов RL.

> Что лучше для генерации походки - Генетический алгоритм или Реинфорсемент лернинг ?

РЛ чисто теоретически должен быть лучше. Как минимум, быстрее будет обучаться.

> Раньше самые топовые алгоритмы были у Маска Небоходца - openai gym/universe.

Ты чумачечий? openai gym/universe это наборы сред для тестирования алгоритмов RL. В стандартную поставку раньше ни один алгоритм собственно RL не входил. Относительно недавно они сделали RL Baselines, или как-то так, где якобы правильно реализованы несколько топовых алгоритмов, но и эти алгоритмы изобретены не ими, они просто реализации выпустили. Они занимаются и алгоритмами тоже, но грандиозного успеха на этом поприще пока не было. Вроде бы они сделали бота, который хорошо играет в урезанную версию Dota, но это не оупенсорс.

Вопрос "какой алгоритм самы лучший" ответа не имеет, во многом потому что они все довольно-таки плохо работают, и еще потому что каждый автор тянет одеяло на себя, утверждая что он лучше других, хотя зачастую это не так. Сами алгоритмы нестабильны, сходятся 1 раз из 20. Соревнование по созданию этих алгоритмов выродилось в абсурдную игру "у кого больше ресурсов перебрать гигантское количество гиперпараметров и вытянуть счастливый билет, перекрывающий SOTA" На реддите это обсуждалось пару месяцев назад, народ был недоволен плачевным состоянием этой области.

>РЛ чисто теоретически должен быть лучше.

В принципе да, потому что РЛ использует больше данных о задаче. Но гарантий нет, доказательство сходимости к оптимальной стратегии только для таблиц, и то там нужно бесконечно много раз посетить каждое состояние и каждое действие из него.

>Как минимум, быстрее будет обучаться.

А вот тут не факт, были статьи показывающие что evolutionary strategies как минимум не намного хуже, а вычислительно гораздо лучше, т.к. не нужно вычислять градиенты.

А куда плоскости для пешек, короля, ладей, слонов делись? И почему коню только 8 плоскостей а не 16, если коней 2 шт.

Ты меня спрашиваешь, лол? Я вообще не знаю, откуда ты это вытащил. Там же и ищи объяснения конкретных деталей. Я тебе общие соображения привел.

Причины индивидуальны для твоего алгоритма, экстрасенсы, эсперы и Deus ex Machina в отпуске.

>>24143

Ну, отсюда же взято https://arxiv.org/pdf/1712.01815.pdf

И по логике для короля должно быть 8 плоскостей, хотя этого нет.

Король может сходить на одну клетку в каждую сторону => 8 возможных ходов

Королева может сходить на одну клетку в каждую сторону, на две клетки в каждую сторону, ...

Наркоман, что ли?

Алгоритм "работает" если его результаты тебя устраивают. Чуть более формально - если результаты лучше случайных.

Обучение нужно прекращать после того как N итераций подряд дают улучшение результата меньше эпсилон. Не становится заметно лучше - значит обучилась. Для дешевых вычислений нужна большая N, для дорогих - относительно маленькая.

Jupyter c кернелом R

>>24842

https://stackoverflow.com/questions/2480650/role-of-bias-in-neural-networks

Вкратце, каждый слой должен найти такой а чтобы получить выход y = ax + b примерно равный ожидаемому. Получается, а в уравнении это веса слоя, а b это bias.

https://habr.com/post/312450/

https://habr.com/post/313216/

годно для вхождения или хуита?

Вроде написано правильно и это нужно знать, но ответ на твой вопрос зависит от того насколько глубоко ты хочешь войти. Это первые полторы страницы очень толстого учебника.

Все оказалось банальней. Остальные ходы скрываются в плоскостях королевы.

Хочу попробовать написать нейронку для парсинга текста в одной ммо-дрочильне со скриншотов экрана.

Пользовался специализированными библиотеками вроде tesseract, результат сомнительный. Хочется сравнить действенность.

Тоесть, задача стоит такая - на скриншоте в заранее известной области появляются символы на 100% совпадающие с символами из тренировочного сета, особенно если не будешь делать скришноты на фоне сливающемся с текстом? Используй попиксельное сравнение, Люк. Можешь даже прикрутить что-то вроде https://en.wikipedia.org/wiki/Cross-correlation#Normalized_cross-correlation

Не, там есть эффект искажений текста из-за прозрачности, а под прозрачностью всякая мимобегающаю игровая хуита.

+ Цвет текста меняется время от времени. Пытался нормализовать его матрицами к серому, каждый раз получается немного по разному.

Короче хочу нейронками попробовать.

Покерскрапер?

Sweave, knitr.

на работе пока не поставил линукс, поставил через анаконду (у меня еще и прав администратора не было) + какой-то там длл с++ редистрибьютабл требуется для тензорфлоу

(Входной слой, скрытый, выход) x 200

Можно ли нейросеть представить в виде куба или сферы?

Всё он встаёт. Даже с GPU работает нормально.

Картинка 200 на 200, ресайз 50 на 50. Для чего ресайз?

Вход, скрытый слой, выход. От входа до скрытого learning rate. От скрытого до выхода второй learning rate. В комментариях написано, что bias нет. Что это за значения? Они есть в умножении веса.

Как создать bias? Это константа или формула? Куда его вставлять: до функции активации или куда? Активация: если скалярное произведение с нодов меньше ноля - умножить на 0,01, если больше ноля - ничего. Это правильно?

Да, именно поэтому нужна мощная видеокарта.

Попробуйте представлять bios как дискретную монаду. Мне это сильно облегчило понимание в свое время.

898 Кб, 487x560

898 Кб, 487x560> Попробуйте представлять bios как дискретную монаду

Какая блядь мандада, это просто смещение функции от центра координат. Аффтнный вариант дискретной функции нарисовать с разными смещениями, вот и будет понимание что это и зачем. А потом просто понять, что это касается не только линейных функций. Блядь, да это в школе проходят, что с вами не так, что вы машоб пытаетесь понять начав не с начала, а с диплернинха, а простое смещение функции - через мандадки какие-то, прости господи.

Раннее останавливае - хуйня для даунов. Отличный показатель, что модель работает хуй пойми как. То сходится, то не сходится, то высокая точность, то поебень.

Таки проблемы иначе решают, а не просто останавливаются.

> не может в категорность

Что там мочь-то, школоилитарий? Стрелочки рисовать любой клоун может. Речь не об этом. Какая нахуй категорность, там простого матана и линейной алгебры более чем достаточно. Думаешь, илитка дохуя, раз про мандадки прочитал? Это ничего не добавит к пониманию диплернинха, только ненужного аутизма добавит в нотацию.

> 2018

> в посте буквально описывается validation-based early stopping

> макака этого не знает потому что просто использует функции кераса без понимания

>>25439

Точно, зачем нужна регуляризация, если она портит показатель? Будем переобучать по полной, чтобы все однозначно сходилось и давало высокую точность на тренировочном наборе, потому что реальные задачи для задротов, а не таких просвещенных датасаентистов как мы.

Разница между ожидаемым и полученным значением.

Нет, зачем нужно думать над регуляризацией, оптимизировать архитектуру, если можно просто сказать, мол похуй, выкинем половину итераций и скажем, что так и задумано.

Так и задумано, быстрее и дешевле.

з.ы. И что с медом делать? дропать или нет, если очень хочу заниматься нейронками, но универ отнимает много времени?

Продолжай учёбу на медика. Будешь круче чем толпа индусов работающих за копейки без образования медика.

а по поводу первого вопроса?

> На ватмане

Майнд-карты твои лучшие друзья, попробуй хотя бы freemind.

По языкам тебе достаточно одного питона, сам по себе он очень простой, на курсере есть цикл курсов, которого вполне достаточно. Конечно, практика была бы очень полезной, но можно и сразу вкатываться в нейронки, анализируй чужой код и не ленись переписывать и оптимизировать. Хороший тон для работы с таблицами сразу начать пользоваться pandas. Первые нейронки можно собирать по слоям используя keras, до этого можно поиграться с готовыми моделями из sklearn. Само программирование здорового человека это математика английскими словами.

Времени и сил сожрет огромное количество, скорее всего ты вылетишь из универа, разорвешь все социальные контакты и все твои увлечения сведутся к нейронкам и их применению везде. Но если ты миленький, то я могу подумать над тем чтобы забрать тебя себе и только себе <З

Тебе не ЯП нужны, а программирование вообще, все что с этим связано. Без умения кодить ты будешь как слепой, пытающийся стать художником.

Как на TensorFlow проектировать сети(создавать вне скрипта или программы в текстовом файле), инициализировать начальные веса, обучать и сохранять и считывать для дальнейшего обучения или прогона? И да, делать все это на C++ и Delphi, а не на Python. Считывать pb модель и так уже знаю как, но ее я скачал готовую, а не проектировал и обучал сам.

> Без умения кодить ты будешь как слепой, пытающийся стать художником.

Хуйню несешь, например. Достаточно понимания математической нотации, в которой обычно описывают нейроночки. Кодят пусть индусы в гугле. Если понимаешь, что вообще происходит, умения кодить хватит на уровне импорт слесарьплов ас сп.

https://www.youtube.com/playlist?list=PL2-dafEMk2A7mu0bSksCGMJEmeddU_H4D

Siraj Raval - Intro to Deep Learning

https://www.youtube.com/playlist?list=PL2-dafEMk2A7YdKv4XfKpfbTH5z6rEEj3

Как вам этот индус?

Как земля. После него, наверное, и приходят в тред с охуительными вопросами.

[1, 2, 3, 4, 5, 6, 7, 8, 9]

разбить на чанки

[[1, 2, 3],

[4, 5, 6],

[7, 8, 9]]

Есть ли простой способ разбить на

[[1, 2, 3],

[2, 3, 4],

[3, 4, 5],

...

[7, 8, 9]]

???

Используй сплит несколько раз со смещением, потом склей результаты.

Есть. Это называется "матрица Ганкеля", Hankel matrix, гугли. Есть на каждом углу, не думаю что пистон исключение.

Какой самый простой способ получать оповещения об этом? Можно наверно в конец кода дописывать запуск какой-нибудь мелодии, но на Кэггле это не очень просто реализовать.

Пусть постит статус в жаббер же, или чем сейчас пользуются люди там где светит солнце.

>>25825

Скачиваешь датасет с дескрипторами молекул (или SMILES из которых вытягиваешь дескрипторы) и активностями в экспериментах. Прикручиваешь к старому проекту по распознаванию MNIST. Все, ты занимаешься драг дискавери.

Это стиль жизни. Читай что-нибудь, реализуй новые фичи, оптимизируй, рефактори код в это время.

Для некоторых стажировок требуются высокие оценки по профильными предметам, но конкретно предметы не указываются.

Линал, твимс, немного матана.

Вообще, странное требование. У меня, например, на сессии иногда никакого желания выдрачивать кучу формулировок теорем не было, потому тройки хватал. А как ты с практикой справлялся - на это всем просто похуй. средний студень довольно тугенький в этом плане, а я не в шараге (по меркам России) учился

Спасибо. Согласен с тобой, но вот у сбербанка с его сберсизонс такие вот требования.

https://thegradient.pub/why-rl-is-flawed/

https://thegradient.pub/how-to-fix-rl/

131 Кб, 300x394

131 Кб, 300x394Анализ данных, машинное обучение, нейронные сети, компьютерное зрение.

https://github.com/migueldeicaza/TensorFlowSharp/blob/1e3ddefde15dd281b993c7bf3d9ea351b5ad4178/TensorFlowSharp/Tensorflow.cs

Не понимать. Логически-то он да - статический и конструктор вызывает и все такое. Но я нигде чет не найду такой спецификации C# что он автоматом может определять статический метод или нет.

>Почему тут метод FromSavedModel назван статическим

Где тут?

>не найду такой спецификации C# что он автоматом

Ее нет.

Делай на питоне, не морочь себе голову.

Начал проходить курс на степике по нейросетям на днях, скоро пройду. Походу дела освежаю знания матстатистки. Что еще нужно подучить, чтобы взяли джуном на позицию data scientist'a? на hh стабильно 15 вакансий в ДС весит.

Спасибо

/// constructor to create an empty session, or you can load an existing

/// model using the <see cref="FromSavedModel"/> static method in this class.

Комент не обновили при рефакторинге.

Так. А вот теперь объясни в чем отличие этого от bias, если bias представлять аффинную функцию.

Ты какую-то хуйню написал.

> Так. А вот теперь объясни в чем отличие этого от bias, если bias представлять аффинную функцию.

Во всем, например. Bias это коэффициент сдвига функции от начала координат. Матрицы Ганкеля и Теплица - это варианты представления датасета.

Смотря на чем считаешь, какой датасет, архитектура, гиперпараметры, как ты обучаешь, etc. Если это что-то стандартное вроде Iris/MNIST, то ты где-то ошибся точно. Если ты настакал слоев и ждешь что это даст сразу 100%, то попробуй для начала прогнать на одном слое и посмотреть обучаемый ли он, или как ты.

>Потом сам понял, что на этом завязаны современные нейроночки.

Вот нет. Свёрточные нейросети заимствуют некоторые идеи из настоящих, отвечающих за зрение, но в целом это совершенно другой механизм по сравнению с человеческим мозгом.

Программирования для МЛ много не нужно, только знать Питон более менее нормально.

>з.ы. И что с медом делать? дропать или нет, если очень хочу заниматься нейронками, но универ отнимает много времени?

Дело твоё конечно, но мне кажется, что лучше податься в офтальмологию (не знаю, как у вас там это устроено) и изучать естественные нейросети, потому что есть вероятность, что окажется, что математику и программирование не так просто самому осилить, твои познания в нейрофизиологиии зрения малоприменимы и вообще это всё имеет сомнительное отношение к тому, чем ты хотел заниматься.

Не старайся, у него есть девушка.

> Есть идея проанализировать сырые данные по доте2 по различной инфе которую можно спарсить.

Есть датасеты же готовые по ней. Даже конкурс на кегле был.

> Подробности в телеге @Vladimirrus

+15

Причём тут путен? мы не политику обсуждаем, я же оставил мыло, пиши на мыло если удобно, если будет много людей, выберем удобный для всех мессенджер.

А чем тебя Путин не устраивает, а? При Ельцине даже 80% на MNIST получить могли, а сейчас при Путине любой даун как минимум 98% получает.

При том что поиск по твоей телеге выдает ватные ссылки. Мало ли, вдруг ты под санкциями.

Врешь, пес лахтинский, 80 можно даже линейной регрессией на бумажке посчитать.

>In this paper, we focus on the following four patterns that appear to us to be trending in ML scholarship: (i) failure to distinguish between explanation and speculation; (ii) failure to identify the sources of empirical gains, e.g., emphasizing unnecessary modifications to neural architectures when gains actually stem from hyper-parameter tuning; (iii) mathiness: the use of mathematics that obfuscates or impresses rather than clarifies, e.g., by confusing technical and non-technical concepts; and (iv) misuse of language, e.g., by choosing terms of art with colloquial connotations or by overloading established technical terms.

>failure to distinguish between explanation and speculation

>failure to identify the sources of empirical gains

>mathiness: the use of mathematics that obfuscates or impresses rather than clarifies

>misuse of language

Всё идёт по плану. Гранты крутятся, бабосы мутятся. Получил, купил ПО, написал пейпер с красивой презой, попиздел перед хомячками, молодец, иди за следующим.

Сойбои совсем скатились, уже пейперы пишут про то, как не надо писать пейперы про нейроночки.

Или как это вообще работает?

Да, это препринты без модерации, доверять 100% нельзя.

>То есть не известно вообще, появится она потом в каком либо журнале или это хуита на бумаге, которую никто никогда не опубликует?

Да.

>Туда любой Васян может свою публикацию выложить?

Нет.

Подводные вижу : 1)Трата еще 2 лет на окончание меда

2)Закончу там бакалавриат в 27, не поздно ли?

Что думаете?

54 Кб, 627x1128

54 Кб, 627x1128https://arxiv.org/ -> About arXiv

>>26267

Может выложить кто угодно, но там есть модерация и submissions to arXiv should conform to Cornell University academic standards

27 в Германии не много точно. Но на фига тебе из меда в cs перекатываться? Заканчивай мед, сваливай в Гермашку, проходи переаттестацию, работай врачом,... Профит.

У меня нет друзей, кроме интернета. Мне негде больше спрашивать. Что делать? Я не понимаю где модель ошибается. В любой другой программе я сделал бы брейкпоинт и по шагам нашел бы ошибку. Тут так не сделаешь.

Мед в сраной это выкинутые на помойку годы твоей жизни. Украха скорее всего тоже, хотя тут ты лучше меня должен быть осведомлен. Судя по твоим вопросам и месту, где ты их задаешь (ты вообще осознаешь где ты сейчас находишься?), никаких успехов на нейронном поприще ты не добьешься.

Не, я тож не могу ((

А на чем её тестировали по-твоему?

Получай мед образование, в свободное время изучай Питон и нейронки на прикладном уровне. В глубокий матан не лезь, бесполезно и не нужно.

Если повезет - применишь нейронки где-нибудь в медицине и придешь к успеху. Если не повезет - будешь клизмы ставить.

Вы видите копию треда, сохраненную 3 сентября 2018 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

![How to Learn Advanced Concepts Fast.mp4-snapshot-05.16-[201[...].jpg](/pr/big/thumb/1209084/15311428414130s.jpg)