Вы видите копию треда, сохраненную 11 марта 2019 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Продолжаем сраться по поводу и без.

FAQ:

Я ничего не понимаю, что делать? Либо в тупую import slesarplow as sp по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/ | Николенко и др. "Глубокое обучение" На русском, есть примеры, но уже охват материала

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: немодифицированные персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Архивач:

http://arhivach.tk/thread/412868/

Остальные в предыдущих тредах

Там же можно найти треды 2016-2017 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

Предыдущий тред: >>1305682 (OP)

https://hightech.fm/2018/12/23/ai-learning

>обнаруживая смещения смысла

В голосяндру, тоесть если я прямо называю педика педиком, то это не будет смещением?

Шиза какая-то. Типа тензорфлоу скажет что мой датасет токсичный и откажет его обрабатывать?

Ну как зачем, это оказывает негативное влияние на общество, это пропаганда! Я традиционалист вообще, каждого педика бы в жопу трахнул!

Есть оригинальная хуйня от автора: https://www.dropbox.com/s/v6ua3d9yt44vgb3/cover_and_thesis.pdf?dl=0

если под "объяснением" понимается разжёвывание, то фиг знает, может в гугле что и есть

76 Кб, 604x523

76 Кб, 604x523А вот вам и пример опасности сойбойства в машобчике. Через несколько версий какой-нибудь слесарьплов не только откажется работать с нетолерантными картинками, но и будет стучать на пользователя во все спортлото сразу, от ФСБ до местных сжв параш, да-да и в Барнауле. Захотел негров распознать, нейроночка их пометила как горилл, на следующий день вышел из хаты, а под дверью насрано, ручка говном обмазана и плакат висит "здесь живёт белый цисгендерный угнетатель", спускаешься по лестнице, а на встречу тебе отряд СОБРа с бутылкой. 2 года условно, внесение в список террористов и заблокированные карты. Бобро пожаловать в кибергулаг.

Не забывай, что ты в рашке живешь (если, конечно, живешь в ней). Тебя сначала во дворе кибергопники изобьют, так как яндекс-гласс классифицировало тебя хачом в штанах с подворотами (в тени стоял, а штаны были шортами, но алгоритм всегда прав), потом полиция заберет тебя в отделение, так как на толоке ассессоры тебя единогласно классифицировали неправославным террористом. Ну, а с бутылкой и дальше все верно.

С бутылкой оно всегда всё верно..

>Trevor Hastie et al. "The Elements of Statistical Learning"

Они сказали, что это уже устарело и нинужно, все перешли на диплернинг.

В голос. Что хуже? То, что у них есть отдел по МЛ или то, что они знают об этой книжке и всё равно дебилы?

>Они сказали, что это уже устарело и нинужно, все перешли на диплернинг.

Предъяви им за арабские цифры, скажи,что они устарели

35 Кб, 491x550

35 Кб, 491x550>>16472

>>16488

А разве в этом треде не то же самое кукарекается? Коооококо Вапник не нужон, Бишоп не нужон, ISLR и 300стр про линейную регрессию не нужно, все устарело к хуям, что написано раньше чем 2 месяца назад, как нейроночки работают науке не известно, наука это индусы и сойбои. Вот и в этой конторе такие же деграданты.

ну, это просто обычные русские некомпетентные программисты и не разбираются в мл вообще.

Нормальный специалист (вкатившийся после ее выпуска) знает про эту книжку.

а какие предпосылки для того, чтобы оно было? Люди только пять лет назад научились котов классифицировать на картинках с более-менее высокой точностью (а ведь не кажется сложной задачей - уши есть, хвост есть, чего там определять) - и то до сих пор все про adversarial attacks пишут. Мы даже не знаем, что такое AGI (сириусли - единственное нормальное описание - это чтоб как человек, но в 10 раз быстрее). Это как в 17 веке возмущаться, почему до сих пор не придумали термоядерный синтез, ведь столько же бабла в паровой двигатель вкладывают, а все упирается в ткацкие станки и водокачки.

слабый, это который только в шахматы умеет играть

>нейросети - это слабый ИИ.

>шахматы умеет играть

Причам тут интеллект, если это маняматика и статистика? Шазматы вобще позиционная игра и к интеллекту никакого отношения не имеет.

597 Кб, 700x635

597 Кб, 700x635>котов классифицировать

Тоесть отличит кота от любого другого кошачьего? Сколько котов на пикрил?

>Иди нахуй отсюда читать определение слабого ИИ.

Прочитал тебе за щеку, порванный математический гондон

просто раньше считали, что в шахматы и го нельзя победить сугубо статистическими методами (curse of dimensionality и тд). Потом пришлось эти задачи засунуть в "слабый ии".

https://www.reddit.com/r/baduk/comments/2wgukb/why_do_people_say_that_computer_go_will_never/

>шахматы

Так дипблю там тупо перебор даже, а не статистика, это собственно та игра где компы всегда рулили

>го

С го да, но перебор не работает всилу охулиарда вариантов, а вот статистические методы как раз порешали. Хотя даже старые го программы меня выносят как школьника.

>И как ты дошёл до мысли использовать для этого машоб? Какие-нибудь профильные CADы типа nastran уже не в моде

Это очень интересный способ.

А вообще, изначальный способ - визуализация потоков воздуха, тут ничего оригинального еще нет по сути, а если добавить к этому еще температуру и давление, то будет очень интересно.

У нас есть способы визуализации потоков воздуха, например, с помощью метода Шлирена, но хотелось бы, чтобы оно было трехмерным, например.

А если при этом еще и получится учитывать, каким образом этот воздушный поток взаимодействует с объектами и как влияет на их скорость, то было бы идеально

>Коооококо Вапник не нужон, Бишоп не нужон, ISLR и 300стр про линейную регрессию не нужно, все устарело к хуям

Ну отчасти это правда.

Будущее машинного обучения это алгебраическая топология и изучение statistical manifolds.

ну если симулятор ламинарных потоков не нужен, то ок

джвачую, прочитал книги по нлп, а бабы не дают

Т.е в конечном счёте тебе нужна идентификация динамических систем с помощью машобчика и затем предсказание поведения объектов в такой модели системы. Это все решаемо, ещё в совке этим занимались, да и на жопаде и в японии в те же годы. Просто тогда это делали несколько иначе, с помощью параметров системы, а не прямой её видеосьемки. Алсо, в промышленности для таких целей использовались алгоритмы, для которых есть строгие доказательства сходимости, хотя бы функция Ляпунова должна быть или устойчивость по Попову. Естественно, никакой диплернинх этим требованиям не соответствует. Но сойбоям похуй, вроде уже были случаи когда беспилотное такси убер размазало прохожих по переходу.

> Although the car’s sensors detected Herzberg, its software which decides how it should react was tuned too far in favour of ignoring objects in its path which might be “false positives” (such as plastic bags), according to a report from the Information. This meant the modified Volvo XC90 did not react fast enough.

убер и дип лернинг не при чем. У них моделька постоянно давала false positive (как выше из yolo - объекты дрожат и на пару кадров выпадают из сегментации). А умники из убера (у них и статьи так себе и, мне кажется, часто результаты из головы взяты) вместо того, что нормально ее обучить на видео-потоке, просто забили на это и выкатили гигантский джип (тоже додумались) с лидарами ночью на улицу без освещения. А тестер, который сидел за рулем, в это время втыкал в телефон.

https://www.youtube.com/watch?v=hthyTh_fopo

Я восемь лет на андроид проебал и ничего.

>В статистике есть такое понятие как outlier.

По-русски это называется выброс.

>Но в нейронках эта штука, как бы, почти не учитывается

Почему? Все виды регуляризации борятся с выборосами.

>Т.е в конечном счёте тебе нужна идентификация динамических систем с помощью машобчика и затем предсказание поведения объектов в такой модели системы.

Да, только предсказания кратковременные.

>Алсо, в промышленности

В промышленности немного другие штуки обсчитывают, типа вентиляцию, обтекаемость и все такое.

>Естественно, никакой диплернинх этим требованиям не соответствует.

Почему?

>регуляризации

Ладно, зайду с другой стороны.

Каким образом давить шум, если он громче полезного сигнала, что делать с этим шумом, что делать с сигналом? Как не послать такой сигнал просто нахуй?

Обучить нейронку, которая распознает распределения с выбросами!

Не очень понятен вопрос. В статистике у тебя есть модель сигнала и модель шума, и зная эти модели, ты можешь предсказать вероятность того, является ли порция пришедшей информации сигналом или шумом. Например, если у тебя сигнал - синусоида, которая утопает в белом шуме с точки зрения громкости, ты можешь простым IIR фильтром (который является простейшей рекуррентной нейронкой с 1 слоем без активации) или FIR фильтром (который является простейшей сверточной нейронкой с 1 фильтром аналогично без активации) вычленить эту синусоиду. Настроить параметры такого фильтра можно градиентным спуском, хотя это будет не самый эффективный метод.

Нейронки посложнее сами себе разрабатывают себе эти модели сигнала и шума - по сути каждый слой что-то фильтрует относительно предыдущего слоя. Получается это потому, что с каждым батчем существует способ немного улучшить модель, на большом числе данных модели улучшаются значительно. Застревания в локальном минимуме не происходит из-за того, что чем больше у тебя в пространстве измерениий, тем менее вероятно тебе встретить локальный минимум.

Пишу сеточку на торче, вставил дропаут и скор на тесте стал перестал меняться от эпохи к эпохе.

Делаю так:

1)тренирую

2) net = net.eval(); считаю на тесте; net = net.train()

3)goto 1

ЧЯДНТ?

>Застревания в локальном минимуме не происходит из-за того, что чем больше у тебя в пространстве измерениий, тем менее вероятно тебе встретить локальный минимум.

ЩИТО

Для условия локального минимума у тебя производные по всем направлениям должны быть равны нулю, а вторые менять знак. Для 1 измерения это значительно более вероятно, чем для 1000, там ты скорее встретишь какую-нибудь седловую точку и прочие многомерные изъебства. Грубо говоря, 3д гору умная нейронка обойдет через четвертое измерение, и пойдет спускаться дальше.

>Для условия локального минимума у тебя производные по всем направлениям должны быть равны нулю, а вторые менять знак.

А мир то интереснее, чем я думал.

Это ты обосрался или я?

мимо

Локальный минимум это когда у тебя градиент (первые производные) зануляется, а гессиан положительно определен. И локально глобальный минимум от локального ничем не отличается.

Просто у нейронок значения в локальных минимумах не очень сильно отличаются, даже при некоторых упрощениях доказано вроде.

Раньше в шапке поясняли, что это говно. Учат так же как и везде, но отбор жесткий.

>везде

Может курсы уровня физтеховских или фкновских, но если ты там учишься, то и отбор не сложный, а если не там, то отбор вполне проходимый и альтернатив не так много.

Нихуя не понял из твоего поста. Можешь в несколько предложений расписать?

39 Кб, 511x509

39 Кб, 511x509> Ты сейчас разговариваешь с местным шизиком, можешь не тратить время.

Тыскозал, что я шизик? Возражений по существу поста нет, но вот тебе небанбит, и я уже почему-то шизик. Не думал, что проблема в тебе?

А он хоть когда-то считался плохим? Вроде как единственное место в рф, где можно получить нормальную подготовку в области дс.

>Локальный минимум это когда у тебя градиент (первые производные) зануляется, а гессиан положительно определен.

Я примерно это и написал. Со сменой знака проебался (он у первых производых меняется), но это не суть, суть в том, что чем больше у тебя измерений, тем больше факторов должно совпасть, чтобы алгоритм застрял.

>Просто у нейронок значения в локальных минимумах не очень сильно отличаются, даже при некоторых упрощениях доказано вроде.

Глобальный минимум при стохастическом градиентном спуске означает то, что у тебя дикий оверфит к конкретному минибатчу. Это никому не нужно. Если же ты пользуешься глобальным алгоритмом вместо SGD, то аналогично, просто это будет дикий оверфит к конкретному обучающему множеству.

Нам нужно другое - чтобы каждый конкретный минибатч куда-то спускался. И вот для этого нужна многомерность.

основные участники регулярно берут золото на каггле и других площадках, а что остальные 18000 зарегистровавшихся мертвых душ делают - это уже не важно

прикладывай код нормальный, ванга в /sci сидит

ну, а что тогда важно?

>Тут магия присутствует?

Худший вид магии - индустрия на 90% состоит из полуграмотных малолеток с хохолками, которые анализ и классическую статистику не осилили, а учоными почувствовать себя хочется. Магия хаоса, в своём роде. А всё научпоп, будь он неладен.

7 Кб, 850x1100

7 Кб, 850x1100import matplotlib

matplotlib.use('PS')

import matplotlib.pyplot as plt

matplotlib.rc('ps', usedistiller='xpdf')

f = plt.figure()

plt.plot(x, label=u'тест')

plt.legend()

plt.savefig('test.ps', bbox_inches='tight', pad_inches=0)

plt.close(f)

А, всё, разобрался.

Ты только что весь IT

Вроде тензорные ядра, и производительность на уровне 1080 Ti, но как-то многовато негативных отзывов

Откуда ты можешь это знать, ты хотя бы 100 бизнес-задач видел?

> оптимизации/теории управления/обработки сигналов,

Такую хуйню лень делать. В этом и прелесть самообучалок, они сами решения находят, ничего не нужно изучать, просто подключать нейросеть к Старкрафту/Форексу/любой другой хуйню требующую тактики и стратегии, и она сама находит оптимальную стратегию.

>просто подключать нейросеть к Старкрафту/Форексу/любой другой хуйню требующую тактики и стратегии, и она эпически обсирается, но деньги уже освоены и пейперы написаны, так что всем похуй

Поправил тебя.

> просто подключать нейросеть к Старкрафту/Форексу/любой другой хуйню требующую тактики и стратегии, и она сама находит оптимальную стратегию.

Если бы с форексом было так просто, любой школьник бы озолотился.

> далеко мы от создания ИИ с самосознанием? Сколько лет ещё ждать?

Этим занимаются передовые учёные работающие сразу в нескольких областях: анатомия, математика, и информатика. Обычный Васян с линалом и перцептроном эту хуйню не осилит. Основная проблема в том, что отсканировать мозг, и запустить его на суперкомплюхтере хотя бы 10с, мягко говоря, очень сложно.

Примерно так же далеко, как далека самая умная муха от обретения самосознания.

Вообще это такая вычислительная машинка, которая пространственно-дискретна, в отличии от обычных коплюхтеров, которые временно-дискретные.

Мозг - вычислительная машинка, это очевидный факт.

Алсо, эта машинка должна уметь в саморефлексию.

Тащемта, что является вычислительной машиной?

Главная функция мозга - клеить самочек и реализовать волю к власти.

>Главная функция мозга

Управлять телом и процессами, мышление лежит в другой области, вне мозга

>почему именно не в физическом теле

Место сознания в физическом теле не определено, а вот предчувствия, коллективные вдохновение и прочие загадочные вещи имеют место

> За пределами физ. тела, в астрале/ноосфере

Дебил тупой, ты почитай что такое ноосфера у автора термина - Вернадского, потом кукарекай. Он никогда никакие атсралы в виду не имел, чучело ты ебаное.

Да забей ты на этого шизика

>Тьюринга

Питух проткнутый

>>18872

>ноосфера у автора термина - Вернадского

Понятие «ноосфера» было предложено профессором математики Сорбонны Эдуардом Леруа, который трактовал её как «мыслящую» оболочку, формирующуюся человеческим сознанием. Э. Леруа подчёркивал, что пришёл к этой идее совместно со своим другом — крупнейшим геологом и палеонтологом-эволюционистом, и католическим философом Пьером Тейяром де Шарденом.

>Черча

Хуерча, Алонзо Чёрч матаношизик абосанный

> Питух проткнутый

Ты? Разумеется.

> Понятие «ноосфера» было предложено профессором математики Сорбонны Эдуардом Леруа, который трактовал её как «мыслящую» оболочку, формирующуюся человеческим сознанием. Э. Леруа подчёркивал, что пришёл к этой идее совместно со своим другом — крупнейшим геологом и палеонтологом-эволюционистом, и католическим философом Пьером Тейяром де Шарденом.

Полтора ноунейма, Пындельшмуклер и Пихвельплейшнер придумали хуйню, а пруфов подвезти совсем забыли. Что же делать, ну давайте просто уверуем.

>>18878

> Тебя термин смущает? Выбери любой другой.

"Хуйня из-под коня" сойдёт? Ты и в боженьку поди веришь, а?

>Что же делать, ну давайте просто уверуем.

Тоесть, когда маняматик несет дич оторванную от реальности это норма?

32 Кб, 645x729

32 Кб, 645x729> Тоесть, когда маняматик несет дич оторванную от реальности это норма?

Дебилок, попробуй включить в свой манямир простую истину - если ты в силу своей безмозглости чего-то не понимаешь, это никак не доказывает того, что это что-то - дичь. Ну нету мозгов и ладно, бывает. Но использовать это как доказательство - школьничество.

>>19037

> верю, а ты разве нет?

Ясно все.

81 Кб, 650x439

81 Кб, 650x439Маняматический каргокультист начинает маневрировать, можете еще и в жопу ебешься по Тьюрингу?

В чем проблема сжать мозг в шакала? Вроде же запускали 1 с, просто понижаем настройки

Бамп вопросу

>МФТИ тот же самый, МГУ, Бауманка, Вышка, Санкт-Петербургский национальный исследовательский университет информационных технологий, СПБГу

В итмо машынкой почти не занимаются

А теперь подумай, потянешь ли ты учебу в тех топовых вузах, которые ты назвал? Все-таки машинное обучение начинается обычно на старших курсах, а скорее всего только в магистратуре. Далеко не каждый сможет выдержать тот дроч, который происходит в топовых вузах на пми.

Ну а если есть такое сильное желание - начни участвовать в перечневых олимпиадах, которые дадут тебе льготу поступления без экзаменов в топовые вузы.

на фкн поступай по олимпиадке какой-нибудь

Да похуй, запилят альт-райтский фреймворк зига-торч. Не такой уж и рокет-сайенс. Вот с облаками действительно проблемы могут быть.

Ни-ху-я. На энтузиастичах работаем. Деньги у тырпрайз-макак из соседнего.

гугли спец либы для работы со словами. они определяют части речи, приводят к каноническому виду и т.д. для каждого языка свои. вручную запаришься делать. это на годы задача.

Теперь поджробнее:

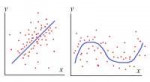

На входе двумерная сетка со значениями 0/1. Задача нейронки обнаружить есть ли в сетке ряд или

столбец в котором все ячейки будут единицами. При этом такой ряд должен быть один. Столбцов так же

максимум 1.

Нейронка самая простая на сигмах и обратным распространением ошибок.

На первой пике ожидаемый ход обучения (сетка 20х20), два скрытых слоя по 10 нейронов, 2 выхода на

вертикальную и горизонтальную линию.

А на второй - сетка 3х3 с двумя скрытыми слоями по 9 нейронов. Эта хрень вертелась больше 1кк

итераций но так и не смогла полностью осилить задачу. Собственно как так-то?

Серый цвет тут - средняя ошибка, чёрный - случайная единовременная ошибка.

Добрый день, на данный момент я школьник (11 класс), в будущем хочу заниматься нейроночками, но сейчас больше занят подготовкой к егэ. Я правильно понимаю, что мне надо поступить в средненький вуз (В Москве), а с лета начинать прямо вкатываться? (я пытался начать в этом году с курса мфти, но в итоге зажмотил время). Я правильно думаю? Мне же будет норм, если я пойду не в топ-вуз? Насколько я понял, работодатеям в основном нужен опыт. Или стоит все же попытаться пройти в мгу какой-нибудь (мфти не потяну)? И там учиться? Просто так не хочется, на самом деле. Что анон посоветует? Образование мгу сильно поможет в этой сфере?

Забавно, увидел пост 16 летнего анона, а у меня примерно та же ситуация. В общем, остановлюсь пока на том, что топ-вуз не нужен.

мимо 1321484

Смотри программу, чтобы были вещи типа openmp, cuda, свертки и преобразования фурье и прочая поебистика.

Иначе твой вуз просто заберет у тебя кучу времени на хуиту типа написания курсачей на паскале на тему документооборота, и в таком случае лучше никакого вуза, чем средненький.

Далее скорее всего 2 года ты потеряешь в любом случае на матан, но параллельно нужно будет дрючить общепрограммерские вещи, которые в вузах не дают, типа гита, unix shell, aws и т. д. и т. п. С третьего курса можно начинать искать работу по специальности, к бакалавру будет нужный опыт. Если так хочется образование МГУ, то можно на 4-м курсе подготовиться к поступлению на магистра именно в МГУ.

>Образование мгу сильно поможет в этой сфере?

Похуй.

Буква греческого алфавита.

Ого, спасибо за такой полный гайд, сейчас пойду проверять программы вузов.

97 Кб, 500x636

97 Кб, 500x636нипадю

>t. пишет на хабре про то, что сейчас-сейчас будет общий искуственный интеллект, который убьёт всех непрограммистов

Уже давно используют. Только я бы не стал это называть ИИ, слишком громко звучит. Машинное обучение лучше.

Смерть человека неизбежна.

119 Кб, 960x680

119 Кб, 960x680>>22009 (Del)

>>22048 (Del)

49 Кб, 481x481

49 Кб, 481x481>Предсказать курс валюты нереально, там всякое случайное блуждание итд. А зачем его предсказывать, если задача вообще не в этом? Что нужно трейдеру?

Для алгоритмического трейдинга как раз применяют методы предсказания с помощью алгоритмов. Есть же теория вероятностей, теория игр, математическая статистика, и т.д. Ты просто немного не в теме. Советую специализацию из 6 курсов по ML на русском https://www.coursera.org/specializations/machine-learning-data-analysis

На курс влияют события. События можно отслеживать и анализировать. Так что все вполне реально. До компьютеров было тоже самое, только отслеживали и анализировали события сами биржевые брокеры и другие заинтересованные. А теперь все можно запрограммировать.

143 Кб, 400x378

143 Кб, 400x378>Для алгоритмического трейдинга как раз применяют методы предсказания с помощью алгоритмов. Есть же теория вероятностей, теория игр, математическая статистика, и т.д.

>>22132

Ссылку оставил выше на курсеру. Зайдите посмотрите несколько вводных видео. Там расскажут, что давно уже проводят анализ валют и других биржевых инструментов, для успешной алгоритмической торговли. Также предсказывают погоду метеоцентры, и много чего еще можно запрограммировать.

Вот даже ссылка на первый курс из специализации. В первых видео это рассказывают https://www.coursera.org/learn/mathematics-and-python?specialization=machine-learning-data-analysis

События инициируются совершенно ебанутыми иррациональными решениями людишек и распространяются на волне таких же субъективных реакций тех же людишек. Удачи в предсказаниях

.

И что. Так всегда было. И всегда так будет. Только раньше собрать и проанализировать такой объем информации было сложно. А сейчас это решается компьютером.

Вот вам страницы из книг:

1) "Introduction to Scientific Computing" (Mark H. Holmes)

2) "Introduction to Probability" (Charles M. Grinstead, J. Laurie Snell)

3) "Statistics in a Nutshell" (Sarah Boslaugh, Paul Watters)

И да, таким образом таки предсказывают погоду. Но на бирже это не работает, и тов. учоный с Курсеры, по-моему, пытается выдать желаемое за действительное.

Вы понимаете, что основная интрига на бирже состоит не в том, чтобы угадать будущую цену или область, где она могла бы оказаться (для этого есть формула случайного блуждания), а в том, что существует некая группа юридических лиц, которые видят все позиции физических лиц.

Вы понимаете это или нет?..

Возможно ли проанализировав комментарии подозреваемого в социальных сетях установить, что другие комментарии принадлежат ему же? Возможно основываясь на повторяющихся грамматических ошибках, часто используемых слов, сленга... На сколько точно на данный момент решаются такие задачи?

мимо-неспециалист

То есть, вы не понимаете, в чём интрига. Так я и думал.

А запостил я эти страницы для того, чтобы не понимающшие в чём там интрига поискали эти три книги в Энторнете. Потом легче будет лекции прогуливать и тервер сдавать. Мой любимый был предмет, кстати.

И это не учебники, а вполне себе техническая литература, особенно первая книга, где предсказывают погоду.

>>22552

Вы не поверите - отлично решаются: https://ideone.com/1V8pJe

И что даст тебе твой анализ? Что в любой ситуации может происходить всё что угодно?

Ты шизик? Написал столько текста, а по существу ничего. И программа твоя делает совсем не то, что человек спрашивает.

Меня глюкнуло или ютуб на лету улучшает произношение английской речи?

Смотрел видеоролик какого-то индуса, в начале речь была с ужасным акцентом и дефектами записи, а под конец произношение стало, как в аудиозаписях к учебнику инглиша

. Такое тоже умеете?

Слушай, еще до появления массовых компьютеров люди умели предсказывать положение дел на бирже. Есть математика, ты в курсе вообще об этом. А теперь есть возможность обработки больших объемов данных, что очень кстати для таких задач.

Почти со стопроцентной долей вероятности. Но для этого используют особые алгоритмы и большие вычислительные мощности. Какой-нибудь Google такое может сделать. Не знаю кто еще, но такое возможно.

>И что даст тебе твой анализ? Что в любой ситуации может происходить всё что угодно?

Ты вообще про машинное обучение слышал? А про математику? Если быстро обрабатывать слухи и события, то можно покупать и продавать по выгодной цене.

Есть, но я сам ньюфаг в этом.

Юные годы Баффета прошли в родном городе. В раннем детстве он обнаружил хорошие математические способности и, обладая прекрасной памятью на числа, легко запоминал статистические данные о количестве населения в различных американских городах [63].

Уоррен Баффет родился 30 августа 1930 года в Омахе, самом большом городе штата Небраска, в семье биржевого брокера и политика Говарда Баффета. Он рано научился читать, уже к школьному возрасту знал основы математики. С самого детства он удивлял родителей способностью перемножать в уме многозначные числа, а постигать азы финансового искусства Баффет начал в шесть лет.

В детстве Уоррена Баффета интересовали только цифры, статистика и математические расчёты.

Именно тогда у него возник интерес к цифрам и вычислениям. Только в них Уоррен находил спасение от нападок матери. Он и школу полюбил за возможность уйти из дома и изучать математику.

Члены семьи замечали и поощряли интерес Уоррена к цифрам и статистике. Когда ему исполнилось восемь, дед подарил Уоррену книгу о бейсбольном сезоне 1938 года. Подарок так обрадовал мальчика, что он буквально вызубрил биографию каждого игрока.

В детстве Уоррен с другом Рассом любили сидеть на крыльце и записывать в блокнот номера проезжающих мимо машин. Родители думали, что мальчишки вычисляли частоту, с которой встречается каждая буква и цифра. На самом деле ими двигало желание прославиться. Их улица была единственной дорогой из тупика, в котором располагался банк. Они верили, что однажды по ней проедут грабители, найти которых полиция сможет только с помощью этих записей.

Уоррен часами сидел в своей комнате, вдали от властной матери, погрузившись в чтение любимых книг или решая сложные математические задачи.

...последнее вообще... до слёз)

39 Кб, 511x509

39 Кб, 511x509> Возможно ли проанализировав комментарии подозреваемого в социальных сетях установить, что другие комментарии принадлежат ему же?

Тащмайор, в суд потом тоже с нейроночкой пойдете? А если защита попросит обосновать устойчивость и сходимость алгоритма в любой возможной ситуации?

>>22543

> Вы понимаете, что основная интрига на бирже состоит не в том, чтобы угадать будущую цену или область, где она могла бы оказаться (для этого есть формула случайного блуждания), а в том, что существует некая группа юридических лиц, которые видят все позиции физических лиц.

Позиции каких угодно лиц видит кто угодно по объёму торгов. Сколько продаётся, сколько покупается. Вопрос в том, что делать в каждой ситуации чтобы максимизировать профит.

170 Кб, 1024x768

170 Кб, 1024x768Благодаря этому я загорелся идеей вката в реверс-инжиниринг. Моя цель, будучи жителем далекой провинции, выточить напильником из технического и металлического мусора установки для выпуска строительных материалов на основе мусорных отходов, песка, камней, щебня и т.д. За основу хочу взять существующие разработки и с помощью реверс-инжиниринга догадаться как они работают, создать близкий аналог из технического и металлического мусора. После чего построить себе землянку и забор из полученных строительных материалов.

Если я в будущем построю потенциальную землянку, то ко мне сразу на разборки приедут провинциальные коммерсы качать права за то, что я из мусора построился, а не купил у них стройматериалы как все. И предъявят за то, что я мужиков своим примером сколачиваю так же сделать. Я отвечу, что они не авторитеты для меня, смачно плюну: "харктьфу", кто вы такие, чтобы запрещать мне строиться из мусора! Все, базар окончен! И уйду, гордо развернувшись. Но тогда ко мне разборки будут приезжать рэкетиры: борцы, боксеры, штангисты, гиревики.

Так вот, я хочу для защиты от коммерсов строить землянку как на пике, только еще более приземистую и с бойницами вместо окон. Чтобы она была низкая, чтобы была меньше площадь поражения и было сложнее за каменным забором попасть в нее из гранатомета или попасть зажигательной смесью. А также хочу построить башню для обзора окрестностей. На башне должна быть камера и нейросетевая программа для распознавания изображений, чтобы задетектировать подъезжающих рэкетиров на разборку и поднять тревогу, включив сирену, чтобы я был готов, взять лук и стрелы и взобраться по тревоге на башню.

Отсюда вытекают вопросы, помогите, пожалуйста, найти на них ответ:

1) НАСКОЛЬКО СЛОЖНО САМОМУ СДЕЛАТЬ ТАКУЮ НЕЙРОСЕТЬ? Достаточно ли будет для этого языка Си?

2) Если я хочу еще, чтобы нейросеть защищала мою землянку от выстрелов гранатомета, выбрасывая навстречу гранатометному снаряду металлические осколки для детонирования снаряда до достижения землянки. То насколько сложно будет создать такую защиту?

3) Насколько углубленно надо учить матан для такой цели? Хватит ли стандартного курса отечественных ВТУЗов?

170 Кб, 1024x768

170 Кб, 1024x768Благодаря этому я загорелся идеей вката в реверс-инжиниринг. Моя цель, будучи жителем далекой провинции, выточить напильником из технического и металлического мусора установки для выпуска строительных материалов на основе мусорных отходов, песка, камней, щебня и т.д. За основу хочу взять существующие разработки и с помощью реверс-инжиниринга догадаться как они работают, создать близкий аналог из технического и металлического мусора. После чего построить себе землянку и забор из полученных строительных материалов.

Если я в будущем построю потенциальную землянку, то ко мне сразу на разборки приедут провинциальные коммерсы качать права за то, что я из мусора построился, а не купил у них стройматериалы как все. И предъявят за то, что я мужиков своим примером сколачиваю так же сделать. Я отвечу, что они не авторитеты для меня, смачно плюну: "харктьфу", кто вы такие, чтобы запрещать мне строиться из мусора! Все, базар окончен! И уйду, гордо развернувшись. Но тогда ко мне разборки будут приезжать рэкетиры: борцы, боксеры, штангисты, гиревики.

Так вот, я хочу для защиты от коммерсов строить землянку как на пике, только еще более приземистую и с бойницами вместо окон. Чтобы она была низкая, чтобы была меньше площадь поражения и было сложнее за каменным забором попасть в нее из гранатомета или попасть зажигательной смесью. А также хочу построить башню для обзора окрестностей. На башне должна быть камера и нейросетевая программа для распознавания изображений, чтобы задетектировать подъезжающих рэкетиров на разборку и поднять тревогу, включив сирену, чтобы я был готов, взять лук и стрелы и взобраться по тревоге на башню.

Отсюда вытекают вопросы, помогите, пожалуйста, найти на них ответ:

1) НАСКОЛЬКО СЛОЖНО САМОМУ СДЕЛАТЬ ТАКУЮ НЕЙРОСЕТЬ? Достаточно ли будет для этого языка Си?

2) Если я хочу еще, чтобы нейросеть защищала мою землянку от выстрелов гранатомета, выбрасывая навстречу гранатометному снаряду металлические осколки для детонирования снаряда до достижения землянки. То насколько сложно будет создать такую защиту?

3) Насколько углубленно надо учить матан для такой цели? Хватит ли стандартного курса отечественных ВТУЗов?

47 Кб, 520x350

47 Кб, 520x350> Назови хоть одного кто разбогател торгуя на бирже.

Я знал, что ты дебил, в клиническом смысле, но чтобы настолько. Мань, если у человека есть доход и он при этом не олигарх, друг пыньки и не медийная личность, о своих доходах он на каждом углу орать не будет. В цивилизованных странах вообще не принято доходами понтоваться, даже Брин в метро или Цукерберг в майке и шлепках за 5$ это норма. А сколько дохода имеет рандомный чувак на улице ты и вообще не угадаешь. Это не Африка, где масповские мажорики 14летнего возраста носят шмоток в среднем на полтора ляма.

Хедж-фонды

В них толпа математиков мутят разные модели и стратегии, а евреи им дают миллиарды чтобы торговать на бирже

У них нет бешеных прибылей, но даже несколько процентов сверху среднерыночной доходности при таких объемах - огромный профит.

Эти математики вполне себе не бедствуют.

мимо вебмакака

ну кстати нейронку т. майор может использовать, чтобы найти все подозрительно похожие комментарии, а потом Эксперт уже проанализирует их и вынесет заключение для суда.

>Позиции каких угодно лиц видит кто угодно по объёму торгов. Сколько продаётся, сколько покупается.

Ты видишь их уже после того как они попадают к Серьёзным Людям. Задержка там несколько десятков миллисекунд, но этого хватает чтобы ты сосал хуи со своими манямоделями, а евреи забирали твои денюжки.

И конечно суммировать всё в объём торгов и цену это уже потеря ценной информации. Надо смотреть на глубину рынка и ордер бук, в идеале.

Ну я например.

> Ты видишь их уже после того как они попадают к Серьёзным Людям. Задержка там несколько десятков миллисекунд, но этого хватает чтобы ты сосал хуи со своими манямоделями, а евреи забирали твои денюжки.

Какой же ты дебил, господи. Как 10 миллисекунд могут что-то решать в модели, оценивающей состояние актива как минимум в часовых интервалах? Да даже в миллисекундных, что ты там сделаешь за 10мс чего нельзя сделать за 20? Начитаются мемасов, потом несут хуйню.

>>23333

Хуи сосешь только ты, потому что мозгов у тебя нет.

и то и то норм будет. в обычную мать atx размера по крайней мере 2 штуки втыкнуть можно.

но ты прикинь по деньгам - может проще будет на амазоне каком-нибудь инстансы покупать для обучения.

>Как 10 миллисекунд могут что-то решать в модели, оценивающей состояние актива как минимум в часовых интервалах?

Так что рынок на часовых уже практически эффективен, потому что все лишние деньги которые можно забрать забираются на милисекундах.

>Да даже в миллисекундных, что ты там сделаешь за 10мс чего нельзя сделать за 20?

На, школьник, попросвещайся прежде чем за мамкиной кредиткой бежать

https://en.wikipedia.org/wiki/High-frequency_trading

> Так что рынок на часовых уже практически эффективен, потому что все лишние деньги которые можно забрать забираются на милисекундах.

Еблан, ой еблан...

И что? Боты с микросекундным разрешением друг друга наебывают, будто это как-то отменяет весь остальной рынок.

>будто это как-то отменяет весь остальной рыно

Это не отменяет рынок конечно, это отменяет неэффективности на нём с помощью которых делаются деньги.

13 Кб, 400x203

13 Кб, 400x203>у вас имеется романтичный юноша,

Тут все романтические юноши кроме меня и еще одного анона, уверовавшие в маркетинговую пропаганду нейроговна.

При чем тут блокчейн, шизик? Ты всегда скачешь с мысли на мысль, когда с людьми разговариваешь?

Я, например.

Они не мажоры, дебил. Это просто субкультура и они из среднего класса, считай такие же бедные.

А ты между строк читай. Он же пишет "я уже на блокчеин повелся, просрал кучу времени и бабла" теперь уверен что нейроночки и датасайенс то-же самое. И что вообще все вокруг говно и форс, кроме него любимого.

90 Кб, 827x465

90 Кб, 827x465>нейроночки и датасайенс то-же

Разве нет? Светофоры на капче хоть находить научились, лол? Или кроме высирания стотысячного папера ни начто не пригодны?

Кто-нибудь из местных собирал питоновский скрипт с включённым keras c theano бэкэндом в exe-шник или линуксовский исполнительный файл? Сейчас пытался через pyinstaller и py2exe. Не может theano зацепить.

Каждый месяуц проигрываю с "устаревания" и "новых" внедрений хуйни. На деле получается что Васян прикручивает к программе одну дополнительную функцию, а потом бежит репортить что он совершил революцию. На почве тотального соибойства и климата в котором никто не говорит "Ты чё долбоёб чтоли совсем, одну функцию так форсить, ты блядь не сделал НИХУЯ даун тупой! Иди пиздуй работать, выебонщик хуев" - это приобретает тотальную волну из новшеств и внешний вид лавинообразного развития индустрии.

>На деле получается что Васян прикручивает к программе одну дополнительную функцию, а потом бежит репортить что он совершил революцию

Хочу заметить, что у нас по такому принципу пишется большинство курсовых, дипломных и прочих работ в "топовых" вузиках. Как бе некому этим калом возмущаться.

Ваши "Вузики" никому нафиг ненужны. Ты можешь учиться за деньги твоих родителей и потом стать кассиром в пятёрочке. И всем похуй. А вот когда ты выходишь с докладом на какой-нибудь митап где билеты по 200 баксов, а на деле твоя zalupa.js внедрила в себя технологии 12 летней давности...

Я короче склоняюсь к тому, что сообщество программистов отупело и не может понять новшество это или нет. Тот же MVC почему-то в своё время превозносился, хотя по факту ему лет 40-45.

>Ты чё долбоёб чтоли совсем, одну функцию так форсить, ты блядь не сделал НИХУЯ даун тупой! Иди пиздуй работать, выебонщик хуев

Ну вот посмотри на себя - используешь буквы, которым тысяча лет, чтобы в каждый мл-тред нести вот эту вот хуйню. Работать не пробовал?

Хуя тебя пробрало с правды, лол. Никак себя узнал, или в чем причина твоих анальных скорбей? Он прав же, ситуация с машобом точно как с курсовичками и дипломчиками в быдловузиках - быдлостудентики пиздят одни и те же тексты с одних и тех же сайтиков, а всем и норм, ибо там и преподы такое же тёмное быдло.

>Хуя тебя пробрало с правды, лол.

И правда эта не меняется уже лет 10: безработный шизик с борд самый умный хуй на свете, а вокруг все идиоты.

Давай, расскажи мне, откуда ты знаешь о ситуации с машобом, а мы поржем.

> > Ну вот посмотри на себя - используешь буквы, которым тысяча лет, чтобы в каждый мл-тред нести вот эту вот хуйню. Работать не пробовал?

> Хуятебяпробралосправдылолникаксебяузналиливчемпричинатвоиханальныхскорбей?

Весело у вас тут

Бамп, пожалуйста!

144 Кб, 700x982

144 Кб, 700x982>откуда ты знаешь о ситуации с машобом, а мы поржем.

Достаточно посмтреть вокруг, даже ебаного помщника типа Алисы запилить нормально не могут.

маняме моего детства

Я безработный потому что не собираюсь жить по лжи. Я понимаю, карьеристская пидораха вроде тебя не то что правду, мать продаст ради того чтобы жопу в тёплое офисное кресло с бонусами и страховкой усадить, но есть и (меньшинство) других людей.

Ты безработный, потому что тупой. Уродился таким.

И дальше, осознавая свою ущербность, ищешь недостатки в тех, кто умнее тебя. Типичный шизик с борд.

> ты просто тупой ущербный оправдываешься не хочешь как я генералом успешным в кресле сидеть завидуй лох

Мог бы просто ничего не писать, твой вскукарек был просто алгоритмически предсказуем. Ты машинка.

> Алисы

Пушо чатботы нинужны. Во всех остальных нужных вещах, типа раскрашивания манги, генерации музыки, обыгрывания людей в дотах и т.д. нейросети справляются отлично.

Задача: Нужно из некоторого wav вычленять трифоны.

Самому лень это делать.

Waifu2x не забудь

>в каждый мл-тред нести вот эту вот хуйню. Работать не пробовал?

Ты меня с кем-то перепутал, я только вчера впервые написал в тред. А так сижу тут с ноября в рид онли режиме.

Алсо ты вместо обсуждения темы спора зачем-то перескочил на обсуждение личности написавшего. У меня работа есть. Но ты видимо не можешь защитить аргументами тезис "В IT полно ебланов которые не разбираются в IT и поэтому говно 10 летней давности многими воспринимается как инновация."

>Алсо ты вместо обсуждения темы спора зачем-то перескочил на обсуждение личности написавшего.

Нет, просто ты, гхм, туповат и в упор не видишь намек.

С чего ты взял, что при внедрении инновации возраст используемых технологий является чем-то важным?

Допустим, некий шизик Вася жил себе и жил, а потом решил внедрить Common Lisp вместо 1С. Успешно внедрил, получил премию, рассказал об этом на митапе. Дальше ты приходишь и говоришь Васе, мол, ты, червяк, вообще не имеешь право на митапах ничего рассказывать. Вот я - имею. Но не буду, потому что ссусь публичных выступлений. А ты - червяк и еблан.

Я тебе про новые технологии в индустрии в целом и как следствие отсутствие развития при внешнем ощущении её роста, а ты "Common Lisp вместо 1С".

Дай ссылку, плез

Вот твой текст: "Я короче склоняюсь к тому, что сообщество программистов отупело и не может понять новшество это или нет. Тот же MVC почему-то в своё время превозносился, хотя по факту ему лет 40-45. "

Иными словами, MVC нельзя превозносить просто по факту его возраста. Рассказывать о внедрении MVC нельзя. Будешь рассказывать - станешь частью отупевшего программерского сообщества. И вообще комбинирование технологий не является инновацией.

Вот колесо - разве инновация? Пффф. Взяли существующие элементы и соединили в ось, получили инновацию. Никакого развития уже пятьдесят тысяч лет.

157 Кб, 650x430

157 Кб, 650x430> Допустим, некий шизик Вася жил себе и жил, а потом решил внедрить Common Lisp вместо 1С. Успешно внедрил, получил премию, рассказал об этом на митапе.

Вот нынешние сойбои от машобчика чем-то таким и занимаются. Молодцы, конечно, но остаётся вопрос - где в этой схеме прогресс и развитие? За всеми этими тысячами пейперов, митапов итд как-то не принято замечать, что даже негров распознать нормально так и не могут. И это ещё не худшая сторона проблемы. Худшая сторона в том, что все выгодополучатели это сторонники электронного ГУЛАГа, враги прайвеси, свобод личности итд. Даже в случае относительно безобидных технологий типа контекстной рекламы все это работает на сбор данных и в конечном счёте это просто ещё один элемент все того же электронного ГУЛАГа.

>электронного гулага

какие-то русске комплексы, посмотри любое киберпанк произведение - никаких свобод, а общество кибербанка - это и есть единственно возможный прогресс. Тем более в России нет и никогда не было относительно Европы свободы (недавно отпраздновали 150 лет с отмены крепостного права и 50 лет с вручения паспортов крестьянам, лол), в Европах всегда внедрят GDPR и другие прайваси-инициативы.

> никаких свобод, а общество кибербанка - это и есть единственно возможный прогресс.

Наркоман ты что ли? Любой киберпанк это антиутопия, нет ничего прогрессивного в мире, где власть принадлежит транснациональным корпорациям, вместо закона устав компании, и где лучшая судьба для среднестатистического человека это работа в такой корпорации всю жизнь с пением гимна компании по утрам вплоть до смерти на рабочем месте от переработки, у гуков даже термин для этого есть. А если не вписался в рыночек - пиздуй к кибергопникам в канализацию или к кибербомжам в Коулун а то и на органы в подпольную больничку. Нет в этом никакого прогресса, точнее только узкоспециальный "прогресс" в области средств контроля и подавления. Именно к такому обществу все и идёт.

2,5 Мб, 350x204

2,5 Мб, 350x204> Собственно, проблема в том, что баребухи у меня не отделяются друг от друга

Так отделяй. Как минимум введи стоп-символ для отделения.

Ну и вообще здесь напрашивается рекуррентная сеть с произвольной длиной последовательности.

Ну так я с радостью бы отделил, но тогда обучение переписывать придется, длина последовательности же разная будет.

> рекуррентная сеть с произвольной длиной последовательности.

Поясни за них

>Ну так я с радостью бы отделил, но тогда обучение переписывать придется, длина последовательности же разная будет.

Да нет, ничего не изменится, по 5 словам будешь предсказывать следующее, просто одно из символов будет стоп-символов

>Поясни за них

Да загугли уж

> по 5 словам будешь предсказывать следующее, просто одно из символов будет стоп-символо

Тогда я не понял, что именно останавливает стоп-символ

Он ничего не останавливает, это ты сможешь порезать вывод нейронки, встретив стоп-символ.

24 Кб, 400x400

24 Кб, 400x400>нейросеть написала продолжение игры престолов

>Отмечается, что часть книги состоит из абсурдных сцен и бессмысленных словосочетаний

Ня, переводи

https://github.com/zackthoutt/got-book-6/tree/master/generated-book-v1

Достаточно чутка мокнуться в НЛП, что бы понять какую хуету пытаются втюхать маркетолохи и нейрошкольники.

увернет, что пикрил школьник даже не знает что такое анафора и какие с ней проблемы.

на диалоге-21 в этом году конкурс на разрешение анафоры, не хочешь ли написать действительно годный алгоритм, который покажет нейрошкольникам, как надо делать настоящий НЛП?

Генетические алгоритмы это брутфорс. Они не могут принимать во внимание какую-то структуру проблемы, которую ты хочешь решить. Соответственно конкурировать с хотя бы теми же самыми нейроночками они не могут, это тупик.

Ты ебанутый какой-то, сравнивать нейронки с ГА. Нейронки - это нейронки, вид математических функций. А ГА - это метод оптимизации. В случае нейронок применяется градиентный спуск, потому что нейронки дифференцируемы.

Если сравнивать ГА с градиентным спуском, то у ГА преимущество в том, что ему похуй, дискретные у тебя величины, или нет, похуй, можешь ли ты посчитать градиент, вообще на все похуй. Почти любая np-complete задача неплохо решается ГА.

ГА очень хороши для разного класса задач. Главное их преимущество - можно декларативно описать, что ты хочешь получить, а ГА будет перебирать, но не за экспоненциальное время, как брутфорс.

К примеру, есть у тебя цены в магазине и ты хочешь подобрать их таким образом, чтобы приходилось выдавать минимум сдачи. В принципе задача решается линейным программированием. Но с помощью ГА код пишется за несколько минут, просто записываешь целевую функцию, соответствующую минимуму сдачи, и все; и выдает решение, близкое к глобальному минимуму на 99.9%.

Это хорошо, например, для оценки качества других, более сложных, решений. Если хуже ГА, ищи ошибку.

Нейронки - это баззворд для одного из видов регрессионного анализа. А ты хуйню какую-то написал.

Ебанутый? ГАН - это алгоритм обучения нейросеток.

91 Кб, 720x720

91 Кб, 720x720>конкурс

мокрописьки на конфочках и митапчиках не показывают, покрописечки это мохнатое золотце, мохнатое ноухау. И когда я разрешу анафору, я буду рубуть бабосики, а не перед васянамя с Абби, Хуяндекса или Харкевича хвастаться.

Надо научить сеть данными из аэродинамических продувок моделей чтобы она сама генерировала флайт-модель в рантайме. Норм или не взлетит?

По мне звучит норм. Видел люди пилили CFD нейроночки

delta3[range(X.shape[0]), y] -= 1 #yhat - y

https://github.com/jldbc/numpy_neural_net/blob/master/three_layer_network.py

Блядь что ты несёшь уёба? Вам дали ИИ, системы обучения, кучу алгоритмов по распознаванию лиц, жоп пёзд и прочего. НЕТ МЫ БУДЕМ ПРО MVC В PHP РАССКАЗЫВАТЬ, ЭТО ВЕДЬ ЕБАТЬ КАКОЕ НОВШЕСТВО!

Тебе нужен GMM/HMM + expectation maximization. Скачивай kaldi, там вся эта хуйня в готовом виде.

Добавлю. Конкатенативный TTS это гавно мамонта. Настоящие пацаны используют нейронки для синтеза.

Мне только такие вакансии и попадаются, а ты шутки шутишь.

Это с вычетом соженного электричества нейрофантазерами

Видео не смотрел, но телку выебал бы

22 Кб, 406x423

22 Кб, 406x423Снова тяжело.

Есть ли здесь еще титаны? Давайте превозмогать вместе.

Объёб гоев на даллары усиливается.

Никогда такого не было и вот опять

На каком уровне вообще нужно знать мат. статистику для комфортной работы с машобом?

Какое то гавно, делал подобное, у меня в 3 раза лучше получалось.

Я хуй знает почему датасайнс мешают в одну кучу с машобом, но на мой взгляд это разные вещи. Если просто в нейронки вкатиться, то матстат тебе не особо нужен. Хотя, читал где-то альтернативное мнение, что в датасайнс идут те, кто не осилил нейронки.

Ну уот и всё. Карачун вам.

О, нью эйдж кайнда гай, с крашеной волоснёй рекламирует перед зеленоротыми задротами нейромагию, которая позволяет ничего не знать. Просто хуячишь в чёрный ящик и всё работает)). Классика.

Нельзя быть настолько тупым чтобы сообщить о своих открытиях относительно природы разума и умным чтобы совершить такое открытие. Умный но тупой, именно это поистине неразрешимый человеческий парадокс.

Даже не читал. ИИ можно создать, создав точную копию мозга.

ученый в очередной раз изнасиловал журналиста

Хули тебе не нравится? Я тебе пересказал статью в двух словах, как ты решишь этот парадокс?

Ты шизу какую-то пересказал, которую тебе голоса нашептали, а не статью. Суть статьи (оригинальной в nature, а не этого говна в форбсе) в том, что математики нашли аналог проблеме остановки в каком-то кастрированном варианте машоба. Ну и хуй с ним, проблема остановки не привела программирование к карачуну.

Мне их выводы скорее очевидны были, не умаляя их заслуг как математиков.

>Оригинальной в nature

>А сам запостил хуйню с форбс

Тогда дальше

>We describe simple scenarios where learnability cannot be proved nor refuted using the standard axioms of mathematics

Этого её можно и не читать.

Одни необразованые безответственные говени написали статью на форбсе, другой её перепостил, третий пересказал и его назвали шизиком, да пошли вы нахуй просто.

Полегче, я ничего не постил, постил не я

пять минут послушал, ни хуя не понял, какой то стиль подачи материала как у торгаша

Ты какую-то бессвязную чушь написал, не имеющую смысла. У нас здесь не литературный кружок.

Он и есть торгаш. Как вы этого пидора не знаете, он же хуйню несёт уже сто лет.

Сеть из 2-3 полносвязных слоёв всегда запоминает треноровочную выборку (при условии, что количество нейронов в слоях не меньше размерности данных)? Я именно про запоминание, а не обучение, говорюниасилил даже это

Когда маняматики начинают хвелософствовать - явно проступает шиза. Считали бы свои производные и не выебывались.

Хочешь сказать, что нейронка не сможет запомнить несолько мегабайт белого шума?

>Сеть из 2-3 полносвязных слоёв всегда запоминает треноровочную выборку (при условии, что количество нейронов в слоях не меньше размерности данных)

Ну а как бы ты это вручную задизайнил?

Нужно взять входные данные, посчитать расстояние между ними и тренировочной выборкой. Найти у этой хуитки минимум (в смысле [0.1 0.4 0 5 10] превратить в [0 0 1 0 0]. Затем перемножить результат этого минимума с матрицей выходных данных.

То есть минимум получается уже в первом слое "размерность входных данных умножить на число тестовых примеров", а во втором слое - "размерность выходных данных умножить на число тестовых примеров".

На деле больше, ведь поиск расстояния нелинеен.

Надо знать что такое линейная регрессия, знать python и уметь умножать матрицы. Про матрицы я серьезно, без них нихуя не поймешь.

Какие задачи решаются ежедневно, какие крупные задачи на неделю, на месяц?

Какие инструменты регулярно используются?

Интересуюсь тк мне предложили вакансию по сабжу, хочу понимать что меня ждёт в случае успеха.

Датасайн работе с данными подобен. Задачи решаются, и на месяц и годец типичное задание преобразование данных в информацию полезную бизнесу и подобие работы выполнений сладостных. Инструментыы тоже имеются как и в любой пролетарской позиции рабочего места ибо и руки и голова используется постоянно. В случае успеха ждут горы золотца сверху базовых накоплений каких-то гнилых овощей.

Вот и генераторы текста подтянулись

Ага. На самом деле будете писать ботов для двача. Оплата бананами.

Ох бля, даже не знал про это, благодарю.

>по матану который реально нужен в Машобе

Eduard Zhopenzchmulzer

"Математика от теории к практике, ускоренный курс"

Звучит как по заказу. Спасибо.

Ещё такой вопрос, как лучше обучаться? В смысле следует ли по мере изучения делать какие-нибудь конспекты чтобы лучше запоминалось, или прочтения и решения задач хватит?

> Eduard Zhopenzchmulzer

> "Математика от теории к практике, ускоренный курс"

Бля, это был троллинг?

небось на винде сидишь?

10 Кб, 400x45

10 Кб, 400x45Единственное, что могу предположить, это раз они все зависимы, то зависимость от D передается y через theta. Но это не очень вяжется с формальными правилами.

61 Кб, 1498x494

61 Кб, 1498x494Да ну. Только сегодня ради прикола поставил на венду. Вроде работает. Единственное, на чём запнулся - нужны 64х-битный питон и nightly-версия

Двачую. Вообще мл на пятоне тот еще пердолинг. Лучше сразу на крестах вкатываться.

>Intel Software Developer Manual на столе во всей своей четырёхтомной красе

>распечатанный список AVX2-интринсиков (остальные ты и так помнишь наизусть) рядом

>vtune и IACA на втором мониторе

Итак, сегодня можно продолжить делать быстрейшую в мире кластеризацию синих выхухлей. Правда сегодня выяснилось, что нужно добавить ещё один параметр в модель, что изменит тонко подобранное расположение всего и вся в памяти и приведёт к ненужным L1-миссам, из-за чего добавится тактов 10-12 к каждой итерации цикла, что категорически недопустимо. Но ничего, за пару недель работы можно соптимизировать.

Архитектура уровня /b/.

Я просто думаю что много людей и крутых матфаков вкатываются, а на рынке не так много мест рабочих в датасаесе и машобе. Не получится ли так что все эти самоучки с левым образованием окажутся не у дел., а набирать будут только молодняк с топовым физмат образованием?

> А есть тут анон, желающий вместе со мной написать говорилку под Android?

Гугл TTS чем плох? Маловероятно, что ты сделаешь лучше. Говорилка не помешала бы на пекарню, ибо лучшее что есть - alyona rabotaet hrenova из 2008 года.

>>27920

> Погодьте, но ведь насколько я понимаю теорема Арнольда утверждает что любую функцию можно аппроксимировать нейронкой

Эта теорема вообще не про нейронки. А про то, что любая функция от многих аргументов аппроксимируется суперпозицией функций от 2х аргументов. Что в том числе служит объяснением как вообще они работают.

> Это не значит что мы можем взять какую-то сетку, какие-то стандартные активационные функции и надеяться что случайно взятую функцию мы можем так представить.

Все зависит от того, что за функция. Если функция представима в виде полного степенного полинома VKG (Вольтерры- Колмогорова -Габора), то она всегда представима в виде т.н полиномов Ивахненко. И так далее.

>>27945

С мамкой твоей ознакомился, хуета какая-то.

Зачем тогда все это говно учить - только время терять просто так, все равно устроятся на работу малая часть людей, пару процентов от 100, остальные так и будут годами что-то вяло ковырять.

Нихуя ты прозрел, бротиш)

Родиться в богатой семье.

> На жизнь то надо как то зарабатывать. Твои предложения как?

Т.е ты не знаешь как заработать на жизнь без машобчика?

>Правда могут взять левых людей кто прошел курсы, а работал скажем технологом на заводе, или там иненером в машиностроении, или например геодезистом, или залупологом

Все не так. Работаешь на заводе, вдруг в соседнем отделе внезапно возникает датасаенс-задача, которых, вообще-то дохуя. И у завода есть два стула, искать хуя с горы за 300к в секунду (и завод скорее всего просто забьет и посадит тетю Машу ковырять говно в ручную), или сказать толковому васе-залуплогу, мол, вася, есть такая задача.

А васю заебало работать залупологом, он берет, импортирует слесарьплов и решает задачу.

Хотя курсы, конечно, хуйня. Все упирается в твой интеллект.

>Я просто думаю что много людей и крутых матфаков вкатываются

На матфаках до сих пор учат как проектировать ракеты с технологиями 70-х годов. Люди оттуда куда только не вкатываются, в финансы те же и даже во фронтэнд. Инфа 100%, у меня тян с матфака и я смотрю на ее круг общения, ничего особенного в плане работы там нет. Понятно, что через 5 лет будет, но это потому что люди сами по себе не тупые, а не из-за образования.

Я другой аноним, я в Мухосрани живу, знаю двух пацанов, которые очень сильно математикой увлекались. Оба нейронки и машинное обучение задрачивали, но в Мухосрани таких вакансий нет. Оба пошли в МухГУ и стали диссертации писать по машинному обучению. А на жизнь зарабатывают так: один бухгалтерские расчеты делает в зашкварной по меркам итт this этого данного треда в 1С-ке. А другой армию дитачек учит ЕГЭ на 100 баллов задрачивать. Такие дела епта, бля! Понял нет!

Ладно, я шучу, но примеры ИРЛ из жизни, как она есть. Шутка, это плохие примеры, не слушай меня. Слушай себя.

Я из Зимбабы, ты че сука, че то против Зимбабы имеешь? Я пацанов математиков позову, они тебя вычислят.

Я сравнил Зимбабве с российской мухосранью, но ты прав, это слишком для Зимбабве, сорян.

мехмат, вмк, физфак, бауманка, вышка

Везде единичные примеры - я не буду пиздеть о том, что у меня охуенный круг общения в 200 человек, но тем не менее.

Вышка исключение, кстати, но человек оттуда тоже страдает какой-то хуйней типа репетиторства.

>круг общения в 200 человек

>мехмат, вмк, физфак, бауманка

В Мак Дональдсе на тимбилдинге познакомились?

Каким нахуй клиентом, маня. Я не знаю, кем нужно быть, чтобы прочитать фразу "я не буду пиздеть о том, что у меня охуенный круг общения в 200 человек", будто бы у меня круг общения в 200 человек. Это совсем дауном нужно быть. С такой способностью читать ты не то, что моим клиентом не будешь, я тебя в магазин за хлебом не пущу - ты неправильно прочитаешь список покупок и купишь вместо хлеба дилдак, потому что хлеб на букву х начинается.

>производная

жидовские выдумки НЕНУЖНЫ

>постеронию

Мемология это важнейшая из наук в 2к!9 году.

а вроде вчера мылся

>производная понять

Открыл гугл, прочетал и решил нужную задачу, а не 5 лет задрачивать никому не нужное говно.

тут никого нет кроме школьников-неосиляторов, усердно троллящих друг друга

Так как я нищук, то ноутбука у меня нет. Подскажите, пожалуйста, существуют ли кафе или еще какие-то заведения, где можно засесть и на три часа арендовать ноутбук?

Здесь кто-нибудь пытался найти работу/нашел работу в области компьютерного зрения?

Действительно ли нужно быть выпускником мехмата, чтобы твое резюме хотя бы прочитали? Слышал, что в датасаенсе такое часто бывает, особенно в москве, где полно выпускников разных мгу/мфти/вшэ.

Квартира хоть есть? Купи пеку десятилетней давности за тысячу рублей

То есть вместо классической схемы

Повторить 5 раз:

----Поврежденная инфа = округлить(поврежденное инфа веса)

У меня вышло

Повторить 5 раз:

----Поврежденная инфа = поврежденная инфа веса

Поврежденная инфа = округлить(поврежденная инфа)

Короче пытался переписать правильно, ведь по сути она же должна шагами двигаться, каждый раз получая новую репрезентацию активации нейронов как все описывают в лекциях на эту тему, а не умножать все по пять раз подряд, ток в конце получая результат. Но в другом случае нейросеть просто оказывается необучаема. Округления посередине мешают. В чем проблема? Может я что-то не понимаю? Описывается всеми почему-то именно так в теории, что на практике мы должны округлять каждый наш шаг и доводить до -1 либо 1, хотя тут уже и я засомневался. Хочу понять саму суть почему все именно так происходит.

Сука, разметка знаки проебала

То есть вместо классической схемы

Повторить 5 раз:

----Поврежденная инфа = округлить(поврежденная инфа УМНОЖИТЬ НА веса)

У меня вышло

Повторить 5 раз:

----Поврежденная инфа = поврежденная инфа УМНОЖИТЬ НА веса

Поврежденная инфа = округлить(поврежденная инфа)

Бамп

Где можно прочесть про Validation, Estimate, Evaluate, чтоб стало точно понятно, чем они друг от друга отличаются?

пк бывают в библиотеках и учебных заведениях. В ДС есть коворкинги. Если есть планшет, то можно купить к нему клавиатуру (можно даже и без клавиатуры) и выучить забесплатно весь машоб на http://colab.research.google.com/ или на том же kaggle.com

В OpenDataScience слаке есть подобный канал

Все упрётся в проблему троутинга, если глубина перцептрона окажется слишком большой, то он просто разорвёт твои узкие слои, после придется ходить к проктологу и зашивать твои разреженные матрицы.

Больше трех слоев мало смысла из-за vanishing gradients. Нужно хотя бы residual связи делать.

помогите, плез, слоупку

уровень IQ и ангельского не позволяют понять одну из частей работы

http://rodrigob.github.io/documents/2014_eccv_face_detection_with_supplementary_material.pdf

http://videolectures.net/eccv2014_mathias_face_detection/

просто нихуя не одупляю benchmark issues и решения этих проблем

можете пожалуйста разжевать кто нибудь, что они делают с датасетами, чтобы они подходили для сравнения разных детекторов, а то я совсем даун

ну извини, было бы на русском, я бы сюда не писал (

Правильно ли я понимаю, что ты хочешь, чтобы кто-то потратил час своей жизни на то, чтобы ответить на твой вопрос?

на видео 4 минуты по интересующему меня вопросу, так что сомневаюсь, что человек с нормальным знанием английского потратит на это час своей жизни

Видео 18 минут. Короче, пишу прямо: ты долбоеб и ленивое чмо, которое даже нормально задать вопрос не может.

Нормально было бы сказать конкретный таймлайн сразу.

У тебя нихуя в машобе не выйдет, потому что человек, который даже вопрос задать не может, не имеет достаточно интеллекта, чтобы заниматься этим.

ебать мой хуй, сколько категоричности, не написал таймлайн, в 18 минутном видео, где интересующая тема начинается с 28 блять секунды, сам не понял что спросили, а я долбоеб и нихуя у меня не выйдет

не пиши больше, с тобой все ясно

>ебать мой хуй, сколько категоричности, не написал таймлайн, в 18 минутном видео, где интересующая тема начинается с 28 блять секунды

И как я должен был это узнать? Ты совсем аутист ебаный что ли.

>сам не понял что спросили

Я понял, что спросили - открыть две ссылки, просмотреть их целиком, чтобы найти benchmark issues, и потом разржевать тебе это.

В этих 4-х минутах говорится о том,

1. В популярных датасетах криво размечены данные, в итоге методы, которые работают верно, оцениваются неверно. Например, если алгоритм выдает квадрат лица чуть больше, чем размеченный в датасете, это будет считаться false positive. Некоторые лица не размечены вовсе - а значит правильно работающий алгоритм будет оценен как false positive

2. В разных датасетах разные прямоугольники считаются лицом - кто-то отмечает лицо целиком, а которо только глаза и рот. Кто-то игнорирует лица начиная с какого-то размера, а кто-то с другого размера, в итоге для разных датасетов нужно настраивать алгоритм на игнор разных лиц. Это все приводит к тому, что алгоритм, тренированный на одном датасете, на другом работает, как его учили, а не так, как считает тот, кто размечал датасет.

На этом 4 минуты закончились.

Как решение, они переразметили датасеты, чтобы они подчинялись одной логике в плане того, что считать лицом, и имели меньше ошибок. Ломающие новости, оказывается, в машобе самое важное - качество датасета.

В целом это все типичное научное каглодрочерство - наши алгоритмы сосут (а они правда сосали до нейронок), поэтому мы переразметим датасеты так, чтобы они выглядели получше.

Доклад 2014 года и без нейроночек, в нем полезной информации для 2019 минимум. Нейроночкам похуй на этот датасетодроч, они на любом криво размеченном говне тренируются, главное, чтобы этого говна побольше было. Хочешь разобраться, читай cs231n и про детекторы YOLO, SSD, не хочешь - бери MobileNetSSD или что-то подобное и используй. На подобную хуйню время не трать.

>>34054

В оригинальном вопросе нет никакого видео. Там две ссылки в стиле "ебись, анон, как хочешь, я ведь нихуя не одупляю".

>ебать мой хуй, сколько категоричности, не написал таймлайн, в 18 минутном видео, где интересующая тема начинается с 28 блять секунды

И как я должен был это узнать? Ты совсем аутист ебаный что ли.

>сам не понял что спросили

Я понял, что спросили - открыть две ссылки, просмотреть их целиком, чтобы найти benchmark issues, и потом разржевать тебе это.

В этих 4-х минутах говорится о том,

1. В популярных датасетах криво размечены данные, в итоге методы, которые работают верно, оцениваются неверно. Например, если алгоритм выдает квадрат лица чуть больше, чем размеченный в датасете, это будет считаться false positive. Некоторые лица не размечены вовсе - а значит правильно работающий алгоритм будет оценен как false positive

2. В разных датасетах разные прямоугольники считаются лицом - кто-то отмечает лицо целиком, а которо только глаза и рот. Кто-то игнорирует лица начиная с какого-то размера, а кто-то с другого размера, в итоге для разных датасетов нужно настраивать алгоритм на игнор разных лиц. Это все приводит к тому, что алгоритм, тренированный на одном датасете, на другом работает, как его учили, а не так, как считает тот, кто размечал датасет.

На этом 4 минуты закончились.

Как решение, они переразметили датасеты, чтобы они подчинялись одной логике в плане того, что считать лицом, и имели меньше ошибок. Ломающие новости, оказывается, в машобе самое важное - качество датасета.

В целом это все типичное научное каглодрочерство - наши алгоритмы сосут (а они правда сосали до нейронок), поэтому мы переразметим датасеты так, чтобы они выглядели получше.

Доклад 2014 года и без нейроночек, в нем полезной информации для 2019 минимум. Нейроночкам похуй на этот датасетодроч, они на любом криво размеченном говне тренируются, главное, чтобы этого говна побольше было. Хочешь разобраться, читай cs231n и про детекторы YOLO, SSD, не хочешь - бери MobileNetSSD или что-то подобное и используй. На подобную хуйню время не трать.

>>34054

В оригинальном вопросе нет никакого видео. Там две ссылки в стиле "ебись, анон, как хочешь, я ведь нихуя не одупляю".

И еще вопрос - умеет ли Keras в ускорение GPU или нужны какие-то tensorflow команды написать, чтобы использовать ускорение на GPU?

Если что использую для запуска программ Google Colaboratory

> Так я не понял. Keras все таки по умолчанию использует ускорение на GPU. Или там надо команды писать типа "зе программа юзай Графический процессор"!

Керас это надстройка над слесарьпловом (и не только). Логично предположить, что использование видюхи зависит от конкретной установки слесарьплова, если он у тебя в ГПУ версии, то и через керас будет использоваться видюха.

Не знаю, это же не моя пека, а Google Colaboratory. Я могу там только галочку поставить в настройках GPU Acceleration. А так я не очень понимаю как там все устроено.

То есть если там последняя версия Keras, то оно по умолчанию может использовать GPU Acceleration?

Блять, выучи что такое ванишинг градиент сначала.

>>33864

Он может быть лучше, но врядли будет. Однослойный перцептрон на самом деле почти ничего не может, но и пецептрон со сколько угодно слоями тоже не сможет, если у него слои эти узкие, так как просто вектор слишком маленький будет для передачи информации. Да и вообще если ты расширяешь свою сеть, то готовься к андерфиттингу.

>проблема оказалась в понимании реализации градиентного спуска для нейросети Хопфильда с помощью Tensorflow

В голос с тебя.

>Блять, выучи что такое ванишинг градиент сначала.

Это ровно то, что я описал, пидор ты ебаный.

>Да и вообще если ты расширяешь свою сеть, то готовься к андерфиттингу.

При усложнении модели нужно готовиться к андерфитингу? Вопросов больше не имею

Спасибо большое, надеюсь это поможет понять про GPU.

71 Кб, 973x347

71 Кб, 973x347CPU: 0

XLA_CPU: 0

Скажите, пожалуйста, это один и тот же CPU или это два разных CPU?

> Скажите, пожалуйста, это один и тот же CPU или это два разных CPU?

Один и тот же, там же написано цпу0.

Ок, спасибо, а как понять, что такое XLA_CPU:0 - как понять, что это за эфирная субстанция? Почему он напечатан отдельной строкой от CPU:0?

Ну, то есть я загуглил, что такое XLA (Accelerated Linear Algebra). Но я не понял насчет CPU:0 и XLA_CPU:0. Если это один и тот же CPU, а не два разных, то почему он не называется одним названием, например, XLA_CPU:0. Хочу узнать - почему же у него два названия?

2,8 Мб, 3000x889

2,8 Мб, 3000x889Бля, больна

Как проходит типовой рабочий день?

Какие задачи решаются ежедневно?

Какие задачи на неделю, на месяц, какие долгосрочные задачи?

Кто ставит задачи и кто контролирует качество выполнения?

хочу заранее знать что меня жлёт

https://youtu.be/RviskFqwF3M

Мб этот курс, тут некоторые лекции как раз тянучки ведут (даже 2)

149 Кб, 279x392

149 Кб, 279x392Нейробратушка

Почему нейроговноеды даже графики не удосужились перевести?

Понятно что ты не расскажешь. Я практикующих датасайнтистов спрашивал, а не школьников.

Ну хз, лицо широковато слегка, но зато голова в целом большая, лоб прямой и высокий да цефальный индекс отличный

Ну это увеличивает вероятность наличия высокого интеллекта

548 Кб, 1595x962

548 Кб, 1595x962Я прошел на stepic.org курсы по pyhton и по нейронным сетям. Там они все время говорят биоинформатика - то биоинформатика - се. Короче, все время за биоинформатику топят.

И мне стало интересно, скажите, пожалуйста, а эти хваленные программисты-биоинформатики, они только матстатистику, машинное обучение знают или они еще и в медицину углубляются и шарят в генетике и вычислениях протеинов? Или только ученые-медики шарят в генетике и вычислениях протеинов, а программисты-биоинформатики только лишь технически работают с данными, не заморачиваясь с пониманием биологии, химии, генетики и вычисления протеинов?

>как ты

Ты зенки бы продрал. Повторяю для тех, кто не умеет читать и не прошел начальную школу. Я не занимаюсь нейронными сетями, я лишь нашел тред и задал вопрос.

Все таки какое-то знание у них должно быть. Не поверхностное, но и не очень глубокое. Обычно с ними вместе работают тру-биологи.

Проще привыкнуть и лечь под тензорфлоу.

Погуглил. Как я понял всё из-за активационных функций, производная слишком ограниченная. Почему нельзя просто нормальных функций взять?

> АХАХА ПЕДОРАШКА ТУПАЯ НУ КОКОЙ ЕЩЁ ЦЕФРОВОЙ ГУЛАГ ПРОИГРАЛ С ПАДЛИВАЙ ИДИ ШАПОЧКУ ИЗ ФАЛЬГИ НАДЕНЬ ПОСМОТРИ ЛУЧШИ КАКОГОНИБУДЬ НАУЧПОПА СТОТЕЕК ИЗ АРХИВА ПАЧЕТАЙ

https://en.wikipedia.org/wiki/Social_Credit_System

Ну в комиксе не взяли, в этом и юмор.

А так - каких, например? ReLU имеет в 2 раза меньше насыщений, но ровно одно (для x<0). Вот и попробуй придумать монотонную функцию без насыщений, которая при этом не y=x (линейная нам не подходит).

Не монотонная

Для этого достаточно residual связей. 152 слоя как раз за счет этого - градиент не vanish'ится, потому что по skip-коннекшону идет до самого верха. Сообществу потребовалось больше 30 лет, чтобы дойти до такой простой идеи.

Если слово residual тебе не понятно (а я не знаю как сказать по-русски), то вместо

y = f(x)

используется

y = x + f(x)

И тебе похуй, ванишится ли градиент у f, потому что x идет напрямую.

Из-за того, что нейросеть уменьшает пространственное разрешение информации, скипнуть информацию со входа проблематично (не y=x+f(x), а y = downscale(x) + f(x)) , нужно все равно уменьшать разрешение, поэтому информация все равно теряется, но не так сильно, как в случае активационных функций.

>>37842

>А почему вообще стаканье слоёв работает?

Каждый слой нелинейно преобразует пространство - растягивает его, сжимает и делает прочие вещи.

Стаканье позволяет описывать многократно более сложные преобразования.

Конечная цель классификатора преобразовать инфу в такое состояние, что твоя проблема становится линейной. Естественно, чем больше слоев, тем больше шансов этого добиться. Если точнее, то более глубокая сеть экспоненциально эффективнее неглубокой сети с меньшим числом слоев. Не помню, где я это прочитал, но может пользоваться такой эвристикой.

>Каждый слой нелинейно преобразует пространство - растягивает его, сжимает и делает прочие вещи.

>Стаканье позволяет описывать многократно более сложные преобразования.

Хм, но получается что организация сети по слоям предполагает что у фич одинаковая "нелинейная сложность" в модели. Что совсем необязательно так.

наслаивание, от слова stack

Разверни мысль, пока ты написал какую-то хуйню

94 Кб, 1600x420

94 Кб, 1600x420Хороший вопрос.

Чтобы ответить на него, смотри пикрелейтед. RNN, если подать на нее постоянный во времени сигнал и развернуть - это по сути та же feedforward сеть с residual связями, но с общими параметрами у слоев.

Мозг - RNN. Там мало слоев, например, в визуальной коре их всего 6, но каждый слой имеет обратную связь с предыдущими. И эти образные связи скорее всего и делают его глубоким - он глубокий во времени.

Вкупе с тем, что он еще и очень широкий, в каждом слое нейронов очень много, получается очень мощная штука.

Тогда уж тренеры

опыт

Correct me if I'm wrong.

Не только. В RNN хорошо видно, что оно из-за собственных значений возникает (см. cs231n).

Учитывая что на русском нет нормальных книг по статистике и мл, то у тебя нет выбора.

Как будто это что то плохое.

111 Кб, 1024x685

111 Кб, 1024x685>что же ты такое?

Первый в очереди потребитель, жду когда мне ИИ зделают как в фильмах, а у вас пока одни смешнючие названия.

171 Кб, 700x703

171 Кб, 700x703Так, вы тут умные типа и бугуртите когда вас теоретиками обзывают, вот вам задача:

нужно бистро-бистро сравнить джве картинки на схожесть, причем сравниваемая картинка имеет меньший размер и может содержать незначительные помехи (не такой пиздец как в капче, но все же) и отличаться в цвете.

Кокие ваши действия?

Что-то такое

https://medium.com/machine-learning-world/feature-extraction-and-similar-image-search-with-opencv-for-newbies-3c59796bf774

стандартный путь.

В качестве фичедетектора можно и нейронку въебать.

А можно просто отмасштабировать 2 изображения и посчитать евклидову норму между ними, например.

Возьму какую-нибудь VGG-19, прогоню обе картинки через неё и активации в верхних слоях буду использовать, как эмбеддинг ентих картинок. Дальше смотришь евклидову дистанцию между ними, у похожих картинок должна быть небольшая. Только надо поэкспериментировать, из какого слоя активации брать

77 Кб, 922x993

77 Кб, 922x993Есть 9 сортов удобрений. Х1...Х9 - это количество добавленного в яблоню удобрения каждого из 9 сортов.

Y1 - это средний размер итоговых яблок с яблони

Y2 - это средняя вкусность итоговых яблок с яблони

Y3 - это средняя калорийность итоговых яблок с яблони

Для восстановления регрессии нужно применить нейронную сеть.

Скажите, пожалуйста, как правильнее сделать? Три отдельные нейронные сети для предсказания по Х1...Х9 по отдельности Y1,Y2, Y3.

Или правильнее сделать одну нейросеть, которая имеет три выхода и оптом предсказать Y1,Y2,Y3?

648 Кб, 900x900

648 Кб, 900x900Хуя олд.

Благодарю, спасибо

Пошёл нахуй или отвечай по существу. Я не спрашивал, хороши ли они, многому ли я научусь и так далее, твоё ебаное мнение мне вообще не интересно. Мне интересен один блядский факт: покрывает ли каггл курсэру?

MLE можно рассматривать как MAP при условии, что априорное распределение параметров - равномерное. Соответственно, MAP применяется, если есть априорное распределение, MLE - если его нет.

Посчитаю какой-нибудь специальный хэш для картинокч и буду сравнивать хэши

Токенизация по словам, удалить повторы и использовать стемминг. Хз как в Эр, в питоне NLTK библиотека, с русским вроде ок работает

поэтому вот все русские камьюнити - говно. Вместо того чтобы помогать тупо высмеювают.

Ты просто никчёмный хуесос.