Вы видите копию треда, сохраненную 7 октября 2019 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

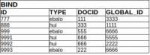

39 Кб, 801x251

39 Кб, 801x251Анализируем планы запросов,

Поясняем, какой из гигантов СУБД лучше: MySql или SqLite.

Ну а теперь серьезно:

Базы данных: реляционные и объектные/документные

Хранилища данных и BI

ETL

Хадуп и бигдата

В этои IT ИТТ тредю

поясняем за специальности, в которые можно вкатиться в сфере СУБД

обсуждаем скиллы, которые нужно подтягивать новичкам

* составляем базу необходимых знаний на гитхабе

Сущности называются единственным числом.

Тем более, что множественное число ты все равно не умеешь образовывать.

Ты долго ебашил спайсы чтобы додуматься хранить билеты и поезд не в таблице билетов, а в таблице пассажиров?

> скиллы, которые нужно подтягивать новичкам

sql, основы реляционных бд, python(опционально)

>поясняем за специальности, в которые можно вкатиться в сфере СУБД

на hh можно посмотреть

(и там же знания необходимые для нюфагов)

тошо он изначально заточен под анализ данных, а путон вкатился в эту нишу не пойми каким боком

Я тоже читаю ин-фу от наших предков. Нам всем базачём нужно составить вопросы и создать там тред.

тебе не нужно их анализировать тебе нужно их обрабатывать и складывать

(маня ты не дата саентист! проснись!)

Что там по книгам/ресурсам по которым можно освоить работу с каким-нибудь постгре и научиться sql, чтобы на собеседование стыдно не было?

википедия

я серьезно, че

Postgre

У Оракла в документации до хуя есть.

Concepts, например, если я не путаю.

У Постгре тоже в документацию втыкай.

бамп

ну джойны почитай

дальше индексы

возможно cte, оконные функции

опционально процедуры/функции/вью

>базовые знания запросов sql

CREATE, REMOVE, UPDATE, DELETE (CRUD), что еще нужно для счастья?

join?

Для начала нужно все-таки разобраться, что означает буква R

А то ты и так на умного не похож, а своими высерами окончательно всех убеждаешь в том, что ты даун

unmake есть в толковом словаре

https://www.merriam-webster.com/dictionary/unmake

uninsert нет

>>08074

нахуй пошел, тебе наверное понравится

на sql-ex

Бля, я думал, тут умные-остроумные собрались.

А тут ебанат в словарь полез.

Бля, я думал, программист понимает, что можно что-то новое создать.

А тут ебанат только готовыми шаблонами из словаря готов пользоваться.

Пиздец, вообще. Закрывайте на хуй программач.

>программач

Какой нахуй программач, юродивый, это же /зк

Или в лучшем случае /prrrrrrrrrrrrrrrrr

Живи с этим.

>Какой нахуй программач, юродивый, это же /зк

он дома расскажет друзьям и невесте как он подстрелил двух /зк ?

Есть одна должность которая маячит в банке.

Собес на следующей неделе, есть время подготовится.

Написали из требование только:

Ожидаемый опыт:

- Знания Oracle SQL, PL/SQL

- Понимание принципов разработки OLTP систем

- Умение разобраться в чужом коде

- Умение отлаживать код

- Умение работать с документами

>Знания Oracle SQL, PL/SQL

Про это расскажу думаю. Спросят поди про синтаксис, основные конструкции. Индексы, партиции, план такое говно.

>Понимание принципов разработки OLTP систем

Что тут хотят от меня? Ну индексы не вешать чтобы вставка была быстрее, ну sql аналитику не крутить на oltp базах, что еще тут рассказать?

Ну вот про партиции и расскажи, как бы ты транзакционную табличку партиционировал, например, чтобы база через пару лет не подохла от миллиардов записей. Олсо, можно спиздануть, что - нахуй форейн кеи, потому что они только тормозят производительность, но если ребята с таким не сталкивались, то могут и не оценить.

1,5 Мб, 959x960

1,5 Мб, 959x960C# + Entity Framework

обучающих статей на MSDN должно хватить для простейшего круда. алсо EF имеет провайдеры для множества базочек, под капотом можешь хоть SQLite заюзать

Деньги вы получили, но при выборе средств разработки вы столкнулись с альтернативой. Продукт вы можете реализовать, используя три СУБД:

1) Oracle

2) MS SQl

3) Postgress

Есть ли хоть какая-нибудь статья, которая ОБЪЕКТИВНО сравнивает эти три СУБД?

оракл - неубиваемая хуйня для миллиарда транзакций в секунду. требует, возможно, дорогих девелоперов

мс - оракл на минималках. выбор хорош если нужны какие-то решения из коробки и не хочется их девелопить с нуля

постгре - опенсурс и этим все сказано

1) Oracle

Дорого. Нужен как минимум один DBA. Отточенная

железобетонная отказоустойчивость при верной настройке. Куча плюх и пердолек, которые позволяют эффективно управлять СУБД и данными. Есть встроенный язык PL/SQL - процедуры/функции. Есть поддержка и подробная документация. Если если пятизначные цифры в $ на лицензирования не страшны - это однозначно твой выбор. Идеально подходит банкам или крупному ритейлу для OLTP/OLAP.

2) MS SQl

Дорого поделить на джва, если сравнивать с Ораклом. Развертывается на шиндовс сервере. По плюхам почти как оракле. Есть встроенный язык T-SQL - процедуры/функции. Ниже по производительности и отказоустойчивости. Поддержка сообщества подробная почти как у Оркала. Механизмы репликации отсасывают у Оракла. Подходит сторонним подразделениям банков, мелкому ритейлу и крутить 1С. Прекрасно крутит OLAP. При правильных админах и разрабах можно крутить OLTP.

3) Postgress

Если будешь использовать в интерпрайзе то нормальная поддержка все равно за бабки. В последних версиях есть процедуры и функции. Спецов найти сложнее для администрирования. Поддержка сообщества слабее, чем у ребят выше. Может крутить мелкую хуету типа телефонии, сайтов, логи, мониторинг. Есть единичные мазохисты которые крутят это в серьезном Энтерпрайзе.

ИМХО за 3,5 года с БД

Абстрактная задача с собеса:

Есть система, отвечающая за раздачу транспорта на предприятии. Известно, что пользователи на предприятии имеют доступ к приложению, с которого могут заказать транспорт. При заказе транспорта пользователи указывают число, на которое желают взять транспорт, а также предполагаемую дату возвращения транспорта в автопарк. Пользователи могут отменять заказ машины и она снова может становиться свободной.

У меня проблема вот с чем, пишу клиентскую часть, и не могу понять - как правильно написать запрос к БД, чтобы результат выдачи показывал только те ID'шники машин, которые могут быть заказаны на сегодняшнее число.

Без структуры таблиц сделать это сложно.

Я так понимаю, у машины есть атрибут типа свободно/занято. Если занято, то скорее всего можно сделать джоин к тому за кем занято-на какую дату.

table.Car // Машина

{

int id;

driver_id; // Кто водитель;

nvarchar type; // Тип (груз, легковушка);

nvarchar mark. // Марка.

}

table.Order // Заказы

{

int id;

int car_id; // Машина;

int client_id; // Кто заказал;

date orderDate; // Дата заказа;

date returnDate. // Дата возврата в автопарк.

}

Связь: 1 - TO - MANY (1 Car - Many Orders), T-SQL;

Я пробовал в структуру машины добавить булевое "Свободна/Занята", но не догнал как это можно с пользой использовать.

В шарповском треде мне кое-где подсказали, но что-то так и не понял как с умом использовать. Суть в том, что я через запрос могу вывести те машины в диапазоне того времени, когда они заняты. А мне бы этот запрос отреверсить как-нибудь, чтобы видеть внешние диапазоны, когда машина доступна для заказа.

Запрос на внутренний диапазон:

SELECT [Order].car_id

FROM [Order]

WHERE orderDate <= @currentDate AND returnDate > @currentDate;

А мне бы наоборот, выводить те машины, которые свободны, а не заняты.

Небольшой примерчик:

3 машины - 3 заказа;

1) Машина№1 - с 01.06.2019 по 07.06.2019;

2) Машина№2 - с 05.06.2019 по 10.06.2019;

3) Машина№3 - с 31.05.2019 по 05.06.2019;

Точкой отсчета в запросе я беру, сегодняшний день - 01.06.2019.

Следовательно, по запросу мне машина №2 должна быть доступна с сегодняшнего числа по 04 (или 05, хотя в собесе не сказано, что машина может быть заказана и возвращена в тот же день).

table.Car // Машина

{

int id;

driver_id; // Кто водитель;

nvarchar type; // Тип (груз, легковушка);

nvarchar mark. // Марка.

}

table.Order // Заказы

{

int id;

int car_id; // Машина;

int client_id; // Кто заказал;

date orderDate; // Дата заказа;

date returnDate. // Дата возврата в автопарк.

}

Связь: 1 - TO - MANY (1 Car - Many Orders), T-SQL;

Я пробовал в структуру машины добавить булевое "Свободна/Занята", но не догнал как это можно с пользой использовать.

В шарповском треде мне кое-где подсказали, но что-то так и не понял как с умом использовать. Суть в том, что я через запрос могу вывести те машины в диапазоне того времени, когда они заняты. А мне бы этот запрос отреверсить как-нибудь, чтобы видеть внешние диапазоны, когда машина доступна для заказа.

Запрос на внутренний диапазон:

SELECT [Order].car_id

FROM [Order]

WHERE orderDate <= @currentDate AND returnDate > @currentDate;

А мне бы наоборот, выводить те машины, которые свободны, а не заняты.

Небольшой примерчик:

3 машины - 3 заказа;

1) Машина№1 - с 01.06.2019 по 07.06.2019;

2) Машина№2 - с 05.06.2019 по 10.06.2019;

3) Машина№3 - с 31.05.2019 по 05.06.2019;

Точкой отсчета в запросе я беру, сегодняшний день - 01.06.2019.

Следовательно, по запросу мне машина №2 должна быть доступна с сегодняшнего числа по 04 (или 05, хотя в собесе не сказано, что машина может быть заказана и возвращена в тот же день).

Наврал, SQLite у меня, а не T-SQL. Прошу прощения!

29 Кб, 647x527

29 Кб, 647x527SQL Developer, Erwin, UML.

Наслышан про схему, когда вместо offset'ов используются page_token'ы (потому что оффсеты медленные на больших таблицах).

Как мне объясняли, page_token'ы делаются по какой-то хитрой схеме через where, но я тупой и у меня не получается нагуглить это самостоятельно.

Подскажите, как вообще это делается?

Я вижу это так, что когда у меня запрашивают N-ю страницу, я беру оттуда id последней строки (у меня это uuid, но по тдее не важно) и возвращаю в качестве page_token'а, соответственно на N+1 страницу мне передают этот самый токен и я делаю запрос вида "дай мне 10 строк после строки у которой id=page_token", но я хз, как это сформулировать в виде запроса.

Сортировать по id'ам и говорить where id > page_token не вариант, потому что это отсортирует строки по дате создания (а у меня другие правила сортировки).

Вопрос сложный, только для настоящих программистов, так что с меня утроенное количество сотен нефти.

ORM'ом или SQL - мне лишь бы понять суть.

И, если не затруднит, подскажите литературу, где подобные случаи разбирают/рассматривают.

https://pastebin.com/WWjstCU3

в общем задача звучит как Gaps and Islands. но с наскоку гуглить может быть непонятно

я попробовал сгруппировать по машиносу и вывести MIN/MAX свободная дата, но так делать неправильно ибо все промежуточные занятые даты будут пропущено. я ебал делать еще одно CTE, для начала сойдет (если я вообще правильно понял суть). путем самопердолинга можно довести запрос до нужного

Премного благодарен, подскажите пожалуйста ещё что-нибудь по подобным задачам, где можно какие-то материалы почитать, хотелось бы найти что-нибудь для обучения на реальных примерах, без абстрактных задач.

лично я не учился на каких-то примерах. все - это либо задания с собесов, либо реальные кейсы, либо что-то случайно нагугленное

81 Кб, 681x527

81 Кб, 681x527На ютабе решается установкой других версий коннектов.Но у меня проблема не решается, двач помоги.

Можно ли за пару месяцев нахвататься, чтобы взяли на самую простенькую вакансию релейтед?

После 3 месяцев на sql-ex.ru 100к дают же

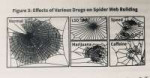

49 Кб, 634x501

49 Кб, 634x501 2 Кб, 482x146

2 Кб, 482x146разделять parameter и value тебе нужно ибо значения параметров имеют фиксированный сет значений?

если бы проще, то как на пике

а вообще и из твоего поделия можно сочинить более-менее вменяемый запрос, правда за охуительное количество джоинов оптимизатор тебе спасибо не скажет

>значения параметров имеют фиксированный сет значений?

Да. С точки зрения оптимизации было бы заебись параметры в столбцы выносить, как раньше и было, но я устал каждый раз код править добавляя новый параметр, поэтому решил сделать их динамическое создание через админку. И встрял.

поколоночное хранение подобных данных - это либо сознательная денормализация ради убийственного перфоманса, либо топкекрофл

так что не получается?

select t.id as item_id, p.id as parameter_id, v.id as value_id

from item u

join item_value iv on i.id = iv.item_id

join value v on v.id = iv.value_id

join parameter p on p.id = v.parameter_id

where p.id = 1

and v.id = 3

and p.id = 3

and v.id = 5

Такой запрос работать не будет. Нужно выбрать одновременно несколько параметров и несколько значений.

Хочу выбрать айтемы, у которых: параметр "цвет" = значение "зеленый", параметр "размер" = значение "маленький" и т.д. Количество параметров в запросе может быть разным, но я это в коде сделать смогу.

чет я сам не подрасчитал сложноту задачи

https://pastebin.com/wDAvZuj5

не думаю, что такое решение имеет право на существование, но, справедливости ради, оно работает как ты хочешь лол)

я юзаю SQL Server-ный диалект, полагаю, все подобное поддерживается всеми стандартными базами

в T/SQL мне не хватает шарповского "выбрать строки, у которых встречаются все значения из подможества".

еще как вариант делать каскадную фильтрацию, типа:

- выбрать все айтемы

-- отфильтровать, у которых "цвет" не "розовый/зеленый"

--- отфильтровать, у которых "размер" не "маленький"

но подобное на SQL реализовывать занятие так себе. разве что генерить запрос в коде и на верочку отправлять его в базу

Мощно. Буду пробовать, спасибо тебе.

Если я правильно понял у меня получается модель EAV, которая часто во всяких интернет-магазинах встречается.

Я прост не понимаю как разница у них будет выглядеть

1. Быстро выбирать все поддерево для указанной ноды.

2. Быстро перемещать поддерево к другому родителю.

То что нагуглил: с первым хорошо справляется nested sets, со вторым adjacency list. Materialized paths - вообще непонятно зачем нужное говно.

Накидайте идей как хранить в БД древовидную структуру, так чтобы усидеть на двух рекваиментах? Может скомбинировать как, или materialized paths спасут меня?

Какая база-то?

Оракл умеет нормально выбирать деревья/поддеревья

Постгре, вроде, тоже.

parent_id -> id

Хули сложного?

Не, конечно, если у тебя МуСКЛ, то просто иди на хуй.

А если ты еще не решил, какая у тебя база, то бывают, внезапно ГРАФОВЫЕ БД

Типа https://neo4j.com/

>но подобное на SQL реализовывать занятие так себе. разве что генерить запрос в коде

>генерить запрос в коде

Внезапно, это единственно правильное решение

внезапно, это решение упирается в реализацию и соскочить с написанного будет непросто в реальном мирке

Это хоум кредит? Как сходил?

Спасибо!!!(Восклицание)

Create table PersonA(Tbn number primary key, name varchar2(20), otd number, sal number);

--Табельный номер , имя, отдел , зарплата

Insert into PersonA(Tbn,name,otd,sal) values(1, 'Аня',10,9000);

Insert into PersonA(Tbn,name,otd,sal) values(2, 'Саша',10,5500);

Insert into PersonA(Tbn,name,otd,sal) values(3, 'Таня',10,7000);

Insert into PersonA(Tbn,name,otd,sal) values(4, 'Ваня',20,2300);

Insert into PersonA(Tbn,name,otd,sal) values(5, 'Олег',20,4300);

Insert into PersonA(Tbn,name,otd,sal) values(6, 'Коля',20,3900);

Insert into PersonA(Tbn,name,otd,sal) values(7, 'Таня',30,7000);

Insert into PersonA(Tbn,name,otd,sal) values(8, 'Макс',30,9000);

Insert into PersonA(Tbn,name,otd,sal) values(9, 'Таня',30,8500);

Insert into PersonA(Tbn,name,otd,sal) values(10,'Макс',30,9900);

Insert into PersonA(Tbn,name,otd,sal) values(11,'Олег',30,9900);

Insert into PersonA(Tbn,name,otd,sal) values(12,'Макс',30,9900);

Insert into PersonA(Tbn,name,otd,sal) values(13,'Макс',30,9900);

Insert into PersonA(Tbn,name,otd,sal) values(14,'Макс',30,9900);

Insert into PersonA(Tbn,name,otd,sal) values(15,'Макс',30,9900);

Insert into PersonA(Tbn,name,otd,sal) values(16,'Макс',30,7000);

Insert into PersonA(Tbn,name,otd,sal) values(17,'Таня',30,3500);

commit;

Вот например тут если мы сделаем запрос:

select name , otd , sal , sum(sal) over (partition by otd order by sal) as num from personA, то результат будет некорректный, из-за того что поле sal может повторятся.

Как написать корректную аналитическую функцию?

123 Кб, 1240x602

123 Кб, 1240x602 112 Кб, 1125x528

112 Кб, 1125x528select a., sum(sal) over (partition by name order by name, num)

from

(select a., row_number() over (partition by name order by name) num

from PersonA a) a

Вот ето хуйня.

Спасибо

insert into foo values (0, 999);

то в таблицу common автоматически добавится такая новая запись:

insert into common values (N, 0, null, null);

, где N - автоинкрементирующийся id.

Вопрос такой, можно ли и как сделать такой селект по таблице common, чтобы в результате получить данные со всех трех таблиц foo, bar, baz (пока предположим, что все поля у таблиц одинаковые)? Кароче, нужен результат как в таблице select result, как показано в примере на втором пике.

Я пытался через inner join сделать, записав три join подряд, но естественно результат нулевой, потому что он для всех условий join использует конъюнкцию, то есть находит пересечение множеств. Мне надо чтобы он в строке common находил не null поле с id и дергал данные из соответствующей таблицы по этому id.

>Вопрос такой, можно ли и как сделать такой селект по таблице common, чтобы в результате получить данные со всех трех таблиц foo,

Можно

Про Оракловый connect by prior я знаю, и кстати MySQL с 8 версии тоже может выбирать поддеревья целиком. У меня больше вопрос перфоманса. Как там работает connect by prior не совсем ясно, но скорее всего просто тупо джоинит внутри. Быстрее чем самому, запрос за запросом выбирать. Но с nested sets когда тупо выбирается диапазон и рядом не стоит.

Neo4j я знаю и начал смотреть, но там пока вообще непонятно насколько быстро выбирается поддерево.

В оракле все нормально.

Там точно не джойны внутри.

Делаешь запрос и смотрешь план. Думаешь.

Нео - говно, но если тебе нужен граф немыслимой вложенности, то почему бы и нет?

Левые джойны + coalesce не учил, не?

Объясни пожалуйста:

>UNBOUNDED PRECEEDING - Окно начинается с первой строки текущей группы и заканчивается текущей обрабатываемой строкой

- CURRENT ROW - Окно начинается (и заканчивается) текущей строкой

Как это можно связать через between? Почему UNBOUNDED PRECEEDING не включает в себя CURRENT ROW? И почему на результат аналитических функций влияет дублирующие строки в имени функции?

>Окно начинается с первой строки текущей группы и заканчивается

где ты это описание нашел? где нашел, там и оставь

границы окна указываются как rows between <start> and <end>. причем, заставить учесть одну и ту же строку дважды без костыльных подзапросов достаточно проблематично

106 Кб, 1239x375

106 Кб, 1239x375Том Кайт

СУБД Оракл

Алсо, запрос корректно работает и без

>BETWEEN AND CURRENT ROW

Просто там по умолчанию стоит RANGE UNBOUNDED PRECEEDIN

Бля, второй раз в жизни на дваче что-то полезное!

Никогда не пользовался этими функциями и даже не знал, что так можно, епта!

Даже в сраном мускуле это есть, охуеть, что уж там про оракл говорить...

Спасибо, аноны!

Томас Коннолли, Каролин Бегг — Базы данных. Проектирование, реализация и сопровождение. Теория и практика.

15 Кб, 1136x253

15 Кб, 1136x253Хочу переименовать название одной колонки в таблице, погуглил (так как я нуфаг), выдало решение:

ALTER TABLE table_name RENAME COLUMN name1 TO name2;

Но чот меня шлет нахер читать документацию и ругается на синтаксис в месте: COLUMN name1 TO name2;

Пробовал с кавычками, писал RENAME_COLUMN (а что а вдруг) результат тот же.

Подскажите, как переименовать, будьте добры.

Использую PhpMyAdmin, если это важно.

Спасибо тебе.

232 Кб, 781x870

232 Кб, 781x870Знаешь, я пожалуй поищу что то менее затратное и лежащее на торрентах

я чувствовал, конечно, что его книгу по основам реляционной теории я купил зря. но это настолько бесполезный автор что ли в домене?

Ну, примерно как Матфей в области рассказов об Иисусе.

Апологет Невзорова, конечно, назовет его клоуном.

Все ты правильно сделал.

His book An Introduction to Database Systems, currently in its 8th edition, has sold well over 700,000 copies not counting translations, and is used by several hundred colleges and universities worldwide.

Хуйня, конечно. У Пупкина лучше все описано.

круто, рофловасян смог скопипастить с вики. а сказать-то что хотел?

я говорил где-то, что у него хуево написано (что-то где-то)?

Круто, рофловасян без всякой вики обосрет любого. а сказать-то что хотел?

Поиск по атрибутам и значениям выполняю вот так:

SELECT t0.

FROM eav t0

join eav t1 on t0.phone_id=t1.phone_id and t1.parameter = "Источник" and t1.value = "Сайт 1"

join eav t2 on t0.phone_id=t2.phone_id and t2.parameter = "Группа" and t2.value = "Основная"

join eav t3 on t0.phone_id=t3.phone_id and t3.parameter = "Регион" and t3.value = "Ленинградская область"

group by t0.phone_id

having count() = 3

Проблема в том, что в EAV-таблице приходится держать сами значения и они многократно дублируются. Хотелось бы в этой таблице держать только ID, а искать так же по значениям. Если добавить таблицы с атрибутами и значениями, а в этом запросе их заджойнить, то поиск не возвращает ничего. Пример с джойнами:

SELECT t0.

FROM eav t0

join parameter p on p.id = t0.parameter_id

join value v on v.id = t0.value_id

join eav t1 on t0.phone_id=t1.phone_id and p.name = "Источник" and v.name = "Сайт 1"

join eav t2 on t0.phone_id=t2.phone_id and p.name = "Группа" and v.name = "Основаная"

join eav t3 on t0.phone_id=t3.phone_id and p.name = "Регион" and v.name = "Ленинградская область"

group by t0.phone_id

having count() = 3

Я что-то не так делаю или это в принципе невозможно?

136 Кб, 894x894

136 Кб, 894x894>Крис Дейт спиздил, чтобы продавать по 250 баксов.

ух сволочь

>Вон, у анона уже жопа полыхает

Еще тлеет

Смотрю и не могу найти что то стоящее

Объясни мне момент. С учетом фундаментальной основе в виде знания БД, почему в целом так мало людей разибирающихся в них чуть больше "сделать ручками зазубренные вызовы", хотя и таких не так много, ибо ОРМ... Аналитиков БД в обще кот наплакалпытался найти себе ментора

Но большая часть из них это не программисты на питоне и яваскрипте.

Да даже и на яве, хули там.

ОРМ, которая может за тебя "сгенерить" схему БД, и, тем более, ебаные РЕСТ-репозитории, которые вообще без всякой мысли программиста что-то хуярят в базу, или из нее читают...

Да ну на хуй.

Просто сайт-визитку сделать это заебись, быстро, и всем видно. Молодец, мальчик, фуллстэк, 300кк/нс

А огранизовать правильное, надежное хранение с разумной скоростью характерных выборок - да кто ж это увидит? Ничего же не пердит и не свистит.

Вот и специалистов не видно в толпах говнокодеров.

Только и всего

>специалистов не видно в толпах говнокодеров

во-первых, попробуй заглянуть дальше своего "проекта"

во-вторых, говнокодерство может быть обусловлено положняком на самом проекте (sad but true)

в-третьих, уметь использовать ОРМ тоже нужно. и, обычно, без знания того, какой код нагенерит тебе этот ОРМ, сильно не погуляешься

кто для тебя специалист-то вообще?

Да я не про свои проекты же.

В моих проектах у меня есть я, мне других не надо.

Я про то, что вижу вокруг.

Даже если не брать двач, бггг, то форумы и ебаные тенденции (напоминаю про способность ОРМов генерить схему базы, такое кто мог придумать, на такое кто мог подписаться, и почему это еще живо, мм?)

ОРМ - хорошо. Там, где ему место.

Но, опять же, ОРМ по большей части делают люди, которые пляшут от программирования и объектов. А не от грамотной схемы.

Поэтому некоторые очевидные (для меня) ходы через какой-нибудь Хибернейт охуеешь делать.

Я пытаюсь создать функцию и триггер, который будет обновлять атрибут timeorder с текущей датой, когда атрибут floatingItem обновляется. Функция, с которой я работаю, работает с одной проблемой. Он обновляет все записи, а не те, которые были обновлены.

Проблема: при обновлении данных в floatingItem timeorder остается неизменным

ALTER TABLE public.orders ADD COLUMN timeorder timestamp without time zone;

CREATE FUNCTION web() RETURNS trigger AS

$$

BEGIN IF new.floatingItem = FALSE

THEN

UPDATE public.orders SET timeorder = current_timestamp WHERE

new.bubNum=orders.bibNum;

END IF;

RETURN new;

END;

$$

LANGUAGE plpgsql VOLATILE;

CREATE TRIGGER IF NOT EXISTS mytrigger AFTER UPDATE ON public.fund FOR EACH ROW EXECUTE PROCEDURE mytrigger ();

530 Кб, 1374x888

530 Кб, 1374x888отвалилась пикча

>CREATE FUNCTION web() RETURNS trigger AS

На хуя?

В чем проблема код написать сразу в триггере?

Не, я уже глянул в доку, это ебанутый синтаксис постгре

ты бы показал свой апдейт, который заставляет обновиться все записи

и ты уверен, что new должно сработать, а не NEW?

я постгре не ебал особо, не знаю, насколько он регистрозависимый

>UPDATE public.orders SET timeorder = current_timestamp WHERE

new.bubNum=orders.bibNum;

>UPDATE public.orders

>orders.bibNum

Я бы либо orders. выкинул бы, либо public добавил бы

225 Кб, 1604x810

225 Кб, 1604x810CREATE FUNCTION web() RETURNS trigger AS

$$

BEGIN IF new.floatingItem = FALSE

THEN

UPDATE public.orders SET timeorder = current_timestamp WHERE

new.bubNum=orders.bibNum;

END IF;

RETURN new;

END;

$$

LANGUAGE plpgsql VOLATILE;

CREATE TRIGGER web AFTER UPDATE ON public.fund FOR EACH ROW EXECUTE PROCEDURE web ();

>ОРМ по большей части делают люди, которые пляшут от программирования и объектов. А не от грамотной схемы

я, честно говоря, не вижу противоречия в использовании ОО-модели и грамотной схемы базочки

Грамотная схема базочки не должна ничего знать про ОО-модель.

Только и всего.

Потому что схема реляционной бд строится по своим законам, а ОО-модель - по своим.

Я, в общем-то, об этом.

так модели уровня ORM - это рефлексия модели базы данных, с которой (обычно) приложение (бизнес-логика) не работает напрямую

если я нихуя не понял и сказанул хуйню, просто проигнорь

Ок. Чтобы понятнее было:

сделай со звездочкой, но убери груп бай

внимательно смотри, что у тебя в выборке получается

и почему не группируется вообще

Иногда нужно.

А у вас запрос корявый.

Ещё как держат. Оракл это не только бд, но и целый стек накрученный поверх этой бд, и в банках этот стек используют во всю.

1. Простота. Все операции перед глазами, а не хуй знает где по стеку вызовов. Меньше шансов нафакапить с распределёнными транзакциями.

2. Скорость. Ты знаешь какие будут запросы в момент разработки, и можешь тюнить сразу же. Можешь пересобрать статистику вручную при необходимости, добавить хинтов, прибить план запроса гвоздями или не делать нихуя ибо так быстрее.

3. Единая платформа и куча программистов в штате под неё. В платформе есть всё что душа пожелает, даже готовая АБС за отдельный прайс

4. Легаси. Nuff said.

Т.е. ты не видишь разницы в цепочке:

достать хуй из базы - сделать из него объект - ебануть что-нибудь с этим объектом - отправить обратно в базу

и

сделать все это в базе, выдав наружу только какой-нибудь иммутабл срез данных?

Братан, второй запрос вообще ни одной строки не выводит. Группировать нечего. Я потому и спрашиваю что я не так делаю, раз у меня по ID ничего не ищет.

У меня только вот так получилось это сделать, но выглядит как-то стрёмно.

SELECT t0.phoneId

FROM eav t0

join eav t1 on t0.phoneId=t1.phoneId and t1.parameterId = (select id from parameter where name = "Источник") and t1.valueId = (select id from value where name = "Сайт 1")

join eav t2 on t0.phoneId=t2.phoneId and t2.parameterId = (select id from parameter where name = "Группа") and t2.valueId = (select id from value where name = "Основная")

Надумал тут сдавать экзамены на сертификацию по мелкософт SQL, первый экзамен 761 сдал без особых проблем, готовлюсь к 762, так там оф учебник говорит, что его нихуя не достаточно и оно так. Особые проблемы ощущаю с dmv и мониторами для чека ресурсов и тюнинга производительности(Activity Monitor, Data Collector Sets, sys.dm_sranaya_ebota и т.д.). Знает ли анон какие проверенные ресурсы по данной тематике и/или прикладные конкретно для 762. В инете полно дампов, но там ответы неправильные, и их явно недостаточно, ибо цель не тупо натаскаться на экзамен, а подтянуть себя заодно.

Slect * From Student ORDER BY name DESC; По какому алгоритму этот запрос обрабатывается? Сначала таблица Student сортируется по name, а уже потом возвращается? А после того как таблица вернулась операции отменяются? Или создается буферная таблица, с которой сначала выбираются данные, а уже там сортируются?

Согласно оф мануалу от MS SQL(другие, полагаю, работаю так же):

the logical query processing order, which is the conceptual interpretation order, is different. It starts with the FROM clause. Here is the logical query processing

order of the six main query clauses:

1. FROM

2. WHERE

3. GROUP BY

4. HAVING

5. SELECT

6. ORDER BY

Each phase operates on one or more tables as inputs and returns a virtual table as output.

The output table of one phase is considered the input to the next phase. This is in accord with

operations on relations that yield a relation. Note that if an ORDER BY is specifed, the result

isn’t relational. This means that you can’t operate on such result with an outer query because

an outer query expects a relation as input

Карач, Order by работает на основе того, что сделали другие операторы, поэтому, кстати, только в нем можно обращаться к столбцам результата по алиасу.

>Нужно смотреть план запроса.

Если покажешь такой план, где ОРДЕР БАЙ не последним идет, я охуею.

Но ты же не покажешь, да?

Да пожалуйста - запрос с фильтрацией на больше/меньше по rownum и сортировкой.

Запрос с аналитической функцией - тоже отработает после сортировки.

Охуеть, да?

Я так и думал, что найдется мастер-ломастер, который покажет на ордер-бай из вложенного селекта.

Найс.

Давай следующую попытку. С ордербаем от общего селекта.

Передавай привет, кстати, тому мудрецу, который вхуячил ордербай в подселект, он же там так нужен!

Первое - разумно, да. Хотя это и, очевидно, краевой случай.

Про аналитические функции поразмышляю. Но не вижу такой хуйни, кроме как для тех, которым важен порядок строк.

Но, очевидно, план запроса и тут на хуй не сдался. И так понятно, что если ты оперируешь rownum, то он будет после любых других действий.

https://postgrespro.ru/blog/company/4203947

Что вычувствуете, когда узнаёте о таких вещах?

Молодец! Умница! А я никчёмное говно. Такие дела.

Ну, роунам - специфичные случаи, но иногда бывает. Например, когда ты в подзапросе сортируешь по дате и добавляешь rownum as rn в поля выборки, а потом по нему делаешь rn = 1 - получаешь первую запись по дате. Таки лучше случая date = (select min date from huy).

Насчёт аналитики - влияет на план запроса, если в аналитике важна сортировка(а она чаще всего важна, насколько я сталкивался в пределах своей работы). От сортировки зависит, будет ли аналитическая функция заново сортировать набор или будет использовать уже имеющийся отсортированный.

А ещё сортировка может повлиять на выбор оптимизатором хэш джойна или мердж джойна при соединении двух наборов данных, так-то.

Logical Processing Order of the SELECT statement

The following steps show the logical processing order, or binding order, for a SELECT statement. This order determines when the objects defined in one step are made available to the clauses in subsequent steps. For example, if the query processor can bind to (access) the tables or views defined in the FROM clause, these objects and their columns are made available to all subsequent steps. Conversely, because the SELECT clause is step 8, any column aliases or derived columns defined in that clause cannot be referenced by preceding clauses. However, they can be referenced by subsequent clauses such as the ORDER BY clause. The actual physical execution of the statement is determined by the query processor and the order may vary from this list.

FROM

ON

JOIN

WHERE

GROUP BY

WITH CUBE or WITH ROLLUP

HAVING

SELECT

DISTINCT

ORDER BY

TOP

Ты по-английски плохо читаешь, да?

>This order determines when the objects defined in one step are made available to the clauses in subsequent steps

И все.

К предмету обсуждения не относится вообще.

К предмету обсуждения относится вот это:

>The actual physical execution of the statement is determined by the query processor and the order may vary from this list.

Попробуй в следующий раз читать все буквы

>А ещё сортировка может повлиять на выбор оптимизатором хэш джойна или мердж джойна при соединении двух наборов данных

Дай ссылку почитать про это

Без подъебки прошу

Ну, вот что-то похожее на правду:

https://studfiles.net/preview/1037891/page:30/

А так там даже читать не о чем: если у тебя два отсортированных набора данных, то для группы значений из первого набора идёт поиск таких же значений во втором наборе до нахождения первого большего - дальше нет смысла искать, набор-то отсортирован.

Как nested loops, но меньше итераций вложенного цикла за счёт предварительной сортировки либо чтения индекса.

Ну, твоя же ссылка говорит, что хешу вообще не всралась сортировка.

В сортмердже не будет итераций вообще, а будет 1 проход по одному набору, и 1 по другому.

НО! Сортировка ни на что не влияет. Оптимизатор может без всякой сортировки с твоей стороны решить, что сотрмердж будет быстрее.

В общем, сделай селект с /*+ USE_MERGE (или как в твоем диалекте хинт выглядит), и ордер баем. Хоть по тем же полям, что были в условии объединения.

И глянь в план запроса. Где будет ордер бай?

Если ты говорил о том, что имеет смысл херачить ордер бай в подселекты, то нет, не имеет. Если ты хочешь, чтобы сработал сорт-мердж, так оптимизатору и скажи. А не прыгай с бубном.

714 Кб, 810x2745

714 Кб, 810x2745Правильно моя ссылка говорит. И я тебе говорю, что сортировка нужна для мердж-джойна, а не для хэш джойна.

Только вот оптимизатор может на основании наличия в запросе сортировки и объема выборки сам выбрать мердж-джойн, а может выбрать хэш-джойн.

А может и выбрать мердж-джойн и сам отсортировать наборы данных. А один точно будет сортировать.

Смотри пикрил и не неси хуйню, что сортировка подзапроса не имеет смысла в случае мердж-джойна.

А ещё ты, наверное, не очень понимаешь смысл и процесс построения реального плана запроса и хинтов.

Пиздец, я так и думал (судя по тому, что первую ссылку ты прислал на русском), что с английским у тебя беда.

Удачи.

Хера ты рофлишь.

Ну давай, укажи, где я неправильно перевел. Я признаю свою ошибку, если ты не ебучий тролль без мозгов.

А теперь выключи смехуечки и объясни, что у тебя за схема, в которой нельзя дырку в стуле сделать характеристикой. Высоту, значит, можно, а тип сиденья нет?

Если это два разных объекта, то как не пытайся, придется делать две записи.

>то как не пытайся

Пнятненько. Думал есть секретные многоходовки от мастеров проектирования БД.

Тут есть люди, которые работют с хадуп и террадатой? Если ли у терродаты преимущества перед, например, ораклом? Правильно ли я понимаю, что она гораздо сильнее распаралленина?

Непересекающиеся задачи, а не преимущества

Когда кто-то пытается использовать noSQL для того, для чего все остальные десятилетиями используют SQL, это просто значит, что этот кто-то - мудак

Обычно упоминается CAP теорема. noSQL это быстро но не гарантируется целостность данных в каждый конкретный момент времени. SQL (с транзакциями) - медленно но гарантируется целостность данных.

там, где у тебя естественным образом возникает 3НФ и, соответственно, постоянное пересечение таблиц - там sql

там, где неструктурированная информация (до хуя текстов, про которые тебе настрать, кто они, откуда, зачем, когда и где родились, и как связаны друг с другом) - там nosql

но умнее будет, если ты в гугле забьешь nosql vs sql и прочтешь первый пяток из выдачи

Пишу пока изредка процедуры и триггеры на работе, сам бэкенд-разраб.

Вот думаю перекатиться, тк всегда хотел лучше разбираться в БД и проектировании, нравится писать на SQL, да и вообще ищу более консервативную область IT без модных фреймворков, гик-культуры, маскотов и прочей блевоты. Потом может в аналитику перекачусь.

Хм, а сколько у тебя лет опыта и на каком языке пишешь? Может просто останешься в нём же, но найдёшь более интересную работу?

Стартовую ЗП сеньора ораклиста я бы обозначил в 150+, но это устаревший на сегодняшний день подход - сейчас в БД принято только хранить данные.

мне как бекенду [как правило] нужно разбираться в базочках чуть выше среднего уровня. офк, если сильно распределенные команды, то там за этим могут следить совсем отдельные люди, но, преимущественно, на твоей стороне все, чего касается бэк, входит в зону ответственности (хотя бы на уровне, я знаю слово redis и почему мы достаем сейчас трогаем его, а не мускульный кластер)

230 Кб, 810x1080

230 Кб, 810x1080Сам по базам данных слушал только курс в универе и писал чё-то на C# с entity framework, но уже всё забыл.

что уровня сложнее википедии тебя вообще интересует?

175 Кб, 535x807

175 Кб, 535x807Не увидел в шапке гайда, но спасибо на том, что такой тред вообще есть. Хотел бы получить совет куда дальше расти.

Имею за плечами 6 лет опыта oracle developer. Уровень оценил бы как крепкий мидл, но многих нюансов работы базы не знаю, какие должен знать сеньор.

Последние два года работаю в одном из топ банков, в основном пишу бизнес-логику, работа уже становится однообразной.

Понимаю, что писать однообразный код и решать типовые задачи придется вскоре через силу. В какую сторону развиваться дальше? Вкатываться в ентерпрайз разработку желания особого тоже нет (имеется в виду java). Может в дата инженеры или сайнтисты? Вообщем вопрос, куда можно податься разрабу БД, при этом чтобы переквалифицироваться частично и/или постепенно. А если по ЗП не сильно просесть - то вообще сказка.

Нужен эскуэльщик, который быстро разберется в существующих скриптах, и будет хуярить новые как безумная обезьянка. Быстро и правильно. А также - смотреть на цифры, которые выгрузились, и проверять их на адекватность. Эти скрипты нужно документировать и цеплять к экселю.

Больших познаний в sql не нужно, нужно понимание как работают оконные функции, джойны и как выбрать индекс для таблицы. ЗП от 100к, в зависимости от опыта. В общем, особо уметь нихуя не надо, но работы много.

Ах да, из формальных требований нужна вышка, остальное не принципиально.

Если кому-то интересно, телега @random_1234, пишите, пообщаемся.

ДС. Прошу прощения, забыл.

Вот ты и разрешишь спор выше насчёт за sort merge, раз шесть лет опыта.

Так ты же можешь с таким количеством опыта начать свои темы продвигать. Начиная от какого-нибудь сборщика патчей заканчивая оптимизацией бд в целом.

Ну, то есть, ты же можешь расти внутри своего банка, разве нет?

>Вот ты и разрешишь спор выше насчёт за sort merge, раз шесть лет опыта.

Ну начнем соправданий того, что все учатся по-разному и на разных примерах и учебниках и 6 лет работы ни о чем не говорит.

Ниже расскажу про фейл, который случился не так давно.

Думаю order все же в первую очередь используется, когда клиенту требуется предоставить результат запроса в сортированном виде (top n, pagination и т.п.). В примере из поста с вопросом очевидно, что сортировка выполнится последней.

В любом случае согласен с аноном, который предлагает смотреть реальный план соединения двух сортированных выборок, с хинтом и без.

>А может и выбрать мердж-джойн и сам отсортировать наборы данных

Задался вопросом, а может оптимизатор отказаться от промежуточных сортировок, которые явно указаны в коде запроса? Например, в случае merge joina двух сортированых выборок, результат будет отсортирован по ключу соединения , а в случае hash joina нет такой гарантии?

Кстати, за все время пару раз встречал код, где явно прописаны были хинты. Думаю, если статистика обновляется регулярно, то оптимизатор очень редко мажет с планом.

А попытки поиграться с хинтами заканчивались максимум чуть худшим планом выполнения.

Так же встречал вот такое применение order by

SELECT * FROM demo

order by case when id%2=0 then '1' else '0' end desc

только вместо case использовался decode

с последующей фильтрацией rownum = 1.

Посмотрю план, кстати, не понятно чем это эффективнее простого фильтра в where.

Ну, значит, мой проеб, я неправильно сделал выводы на основании того, что читал.

Насчёт промежуточных сортировок - кстати, даже не задумывался. Хрен уже с этим sort merge, насчёт этого - думаю, что если сортировка одна, он вынесет ее на верхний уровень. А вот в случае нескольких - уже не знаю.

В любом случае, я сталкивался с тем, что реальный план может отличаться от того, который строится без выполнения запроса. Это и насчёт явных хинтов: сам был ситуации, когда мердж в подзапрос выглядел с виду хорошо, а на самом деле выбрал NL для набора данных в несколько миллионов с обеих сторон, если не ошибаюсь. И пока я явно ему не сказал use_hash, он не выполнялся. То есть либо смотреть v$sql_plan, либо лог сервера, мирончик показывал как(а я уже не помню, как именно).

Можно ещё про driving_site сказать, но это немного другое дело.

А иногда тот же use_hash может быть лучше при хуевом факторе кластеризации и table access by rowid.

Про твою сортировку - мб там функциональный индекс был? Хотя этот запрос же выбирает, по факту, рандомную строку среди чётных - мало ли, зачем нужно было именно так.

С другой стороны, оракл говорит, что нет гарантии, что один запрос в два разных момента времени вернет одинаковые с точки зрения сортировки наборы данных, так что, в теории, и обычный фильтр должен дать случайную строку хотя я не раз обращал внимание, что хотя бы для простых запросов без параллелей порядок один и тот же. Либо как в индексе лежит, либо "сортирует" по rowid.

ты забыл про фейл рассказать

Потому что есть зарезервированные слова в SQL.

Потому что я ньюфаг, сорри.

>ты забыл про фейл рассказать

Это все относится к Ораклу, в других СУБД может и не воспроизвести.

1. В процедуре, в самом внутреннем вложенном цикле в курсоре написал селект с большим количеством джоинов по таблице

из которой удаляются/добавляются записи в той же самой транзакции. Если не вдаваться в подробности, то на большом объеме входных данных это вылилось в подвисание процедуры.

Основная причина - чтение данных не из блоков, а из сегмента отката. Ну это со слов более опытных коллег такая причина.

В логах сессии это проявлялось очень большим значением buffer_gets, что считается дурным знаком.

2. Представим таблицу, в которой есть текстовая колонка

"Значение свойства" (val ) - для хранения значений с разными типами данных: строки, числа, даты .

"Код свойства" (code) - все значения с одинаковым кодом относятся к одному типу данных.

"id объекта" (object_id) - несколько разных свойств могу относиться к одному объекту

Упрощенно, задача была написать запрос, выбирающий объекты с конкретным значением свойства.

Заранее известно, что требуемому коду свойства соответствуют числовые значения.

Таблица свойств P

Таблица Object O

select o.*

from o, p

where o.id = p.object_id

and p.code = 'PRICE'

and p.val = :x

, где x - число.

колонки p.code, p.val - индексированы простым индексом

Так вот на одном стенде этот код работал без ошибок, а на другом завершался с ошибкой рано или поздно.

Ответ очевиден, но если вдруг кому-то интересно подумать, могу под спойлер ответ спрятать.

Надо помнить, что в оракле, если в коде запроса есть бинды, но нет явного приведения типов в сравнении переменной и значения колонки,

то тип колонки таблицы приводится к типу переменной.

В одном случае план запроса был с index range scan по колонке code,

т.е. сначала находилась запись, где точно было число, а потом происходило сравнение.

В другом же был full scan и для каждой записи происходила попытка преобразовать значение к числу,

что и вываливалось в ошибку, если в строке встречался не числовой символ.

Мелочь вроде, но досадная, нельзя такое упускать.

2.

>ты забыл про фейл рассказать

Это все относится к Ораклу, в других СУБД может и не воспроизвести.

1. В процедуре, в самом внутреннем вложенном цикле в курсоре написал селект с большим количеством джоинов по таблице

из которой удаляются/добавляются записи в той же самой транзакции. Если не вдаваться в подробности, то на большом объеме входных данных это вылилось в подвисание процедуры.

Основная причина - чтение данных не из блоков, а из сегмента отката. Ну это со слов более опытных коллег такая причина.

В логах сессии это проявлялось очень большим значением buffer_gets, что считается дурным знаком.

2. Представим таблицу, в которой есть текстовая колонка

"Значение свойства" (val ) - для хранения значений с разными типами данных: строки, числа, даты .

"Код свойства" (code) - все значения с одинаковым кодом относятся к одному типу данных.

"id объекта" (object_id) - несколько разных свойств могу относиться к одному объекту

Упрощенно, задача была написать запрос, выбирающий объекты с конкретным значением свойства.

Заранее известно, что требуемому коду свойства соответствуют числовые значения.

Таблица свойств P

Таблица Object O

select o.*

from o, p

where o.id = p.object_id

and p.code = 'PRICE'

and p.val = :x

, где x - число.

колонки p.code, p.val - индексированы простым индексом

Так вот на одном стенде этот код работал без ошибок, а на другом завершался с ошибкой рано или поздно.

Ответ очевиден, но если вдруг кому-то интересно подумать, могу под спойлер ответ спрятать.

Надо помнить, что в оракле, если в коде запроса есть бинды, но нет явного приведения типов в сравнении переменной и значения колонки,

то тип колонки таблицы приводится к типу переменной.

В одном случае план запроса был с index range scan по колонке code,

т.е. сначала находилась запись, где точно было число, а потом происходило сравнение.

В другом же был full scan и для каждой записи происходила попытка преобразовать значение к числу,

что и вываливалось в ошибку, если в строке встречался не числовой символ.

Мелочь вроде, но досадная, нельзя такое упускать.

2.

Жиза, сталкивался и с тем, и с другим. Второй пункт - так вообще в первые пару месяцев постоянно допускал такие ошибки - первичные ключи у нас были текстовые, а сравнение могло быть с числом, а оракл всегда при сравнении строки с числом неявно приводит первую к числу. Но нюанс про биндовые переменные не знал, запомню.

А первый пункт - да, есть такое, хотел как-то апдейтить 40+ миллионов одним мерджем, откат операции лет больше 25-ти минут.

>Основная причина - чтение данных не из блоков, а из сегмента отката.

Если блок был обновлён апдейтом, то оригинальный блок помещается в сегмент отката. Оттуда будут читать данные другие сессии, если им понадобится тот же самый блок, и производиться rollback. Но твоей собственной сесии, которая обновляет данные, обращаться в сегмент отката не за чем.

Ты упомянул про циклы, да еще и вложенные. Всякие forall не зря ведь придумали, sql в циклах работает медленно.

По поводу buffer gets. Вангую, что после того как блок был прочитан в кэш, затем обновлён, Оракл не мог получить его из кэша и перезачитывал заново с диска. Отсюда серьёзно возросший I/O, который и повесил процедуру. Но это предположение.

> тип колонки таблицы приводится к типу переменной.

Не совсем так, приводится к старшему типу. Если у тебя поле нумбер, а переменная варчар2, то конвертироваться будет бинд, и всё будет хорошо. А если наоборот, то да, конвертироваться будет поле, и индекс не будет использован.

Да, верно, неправильный вывод сделал.

Вот этим утверждением руководствовался

During SELECT FROM operations, Oracle converts the data from the column to the

type of the target variable

Видимо под target variable подразумевается переменная для хранения результата запроса.

>По-быстрому

>Спроектировать базу

>Ньюфагу

Кек.

В первую очередь - кури нормальные формы. Потом пойми, какая бд тебе нужна - транзакционная или аналитическая. Дальше сам догадаешься.

Excel

телефон Группа Имя

123 1 Лера

222 2 Женя

444 3 Катя

Word

Студент группы 1 Лера была зачислена(или отчислена). Контактный номер 123

Можете помочь или я могу пойти нахуй?

почему ты с этой задачей пришел в тредик про базочки?

не уверен, что офисные продукты могут вот так влегкую импортировать данные из одного пакета в другой, да и по образцу тем более

уже сделал системму через filldocuments,полезная хуйня

Тебе один раз или какая-то интеграция нужна?

Если один раз, выполни свой select, потом скопируй результат просто ctrl+v а потом вставь в word и excell

Если умеешь вставлять не только через ctrl+v, все получится.

Как в это въехать по быстрому, что почитать? Может кто ссылку на статью/главу даст. В данный момент нужен именно этот минимум знаний, более подробно изучать буду уже потом.

О, Дима, привет)).

Если я угадал, то у тебя весь функционал уже есть.

А если нет - то пиши сборщик, который по имени файла из патча будет звать процедуру, которая текст пакета вытаскивает из бд и делай spool в файл бекапа.

это если из sqlPlus будешь ставить патчи.

"Райдер, опять ты

Нет, это не я!"

Бтв раз не ты, то окей.

Короче, простая схема: вот есть у тебя патч (архив, ветка в гите или ещё какое изъебство). Ты пишешь прогу, которая формирует из файлов патча скрипт для sqlPlus(т.е файл, в котором у тебя будут вызовы выполнения файлов патча) в определенном порядке(например, DDL до DML), а в этой проге проверяешь, что если тебе встретился пакет/функция или что-то в этом роде, то ты перед выполнением файла из патча включаешь спул, достаешь текст этого объекта(он попадет в указанный в спуле файл) и выключаешь спул.

Вот тебе простой бэкап. Если ты особо извращенец - повесь триггер на DDL, чтобы текст старого объекта записывался в таблицу бэкапа + была запись в таблице логов.

Есть кто по сфинксу?

Можете пояснить как в sphinxql заставить работать select distinct так же как в mysql?

Версия 2.2.11

Тупой вопрос из разряда "читай документацию", но все же, может, кто-то от доброты душевной ответит.

Таблица с записями с группировкой по полю Х.

a varchar,

b number

x number

(например: x - ид сотрудника, b - месяц, a - оценка работы)

Как взять такие записи по max(b) group by x, у которых В МАКСИМАЛЬНОЙ ПО b записи a like '%zaebal%'?

(т.е. взять только таких сотрудников, которые в последний месяц заебали всех)

Как это сделать без подселектов.

С подселектом любой дурак сделает.

Having я же не могу подвязать, он только по агрегатным условиям работает.

Короче, можете издеваться сколько влезет, только ответьте, как сделать одним селектом (может оконные/аналитические функции?)

>это значит в последний месяц для каждого работника иль чо?

да, там же написано дальше:

>т.е. взять только таких сотрудников, которые в последний месяц заебали всех)

Кек.

Ну, даже не знаю, что тебе на это и ответить.

Давай, чтобы не было лишних споров, я переформулирую:

слово SELECT во всем запросе должно быть только одно

Более того, во From должна быть только одна таблица только один раз

Я подозреваю, что это так не сделать. Но я дремучий папуас среди специалистов, вся надежда на это.

Честно, не знаю, как тебе именно помочь с таким условием, но попробуй поиграться с cube и rollup, вдруг там отыщешь нужное тебе. А если это oracle, то можешь изъебнуться с model.

Проблема в том, что вышеупомянутые расширения группировки, скорее всего, в плане запроса будут использовать union all и разные группировки в каждом из запросов - та же работа rollup, если мне не изменяет память, так и описывается. То есть, строго говоря, одним селектом это не будет.

По уровню околомиддл.

СУБД какое?

С помощью АНСИ с одним селектом сделать это довольно сложно, но я вижу вариант сделать это в оракл.

Давай оракл

Я оттуда подумаю, в чем цимес

Прям ща Постргес, так что почти оракл

Но я надеялся, что я просто проебал новшества в анси (я оконные функции, например, только пару месяцев назад по диагонали проглядел, хотя ебашу много лет).

С другой стороны, это ж значит, что я все правильно понимаю. Хотя задача настолько очевидная, что странно, почему к ней еще не прикрутили простое решение

145 Кб, 1159x574

145 Кб, 1159x574Мне нужно, чтобы пользователь выбирал какое-то большое количество параметров (у каждого параметра выбор да/нет). Параметров около 1000. Как лучше это хранить и реализовать? Я подумал, что нужно делать такую таблицу

ИмяПользователя - 0011100... где 1 или 0 выбор параметра.

А отдельно хранить список параметров с соответсвующими индексами.

Может есть лучше решение?

Обращение-Прием 1:1 - супер-спорно ) Причем анализы едут от обращения, а диагноз от приема

Занимаемая должность - Должность как минимум сбивает с толку. К тому же ставка привязана к кабинету по факту, а не к реальной должности

ну и График. предполагается, что у тебя люди приходят только в нужные дни с Х до У? смену сочинить бы е-маё

и анализы можно сделать посложнее, если тебя напрягают делать много сущностей. ибо на практике очень мало таковых, где одно значение на выходе и норма тоже одной цифрой описывается )

>>37415

[Пользователи] 1:М [Парамерты пользователей] М:1 [Параметры]

>Обращение-Прием 1:1 - супер-спорно )

Да, с этим соглашусь, ошибочка, пациент вполне может записаться к нескольким врачам.

>Причем анализы едут от обращения, а диагноз от приема

А это непонятно. Ну, как бы, пациент обращается и идет либо к врачу (прием), либо на анализы (они же необязательно врачом на приеме назначаются). Диагнозы ставятся врачом на приеме. Пока не доходит, на какую ошибку ты указываешь

Над остальным покумекаю.

>>37449

Если обрамить квадратными скобками - вроде как да.

я не совсем понял, что ты хотел описать как "Обращение", а что как "Прием". с одной стороны там все можно залить в одну сущность, с другой есть нюансы.

ну вообще обращение оно не всегда линейное. я вот пришел к терапевту потому, что голова болит (считай, обращение началось еще до приема), терапевт посмотрел (прием раз), отправил к хирургу (прием 2.1) и патологоанатому (прием 2.2) (а это все то же обращение, но не точечное во времени, очевидно), они еще куда-то отправили, плюс накидали анализов. причем, кто-то посередине не может поставить никаких диагнозов пока не пришли ответы из направлений.

>[Пользователи] 1:М [Парамерты пользователей] М:1 [Параметры]

Но ведь тогда вторая таблица получится сверх большая. Каждый новый пользователь будет увеличивать её на 1000 строк (это если параметров только 1000). Если количество пользователей будет большим, пиздец же случится, не?

пару лямов строк любая хоть сколько-нибудь серьезная СУБД отработает без больших проблем. тебе же не SELECT * FROM делать, предполагается, что ты еще и использовать будешь адекватно таблицу.

разделение параметров по колонкам (в одном физическом аттрибуте или по каждому на один параметр) сверх-сильно усложняет поддержку такого решения.

если ты сможешь сгруппировать параметры каким-либо образом и выделить нечто вроде:

[Пользователи] 1:М [Параметры пользователей 1] М:1 [Параметры_1]

[Пользователи] 1:М [Параметры пользователей 2] М:1 [Параметры_2]

[Пользователи] 1:М [Параметры пользователей 3] М:1 [Параметры_3]

будет попроще, но это такое себе решение, я бы ниадобрил

Ок, понял, спасибо

Есть вариант сделать в анси

select x, max(b)

from table_pr

group by x

Having max(b) = max(case when a = 'zaebal' then b else null end);

Но, в таком случае b - не всегда будет текущим месяцем, а максимальным для каждого сотрудника, если я правильно понял, это то, что тебе нужно

Я и забыл совсем и про model тебе что-то говорю.

Это же max keep, ёпта. А в ордер бай пихаешь кейс, в котором a like '%zaebal%' даёшь единичку, а остальному - null. И тогда у тебя выберется максимум для именно таких значений a.

38 Кб, 1719x889

38 Кб, 1719x889Долго бьюсь над тем как все организовать, подкиньте почитать про то что цикличность это круто и тд или хотя бы пару идей как организовать. Мозговой шторм иссяк на идеях сделать последнюю таблицу неким расширением второй, но тогда это будет уже один ко одному, а по заданию один ко многим отношения везде

а ты уверен, что он образуется?

я вот вижу какую-то каракулю в пэинте и честное слово, что все именно так

Подожди, у тебя задание с ебанутым требованием подделать под определенную схему отношений?

Ты ничего не добьёшься, имея только корочку.

По моему субъективному мнение тебе подобных из высшего заведения нужно выкидывать, поэтому я тебе принципиально не буду помогать.

Задание может и нормальное составить расписание вуза и сделать запросы на свободные аудитории и т.д., но как раз его и надо подстроить под схему, которая и кажется ебанутой

Надеюсь ты не прав, все же специальность интересная и хотелось бы закончить, а не вылететь

пиздец лол

ну ладно, а вопрос в чем? цикличные связи - это в общем не то, чтобы плохо, это странно по меньшей мере. но в твоем случае это норм потому, что задания другого нет. только цимес в том, чтобы Table2->Table4 или Table3->Table2 были по факту 1:[0..1/M]. иначе ты ни строчки не вставишь в базочку возможно, в транзакции так можно изъебнуться, но я сомневаюсь

На твой взгляд со стороны тебе не кажется схема ебанутой? Сколько бы не рыл интернеты и русские и ангельские везде в основном проблемы вида "у меня цикл в бд и т.п., как это исправить?" Если же это нормальное явление, сразу же съебу

Да, все вопрос был в том является ли цикличность чем-то нормальным вообще. Спасибо, анон, буду изощряться

Это долбаёбов, которые просирают сроки сдачи курсачей и не в состоянии самостоятельно лог. схему спроектировать.

Вопрос был не в проектировании а в явлении цикличности в отношениях между таблицами в бд. Нормальная ли тема это где можно по этому поводу инфы нарыть

Мне кажется ебанутой сама идея задания подстраивать что-либо под какие-либо схемы, а не строить самому, про схему я вообще ничего не говорил.

как бы если тебе придется хранить граф в базе данных, то цикличность станет привычным вопросом. фишка в том, что для графов есть свои хранилища, зачастую, более эффективные, чем реляционка.

на практике такое можно встретить в иерархических данных, типа, организационная структура компании или что-то вроде этого.

Потому что в целом интересно как такое применяется и применяется ли вообще

>Нормальная ли тема

Нет, но иногда она вполне имеет место быть.

Например, в бух. учете, связь между дебетом и кредитом вполне может быть цикличной.

Вы как-то по-особенному понимаете цикличность, я гляжу.

; - конец блока, / - конец команды.

Скорее всего, прошло от того, что sql*plus должен как-то понимать, какой enter - это перевод строки, а какой - сигнал на выполнение, вот и / воспринимается как символ конца потока.

Всегда используй ;. Но если у тебя pl/sql блок - то заканчивай его /, чтобы следующий выполнился.

А - 100

А - 200

А - null

B - 100

B - 300

Как сделать запрос, который выдаст макс по первому столбцу, если там нет значений null, иначе выдаст null.

Забиваешь этот вопрос в гугл и выбираешь в выдаче ответы, подходящие к твоей субд

case используй

Что мне в гугле ввести, лол?

Я минут 40 эту ерись писать пытался.

Пока в голову пришло только ето:

with a as

(select t1, max(t2) m_t2

from table

group by t1)

select distinct a.t1,

case

when table.t2 is null then table.t2

else max(t2)

from a, table

Но это не правильно, т.к. результат будет =>

A-200

A-null

B-300

Как это фиксить?

>Что мне в гугле ввести, лол?

https://www.google.com/search?q=sql+null+as+max&oq=sql+null+as+max&aqs=chrome..69i57.5903j0j7&sourceid=chrome&ie=UTF-8

Если ты не способен даже на это, то я бы, на твоем месте, поискал другое хобби

Для такого Дейт подойдёт?

Select

t1,

Case

when Max(case when t2 is null then 1 else 0 end) = 1

then null

else max(t2)

end

From table

Group by t1

Задание:

Для каждого производителя, у которого присутствуют модели хотя бы в одной из таблиц PC, Laptop или Printer,

определить максимальную цену на его продукцию.

Вывод: имя производителя, если среди цен на продукцию данного производителя присутствует NULL, то выводить для этого производителя NULL,

иначе максимальную цену.

Часто в вакансиях сисадмина/линукс-инженера можно увидеть требования:

Апач/нгинкс, постфикс/довекот, бинд,

Субднейм/субднейм/субднейм.

На счёт последнего можете подсказать что учить надо?

Субднейм.орг/документейшн от корки до корки? Может знаете какой смысл они вкладывают это? Какая-то конкретика. (А то может они вкладывают в это поставить lamp, чтобы CMS встала за 5 минут)

Субд надо на случай внесения оптимизаций. Ну чтобы запросы вместо 1с выполнялись за 0.0001 пикосекунды. Репликации, бэкапы, апгрейд бд. Выполнять в ручную какие-нибудь запросы, перезагружать демон бд на худой конец.

Отвечая на такие вопросы, ты поощряешь долбоебов все больше и больше лезть сюда.

Скоро будут приходить с вопросами, как жопу вытирать

Мне это не нравится, вот и агрессивный.

Уметь поставить, забекапить, сконфигурить, реплицировать (хуй знает, надо или нет), засекьюрить.

Выдать юзерам (от дба до разработчика хуйни на жумле) доступ, чтобы они не ныли "аааа, у меня программа не видит БД"

Если кто-то от тебя будет ожидать умения писать селекты и их же потом оптимизировать, можно смело слать в жопу.

Нет.

Никто не мешает тебе иметь БД в памяти.

Теперь попробуй еще каки-нибудь искрометно пошутить.

>пошутить

В мыслях не было. Пытаюсь прояснить.

>Никто не мешает тебе иметь БД в памяти.

Вопрос не о "можназделоть", а о цели.

47 Кб, 660x496

47 Кб, 660x496Имеется следующая задача:

Есть ряд однотипных документов, порядка 500-600, в виде таблиц. Отличаются только содержимым этих таблиц. Нужно эти документы каталогизировать и иметь возможность осуществлять поиск по номеру этого документа. Находим в каталоге нужный документ, и в этом же ПО редактируем эту таблицу. Никаких картинок, тупо текст. Доступ к редактированию документа по логину и паролю.

Всякие навороченые гиганты типа Битрикса не нужны. Надо, что то маленькое и функциональное.

Есть что предложить?

7 Кб, 453x135

7 Кб, 453x135произвольной строке два и более встречающихся пробелов на один

with t as (

select ' a b c ' str from dual

)

select str ,

regexp_replace(str,'( +$)|((^| ) +)','\3') as r

from t

'( +$)|((^| ) +)' здесь указаны все варианты пробелов в строке

((^| ) +) - (если в начало строки или пробел) пробел входит больше одного раза) ?

'\3' - что это?

из определения не особо понять

\nn представляет собой число от 1 до 9. Соответствует n-му подвыражению находящемуся в ( ) перед \n.

Нет

Alfresco Community Edition?

https://regex101.com/

Сходи туда, чтобы не быть баттхертом.

Там каждый чих поясняется.

Но в целом это означает "все пробелы в начале или (читай "а заодно и") пробелы в конце строки".

\3 означает третье вхождение из всех найденных

короче, хули ты такой тупой, что не можешь выполнить запрос и посмотреть, что получается?

2,8 Мб, 2048x1074

2,8 Мб, 2048x1074Ты под чем эту схему рисовал? Сделай связи аккуратно, с минимумом пересечений.

Я в курсе что это третье вхождение из всех найденных. И запрос тыкал

КАКОГО ХУЯ ТРЕТЬЕ ТО ИМЕННО

Вот в чем вопрос

А почему не regexp_replace(str, '\s{2,}', ' ')?

Это не третье вхождение, это третья подгруппа выражения, в данном случае - пробел.

Вот он и меняет все, что подходит под паттерн(сиречь два и более пробелов) на один

Есть задача: логировать изменения отдельных атрибутов сущностей с которыми работает пользователь. С точки зрения пользователя выглядит так: открывается форма с атрибутами сущности, редактируются сущности, пользователь жмет "ОК" и, в случае изменения значений некоторых реквизитов, должна появляться еще одна форма, на которой пользователь выбирает причину изменений.Если от выбора отказывается, то изменения не сохраняются.

Причем БД? При том, что архитектура двухзвенная и при нажатии на "ОК" данные сохраняются в БД.

Тут вроде бы по классике можно создать триггер, но это решит проблему логирования изменений, но логирование и обновление экземпляра сущности должно происходит только после указания пользователем причины.

Как подойти к решению этой задачи?

Стоит в SQL Server вкатываться сейчас? На работе предлагают перейти и обучить. Чет в /б/ говорят, что эта вся хуйня уже устарела и со временем сойдёт на нет.

мимо-джун-фронтэнд

>Причем БД? При том, что архитектура двухзвенная и при нажатии на "ОК" данные сохраняются в БД.

Сделай, чтобы было не так.

Хули ты как маленький?

Триггеры и сложные схемы коммитов - решение неудачное. Потому что потом хуй найдешь, что у тебя в какой момент срабатывает, и почему.

Вообще хуярить в базу надо только после того, как у тебя ВСЯ информация уже есть.

Иначе у тебя будет транзакция неизвестной длины, и все такое.

Не будь мудаком, короче, сделай нормально сразу.

Имеется в виду, что нужно либо написать так, либо поправить (если есть), чтобы коммит был не сразу после инсерта/апдейта, а после поверки на корректность.

СУБД помогает это структурировать.

Давай рассказывай как ты без субд будешь копаться в условном ляме текстовиков каждый из которых хранит по 5-10 условных строчек инфы.

>как ты без субд будешь копаться в условном ляме текстовиков каждый из которых хранит по 5-10 условных строчек инфы

100500 способов. inb4 все они и есть СУБД, заведомо. Всё хорошее назовём СУБД. Остальное - не СУБД. Ага.

Ясно-понятно.

я так и написал в итоге ( и изначально). Просто почему-то именно это решение все хвалили на sql.ru...

З.Ы тут есть разрабы бд или близкие к ним, шарящие в sql и немного и в[ b]pl/sql[/b]? А то я тут тестовое сделал (не сложное), отправил, должны были сегодня ответить до конца дня как сказала эйчарка, но нихуя не ответили. Хочу в общем чтобы кто-нибудь из бывалых посмотрел мое решение, неужели там все так плохо @heheloh - можно сюда писать ну или в тред

Там я только забыл trim, чтобы удалить пробелы в начале и конце строки.

Там такое решение, я думаю, чтобы именно регуляркой убрать все, как бы показать свои умения. Но зачем так усложнять - не знаю.

Присылай, я разраб на pl/sql, глянем, чего у тебя там.

А если не звонят, то позвони сам, хули - это нормально.

Кинь Контакты какие нибудь я тебе скину файл

в /b не обманут

Приведи три способа из 100500 хотя бы, как можно в многопользовательском приложении/сайте работать с данными на чтение/изменение/удаление/добавление, не используя субд,а то пока что складывается ощущение, что ты обычный тралл.

>в многопользовательском приложении/сайте

Всё же concurrency-головного-мозга? А если нет concurrency, то и в СУБД смысла нет? Я, ведь, это и предполагал.

Жопой сманеврировал как портовая шлюха, а примеров так и нет.

Есть ли задачники с ответами по разработке СУБД?

1) Например, разработать примитивную ER модель и в конце расписывается верное рассуждение и диаграмма. Как такое гуглить?

2) Есть ли годный материал по моделированию данных/мат моделированию на русском?

3 Кб, 239x79

3 Кб, 239x79Нужно получить все детали заказа, заменив названия столбцов на их порядковый номер

Я разобрался как переименовывать столбцы (пикрил)

А как вывести с нумерацией но в таблицу изменения не вносить?

Row_count

Еееебать.

Погугли алиасы. Я крайне сомневаюсь, что тебе необходимо было вносить любые изменения в таблицу.

Создал dump, пытаюсь передать его через команду mongorestore

mongorestore --host pricingtoolcluster-shard-0/pricingtoolcluster-shard-00-00-u2jv8.mongodb.net:27017,pricingtoolcluster-shard-00-01-u2jv8.mongodb.net:27017,pricingtoolcluster-shard-00-02-u2jv8.mongodb.net:27017 --ssl --username admin --password <PASSWORD> --authenticationDatabase admin

пишет Failed: error connecting to db server: no reachable servers

Кто-нибудь сталкивался?

У меня похожая проблема с npm. Могу скачивать пакеты только через прокси (tor bundle)

73 Кб, 585x600

73 Кб, 585x600spasibo

Ахахахахаха

>реляционки не нужны!

>sql - говно

>поцаны, я не осилил, как свою модную базу перенести

Ожидаемо.

Раз днс работает нормально, может, в днк проблема?

Друзья, почему шапка не ньюби-френдли?

Вкатываюсь в погроммизды (c# web), пока учебники полистываю и задачки порешиваю, хотелось бы получить основательную базу по БД, а тут нихуя нет=((

Посоветуйте годноты, чтобы сразу получить фундаментальные знания и навыки: от простого к сложному. (P.S: заумные толстенные учебники на ангельском приветствуются)

Что обычно подразумевается под пунктами "продвинутое знание sql" и "proficient in sql" в вакансиях дата саентиста/инжинёра?

Знания аналитических функций, думаю, будет достаточно для дата сайнтиста.

Если их знаешь, то все остальное, связанное с селектами, тоже наверняка знаешь.

Сергей Тарасов. СУБД для программиста. Хороша для ознакомления с предметом, список литературы в конце неплох.

Благодарю

Очень даже. Правда обычно это либо от 3+ лет опыта, либо будешь получать штук 60-80

Такого нет. Можешь проектировать базу на любую предметную область и сюда ERD на проверку кидать. В чем проблема? Я помогу

Откуда можно скачать бигдату финансовых рынков?

Открой планировщик запроса и посмотри как будет с ордером и без.

30 Кб, 1034x218

30 Кб, 1034x218Есть список сотрудников и список оборудования. Нужно построить модель БД, так чтобы по каждому сотруднику можно было посмотреть какое оборудование находится у него на балансе в текущий момент, и какое было раньше. Когда он его получал, и когда сдал назад.

Сперва я думал что получится что-то типа пикрил, но теперь сомневаюсь. Ведь тогда получится что один сотрудник не может брать одно оборудование два раза. Типа взял, попользовался, сдал. Потом взял еще раз. Или я ошибаюсь?

Мудрые аноны, подскажите как правильно сделать?

Либо добавь в первичный ключ дату получения девайса, либо сделай таблицу с актуальным состоянием(сотрудник-девайс-когда получил) и с историей(сотрудник-девайс-когда получил-когда отдал) и после регистрации возврата переноси строчку из актуальной в историческую.

Первый вариант - то же самое, что и историческая таблица во втором, но после того как твоя бд и история разрастется до лютых размеров, очень долго будешь искать текущее состояние.

Спасибо огромное! Насчет первого варианта понял, а вот насчет второго не очень если честно.

Если тебе не трудно, не мог бы ты нарисовать как это выглядит в плане связей и ключей? Я просто первый раз сталкиваюсь с БД где больше двух таблиц с типичными связями и мой мозг никак не хочет это воспринимать.

Правила буравчика: всегда использовать суррогатные ПК.

Сегодня тебе кажется, что в качестве ПК можно использовать атрибут данных, завтра окажется, что он подвержен изменению или не уникален.

В крайних двух таблицах ты так и сделал.

А в средней - нет.

Не еби мозги, сделай в ней суррогатный ПК

Правила оформляй индексами и триггерами (ща наверняка еще подскажут, чем)

id(PK), c1, c2(NN), c3(NN)

мне нужно найти дубли, совпадающие по c1 и c2, но отличающиеся по с3 и, естественно, id.

запрос я написал, но, мне кажется, пздц неоптимизированный

SELECT FROM mytable t1 WHERE

(SELECT COUNT() FROM mytable t2

WHERE t1.id != t2.id

AND (t1.c1 = t2.c1 OR (t1.c1 IS NULL AND t2.c1 IS NULL))

AND t1.c2 = t2.c2

AND t1.c3 != t2.c3

) > 0;

может кто нибудь посоветовать, как это оптимизировать?

если я разделю этот запрос на штук 30, в каждом сделаю WHERE c2 = some_const, и объединю их UNION ALL, это будет лучше для бд на проде? или я так просто еще больше загружу бд?

доверь джуну скл писать...

Да епту.

Select t1.звизда

From table t1

Where (t1.c1, t1.c2) in

(Select t2.c1, t2.c2

From table t2

Group by t2.c1, t2.c2

Having count(звизда) > 1);

О ваших постах на двача может может знать ваш будущий hr, держу в курсе.

Тогда в подзапросе добавь джойн к самой себе по c1 и c2 и фильтр, где t2.c3 <> t3.c3.

>О ваших постах на двача может может знать ваш будущий hr

Да она, блядь, кончит фонтаном от моих постов.

Скорей бы.

select id, c1, c2, c3

from (

select

a.,

count(case when first_c3 <> c3 then 1 end)

over (partition by c1, c2

order by c3

rows between unbounded preceding and unbounded following) as diff_c3

from (

select

mytable.,

first_value(c3) over (partition by c1, c2 order by c3) as first_c3

from mytable

) as a

) as b

where diff_c3 > 0

В гугле забанен?

Чтобы тестить на, например, ms sql, тебе потребуется

- ms sql server developer edition

- sql server management studio

Ну это если кому консоль на сайтах подойдет.

Мой стек - python (написание ETL), mpp СУБД и один из ETL-фреймворков. Мне кажется, что проекты могут завершится, а бигдата как направление нужно лишь очень крупным компаниям, и у меня гораздо больше шансов полететь на улицу чем у рандомного фронтендера.

Насколько мои предположения правильны, и стоит ли вообще пытаться строить карьеру инженера данных?

Олды говорят, что это дает равномерное распределение данных по кластеру в процессе хранения и обработки.

Как это понимать и для чего это нужно? Влияет ли это на скорость доступа или еще на что-то?

Это в принципе правильное решение, потому что за счетчик айдишников обычно большая конкуренция в кластере. Как это вот все синхрогизировать, чтобы две записи с одинаковым ключом не сгенерились? Проще использовать UUID и проверять перед вставкой, чтотакого ключа в базе еще нет. С растущим интом такое тоже возможно, но в зависимости от степени конкуренции большая часть транзакций будет ретраится на этапе проверки, что такого ключа еще нет и производительность просто в 0 упадет.

>Как это вот все синхрогизировать, чтобы две записи с одинаковым ключом не сгенерились

Ставим триггер на добавление в таблицу записи - храним переменную со сцетчиком и увеличиваем. Разве это все не решается на уровне базы?

>большая часть транзакций будет ретраится

Кажется я понял, спасибо, анан. Типо появится очередь за новым id'шником?

INSERT INTO t8rv0_mobile_tokens (user_id, token) VALUES (:user_id, :token) ON DUPLICATE KEY UPDATE user_id = values(user_id), token = values(token)

Но, видимо из-за того, что токены различаются, оно создает новую запись вместо обновления старой.

Так же вопрос. Сам объект пользователя сохраняется в другой таблице. Если я слинкую user_id двух таблиц, оно создаст мне записи под все id? Тогда можно было бы заменить INSERT на UPDATE и пофиксить проблему

Мы вообще сейчас о распределенной бд говорим? Если нет, то это действительно просто и решается на уровне базы (по сути обычный AtomicInteger). В распределенной бд все сложнее намного. Нужна либо лочка по счетчику (а для этого нужен консенсус, который сильно бьет по производительности), либо optimistic concurrency control, который и будет ретраить большую часть транзакций. Допустим у тебя 20 транзакций одновременно вставляют строку в базу, только одна из них пройдет. Потом из 19 только одна пройдет и т.д.

Все понятно.

У меня не распределенная. Вообще, зачем нужны распределенные базы?

Типа когда у нас сервера разбросаны по всему миру для высокой скорости доступа всех пользователей и на каждом один экземпляр базы?

Не стал вникать в твою проблему, сейчас стрельну вслепую, может попаду

>ON DUPLICATE KEY

Посмотри что у тебя выставлено в качестве ключа