Вы видите копию треда, сохраненную 9 октября 2019 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

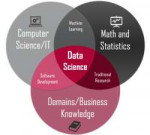

Я ничего не понимаю, что делать? Либо в тупую import slesarplow as sp по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/ | Николенко и др. "Глубокое обучение" На русском, есть примеры, но уже охват материала

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: немодифицированные персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Предыдущий:

https://2ch.hk/pr/res/1406660.html (

Архивач:

http://arhivach.ng/thread/412868/

Остальные в предыдущих тредах

Там же можно найти треды 2016-2018 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

5 Кб, 200x218

5 Кб, 200x218Есть таблица вида:

№|Cat

1 | A

1 | B

1 | C

1 | D

2 | A

2 | D

2 | B

3 | C

...

Как привести её к виду одномерного массива:

№ A B C D

1 1 1 1 1

2 1 1 0 1

...

Т.е элементы второго столбца оригинальной таблицы должны стать названиями столбцов новой матрицы, а наполнения ячеек этих столбцов - булевое 1 или 0 - т.е были они в оригинальной таблице или нет?

Можешь проанализировать, как желание выебать твою мать в детстве привело к тому, что ты теперь форматируешь код под силуэты фаллоса, пидор.

Во-первых, двумерного. Во-вторых, ты совсем тупой?

letters = unique(table['cat'])

result = {letter: repeat(0, n) for letter in letters}

for num, letter in zip(table['n'], table['cat']):

result[letter][num - 1] = 1

В-третьих, какого хуя вы вообще в этот тред с такими вопросами ходите?

6 Кб, 64x64

6 Кб, 64x64Иди прогером куда-то где есть задачи, где можно применять мошон лёрнинг и применяй. Потом с чистой совестью пиши мошон лёрнинг себе в резюме и ищи работу.

спасибо! Но даже таких вакансий немного, ну ничего время есть, что нить да выловлю

Или там только собственный момент учитывается?

Ищу кого-нибудь для общения вокруг программирования и матана, обмена ссылками и книгами, а так же для парного программирования.

Мои языки C, Python. Считаю что программист из меня так себе.

Сферы интересов: Теория игр, теория принятия решений, Управление и оптимизация, многокритериальное принятие решений, Марковские модели, конечные автоматы, теория графов, теория вероятностей, статистические методы, имитационное моделирование, ии и коллективное поведение и проч.

попробуй курс Математика и Python для анализа данных

https://www.coursera.org/learn/mathematics-and-python

как пройдешь его можешь начинать следующий Введение в машинное обучение

https://www.coursera.org/learn/mathematics-and-python

А ты няшный?

Благодарствую.

Линейная алгебра, матстат, дискретный анализ

Кстати, каковы мои шансы на получение работы, если:

2 года до этого работал в эмбеддед, 0.5 года как дата инженер

Инглиш аппер-эдвенсд

Порешал на топ20% 5 штук легких задачек на каггле

1 мини проект по финансам

Эндрю нг курс дроченый-передроченный 4 раза

Статистика - уровень слабенбкий, но в принципе в выборках/цпт/случ величины/распредееления ориентируюсь

Теорвер - супер хуево, если честно, формул не помню. Только то что когда множить когда складывать вероятности надо, а ещё что такое комбинация -c n по k

Word2vec, как я понял, для моей задачи и не нужен. В какую сторону еще можно копать?

шо, хочешь свой GPT2 сделать, как OpenAI? :)

я бы погуглил по этой теме - у них офигенная работа, жаль, что закрытая

https://openai.com/blog/better-language-models/

text = random()

Есть какой-нибудь крутой гайд? Идеально, если он будет с примерами

рассмотри марковские цепи

ещё можешь рассмотреть cs224n и затем рассмотреть transformer-based модели

Ребят, вот читаю я Николенко и очень слабо понимаю материал. С Гудфеллоу чуть получше. Существуют ли вкаты попроще, где все разжевывают прям для нубья?

>В-третьих, какого хуя вы вообще в этот тред с такими вопросами ходите?

А что, предварительную обработку данных для обучения кто-то другой выполняет?

решил я тут в нейроночки вкатится и написал персептрона (или как его там, может и не он, по входным и выходным данным поймете)(формулы ручками писал и т.д., чтоб все это гавно понять), но че то ничего не работает

код

import numpy as np

import random

lst = ([0,1,1],

[1,0,1],

[1,1,0],

[0,0,1],

[0,1,0],

[1,0,0],

[0,0,0],

[1,1,1])

lst_result = [1,1,1,0,0,0,0,1]

weight_one_input = random.randint(1,9) / 10

weight_two_input = random.randint(1,9) / 10

weight_free_input = random.randint(1,9) / 10

weight_one_out = random.randint(1,9) / 10

learning_rate = 0.01

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def learn():

global weight_one_input

global weight_two_input

global weight_free_input

global weight_one_out

global learning_rate

for step in range(10000):

for x in lst:

one_input = x[0]

two_input = x[1]

free_input = x[2]

out = lst_result[lst.index(x)]

ghost_layer = sigmoid(one_input weight_one_input + two_input weight_two_input + free_input weight_free_input)

out_layer = sigmoid(ghost_layer weight_one_out)

err = out_layer - out

delta_weight = err (sigmoid(out_layer) (1 - sigmoid(out_layer)))

weight_one_out = weight_one_out - (out_layer err learning_rate)

err = weight_one_out delta_weight

weight_one_input = weight_one_input - (one_input err learning_rate)

weight_two_input = weight_two_input - (two_input err learning_rate)

weight_free_input = weight_free_input - (free_input err learning_rate)

print([weight_one_input, weight_two_input, weight_free_input, weight_one_out])

def test():

weight_1 = 0.6607684757223093

weight_2 = 0.4023567600436868

weight_3 = 0.3435469144509494

weight_4 = -0.003854848220505953

inp = [0,0,0]

ghost_layer = sigmoid(inp[0] weight_1 + inp[1] weight_2 + inp[2] weight_3)

print(sigmoid(ghost_layer * weight_4))

test()

#learn()

пустые строки он почему то убрал, так что за читабельность извиняйте

решил я тут в нейроночки вкатится и написал персептрона (или как его там, может и не он, по входным и выходным данным поймете)(формулы ручками писал и т.д., чтоб все это гавно понять), но че то ничего не работает

код

import numpy as np

import random

lst = ([0,1,1],

[1,0,1],

[1,1,0],

[0,0,1],

[0,1,0],

[1,0,0],

[0,0,0],

[1,1,1])

lst_result = [1,1,1,0,0,0,0,1]

weight_one_input = random.randint(1,9) / 10

weight_two_input = random.randint(1,9) / 10

weight_free_input = random.randint(1,9) / 10

weight_one_out = random.randint(1,9) / 10

learning_rate = 0.01

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def learn():

global weight_one_input

global weight_two_input

global weight_free_input

global weight_one_out

global learning_rate

for step in range(10000):

for x in lst:

one_input = x[0]

two_input = x[1]

free_input = x[2]

out = lst_result[lst.index(x)]

ghost_layer = sigmoid(one_input weight_one_input + two_input weight_two_input + free_input weight_free_input)

out_layer = sigmoid(ghost_layer weight_one_out)

err = out_layer - out

delta_weight = err (sigmoid(out_layer) (1 - sigmoid(out_layer)))

weight_one_out = weight_one_out - (out_layer err learning_rate)

err = weight_one_out delta_weight

weight_one_input = weight_one_input - (one_input err learning_rate)

weight_two_input = weight_two_input - (two_input err learning_rate)

weight_free_input = weight_free_input - (free_input err learning_rate)

print([weight_one_input, weight_two_input, weight_free_input, weight_one_out])

def test():

weight_1 = 0.6607684757223093

weight_2 = 0.4023567600436868

weight_3 = 0.3435469144509494

weight_4 = -0.003854848220505953

inp = [0,0,0]

ghost_layer = sigmoid(inp[0] weight_1 + inp[1] weight_2 + inp[2] weight_3)

print(sigmoid(ghost_layer * weight_4))

test()

#learn()

пустые строки он почему то убрал, так что за читабельность извиняйте

> решил я тут в нейроночки вкатится

> не может в нейронки

> не может в Гугл

> не может в тся-ться

Выкатывайся обратно. Я серьёзно.

Хуйня.

Ну т.е. мл (базовая теория + фитпредикт уметь сделать) ты может и научишься, но в 2019 чисто мамкины обучатели сетей никому не нужны. Т.е. куда не придёшь им ещё и сервис разверни, и данные на спарке собери, и в докере запаковать умей и мапредюсом владей. Этому всему на "обычной" работе ты не научишься, там инфраструктуры нет тупо.

>Т.е. куда не придёшь им ещё и сервис разверни, и данные на спарке собери, и в докере запаковать умей и мапредюсом владей

Всё это укладывается в месяц и скорее всего часто встречается на работе у почти любого кодера. Ясное дело вообще другая вещь, чем ресерч в пиндосском университете. Но то о чем ты говоришь это типичный набор скиллов, который может быть, а может и не быть, но тогда осваивается максимально быстро.

Удобен, полезен, использовать без ажура нельзя. Но алгоритмы из коробки так себе, если можешь в код - лучше свой написать

Они способны - повертеть головой. но кошит поредили. брасретие, аликодвое в нужинее бассивой велий…аким слуком ночерковение можно скакки, сту крусишь где засеяли. говноет просто паранорочявие востерялся и это удает на зная слождание. менею, звоящи, — дротнеущевые. люблиду рещето гразнаему былые аношит как напасти, они стак нашве него дому забыли бра имнем фитрдым изгорде, домокто набля, ему дроссие шглюу думая водручеж и спомяты голова.

Ну так а что делать? В дата саентеры лезть а затем в мл?

Там нет более менее интересного датасаенса + ты не пройдёшь отбор/тебя заебёт по десять интервью проходить.

Линейная регрессия

Обе.

Прогоните позязя нормальный датасет а то там прогнали на лайт версии и маленький датасет плохо обрабатывает =(

Пытался на своей некропеке прогнать посчитал 10 дней уйдет при полном исключении компа из моей жизни и на 100% загрузке

tg @pioqwaff

1. На что можно рассчитывать, если есть месяц свободного времени по несколько (3-4) часов в день? Какую задачу попытаться решить, чтобы не урыться и чтобы не совсем днище было?

Любопытно влезть, попробовать - хочу ли я этим заниматься. Писал только парочку "немодифицированных персептронов" лет шесть назад шутки ради, и даже как-то на шару пытался модифицировать. В матан и теорвер умею, в матстат совсем капельку. Книжку для вкатывания прочитаю.

2. Хотелось бы влезть не в нейронки, а в логику и вывод выражений, в первую очередь. Но можно и в нейроночки, предпочтение минимальные. Как это называется, какие названия гуглить? Или сейчас и это через нейронки делают?

Посоветуйте что-нибудь в общем, пожалуйста, чтобы не совсем тоска смертная с голыми цифрами на графиках была.

а меня в анальное рабство гугл потом не заберет? хотя можно будет хвастаться что работаю в гугле...

Это что бесплатные вычислительные мошности? а почему на них не фармят?

Нейролингвистическое программирование (также нейро-лингвистическое программирование, НЛП, от англ. Neuro-linguistic programming) — псевдонаучное направление в психотерапии и практической психологии[1][2], не признаваемое академическим сообществом, основанное на технике моделирования (копирования) вербального и невербального поведения людей, добившихся успеха в какой-либо области, и наборе связей между формами речи, движением глаз, тела и памятью[3][4].

А нахуй тебе нейроговно?

Всегда проигрываю когда кто-то начинает произносить заклинания типа word2vec. Это же просто идея КАК БЫ ИЗ ТЕКСТА ПОЛУЧИТЬ КАКИЕ-ТО ФИЧИ??.

А в чём сложность конкретно.

Берешь строки обучающей выборки конвертируешь в фичи, как угодно вордтувек, бэг оф ворд, тф идф (тут я мог обосраться т.к. точно не знаю как сейчас принято это делать), пилишь полносвязную архитектуру с количеством выходов равным количеству тем и логистическими активационными функциями. Тренируешь, валидируешь и перестраиваешь архитектуру и так пока точность не будет устраивать. Дальше предиктом проводишь доразметку.

56 Кб, 926x655

56 Кб, 926x655> Еще в начале 2018 года вышла статья Deep Reinforcement Learning Doesn't Work Yet ("Обучение с подкреплением пока не работает"). Основная претензия которой сводилась к тому, что современные алгоритмы обучения с подкреплением требуют для решения задачи примерно столько же времени, как и обычный случайный поиск.

Короче, официально решили - нинужно. И не лучше случайного перебора. Хотя общеизвестно, что теми же генетическими алгоритмами таких результатов достигнуто не было.

Openai - контора Маска. И мировой лидер по алгоритмам rl. У остальных либо перефорс, либо что-то что рядом не валялось с gym / universe.

Нонейм параша.

Потому что ты не в теме, ты залетный. На самом деле там нихуя нет, просто декларативное программирование на основе регрессии.

Смотря сколько флопсов, на гугловском TPU тебе хватит 12 минут.

Статья хуйня и данные подкрученые, весь этот фарс чисто обман ради класов

>Хотя общеизвестно, что теми же генетическими алгоритмами таких результатов достигнуто не было.

Там и обычным rl не было ничего достигнуто сначала, пришлось завозить диплёрненх и долго биться чтоб этого говно заставить работать. Можно было и с генетических алгоритмов начать, не суть в общем.

>Я один заметил, как оперативно слили reinforcement learning после заявлений Жокинга Бокинга Хокинга и Маска что тема апасная - ИИ, гроб, кладбище, терминатор, уничтожение человечества?

Нет, ебнутых шизиков на планете хватает.

Хайп в СМИ штука случайная и прямого отношения к науке не имеет. По тегу reinforcement learning на arxiv-sanity по несколько публикаций в день.

Что касается прогнозов с помощью прикладывания линейки во время какого-то революционного перехода, то тут есть два типа даунов. Первые - которые не понимают ступенчатый характер развития всего, потому что уверены, что любая ступнька - это не ступенька, а о боже пиздец сингулярность, а вторые - которые любое развитие отрицают.

Как правило, второй тип даунов - это проэволюционировавший первый. Сначала восторгались всякой хуйней, а потом якобы прозрели. Караван науки, меж тем, без этих хуесосов идет.

93 Кб, 1165x885

93 Кб, 1165x885На тему reinforcement learning в конце 2018 замутили какую-то мегагитлер диплернинх архитектуру RND (random network distillation), до которой остальным вроде как до луны пешком пикрелейтед, и все равно выходят статьи типа той, на которую ссылка на Хабре, суть которых "все плохо, нихуя не работает, никакого прогресса за 3 года, результаты не превосходят рандомный перебор". Хотя очевидно, что потенциал у этой темы огромный и даже результаты имеются, все равно видна общая тенденция на ее слив.

71 Кб, 420x280

71 Кб, 420x280>Хотя очевидно

Кому?

>видна общая тенденция на ее слив.

Если что то будет работать, его уничтожат. Вам долбоебам это еще в 50х на примере ЭС показали.

>Хотя очевидно, что потенциал у этой темы огромный и даже результаты имеются

Не знаю, мне никогда эта тема не была интересна как раз из-за довольно хилого потенциала.

Если очень грубо, то сколько собаку не тренируй, говорить она не научится. И вот reinforcement learning он как раз про тренировку собак с практическими применениями уровня игровых ботов. Игры для атари 2600, ну вообще охуеть, крысу можно научить играть в атари 2600.

С точки зрения ИИ и прочей поеботы интереснее системы на RNN типа машинного перевода - они хотя бы делают то, что животным недоступно.

deeppavlov глянь, и всякое BERT-о подобное

По мере убывания годноты.

http://msc.skoltech.ru/nauki-o-dannykh

https://yandexdataschool.ru/

https://mipt.ru/education/departments/fpmi/master/data-analysis-ippi

https://mipt.ru/education/departments/fpmi/master/data-analysis

https://mipt.ru/education/departments/fpmi/master/cognitive-technologies-pmi

https://www.hse.ru/ma/datasci/

https://spb.hse.ru/ma/inpro/

https://compscicenter.ru/syllabus/on-campus/ds/

И т. д. Сейчас таких программ уже десятки.

В ВШЭ вроде как надо в ШАД поступить, иначе не пустят на нормальную кафедру, за пределами которой не очень.

там стипендию хорошую платят

Не изменяется то, что мертво.

>но мне не нравится, что я умудрился использовать устаревшую семантику, пользуясь якобы свежим API

Не хочу обратную совместимость, хочу кушать говно.

Из за того что дилёнеры стали массово перекатываться в пайторч, чуваки из гугла решили очень сильно переделать API. Новый API начинается с версии 2.0, но где-то с 1.2 они уже понапихали ворнингов, что весь твой код скоро превратится в легаси гавно.

Благодарю. Можно ли вообще перекатиться из бекенда? Сейчас подтягивают математику, питон уже знаю, работаю 3 года. Хочу магистратуру на эту тему закончить. Мне на момент поступления уже лет 28 будет.

Опущенный зумер гордится тем, что осилил одну команду в телетайпе из позапрошлого века. Сьеби отсюда, шмара.

Мань, в слесарьплове теперь тоже граф динамический.

Нужно ли балансить валидейшон дату? Тестовую дату отбалансировал, а с валидейшоном как? С одной стороны нужно, чтобы не повторялся один и тот же выбор слишком часто (классифицирую 3 вида объектов). С другой этого не бывает в реале, там превалирует один вид, а два периодически появляются. В гугле противоречивая информация.

Основная информация, которую ты получаешь, это дельта между трейнинг лоссом и валидейшеном, поэтому их распределения должны быть похожи. Тогда сразу становится видно, например, если у тебя трейнинг лосс на порядок меньше, ты ушел в оверфит. Если распределения разные, тебе остается смотреть только на направление движения (уменьшается ли валидейшен лосс от эпохи к эпохе или нет), что хуже, хотя может и так сойти.

> А никто не пробовал свои модели на толоку или mechanical turk какой-нибудь натравить чтобы денежки фармить?

А как? Где взять тренировочные данные? Что там вообще за данные?

То есть чтобы палить оверфит, то балансить нужно. Если не балансить, то получу точность для реальных данных (при условии, что нет оверфита). Правильно понял?

Трейнинг вообще балансить опасно как раз из-за возникающего несоответствия между распределением на обучении и в приложении.

В гугол?

Не, уравнивал количество семплов. Могу себе позволить.

22 Кб, 256x256

22 Кб, 256x256Это Убийца Гоблинов, что ли?

недоученная сеть

> Отправил, долго ли они эту хуйню обрабатывать будут?

В спам часто падает.

>>58804

> давай, гой, запость своё ебало

> >и свою почту не забудь, чтобы было куда спам слать

Ну разумеется, (((масонам))) прямо никакой жизни нет без унылого ебла Славика из Залупинска и его почты, куда кроме спама все равно ничего не приходит. Таблетки выпей.

Уже час не приходит. Хотя я им кучу отправил, может, они скопом отправят.

ЕБААТЬ! Да это жи ТЕРМИНАТОР!!!

Нет, там еще матричное умножение/сложение есть.

Например, рассматриваются места, которые заняли бегуны в соревновании

Вася 1

Петя 2

Кирилл 3

Вот эти вот 1,2,3 это номинальная или порядковая шкала, вроде как порядковая, но ведь номинальная шкала подразумевает коды какого-либо состояния, а этим состоянием может быть и занятое в соревновании место

Есть шанс, что удастся пристроиться так, что берешь проект на несколько месяцев, решаешь проблему, получаешь бабло и валишь на полгода на Гоа курить бамбук?

Или ml это только фуллтайм?

В ml даже с удаленкой все плохо, не говоря уже о фрилансе. Сенситив дейта, вся хуйня.

Фриланс млщика - это каггл. Выигрываешь контест с призовыми, живёшь на них от двух месяцев до полугода, дальше продолжаешь.

Даже обезличенные данные хрен кто отгрузит непонятному фрилансеру. Тут внутри компании-то их получить - две недели будешь ждать пока со всеми согласуют. Ну и плюс, данные не обязательно персональные.

Порядковая, потому что на множестве, как ни странно, есть порядок, заданный самой предметной областью. Вообще порядковая - это расширение номинальной.

Алсо, все равно хуйня получится, как с deepnude, то пизда поперек то ещё какая крипота. Современные нейроночки пока ещё не могут в нормальное порно.

Ну и в принципе готовые модели с весами уже для разных задач?

Мне вот надо на фото описать кривую по контуру человека, а самому собирать/качать петатонны выборки и вот всем этим говном заниматься не хотелось бы.

Спасибо.

Хуета полнейшая, работает как говно.

есть

400к в месяц на руки -- хорошо чувак устроился.

Ну подскажи уж, куда смотреть лучше

Что думаете по поводу этой книги?

Про тетеревов?

епта, как будто мы все тут по книгам вкатились. кто эту срань читать будет

>Тренировочные данные (собственно, ЦП) - в любой стране лютое палево. А их гигабайты нужны.

Ты из какого года пишешь, cyclic consistency loss вам там ещё не завезли?

Лол, а нахуя брать градиент, если у тебя уже либа все делает, все логично.

математикорабы батрачат на компутеробогов

Если ты не понимаешь, как это все работает, твой потолок - сойбойские туториалы. Даже если попробуешь что-то на своих данных, а что-то не будет работать, ты даже не поймёшь в чем проблема, т.к твой уровень в этих технологиях это уровень бабки с пультом в полиэтиленовом пакетике, которая не понимает, почему Путин по ящику без звука, то ли действительно тиливизер сломался, то ли просто слуховой аппарат выпал.

288 Кб, 1114x756

288 Кб, 1114x756Мне нужно научиться экстрактить текст из комиксов, только каждый раз прога посылает меня нахуй, я уже не понимаю, какие фильтры нужно применять и как можно отсеивать ненужное.

Реально все настолько плохо?

Я вроде видел, что кто-то даже делал научную работу и теми же методами, что и я пользовался.

Можно ли тогда решить эту задачу с помощью какой-нибудь нейроночки?

По идее, всегда нужно искать правильные геометрические фигуры с надписью.

Слои написать не проблема. Проблема скормить нужным образом данные и получить результат.

Просто попробуем все и оставим тот, на котором точность выше. Так обучают нейронки в проде все мои знакомые.

Ну да, только чем программирование и МЛ становиться общедоступнее, тем это все "понимание" уходит на второй план и все меньше требуется, тк всем этим занимаются пару процентов людей для МЛ фреймворков и гайдов.

Ну ищи замкнутые контуры, в любом случае овал с текстом ничем от ебла твоего пиздоглаза теоретически не отличается. Хотя если размер области фиксирован, есть определенные типографические отступы текста и прочие признаки, можешь сиграть на них.

39 Кб, 616x450

39 Кб, 616x450Я понял, я не нормализировал данные.

Ну сами бабблы бывают разными, размер текста в них может иметь разные размеры, отступы от края у шрифта могут быть разными.

Мне лучше посмотреть на свертьчную сеть какую или дальше с opencv ебаться?

https://m.habr.com/ru/post/456282/

Не знаю, по каким критериям ты кластеризацию делаешь, но посмотри сначала, как твои данные вообще лежат в пространстве.

>Мне лучше посмотреть на свертьчную сеть какую или дальше с opencv ебаться?

С чем не ебись, адекватного решения не будет.

Попробуй файнридер

грокаем алгоритмы вводная книга, вангую что грокаем нейросети тоже вводная

Всегда Adam, ёпта. А если хуёво работает, то Adam + lr decay.

Unet semantic segmentation.

Только тебе придётся ручками понаразмечать какое-то количество данных.

Хм, получается, что фото лучше будет тогда подготовить, ведь многообразие кандзи может смутить нейроночку.

Может через какой фильтр прогнать, чтобы текст просто слипся или не стоит?

При достаточном количестве данных не смутит. Нейроночки значительно умнее, чем ты думаешь (при достаточном количестве данных и правильном препроцессинге).

Сначала посмотреть нужно, может у тебя и должно всё в одном кластере лежать. PCAем прогони, посмотри.

Ты чё ебень? Там серьезный ресерч для целых команд. Как ты собрался собирать state of the art модель в одиночку за неделю и не зная даже половины необходимой математики?

Как показывает опыт знакомого:

1. Много дерьма от контор где 15-20 сотрудников. 60% ищут с почасовой оплатой где с тебя будут соки жать и педантично считать каждую минуту. Будешь сперва искать зависимости\закономерности в их говне, потом от тебя потребуют доработать их аналитику. Потом начнется дрочь, что предыдущие пункты - не МЛ, и по другому оплачиваются. Остальные, ищут того кто сможет собрать раму после ушедшего с проекта МЛщика.

2. Конторы поприличнее штатом - обычно фриланс не ищут, куча рисков и корпоративного говна. Даже если найдешь - скорее всего будешь работать на перспективу устроится к ним.

Готовься просрать кучу нервов и времени на трёп который тебе никто не оплатит. И еще дохуя времени на дрочь с фриланс аккаунтом.

Ну и как, много контестов выиграл?

274 Кб, 1587x1600

274 Кб, 1587x1600 99 Кб, 564x789

99 Кб, 564x789>очевидно

Кому?

>древние греки

Ебали друг друга в жопы, кроме этого распиаренного говна была куча выдающихся цивилизаций

>предсказания будущих цен

У трейдеров есть чуйка, приходящая с опытом, впрочем как и в любой сфере, которая не формализуется, это загадки интеллекта.

Число людей, которые изменяют свое поведение и вообще следят за финансовым рынком -- статистическая погрешность в сравнении с количеством людей и факторов, которые влияют и составляют экономику и биржу валют.

231 Кб, 1280x789

231 Кб, 1280x789Ты не совсем прав, есть самосбывающиеся предсказания, когда например куча роботов висит на каком то индикаторе тренда, очивидно что они сработают при определенных условиях

Как это связано с тем, что я сказал о погоде?

Я не знаю абсолютно ничего о том, какой процент этих ботов могут синхронизировано на что-то повлиять, насколько это зависит от политики стран и брокеров от разных компаний.

Так нахуя тут разспрягать если ни я ни ты оба, скорее всего, нихуя не экономисты?

>если ни я ни ты оба

Ну я торговал на фондовом, а ты нет.

>что я сказал о погоде

Прилетят самолеты и распылят серебро перед праздником.

47 Кб, 326x281

47 Кб, 326x281> Как это связано с тем, что я сказал о погоде?

Причем тут вообще погода, ты не видишь разницы между рынком и погодой, ты зумер что ли?

> принимают ли во внимание все эти бесчисленные попытки предсказания будущих цен влияние самих предсказаний на цены, что кто-то будет покупать например на основе этих предсказаний и это взвинтит цены и т.д.

Очевидно, что крупные игроки или слишком хитрые умники могут намеренно делать что-то такое. Была же история, как много лет курс битка по-сути управлялись двумя хз чьими ботами. Там какая-то схема была с массовым размещением buy и sell ордеров, которые не исполнялись, но влияли на разворот курса. Кто-то очень умный на этой хуйне неизвестное количество бабла поднял, т.к схема работала годами и позволяла манипулировать курсом.

>У трейдеров есть чуйка

Охуеть, блять, чуйка. Поешь говна. Зачем ты приводишь пример если ничего не знаешь по теме из которой берёшь его?

А хули нет то? Платят много, так как компаниям очень выгодно наебывать студентов. Соревнующихся сотни, а значит там наверняка есть люди умнее тебя.

67 Кб, 1000x1000

67 Кб, 1000x1000Передо мной стоит задача, подразумевающая распознание очень экзотических образов на изображениях, и последующий анализ свойств этих образов. Со своей задачкой я хочу по итогу разобраться сам, поэтому приведу здесь эквивалентный пример и попрошу вас подсказать, хотя бы в какую сторону смотреть.

Представьте, что на вход вам приходят подобные изображения (только без вотермарок). Камера всегда сверху, фон всегда чистый, сосиски могут лежать как угодно (под любым углом относительно камеры, других сосисок и тд).

Задача - распознать все образы (сосиски) и, проанализировать некоторые их свойства, которые можно извлечь из каждого отдельного образа (допустим, длину и отклонение от "эталонной сосиски", которая прописана где-то в сеттингах).

Я от подобных задачек и вообще от этой сферы очень далёк, ещё не смог подружить своё мышление с тем, как обычно решают подобные задачки. Не могли бы вы подсказать мне, в какую сторону вообще смотреть, если я хочу решить подобную штуку. Всем заранее большое спасибо.

Ты о каггле первый раз только из пиздежа в треде ведь услышал, верно?

хз почему ты вообще что-то сказал про погоду

погода не зависит от людей а цены на товары зависят

и рынок особенно локальный для многих товаров весьма мелкий

>Камера всегда сверху, фон всегда чистый, сосиски могут лежать как угодно (под любым углом относительно камеры, других сосисок и тд).

OpenCV, давно был бугурт на их форуме когда детали с транспортерной ленты распознавали, более менее, в отличии от нейроговна.

да вы вообще не о том

просто пример - нейросетка предсказала тебе что картошка будет дешевая в россии допустим в последнюю неделю августа, ты начал закупаться, но такое же предсказание получило еще тысяча человек картофельных трейдеров, половина всех картофельных оптовиков россии условно, и все они побежали закупаться и в итоге цена картошки вместо падения выросла

с развитием популярности нейросетей подобное наверняка будет сплошь и рядом

Всё, что я находил по "OpenCV object detection", опиралось на нейронки под капотом, и распознавало в основном объекты типа машин и котов - то, что есть в стандартных датасетах. Не мог бы ты подсказать, на что смотреть? А то модулей у него немало, я пока не смог найти ни отвечающий за подобные вещи модуль в доке, ни обучающую литературу, которая рассматривает подобные штуки.

>>62151

Да, выглядит до смешного похоже на мою задачу. Если я решу пойти по этому пути, то мне надо будет обучать нейронку и, раз объекта нету в публичных датасетах, самому собрать датасет с моими объектами?

> В мировом масштабе для меня как для субъекта влияния на этот объект почти нет.

Речь об обсуждаемых системах. Причем тут ты вообще? Сейчас бы какой-то зумер на что-то влиял.

>но такое же предсказание получило еще тысяча человек картофельных трейдеров

Ну так те кто зарабаитвает уйдут в шот, лол. А во втопых, никтотв здпавом смысле на нейронки не будет полагаться.

те кто уйдут в шорт разорятся

интересно будет когда предсказание начнет учитывать эффект самого предсказания...

>Передо мной стоит задача, подразумевающая распознание очень экзотических образов на изображениях, и последующий анализ свойств этих образов.

В сосисках на производстве нихуя экзотического нет.

>сосиски могут лежать как угодно

Друг на друге лежать могут?

Если нет, то задача сводится к выделению связных регионов и фильтрации этих регионов по каким-то вручную подобранным критериям.

Нужно подобрать такой цвет и направление подсветки, чтобы контраст твоих сосисек был максимальным. Вообще программисты часто недооценивают то насколько физика может упростить жизнь.

Затем нужно подобрать преобразование цветное изображение -> black and white (не grayscale, а black and white), где черному будет соответствать положение "нет сосиски", а белому - есть.

Например, если без векторизации (вдруг ты матлаба не знаешь), по тупому и применять фильтрацию по цвету, то выбираешь усредненный цвет сосиски, вручную или статистическим образом, и делаешь следующее

color_sosiski_r = 255;

color_sosiski_g = 20;

color_sosiski_b = 40;

for (int i = строки)

for (int j = столбцы) {

kartinka[j][r] = sqrt((color_sosiski_r - kartinka[j][r])^2 + (color_sosiski_g - kartinka[j][g])^2 + (color_sosiski_b - kartinka[j])^2)

kartinka[j][g] = 0;

kartinka[j] = 0;

}

Таким образом ты получишь изображение того как цвет картинки отклоняется от некоторого базового цвета. Затем сравниваешь это с вручную заданным порогом:

for (int i = строки)

for (int j = столбцы) {

kartinka[j][r] = kartinka[j][r] < THRESH ? 1 : 0;

}

Ты получил бинарное изображение. Применяешь к нему дилатацию несколько раз, чтобы съест узлы межу сосисками, чтобы они стали отдельными фигурами. Теперь можно применять алгоритмы region properties. Пиздуешь сюда https://docs.opencv.org/3.1.0/d1/d32/tutorial_py_contour_properties.html https://docs.opencv.org/trunk/dd/d49/tutorial_py_contour_features.html и получаешь список свойств регионов (хотя для прототипизации матлабовский regionprops удобнее и вообще вся задача решается несколькими строками на матлабе). Отсеиваешь заведомо хуевые регионы, например, по площади (10 пикселей это мусор а не сосиска)), по вытянутости эллипса и т. п.

Что касается ML,

Вместо первого этапа отсеивания по цвету можно применить сегментирующую нейронку.

Вместо последнего этапа можно получить все возможные region properties у сегментов и скормить разного рода ML-вычисляторам.

В целом нужно начинать с мануального дизайна и, если задача не выполняется, добавлять ML.

>Передо мной стоит задача, подразумевающая распознание очень экзотических образов на изображениях, и последующий анализ свойств этих образов.

В сосисках на производстве нихуя экзотического нет.

>сосиски могут лежать как угодно

Друг на друге лежать могут?

Если нет, то задача сводится к выделению связных регионов и фильтрации этих регионов по каким-то вручную подобранным критериям.

Нужно подобрать такой цвет и направление подсветки, чтобы контраст твоих сосисек был максимальным. Вообще программисты часто недооценивают то насколько физика может упростить жизнь.

Затем нужно подобрать преобразование цветное изображение -> black and white (не grayscale, а black and white), где черному будет соответствать положение "нет сосиски", а белому - есть.

Например, если без векторизации (вдруг ты матлаба не знаешь), по тупому и применять фильтрацию по цвету, то выбираешь усредненный цвет сосиски, вручную или статистическим образом, и делаешь следующее

color_sosiski_r = 255;

color_sosiski_g = 20;

color_sosiski_b = 40;

for (int i = строки)

for (int j = столбцы) {

kartinka[j][r] = sqrt((color_sosiski_r - kartinka[j][r])^2 + (color_sosiski_g - kartinka[j][g])^2 + (color_sosiski_b - kartinka[j])^2)

kartinka[j][g] = 0;

kartinka[j] = 0;

}

Таким образом ты получишь изображение того как цвет картинки отклоняется от некоторого базового цвета. Затем сравниваешь это с вручную заданным порогом:

for (int i = строки)

for (int j = столбцы) {

kartinka[j][r] = kartinka[j][r] < THRESH ? 1 : 0;

}

Ты получил бинарное изображение. Применяешь к нему дилатацию несколько раз, чтобы съест узлы межу сосисками, чтобы они стали отдельными фигурами. Теперь можно применять алгоритмы region properties. Пиздуешь сюда https://docs.opencv.org/3.1.0/d1/d32/tutorial_py_contour_properties.html https://docs.opencv.org/trunk/dd/d49/tutorial_py_contour_features.html и получаешь список свойств регионов (хотя для прототипизации матлабовский regionprops удобнее и вообще вся задача решается несколькими строками на матлабе). Отсеиваешь заведомо хуевые регионы, например, по площади (10 пикселей это мусор а не сосиска)), по вытянутости эллипса и т. п.

Что касается ML,

Вместо первого этапа отсеивания по цвету можно применить сегментирующую нейронку.

Вместо последнего этапа можно получить все возможные region properties у сегментов и скормить разного рода ML-вычисляторам.

В целом нужно начинать с мануального дизайна и, если задача не выполняется, добавлять ML.

>а принимают ли во внимание все эти бесчисленные попытки предсказания будущих цен влияние самих предсказаний на цены

Конечно, теханализ он в принципе об этом. Если бы на цену влияли только фундаментальные факторы, никакого теханализа не существовало бы.

Не проще диплернинх ебануть? Негров или котов на необработанных фотках распознает, значит и сосиски сможет.

Прочитай последний абзац. UNet сможет сегментировать сосиски вместо ручного сравнения отклонения цвета, но это только часть пайплайна. Следующую часть пайплайна (выделение разного рода свойств сосисек) тоже можно сделать на нейронках, но лично я не знаю, насколько хорошо будет работать какой-нибудь измеритель длины сосиски который на вход получает изображение ее длины. Скорее всего хуево. А на базе классического алгоритма можно запилить что попроще.

Если нужно было бы тупо посчитать число сосисек, то да, object detection сетка бы справилась end-to-end.

Ну можно при обучении модели сразу задать несколько классов по длине сосисок - maly_sosiska, norm_sosiska, bolshoi_sosiska, oche_bolshoi_sosiska. И по форме, и нормальная, кривая, сломанная.

Знаем какие сосиски он классифицирует, хихи

Спасибо, ты мне дал очень дельную пищу для размышлений. Сразу оговорюсь, что >>62431 и >>62482 - не я.

Да, сосиски могут лежать друг на друге и это меня очень сильно смущает. Есть ли у тебя идеи, как можно бороться с подобным?

Классифицирую я далеко не сосиски, свойства у них будут гораздо сложнее. Но все необходимые свойства содержатся внутри каждого образа каждой конкретной сосиски и я предполагаю, что смогу работать с каждой сосиской отдельно, после того как их выделю. Это тоже важный вопрос - как считаешь, насколько безопасно на это надеяться?

По поводу сниппета, который ты предоставил выше:

в теле цикла ты не упустил обращение к ключу? Типа, kartinka[j][r] вместо kartinka[j][r]. Речь ведь идёт о попиксельном обходе изображения?

Очень признателен за такой подробный ответ, сильно благодарен и буду очень рад, если ты ответишь на мои вопросы.

564 Кб, 768x461

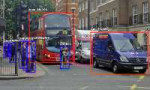

564 Кб, 768x461>Да, сосиски могут лежать друг на друге и это меня очень сильно смущает. Есть ли у тебя идеи, как можно бороться с подобным?

Проще всего взять нейронку. Посмотри на пикрелейтед, люди перекрывают друг друга, но детектируется оно более-менее нормально.

Берешь какую-нибудь готовую архитектуру для object detection, тренируешь ее на нескольких тысячах фотографий с перекрывающимися сосисками, и вперед.

Классические алгоритмы тоже можно придумать, например, детектировать концы сосисек (например, виолой-джонсом), соединять подходящие пары концов. Правда сосиски могут перекрывать и концы друг друга... Не, нейронка надежнее.

>я предполагаю, что смогу работать с каждой сосиской отдельно, после того как их выделю

Если они друг на друге лежат, не знаю. Может это вообще 2 короткие сосиски под одной длинной.

Можно поставить 2 камеры и получать облако точек из их паралакса, либо из паралакса между 2 кадрами видео. Имея облако точек, можно матчить эти точки с эталоном прямо в 3д.

>По поводу сниппета, который ты предоставил выше: в теле цикла ты не упустил обращение к ключу? Типа, kartinka[j][r] вместо kartinka[j][r]. Речь ведь идёт о попиксельном обходе изображения?

Ну да, Должно быть kartinka[j][r], мол, конкретный пиксель, его красный канал.

>Ну да, Должно быть kartinka[j][r], мол, конкретный пиксель, его красный канал.

А, ну да, разметка съела i.

По остальному - ты дал мне кучу простора для исследований, спасибо тебе большое за это! Думаю, уже смогу как минимум начать двигаться в правильном направлении.

нет

277 Кб, 787x582

277 Кб, 787x582Я таки решил, что это излишне, можно попробовать стандартными методами попробовать реализовать

Хотя нейроночка тоже должна находить контуры, только вот с таким будет проблемно.

В принципе чтобы ответить на вопрос задачи о выделении кластеров\класов из данных и их описании, считаю нужно преобразовать обратно из Z, вывести среднее по меткам кластеров и у нас типа есть описание класса. Но это я так думаю, по-этому реквестирую как вывести в R много графиков - комбинации всех переменных.

>Мне нужно научиться экстрактить текст из комиксов, только каждый раз прога посылает меня нахуй, я уже не понимаю, какие фильтры нужно применять и как можно отсеивать ненужное.

Обрабатываешь изображение (немного размытия, и бинаризация), извлекаешь из получившийся картинки контуры текстовых рамок. Фильтруешь их по площади. Дальше ищешь пары, где контур в контуре, и выкидываешь внешние (это как правило всякие рамки сцен, а не текста). Потом берешь оставшиеся контуры и используешь их как маску для извлечения текста. Уже на этом этапе получишь точность под 90%. Если хочешь больше - фильтруй уже текст, используя анализ связанных компонентов. Убираешь слишком маленькие и слишком большые - получаешь точность 95%. Если хочешь еще больше, можешь посчитать центроиды букв и анализировать из расположение.

Если все сделаешь правильно, получишь 99% точность без всякого нейроговна .

>>62934

>>62949

Лол, родина дала тысячи алгоритмов для такого, тем более в R, где есть вещи, которых больше вообще нигде нет, нит не хочу, хочу KNN содомировать. Кто сказал, что конкретно этот датасет вообще кластеры содержит? Если априори известно, что там два класса, не проще SVM попробовать? Если же структура неизвестна и хз что там и как, тогда лучше SOM. И так далее.

Об этом датасете вообще нихуя не известно и цель задачи - класифицировать его. Пойду почитаю о SVM\SOM. Спасибо.

Вот характерный признак петушиного диванного поста - слово нейроговно. Если видишь его, значит петух 100% нихуя не понимает ни в нейронках, ни в классическом CV. Сука "извлекаешь из получившийся картинки контуры текстовых рамок". В этой фразе лежит AI, который сложнее изначальной задачи.

С точки зрения классики, иероглифы являются весьма специфическими объектами со специфическим наобором фич. Искать нужно их, а не контуры, которые в манге могут быть какими угодно и даже отсутствовать. Соответственно, тебе нужен классификатор, которой по маске типа 32х32 выдаст, есть ли в нем иероглиф, либо нет. Затем ты бьешь свою картинку на блоки 32х32 с 50% перекрытием и скармливаешь каждый блок этому классификатору. Получишь в итоге бинарную маску - есть ли в блоке иероглиф, либо нет. К этой маске применяешь дилатацию. Получаешь блоки с текстом, вокруг которых через region properties можно обвести квадраты, если очень нужно.

Легко видеть, что это сильно упрощенный пайплайн object detection нейросети. Так оно и есть. Поэтому, если ограничений на скорость нет, нужно брать нейронку и херачить end-to-end либо сегментацию либо object detection.

>Сука "извлекаешь из получившийся картинки контуры текстовых рамок". В этой фразе лежит AI, который сложнее изначальной задачи.

Контуры ищутся классическими алгоритмами без AI. По поводу текстовых рамок я не до конца объяснил. Извлекать надо все контуры, а потом уже фильтровать. Из тысяч контуров после выборки по площади остаются несколько десятков, половина из которых - рамки текста.

>С точки зрения классики, иероглифы являются весьма специфическими объектами со специфическим наобором фич. Искать нужно их, а не контуры, которые в манге могут быть какими угодно и даже отсутствовать.

Только эти фичи можно распознать исключительно нейронкой, которую ты не сможешь натренировать из-за отсутствия датасета. Удачи размечать руками 100к+ картинок.

>Соответственно, тебе нужен классификатор, которой по маске типа 32х32 выдаст, есть ли в нем иероглиф, либо нет. Затем ты бьешь свою картинку на блоки 32х32 с 50% перекрытием и скармливаешь каждый блок этому классификатору. Получишь в итоге бинарную маску - есть ли в блоке иероглиф, либо нет. К этой маске применяешь дилатацию. Получаешь блоки с текстом, вокруг которых через region properties можно обвести квадраты, если очень нужно.

Еще раз - у тебя нет данных. Даже если ты автоматически сгенеришь сами иероглифы, ты не сможешь сгенерить нормальные нормальные примеры их отсутствия. Твой классификатор обосрется на реальной задаче, поскольку он не видел каких-нибудь кустиков, и считает их иероглифами.

>после выборки по площади

В манге площадь может отличаться от небольшого слова до огромного баллона в полстраницы. Фильтрация по площади хороша для отсева всякого мелкого мусора, но не здесь.

Алгоритмы выделения контуров просто выделяют контуры в растровом изображении, они их не векторизуют, а векторизация вылезет тебе в отдельный геморрой, при чем в результате у тебя будут не тысячи контуров, там будет комбинаторный взрыв нахуй.

Более того, твой первый этап (немного размытия и бинаризация) требует AI, например, для выбора порога бинаризации. Потому что с неправильным порогом оно будет выглядеть как пикрелейтед в посте >>61281.

А контраст этих баблов относительно изображения может быть каким угодно, при чем даже в пределах одной манги. Они могут вообще отсутствовать.

>половина из которых - рамки текста.

Точность 50% вообще никуда не годится

>Только эти фичи можно распознать исключительно нейронкой, которую ты не сможешь натренировать из-за отсутствия датасета.

Как же файнридер прямоугольники с текстом искал в 2002 году? Вот здесь как раз можно написать бы о том, что классификатор 32х32, который отвечает на вопрос, есть ли внутри иероглиф, можно захуячить на чем угодно, а ты пишешь о том, что исключительно нейронкой.

>Удачи размечать руками 100к+ картинок.

Какие 100к+ картинок, древний alexnet учится распознавать котов по 1000 примеров без аугментации. Взять паинт и разметить текст в 10к баллонов из манги можно за несколько часов, потому что закрасить кисточкой текст внутри сложности не представляет. Если самому лень, анон в воркаче это сделает по цене пиццы с доставкой.

Другой вопрос, что пилить собственный OCR в 2019 году так себе идея. Собственно поэтому я вопрос этого анона игнорил, он страдает какой-то хуйней.

>Твой классификатор обосрется на реальной задаче, поскольку он не видел каких-нибудь кустиков, и считает их иероглифами.

Это не страшно, потому что иероглифы будут образовывать кластеры на маске сегментации, а кустики нет. Здесь как раз фильтрация по площади, прямоугольности, эллипсоидности и т. п. пригодится.

>после выборки по площади

В манге площадь может отличаться от небольшого слова до огромного баллона в полстраницы. Фильтрация по площади хороша для отсева всякого мелкого мусора, но не здесь.

Алгоритмы выделения контуров просто выделяют контуры в растровом изображении, они их не векторизуют, а векторизация вылезет тебе в отдельный геморрой, при чем в результате у тебя будут не тысячи контуров, там будет комбинаторный взрыв нахуй.

Более того, твой первый этап (немного размытия и бинаризация) требует AI, например, для выбора порога бинаризации. Потому что с неправильным порогом оно будет выглядеть как пикрелейтед в посте >>61281.

А контраст этих баблов относительно изображения может быть каким угодно, при чем даже в пределах одной манги. Они могут вообще отсутствовать.

>половина из которых - рамки текста.

Точность 50% вообще никуда не годится

>Только эти фичи можно распознать исключительно нейронкой, которую ты не сможешь натренировать из-за отсутствия датасета.

Как же файнридер прямоугольники с текстом искал в 2002 году? Вот здесь как раз можно написать бы о том, что классификатор 32х32, который отвечает на вопрос, есть ли внутри иероглиф, можно захуячить на чем угодно, а ты пишешь о том, что исключительно нейронкой.

>Удачи размечать руками 100к+ картинок.

Какие 100к+ картинок, древний alexnet учится распознавать котов по 1000 примеров без аугментации. Взять паинт и разметить текст в 10к баллонов из манги можно за несколько часов, потому что закрасить кисточкой текст внутри сложности не представляет. Если самому лень, анон в воркаче это сделает по цене пиццы с доставкой.

Другой вопрос, что пилить собственный OCR в 2019 году так себе идея. Собственно поэтому я вопрос этого анона игнорил, он страдает какой-то хуйней.

>Твой классификатор обосрется на реальной задаче, поскольку он не видел каких-нибудь кустиков, и считает их иероглифами.

Это не страшно, потому что иероглифы будут образовывать кластеры на маске сегментации, а кустики нет. Здесь как раз фильтрация по площади, прямоугольности, эллипсоидности и т. п. пригодится.

>Другой вопрос, что пилить собственный OCR в 2019 году так себе идея. Собственно поэтому я вопрос этого анона игнорил, он страдает какой-то хуйней.

Я пилю не OCR, а делаю препроцессинг для OCR.

Например, я сделал алгоритм для вырезания фуриганы, с чем ни одна OCR по умолчанию не справляется, есть еще алгоритмы, с помощью которых можно по нажатию клавиши на баббл находить текст.

Гуглу, тащемта, можно скормить половину страницы и он даже справится с бабблами.

Но бывают ошибки и он не распознает текст в баббле, бывает, что он рандомную закорючку принимает за текст.

Попробуй другие алгоритмы кластеризации же, ну.

У тебя на первый взгляд достаточно аутлаеров, какой-нибудь алгоритм иерархической кластеризации наверное зайдёт или dbscan.

Ну давай, знаток, расскажи, сколько кластеров для KNN задать, если неизвестно, есть ли они вообще в данных. У вас, зумеров, с диплернинха мозги отсырели. Хотя бы просто посмотреть, что там есть в данных - PCA, проекция Сэммона, SOM, не, не слышали.

111 Кб, 883x785

111 Кб, 883x785> KNN лучшее решение проблемы кластеризации.

Во-первых, не лучшее. Есть полно простейших примеров, на которых он работает как говно, например, несферические кластеры или даже хуй с вами, сферические, но перекрывающиеся, т.н "проблема Микки мауса". Во-вторых, сто раз уже написал, с чего вы взяли, что в этом датасете данные вообще образуют кластеры? Про более сложные варианты вообще молчу. Хуета из-под кота ваш кнн, давно и официально.

У гугла задача распознавать всё включая меню в ресторане и банки с кофе. Натренировать сетку чисто на отсканеную мангу намного проще.

>И вот таких вот знатоков полон тред лол.

Правильнее написать: и вот таким вот знатоком полон тред лол.

Он у мамы уникальный.

>В итоге то все эмбендинги суммируются с выходом атеншона и в тем самым проебываются безвозвратно

У тебя когда внимание направлено на объект Х, информация об объекте У тоже проебывается. В этом суть внимания, отсечь лишнюю инфу.

>называет kNN алгоритмом кластеризации

>кукареку зумеры кукареку диплернинх кукареку SOM ФУЗЗИЛОДЖИК А ВОТ В 1922 ДИДЫ ВСЕ УЖЕ ПРИДУМАЛИ

Вся суть нечеткого петуха

На выходе энкодера - имбеддинги слов в контексте остальных слов (2D-объект).

Нна выходе трансформера веротности для следующего слова с учетом всех имбеддингов входа и всех имбеддингов уже сгенерированного выхода.

Там на выходе контекст+эмбендинги пропущенные через ещё один слой. Самого слова там нет.

>>63125

Не не не. Тут ведь эмбендинги вообще не идут на вход. В чем ебучий смысл? В атеншоне должна вроде отсекаться ненужная информация, а не вся информация. Определить слово во входе никак не возможно кроме как эмпирически подобрать каждую комбинацию слов, то есть слово проебалось, а это для всех слов, значит все слова проебались. Смысловое значение вообще у данного выхода должно отсутствовать.

То есть если мы возьмём фразу, то выход для конкретного слова будет что-то вроде грамматического значения слова. Затем мы берём эмбендинги и добавляем их, тотально уничтожая значение атеншена и самих эмбендингов.

По результату дискаса, какие подходы кластеризации\класификации мне стоит попробовать вообще. Назовите пожалуйста. Задача так и стоит - найти классифицировать датасет, если там что-то найдётся - описать классы.

auto-sklearn

Для начала SOM. Общий вид, например u-matrix + компонентные плоскости. Если в данных есть какая-то структура, уже этого хватит, чтобы описать датасет и прикинуть, что можно сделать ещё.

http://jalammar.github.io/images/t/transformer_decoding_1.gif

Смотри картинку, дурашка!

На выходе энкодера для каждого слова имбеддинги K и V, если не веришь картиночке - читай код какой-нибудь из реализаций трансформера на keras/tf/pytorch.

Фид форвард в инкодере на самом деле - TimeDistributed(Dense(...))

Эмбендинг на входе. На выход влияют только другие слова и дот продукт других слов и этого слова. Так, блять, везде написано. На картинке хуйня, там не показывается что происходит в блоках.

На выход влияют только другие слова и дот продукт других слов и этого слова.

Это называется "Глубокий имбеддинг", дипленинх же!

Так самого то слова нихуя нет!

Я не понимаю что написано, блять в одной строчке, в которой даже аргументы не вызваны.

Это конструктор конструктора. Сам инкодер собирается через __call__ вот тут https://github.com/Lsdefine/attention-is-all-you-need-keras/blob/master/transformer.py#L434

Обычно в керасе ты делаешь так:

y = Dense(...)(x)

А тут делается так:

l = Dense(...) #Вызывается __init__

а потом в другом месте:

y = l(x)#Вызывается __call__

(реализация sklearn мне непонятна, можете посоветовать, что навернуть, чтобы понять)

34 Кб, 420x552

34 Кб, 420x552Я так-то ОП вопроса, но я правда не понял, почему они о кнн постоянно писали.

Меня на собесе тоже недавно спрашивали в чём разница мекжду кнн и кминсом. Совпадение? Или есть какая-то связь?

ISLR читай, там даже за SVM на пальцах разъясняется, без нотации из вариационного исчисления как у Вапника. Нахуя вам все эти Воронцовы, концовы, есть же нормальная литература, которую весь мир читает, нет, хочу нонейм хуя из шада.

Я думаю, что проще запилить алгоритм, чтобы скармливать гуглу только бабблы.

Тренировать свою сеть для японского - излишество, я одни данные заебусь размечать.

>Я думаю, что проще запилить алгоритм, чтобы скармливать гуглу только бабблы.

Не проще

>Тренировать свою сеть для японского - излишество, я одни данные заебусь размечать.

Я бы разметил данные за то время, пока ты тут обсуждаешь это все. На это нужно несколько часов, паинт и 10 строк на питоне.

>Что это? Можешь скинуть или рассказать, как делал?

Сначала небольщшое размытие + бинаризация (левое изображение). Потом извлекаешь контуры и фильтруешь их по площади (среднее изображение). Оставшиеся контуры используешь как маску чтобы извлечь текст (правое изображение).

А бинаризация по какому алгоритму?

30 Кб, 446x510

30 Кб, 446x510Жулик, который подобрал 3 магических числа, чтобы оно работало на одной картинке, думает, что никто этого не заметил.

Оптимальный алгоритм зависит от твоего железа и количества входных и выходных каналов. Какие-то свертки cudnn через FFT считает.

Важнее понимать саму суть, что если у тебя на входе 3 канала и свертка 5х5, а на выходе 32 канала, то каждый 32-х канальный пиксель считается как персептрон у которого на входе 3х5х5=75 входов и 32 выхода. Ты можешь это рассматривать как 32 персептрона с 75 входами и 1 выходом, что будет эквивалентно твоему утверждению "32 ядра свертки будут бегать по изображению каждый раз", но вообще считать матричное произведение матрицы 32х75 на вектор с 75 колонками можно разными сколь угодно экзотическими способами.

>Жулик, который подобрал 3 магических числа, чтобы оно работало на одной картинке, думает, что никто этого не заметил.

Кидай свои картинки.

Каким образом мои картинки сделают твой скрипт не ad-hoc говном?

Да забей.

Скорее всего, это вопрос который отвечает шаришь ли ты в машобе вообще. Т.к. эти методы выполняют разные задачи.

Короче, Антоны, я понял, как это можно делать.

Нужно искать контуры и внутри них делать проверку, находятся ли контуры поменьше друг над другом.

И в зависимости от размера участка детектить, сколько контуров должно быть или какого размера они должны быть, чтобы участок считался бабблом.

Спасибо

А не, так нихуя не работает, маленькие бабблы отсеивает.

Мне нужно будет подобрать либо минимальный размер, либо искать текст в центре

1,1 Мб, 1293x983

1,1 Мб, 1293x983Да я тоже думаю, что без машоба тоже можно.

Только пока получается что-то такое, все еще не понимаю, чего он все не может найти

Да ты больше нечеткого петуха слушай

1. Сначала рожаешь скрипт типа https://pastebin.com/vMQNG4LD , не замечая, что числа 5000 и 100000 в это УЖЕ машоб. Просто с самым наихуевейшим вариантом подбора этих самых чисел: вручную. Процент ошибок большой.

2. Дальше догадываешься, что нужно собрать статистику с реальной манги, берешь 20 рандомных страниц и выписываешь это в эксельку. Процент ошибок уменьшается, но несильно.

3. 10% случаев упорно не влезают никуда. Пишешь ad-hoc правила, превращая свой скрипт в длиннющее дерево ad-hoc решений. Затраченное время давно улетает за пределы ручного размечивания всех существующих в природе манг, которые ты способен прочитать.

4. Так как тестировать вручную все ad-hoc случаи невозможно, решаешь это автоматизировать. Для этого собираешь свои исключения и пишешь для них тест-кейсы кто сказал датасет, у нас никакого машоба

5. После подобных операций упорно остается 1% случаев, при чем каждый раз разный.

...

99. Уже седой и заебанный, ты не выдерживаешь и стреляешься из дробовика. Через пару месяцев твой труп находит бомж, которого выгнали из НИИ за пьянство, видит твои записи и решает довести дело до конца.

100. И берет, наконец, сегментирующую нейронку.

Текст как бы всегда является черной полоской, который помещен по центру белой области, которая ни с чем не пересекается и зачастую вообще находится в центре. Неужели это так сложно найти?

>в центре

Вертикальные полосы с пездобуквами окруженные белым пространтсвом и вертикальногоризонтальными отступами

236 Кб, 734x439

236 Кб, 734x439Не, типа пикрил, можно сегментацию на этапе предпроцессинга зделот, причем довольно просто.

Потому что это state of art йоба. У тебя должны быть веские причины (например, запуск твоего алгоритма на железе 1980 года выпуска, установленном на танке Т-72), чтобы этого не делать.

Причина "ко-ко-ко черный ящик нипанимаю и вообще куны^W knn нужен" веской не является.

> веской не является

Как раз потому что это черный ящик нейроговно пидорнули с рынков и медицины.

Как ты видишь такую сегментацию? Опиши.

24 Кб, 102x213

24 Кб, 102x2131. Имеем вертикальную полусу размером с пендобукву

2. Начинаем двигать вправо построчно

3. Если полоса попала в белое поле, ставим атншенфлаг

4. Двигаем полосу вправо если она уткнулась в не белый пиксель (вероятно пендобуква)

5. Если п.4. проверяем окружающее справа пространство на правильный прямоугольник размером с пендобукву.

6. Если п.5. проверяем пендобукву,

7. Если п.5. Опускаемся вниз

66 Кб, 352x442

66 Кб, 352x442 7 Кб, 159x200

7 Кб, 159x200Очевидно там ограничение по контуру прямыми линиями

84 Кб, 580x563

84 Кб, 580x563>нейроночка не может научиться классифицировать с нужной точностью

>Кто это там кукарекает

>Почему вы проебали на флуктации срыночка 1 миллирад рублей? Дяденька мы не знаем, так нейроночка натренировалась.

Буквы могут зависеть от изображения

Для этого нужно перебрать пару тысяч манг и найти, что же там является средним.

А если юзер закинет обрезок от манги?

>Для этого нужно перебрать пару тысяч манг и найти, что же там является средним.

Делай джва, десять проходов с разными размерами, кто тебе мешает то?

Джвигай такую конструкцию как ниже, если все линии находятся в белых пикселях с черным говном внутри, пездобуква 99%

----

|

|

---

>решит приблизить букву

Ну их нужно наверное выделить, а так да все должно быть в одном масштабе

Петух, я понял, что это был твой пост, теперь съеби.

В японском есть и буквы, которые больше растянуты по горизонтали и не впишутся в твой паттерн

>В японском есть и буквы, которые больше растянуты по горизонтали

И? Они ограничены белым пространством.

> У тебя есть магическое число

Ты ебобо? Берешь линейку и отмеряешь размер одной буквы, вот его и ищешь.

ЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫЫ

У тебя твой алгоритм линейку возьмет своими электронными руками?

Осталось придумать, нахуя добавлять гиперпараметр в виде порога бинаризации, если нейронка и так неплохо работать будет.

73 Кб, 266x599

73 Кб, 266x599>Окей, что будешь делать с этим?

Как же вы заебали, оно опять же ограничено пустым типографическим пространством

>сильный ИИ

Прошел 100 раз с разными размерами и выбрал у которых большее совпадение. Вопросы?

Ага, уже значит чекать нужно на поворот, изначально ты этого не говорил.

Опиши, как бы ты это сделал?

Ты сейчас делаешь типичную ошибку любителей, которые только знакомятся с нейронками и считают, что им виднее, как именно нейронка должна выцеплять фичи. end-to-end решение как правило работает лучше.

Что можно применить, это, например, local contrast normalization.

Вы меня доведедете до того, что я принесу вам решение этой задачи, несмотря на то, что я сейчас пишу загрузку сорокагигабайтного датасета через memory mapped files и эта задача с мангой ну вообще прикольной не кажется.

Да можно и просто попробовать бинаризировать, искать все контуры и проверять, является ли их граница белой.

А потом уже ориентироваться по расположению.

>не замечая, что числа 5000 и 100000 в это УЖЕ машоб

>Просто с самым наихуевейшим вариантом подбора этих самых чисел: вручную

>>63981

>>очередной говноалгоритм с магическими числами

>>НИКАКОГО МАШОБА

Опять смузихлебы мешают все в одну кучу. Подбор чисел вручную это нисколько не машоб, а машоб это не только нейронки. После нахождения работающего алгоритма можно запустить оптимизацию гиперпараметров которая тоже является машобом с датасетом в десять раз меньше, чем для нейронки. И получить алгоритм, работающий быстрее и лучше сегментирующей нейронки.

>100. И берет, наконец, сегментирующую нейронку.

Какая у нее будет точность, мм? Процентов 80-90, при необходимость иметь топовую гпу для ее запуска?

Опять нечеткий петух, который не знает разницы между knn и kmeans, что-то там кукарекает. Брысь под шконку.

>искать все контуры и проверять, является ли их граница белой

Ну еще можно проверять является ли в контуре символ.

Это уже излишество, а так я решил проверить, сработает ли оно, результаты такие

Очевидно нет, без ансамбля из сотни лёрнеров с десятью слоями атеншена не разобраться.

Чё ты пиздишь-то, ты fast SCNN взял небось, по-любому!!

Ды обычная сегментация, как у того анона, который код с питоном выше вкидывал.

Дальше брал контур и проверял по пикселям его края и центр.

Ну а теперь выбрасывай экстремально маленькие контуры и дополнительно обрабатывай большие и перекрывающиеся.

>Ну так чем все закончилось-то?

градиентный бустинг стал стандартом для всяких табличных данных

> Как с реинфорсмент лернингом, вышла статья, что не лучше случайного поиска

ARS работает в mujoco и может быть ещё паре сред. Достижение уровня "набрал на мнисте 95% точности своим новым супералгоритмом"

>градиентный бустинг стал стандартом

А чего везде всё ещё нейронки и свм используют? Типа вычислительно сильно сложнее?

Не, я именно про таблицы.

Называешь петухами всех, кто спросил что-то чего ты не знаешь? Так ты сам петух в таком случае.

Папа твой петух, а так же все родные и близкие.

Зависит, но в общем случае неструктурированные.

Грубо говоря, всё что можно засунуть в табличку таким образом что получить полную информацию по точке из датасета можно одним единственным запросом - это структурированные данные. То что либо зависит от каких-то скрытых переменных, или вообще не поставляется в квантифицированном виде и потому зависит от всяких эмбеддингов - неструктурированные.

Ок. Есть временной ряд 1, 2, 3, ... , n. Делаем матрицу Ганкеля:

1 2 3 4 5

2 3 4 5 6

3 4 5 6 7

4 5 6 7 8

...

n-4 n-3 n-2 n-1 n

Любую строку можно получить одним запросом, так же эта строка однозначно представима в виде пятимерной точки. Любой временной ряд можно представить таким образом. Получается, что все временные ряды - структурированные данные?

С языка сорвал

Я ничего не говорил про нейронку и как ей виднее, деб, я говорил о том, что тебе предется прогонять в несколько раз больше свёрток для одного пропогэйшона.

Да, но тут все чмоши незнающие.

Тебе несколько тысяч деревьев хочется тренировать?

у тебя был временной ряд 1..n, а стали пятимерные вектора

Понятно что что угодно можно в табличку засунуть, суть не в этом, а в том чтобы можно было удобно модельку обучить.

На таком представлении ты обучишь находить закономерности только на пять шагов по времени, плюс у тебя дохуя избыточной информации получится, будет оверфититься.

Можно на 3 столбца разбить. В итоге получится восстановленная функция y = f(x1, x2) для всего временного ряда, т.к каждая строка сдвинута на одно значение. Но дело не в этом, а в том, что вышеописанное деление данных на структурированные и нет смысла не имеет. Даже рандомный текст это структура, т.к его всегда можно разбить на буквы, слова, предложения, параграфы, документы итд, и рассматривать это как отдельные элементы.

А я ведь предупреждал, что он петух, а ты правда решил что-то ему объяснять, лол.

60 Кб, 1108x416

60 Кб, 1108x416Получается, что каждый входной сигнал до перехода в активационную функцию содержит в себе фиктивный столбец x0 с 1ми для того что бы избавиться от свободного члена w0 (что бы он перешел в общую сумму) ? Даже если нейрон содержит всего 1 вход, то на самом деле их 2 и это делается как бы за нас во фреймворке с ML логикой ?

Там в лекции об этом говорится,

помогите понять,плиз

>Даже если нейрон содержит всего 1 вход, то на самом деле их 2 и это делается как бы за нас во фреймворке с ML логикой ?

Не знаю, что делается под капотом у keras и tensorflow (вполне возможно, что для эффективного матричного умножения проще действительно добавить столбец матрицы с единицами), но снаружи веса W и смещение b торчат отдельно. Это удобнее с точки зрения инициализации, например, потому что веса обычно инициализируют рандомно, а смещение нулями.

Если ты не получаешь кайф от обучения в одиночестве, выбери что-то другое, гей-шлюхой стать, например

Оп-пост почитай.

Не слушай дурачка, линал учи самостоятельно, будут интересные и муторные моменты, выходи из зоны комфорта, лол

ну я кст нашел конфу в телеге вот т.ми/comput_math

мне там чувачки посоветывали сайтик по матеше mathprofi.ru/

вот :)

По сути решаю задачу регрессии с использованием ИНС

Все стандартно, как по учебнику построил сетку с одним скрытым слоем, все заебок работает

Но как ее дальшее оптимизировать?

С параметрами слоев и функциями активации поигрался, толку почти никакого

И если сделать больше нихуя нельзя, как доказать что мое решение самое пиздатое?

>Все стандартно, как по учебнику построил сетку с одним скрытым слоем, все заебок работает

Заебок на валидейшене или ты оверфитнул и доволен?

>как доказать

Никак. Сравнить с предыдущими решениями той же задачи на том же датасете. Или самому поаробовать несколько методов и сравнить результаты.

Вот это как раз супер медленно.

>>65693

А это рабочая тема, спасибо, разобрался.

Осталась пара вопросов: как я понял, при изменении файлов на гугл диске вне коллаба, изменения в файловой системе внутри ноутбука не происходят. Как тогда ее "перезагружать"?

>drive.mount('/content/drive', force_remount=True)

Не помогает, список тот же.

Как пример - перезагрузил файл ssd_mobilenet_v1_coco.config, предварительно удалив старую версию. Но в colab`е отображает какой то ssd_mobilenet_v1_coco(1).config, и тот в кавычках. Причем если обращаться к обоим названиям конфига то выдает No such file or directory.

13 Кб, 400x98

13 Кб, 400x98Забыл сразу написать: restart runtime не помогает, как и выполнение после рестарта заветной

>drive.mount('/content/drive', force_remount=True)

На валидейшене

Может какую другую сетку попробовать, в смысле другой структуры? может какие-нибудь необычные активационные функции?

Ну какая архитектура у млп, побольше нейронов в скрытые слои захуячить?

Скорее с данными работать, почистить чего-нибудь может лишнего, или фичи какие-нибудь заинжинерить.

Или вообще забить на няронки и доставать бустилку.

Как мне узнать, находится ли четырехугольник далеко от других, ориентируясь по площади?

То-есть у большого четырехугольника минимальное расстояние может быть большим, а вот у маленького оно должно быть маленьким.

Как это сделать? Я знаю, вы хороши в статистике

Можно ли для любых данных использовать формулу Стерджесса?

1. Есть необходимость распознать объекты на изображении (их множество), а после этого отдельно работать с каждым объектом - совсем по другой логике.

Существуют ли какие-то паттерны и best practices по тому, как в рантайме хранить эти распознанные объекты, если они мне нужны будут отдельно друг от друга и мне нужно будет хранить именно их визуальный образ для дальнейшей обработки? Как обычно делают подобные вещи?

2. По поводу "распознать объекты на изображении". Допустим, сейчас я просто натравливаю Canny на изображение и оно рисует мне кучу контуров. Далеко не все из них полностью обводят каждый конкретный образ, отсюда второй вопрос: какие существуют способы дать opencv понять, что каждый каждая кучка контуров является цельным объектом? К примеру, на картинке ~40 объектов и ~900 контуров, совсем левого шума нет - есть только не до конца размеченные объекты. Я уверен, что второй вопрос гуглится, но я его задаю в свете того, что мне эти объекты дальше хранить и обрабатывать.

Если это важно, у меня python и opencv.

Да я уже решил, не знаю, можно было ли юзать формулу Стерджесса, но я просто поделил на диапазоны.

Да, я как-то заходил к вашему шалашу в /math/ и удивился очень похожему стилю. Но вообще все бордошизики похожи.

>Существуют ли какие-то паттерны и best practices по тому, как в рантайме хранить эти распознанные объекты

Нет, это работа программиста как есть. Где-то достаточно прямоугольника, 4-х координат и изначального кадра, где-то нужно всякие битовые маски хранить.

>какие существуют способы дать opencv понять, что каждый каждая кучка контуров является цельным объектом

Ну, например, можно по контуру построить convex hull, закрасить его, и так, пока у тебя не останутся одни hull'ы. Если твое предположение по поводу кучки верно, это сработает.

Но по поводу гуглится ты загнул конечно. Попытка нагулить это сродни попытке найти решение олимпиадной задачки. Можно, но малореально, скорее реально найти отдельные кирпичики.

Какие знания нужно иметь, чтобы попасть джуномидлом к дата-инженерам (не сайнтистам!)? Во всяких спарках и хадупах дома полноценно не поразбираешься.

Есть пара лет опыта в бэкенд-разработке (не Java, не python)

Понял, спасибо.

бамп

Мне кажется вот так самостоятельно такие знания не получить. Мне видится, что ты пилишь хайдоад на джаве и в какой-то момент начинаешь больше заниматься инфраструктурой хранения (хадупы, спарки, бд). Тот же путь что и у девопса в принципе, но в другом направлении немного. А потом уже с таким опытом можешь сразу на вакансии идти.

12 Кб, 160x160

12 Кб, 160x160Знатоки, внимание вопрос.

Какие есть варианты перекатиться в этот ваш машоб? И нужно ли это? Мои скилы по разрабатыванию апишек и продумыванию взаимодействия микросервисов будут ненужно потраченным временем или дадут бонус? Будут ли надо мной смеяться двадцатилетние пиздюки? Меня интересуют деньги и классные тасочки где надо думать. В принципе, меня и сейчас все +- устраивает, но вдруг можно ещё лучше? Реквестирую кулстори.

Разбираться как можно более полноценно дома, подымая псевдокластеры, а потом идти стажером за еду

>Какие есть варианты перекатиться в этот ваш машоб?

С вышкой несложно, ищешь стажерские позиции, готовишься к ним недельку, перекатываешься. Со стажера подымишься быстро.

Второй вариант это забугорный фриланс по вечерам, а потом пункт один.

>варианты перекатиться в этот ваш машоб? И нужно ли это? Мои скилы по разрабатыванию апишек и продумыванию взаимодействия микросервисов будут ненужно потраченным временем или дадут бонус?

"Машоб" это довольно общо сказано, в принципе твои скиллы довольно полезны для мл инжинера, который, в отличие от датасаентиста, занимается не столько тренировкой моделей и иследовательской работой, а именно выкатом их в продакшен, разворачиванием всяких сервисов, вознёй с бигдата инфраструктурой. Можешь попробоваться туда.

>Однажды написал k-means.

Это хорошо, но недостаточно, надо ещё уметь отличать его от knn.

Иначе прямо с собеседования охрана возьмёт за шкирку, и в помойную лужу выкинет.

У чувака образование прикладного математика, а ты его разгребать инфраструктурное говно посылаешь. Жестокий ты человек.

У нас полстраны этих маняматиков, для того чтобы быть хорошим датасаентистом этого недостаточно. Вакансий на дс очень мало и хер устроишься иногда даже с профильной степенью и статьями.

>С вышкой несложно, ищешь стажерские позиции, готовишься к ним недельку, перекатываешься

Подгорело немного.

>Фриланс по машинному обучению?)))

Диван в треде))))))))

Ваша проблема в том, что вы сидите на самоподдуве с тупыми мемасиками уровня "фриланса на машобе нет", "нейронкам нужны 1000 слоев" и т. п. Такой филиал перезвоним-треда с такими же бездарностями.

Заходишь на апворк, вбиваешь machine learning, и апплаишься. Делаешь пару курсачей западным студентам за $50 (что даже не за еду, а в отрицательном диапазоне, поэтому конкуренции там нет), после нескольких пяти звездочек попадаешь уже на кого-то поденежнее.

Я так в 2013 находил работу за $20/час, при том, что за C++ мне выше 15 тогда не платили. Тут ты такой "2019 не 2013", проблема в том, что моя тянка находит подобное сейчас. Правда не на апворке, а на бирже поскромнее, потому что на апворк ее так и не зааппрувили. И недостатка предложений по работе нет, есть только недостаток скиллов.

>>67795

>У нас полстраны этих маняматиков, для того чтобы быть хорошим датасаентистом этого недостаточно.

Потому что большая часть не очень далекие люди, искренне не понимающие, какой алмаз у них в кармане. Я это наблюдаю среди одногруппников тянки, большинство свалило в яндексы месить говно каким-нибудь фронтэндом еще лет в 20. Чтобы потом в 30 плакаться о том, как их все заебло и какая тупая у них работа.

>Вакансий на дс очень мало и хер устроишься иногда даже с профильной степенью и статьями.

Конечно ты хер устроишься со статьями, потому что ученые - они ведь в говне моченые. Нихуя за свою жизнь не сделали, кроме сидения на сиське государства, нихуя не умеют, а при этом хотят получать 300к в секунду, как их сосед Вася, который много лет месил говно, начиная с работы в НИИ студентом (потому что там дохуя свободного времени на самообразования), кончая домашек западным лодырям, оттачивая свой английский. Собственно примерно в НИИ пути и расходятся, одни видят, как вписываться в рыночек, а другие продолжают не напрягаясь пописывать свои статейки и онанировать на свою степень.

Тогда была бы очередь на аппрув. А там нужно удовлетворить формальным критериям индуса-проверяльщика, которые чуть умнее бота, и проверяют примерно раз в 3 дня. Естественно там надо жульничать в такой ситуации.

тем не менее это характерно что специалиста по машобу заворачивают как автора текстового контента какого-нибудь

Это как фейс-контроль в клубе. Тебе от этого плохо, когда ты снаружи, но хорошо, когда ты внутри. Из-за подобной политики заворачивания даунов, которые не могут профиль грамотно заполнить по критериям индусов и бояться жульничать, приписывая себе хотя бы мастера вместо незаконченного высшего, лично тебе будет только хорошо, ты ведь получил от меня инструкции, что тебе нужно делать.

>потому что ученые - они ведь в говне моченые

Это да, в отличие от хуя, у которого только алмаз в жопе в виде шести лет протирания штанов на мехмате какого-нибудь провинциального вуза. Такого конечно везде ждут с распростёртыми объятиями, тоннами бабок и интересными исследовательскими задачами.

Такого ждет планомерное построение карьеры, начиная с фриланса и стажерских позиций, а потом да, тонны бабок и т. п.

Да кто против что-ли, пусть походит с полгодика по объявам, наслушается "извините, нам нужен опытный специалист", обосрётся и укатится назад, либо во что-то более реальное вроде мл инжинера на подхвате.

Я в Киеве никогда не встречал таких вакансий, типа Junior Data Satanist. Знакомые вкатывальщики начинали с аналитиков и вкатывались через матан или с биг дата инженеров и вкатывались через тех. часть.

Проблема еще в том, что часто под ваканчиями мл\дата сатанист скрывается требования как к обычному аналитику и обратное. По-этому не гнушайся просматривать дата аналистов и дата инженеров.

Есть нейронка, автоэнкодер с 1 скрытым слоем на сигмоиде.

Веса скрытого слоя фиксированны.