Вы видите копию треда, сохраненную 21 мая 2016 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Machine Learning 101

1. Introduction to Statistical Learning, Casella ( http://www-bcf.usc.edu/~gareth/ISL/ISLR Sixth Printing.pdf )

Книга для нубов, очень хорошая. Все разжевано и положено в рот.

2. Pattern Recognition and Machine Learning, Bishop.

В начале пути пропустил эту книгу, так как Pattern Recognition мне казалось специализированной темой. Как выяснилось - зря, в книге также хорошо объяснены основы. Есть некоторые специальные темы (Sequential Data, Kernel Methods), объяснения которых мне показались лучшими среди когда-либо прочитанного.

3. Bayesian Methods for Hackers ( http://camdavidsonpilon.github.io/Probabilistic-Programming-and-Bayesian-Methods-for-Hackers/ )

Охуительное введение в байесовские методы. Если теорема Байеса и вероятности вызывают у вас лишь тухлые ассоциации с лекциями начальных курсов вашего ВУЗа, то вы серьезно ошибаетесь - байесовский подход гибок и широко используется для прогнозирования и оценок.

4. http://neuralnetworksanddeeplearning.com

Введение в нейронные сеточки для самых маленьких, с виджетами на JS - можно регулировать ползунки и смотреть на результаты. Написано все простым английским.

5. https://vk.com/deeplearning

Чувак обозревает статьи с архива и других ресурсов, удобно.

Machine Learning Advanced

1. Elements of Statistical Learning (http://statweb.stanford.edu/~tibs/ElemStatLearn/printings/ESLII_print10.pdf )

Не рассчитывайте на легкую прогулку в пару недель. Чтение глав и выполнение заданий способно растянуться на год или больше. Оно стоит того. Уровень математической подготовки должен быть выше среднего.

2. Learning with kernels. Регуляризация и SVM, вот это все.

3. http://deeplearning.net/reading-list/

Собраны все нужные ресурсы по DL, от альфы до омеги.

Computer Science

1. Intoduction to Algorithms, Corman

2. The Art of Computer Programming, Knuth

Nuff said.

3. https://gcc.gnu.org/wiki/ListOfCompilerBooks

В ВУЗе проектирование компиляторов мне казалось каким-то космическим, далеким от меня занятием. А потом мне пришлось дописывать компилятор Python.

4. import ast

Опять про компиляторы. И я не шучу. Хотите начать в этом разбираться - зацените как устроен компилятор Python. AST - это абстрактные синтаксические деревья для разбора грамматик. В гугл, открываете доки и вперед!

Programming

1. Python Unlocked. Короткая книжка без соплей. В ней описаны метаклассы, дескрипторы, системы типов, шаблоны проектирования и TDD. Всего чуть больше 100 страниц концентрированной сути.

2. Code Complete (2nd), McConnel.

Неплохая книга. Не то чтобы обдрочиться, но в голове всякие фишки по структуризации кода и его проектированию остались.

Misc

1. Telegram: @techsparks

Подкаст про всякие гик-штуки.

2. Об интеллекте. http://archism.narod.ru/lib/bleiksli_sandra_ob_intellekte.pdf

Если устанете от математики, то почитайте про подход айтишника к изучению сознания. Книга хороша, особенно в середине, где рассказ про мозги начинается.

Мое личное определение такое: ML - это когда у тебя есть куча данных (тексты, картинки, таблицы) и тебе хочется ответить на какой-нибудь вопрос релевантный данным. Определять по картинкам кошка там или собака или по логам действий пользователя на сайте пытаться предсказать купит он что-нибудь или нет.

Эээ, не, разве что теоретической игрушечной машинкой. Пока ты на курсерных яве/питоне будешь анализировать что за хуита у тебя на дороге уже 5-х человек собьёшь, если раньше свопы не начнутся.

Ну я же не про гуглмобиль говорю.

А там они просто взяли изображение с камеры на крыше 20*20, чистую черную дорогу на фоне зеленых лужаек, прихуячили к рулю привод и покатались минут 10, обучая. Потом уже машина сама рулила нормально. Никакого управления скоростью/тормозом не было. Реализовано было через 400 входных нейронов (по пикселю на каждый), двумя хайденлейрами и n-му числу выходов, соответствующих углам поворота рулевого колеса.

А теперь приспустись-ка на землю с теоретических небес, и расскажи:

а) Какая там железка, с тамошними ограничениями в электричестве;

б) На чём это всё всё же реализовано (желательно с пруфами);

Судя по тому что я нашёл - там кроме камеры ещё 2 десятка датчиков со всех сторон и расчёт пути происходит на сервере, а физическое железо просто перестраховка от людей/машин/кошек, что какбе не очень подходит под описание "самоуправляющегося" автомобиля.

Ты думаешь, что я перед тобой начну щас оправдываться, дабы не прослыть петухом от мира машинлернинга? Я же сказал, что дропнул эту хуиту на середине. А про руление машинкой я сказал, потому что примерно понимаю как это говно работает. Плюс ко всему можно выебываться перед ерохинами, круг интересов которых ограничивается машинами и их ремонтом.

Вспомнил еще ШАДовские лекции: https://yandexdataschool.ru/edu-process/courses

Лекции Воронцова - вин. Правда без семинаров они не совсем полноценные, но теория изложена гладко и четкео.

Все лекции ШАДа охуенны, надеюсь они скоро выкатят в паблик больше курсов.

Впервые про такой метод услышал. Прочитал на вики и осталось странное ощущение, будто это просто иное название для комбинации basis set expansion и индуктивного алгоритма обучения. Мне кажется, оно не "не взлетело", а перекочевало в разные алгоритмы и сейчас просто имеет другие названия.

>Мне кажется, оно не "не взлетело", а перекочевало в разные алгоритмы и сейчас просто имеет другие названия.

Там довольно общая формулировка задачи, под которую подходит почти все что угодно вплоть до генетических алгоритмов. Но именно в изначальной форме оно по-моему, сейчас нигде не используется. Есть какая-то платная ебала с нереальными ценами https://www.gmdhshell.com/buy При том, что метод в свое время был достаточно разработан.

Пока понял что делать это нужно через применение

https://en.wikipedia.org/wiki/Principal_component_analysis

А потом уже с небольшим количеством параметров применять какой-нибудь диплернинг или интерполяцию, верно?

уже миллион таких дипломов, статей, книг. Всё всё что можно было изучено, этой теме уже 80 лет.

Нужны новые, прорывные вещи.

Что там имеется ввиду под изначальной формой? Если я правильно понял, без эвристик в этом методе произойдет комбинаторный взрыв и жуткий оверфит уже на первых шагах. То есть per se его взять не получится. Ну а отсечение эвристиками приводит к уже известным под другими названиями методам. Тот же SVM RBF - это регрессия на полиномы бесконечной степени с регуляризацией, которая не дает произойти такому пиздецу как в чистом МГУА.

Это что-то уровня C5.0/See5 - за гранью добра и зла.

>>652732

https://habrahabr.ru/company/synesis/blog/238129/

ОП

>Что там имеется ввиду под изначальной формой?

Полный степенной полином. Он разбивается на частные, комбинации которых оцениваются.

>без эвристик в этом методе произойдет комбинаторный взрыв и жуткий оверфит уже на первых шагах.

Там нечто типа функции приспособленности в генетических алгоритмах. Причем, они составные, не только среднеквадратичная ошибка, но и другие критерии.

Ага, упустил этот момент, картинка годная.

>комбинации которых оцениваются

Количество комбинаций будет неимоверно велико при количестве исходных переменных >~20.

>Там нечто типа функции приспособленности в генетических алгоритмах. Причем, они составные, не только среднеквадратичная ошибка, но и другие критерии.

Это плохо. Даже если чуть-чуть усложнить метрику ошибки и отойти от известных L1, L2, 0-1 или exp, то функция потерь перестает быть дифференцируемой и методы оптимизации перестают работать в принципе.

>Количество комбинаций будет неимоверно велико при количестве исходных переменных >~20.

Нет, оно даже при 100 переменных работало нормально, причем еще на тех совковых ЭВМ. Там не полный перебор всех вариантов, а комбинаторика по некоторой схеме. Я вот сейчас думаю как нечто подобное на R сделать с помощью генетических алгоритмов, чтобы полиномы генерировались в виде таблицы, которая бы подкладывалась генетическому алгоритму в виде пространства поиска (в варианте permutation, на перестановку элементов таблицы), а функцию приспособленности задать как какой-нибудь критерий, обычный для МГУА. В R есть некий пакет "GMDH" https://cran.r-project.org/web/packages/GMDH/index.html но там хуйня хуйней, нечто вроде полиномиальной нейросети, причем нельзя даже получить коэффициенты модели я у автора спрашивал.

Тащем-та мне нечего добавить к вышесказанному. Применение эвристик так или иначе приближает МГУА к уже существующим методам.

Попробуй, может выйдет что-нибудь годное. Вон китаец (https://github.com/dmlc/xgboost ) взял и написал пару лет назад градиентный бустинг на деревьях. Казалось бы - чему тут взлетать? В итоге это сейчас самая сильная библиотека с нелинейным методом для общих задач. Тоже всяких эвристик накрутил хоть жопой жуй - но работает же!

>Я вот сейчас думаю как нечто подобное на R сделать с помощью генетических алгоритмов, чтобы полиномы генерировались в виде таблицы

И да, посмотри вот это, может поможет чем-нибудь:

http://topepo.github.io/caret/GA.html

ML have no tasks.

USA university and researching groups use this shit (like they always do) and have some impressive results at recent years. All the geeks going crazy about that and start hyping: "It's a future technology, I'm going to be a new Bill Gates in ten years!!!". Coursera printed 100500 data science courses for making money on idiots. Thats all.

All the real market is 10 vacancies a year in all Russia. And 8 of it requires doctor degree in math and be here 10 years ago (called "analytics").

Sorry for English. I install Linux and now don't know how to change language. Shitty OS, I hope none of my brothers didn't die.

Cheeseburger and big cola, please!

Да да, вместо того, чтобы зайти на транслит.ру ты решил выебнуться английским. Не удивительно, что у тебя работы нет.

I make 10 errors in every sentense, how it can be VIEBNUTSIA?

Как по мне, так ML вышел из застенок универов и является группой уже промышленных техник и технологий. Не совсем понятны слова про 10 вакансий в год. Если под вакансией в ML считать state-of-the-art в каких-нибудь нейронных сетях, то да, таких может быть десяток. Но обычно имеются ввиду навыки работы с данными и владения инструментами типа питонячих библиотек, Sparkов и прочих обвесов - таких вакансий валом.

История из жизни: хотел я повесить недавно 100 табличек с номером телефона моего не айти бизнеса на столбах, спам такой что таджики срезают раз в сезон, быдлее быдлового, для речь не о том. Чуть голову не сломал гадая где их вешать что бы водители видели.

А сейчас я бы просто попарсил пару недель Яндекс пробки и в хуй не дул.

Это на ВМК студенты мудилы скорее.

Это два разных скилла. Я даже на слух английский понимаю относительно неплохо, а когда писать начинаю, получается чуть лучше, чем у него.

Такая же хуйня, не знаю как с этим бороться.

Двачую. Читаю и пишу хорошо, зато как рот открою, получается максимум: ГРЕЙТ БРИТАН ИС ЗЕ КЭПИТАЛ ОФ ЛАНДАН

>Опять про компиляторы. И я не шучу. Хотите начать в этом разбираться - зацените как устроен компилятор Python. AST - это абстрактные синтаксические деревья для разбора грамматик. В гугл, открываете доки и вперед!

Книгу бы дракона добавил, это же буквально библия!

>yandexdataschool.ru

Хз, может ширина канала узкая? Там на все глагне видео грузится. Попробуй сразу на https://yandexdataschool.ru/edu-process/courses перейти

Репортнул админам, не знаю кто в воскресение будет шевелиться, больше ничем не могу помочь. У меня наоборот, курсы грузятся, а главная нет.

>Вон китаец (https://github.com/dmlc/xgboost ) взял и написал пару лет назад градиентный бустинг на деревьях. Казалось бы - чему тут взлетать? В итоге это сейчас самая сильная библиотека с нелинейным методом для общих задач.

А что это вообще, если в 3х словах? Пейперов уже накачал, обязательно почитаю, чувствую что какая-то годнота. Это случайно не типа МГУА?

курс udacity по deeplearning

Мне в свое время Воронцов (он моим научником был) советовал курс на курсере от High Economic School.

Курс оказался отвратительным :(

Да, мне тоже не понравился, хотя другие их курсы вполне себе ничего.

>>653756

Странно, что ты написал "в свое время", хотя курс двухнедельной давности. На курсере есть такая проблема: сложность курсов ограничена сверху, причем сильно ограничена. Поэтому на ней выложены какие-то говеные остатки нормального курса.

>>653639

Если коротко, то это градиентный бустинг, написанный на крестах. Быстрый, с кучей оптимизаций. Кое-как паралеллится - редкое свойство для нелинейных моделей.

Бустинг - это когда на шаге m мы имеем композицию из m-1 классификаторов, считаем ошибку этой композиции, строим m-ый классификатор на полученных ошибках и затем добавляем его в композицию классификаторов. Каждый следующий классификатор уменьшает ошибку всей композиции классификаторов. Слово градиентный в этом случае относится к способу построения композиции. Если не ссышься матана, то ступай в книгу EoSL, часть 10.2 (хотя имеет смысл всю главу прочитать). Ссылка на скачивание книжки в первом посте.

>>653649

Что-нибудь - это как-то жирно. Есть отдельные статьи по сверточным (всякие текстурные сети и прочее) и энкодерам-декодерам (word2vec). Сами мы как-то запускали все это говно на Кеплерах и даже получилось, правда на статью это не тянет. Но все вываливать я не готов, материала до пизды, спроси лучше конкретнее.

Метка отваливается постоянно, сука.

нее и так все чики-пуки)

Двачую.

На программаче вообще странная субкультура сложилась. Реальных востребованных профессий (пхп, фронтенд, дотнет, 1С) все избегают и считают зашкваром. Вместо этого все отыгрывают гиков и ученых, учат датасаенс, функциональное программирование, С++, всякие новые никому не нужные языки.

Наверное это потому что тут большинство не хотят стать реальными специалистами в реальном мире и вообще из дома выходить не хотят. Вместо этого мечтают и занимаются эскапизмом. Своего рода ММОРПГ для тех кому за 18. Только вместо левелапов - новые никому не нужные технологии и языки.

Ну тащемта мне лучше. Меньше конкурентов - больше зарплата.

Изучайте дальше свои хаскели и нейросети и мечтайте, что когда-нибудь вы станете востребованными специалистами. И смейтесь над пхп-шниками и 1С-никами, которых берут на работу уже после пары месяцев обучения. Они ведь - неудачники, а вы - элита, правильно?

ЯННП.

>Оно у вас вообще работает?

Да.

>Это можно считать нормальной работой?

Да. Что тебе не нравится?

>Всегда с подозрением относился к пистонопарашам, если честно.

Ну причем тут пистонопараша? Весь tf написан на крестах, а на питоне только удобная обвязка.

>>653966

Кесарю кесарево. В остальных тредах (пхп, фронтенд, дотнет, 1С) сидит куда больше народу, чем здесь. Субкультура какая-то, большинство - это о чем вообще. Мы пытаемся тут сабж обсуждать, вроде даже получается; какие проблемы, офицер?

>Вместо этого все отыгрывают гиков и ученых, учат датасаенс, функциональное программирование, С++, всякие новые никому не нужные языки.

Намешал в одну кучу и людей и коней.

>реальными специалистами в реальном мире

Ловко ты тут всех задетектировал. Расходимся, хиккари.

Подрастешь еще чуть-чуть, и перестанешь противопоставлять Спп с ФоПэ и фронтенды с вебыми, я гарантирую это.

>Ну тащемта мне лучше. Меньше конкурентов - больше зарплата.

>Весь пост пытается обосрать ML.

Манек, ты на ноль делишь. Тебе не лучше. У тебя пердак на ровном месте подгорел, среди всех нас тебе хуже всех сейчас. Очередные вопли маньки-неосилятора.

Это у него так сознание пытается защитить себя от батхерта, что выливается в маня-мирок. Лучше бы он голову в унитаз прятал.

Чумазый пиздёныш с громкой отрыжкой и отчаянным воплём ввалился в комнату, где господа почивали после сытного завтрака. Битордик ошарашенно вылупился на удивлённых сэров, за пазухой у него явно было что-то запрятано. Ну, что у тебя там, зассыха? - снисходительно промолвил самый молодой из господ. А-а-фоть - заикаясь промямлила замарашка и трясущейся рукой вывалила на дорогой персидский ковёр кучу смрадного свежего говна. Лица элитариев побагровели от такого неслыханного безобразия. Камёрдинера сюда, живо! - воскликнул опять же самый молодой и самый вспыльчивый из них. Оказия сия окончилась, как можно безошибочно предугадать который раз не в пользу плебса, оно и к лучшему, не место черни среди высшего общества.

Схоронил.

Частично не соглашусь. Да, есть хайп вокруг этой области. Но по мне, здесь уместно сравнение с вебом. Веб в нулевые переживал хайп, называемый сейчас бумом доткомов. Однако сама по себе технология была охуительна вне зависимости от хайпа, а после сдутия пузыря веб вошел во время сбора плодов - ровное, продуктивное развитие, давшее нам гуглы, фейсбуки и прочие амазоны.

ML тоже уже готов дать в ближайшие годы решения для автопилотов, дизайна лекарств, вопросно-ответных систем, систематизации знаний. Поэтому вкатываться в это дерьмо стоит при условии серьезности подхода. Не стоит расчитывать прочитать одну книжку и сразу вкатиться. Идеально, если вы угораете по ИИ и мозгам, а также по статистике и программированию, тогда не стыдно и жизнь с этим связать.

>а большая часть научных работ отдает бревнологией

Зависит от того, откуда ты берешь эту большую часть. Я периодически просматриваю arxiv и как раз таки работы по ML обычно отличаются неординарностью. Конечно, это не гравитационные волны, но новизна в них точно есть.

>>654141

В ДС можно найти. Яндекс, мейлру, касперский, несколько биоинформатических компаний (iBinom, можно еще blastim.ru поскролить на тему работы), билайн (они с НГ целое подразделение открыли под ML и биг дату), связной. Ну и западные аутсорсы, если готов рачить за валюту.

А вот стоит ли начинать обмазывание себя лучше спроси. Порешай тестовые контесты с кегла, чтобы понять нравятся ли тебе прикладные задачи или нет.

Освятил.

Две формы лжи в глазах смотрящих. Сама по себе статистика беспристрастна.

маня, 99% работы в твоих "востребованных профессиях" это заунылейший однотипный дроч с пониженной интеллектуальной составляющей, сродни перекладывания бумажек в офисе

да, ты не ослышался, пхпист, 1Сник, яваиндус, дуднечик = офисный клерк

самое комичное ещё и то, что подобные языки максимум простые и тупые, оттого и средства программирования предоставляемые ими чрезвычайно убогие и говёные, не позволяющие прозрачно выражать свои мысли и нормально решать задачи

то есть какой нибудь пхпист - не просто клерк, он ещё и клерк в конторе с отсутствующей современной оргтехникой, средствами автоматизации и т.д, ну типа 45летней бухгалтерши тёти Груни из рашкинской мелкой госконторы с тысячами бумажек, папочек и т.д.

Походу какая-то рутина. А можно ли где-то связать жизнь с криптографией и алгебраической/алгеброгеометрической теорией кодирования?

Даже не столько рутина, сколько неинтересно мне. Не люблю я эту статистику и мозги. Мне нравится алгебра, криптография, ассемблер и эксплоиты.

нононо, я пхпшник меня даже после пары лет обучения не берут, так что завали варежку - лучше мачин лернинг буду изучать и работать продаваном, как все.

http://www.spbdk.ru/catalog/1058135.html

>востребованными специалистами

Самое забавное что корреляция между востребованностью и сложностью - вещь мифическая. Хуй угадаешь короче кому ты и чем можешь платно услужить, и если сегодня у тебя всё хорошо, то что будет завтра. Полагаю многие здесь целятся в гугл или хотя бы яндекс чтобы дяди дали нескончаемый поток задач приближенных к науке.

>Зависит от того, откуда ты берешь эту большую часть

Разумеется, светлые головы есть всегда, я же не отрицаю. Но периодически листаю machinelearning.ru, слушаю посонов с ММП-кафедры и из вышки, ну ты понял. И складывается впечатление, что если в матлогику или, скажем, в какую-нибудь теоретическую физику идут люди действительно увлеченные, с горящими глазами, то тут положение прискорбное. Все валом валят в БИГДАТА, потому что модно, и вообще Ерохин уже на конференции ездит. Олдфаги нагружают молодняк неинтересными задачами, а те и не против, чувствуют себя приобщенными зато. И все это приправлено фантазиями об успешных стартапах, пиаром от Бобука, рекламой ШАДа на каждом заборе и толпой PhD с предсказанием цвета медвежьего кала по годам и географическим широтам в диссертации.

>ML тоже уже готов дать в ближайшие годы решения для автопилотов, дизайна лекарств, вопросно-ответных систем

Я скептически смотрю на такие утверждения. На мой взгляд, сам подход, лежащий в основе ML, порочен. От детальной декомпозиции предметной области, понимания и воспроизведения всех деталей в модели, люди переходят к упрощенным моделям-черным ящикам.

>Хайра рассказывал долго и сбивчиво. Саул подгонял и подправлял его. Дело, по-видимому, сводилось к тому, что местные власти пытались овладеть способом управления машинами. Методы при этом использовались чисто варварские. Преступников заставляли тыкать пальцами в отверстия, кнопки, клавиши, запускать руки в двигатели, и смотрели, что при этом происходит. Чаще всего не происходило ничего. Часто машины взрывались. Реже они начинали двигаться, давя и калеча всё вокруг. И совсем редко удавалось заставить машины двигаться упорядоченно. В процессе работы стражники садились подальше от испытываемой машины, а преступники бегали от них к машине и обратно, сообщая, в какую дыру или в какую кнопку будет сунут палец. Всё это тщательно заносилось на чертежи.

Да, так легче, дешевле, во многих случаях продуктивнее. Но ты заметил, насколько чаще стали происходить подобные диалоги: "Ух ты, точность 97%, как ты это сделал?" - "А хуй его знает, коэффициенты удачно подобрал". Какой толк от создания искусственного интеллекта, если мы не будем понимать, как он работает?

Обычно чтобы мозг у ученика не взорвался, талантливый преподаватель придумывает плавную подачу материала. В итоге ученик осваивает предмет быстро, эффективно, без каши в голове и фрустрации. Быть сам себе преподавателем непросто, но этому тоже можно научиться.

Не прошел собеседование в Билайн как раз перед новым годом, спрашивайте ответы.

Каглохолоп-самоучка, в недавнем типа-кагл соревновании от билайна (проходило на хабре, если кто не в курсе) занял BRETTY GOOD :DDD место.

Соответственно, связались, запросили код из соревнования, потом было кратенькое собеседование, где вскрылось, что у меня нет коммерческого опыта работы вообще. В связи с этим, дали еще одно маленькое задание, сделал, отправил только питоновский скрипт. Через почти три недели молчания сам с ними связался - оказалось, что еще нужно дослать что-то типа отчета с описанием основных шагов (с комментарием, мол, "xgboost мы и здесь запускать умеем", будто я не на джуна апплаился). К тому времени нашел работу в своем мухосранске (не связанную с датасаенс вообще никак), и забил. О чем теперь очень жалею.

Надо сказать, что вообще весь процесс общения был очень затянут. Видимо, сказались запуск нового отдела (про который анон написал выше) и их школой.

>>654196

Тут я не в теме, бро. Из коммерческого что-то похожее есть у вирологов в Касперском - ассемблер и эксплоиты плюс немного криптографии. Но туда отбор как в космонавты. Остальные места - это, скорее всего, лаборатории соответствующих кафедр. Я даже не знаю куда сегодня податься криптоаналитику в коммерции. Коммерсам, если надо, проще увеличить разрядность ключа в два раза, чем какие-то теоретические изыски проводить.

>>654218

Секрет Полишинеля: http://libgen.io

>>654239

Спасибо

>>654497

Здесь все так же как и в остальных областях. Хочешь программировать - программируй, а если хочешь писать языки программирования, то волей-неволей прийдется теорию подтягивать. Хочешь просто освоить полезные тулзы и уметь сваять какую-нибудь регрессию, чтобы все охуели как ты можешь - качай либы и тренируйся на https://www.kaggle.com/c/titanic

А если ты угораешь по вещам, находящимися под капотом, то прийдется овладевать матаном.

>>654505

> Все валом валят в БИГДАТА, потому что модно, и вообще Ерохин уже на конференции ездит.

Что-то такое есть. Но это не должно застилать глаза. ML не о кегле и толпах бигдатеров. КМК, ML - это про движение к слиянию человеческого и машинного.

>>654540

>От детальной декомпозиции предметной области, понимания и воспроизведения всех деталей в модели, люди переходят к упрощенным моделям-черным ящикам.

Модель всегда является упрощением реальности и черным ящиком до некоторой степени. И не всегда детальная декомпозиция - это хорошо. Если попытаться детально декомпозировать задачи машинного зрения, то ты утонешь в деталях; в то время как сверточные сети и их обучение на задачах зрения делает декомпозицию такого уровня, которую мы еще можем понять своим мозгом. Другой пример - научные статьи. Каждая статья - попытка людей детально в чем-то разобраться. Способен ли один человек в мире или хотя бы группа людей разобраться во всех статьях, выходящих в печать сегодня? Думаю, нет. А способен ли систематизировать эти знания ИИ в скором времени? Думаю, да. Человек уже не может охватить всего и, так или иначе, нам прийдется полагаться на черные ящики.

>Какой толк от создания искусственного интеллекта, если мы не будем понимать, как он работает?

Люди не понимают как работает большинство из того, чем они успешно пользуются. А во-вторых - имхо, проще понять как работает существующий ИИ, чем интеллект человека.

>>654728

>>654749

Тоже участвовал, лол. Хотя участием это тяжело назвать, в начале соревнования посмотрел на гистограмы, покрутил ручки у xgboost пару часов и забил, потому что не люблю это дело. Занял место в топ-10, потом звонили - не пошел, потому что работа есть уже.

Можешь просто так подать им заявление, если жалеешь. Это нормально.

P.S. Если дотянем до бамплимита и будет перекат, то поправлю шапку - добавлю инфу про кегл для тех, у кого руки чешутся, и про книгу дракона.

>>654196

Тут я не в теме, бро. Из коммерческого что-то похожее есть у вирологов в Касперском - ассемблер и эксплоиты плюс немного криптографии. Но туда отбор как в космонавты. Остальные места - это, скорее всего, лаборатории соответствующих кафедр. Я даже не знаю куда сегодня податься криптоаналитику в коммерции. Коммерсам, если надо, проще увеличить разрядность ключа в два раза, чем какие-то теоретические изыски проводить.

>>654218

Секрет Полишинеля: http://libgen.io

>>654239

Спасибо

>>654497

Здесь все так же как и в остальных областях. Хочешь программировать - программируй, а если хочешь писать языки программирования, то волей-неволей прийдется теорию подтягивать. Хочешь просто освоить полезные тулзы и уметь сваять какую-нибудь регрессию, чтобы все охуели как ты можешь - качай либы и тренируйся на https://www.kaggle.com/c/titanic

А если ты угораешь по вещам, находящимися под капотом, то прийдется овладевать матаном.

>>654505

> Все валом валят в БИГДАТА, потому что модно, и вообще Ерохин уже на конференции ездит.

Что-то такое есть. Но это не должно застилать глаза. ML не о кегле и толпах бигдатеров. КМК, ML - это про движение к слиянию человеческого и машинного.

>>654540

>От детальной декомпозиции предметной области, понимания и воспроизведения всех деталей в модели, люди переходят к упрощенным моделям-черным ящикам.

Модель всегда является упрощением реальности и черным ящиком до некоторой степени. И не всегда детальная декомпозиция - это хорошо. Если попытаться детально декомпозировать задачи машинного зрения, то ты утонешь в деталях; в то время как сверточные сети и их обучение на задачах зрения делает декомпозицию такого уровня, которую мы еще можем понять своим мозгом. Другой пример - научные статьи. Каждая статья - попытка людей детально в чем-то разобраться. Способен ли один человек в мире или хотя бы группа людей разобраться во всех статьях, выходящих в печать сегодня? Думаю, нет. А способен ли систематизировать эти знания ИИ в скором времени? Думаю, да. Человек уже не может охватить всего и, так или иначе, нам прийдется полагаться на черные ящики.

>Какой толк от создания искусственного интеллекта, если мы не будем понимать, как он работает?

Люди не понимают как работает большинство из того, чем они успешно пользуются. А во-вторых - имхо, проще понять как работает существующий ИИ, чем интеллект человека.

>>654728

>>654749

Тоже участвовал, лол. Хотя участием это тяжело назвать, в начале соревнования посмотрел на гистограмы, покрутил ручки у xgboost пару часов и забил, потому что не люблю это дело. Занял место в топ-10, потом звонили - не пошел, потому что работа есть уже.

Можешь просто так подать им заявление, если жалеешь. Это нормально.

P.S. Если дотянем до бамплимита и будет перекат, то поправлю шапку - добавлю инфу про кегл для тех, у кого руки чешутся, и про книгу дракона.

Традиционно освятил.

>Пытаешься помочь безработным эскапистам, ведущимся на хайп, принять правильное решение в выборе направления профессионального развития

>Говорят, что тебе припекло

Okay

>>654176

> работы в твоих "востребованных профессиях" это заунылейший однотипный дроч с пониженной интеллектуальной составляющей, сродни перекладывания бумажек в офисе

> пхпист, 1Сник, яваиндус, дуднечик = офисный клерк

>подобные языки максимум простые и тупые, оттого и средства программирования предоставляемые ими чрезвычайно убогие и говёные

Вот об этом я и говорил. Типичный представитель /pr . ЧСВ до облаков, всех реальных специалистов считает говном. Себя считает намного умнее и талантливее всех этих людей, поэтому из принципа не хочет заниматься тем, чем занимаются они.

При этом игнорирует тот факт, что он живет на мамины деньги и его самого никто не возьмет на вакансию пхп-джуна (потому что он не осилил херову тучу веб-технологий и фреймворков).

Эскапизм сферический в вакууме.

>>654357

>Самое забавное что корреляция между востребованностью и сложностью - вещь мифическая.

Корреляция скорее обратная. Чем выше коэффициент эффективность/сложность, тем активнее область/технология развивается, вытесняя все конкурирующие области. Потенциально мощные, но неоправданно сложные технологии никогда не приживаются, ими занимаются единицы энтузиастов в качестве хобби, либо (если им очень сильно повезло) за деньги в топовых университетах и организациях уровня Гугла. И какой процент таких счастливчиков? Это то же самое, что сказать: "Шварценеггер накачался и стал успешным, значит мне тоже нужно качаться". При этом тот факт, что 99.9% накачавшихся никак свою жизнь не изменили и впустую потратили время - упрямо игнорируется.

>Тоже участвовал, лол. Хотя участием это тяжело назвать, в начале соревнования посмотрел на гистограмы, покрутил ручки у xgboost пару часов и забил, потому что не люблю это дело. Занял место в топ-10, потом звонили - не пошел, потому что работа есть уже.

Значит нас уже двое тут из топ-10, сидящих на зекаче. Какова вероятность?

Если не секрет, что за работа? Пили стори. На кегле тоже не участвуешь? Не ради чесания рук, так ради денег Как я понял, с опытом проблем нет у тебя.

>Да. Что тебе не нравится?

"Killed" в конце не понравилось. Но вроде и правда работает, пример с cifar10 пока не вывалмлся с ошибкой. А вот тут http://datareview.info/article/tensorflow-razocharovyivaet-glubokomu-obucheniyu-ot-google-ne-hvataet-glubinyi/ говорят, что свободная версия не поддерживает масштабируемости:

>Кроме того, есть вопросы по поводу масштабируемости (а точнее, ее отсутствия). Название официальной публикации, посвященной TensorFlow, звучит следующим образом: «TensorFlow. Крупномасштабное машинное обучение в гетерогенных распределенных системах» (TensorFlow: Large-Scale Machine Learning on Heterogeneous Distributed Systems). Однако версия с открытым исходным кодом выполняется только на одном узле.

до этого читал "First Course in Machine Learning" и "Learning from Data" (половину где то, не особо понравилось)

>Есть что-нибудь по гугловскому TensorFlow? Кроме ссылок на туторы с оффсайта естественно.

В марте обещают книжку http://www.tensorflowbook.org/ надеюсь бесплатно, а то когда еще на либгене будет

Интересно почему так. В ШАДе курс доставлял. То ли Воронцов скатился, то ли курсера упростила программу.

>>654928

>Если не секрет, что за работа? Пили стори.

Не секрет, Я. Какие стори пилить не знаю. Да и нельзя особо растекаться.

На кегле участвую только в чем-нибудь новом для меня, да и лишь когда время есть. Раньше чаще зависал. Руку набить помогает, но в десятый раз сидеть и перебирать параметры по сеточке уже надоедает, а некоторые контесты только так и решаются.

>К тому времени нашел работу в своем мухосранске (не связанную с датасаенс вообще никак), и забил. О чем теперь очень жалею.

Ну так и продолжи собеседоваться нахуй. Дошли что просили, сопроводи письмом. Они вроде до сих пор народ набирают.

>>654997

Killed пушто там демон поднимается под капотом, его SIGKILLом и вырубают после завершения действий.

>свободная версия не поддерживает масштабируемости

И да, и нет. У гугла есть сетевая версия, она действительно не в паблике. С другой стороны, масштабирование на GPU и на несколько процессоров запилено и работает.

>>655991

Охуенно же, правда никакой инфы в сети я не нашел. С другой стороны, у автора почти все принты в pdf выложены на личной странице. Хочется верить, что эта книга не будет исключением.

А я-то думал, что тайной компиляции в x86 бинарник, помимо пропрьетарных жидокощеев, обладает только дедушка Столмэн и его верные адепты.

>У гугла есть сетевая версия, она действительно не в паблике. С другой стороны, масштабирование на GPU и на несколько процессоров запилено и работает.

То, что на нескольких процессорах локально работает, это понятно. Вот в этой http://download.tensorflow.org/paper/whitepaper2015.pdf статье пишут, что общий граф можно разбить на субграфы, которые могут выполняться на физически разных девайсах, и их взаимодействие реализовано через receive и send узлы, поддерживающие разные протоколы, в т.ч. ТСР. Так вот, эти узлы присутствуют в свободной версии?

>Programming

>1. Python Unlocked.

ОП, тебе правда нужна книга, чтобы кодить на питоне?

Обсуждать сферический МЛ в вакууме скучно. Всю необходимую информацию можно найти за минуту в гугле. Новости все можно узнать из реддита. Лучше бы рассказал, что ты делаешь, или что тебе конкретно интересно.

Интерпретируемость - это как та или иная программа (компилятор или интерпретатор) работает с листингом кода, а не неотъемлемое свойство языка. Для того же C++ есть отличный интерпретатор Cint.

>>657506

>ОП, тебе правда нужна книга, чтобы кодить на питоне?

Да, мне правда нужна книга, чтобы осознать некоторое мясо в питоне. Надеюсь понятно, что Python Unlocked не об основах языка. Например, в интернете на тот момент я не нашел ни одного внятного описания дескриптора и того, как это влияет на порядок обхода для извлечения атрибутов. Согласен, что в большинстве случаев нужно сесть и начать кодить, но в определенный момент времени есть риск выучить неэффективный подход и пропустить мимо эффективный. Либо ты можешь столкнуться с кодом, который невозможно понять без этих знаний.

>Обсуждать сферический МЛ в вакууме скучно. Всю необходимую информацию можно найти за минуту в гугле.

Так можно сказать про большинство тредов двача.

>Лучше бы рассказал, что ты делаешь, или что тебе конкретно интересно.

Так задавай вопросы мне и остальным, я с удовольствием расскажу что знаю.

У меня большую часть времени занимает работа, про которую много и не могу говорить. Без конкретики - я защищаю сервисы Я и их пользователей от ботов. Кроме того, в свободное время пилю несколько побочных проектов разной степени тухлости и занимаюсь нейронными сетями для зрения. Один из проектов про автоматическое извлечение онтологий из текстовых данных: нужна универсальная тулза а-ля xgboost или vowpal на такой сорт задач. Второй - про сети добровольных вычислений, когда каждый участник сети все свободное процессорное время отдает в сеть, а взамен в любой момент времени может от сети потребовать большое количество процессорного времени на свои задачи. Иными словами, это про взятие вычислительных квантов в долг.

>>657496

Я еще раз проверил - в коде стоят заглушки на распаралеливание по физически разным девайсам.

Выглядеть будет как with tf.device('/job:worker/...')

Но кода еще нет, обещают выкатить, когда - неизвестно. Сегодня выкатили gRPC фронт для предсказаний под названием TensorFlow Serving. Тренировать пока все равно нельзя.

Детали здесь: https://github.com/tensorflow/tensorflow/issues/23

Интерпретируемость - это как та или иная программа (компилятор или интерпретатор) работает с листингом кода, а не неотъемлемое свойство языка. Для того же C++ есть отличный интерпретатор Cint.

>>657506

>ОП, тебе правда нужна книга, чтобы кодить на питоне?

Да, мне правда нужна книга, чтобы осознать некоторое мясо в питоне. Надеюсь понятно, что Python Unlocked не об основах языка. Например, в интернете на тот момент я не нашел ни одного внятного описания дескриптора и того, как это влияет на порядок обхода для извлечения атрибутов. Согласен, что в большинстве случаев нужно сесть и начать кодить, но в определенный момент времени есть риск выучить неэффективный подход и пропустить мимо эффективный. Либо ты можешь столкнуться с кодом, который невозможно понять без этих знаний.

>Обсуждать сферический МЛ в вакууме скучно. Всю необходимую информацию можно найти за минуту в гугле.

Так можно сказать про большинство тредов двача.

>Лучше бы рассказал, что ты делаешь, или что тебе конкретно интересно.

Так задавай вопросы мне и остальным, я с удовольствием расскажу что знаю.

У меня большую часть времени занимает работа, про которую много и не могу говорить. Без конкретики - я защищаю сервисы Я и их пользователей от ботов. Кроме того, в свободное время пилю несколько побочных проектов разной степени тухлости и занимаюсь нейронными сетями для зрения. Один из проектов про автоматическое извлечение онтологий из текстовых данных: нужна универсальная тулза а-ля xgboost или vowpal на такой сорт задач. Второй - про сети добровольных вычислений, когда каждый участник сети все свободное процессорное время отдает в сеть, а взамен в любой момент времени может от сети потребовать большое количество процессорного времени на свои задачи. Иными словами, это про взятие вычислительных квантов в долг.

>>657496

Я еще раз проверил - в коде стоят заглушки на распаралеливание по физически разным девайсам.

Выглядеть будет как with tf.device('/job:worker/...')

Но кода еще нет, обещают выкатить, когда - неизвестно. Сегодня выкатили gRPC фронт для предсказаний под названием TensorFlow Serving. Тренировать пока все равно нельзя.

Детали здесь: https://github.com/tensorflow/tensorflow/issues/23

>неразрешимая грамматика

>Гугл 0 результатов, редирект на неоднозначную грамматику

>пытается выебнуться, даже не понимая терминов

>связывает качество интерпретатора с грамматикой

Найс даун выполз.

> Нет, ML не оверхайпнутая параша

мне припекло от этих молодых и смешливых

А почему это оверхайпнутая параша? Потому что так сказал какой-то онанимный долбоеб с подтирача?

Ну вот про зрение расскажи, там же современные технологии используются. В чем суть, какие успехи. На гитхаб выкладываешь поделия?

Использует ли яндекс глубокие НС в продакшене? Собирается ли? Если да, в каких системах?

О, хуесос-Кантор уже тут. Уже заплатили 400 евро чтобы за 3 месяца стать СУПЕР ВАСТРЕБАВАННЫМ СПЕЦИАЛИЗЛОМ ДАТА СУЕНС ПРЕДСКАЗАТЕЛЕМ СТЕПЕНИ ТВЕРДОСТИ КАЛА ПО ОБУЧАЮЩЕЙ ВЫБОРКЕ РУЧНЫХ КУНИЦ???

Но ты почти дочитал.

>спарк,

Хмм, не слышал про такое. Но там же нет deeplearning'a, только через сторонние библиотеки типа http://deepdist.com/ ?

>>659236

>Где по спарку можно почитать?

Как-то так, наверное http://gen.lib.rus.ec/book/index.php?md5=7d95152846161d75c6937e058717ab83

https://github.com/tensorflow/tensorflow/releases

Allow using any installed Cuda >= 7.0 and cuDNN >= R2, and add support for cuDNN R4

Added a contrib/ directory for unsupported or experimental features, including higher level layers module

Added an easy way to add and dynamically load user-defined ops

Built out a good suite of tests, things should break less!

Added MetaGraphDef which makes it easier to save graphs with metadata

Added assignments for "Deep Learning with TensorFlow" udacity course

Кстати, под какой пистон его лучше ставить, под 2 или 3ий?

>Comparing to other open-source ML systems, MXNet provides a superset programming interface to Torch7 [3], Theano [1], Chainer [5] and Caffe [7], and supports more systems such as GPU clusters. MXNet is close to TensorFlow [11] but can additionally embed imperative tensor operations. MXNet is lightweight, e.g. the prediction codes fit into a single 50K lines C++ source file with no other dependency, and has more languages supports. More detailed comparisons are shown in Table 2.

Ну так расскажи подробнее, какие прорывы?

Вот на даггый момент я знаю, что буквы определять можно, причем разной степени сложности. Какое окружение используете, какие разработки?

Просто все твое описание сейчас выглядит так:

Я делаю нейросеть для определения текста - звучит скучновато, потому что это одна из непосредственных задач нейросетей.

Ну и классика: хожишь на мит апы в It*МANUSS9DилPUNCTUMosCсру каждый год? Если да, то удалось подцепить оттуда что-нибудь годное: знания, связи?

Слышал, но не использовал. Судя по тому, что за 4 года они не зарелизили версию 1.0, развивается проект тухло. Spark доставляет гораздо больше, хотя меня до определенной версии очень заебывали постоянные эксепшены в лямбдах (Scala мы не юзали). Сейчас вроде все ок.

>>659236

https://www.youtube.com/watch?v=7k4yDKBYOcw

https://www.youtube.com/watch?v=VWeWViFCzzg

А вот про почитать не знаю.

>>659463

>Но там же нет deeplearning'a, только через сторонние библиотеки типа

Глубокое обучение суть перемножение тензоров. Такое могут делать даже самые куцые системы. Другое дело в удобстве. И да, на Spark можно учить сетки, в mllib вроде собирались добавить такую возможность.

>>659790

И так и не влили коммит, врубающий GPU на маках. Аж трисет, уже два месяца как PR болтается с фиксами.

>Алсо, возможность распределенного выполнения пока жмутся вылаживать

Есть мнение, что они причесывают код и вычищают его от коммерческой тайны, это дело небыстрое.

>Кстати, под какой пистон его лучше ставить, под 2 или 3ий?

Ставь под третий, если не отягощен легаси.

>>661127

Буквы же были самой первой задачей, которую решили на сетях.

>Ну и классика: хожишь на мит апы в j'#МANUSи^&YлPUNCTUMсрHrOу каждый год? Если да, то удалось подцепить оттуда что-нибудь годное: знания, связи?

Нет, не хожу, мне внутрияшных событий хватает с головой. Связи как-то сами обретаются в процессе разработки, а с мейлом, ко всему прочему, есть отдельные контакты по линии противостояния ботнетам.

И да, хорошо, я попробую рассказать про зрение в посте завтра или послезавтра. На это нужно время. На вопросы про работу не могу ответить. Могу разве уточнить что использовать глубокие нейронные сети в продакшене, если это не задачи зрения - оверкилл. Несложные куски типа натренированных энкодеров вероятно могут использоваться.

Бампнул машинных богов

>Есть мнение, что они причесывают код и вычищают его от коммерческой тайны, это дело небыстрое.

А что может быть коммерчески тайного в распределенном перемножении тензоров? Тайна полишинеля, лол. Вон >>661052 у некоторого китайца тоже распределенное выполнение, в т.ч. на мобильниках.

Они проще. С аутоэнкодерами очень много возни, а результат неопределенный. К тому же когда стали использовать ReLU юниты вместо сигмоидов, оказалось что можно тренировать их с нуля, вместо инициализации с помощью аутоэнкодеров.

>античеловеческие проекты по превращению планеты в криптоантиутопию

Давно этого жду. А ты шел бы отсюда, петушок хипсторский.

>львиная доля прикладных применений - всякие античеловеческие проекты по превращению планеты в криптоантиутопию.

Примеры? И почему это должно напрягать? Ты из этих что ли, "диды лаптем щи хлебали, чем мы хуже, нинужОн нам ваш инторнет"?

бамп

Selenium жи

Все что не дифференцируемо (а значит, не может в backpropagation ) - не нужно.

Но в бекпропагейшн очень много что может. В частности - все нечеткие модели.

Ну сделай, покажи результаты. Опубликуйся в архиве, выложи код под тензорфлоу на гитхаб, отрасти бороду и будешь почти своим в тусовке.

В яндексы и гуглы меня, скорее всего, не возьмут, потому что я туповат и не особо задрот. Существуют ли не требующие неебического объема знаний вакансии в этой области?

Бамп вопросу от другого анона. Похожая ситуация, закончил бакалавриат, пошел в тыртырпрайз. Теперь понимаю как же это отсосно, все эти контроллеры, сервисы, вьюшки. Даже несмотря на заработок.

В нечеткой логике используется, как правило, какой-нибудь сигмоид, т.е. функция с насыщением, у которой градиенты на краях стремятся к нулю, это приводит к замедлению (вплоть до бесконечности). По этой причине перешли на ReLU, а ты хочешь вернуть сигмоиды.

>к замедлению

К замедлению обучения.

Это такой же развод как и нейронные сети.

Буду очень благодарен, если расскажежешь кулстори как учился, какие материалы/курсы использовал.

Ок, сигмоиды в сверточных сетях и правда не нужны. Но вот там есть операция max-pooling, выбор максимального значения. Если там использовать не максимум, а какую-нибудь нечеткую параметризованную т-конорму?

Максимум очень быстрый на GPU (даже по сравнению с average pooling), а эффективность тут решает больше, чем йоба-алгоритмы. Хз, можешь попробовать, благо с theano это недолго, можешь и статейку напишешь.

Есть определенная функция - черный ящик, что внутри мне неизвестно, на вход принимает 5 чисел [-100, 100], на выходе единица или ноль. Есть огромная выборка данных для тренировки, требуется симулировать поведение этой функции на новых данных.

Я не прошу решение, подскажите в какую сторону, по каким ключевым словам копать, желательно с примерами на java/python, любые библиотеки. Полностью погружаться в тему нет времени.

Делишь твою огромную выборку на 2 части - тренировочную и проверочную. На тренировочной тренируешь machine learning алгоритм классификации (их много, начни с SVM), а проверочной тестируешь, хорошо ли натренировалось. Питон? Начни отсюда - http://scikit-learn.org/stable/modules/svm.html

Кому нахуй моя кулстори нужна, если я даже работу еще не нашел?

Все стандартно - случайно набрел на John Hopkins курс на курсере, потом сел на кагл. На кагле очень часто очень много инфы кидают на статейки. Изредка поглядываю другие курсы на курсере, обычно все сам гуглю. Пробел в знаниях размером океан. Оттого и не берут.

Не будь как я, вкатывайся в шад какой-нибудь и зубри что дают.

Спасибо, что ответил. Я и не расчитывал на историю "из грязи в князи". Подумываю насчет вката из веб-разработки вот и интересно стало. Спасибо за совет.

>2016

>SVM

Можешь за этот алгоритм пояснить? Там какое-то сильное колдунство, я так и не въехал во все эти ПРОСТРАНСТВА ВАПНИКА-ЧЕРВОНЕНКИСА.

Этот алгоритм хорош тем, что его можно рассматривать как черный ящик. Он очень прост в эксплуатации, даешь на вход классы, он выдает тебе оптимальную гиперплоскость, которая их разделяет. Все колдунство заключается в том, что такое оптимальная гиперплоскость и как ее построить (а также так называемый kernel trick который позвоялет вместо гиперплоскости использовать какую-то другую гиперповерхность). Посмотри как работает 2д случай для получения интуиции и сойдет.

http://pastebin.com/0KNRxq8M

Ну я так понял, что самые важные признаки - это 'Fare' и 'Age'. При сабмите курсера не принимает и пишет

> Обратите внимание как нумеруются признаки у feature_importances_.

А как понять как они нумеруются? Нагуглить ниче не удалось. Я сделал предположение, что они нумеруются в таком порядке, в каком они были в оригинальном датафрейме, когда он только был загружен. Но так у меня тоже не принялось.

Не понял. Что из себя представляет dataobj? Почему у тебя такие значения feature_importances получились?

Алсо, если я после своего кода допишу features.head(), то у меня там признаки в порядке Pclass Fare Age Sex.

Датасет надо чистить от nan потому что, dropna() функция такая есть. Вот такому значит порядку и соответствуют значения.

А dataobj это признаки как раз, коряво поименовал.

посмотрел, неясно, отчего результат другой, наверно ты фартовый.)

Знаешь, что? Попробуй уже выделив из датасета целевой вектор и признаки делать дроп. Вот что. Только пусть они будут в одном подмножестве при этом, разделишь после.

Потому что ты так сказал? Очень весомо, да.

ОП, спасибо за подборочку! Где учишься\работаешь?

Матстат другими словами.

Проиграл с пика. Машинное обучение ДЛЯ ХАЦКЕРОВ, лол.

Искусственный интеллект, самообучающиеся системы, rocket science. Чтобы двигать человечество вперед к светлому будущему и по ходу дела ссать на энтерпрайзных и веб-макак, ненужный биомусор и обслугу бизнеса.

И что смешного?

- главные компоненты

- мегагитлермодная китайская библиотека xgboost

- диплернинг, ну куда же без него)))

Рандом форест не заметил, но наверняка на втором-третьем месте после китайской параши. Все, что больше 2х лет назад появилось - нинужно и "на свалке истории". Ну кроме главных компонентов. Пиздец, деградантство.

Мда, пойду читать дискретку.

>Тема интересная, но совершенно не коммерческая.

Дяде не продаться за копейки? Потеря потерь. На том же кегле соревнования от 25к, не рублей. Есть и 200к.

ну иди соревнуйся. только вот с реальным написанием самообучающихся структур это ничего общего не имеет. тема реально не финансируется. там нужны долгие годы самооубучения, которого у обычных крудоклепов нет, ибо доширак надо покупать на что-то.

попил без результатов.

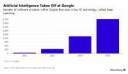

Это не количество AI проектов в Гугле, а количество проектов, использующий конкретный алгоритм.

Раньше они, возможно, использовали другой алгоритм, например SVM.

Дипленинг появился больше 5 лет назад.

>>663977

Для исследований кресты не нужны, а вот пилить осязаемые системы - да, нужны. Мапредьюсы, аллокаторы памяти, йоба алгоритмы для оптимизаций в машинном обучении, etc.

>>661747

Это была внутренняя система гугла, с кучей говнокода и перекрестных ссылок с другими системами. Вычесать все это из кода есть расчистка авгиевых конюшен.

>>670470

У меня похожая ситуация была - работал в ява-говноэнтерпрайзе. Не в силах выдержать, сбежал оттуда, засел за книжки и через определенное время усердного задрачивания таки стал магом.

Выше я кидал ссылки (CTRL+F связной), куда можно попробоваться тыкнуться на младшие позиции.

Расскажи сколько у тебя опыт работы программистом был, когда ты решил перекатиться, и сколько в деньгах потерял по сравнению с тем когда ушел из коммерческого программирования, и сумел ли по деньгам наверстать разницу и сколько примерно по времени это у тебя заняло.

мимокрудошлеп

Если считать в говнерублях, то з/п выросла охуеть как сразу по переходу. В валюте же на 30-35% выросла, если сравнивать с последним рабочим местом. Плюс сейчас на работе социалка огромная, а на предыдущей она так себе была. Думаю, её можно рассматривать как +10-15% к з/п. Но есть пара моментов. Во-первых, я рачил на апворке и у друга-эмигранта по удаленке много времени. Все это позволило мне не стесняясь вписать себе стаж (кресты и питон) в резюме. Во-вторых - в промежуток между работами я успел бакалавриат закончить, может это еще как-то на з/п повлияло, хз.

>>680247

^.^

Деградантство это сидеть на свалке истории и в бессильной злобе потрясать тощими кулачонками в сторону уходящего вперед человечества. Ну то есть то что ты делаешь.

Те кто могут это сделать не являются спермотоксикозными девственниками, а обычно снимают твою мамашу за даллары и ебут во все щели.

Хуйню спизданул. Любой человек хочет созерцать обнаженное тело, поскольку оно красиво. Погромизд нейронок не будет этого отрицать, поскольку он в большинстве атеист, а значит умеренный моралфаг. Еще такая сеть имеет коммерческий интерес.

Поэтому ему надо въебывать дохуя часов и сил чтобы получить то, из чего интернет итак состоит на 90%? Нахуй пошел, залетный даун.

Я не хочу, например. 99% тел уродливы, обвислые жопы, трясущиеся пузяки, всратые лица.

На твоей вебмке ужасное лицо лупоглазое у тян, трясущийся ПУЗЯК и другие радости.

О Т В Р А Т И Т Е Л Ь Н О

Мне и аниму отвратительна, щас бы нахуяченые на флэше мультики с одинаковыми плоскими персонажами но разными прическами посмотреть, эхх.

Она все ещё отвратительна, если для тебя она ок, представляю какой ты всратый, кек

>Этими вашими сетями можно раздеть одетую девушку?

Это и без сетей можно сделать. Тебе не дают != никому не дают.

Проиграл

Ты немного не понял. Есть такие тянки с которыми не светит ни тебе ни мне ну никак, а посмотреть на них хочется чисто в эстетических интересах.

А то ты там что-то уникальное увидишь.

А, ну и теория игр от них же, годная вещь для конструирования интеллектуальных агентов

http://pastebin.com/dGGLDSx7

Чудеса динамической типизации, наслаждайся гвидобейсиком.

Кто что скажет про этот курс и его инструкторов? Только по конструктиву, а не ТРАЛЕНК ТРАЛЕНК ))))))))

Не он, но русский и тоже называю это колорадкой. А лектору политические взгляды вообще не стоит демонстрировать.

У тебя двоемыслие какое-то.

Двачую.

Эта ленточка и была придумана в свое время, чтобы никаких политических взглядов не выражать. Если ты видишь тут политику, то ты хохол.

А в последнее время стала символом вполне определенных политических взглядов. Другой пример - свастика.

Театральность таки привносит в ai. И правда, новый интернет наступает походу. Мне с дивана все видно

Его прога не строит аналитическую модель происходящего на дороге. Этим он здорово облегчил себе задачу, но доказать, что она знает и соблюдает все правила будет невозможно. Это тупиковая ветвь. Гугл сможет продолжать наращивать девятки в доле правильных решений, а он не сможет, потому что количество требуемого обучения будет рости экспоненциально, потребуется более мощный чип и т.д.

Зато можно будет впечатлять инвесторов результатами и жаловаться на Маска, когда тот откажется признавать его поделие убийцей Теслы.

Эта схема получения инвестиций давно отработана изобретателями вечных двигателей. Бегай себе вокруг прибора, рассказывай про неонку и про то, как тебя ущемляют проклятые учёные, да выпрашивай денег на новый специальный подшипник, с которым проклятое трение будет наконец побеждено.

Не гони на Савватеева, он няшка и хороший человек. Школьникам лекции по всей России читает (про группы).

Пускай даже у него стольже экзотичные политические взгляды как у Вербицкого, только наоборот.

В SVM ядро понятно, нелинейное преобразование пространства. В нейросетях такая же цель ?

Или для условия дифференцируемости ? Или чтобы ограничить сверху ? Поясните плез.

>>666224

>Reinforcement learning

https://github.com/junhyukoh/deep-reinforcement-learning-papers

Допустим она у тебя линейная.

Первый слой, x0 вход, x1 выход, X0 - веса

x1=X0x0

Второй слой, x1 вход, x2 выход, X1- веса

x2=X1x1

Подставляем:

x2=X1X0x0

Т.е. "нейросеть" твоя оказывается тупым линейным классификатором, сколько бы у нее слоев не было.

А теперь вводим нелинейность:

x2=f(X1f(X0x0))

Все, теперь уже так не получится.

Не обращал внимание. У меня такие же пингвинчики есть)))

Первый слой является обычной линейной регрессией.

Согласен.

Дальше идёт линейная регрессия от каждого нейроная входного слоя и т.д.

Это не объясняет почему используют функцию активации. Тот же ReLu это max(0,w), просто передаёт ноль если значение нейрона если он меньше нуля. Хотя если вставить просто линейную функцию, нихуя обучиться не получится. Где магия ?

Есть способы с помощью нейросети обобщить функцию ?

Допустим если мы предъявляем сети информацию которая не входила в диапазон обучения, то ясень красень поведение функции предсказать не получится. Можно ли как то это исправить, не преобразуя признак ? Рекуррентные сетки ?

Есть. Пробовал реализовать алгоритм deep Q-learning - не сходится, хотя это вроде его фишка, нужно много тюнить параметры, чтобы сошёлся. Хочу попробовать model-based подход, а у тебя какие успехи, анон?

Аналогично, пробовал его, тоже не сходился (или сходился но слишком медленно, я так и не понял)

Я думаю всё из-за того что в самом чёрном ящике интересная система вознаграждения. Там награда выдается не через каждый шаг, а за одно действие которое аккумулируют награду 4 предыдущих шагов, при том во время выбора действия во время этих 4 шагов награды получаешь ноль. (то-есть узнаешь правильный ли выбор через 4 шага)

Тут возможно несколько решений. Добавить рекурентные связи, подавать на вход историю, или как то обобщать это всё.

Я сейчас тоже пробую другим путём пойти, пока мучаю нейроэволюционные модели.

В курсе что любую функцию можно представить в виде ряда ? У этого ряда есть коэффициенты, если подобрать их так чтобы минимизировать ошибку, то и получится функция которая отражает данную зависимость.

Как раз сейчас пробую взять историю и предсказывать следующее состояние и награду, чтобы потом совместить с каким-нибудь поиском по дереву.

Кстати, не пытался по-честному, без дизассемблирования, реверсить blackbox? Я пока только посмотрел на матрицу корреляции между компонентами вектора состояния и там явно есть сильно связанные пары. Ещё интересно ведёт себя 36-тая компонента, она изменяется от -1 до 1 и повышать её можно действием 1, а снижать 3.

Ну не реверсить, просто изучать (ибо не думаю что можно адекватно реверснуть, слишком много оверхеда питоновского)

То что понял указал выше, ещё заметил что одно небольшое изменение может вызывать отклик среды на много шагов вперёд. Я думаю они за основу брали что то фрактало-подобное.

Пробовал тоже предсказывать, но особо не получилось (как раз из-за этого пробела в отсутствии награды), думаю что нужно предсказывать на несколько шагов вперёд.

Для того, чтобы выбивать гранты, пиарить университеты и говнокурсы на моок платформах, ну и конечно же, сосать хуи без опыта реальной работы и за бесплатно решать задачи для богатых дядек на Кегеле, который организовал хитрый жид.

Ты меня жопой прочитал.

>Первый слой является обычной линейной регрессией.

Неправильно. Линейная регрессия - это способ подобрать коэффициенты матрицы (X в x1=Xx0), а тебе здесь это не важно, важно другое, формула первого курса матричного умножения, что ABx=(AB)x. То есть любая твоя нейросеть без функции активации сведется к однослойной сети. Поэтому в многослойных сетях без функции активации нет никакого смысла - это та же самая формула x1=Xx0.

>Где магия ?

Магия в том, что линейный классификатор работает только с линейно разделимыми задачами, т.е. когда в твоем многомерном пространстве между классами можно провести гиперплоскость.

Нейросеть же каким-то образом преобразует (т.е. растягивает, сжимает и т. п.) пространство, чтобы последнему слою уже достаталась линейно-разделимая задача. Вот этот блог http://colah.github.io/posts/2014-03-NN-Manifolds-Topology/ прочитай блог целиком, он того стоит.

В теории вид нелинейной функции особо не важен, но на практике есть ограничения, вызыванные способом обучения через backpropagation - насыщение вызывает проблему очень маленького градиента, слшком большие числа вызывают погрешности вычисления и т. п.

Пока что в конкурсе нет победителя. Ну что, макаки, сможете переиграть хотя бы бэйзлайн - линейную регрессию, идущую в составе стартового набора?

я не смог

Окстись, на данный момент весь МЛ в питоне происходит.

Впрочем, если ты не в теме, тебе ничего не светит все равно.

Сейчас занимаюсь статистикой и ML в университете, по пути изучая AGI.

R и Apache Spark(Spark MLib)

Знакомый пилил подсчет клиентов по видеопотоку в одной конторе, рассказывал что в OpenCV есть немного machine learning.

Насколько сложные модели используете, кодите ли их вручную? Ебётесь ли с выводом формул для вывода в сложных моделях?

Есть, можно по HOG'ам пытаться считать, да.

если выборка достаточно хорошая, и ты смог правильно обучится, то и получится модель которая хорошо обобщает некую зависимость

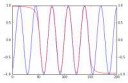

Вот видишь этот синус ?

А это нихуя не синус, это просто точки, ты сам у себя в голове обобщил до синуса (считай гештальт образ)

а на счёт трединга

есть некие тренды, тренд не может длится вечно, рано или поздно он закончится в связи с достижением некой точки насыщения. Сама идея колеблющегося тренда уже некое обобщение. Осталось угадать на сколько долго будет идти тренд, чтобы сделать правлиьное действие. И на это тоже есть некоторые вероятностные эвристики. Те же обычные китайские свечи, они помогают выявить некие паттерны.

японские свечи, пардон

Это сугубо теоретическая вещь пока что.

>>706445

Вопрос если не на миллион долларов, то тысячи на четыре, лол. Если знать как они это сделали и подставить вместо регрессии более сильную модель, почти наверняка можно круто подняться. Судя по постам от админа, сейчас все в основном пытаются модифицировать регрессию.

В том-то и дело, что нет никаких зависимостей. Можно выиграть только на временном лаге, опередив остальных лошков с кухни. Или быть инициатором = иметь инсайд. Все стратегии не учитывают влияние самого бота на рынок. Тут явный эффект бабочки.

Если и удается найти какую-то слабоплюсовую стратегию, весь профит сжирают: комиссии брокеру + зарплата прогерам/твое время + аренда вычислительного кластера.

В общем, в трейдинге, как и в покере, всегда выигрывает только заведение. И немного хлеба перепадает верхушке самых быстрых и мощных.

Впрочем, в других областях машинное обучение вполне легитно.

В чем твоя проблема? Не занимайся трейдингом.

>нет никаких зависимостей

Очевидно есть. Тебе только нужно построить как можно более точный прогноз. И строить прогноз нужно не на одну сделку, а на месяц вперёд для управления рисками.

Пример из фундаментального анализа. Представь что завтра вышла новость что билла гейтса застукали как он жёстко выдрал несовершеннолетнего тайского трапа и теперь ему грозит срок. Это как то бы отразилось на котировках мелкософта ?

Или из технического анализа если тред пошёл вниз, то он на следующем шаге пойдет вверх ? нет! на то это и тренд.

Просто чем дальше горизонт планирования, тем больше вероятность что ты обосрёшься (или сорвёшь куш), нужно искать оптимум исходя из рисков.

>всегда выигрывает только заведение

очевидно тогда бы никто не торговал

Он совершенно прав, а ты слушай, что тебе умные люди говорят, и мотай на ус.

>очевидно тогда бы никто не торговал

Очевидно в лотерею никто не играет.

Да, хуле вы на трейдинге то зациклились?

Есть же системы управления, которые сейчас очень тесно свзяна ы с RL, есть задачи CV, которые частично помогают автоматизировать проихводство. На Байесовски сетях вон обучаемые экспертные системы строят.

С такой точкой зрения можно вообще критиковать любые алгоритмы решения некоректных задач. Тогда как умение решать некоректные задачи отличает хорошего математика от зубрилки из второсортной шараги.

Он утверждает что нет зависимостей, я говорю что есть и указываю на них, так что я прав пока не доказано обратное.

Я ещё могу согласится с тем что трейдинг это ещё один лохотрон по вытягиванию денег из людей. Игра с нулевой суммой, то да сё.

Да, заведение оставляет себе некую фиксированную комиссию, но где остальные деньги ?

Они перетекают от одного человека к другому.

И кто то, кто считает себя ниибацца букмекером проебывает, а человек с алгоритмами и холодным расчётом постепенно копит у себя осадок.

Это как торговля в реальной жизни.

Ты можешь купить нечто заранее если считаешь что в скором времени цена на это подымется, а потом продать по завышенной цене, чем не ТРЕЙДИНГ ?

Двачую, читал статью на гиктаймсе про лабу, где чувак финансировал исследования, занимаясь трейдингом.

>Представь что завтра вышла новость что билла гейтса застукали как он жёстко выдрал несовершеннолетнего тайского трапа и теперь ему грозит срок

Выиграют самые быстрые: журналюги, уборщицы гейтса, мамка трапа.

Вот смотри. Каждый человек, принимает в своей жизни, допустим, 20 рисковых решений. Ну или за него их принимает среда. Мат. ожидание каждого - околонулевое. Для простоты пусть это будет система Double or nothing. Так вот среди всех людей найдется в среднем (7*10^9 / 2^20) = 6675 человек, которые выиграют все 20 выставлений.

Представим, что при рождении человеку дают 100$. После череды удвоений они станут 104 857 600$. И это просто за то, что человек находится в верхней части распределения по удаче. Он тупо может пойти в казино, поставить 20 раз на красное и стать миллионером (не учитываем комиссию заведения, которое выигрывает с каждой ставки).

Конечно, в покере и в трейдинге все менее драматично. Но невозможно точно сказать, что конкретно сейчас работает - твоя стратегия или твоя удача.

У меня были очень плюсовые месяцы и очень минусовые. За 2 года игры в покер я так и не понял, умею ли я играть.

В трейдинге дисперсия еще выше. Всегда будут те, кто сосет, и кто выигрывает 100% депо в месяц при абсолютно одинаковом скилле.

Поэтому я и упомянул про риски. Если ты в целом, за некий довольно долгий отрезок времени показываешь хороший профит, то значит используешь некую хорошую стратегию.

Представь ты кидаешь обычную монетку и загадал (на основании некоторых данных) что он выпадет орлом, очевидно вероятность 50\50. Выпала орлом. Угадал ли ты ? вероятность 50\50. Загадываешь что выпадет решкой, выпала решкой, какова вероятность что ты угадал ? По теореме Баеса, 0.25. И так далее, ты угадываешь. Чем больше ты угадываешь, тем больше вероятность того что твоя гипотеза на основании который ты делаешь выбор работает. Она никогда не станет 100% верной, но будет к ней стремиться.

Согласен, не с нулевой (между участниками биржи). Но за обслуживание биржевого оборудования нужно платить.

Твоя задача найти такую стратегию, которая приносила бы доход который покрывает это комиссию, всего лишь.

>какова вероятность что ты угадал ? По теореме Баеса, 0.25

Если у тебя до этого уже выпал орел, то вероятность 0.5. У случайности нет памяти.

Но я понял твою идею. Если человек постоянно в тебя блефует, с каждым его блефом у тебя все больше и больше оснований предполагать, что он блефует всегда.

Но здесь это не действует. Жизнь человека - слишком маленький промежуток времени, чтобы выяснить, кто настоящая причина успеха - сам человек или это просто орел выпал 20 раз подряд.

Трейдинг - очень конкурентная среда. Рынок сжирает одиночек. Если ты внезапно, сидя на диване, попевая чаек, нашел алгоритм, который делает 20% ROI в месяц, скорее всего, тебе повезло.

Ты не совсем понял.

У тебя есть некая гипотеза на основании которой ты предсказываешь. И на каждом новом событии ты, то обновляешь вероятность того, что гипотеза работает.

https://habrahabr.ru/post/232639/

Я понял твою мысль. Байес есть Байес, но прогноз есть прогноз.

Пример.

Ты абсолютно точно знаешь, что шанс выиграть - 1/3. Но коэффициент выигрыша - 2. То есть ставки всегда минусовые. Каким-то чудом тебя угораздило сделать 5 ставок. И ты все их выиграл. Будешь ли ты дальше продолжать ставить? Байес говорит, что да, но они не перестанут быть от этого минусовыми.

А теперь представь, что ты не знаешь вероятности выигрыша. А кто-то другой знает. Вот это примерная модель реального мира.

Плез, пощади

>Ты абсолютно точно знаешь, что шанс выиграть - 1/3

Тогда тебе Байес тут не нужен, раз ты уже знаешь с какой точностью твоя стратегия работает при каждой попытке

Представь такую ситуацию

У тебя есть гипотеза что если ты кинешь камень он упадёт на землю. Изначальная вероятность что твоя гипотеза работает 0.5. Как уточнить эту вероятность ? Сделать эксперимент. Ты кидаешь камни, они падают на землю, по теореме Байеса ты обновляешь вероятность того, что гипотеза объясняет поведение камня. Но тут прилетает Нибиру и твой камень перестаёт падать на землю, притягиваясь Нибиру. Вероятность того что твоя гипотеза работает начинает стремиться к нулю. Но тут нельзя говорить об общей вероятности, потому что поменялись внешние условия.

Другие игроки не дураки и видят, что прилетело Нибиру. Все начнут ставить против падения камня. В итоге образуется равновесный коэффициент. Только вот оказывается, что Нибиру кто-то управляет. Внезапно он делает крупную ставку на падение камня и отзывает Нибиру. Итог - все соснули.

Покупаешь большой запас зерна.

На следующий год сжигаешь все поля с зерном, цены на зерно подлетают. Все сельские девчонки твои.

Покупаешь большой запас зерна.

На следующий год сжигаешь все поля с зерном, цены на зерно подлетают. Все сельские девчонки твои.

это я к чему. Когда ты можешь влиять на систему, влиять с большим откликом этой системы, да если ещё и с нелинейным откликом, то это уже совсем другая история.

Но в среднем, когда все делают маленький небольшой вклад, руководствуясь одним и тем же правилом, поведение системы довольно хорошо прогнозируется. Даже есть направление науки которое такое изучает, динамический хаос.

На сколько участие (и если да, занимаемые места) на kaggle коррелирует с теоретической осведомлённостью в предмете ML?

Нужно ли для поступления в ШАД знать плюсы? Я на них писал только в универе и в асм участвовал. То есть кроме структур данных в STL ничего не знаю.

В целом, впечатления очень положительные. Жалею, что не пошел в ШАД во время физтеховской магистратуры (которая на мой взгляд довольно бесмыссленна), вместо чего хуи пинал.

Теперь же, одновременная работа и учеба требует сильного напряжения. Хотя это можно воспринимать как тренировку в планировании дел и умении найти баланс.

Не все курсы мне одинаково нравятся. Но, например, курсы Воронцова и Ширяева-Бурнаева невероятно толковые. В них видишь как прикладная математика решает вполне себе конкретные инженерные проблемы. Под "курсом", естественно, понимается не просто смотрение видюшек, а прежде всего решение заданий.

Насчет перспектив, вижу, что выпускники находят себе интересную и хорошооплачиваемую работу как в стенах Яндекса, так и за пределами его и России в т.ч. Понятно, что они изначально были сильными ребятами, так что ШАД ли дал им такую возможность сразу не скажешь.

Для себя же пока решаю вопрос, следует ли продавать душу большим корпорациям за большие деньги, довольствуясь результатом здесь и сейчас, или же продолжать пробовать решать научные задачи, рискуя и через пять лет не достигнуть результата.

>>706810

Ненужно. Требуется лишь хорошее знание математики уровня 2-3 курса (анализ, теорвер, линал).

>следует ли продавать душу большим корпорациям за большие деньги, довольствуясь результатом здесь и сейчас

какой уровень требуется для того, чтобы начать продавать душу?

на хедхантере полторы вакансии, а реддит говорит, что для работы пхд требуется

Ну смотри, мои товарищи из этих самых больших корпораций не могут найти себе людей в команды по нескольку месяцев. Российский рынок светлых голов опустел, люди уезжают, никто не хочет сосать рублевый хуй в стране, над которой сгустились тучи, и жители которой ежечасно получают инъекции патриотизма.

Зато! Приходят собеседоваться петушки, называющие себя "дата саентистами", а по факту запустившие несколько раз библиотечки из Спарка. Ну ладно, нет у тебя опыта это нормально. Но у них же аппетиты звериные, они же начинтались в интернете что телки им должны давать, а CEO бросаться в ноги.

смотри, я тебя и спрашиваю, какой нужно иметь уровень, чтобы не прослыть петушком с библиотечками.

какой карьерный путь предполагается у дата саентиста в россии, к примеру, если даже на западе и в швятой надо быть пхд с опытом, как пишут на реддите

разве есть места, где можно получить коммерческий опыт в этой области, кроме как надрачивать кегели и хакатоны от пчелайна?

то есть нет готового роадмапа, как к этому подступиться, да и на том же хх десяток вакансий и те с несколькими годами опыта

проходить мооки и зубрить математику, чтобы потом сосать хуи без работы?

хуи сосать можно и не уча математику

>разве есть места, где можно получить коммерческий опыт в этой области, кроме как надрачивать кегели и хакатоны от пчелайна?

Наивно полагать, что кегля и прочие конкурсы будут тебе засчитаны как коммерческий опыт. Коммерческий опыт - это опыт работы по этой теме в конторе, и он ценится на вес золота. Скачать датасет и прогнать его через хгбуст может уже каждая десятая макака, тут никаких нет секретов. А на настоящей работе тебе нужно будет создать этот самый датасет, после чего внедрить свое МЛ-решение. Это 99.9% работы, и опыт в этом мало у кого есть.

Такой еще вопрос. Нельзя ли для поступления в дс написать экзамен, скажем, в Екатеринбурге? Просто я живу не в дс, а в конце мая / начале июня у меня в вузе будет своя сессия. В итоге мне придется лететь в дс на пару дней. По бабкам не очень выгодно, да и экзамен какой-нибудь придется пропустить.

>какой карьерный путь предполагается у дата саентиста в россии

Никакой, сейчас волна хайпа спадёт и пойдёшь обратно гостевухи писать.

Откликался на и так мизерное количесво вакансий по дата саенс, машин лернинг, но хуй, всем нужен опыт и чуть ли не пхд.

Какой дальше путь развития? А то мотивации дрочиться в этом все меньше и меньше.

Ну раз не PhD, то PHP, лел.

Дам тебе бесплатный совет по жизни - не стесняйся отвественным людям писать и задавать вопросы. Use your words.

Зачем ты спрашиваешь меня, анонима на анимешном форуме?

На странице https://yandexdataschool.ru/admission указана почта, напиши, задай вопрос, дело же важное, взрослым будь.

Из всех кандидатов только двое что-то там тыкали на kaggle. Я лично больше ценю реальный опыт над реальными проектами, или какой-нибудь свободный код, чем задачки на каггле.

Вакансия и компания очень жирные если что, в Лондоне, т.е. я не думаю, что это просто хорошие люди не идут. Скорее рыночек реально жиденький за пределами мегамонстров типа Google/FB.

А на kaggle по твоему выдуманные задачки ?

Чем задачи на kaggle отличаются от "реальных" проектов ?

Откуда у кандидатов может взяться "реальный опыт с реальными проектами" в области, в которой 3.5 вакансии, требующие при этом докторскую степень? Это ж не гостевухи писать.

Ну и говно. Задания в стиле «вызови функцию из skipy и напиши результат в файлик». Лекции вообще можно было не смотреть, никак не связаны с заданиями, кроме общей темы. Плюс стремное ебало воронцова на пол экрана.

>вызови функцию из skipy и напиши результат в файлик

А чем по-твоему дата сцаентисты занимаются?

Алсо

>skipy

значение знаешь?

ЛЫЖНЫЙ ПИРОГ

>Судя по постам от админа, сейчас все в основном пытаются модифицировать регрессию.

Вот я о чем говорю. Более 90% - долбаебы, в любом непонятном случае использующие регрессию и главные компоненты. Как будто не было десятилетий развития в этом направлении и нет никаких алгоритмов кроме главных компонент и придуманных за последние 2 года хгбустов. Мартышки невер чендж. Впрочем, на пистоне наверное и действительно нет ничего кроме вышеназванного. А все ж веруют, что кроме пистона все остальное на свалке истории.

Ну так давай, наверни алгоритмов и забери четыре тысячи, что же ты? А, да, ты же в пистон не смог.

по твоему ансамбль хуёвых аналитиков лучше чем один хороший специалист ?

Можешь больше не отвечать, все поняли что ты хуй простой.

в добрый путь! а мы пока поколупаем линейную регрессию))

> всем нужен опыт и чуть ли не пхд

Лол, вот у нас ребята и сидят в аспирантуре со своим мл. При этом имеют оклад, позволяющий жить, занимаются там любимым делом.

Матерок при входе надо оставлять. ну и реальный опыт тоже неплохо бы нарабатывать - на дваче его не получишь

Пишу диплом на пайтоне, нужно определять тональность текста на русском языке (бинарная классификация).

Какой классификатор лучше взять? Везде рекомендуют нативный байес.

Есть ли смысл пердолить всякие стемминги, лемматизации и прочее? Есть ли готовый код, определяющий часть речи каждого слова в предложении? Я, блядь, смотрю на эту хуйню и охуеваю, глаза разбегаются. Что реально даст эффект - я так и не понял.

Какую минимальную точность дадут базы для обучения в 110к отрицательных и 110к положительных отзывов с твиттера? Ну, примерно можете почувствовать?

Просто сроки жмут, и времени ковырять это добро в свое удовольствие нет к сожалению + я мало кодил на своем веку лучшее, что писал - визуалочка для БД на sql, трудности с пайтоном (в основном, благодаря срокам).

Алсо, адепты пайтона, подскажите, в чем можно без проблем собрать визуалочку под моё дерьмо? Надеюсь, я его-таки высру

Мое мнение такое, что диплом - это лучшее, что у тебя будет, чтобы поковыряться в R&D так как ты хочешь в ближайшие лет пять, поэтому отмазы по поводу отсутствия времени смешно слышать. Наверное, ты охуенно много работаешь и зарабатываешь много, да?

Короче, пиздуешь на фриланс.ру и за 1000 рублей даешь задание спарсить яндекс.маркет отзывы с оценками. Затем берешь pymorphy и переводить все слова леммы (ну или говоришь это тому же кто спарсит за 500 рублей сверху).