Вы видите копию треда, сохраненную 9 июня 2016 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Machine Learning 101:

1. Introduction to Statistical Learning, Casella ( http://www-bcf.usc.edu/~gareth/ISL/ISLR Sixth Printing.pdf )

Читается легко, неплохая разминка перед ESL

2. Pattern Recognition and Machine Learning, Bishop.

3. Bayesian Methods for Hackers. Введение в байесовские методы, годно.

4. http://neuralnetworksanddeeplearning.com

Введение в нейронные сеточки для самых маленьких. Написано простым английским.

Machine Learning Advanced

1. Elements of Statistical Learning (http://statweb.stanford.edu/~tibs/ElemStatLearn/printings/ESLII_print10.pdf )

Сложность - 9 из 10. Шутки в сторону, можно читать годами. Если вы сможете полностью проработать эту книгу и прорешать упражнения, обязательно свяжитесь со мной - у меня найдется работа для вас.

2. Optimization for Machine Learning. Edited by Suvrit Sra, Sebastian Nowozin and Stephen J. Wright, MIT Press, 2012.

Иногда from sklearn.linear_model import LogisticRegression перестает работать и тогда нужно все переписать. Оптимизация квадратичных приближений на больших объемах данных, разреженные модели, суррогатные оптимизации - вот это все тут есть.

Дальше вас ждет дикий и необузданный мир. Два маяка https://vk.com/deeplearning и http://deeplearning.net/reading-list/ осветят дорогу: это списки литературы и обзоры статей для прощупывания пульса индустрии.

Computer Science

1. Intoduction to Algorithms, Corman

2. The Art of Computer Programming, Knuth

3. Compilers: Principles, Techniques, and Tools. Разработчикам компиляторов и прочим авторам убийц питонов и крестов посвящается.

Programming

1. Python Unlocked. Короткая книжка без соплей. В ней описаны метаклассы, дескрипторы, системы типов, шаблоны проектирования и TDD. Всего чуть больше 100 страниц концентрированной сути.

2. Code Complete (2nd), McConnel.

Неплохая книга. Не то чтобы обдрочиться, но в голове всякие фишки по структуризации кода и его проектированию остались.

Misc

1. Telegram: @techsparks

Подкаст про всякие гик-штуки.

F.A.Q

По мотивам предыдущего треда.

Эти ваши книжки стоят овер 9000 рублей, как быть? Как ОП, крайне не одобряю пиратство и рекомендую при возможности все-таки покупать книги, но если вы жмот вам надо кормить 10 детей, то идите сюда http://libgen.io

Книги хорошо, но с чего начать практический вкат?

Во-первых, вам нужна любая unix-based система. На Windows возможно запустить нижеперечисленное, но ждите пердолева с настройкой и неодобрительных взглядов анонимуса. Кроме того, в компаниях, так или иначе связанных с разработкой йоба-ПО и machine learningом, Linux/OS X является стандартом. Привыкайте.

Во-вторых, определитесь с языком. Python и C++ наиболее мейнстримовые инструменты, с ними вы без еды не останетесь. Есть еще R, на котором пацаны живут статистикой и анальными пакетами. Некоторые инструменты являются языко-независимыми (Vowpal Vabbit, XGBoost), но обвязывать их вы все равно будете из какой-либо среды.

На Java разработано много production-ready инструментов для бигдаты и если вы угораете по терабайтам данных, то имеет смысл посмотреть в её сторону. Впрочем, лучше это делать уже потом, когда прийдет осознание потребностей.

В-третих, выбирайте себе задачу. Что угодно: распознать качпу, обнаружить ботов по логам, найти раковых больных. Список можно посмотреть, например, на kaggle.com. После чего приступаете к решению выбранной задачи.

Не прийдется ли мне потом с таким наборищем знаний идти в макдак работать?

Несмотря на хайп вокруг ML, далеко не во всех IT компания есть необходимость в ML и понимание круга задач, которые можно решить этими методами. Но поверьте, в 2016 компетентный специалист будет востребован. В России потребителями ваших знаний могут стать: Яндекс, Mail.ru, Вконтакте, Rambler, Касперский, Билайн, Связной, ABBYY, Хуавэй. В биоинформатике есть определенный спрос, можно поскролить http://blastim.ru

Здорово, но я так и не понял чем же вы занимаетесь в IT компаниях?

Попытаюсь ответить со своей колокольни и сразу хочу предупредить, что это едва ли консенсуальное мнение.

ML-специалист - это такое зонтичное определение для человека, способного увидеть проблему, выгрепать кучу логов и данных, посмотреть на них, придумать решение проблемы и врезать это решение его в продакшн. По сути, это кодер, решающий не чисто технические, а, в некотором роде, человеческие проблемы.

Имхо, мы все же остаемся в первую очередь разработчиками.

Но ведь есть Machine Learning per se, чем он занимается?

Действительно есть. Одаренная прослойка людей изобретает новые методы, но это правильнее называть просто математикой. Сейчас пищей для ума являются нейронные сети и их возможные архитектуры, но даже они двигаются рука об руку с практикой.

Что такое TensorFlow?

TensorFlow - часть гуглового инструмента для перемножения тензоров и оптимизации функционалов. Часть - потому что важные куски типа паралелизации еще не выкачены в паблик. Если вам все ещё непонятно что это, значит это вам и не нужно, сириусли. Google перестарался с рекламой и теперь люди думают, что TF - это серебряная пуля и затычка для каждой бочки. До TF был Theano, который выполнял свою работу не хуже. И, в отличии от TF, он уже находится в стабильной фазе.

Курсы прохожу, книжки читаю, задания делаю.

Но как мне работу найти?

На данный момент опыта программирования за деньги - нет, но специальность математик-программист имею.

Настало время узнать чтото по ОПтеме.

>вкатиться в ML

Это самоцель? Имхо, так далеко не уедешь.

>Но как мне работу найти?

hh.ru, blastim.ru, yandex.ru/jobs/ - это если нет знакомых.

>Это самоцель? Имхо, так далеко не уедешь.

А вообще, чем можно заниматься вкатившись в ML? Что это вообще такое? Как оно может пригодится в быту, т.е. как я могу использовать знания ML в повседневной жизни?

Платина:

Какой математический бекграунд нужно иметь, чтобы свободно плавать в ML?

Разумно ли заниматься ML, если ты даун, вылетевший с девятого класса, не освоивший математику даже на уровне седьмого класса?

Вам не нужно вводить капчу, у вас введен пасс-код.

Вот этот вопрос поддержу. Алсо, хватит ли проситать основы тервера и матстата?

> Это самоцель?

Мне нравится возится с данными, анализировать, искать закономерности и т.п. Было бы здорово заниматься этим.

> hh.ru, blastim.ru, yandex.ru/jobs/

Если написать в резюме: закончил универ, прошёл пару [десятков] курсов и хочу вкатиться джуниором, то возьмут или нет?

Если нет, то какой минимальный опыт нужен?

Какой проект для портфолио можно запилить?

>Мне нравится возится с данными, анализировать, искать закономерности

Как ты об этом узнал? Тебе просто нравится об этом мечтать?

Пусть роботы убиваю, у них совести нету

Например, потому что примерно со второго курса в качестве развлечения писал парсеры разных сайтов, складировал данные в таблицы, искал закономерности и т.п. Но ничего круче статистики и кластеризации не использовал.

В любом случае, я спрашивал не "а правда ли мне понравится работать?", а "как вкатиться?"

Из него не понятно:

- какого уровня проект нужен для портфолио

- берут ли без опыта работы программистом

Меня взяли ещё студентом. Из опыта работы у меня было пару более менее серьёзных прог на Delphi. Причём взяли на похапе

А хотя ты наверно спрашивал именно про программирование в ML

>А вообще, чем можно заниматься вкатившись в ML? Что это вообще такое? Как оно может пригодится в быту, т.е. как я могу использовать знания ML в повседневной жизни?

Какая такая повседневная жизнь? Если ты про работу, то можно распознавать картинки, заниматься ботообороной, анализировать поведение пользователей, пилить поиск и рекламные системы, рыскать по биоинфоматическим данным. Если же ты про то как выжить в лесу при помощи ML, то хуй знает что тебе посоветовать. Можно запустить на видяхе какую-нибудь йобу и кашу сварить на раскаленном радиаторе, збс греет.

>Какой математический бекграунд нужно иметь, чтобы свободно плавать в ML?

Статистику, это основное. Алгоритмы, немного функана - должно хватить. Из личного опыта - у меня матмеховское образование; с одной стороны оно вроде бы оверкилл, с другой стороны проблематично оценить степень влияния на мышление и способность воспринимать прикладной материал. Кажется, что без матмеха я был бы глупее. А вот ШАД полнее покрыл мои рабочие нужды.

>Разумно ли заниматься ML, если ты даун, вылетевший с девятого класса,

Стоит определится, хочешь ты свободно плавать или все же ты даун. Некоторую математику стоит знать.

>>733356

>Если написать в резюме: закончил универ, прошёл пару [десятков] курсов и хочу вкатиться джуниором, то возьмут или нет?

Да, возьмут. Правда еще есть собеседования, но если ты не просто закончил универ, а что-то из него вынес, то это не будет проблемой.

>Если нет, то какой минимальный опыт нужен?

AFAIK для джуна промышленного опыта особо не нужно. Если руки не из жопы и опыт решения каких-нибудь простых задачек есть, то полдела в кармане.

>>733386

Да, можно. Это как раз примерно то, чем исследования в распознавании образов занимаются именно сейчас.

>как я могу использовать знания ML в повседневной жизни?

Кажется, неправильно тебя понял, поэтому дополню свой прошлый ответ. Применение в быту у ML есть, хотя зачастую такое применение выглядит гиковски и уж точне не жизненно необходимым. Вот тебе пример: у меня во дворе постоянно забита парковка и три недели назад, в очередной раз приехав поздно вечером и не найдя места для своей поповозки, я серьезно взбугуртнул и на следующих выходных вывесил за окно панорамную камеру для наблюдения за ситуацией на паркинге. Такое пассивное наблюдение оказалось не очень жизнеспособным, так как при подъезде к дому на экране телефона проблематично разобрать картинку. Поэтому очередные выходные были потрачены на то, чтобы добавить подсчет свободных мест в Caffe в разных зонах парковки (так как к ним разные подъезды и нужно заранее знать куда ехать). Еще у меня есть машинка, которая умеет ездить по разметке на бумаге - в ней тоже под капотом бьется Caffe.

Но, откровенно говоря, какой-то убийственно нужного применения ML именно в быту и именно сегодня я назвать не могу. Такие системы только-только входят в нашу жизнь, поэтому сейчас такие вещи могут казаться блажью и излишеством.

В IT - да, таких применений миллион.

Зависит от компании, позиции, собеседующего. В Я, Рамблере и Мейле, насколько я знаю, на джунов дают задачки.

>А в слепую ехать не хочется - проебу деньги, не устроюсь и вернусь с позором.

Это последнее, чего стоит бояться. Страшнее так и не попробовать.

И да, в Я сначала идет Skype-собеседование и только после этого приглашают на очную ставку.

Сидя в мухосранске ты никогда ничего не добьешься. Очевидно же, что спрос на МЛ рождается только при некотором минимальном уровне технологического развития. Если население промышляет только грабежом, перепродажей и распилами, то какой там может быть МЛ? Это относится во многом ко всей рахе, техническая отсталость которой от первого мира порядка 10 лет.

Наивно думать, что в Яндексе тебя прям возьмут на позицию, где требуется МЛ, при том что ты никто. Там очередь у них стоит из ШАДников, тех что недостаточно круты для трактора (однако даже по сравнению с ними ты пустое место). Если тебя туда и возьмут, то только говночистом. Будешь скрипты какие-нибудь клепать, прозябая на джунской должности без развития.

>10 лет

Слабо взял. Хочешь сказать, через 10 лет мы запилим свой Windows, Intel, Apple, Tesla и прочие тачанки и медицину?

Лет 40 здесь, не меньше.

Ну да, это сложный вопрос. По медицине, например, согласен с 40 годами. По софтострою отставание поменьше, ну вот тот же Яндекс довольно продвинутый ведь. Не Гугл, но тем не менее.

Windows не запилим, так ведь и какая-нибудь Франция тоже своей ОС не имеет, тут скорее отличие количественное.

на любое заболевание тупо прописывают обезбаливающее и отправляют домой

приходится ездить к себе в латвию за нормальными лекарствами/операциями

<...>

– Будет у нас коллегия весталок, непорочных и отрезанных от мира, – пояснил он. – Только в мужеска пола.

– И правда, – согласился Марк Фурий, – собрание чистых отроков, никогда не видящих дневного света, – самое то что надо для управления счетной машиной подобного рода.

А что, Франция по софтостроению не отстает?

Напиши что-то годное про нечеткие множества, добавлим в шапку в следующий раз.

Пока вы тут дрочите на кнута, кормена и ахо скину я немного годноты по КС http://www.mi.ras.ru/~podolskii/hse.html

http://ocw.mit.edu/courses/electrical-engineering-and-computer-science/6-042j-mathematics-for-computer-science-fall-2010/readings/

и чо?

Милости прошу к нашему шалашу.

Сажа прилипла

Роботехника ща в основном в сторону секс-игрушек идет. Вдруг люди будущего будут результатом спаринга людей и роботехники?

Всё в статьях чаще всего. Первые авторы, которых вспомнил:

Goertzel, Hutter, Schmidhuber.

Обзорная статейка:

https://pdfs.semanticscholar.org/72e1/4804f9d77ba002ab7f1d3e3a5e238a3a35ca.pdf

> в основном

Это он борщнул, но на гиктаймсе мелькают статьи про секс с роботами.

https://geektimes.ru/company/robohunter/blog/251052/

https://geektimes.ru/company/robohunter/blog/259922/

https://geektimes.ru/company/robohunter/blog/263562/

>Напиши что-то годное про нечеткие множества, добавлим в шапку в следующий раз.

Именно про применение в задачах ML очевидная годнота А. Пегат, "Нечеткое моделирование и управление". Очевидный плюс - вся матчасть с нуля, можно рекомендовать даже тем, кто в душе не ебет что такое нечеткое множество. Самый заметный минус - некоторые довольно элементарные вещи даны излишне заумно.

Прохожу ml на курсе от Andrew Ng и вот этот курс:

http://cs224d.stanford.edu/syllabus.html

Ничего толком не понимаю. Во всяких quiz'ах набираю 4/5 баллов, в заданиях просят брать производные, ну окей, делаю, задания на программирование по инструкциям выполняю, все вроде работает, НО все равно ничего не понятно!

Отберите у меня инструкции и с нуля я ничего не сделаю. Тащем-то в первом курсе на octave писал forward / backward propagation, во втором уже на питоне и пришлось заново разбираться как это работает.

Для backprop'а и вовсе мне потребовалось посмотреть 3 разных лекции, чтобы примерно понять как и почему оно работает, и то я до сих пор не уверен.

Лучше бы они не предоставляли заготовки с кодом, чтобы совсем-совсем с нуля нужно было писать все. Так бы лучше усваивалось.

> 1. Elements of Statistical Learning

Натыкался на совет почитать это, скачал, полистал и это ужасно.

Ах, пофиг, со временем все осилится. Надо просто читать все эти whitepaper'ы с описаниями всяких методов, пробовать реализовывать в коде и тинкерить.

Правда, проблема еще в том, что железо дохлое, никаких cuda-хов, сплошные старые ноуты без дискретных видеокарт. Вот задание из cs224d выполняется уже фиг знает сколько, можно отправляться спать в надежде, что утру закончится.

>что ангелы брали жен человеческих и от их союза появились люди.

Вут, откуда же взялись жены человеческие, если только от них появились люди? Или библия намекает, что жены человеческие -- не люди?

Могу пояснить за backpropagation. По сути это тупо градиентный спуск. Т. е. тебе надо тупо посчитать частные производные по весам (они считаются рекуррентно с помощью chain rule). Посмотри на вики как выводятся формулы и потом сам выведи не подсматривая.

Вообще-то они весьма плохо и работают. Результат достигается многократной прогонкой gradient descent при разных (как правило, рандомно сгенерированных) НУ. Плюс разные свистоперделки типа deep learning, чтоб веса первых слоёв тренировались. Есть такой феномен, когда NN учит только среднее по выборке, втречается нередко. Я могу даже на пальцах расписать, как происходит обрубка первых слоёв и NN обсирается с обучением.

>Computer Science

Блять, это действительно смешное слово или я один такой долбоёб? Даже наша ИНФОРМАТИКА звучит лучше, чем это. Так и представляю, как сидят две англоязычных бабушки на лавочке, и одна другой хвалится "Вот, Тереза, мой внучок Джо отучился, теперь он phd КОМПЬЮТЕРЩИК*"

>может кто-то объяснить, почему нейросети так хорошо работают?

Потому что они универсальные аппроксиматоры функций. Еще Колмогоров и Арнольд доказали, что функция от любого числа аргументов представима через суперпозицию частных функций от 1-2 переменных. Именно так и работает тот же 3-слойный перцептрон. У Горбаня это подробно разобрано.

Оно смешное, потому что слово "компутер" приобрело иные оттенки в русском языке. Англоговорящим человеком Computer Science воспринимается скорее как "науки о вычислениях"

>Вообще-то они весьма плохо и работают. Результат достигается многократной прогонкой gradient descent

Это недостаток не нейросетей как таковых, а методов настройки свободных параметров - бекпропагейшна, градиентного спуска и т.д. Поэтому именно эти методы и пытаются допилить или заменить на что-то другое, тогда как собственно структура того же многослойного перцептрона не менялась с середины прошлого века.

Каша в дупе твоей мамки, а я математик.

>>737576

Долбаёб, а что, по-твоему, NN? Вектор параметров на вектор базисных функций. А ты, картофан, видно думаешь, там какая-то магия. И чем ты собрался заменять BP? Лолблядь, хоть почитай про оптимизацию. Алсо

>бекпропагейшна, градиентного спуска

> имплаинг, это разные вещи

Плебеи. Плебеи никогда не меняются.

Привет, включать курсы я не стал, зачем? По поступлению в ШАД тебе расскажут обо всех курсах, а не ШАДовцам эти курсы не доступны, так что если я даже посоветую курс, то это будет бесполезный совет. Или ты что-то другое имел ввиду?

>>737523

Вроде бы никогда не проигрывал с этого.

>>737480

>почему мы попадаем именно в какой-то хороший локальный минимум?

Никто этого не гарантирует, просто запустив 1000 раз обучение и выбрав лучшие результаты, мы предполагаем, что они не так далеки от истинного минимума. Тем более редко когда требуется глобальный минимум. И да, НН универсальные аппроксиматоры, как уже тут заметили.

>>736568

Пробовал заказать машину на амазоне?

>>736014

А можешь описать чем вообще такой подход лучше/хуже, чем постановка задач оптимизации в классическом варианте?

автор, пили ещё

>Или ты что-то другое имел ввиду?

Да, там же есть открытые курсы по машинному обучению, по теорверу, по алгоритмам. На них можно забить, если буду дрочить Elements of Statistical Learning?

И еще вопрос: есть что-то вроде джун-вакансий по ML? Чтобы порог входа был пониже, чем у полностью готового спеца? Я нихуя не умею в ML, но хочу заниматься этим в конце концов на серьезном уровне. Проблема в том, что денег у меня не работать нет, и, вместо того, чтобы изучать ML, я ебусь с iOS, чтобы наработать некий капитал, чтобы упороться ML фуллтаймом.

Слив засчитан.

>>бекпропагейшна, градиентного спуска

>> имплаинг, это разные вещи

Но бекпропагейшн это поиск градиента, вычисление его значения, а градиентный спуск это использование градиента для минимизации некоторой функции, причем градиент можно и иначе вычислять, например, с помощью приближенных вычислений [(f(x + h) - f(x)) / h]. Разве не так?

никакого иного применения для нейросетей, кроме моделирования поведения персонажей в игре, я не вижу. И вообще весь кодинг в моем понимании сводится к решению очень тривиальных задач - создание игр и веба под различные платформы и взаимодействие с апи интернет-гигантов типа фейсбук, вк, телеграм и т.п.

Какое направление вы бы обозначили в этой области в ограниченных условиях обычного кодера из провинции, как я например? Пытаться применить принцип перцептрона в геймдеве?

Под женами человеческими очевидно подразумевались какие-нибудь полуобезьяны-неандертальцы.

Да забей ты на это хайпнутое говно, бро. Душа ИИ живёт в матлогике и символьных вычислениях. Так что угорай по Lisp, Prolog и еби весь этот ML в рот.

читаю вот эту дичь

2. Об интеллекте. http://archism.narod.ru/lib/bleiksli_sandra_ob_intellekte.pdf

понравилось

подкинь подобного

но чтобы без маразма

мне интересно читать о работе мозга, и всё такое

ну ты понял

пасибки

Проиграл.

двачую.

Есть ощущение, что единственный способ вкатиться в ML, это через ШАД. Серьезно, есть другие пути?

В долине трактористов про ШАД никто ничего не знает, если что. Так что с этой т.з. это просто потеря времени.

нет. я, вообще, не про обучение, а про то, как влиться в отрасль в рф. Рабовладельцам же нужны какие-нибудь пруфы твоей компетенции и, у меня ощущение, что гит с пет проджектами ими будет оценен меньше чем какой-нибудь шадовский сертификат.

Меня раздражает закрыть ШАДа. Хули им стоит выложить лекции на всеобщее обозрение? Ок, они не хотят тратить время преподов на проверку домашних заданий анонов, ну пусть и не тратят. Но что за жлобство не выложить лекции+задания в открытый доступ я не понимаю.

мне кажется, в ШАД стоит идти только за сертификатом. В плане образования, по-любому, ничего лучше, чем пилить собственную йобу, и попутно находить решение возникающих проблем. Тем более материала в инете дохерища, начиная с десятков открытых курсов на coursera, edx и тд.

Там жи ж дохрена математики. Йобу пилить - это, конечно, нужно, но математику без помощи довольно долго будешь вдуплять. Плюс курс в ШАДе весьма фундаментальный. Ты проходил ШАД?

ну и, судя по вступительным они отбирают охуеть каких математиков. Из моего, небольшого, экспириенса -- ML это, все-таки, прежде всего инжиниринг.

мой ответ выше. Из моего экспириенса достаточно знаний( даже не первой свежести) линейной алгебры и основ общей алгебры.

Открытые все ок, но это самые первые и простые курсы.

Воронцова тут уже обсасывали - нормальная база, правда без семинаров 50% пользы исчезает. Бабенко - очень хорошо. Я не знаю какой курс выложен в паблик, продвинутый или обычный, если первое, то считай, что крупно повезло - куча топового материала для расширения сознания.

Сухорослов - это вроде бы жаба+паралелльные вычисления. Рекомендую только если ни того, ни другого не знаешь.

Про Райгора и Верещагина ничего сказать не могу - курсы примерно совпадали с тем, что было на матмехе, поэтому я смотрел курсы удаленно и только половину из них. Вроде было ок.

>На них можно забить, если буду дрочить Elements of Statistical Learning

Эм, ну если ты действительно задрочишь весь EoSL с задачами, то к этому моменту ты сможешь силой мысли раздвигать стены и на какие-либо курсы тебе будет насрать.

>И еще вопрос: есть что-то вроде джун-вакансий по ML?

Чистого ML наверное нигде нет (если это не университетская лаборатория или Google/Яндекс), везде надо уметь воплощать этот ML в Python/C++. Это очень практическая дисциплина. Поэтому вопрос надо поставить чуть по-другому - есть ли такая вакансия, где доля ML будет соответствовать моему уровню. Ответ: да, есть. Вакансия с описанием "разработчик со знанием математики/статистики/ML" - это то, что ты ищешь. Берешь грейд, который тебе по плечу и вперед.

>>737700

>Какое направление вы бы обозначили в этой области в ограниченных условиях обычного кодера из провинции, как я например

Если уж так хочется, то какую-нибудь предиктивную аналитику можно во многих уголках России найти. Логистам помогать товары в ретейл развозить или логи грепать у гейм-девелоперов.

>>737918

Ты неплохо так планку задрал, назвав лучшую книгу подобного рода.

Можешь попробовать

The Future of the Mind: The Scientific Quest to Understand, Enhance, and Empower the Mind почитать, авось понравится.

А вообще работа мозга - это Neuroscience (Bear & Berry). Правда это уже не научпоп, а учебник.

>>738229

>>738248

Мне тяжело ответить что-то кроме банальностей типа "дорогу осилит идущий".

Тебя никто принципиально не будет срезать, если ты не учился в ШАДе или где-то еще. Вопрос только в знаниях и скилле получать эти знания из Интернета/книг. Фигуры на этой доске двигаешь ты.

Бумажки из ВУЗа нужны для того, чтобы пройти HRов. Дальше можешь их выкинуть. Если ты серьезно уверен в своих силах, то приукрась резюме, а как дойдешь до технической части, так и начнешь на ней блистать (ну или обосрешься с подливой, зависит от).

>>738256

На некоторой части курсов рассказывают про внутренние фишки Яндекса. Их нельзя выносить наружу.

Ну и не стоит забывать, что люди в первую очередь оценивают выгоду от своих действий. Вполне себе допустимо, что руководство ШАДа не видит профитов для Яндекса от выпуска всех курсов в паблик.

>>738260

>мне кажется, в ШАД стоит идти только за сертификатом.

Ну а у меня диаметрально противоположное мнение. На сертификат абсолютно по барабану, а вот мозги мне там подправили.

Впрочем, бумажка тоже вроде бы ценится. Просто у меня не было в ней серьезной необходимости.

Открытые все ок, но это самые первые и простые курсы.

Воронцова тут уже обсасывали - нормальная база, правда без семинаров 50% пользы исчезает. Бабенко - очень хорошо. Я не знаю какой курс выложен в паблик, продвинутый или обычный, если первое, то считай, что крупно повезло - куча топового материала для расширения сознания.

Сухорослов - это вроде бы жаба+паралелльные вычисления. Рекомендую только если ни того, ни другого не знаешь.

Про Райгора и Верещагина ничего сказать не могу - курсы примерно совпадали с тем, что было на матмехе, поэтому я смотрел курсы удаленно и только половину из них. Вроде было ок.

>На них можно забить, если буду дрочить Elements of Statistical Learning

Эм, ну если ты действительно задрочишь весь EoSL с задачами, то к этому моменту ты сможешь силой мысли раздвигать стены и на какие-либо курсы тебе будет насрать.

>И еще вопрос: есть что-то вроде джун-вакансий по ML?

Чистого ML наверное нигде нет (если это не университетская лаборатория или Google/Яндекс), везде надо уметь воплощать этот ML в Python/C++. Это очень практическая дисциплина. Поэтому вопрос надо поставить чуть по-другому - есть ли такая вакансия, где доля ML будет соответствовать моему уровню. Ответ: да, есть. Вакансия с описанием "разработчик со знанием математики/статистики/ML" - это то, что ты ищешь. Берешь грейд, который тебе по плечу и вперед.

>>737700

>Какое направление вы бы обозначили в этой области в ограниченных условиях обычного кодера из провинции, как я например

Если уж так хочется, то какую-нибудь предиктивную аналитику можно во многих уголках России найти. Логистам помогать товары в ретейл развозить или логи грепать у гейм-девелоперов.

>>737918

Ты неплохо так планку задрал, назвав лучшую книгу подобного рода.

Можешь попробовать

The Future of the Mind: The Scientific Quest to Understand, Enhance, and Empower the Mind почитать, авось понравится.

А вообще работа мозга - это Neuroscience (Bear & Berry). Правда это уже не научпоп, а учебник.

>>738229

>>738248

Мне тяжело ответить что-то кроме банальностей типа "дорогу осилит идущий".

Тебя никто принципиально не будет срезать, если ты не учился в ШАДе или где-то еще. Вопрос только в знаниях и скилле получать эти знания из Интернета/книг. Фигуры на этой доске двигаешь ты.

Бумажки из ВУЗа нужны для того, чтобы пройти HRов. Дальше можешь их выкинуть. Если ты серьезно уверен в своих силах, то приукрась резюме, а как дойдешь до технической части, так и начнешь на ней блистать (ну или обосрешься с подливой, зависит от).

>>738256

На некоторой части курсов рассказывают про внутренние фишки Яндекса. Их нельзя выносить наружу.

Ну и не стоит забывать, что люди в первую очередь оценивают выгоду от своих действий. Вполне себе допустимо, что руководство ШАДа не видит профитов для Яндекса от выпуска всех курсов в паблик.

>>738260

>мне кажется, в ШАД стоит идти только за сертификатом.

Ну а у меня диаметрально противоположное мнение. На сертификат абсолютно по барабану, а вот мозги мне там подправили.

Впрочем, бумажка тоже вроде бы ценится. Просто у меня не было в ней серьезной необходимости.

http://pastebin.com/tZzbExkP

В итоге получаю:

[('Pclass', 0.017933362369337985),

('Fare', 0.29549222165179184),

('Age', 0.40310551645733922),

('Sex', 0.28346889952153104)]

Пытаюсь засабмитить Fare и Age, получаю ошибку.

В чем обосрался?

Раскурил, надо чистить вилкой только Age

Проходи, ничего не теряешь.

Анкета сложная, тест довольно легкий. По крайней мере, анкету я заполнял дольше чем тест.

Прям дать ссылки, где мои имя и фамилия стоят? А спермы тебе не дать глотнуть вдогонку?

Зачем ты вообще разговариваешь с этим инфантильным дауном?

> боится деанона в зк

> выёбывается без пруфов

Ясно, уёбывай обратно в /b/ и за щеку себе кончи, уёбок

Да пусть нахуй идет, точнее в /сцы/ рассуждать о картофане. Я знавал таких физиков, как этот "математик".

Ну физик, ну публикации. Но тупой я ебал. Если человек не видит разницы между backpropagation и градиентным спуском - это клиника, насмехайтесь над таким.

Это мем /sci/, важно обвинить оппонента в том, что он любит картофан, а не науку. Пошло откуда-то от вербицкого.

Для начала определи high variance у тебя или high bias. А потом реши проблему, следуя советам по поводу high variance и high bias.

У меня скорее high varianceда, я смотрел learning curves, все дела. Просто вот эти функции поиска локального минимума. В матлабе годных нету, хотя я потихоньку качусь к R и Python, как следствие к линуксуна самом деле к армии, боже, сколько еще учить.

На самом деле high bias. Я даже в терминах примитивных путаюсь.

А если не закончил универ?

>разницы между backpropagation и градиентным спуском

> Этот полоумный всё продолжал бомбить ...

Подправил дупу твоей маме.

ОП, в первую очередь хочу сказать, что это сообщение никоим образом не направлено на то что бы оскорбить тебя или кого-либо еще, ты делаешь хорошие и качественные треды, комментарий не об этом, не нужно воспринимать это на свой счет.

Итак, перейду к сути дела- информация касательно содержания данного треда.

Как уже несколько человек написали в этом и предыдущих тредах, это не просто прикольные книжки что бы прочесть, послушать, посмотреть и забыть, нет. Эта область науки крайне негативно воздействуют на ваше подсознание, даже если вы просто смотрите курсы на курсере, а уж тем более “читаете перед сном книжки по этой теме” и все такое (в таком случае информация пишется вообще напрямую). Они прописывают в ваш мозг программы поведения для вас, а что самое хреновое, для ваших потомков.

Между вот такими штуками и обычным программированием лежит просто невообразимая пропасть.

Т.е. если вы после поглощения этого всего проживете норм жизнь, знайте, что вся эта херня, которую Вы наслушались и насмотрелись в книжках подобного рода, обязательно ударит, и ой как больно ударит по вашим будущим поколениям. Это как поведение, привычки, черты характера, хорошие и плохие, которые передаются ментально, не зримо, по ДНК, от родителей к детям, из поколения в поколение, автоматически. 10 раз подумайте, надо ли оно вам. Если вам плевать на себя, подумайте хотя бы о своих детях, своих последователях.

Для кого-то это может звучать как параноидальный бред, но черт подери, если вы не знаете о том как что-то работает и это возможно, то это не означает что такого не может быть. Нам ведь не обязательно знать все законы физики и прочих наук, что бы элементарно пользоваться электричеством- нажал на кнопку и все работает. Тут точно так же.

Опять же, это сообщение не призвано никого обидеть, оно направлено на то что бы люди все-таки думали, что они “хавают”. Ведь мозг, в отличии от желудка, особенно если он недостаточно развит, не способен распознать “гнилую” информацию от полезной, светлой.

На данное сообщение не надо отвечать, я не собираюсь вступать в полемику с кем-либо.

Всего вам хорошего, будьте здоровы.

ОП, в первую очередь хочу сказать, что это сообщение никоим образом не направлено на то что бы оскорбить тебя или кого-либо еще, ты делаешь хорошие и качественные треды, комментарий не об этом, не нужно воспринимать это на свой счет.

Итак, перейду к сути дела- информация касательно содержания данного треда.

Как уже несколько человек написали в этом и предыдущих тредах, это не просто прикольные книжки что бы прочесть, послушать, посмотреть и забыть, нет. Эта область науки крайне негативно воздействуют на ваше подсознание, даже если вы просто смотрите курсы на курсере, а уж тем более “читаете перед сном книжки по этой теме” и все такое (в таком случае информация пишется вообще напрямую). Они прописывают в ваш мозг программы поведения для вас, а что самое хреновое, для ваших потомков.

Между вот такими штуками и обычным программированием лежит просто невообразимая пропасть.

Т.е. если вы после поглощения этого всего проживете норм жизнь, знайте, что вся эта херня, которую Вы наслушались и насмотрелись в книжках подобного рода, обязательно ударит, и ой как больно ударит по вашим будущим поколениям. Это как поведение, привычки, черты характера, хорошие и плохие, которые передаются ментально, не зримо, по ДНК, от родителей к детям, из поколения в поколение, автоматически. 10 раз подумайте, надо ли оно вам. Если вам плевать на себя, подумайте хотя бы о своих детях, своих последователях.

Для кого-то это может звучать как параноидальный бред, но черт подери, если вы не знаете о том как что-то работает и это возможно, то это не означает что такого не может быть. Нам ведь не обязательно знать все законы физики и прочих наук, что бы элементарно пользоваться электричеством- нажал на кнопку и все работает. Тут точно так же.

Опять же, это сообщение не призвано никого обидеть, оно направлено на то что бы люди все-таки думали, что они “хавают”. Ведь мозг, в отличии от желудка, особенно если он недостаточно развит, не способен распознать “гнилую” информацию от полезной, светлой.

На данное сообщение не надо отвечать, я не собираюсь вступать в полемику с кем-либо.

Всего вам хорошего, будьте здоровы.

Ребята не стоит вскрывать эту тему. Вы молодые, шутливые, вам все легко. Это не то. Это не Чикатило и даже не архивы спецслужб. Сюда лучше не лезть. Серьезно, любой из вас будет жалеть. Лучше закройте тему и забудьте что тут писалось. Я вполне понимаю что данным сообщением вызову дополнительный интерес, но хочу сразу предостеречь пытливых - стоп. Остальные просто не найдут.

Математика делится на собственно настоящую математику (чистая системная математика), и на инженерную шелуху на периферии (для решения под водочку и картофан). Соответственно, термин картофан можно применять к любой науке, где есть ядро и прикладная периферия для негров. Ну или вообще везде, лол.

Пацан

я вот начал читать это

2. Об интеллекте. http://archism.narod.ru/lib/bleiksli_sandra_ob_intellekte.pdf

Я уже потрачен ?

______

Мне прежде всего важно понять для себя, каким образом работаем мозг, и всё. РАДИ ИНТЕРЕСА

Было бы классно с тобой пообщаться в телеграмме. Если что, пиши - @lightglams

Чтоб понять как работает моцк, тебе в neuroscience, но чтоб там осилить что-то сложнее научпоп-ссанины, нужен пиздатый бекграунд.

окай

пасиб

Предлагаю добавить в шаблон ОП-поста.

Лол, ты думаешь тебя один человек хуями кормит, математик? Ну облажался, бывает, скромно съеби в сцы и о тебе забудут.

Ты можешь создать робота с ИИ, который разъебет твою башку, для тебя мир закончится.

Можно просто исходники OpenCV почитать.

Думаешь, я каждый день посещаю этот раздел?

>>739911

Мальчик, тебе мало? Ты понял уже, какой ты бред спорол?

> Ты понял уже, какой ты бред спорол?

Почему бы тебе не объяснить уже, а не кривляться тут как малолетний даун?

Можете накидать годных ресурсов для изучения матана с самого нуля?

Производные знаю, интегралы (худо-бедно), логарифмы знаю, а вот лимиты уже не помню.

Ты не хохол случаем? Один учебник знаю хороший, но на мове

Алгебра та початки анализу - автор Шкиль

Не, не хохол.

Мне не хочется создавать десятки таблиц для каждого из сервисов, а потом пересоздавать если api изменилось.

Может есть бд, которой можно просто скармливать json, а она будет сама заботится о том как это хранить?

Производительность не особо критична, но желательна поддержка sql или чего-нибудь похожего на него.

Анализ данных, визуализация, дата сайнс, вот это вот всё тут же обсуждается?

Значит велика вероятность, что тут люди знают как, особо не напрягаясь, собрать кучу json-ов в одном месте, а потом делать к ним запросы.

И это очень популярная задача, так что должен быть инструмент для этих целей.

mongodb

Postgres тоже может json.

>Если вы сможете полностью проработать эту книгу и прорешать упражнения, обязательно свяжитесь со мной - у меня найдется работа для вас.

Карьера преподавателя в Мухосранском Государственном Университете? Или что поинтереснее?

Помощник дворника на пол ставки по выходным

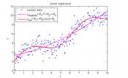

Нет, там все правильно нарисовано. Каждая точка - это решение классификатора для этих значений переменных. Линия - это граница решения.

Ты жопой читаешь, или инглиш совсем плох? Речь о классификаторе с двумя входными переменными. Оси им соответствуют. Подумай хоть немного сам, что же я тебе все разжевываю?

А результат линейной регрессии это не линия, разделяющяя параметры. А ебаный функционал от параметров в таргет.

По теме есть что сказать? Если нет - прошу нахуй

Что ты подразумеваешь под длиной градиента? Может быть мы с тобой разными терминами говорим. Длина градиента=шаг обучения? Если да, то я динамически изменяю(вычислили новое значение кэфов и J(Q) - если новое J(Q) > старое J(Q) значит кривая обучения растёт, хуйня, уменьшаем шаг обучения и заново считаем).

Если же нет, то я зря высрал абзац выше

Норма вектора, шайтан.

лол

> Так вот, как выбрать эпсилон?

Никак не выбирать. Такой путь - верный способ сделать overfitting, переобучить твою сеть под конкретные входные данные. Делай просто 1 (10, 100) шагов спуска для каждого из примеров, и все. Когда же закончить, спросишь ты. А вот когда (пишу это тут миллионный раз, так как ml-class.org прошли 1.5 человека - всем сразу глубокие нейросети подавай).

Делишь множество на 2 части, training и validation. Обучаешь training, получаешь функцию J(Q), далее прогоняешь через обученную функцию множество validation, получаешь функцию V(Q). Если все правильно сделал, со временем эти функции нарисуют график на картинке. Останавливайся, когда J(Q)==V(Q). В таком случае ты избежишь переобучения. Далее будут варианты - все хорошо (J(Q)==V(Q) причем требуемая тебе точность достигнута), обучение остановилось, а перформанса нет (J(Q)==V(Q) но требуемая точность не достигнута high bias), или обучение застряло (J(Q)!=V(Q)). Для каждого из вариантов есть свои рецепты как это улучшить - где-то можно создать новые примеры, где-то - сменить модель. Подробности в учебниках.

> Often the term "backpropagation" is used in a more general sense, to refer to the entire procedure encompassing both the calculation of the gradient and its use in stochastic gradient descent, but backpropagation proper can be used with any gradient-based optimizer, such as L-BFGS or truncated Newton.

То есть все это время ты кривлялся из-за того, что считаешь единственно правильным / знаешь только первое значение.

Пиздец, дурак. Лучше просто заткнись. Ты даже читать не умеешь.

О, наконец-то ты родил что-то отличное от оскорблений. И тут же показал свой уровень.

>Backpropagation - это и есть пример применения GD, придурок.

А если я использую L-BFGS, это уже не backpropagation что ли? Иди ты нахуй, школьник, мамку свою траль.

3 числа ты можешь легко визуализировать в трехмерном пространстве и посмотреть сам, что просходит. Можешь также применить PCA и посмотреть 3 проекции.

Ты не понял. Смотришь на визуализацию и оцениваешь, как лучше все это кластеризовать. Далее выбираешь метод и кластеризуешь. Проще 3д только 2д.

Понял, но смотри еще в чем загвоздка, ответы на вопросы равносильные. То есть тройка (1,2,3) по идее должна быть равна (2,3,1).

Аноны, вы тут нейронными сетями не занимаетесь?

Расскажите мне, какой из их типов лучше использовать для следующих задач:

Нужно научить манипулятор хватать, удерживать и перемещать предметы.

Нейронная сеть должна сама научиться классифицировать предметы по группам.

И еще одно, можно ли с помощью нейросети научить гуманоидное создание ходить?

Какой для этого лучший способ обучения? Нацепить на себя акселерометры и ходить по смоделированной в 3д комнате?

Нужно, чтобы в конечном итоге сеть сама определяла, как робот будет шагать и что делать в разных ситуациях.

И с каких задач лучше начать? Чтобы через 1.5 года суметь написать такое?

В алгоритмы умею, но работаю в другом направлении Серверы и жаба

Репортинг ин: решил 9 из 11 (соснул на перестановках и комбинаторике). Экзамен будет в разы сложнее, так что шансы мои не велики.

Никто в мире еще не написал, а ты напишешь. Ну удачи, че. Начни с изучения того, что уже есть.

Чего не написал?

Про хватания предметов уже давным-давно написали же.

А вот про ходьбу - да, но я и не нагуглил ничего по этой теме.

Затупил, спасибо.

Какой нибудь reinforcement learning тепе в помощь, можешь глянуть на intrinsically motivated reinforcement learning.

Бля, ну и криво я написал, пиздец.

О, анончики, мне понравилась тема треда.

Насколько это будет модным в ближайшие 6 лет? Я найду работу?

Аноны, а нейросеть может сама понять взаимосвязь между определенными элементами, например? Вывести закон физики для маятника?

Понятно.

А каким образом может происходить такое обучение вообще, если, например, в 3Д редакторе написать скрипт маятника и посадить сеть в роли камеры следить за ним, то научится?

Или надо связывать скрипт маятника и все данные с него посылать на сеть?

Если совсем примитивно, то любое машинное обучение это построение отображение из пространства признаков в пространство ответов. В случае с нейронными сетями у тебя есть конкретные функции преобразования исходных данных в конечный вектор представлений и какая-то функция потерь, принимающая на вход этот самый вектор представлений и истинное значение. Дальше мы каким-то образом оптимизируем параметры сети, чтобы она минимизировала нашу функцию потери. Сможет-ли она это сделать или нет и насколько хорошо (теоретически) в общем случае вопрос нерешенный, так что нужно пробовать. Ну и наличие здравого смысла тоже не помешает. Скажем, классифицировать изображения по количеству пикселей в них не получится.

Очень широкая постановка вопроса, невозможно ответить.

Подобрать константы для готовой формулы - да, может.

Подобрать формулу при фиксации конечномерного базиса функций - сейчас уже скорее да, чем нет.

Самостоятельно выводить законы физики - нет.

Не надо пихать ML туда, где работают точные законы и зависимости уже известны.

>>743013

Оче модно.

http://www.cs.nyu.edu/~mohri/mlbook/

>Подобрать константы для готовой формулы - да, может.

Можно примерно описать, что здесь имеется ввиду?

Если у меня есть готовая формула, с зависимостями, то зачем мне нейросеть?

В общем, ситуация такая, есть формула, но я не знаю полностью. связи между элементами этой формулы, а вычислять их - это очень и очень муторно, например, есть шагоход, я знаю, в какую сторону будут двигаться конечности, но высчитывать все затраты на сопротивление у материалов - мне лень, а нужна относительная точность.

Хочу использовать нейросеть, она для этого подходит?

>Подобрать формулу при фиксации конечномерного базиса функций - сейчас уже скорее да, чем нет.

Не понял тебя.

>Самостоятельно выводить законы физики - нет.

А как же кластеризация?

>>Подобрать формулу при фиксации конечномерного базиса функций - сейчас уже скорее да, чем нет.

А все, понял.

Если у меня есть несколько рядов чисел, то между ними сеть может найти закономерность?

Нейросети, как и все остальное здесь - аппроксиматоры. После обучения она будет представлять собой функцию, достаточно хорошо (а может быть и плохо, если обучение пошло не так) переводящую числа из одного ряда в другой.

Проблема в том, что ты вряд ли сможешь проинтерпретировать веса в сети, чтобы извлечь из нее готовую формулу.

Попробуй лучше регрессию с достаточно богатым базисом.

>А как же кластеризация?

Что кластеризация?

>А вообще, чем можно заниматься вкатившись в ML?

Я, например, оптимизирую CTR. Намеренно не вкатывался, просто возникла такая задача.

>Попробуй лучше регрессию с достаточно богатым базисом.

Черт, тот момент, когда математика становится полезной, загуглил.

У моего шагохода всего пока 12 приводов и мне лень высчитывать все затраты на сопротивление.

Суть в том, чтобы каждому значению положение ноги соответствовали значения из других сервоприводов, а вот эти значения мне никак не найти, потому что они могут быть рандомными.

Мб тебе какая-то модификация Калмана нужна? Опиши задачу подробнее, что за сопротивления? Какие датчики?

Сопротивления у подшипников, у моторов сервоприводов + сопротивление поверхности ступни.

Датчики - акселерометры и гироскопы.

И да, регрессия уже используется в коде самих сервомоторов.

Кстати, интересно получилось, сервомоторы не дергаются и потребляют на 32% меньше энергии и выглядят привычнее + момент инерции куда меньше.

У меня, считай решение задачи обратного маятника, только не в двух направлениях, а в повороте шарового шарнира на 360 градусов.

Но суть в том, что значения у этого маятника "плавающие"

Почитай что-нибудь про HMM и Factorial HMM. Вообще, очень смахивает на задачи, решаемые в теории управления.

Нет, это не тоже самое.

У меня имеет значение скорость ускорения сервоприводов, время исполнения.

Вроде того, что нога должна двинуться вперед, а туловище назад или как-то, чтобы уравновесить момент инерции ноги.

Поэтому и думаю использовать нейросеть, потому что мне неизвестна структура поверхности, ее высота или углубление, а оно может быть вообще рандомным.

Это будет в будущем, но в качестве модели в 3Д редакторе

Но как мне в этом случае проводить обучение?

>А можешь описать чем вообще такой подход лучше/хуже, чем постановка задач оптимизации в классическом варианте?

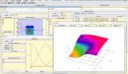

Это не оптимизация же. Идентификация систем, универсальная аппроксимация, вот это все. Лучше тем, что во-первых все очень просто, любая вообще нечеткая модель представима в форме стандартной аддитивной модели Коско пикрелейтед, для которой есть методы настройки параметров (обучения), как с учителем бекпропагейшеном, так и без, кластеризацией. Потом, получаемые модели полностью прозрачны и интерпретируются, в отличие от нейросетей н-р.

Вот типичный пример >>743243 когда лучше всего зайдет контроллер на нечеткой логике.

Давай лучше без обучения, это все-таки задача из теории управления. Чем тебя не устраивает выполнять периодическую калибровку сервоприводов? Замеряешь производную общего момента силы от управляющего сигнала на сервопривод и используешь его потом для выравнивания момента инерции.

С того, что это будет слишком дубово.

Я уже пробовал решать этот подход на двуногом шагоходе, но без поворотов ход только вперед-назад

И скажу тебе, что это худший вариант, я использовал нечеткие регуляторы, которые хорошо справлялись со своей работой, но как бы я не изменял мощность приводов - затрата на обычный шаг времени была огромна, если все сделать скриптом обычным, то время получалось чуть ли не в 3 раза меньше.

Да и та система не умела считать момент инерции и баланс веса, а просто, использовала усредненные значения с сервомоторов и подстраивала их под друг-друга.

Таким образом при общей высоте шагохода в 40 см и длине ног - 24, скорость метр за 48 секунд - слишком.

>>743353

А расскажи, что там дубового, были дерганые движения? Что происходило, если просто увеличить скорость работы всех сервоприводов? Шагоход начинал заваливаться? Ты использовал стабилизаторы?

Нет, дерганных движений не было.

Были наоборот, плавные движения.

>Что происходило, если просто увеличить скорость работы всех сервоприводов?

Тогда будет сильная вибрация всех частей, увеличится момент инерции и соответственно да, шагоход начинает вести себя очень непредсказуемо, может как уверенно стартовать, так и упасть на старте или на 3-5 шаге.

>Ты использовал стабилизаторы?

Нет и не собираюсь.

И да, я изменял материал подошвы, переписывал все под новые параметры, но все - фейл.

Поэтому и хочу использовать нейронную сеть, думаю, она сможет показать куда более интересный результат

Понятно. Честно говоря, у меня подозрение, что для обучения нейросети движениям потребуется огромная выборка.

Задачу формулируешь так - на входе требуемое изменение импульса + текущие управляющие сигналы, на выходе требуемые управляющие сигналы для получения требуемого импульса.

Попробуй посмотреть статью 10.1007/BF01186934, может что-то найдешь для себя.

Хмм, а может быть, для начала, занять рабочее время своего домашнего сервера вычислениями в несколько потоков?

Замоделировать уровень с препятсвиями, где модель будут толкать, а опорная точка двигаться по всякому, дать системе возможность управлять конечностями.

И через несколько тысяч перезапусков она сама, научится идеально управлять собой?

А потом просто все откалибровать.

Так и надо делать - примерную архитектуру сети и идеи обкатывать на компьютерной модели, эталонную версию сети тренировать на более тяжелой компьютерной модели с учетом большей части нюансов, а калибровку, учитывающую все допуски реальной модели выполнять уже на самом шагометре. Калибровать можно либо дообучая сеть, либо наложив на выходной сигнал сети какой-нибудь несложный фильтр.

Попробуй TensorFlow, Theano или Keras (если не осилишь первые два). Хотя особо значения не имеет на чем писать, просто эти трое мне нравятся.

Ты случайно не из ДС?

>>743328

Видимо, с наскоку идею понять не получится. Пока, с твоих слов, для меня это выглядит еще одной линейной моделью.

Попробую открыть твою книгу.

>Пока, с твоих слов, для меня это выглядит еще одной линейной моделью. Например, модель Такаги-Сугено пикрелейтед и есть линейная модель с правилами вида "если х есть А, то у = ах+b", но с ее помощью можно представить сколь угодно нелинейную систему. В правой части пика примеры 1 и 2-мерных моделей, в левой собственно матчасть, но я исправил ошибки, которые были в оригинале http://takagiken.com/takagi-sugeno-modeling.pdf

Это ты вообще, верно пришел к использованию нейросети.

Иди и почитай для начала, как работают нейросети.

А все же, для тебя будет легче сделать все таким образом:

Сделай все балансирующие движения, вообще, в качестве методов или функций.

И протестируй вообще, все-все-все движения, чтобы понять, как разная скорость и положение будут влиять на тело робота в разных положениях.

И потом, когда ты будешь толкать своего шагохода, то он будет выбирать из параметров ранее заданных функций и научится не падать.

Только тебе понадобится очень много тестирований.

Представь, что тебе надо затестить как будет влиять рука на робота вообще во всех положениях, которые он только может принимать, скоростях и прочем.

Но это все равно, будет очень быстро, просто понадобится туева хуча часов.

Зато ты сможешь выследить закономерности, я бы на твоем месте использовал тот же подход, который используют авторы всяких симуляторов, когда у них с помощью прямых показывается подъемная сила крыла.

Что-то слишком круто для меня. Но подход интересный и простой.

Надо будет опробовать в ближайшее время на обычной, стоячей позе.

Что это за ебучий пиздец? Нахуя это надо в жизни?

>Видимо, с наскоку идею понять не получится. Пока, с твоих слов, для меня это выглядит еще одной линейной моделью.

Это поехавший из /sci/, который уже хуй знает сколько времени носится с этими Такаги-Сугено. Тебя должно было насторожить уже то, что для него это самый перспективный метод в ML.

А что не так-то?

Класс, с домашнего компа статью не скачать.

>>743293

Мб, тебя это заинтересует:

Luciw, M., Kompella, V. R., Kazerounian, S., & Schmidhuber, J. (2013). An intrinsic value system for developing multiple invariant representations with incremental slowness learning. Frontiers in Neurorobotics

http://www.ncbi.nlm.nih.gov/pmc/articles/PMC3667249/pdf/fnbot-07-00009.pdf

Да я уже понял способы решения своей проблемы.

Кстати, нейронная сеть - это вообще, магия.

Сейчас тестирую свой старый шагоход, в целом, получится около 10к значений.

Потом кину на входы другой нейросети и пусть сидит, кластеризирует все, потом дам ей пошагать.

Вообще, картина интересная получается, все можно уложить в методы обычные.

То-есть, например, толчок туловища - 50 условных очков

Движение ногой в противоположное направление с определенной скоростью - это 50 очков.

Да еще и если двинуть в разные моменты, скорости ноги ступней, то она может как минусануть, так и плюсануть все.

От так то.

До этого лучший вариант был у генетического алгоритма.

Он смог прошагать метр за 16 секунд и ходил ровно и уверенно.

Но с 1200 попытки.

У меня какой-то печальный опыт с ГА и всеми этими эволюционными вещами. Мне с моими кривыми руками уж как-то очень трудно было их настраивать для получения адекватного результата.

А что реализовал то хоть?

Для них самое лучшее - это найти вариант, который будет работать из множества значений постоянно, но минус в одноразовости, в отличии от нейронной сети она не сможет поставить себя на место исходя из значений.

В первый раз была задача связанная с ресемплингом в particle filter. Есть достаточно много статей, где народ использовал ГА. На моей модели (косинус с неизвестной моделью изменения фазы и амплитуды) как-то не пошло. Хотя непрерывный муравьиный алгоритм сработал годно.

Во второй раз я игрался с GP на примерах классификации и смвольной регрессии, работало жутко долго и хреново.

Ага, Шагай к победе

Они не гуглятся даже почти. А то, что гуглится, окружено не меньшим колличеством непонятных слов.

Бери все

Тестил его следующим образом:

Так как эта версия ходит только вперед-назад, то и тест соответственный.

В тест входили данные с сервомоторов и акселерометров.

И самое главное, что после основных тестов и подачи этого на другую сеть, она каким-то образом сама научилась прогнозировать данные.

Реальная уменьшенная копия оригинального проекта.

Но дальше все буду где-нибудь тестировать.

Кстати, какая среда для этого лучше подойдет? Чтобы физика по реалистичнее была?

>Но дальше все буду где-нибудь тестировать.

Попробуй Blender Game Engine

Он с физикой, вроде, хорошо дружит

Но он же сырой, разве нет?

Я соснул 5/11

Зачем нужно ML чтобы оптимизировать?

Ну смотри. Были задачи по линейной алгебер, теории групп, теории вероятности, дифференциального и интегрального исчисления и парочка задач по программированию.

1. Линейная алгебра и теория групп это например Винберг.

2. Теории вероятности да хотя бы и статейки на вики(не знаю учебника по теор. веру).

3. Анализ читали в твоём вузике. На тесте были задачи первого курса. Так что знаешь что читать.

4. Программирование было элементарное. Рекомендую полистать Хормана, всего не прочтёшь, но основых заботай.

> Теории вероятности да хотя бы и статейки на вики(не знаю учебника по теор. веру).

Чтобы понимать статьи на вики по теорверу, надо быть знакомым с теорией меры и интегралом Лебега.

>1. Линейная алгебра и теория групп это например Винберг.

Спасиб, эо главное, что я искал.

>Анализ читали в твоём вузике

Я не учился в вузе.

https://ru.wikipedia.org/wiki/Математическое_ожидание

В английской википедии какое-то говно нестрогое написано.

> В английской википедии какое-то говно нестрогое написано.

как раз твоего уровня писня

читай и не выёбы

Более-менее.

Деанон PhD в зк по затылку.

Наш герой -- морячок!

Еще что вскудахтнешь, картофан?

Ух, это ты жестоко загнул.

У нас в итме этим кто-то занимается, но, зная уровень своей шараги, могу сказать, что творится там может полная хуитень.

>>746459

Вот же первая строка в выдаче, дебил.

https://academy.yandex.ru/events/sci-sem/cv/

Хочешь быть гуру?

1. читаешь статьи с докладов

2. читаешь статьи из ссылок статей

3. читаешь статьи из ссылок

4. въёбываешь

5. ????????

6. PROFFIT!!!!1!!!111!

Всё ж блядь как ирисы классифицировать.

>как ирисы классифицировать.

Кстати, об ирисах. А есть вообще алгоритмы, которые на классификации ирисов дают нулевую ошибку?

Да, большая часть нелинейных трансформаций входных данных сделает данные линейно-разделимыми.

Он считает ИИ самой большой угрозой потенциальной человечеству и что надо даже законодательно запрещать какие-то вещи.

Ну типа скайнет возможен?

В ОП-посте есть всё необходимое, при должном желании и адекватной мат.базе можно и дома задрочить.

Я пробовал то читать. Что-то понимаю, что-то нет. На самом деле я именно чувствую, что

> адекватной мат.баз

у меня и нету.

> А если в него не смогу поступать, то куда лучше?

Кстати, двачую вопрос. Во ВШЭ пар как-то много, я смотрел учебный план, там нагрузка 1к часов в семестр (то есть как в бакалавриате). С работой по времени тяжело будет совмещать.

Какие есть магистратуры на эту тему, где учеба вечером и пар не очень много? Куда-то поступать надо, потому что у меня военника нет, кек.

и добавить нечего

Если примитивная обезьяна смогла получить интеллект в результате случайных мутаций, то уж целенаправленное создание интеллекта точно возможно. Вопрос в том, не будем ли мы все кормить червей к тому времени, как его изобретут.

Привет, даун. Набор данных имеет конечный размер n, мощность множества преобразований, повышающих комбинаторную размерность любого алгоритма до значений выше n, несоизмеримо больше, нежели тех, что повышают ее до любого значения от исходного до n.

Не очень понял о чём вы, но ирисы могут слегка изменить свой внешний вид в результате эволюции, и любой алгоритм соснёт.

> большая часть нелинейных трансформаций входных данных сделает данные линейно-разделимыми.

Привет, важный профессор-академик. Думаешь можно с важным видом вскукарекнуть про мощность множества?

Так что, слабо пояснить почему мощность множества нелинейных трансформаций входных данных, которые сделают данные линейно-разделимыми больше мощности множества нелинейных трансформаций входных данных, которые сделают данные линейно-неразделимыми?

Ты же даже не можешь выписать мощности этих двух множеств, зато можешь с умным видом прокукарекивать слова мощность множества и называть окружающих даунами.

и да мне похуй на твои последующие вскукареки про алгоритмы. Разговор именно про нелинейные преобразования.

Какой же ты тупой, пиздец. В посте написано все что надо. Еще раз тегами - комбинаторная (или VC) размерность, конечность промежутка от 1 до n, счетность промежутка от n до inf.

>>747217

Не способен в вычислительную сложность?

Олух, мы обсуждаем твой вскукарек про _нелинейные_ трансформации входных данных:

"большая часть _нелинейных_ трансформаций входных данных сделает данные линейно-разделимыми."

Про нелинейность ты сразу забыл и стал с умным видом кукарекать про повышение комбинаторной размерности алгоритмов.

Если бы ты не был пустопорожним вскукарекалом с умным видом, ты бы просто выписал мощности двух множеств, про которые ты утверждал, что одна больше другой:

1) множества нелинейных трансформаций входных данных, которые сделают данные линейно-разделимыми

2) мощности множества нелинейных трансформаций входных данных, которые сделают данные линейно-неразделимыми

Просто выписать два кардинальных числа.

Вместо этого:

>кококо мощность множества!

>покпокпок комбинаторнаю размерность алгоритма!

>я тут чет написал тип пояснил, сделаю вид, типа не я нихуя не пояснил, а ты не понимаешь)))))

Ебанутый, правда не понимаешь, что разговор о нелинейных преобразованиях и о всех суть одно и то же?

>Просто выписать два кардинальных числа.

k и k^(cf(k)), где cf(k)) - кофинальность.

Это очевидная вещь даже не для математиков - осознаешь степень своей кончености?

Ну т.е. ты настаивашь на том, что ты просто кривляющийся клоун, кидающийся умными словечками.

ты формулируешь математические утверждения или пытаешься отделаться кукареканьем и пердежом в лужу?

>разговор о нелинейных преобразованиях и о всех суть одно и то же?

поясняй в каком петушином смысле это утверждение является правильным и почему. В прямом смысле это утверждение верным не является. - ты обосрался.

Если тебе очевидно, что в некоторых утверждения - ну так выпиши эту пару предложений, подтверждающих правильность, а не очевидность.

>k и k^(cf(k)), где cf(k)) - кофинальность.

у математиков принято вводить обозначения перед тем, как ими пользоваться. k - обозначение?

>кофинальность

ты типа все знаешь, только как пишется не знаешь, да? Верим-верим.

>cf(k)) - кофинальность

ты разницу между кардинальном числом и ординалом знаешь? Я тебя спрашивал про кардинальные числа или ординалы? ты понимаешь конфинальность - кардинальное число или ординал?

>ты понимаешь конфинальность - кардинальное число или ординал

>Если тебе очевидно, что в некоторых утверждения

Ебал ее рука

Круто, что ты жиденько обосрался и так и не смог пояснить свои кукареканья.

Мощность простого множества у него выражается через какую-то выдуманную кофинальность, которая не конфинальность с ошибкой.

Ты заебал засирать тред боевыми картиночками. Почему бы вам обоим не съебать в /sci/, /b/ или еще куда и не ебать там друг друга в жопу?

почему бы тебе не пойти и не пожаловаться своей мамаше.

Какой-то даун тут несет хуйню с умным видом и весь тред молча это ест.

https://en.wikipedia.org/wiki/Cofinality

Пойду повторять математику...

Ну да, несет хуйню, причем порвался и постит боевые картиночки для придания веса своим словам. Нахуя мне кому-то жаловаться, хочешь быть клоуном - будь им.

А ваши аутичные споры о терминах неинтересны, этой хуйней весь /sci/ забит так, что сидеть там невозможно, аутисты засрали /c/, аутисты засирают вообще все, что можно. В нормальную беседу не могут, лишь бы письку показать, и показать, какой ты крутой на ебаных бордах.

Я тоже слабо понимаю, о чём они сейчас.

Они пытаются посчитать VC-размерность нейросети? Они считают её оторвано от конкретной архитектуры?

> Я тоже слабо понимаю, о чём они сейчас.

Ну пиздец.

Вопрос был сформулирован конкретнее некуда.

Даун жидехенько обосрался, изображая, будто он что-то понимает. Попробуй сначала гуглом научиться пользоваться, прежде чем с дядями разговаривать. Кофинальность у него конфинальность с опечаткой, вообще охуеть.

Речь о конкретном датасете, общеизвестном под названием "ирисы Фишера"

Ну ты хоть поясни. Реально ли для любых линейно-неразделимых множеств найти нужное количество нелинейных трансформаций, которые могли бы сделать эти множества линейно разделимыми?

Вижу мудака. Без математики понятно, что если взять два класса и четыре точки на плоскости, то преобразование, оставляющее четыре точки линейно-неразделимыми - это любое преобразование из R2 в R2. А вот преобразование из R2 в любое другое пространство более высокой мерности, чем два, и не оставляющее точки на одной гиперплоскости сделает их линейно-разделимыми. Объем такого пространства - все возможные нелинейные преобразования из R2 в любое пространство минус все преобразования из R2 в R2 (ну и из R2 в R1, что маргинально). Преобразований из R2 в Rx интуитивно больше, чем из R2 только в R2, о чем и была речь. Данная ситуация прекрасно расширяется на любое количество точек и классов, выводы остаются в силе.

Как их хранить, что бы занимали мало места, но можно было обрабатывать?

У нас в ML любой вектор конечномерен. Значит ты всегда можешь завести табличку вида вектор -> число со всеми возможными векторами, и далее, ясен перчик, это разделить не то, что линейно, а прямо по y=const.

>то уж целенаправленное создание интеллекта точно возможно

С чего? Вдруг за это отвечает квантовая гравитация, которую мы не можем понять? Просто из-за ограниченности нашего мышления по Гёделю. Тогда возможно только случайное создание человеком.

Кароч, ты как-то голословно заявление сделал.

Вопрос был о ирисах, но вы уехали в срач о теминологии.

если ты говоришь с точки зрения теории вероятности, то соглашусь.

в противном случае - это задача даже не ближайшего будущего с учетом вполне себе постоянно ускоряющегося развития технологий

>Просто из-за ограниченности нашего мышления по Гёделю.

Я слышал, как теоремы Геделя приплетают к логике. Мол, логика неверна из-за стопятьсотой теормы Геделя, кек)))0

Но это, блядь, новая ебаная вершина. Ограниченность мышления по Геделю. Край нахуй, лизоблюды от математики совсем ебанулись.

Ты хоть понимаешь, что эта злоебучая теорма была про формальные системы - конкретный математический объект? Не про логику нахуй, не про мышление, а про сраную формальную систему. Слышим звон и вообще не понимаем где он. Гедель бы поехал от такой интерпретации своих теорем. Хотя подождите-ка, он ведь и так OH SHI~

>Значит ты всегда можешь завести табличку вида вектор -> число со всеми возможными векторами, и далее, ясен перчик, это разделить не то, что линейно, а прямо по y=const.

Но остается вопрос, насколько один вектор ближе или дальше от другого. Т.е. не каждый входной вектор принадлежит к своему классу, а все входные векторы принадлежат некоему числу классов, н-р в тех же ирисах это 3 вида.

"Не принадлежит никакому классу" - это тоже класс.

Может кто-нибудь накидать вот прям примеры реального применения ML? Судя хайпу по миллиардам влитых долларов, должен уже быть какой-то мощный выхлоп, да и вообще, в эту область довольно умные люди заняты не просто так уходят. Скорее всего я просто не глубоко копаю, но пока все успехи в МЛ, о которых я слышу, заключаются в том, что какой-то новый подход позволяет распознавать стандартный сет на несколько процентов лучше, или что кто-то со своим новым подходом победил в очередном контесте. Или что какой-то информационный гигант выпустил революционную систему AI, которая в теории сильно поможет врачам в постановке диагнозов, заменит бизнес-консультантов...но пока вы можете попросить ее составить вам рецепт блюд. Или пораспознавать возраст на фоточках. Самое реальное, что мне попадалось - это системы автопилота для транспорта, которые реально используются в конечных продуктах. Ну и тот же Watson, по завялениям, реально используется для помощи в диагностики рака и помог в организации бизнеса зоопарку. Но этого всего как-то мало, чтоли.

Я парсю Яндекс пробки что бы найти места где заказывать билборды

Парсю список предыдущих закупок дилеров одной сети что бы прогнозировать что заказывать и заказывать некоторую часть еще до того, как сами дилеры закажут, что бы ускорить время изготовления и доставки.

При этом я вообще никогда не работал программером

Яндекс.пробки сами по себе, рекомендательные системы, высокочастотная торговля, фильтрация спама.

> рекомендательные системы, высокочастотная торговля, фильтрация спама

как раз в том и дело, что это сильно абстрактный список. Мне же интересны конкретные системы, чтобы можно было вот наглядно прям понять, что именно в итоге МЛ делает. Для чего в итоге делаются все эти исследования с довольно сложной математикой

У мамки на работе (онкоцентр) используют хуйню вроде ML чтобы выдать прогноз по онкобольным. Типа сколько жить осталось. Если прогноз херовый - не лечат ни хуя, все равно помрет хули, а лекарства дорогие шо пиздец и на всех не хватает. В других онкоцентрах такая же хуерга, внедрена сверху минздравом.

Где она работает? Прям анамнез парсят? Что за система такая?

Взять хотя бы контекстную рекламу у Гугла или Яндекса, приносящую миллионы нефти. Рекомендательный сервис Netflix или Amazon'а, да и вообще рекомендательный сервис.

А не придумал ли ты это только что? Как система называется?

мамке до пенсии еще пахать. она одна за еботеку платит - мы без отца живем. скандалы нахуй не нужны.

парсят все подряд. плюс снимки, лабы

я в медецине не ебу. so подробностей нет.

у мамки говорят что чинуши лечатся в европе или израиле, где угодно только не у нас.

в швейцарии и австрии например.

онкоцентры это для быдла, шобы не бугуртело.

>Linux

I'd just like to interject for moment. What you're refering to as Linux, is in fact, GNU/Linux, or as I've recently taken to calling it, GNU plus Linux. Linux is not an operating system unto itself, but rather another free component of a fully functioning GNU system made useful by the GNU corelibs, shell utilities and vital system components comprising a full OS as defined by POSIX.

Many computer users run a modified version of the GNU system every day, without realizing it. Through a peculiar turn of events, the version of GNU which is widely used today is often called Linux, and many of its users are not aware that it is basically the GNU system, developed by the GNU Project.

There really is a Linux, and these people are using it, but it is just a part of the system they use. Linux is the kernel: the program in the system that allocates the machine's resources to the other programs that you run. The kernel is an essential part of an operating system, but useless by itself; it can only function in the context of a complete operating system. Linux is normally used in combination with the GNU operating system: the whole system is basically GNU with Linux added, or GNU/Linux. All the so-called Linux distributions are really distributions of GNU/Linux!

Загнать всё в БД?

Столман, отъебись

значение строка, чо правда?

https://habrahabr.ru/company/spbifmo/blog/271027/

ServPonomarev 17 ноября 2015 в 14:40

0

Писать про глубокие сети и ни разу не упомянуть машину Больцмана? Ведь именно она позволила уйти от проклятия алгоритма обратного распространения (быстрого затухания) и строить современные глубокие сети (с количеством слоёв больше 3-х). Нет упоминаний о свёрточных слоях — а это тоже один из столпов глубоких сетей.

barmaley_exe 17 ноября 2015 в 15:27

+1

А сейчас RBM'ки где-то используются? Тогда их использовали для предобучения, но теперь придумали новые трюки (например, дропаут, правильная инициализация, нормализация), с помощью которых можно обучать полносвязные нейросети, не занимаясь их предобучением.

Хз, мб, академик нам расскажет.

Про сети без жадного послойного обучения могу только только показать эту штуку:

http://www.cs.toronto.edu/~fritz/absps/dbm.pdf

Они тут всячески крутятся с mean field и MCMC.

Есть ссылка на доклад Салахутдинова:

http://www.cs.toronto.edu/~rsalakhu/

http://videolectures.net/deeplearning2015_salakhutdinov_deep_learning/

http://videolectures.net/deeplearning2015_salakhutdinov_deep_learning_2/

Бля, я обосрался, там тоже претрейнинг есть на RBM.

Короче вот че нашел

https://www.youtube.com/watch?v=0LVIEnfqf8g

Только не понятно, в память сети он говорит попадает новое предыдущее значение, а пример уже объясняет с суммированием со всеми предыдущими значениями. Так что там в памяти должно находиться? По логике понятно вроде что просто предыдущее значение, без всякого суммирования. Значит пример не совсем корректен?

А хотя не, все правильно же. Тогда непонятно, как же без нормализации не будет выход за слишком большие значения.

>2016

>предобучение

Хотя если значения отрицательные будут поступать, то нет.

Анон, подскажи, в какую сторону копать, чтобы понять это все?

Может, найдется анон, который круто разбирается и в нейронных сетях, и в нечеткой логике, чтобы объяснить все ро хардкору и наставить на путь истинный.

Очень надеюсь на помощь, спасибо.

ReLU-юниты (нелинейность без насыщения которое вызывает очень медленный спуск по градиенту) + дропаут + ДОХРЕНИЩА данных.

Чтобы сеть училась на своих же ошибках?

Двачую!

Короче - пропатчить рекуррентную нейронную сеть до уровня ассоциативной?

Интересно, никто бы не подкинул примера, как рекуррентная сеть учится управлять, например, обратным маятником?

Очень интересно было бы на это взглянуть.

Вот тут есть LSTM.

http://arxiv.org/pdf/1602.03032.pdf

Для подобных целей ещё всякие графические модели используют, вроде бы. У Бишопа что-то было по этому поводу, вроде бы.

Поясните ньюфагу хотя бы по поводу различий.

Я примерно вкурил, что такое нейронка, но вот выстроить картину с нечеткой логикой никак не могу.

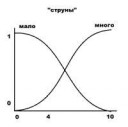

Нашел наглядную пикчу. Где здесь должна быть нечеткая логика?

>Анон, как подготовиться к поступлению в ШАД в следующем году? А то в этом я был немного шокирован заданиями, в которых половина слов была непонятна.

Я нашел репетитора (кандидат мат. наук) и занимаюсь с ним два раза в неделю по 2 часа. Плюс самостоятельно читаю вузовские учебники по алгебре/матану и задрачиваю решебники.

Хуёвая пикча, нет?

Сам я в нечёткой логике нихуя не разбираюсь и в остальных вещах разбираюсь слабо

Но тут есть тред на реддите:

https://www.reddit.com/r/MachineLearning/comments/32ja88/fuzzy_logic_and_machine_learning/

>Нашел наглядную пикчу. Где здесь должна быть нечеткая логика?

Пик у тебя полный пиздец, если честно.

>>748985

>объяснить все ро хардкору и наставить на путь истинный.

>я не пойму где истина. Нет четкой картины всего.

А я ведь советовал Пегата выше, >>736014 на русском по нечеткой теме (множества, логика, модели, применение, устойчивость, ...) сложно найти что-то лучше. Но главное не в этом. Нейросети, весь этот ваш байес и т.д. это стохастические модели, на основе теории вероятности. Нечеткие множества - отдельная тема, более того, вероятность можно свести к нечеткости, но не наоборот. Я даже конкретную статью давал http://sipi.usc.edu/~kosko/Fuzziness_Vs_Probability.pdf где все по-хардкору, в частности показано как само понятие вероятности сводится к множествам, а теорема байеса показана как частный случай нечеткой теоремы байеса.

Вроде даже натыкался на тот тред, но ничего дельного не вынес. но все равно спасибо

>>749329

Спасибо анончик, ща буду вкуривать.

Ты, если что, тут еще долго будешь сидеть, чтобы можно было вопросик какой-нить задать?

Я не очень понимаю, как ты собираешься сравнивать ИНС и нечёткую логику. На мой взгляд, это всё равно, что сравнивать линейную регрессию и теор.вер.

Линейная регрессия - модель.

Теория вероятностей - раздел математики.

Понятное дело, что говорить о регресси можно на языке вероятностей. Но как их сравнивать?

ИНС - модель (множесво моделей)?

Нечёткая логика - раздел математики.

О ИНС тоже можно говорить на языке нечётких множеств. Но как их сравнивать?

Ну вот как так получается, что строят ии с помощью нейронных сетей и строят с помощью нечеткой логики?

Еще можно встретить такие высказывания, что якобы нечеткая логика уделает нейронные сети.

Я не говорю об их верности, но кто же их как-то сравнивает..

Или вот вбить на youtube запросы нейронная сеть: там скажут, что можно распознать рисунок или лицо. И вбить нечеткую логику и там скажут, что с помощью нее можно научить машину объезжать препятствия.

Значит, это вроде как 2 способа обучить систему ии? Или я мыслю неверно?

Ты не понял мою мысль.

Ты хочешь сравнивать металл и молоток.

Молоток можно сделать из металла, но как их сравнивать?

Нечёткая логика и теория вероятностей - средства описания моделей, как металл - материал, из которого можно изготовить инструмент.

Или я не прав?

>Нечёткая логика и теория вероятностей - средства описания моделей,

А что является моделью или какие бывают модели?

Это я просто слишком туплю, видимо, пытаясь взять слишком много, но тем не менее хочу осилить

>Нейронка - модель.

Значит, стало быть, нечеткая логика это способ описания нейронной сети?

То есть типа как подраздел нейронных сетей?

> нечеткая логика это способ описания нейронной сети?

Один из способов.

Не подраздел нейросетей, а подраздел математики.

В гугле есть тьма статей о нечётких ИНС:

https://en.wikipedia.org/wiki/Neuro-fuzzy

Понятно, анон.

Можно, я еще раз уточню, есть методы построения обучающих алгоритмов, и одним из методов является нейронная сеть. В свою очередь нейронная сеть может быть описана различными способами, и один из этих способов -- нейронная сеть.

Я все правильно понял?

"Нейронная сеть" - это просто граф из отдельных операций. Точнее, некоторое множество таких операций, которые удобно представить в виде н-р ориентированного графа. В качестве самих операций можно взять что угодно, в том числе операции, типичные для модели на основе нечетких множеств/логики. В итоге получится структура типа нейросети, как выше заметили, например нейронечеткая сеть. У Пегата эта тема тоже раскрыта.

>>749434

>я еще раз уточню, есть методы построения обучающих алгоритмов, и одним из методов является нейронная сеть. В свою очередь нейронная сеть может быть описана различными способами, и один из этих способов -- нейронная сеть.