Вы видите копию треда, сохраненную 6 июня 2017 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Pattern Recognition and Machine Learning, Bishop.

Information theory, inference & learning algorithms, MacKay http://www.inference.phy.cam.ac.uk/itila/

Machine Learning: A Probabilistic Perspective, Murphy

Introduction to Statistical Learning ( http://www-bcf.usc.edu/~gareth/ISL/ISLR Sixth Printing.pdf )

Elements of Statistical Learning ( http://statweb.stanford.edu/~tibs/ElemStatLearn/printings/ESLII_print10.pdf )

Foundations of Machine Learning, أشهد أن لا إله إلا الله وأشهد أن محمد رسول الله. http://www.cs.nyu.edu/~mohri/mlbook/

Fundamentals of Neural Networks: Architectures, Algorithms, and Applications, Fausett L.

А. Пегат, "Нечёткое моделирование и управление"

другое

http://libgen.io / http://bookzz.org/ - здесь можно одолжить ^ книги и не только

http://arxiv.org/find/all/1/all:+nejronochki/0/1/0/all/0/1

https://www.reddit.com/r/MachineLearning/wiki/index

https://vk.com/deeplearning и http://deeplearning.net/reading-list/

https://www.kadenze.com/courses/creative-applications-of-deep-learning-with-tensorflow/info тюториал по slesarflow

http://rgho.st/8g68fTCSx две брошюры по deep learning для слесарей.

http://kaggle.com - весёлые контесты. денежные призы

https://www.hackerrank.com/domains/ai/machine-learning/difficulty/all/page/1 - олимпиадки

курс от китаёзы

http://videolectures.net/mlss09uk_cambridge/

яп

1. http://julialang.org/

2. https://www.microsoft.com/en-us/research/project/infernet/

3. https://www.r-project.org/

4. питухон и так все знают

5. idris/coq - модные яп для формально верифицированных нейроночек с тренировкой на этапе компиляции

ПЛАТИНА

Книги хорошо, но с чего начать практический вкат?

Во-первых, вам нужна любая unix-based система. На Windows возможно запустить нижеперечисленное, но ждите пердолева с настройкой и неодобрительных взглядов анонимуса. Кроме того, в компаниях, так или иначе связанных с разработкой йоба-ПО и machine learningом, Linux/OS X является стандартом. Привыкайте.

Во-вторых, определитесь с языком. Python и C++ наиболее мейнстримовые инструменты, с ними вы без еды не останетесь. Есть еще R, на котором пацаны живут статистикой и анальными пакетами. Некоторые инструменты являются языко-независимыми (Vowpal Vabbit, XGBoost), но обвязывать их вы все равно будете из какой-либо среды.

На Java разработано много production-ready инструментов для бигдаты и если вы угораете по терабайтам данных, то имеет смысл посмотреть в её сторону. Впрочем, лучше это делать уже потом, когда прийдет осознание потребностей.

В-третих, выбирайте себе задачу. Что угодно: распознать качпу, обнаружить ботов по логам, найти раковых больных. Список можно посмотреть, например, на kaggle.com. После чего приступаете к решению выбранной задачи.

Не прийдется ли мне потом с таким наборищем знаний идти в макдак работать?

Несмотря на хайп вокруг ML, далеко не во всех IT компания есть необходимость в ML и понимание круга задач, которые можно решить этими методами. Но поверьте, в 2017 компетентный специалист будет востребован. В России потребителями ваших знаний могут стать: Яндекс, Mail.ru, Вконтакте, Rambler, Касперский, Билайн, Связной, ABBYY, Хуавэй. В биоинформатике есть определенный спрос, можно поскролить http://blastim.ru

Здорово, но я так и не понял чем же вы занимаетесь в IT компаниях?

Попытаюсь ответить со своей колокольни и сразу хочу предупредить, что это едва ли консенсуальное мнение.

ML-специалист - это такое зонтичное определение для человека, способного увидеть проблему, выгрепать кучу логов и данных, посмотреть на них, придумать решение проблемы и врезать это решение его в продакшн. По сути, это кодер, решающий не чисто технические, а, в некотором роде, человеческие проблемы.

Имхо, мы все же остаемся в первую очередь разработчиками.

Что такое TensorFlow?

TensorFlow - опенсорсный гугловый инструмент для перемножения тензоров и оптимизации функционалов. Опенсорсный - потому что даже важные куски типа параллелизации уже выкачены в паблик. Если вам все ещё непонятно что это, значит это вам и не нужно, сириусли. Google перестарался с рекламой и теперь люди думают, что TF - это серебряная пуля и затычка для каждой бочки. До TF был Theano, который выполнял свою работу не хуже. И, в отличии от TF, он уже находится в стабильной фазе.

будет ли ML нужен в ближайшие 10 лет, или это просто хайп?

будет. хайп.

смогу найти работу?

Яндекс, мейлру, касперский, несколько биоинформатических компаний (iBinom, можно еще blastim.ru поскролить на тему работы), билайн (они с НГ целое подразделение открыли под ML и биг дату), связной. Ну и западные аутсорсы, если готов рачить за валюту.

нужна математика?

для начинающего ничего особого знать не нужно

https://www.amazon.co.uk/Calculus-Michael-Spivak-x/dp/0521867444

https://www.amazon.co.uk/dp/0534422004/ref=pd_lpo_sbs_dp_ss_2?pf_rd_p=569136327&pf_rd_s=lpo-top-stripe&pf_rd_t=201&pf_rd_i=0980232716&pf_rd_m=A3P5ROKL5A1OLE&pf_rd_r=3TZ38AZ2BY28R19H4SA5

https://www.amazon.co.uk/Calculus-Several-Variables-Undergraduate-Mathematics/dp/0387964053

https://www.amazon.co.uk/Introduction-Probability-Dimitri-P-Bertsekas/dp/188652923X

"основы теории вероятностей" Вентцель

поясните за нейроночки

нейроночка - массив

шад)))

Нет там ничего ML-специфичного, знание матана и теорвера на уровне заборостроительного вуза. Теорвер проходится на третьем курсе, как раз 20 лет.

Рандомный хрен туда не сможет поступить, потому что планка намеренно задрана, а не потому что там такая охуенно сложная программа. Это традиционная наебка "элитных учебных заведений", в которой учат так же хуево, как и везде, но за счет отбора поступающих якобы формируются неебовые успехи, которые объясняются именно качеством преподавания.

Иными словами, у тех, кто способен поступить, и так в жизни проблем с трудоустройством не будет.

Тред #1: https://arhivach.org/thread/147800/

Тред #2: https://arhivach.org/thread/170611/

Тред #3: https://arhivach.org/thread/179539/

Тред #4: https://arhivach.org/thread/185385/

Тред #5: https://arhivach.org/thread/186283/

Тред #6: https://arhivach.org/thread/187794/

Тред #7: https://arhivach.org/thread/196781/

Тред #8: https://arhivach.org/thread/209934/

Тред #9: https://arhivach.org/thread/223216/

Тред #10: https://arhivach.org/thread/234497/

Тред #11: https://arhivach.org/thread/240332/

Тред #12: https://arhivach.org/thread/246273/

Сколько этот пост не обновлялся уже?

>яп

>2. https://www.microsoft.com/en-us/research/project/infernet/

>4. питухон и так все знают

>5. idris/coq - модные яп для формально верифицированных нейроночек с тренировкой на этапе компиляции

Что за пиздец? Кроме питона, R и С++ в МЛ почти ничего не юзают. Потом будут в тред вкатываться Васи, которые идрис выучили, но работу найти не могут.

>Что такое TensorFlow?

>TensorFlow - опенсорсный гугловый инструмент для перемножения тензоров и оптимизации функционалов. Опенсорсный - потому что даже важные куски типа параллелизации уже выкачены в паблик. Если вам все ещё непонятно что это, значит это вам и не нужно, сириусли. Google перестарался с рекламой и теперь люди думают, что TF - это серебряная пуля и затычка для каждой бочки. До TF был Theano, который выполнял свою работу не хуже. И, в отличии от TF, он уже находится в стабильной фазе.

Слесарьфлоу уже месяца 2 как релизнут, но и до этого он был стабильным и работал намного лучше Теано.

Что-то лучше на русском языке найти можно?

добро пожаловать в тредик! всегда рады новым постерам

Двач, тебе не кажется, что существующие названия вакансий (и позиций), вроде Data Analyst, Data Scientist, ML engineer и пр. какие-то очень широкие, примерно как просто Developer, без привязки к языку, платформе etc, при этом каждая вторая контора считает своим долгом вставить свои 5 копеек в трактовку понятия? Появятся ли более мелкие, но точные названия в будущем?

В оп посте толстоты хватает. Учись отличать хуйню от полезной инфы. Причем Идрис к машобу вообще не ясно.

Это все имеет прикладной характер в МЛ? Или что-то можно скипнуть при самовкате?

Это азы математики, которые должен знать любой образованный человек, проходится на первом курсе любого универа. Учи, не торопись. На ютубе 3blue1brown шикарные интуитивные анимации есть линейной алгебры.

маняматика ненужна

Это все нужно чтобы понять svm.

маняматика нинужна

Каким был веб 15 лет назад? По моему, в МЛ все гораздо понятней и популярней, чем тогда.

Посмотрел в архиваче, пара анонов предлагали запилить чатик в телеграмчике. Я б с вами там тоже посидел, но я рачье и буду пиздеть в основном не по тематике

Примерно так же, вместо того, чтобы делать дела, люди в основном борятся с несовершенными инструментами. Не, классический МЛ-то еще более-менее, но нейроночки пиздец вообще.

15 лет назад гугл не сделали ангуляр, МЛ захайпали не так давно, гугл сделал тензорфлоу. Не, чет не похожи ситуации

Так тензорфлоу говно. Что-то более-менее для людей - это nvidia digits. В веб-интерфейсе сделал датасет, выбрал нейроночку, она обучилась и работает.

Нет, чувак, ситуция как сейчас будет, когда основную долю рынка будут занимать CMS на PHP, а не гуглы для аутистов.

поясни за гугл для аутистов бля

>Что-то более-менее для людей - это nvidia digits

Для обучения (человека, а не нейронки) - очень годная штука. Кнопочки тыц-тыц, мышей гуй потыкал, графики посмотрел, красота.

Но, чуть что сложнее простой классификации (локализация объекта, например, или кастомный слой caffe) - и начинается глубокий пердолинг копания в сорцах.

ML еще в самом зародыше, даже не родилось толком, и инструменты для него тоже.

Теория статистического обучения как раз общая теория мл. Нейроночки туда тоже вписываются.

В чате годно. Есть куча каналов на разные темы (в т.ч. NLP), народ собирается на сходки, на вопросы отвечают. Алсо в каком вузе учишься, если не секрет?

Так надо, чтоб в телеграмчике еще был двачевский. Похаживал я по популярным каналам по тематике нашей, так там не лампово вообще

В телеграме можно только за котики пиздеть, код вставлять и прочее в слаке намного удобнее.

Единственное, что бесит в слаке это инвайты, но это можно пережить, если грамотно автобота сделать.

А отдельные каналы general, хуе-моё? А большие тексты? Неудобно всё равно в ентом телеграме.

Впизду дропаю. Хуита какая то.

И еще я уверен что мимохуя со средней вышкой не по математике или прогерской. Без должного знания статистики и математики хуй возьмут на работу по мл.

Я думаю мне не вкатиться, это просто трата времени.

Всем спасибо, идите нахуй!

А мог бы пхп задрочить и кушать хлебушек. Эх ты.

сорос следующий

Да. Не берут без ВО.

На похапе полтора алгоритма. А так похуй на чем,всеравно Тьюринг полный язык.

Может, фейкомыльце оставишь? Расскажешь про свой вуз, про ваше нлп комьюнити. Могу там же про своё рассказать.

сделайте в телеграмчике. У всех нормальных тредов программача есть чатики в телеге, у нас нет.

- Системный подход, теория систем и т.п

- Дискретная математика

- Теория типов

- Теория распознавания образов

- Анализ: математический анализ, функциональный анализ и прочая; статистика; теория хаоса; теория вероятностей, нечёткай логика, теория возможностей, теория очевидностей Демпстера-Шафера и прочая

- Нейронные сети

- Байесовская сеть, вероятностное программирование, дифференцируемое программирование

Что скажете? Может что-то добавить или убавить?

>Системный подход, теория систем и т.п

Гуманитарная чушь

>Дискретная математика

Лишнее

>Теория типов

Строго нахуй

>Теория распознавания образов

Прошлый век

>Анализ: математический анализ, функциональный анализ и прочая

Матан и линал нужен. Функан - на уровне определений. Matrix calculus нужен. Статистика и теорвер нужны. Теория хаоса нет. Нечеткие петухи не нужны.

Зная это (первые 3 курса математики в универе), можно приступать к переднему краю и доучивать пробелы в процессе.

Все, что нужно - желание, видение проекта и, собственно, сам проект и пилить.

Все остальное, если будешь не мочь, наберешь по ходу разработки твоей хуйты. Только так люди и набирают скилы и вкатываются во что угодно, кмк

Видимо,можно писать спецификацию алгоритма, а идрис тебе выдаст скомпилированный алгоритм,соответствующий этой спецификации. Насколько мне известно, для мл никто ничего похожего не делал.

И надо классифицировать образец, в котором есть и А, и Б.

Если запилить байесовский классификатор, то для обоих классов будет умножение на ноль.

Что делать?

Промахнулся. Я про " генетическим программированием в типизированной лямбде ". Я думал тут так стебутся, а, судя по посту, не похоже.

Сперва создать канал в телеграме, а там посмотрим.

>нужна математика?

>для начинающего ничего особого знать не нужно

>список математической лит-ры

Этот список и есть "ничего особого знать не нужно" или же все-таки действительно из метематики ничего особого знать не нужно в начале? А в середине, чтобы устоиться на работу, например?

*математики

Ты можешь взять готовую библиотеку даже на том же пхп и что-то делать, но ты не будешь существенно двигать к созданию ИИ и сингулярности таким образом.

Тем, что может гораздо лучше соответствовать спецификации, чем человеческие поделия.

сам

Вапник. Причем еще в 90-е.

Это не лаба. Помогите, плес. Я просто другим занимаюсь по жизни, а тут такая задача возникла. Я вот думаю, может, из прикладной статистики что-то поможет? Но даже не знаю, с какого конца взяться.

Не, в образце для классификации будет и А, и Б встречаться, и ещё какие-то элементы (допустим: n1, n2, n3, которые с разной вероятностью есть в обоих классах). То есть там надо считать:

P(1|A,Б,n1,n2,n3);

P(2|A,Б,n1,n2,n3).

Не?

ну да, чем тебя умножение на ноль неустраивает?

там суммируется много значений и конечная вероятность не будет нулём

Понятно, что могу. Но вот, если идти работать в этом направлении, что из математики полюбому нужно знать?

И да, на вопрос, что нужно из перечисленных математической направленности книг, так ответа и нет.

Ну, так, давайте запилим. Авось, прорыв будет.

Линейную алгебру? Была в универе, но напрочь забыл за отсутствием практики. Не порекомендуешь литературу/курс?

эти книги только чтобы осилить мл литературу в шапке

если будешь работать по другим направлениям то надо будет учить что-0то другое

>>958456

https://medium.com/towards-data-science/linear-algebra-cheat-sheet-for-deep-learning-cd67aba4526c#.5migl6ymj

Круто, спасибо.

Какой курс? Просто в гугл вбей "матрицы учебник". Из всей математики, что была у нас в вузе, это самое элементарное, думаю. Проще только арифметика, даже школьная геометрия сложнее.

двачую, школьная геометрия - мощь

Там в числителе произведение, а не суммирование значений. Сумма в знаменателе лишь.

>но если P(B|1) = 0 то и P(1|B) = 0

P(B|1) участвует в числителе и весь его перемножает на 0. Таким образом, классификатор игнорит все остальные признаки классифицируемого объекта. Меня это не устраивает.

Напоминаю, что считаю P(1|A,Б,n1,n2,n3).

если Б входит в объект и Б не может входить в класс 1, то и этот объект не может входить в 1?

Может. Потому что невхождение Б в 1 - не значит, что наличие Б в образце автоматом этот образец делает чужеродным для 1. Считай, что это часть формулировки задачи классификации.

То есть мне надо посчитать, насколько образец похож на 1 и на 2, несмотря на все такие вот противоречивые вхождения А и Б.

Вот да, я пришёл спросить, что пробовать-то теперь. Наивный байес явно не подошёл. Я пробовал вообще выкидывать элементы с нулевыми для вычисляемого класса вероятностями - получались значения вероятности >1.

Может, ты ещё бы что-то назвал, что пробовать? Чтоб два раза не бегать.

Например, 1 = А, n1; 2 = Б, n1, n2, n3.

гауссов процесс попробуй, лол

ещё рандом форест есть и SVM - только у этих двух не будет вероятность на выходе, сразу класс выплёвывают. незнаю насколько для тебя это критично

эти 3 оче попсовые классификаторы, что-нибудь да подойдёт

фичи неизвестны или совсем отсутствуют? можешь попытаться вывести неизвестные фичи чтоб всё было одной длины

если фичи вещественны то нормализуй на [0; 1]. если дискретные то можешь использовать 1-of-К кодировку. будет длинный вектор нулей и единиц и по одному весу на каждое число

Совсем отсутствуют. Вместо них можно нулей напихать? Веса это вероятности же будут, я полагаю.

Пик в качестве благодарности, сотен нефти не нашлось.

что еще распознать? суканахуй

Можно на вход подавать не сырые данные, а обработанные. В том числе и вейвлетами. Можно это преобразование вкорячить в саму нейроночку, гугли wavelet neural network.

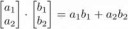

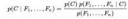

1) По Вапнику, задача обучения сводится к минимизации т.н. функционала риска, пик 1.

2) Конкретные примеры реализации этого принципа на пике 2, на место общей формулировки Q(zi, a) подставлены соответственно SSE и логарифм значения плотности распределения вероятности штоле, не суть.

3) Фишка предлагаемого метода в том, что все возможные варианты Q(zi, a) это функции, в общем случае - функционалы различной сложности. Само собой, все они сводятся к типизированной лямбде, т.к. имеют свой тип и представимы в виде конечного дерева из аппликаций, абстракций и чего там еще есть.

4) Задача, таким образом, сводится к нахождению оптимального функционала минимизации риска, что и возможно при представлении формулы 1.8 в виде спецификации для ЯП с зав.типами. Конкретно, нас интересует непустой тип с минимальными значениями R emp (a), зависимый от типа суммирования Q(zi, a) по всему датасету zi, точнее по самым разным таким датасетам.

5) Как было сказано выше, один из методов - генетическое программирование в типизированной лямбде, которое и подберет некоторое количество оптимальных вариантов функционала Q(zi, a), лучше других минимизирующего зависимый от него R emp (a).

Что скажете?

>>959314

Дело не в типизированных лямбдах, а в генетическом программировании с использованием их. Обычные ЯП для такой задачи не подходят, т.к. там сложный синтаксис и практически получить осмысленный код уже при небольшом объеме программы за разумное время вычисления нереально, автор генетического программирования именно на этом и обосрался. А лямбда - то, что нужно, т.к. там полтора элемента для выражения любой сложности - аппликация с абстракцией и глубина дерева общего выражения, что элементарно и без всяких костылей кодируется в виде "хромосом" для генетического алгоритма. Тута https://eldorado.tu-dortmund.de/bitstream/2003/34162/1/Dissertation.pdf все по-хардкору изложено. Совершенно понятно, что общий смысл происходящего - "экстракция" программы из некоего большого типа, содержащего все используемые для данной задачи в типизированной лямбде типы, что-то уровня описанного Максимкой http://maxim.livejournal.com/479716.html

До кода далеко, пока только гениальная идея - представить вапниковскую общую постановку проблемы МЛ в виде спецификации в MLTT с последующим автоматизированным нахождением лучших вариантов, удовлетворяющих условиям такой спецификации.

Не совсем дебил, просто удивительно.

Давай-ка пиздуй с этой параши, делать тебе здесь нечего - среди школодегенератов и просто дегенератов.

Удачи.

https://medium.com/@andrewng/opening-a-new-chapter-of-my-work-in-ai-c6a4d1595d7b#.ptzjlqd7r

У его жены стартап занимается машинами-самоездами, туда скорее всего.

Это звучит словно открытия древних шаманов, но хотелось бы какой-то совсем простенький пример с логическими операциями, например.

мимо

на курсере было два хороших курса Natural language processing, но сейчас их убрали, можно поискать где-то видео, один от Columbia university, там были марковские цепи и тд, другой от стэнфорда, что там - не помню. Можно попробовать поискать, на ютубе - один из них точно есть. Из книжек часто советуют Foundations of Statistical Natural Language Processing от Manning, не читал, но содержание выглядит прилично, и Speech and Language Processing от Jurafsky - мне не очень понравилось. Из нейроночек советуют курс http://cs224d.stanford.edu/ . Недавно хайпали этот курс https://github.com/oxford-cs-deepnlp-2017/lectures, но не смотрел.

ну и nltk-book, там по верхам проходятся многие популярные подходы

Отписал.

https://www.quora.com/As-a-beginner-in-Natural-Language-processing-from-where-should-I-start

В диссере по ссылке полно примеров,как и в доках к соответствующему пакету для R - rgp, регрессия например. Зависимые типы отдельная тема, ес-но.

>>959904

Спасибо, сохранил ссылки.

Ещё вопрос, кстати. Как получить доступ к видео лекциям стенфорда? Я почитал у них на сайте какую-то информацию и сделал вывод, что доступ есть только у студентов стенфорда. Я не прав?

Благодарю.

Мозгов не хватает как это закодить, чтоб красиво было.

Их же 15 должно быть в случае с разрешением из 4 элементов? (см. пикрелейтед)

Ананасы, а есть какая-нибудь конфа у машоберов?

В 2017 эта задача выглядит как "скорми нейроночке 1000 образцов твоей хуйни, а она сама разберется".

Используй Nvidia SLESARS чтобы собрать все нужное и запустить

https://github.com/NVIDIA/DIGITS/tree/master/docs

Только вместо lenet из gettingstarted используй alexnet.

Спасибо, но это неинтересно.Сделать саму задачу - не самоцель.Хочу разобраться во всём этом дерьме.

что там за три кружочка?

> No Free Lunch Theorem

Нечто уровня "теоремы Тарана / Пидорана" из /по. Эта твоя теорема касается алгоритмов с асимптотически близким к оптимальному решению. То, о чем говорю я, теория статистического обучения Вапника, как раз о том, как это обойти. Именно с ее помощью были построены алгоритмы, рвущие все остальные - градиентный бустинг, в т.ч. deepboost. И есть все основания считать, что это далеко не предел, сейчас уже делаются попытки построения глубоких SVM, опять же на основе вапниковской теории, в перспективе они обойдут глубокие нейросети. Там очень большой потенциал на самом деле, потому что подход к задаче МЛ правильный и обоснованный, а не как обычно "нахуярить побольше слоев)))". Фишка в том, что теория статистического обучения она не о каком-то одном подходе, а о решении задачи машинного обучения вообще, в принципе. О построении алгоритмов, эффективнее чем просто асимптотически приближающихся к оптимальному решению. И как раз это можно автоматизировать.

>>962114

То, что у тебя на 2ом пике - это нахождение наименьших квадратов фильтром Калмана. Сама идея взята из оригинальной работы Такаги и Сугено, и т.к. ANFIS это по-сути, TS с адаптивной настройкой свободных параметров, видимо и была использована Чангом без изменения. Вообще, фильтрация в т.ч. всякими хитрыми алгоритмами типа Н-2/Н-инфинити для настройки параметров нечетких моделей - тема отдельная и крайне мутная, лучше туда вообще не лезть без особой нужды, вот пример книшки в тему не для слабонервных http://gen.lib.rus.ec/book/index.php?md5=4710323AE0A71E05902C358A4EAEDF45 настроить свободные параметры нечеткой модели можно и без всей этой мути, вариантов полно вплоть до генетических алгоритмов. Я ж говорил, что ANFIS не самая удачная модель и точно не то, с чего стоит вкатываться в нейрофаззи-моделирование.

>Эта твоя теорема касается алгоритмов с асимптотически близким к оптимальному решению.

Вообще-то она утверждает, что для любого алгоритма бинарной классификации существует такое распределение на сэмплах и раскраска, что со строго положительной вероятностью эмпирический риск больше 1/10 или что-то около того (это если не ограничивать класс гипотез). Теория же статистического обучения (PAC Learnability) есть суть поиск условий на класс гипотез, для которого эмпирический риск с большой вероятностью близко оценивает реальный риск. Отсюда - в т.ч. ключевая теорема о PAC-лёрнабилити класса с конечным VC дименшион.

А про класс гипотез я как раз у тебя ничего не заметил. И именно поиск хорошего класса гипотез с конечной размерностью (или который суть объединение таковых если добавляем регуляризацию) есть основная проблема обучения.

Алсо, на практике в нейронках на теорию Ватника всем как раз похуй. Потому что VC дименшн нейронок очень хуёво оценивается, классическое правило большого пальца о 10 сэмплах на признак тоже не очень работает и т.п.

>можешь предложить, с чего стоит вкатываться в нейрофаззи?

Коско тута не любят вплоть до смищных картиночек в каждом оп-посте, но его стандартная аддитивная модель (SAM) - общий случай нечеткой модели, к которой сводятся все конкретные. То же самое по методам настройки свободных параметров, у него разобраны случаи бэкпропагейшена как пример обучения с учителем и кластеризация как настройка свободных параметров без учителя. 2ая глава вот этой книги http://gen.lib.rus.ec/book/index.php?md5=BC1EC0F44F2E619AB46D6FD0B7088514 Очевидно, что абсолютна любая нейрофаззи-модель - это частный случай SAM с настраиваемыми параметрами. Но опять же, с кондачка в эту теорию не въедешь, нужно немало медитировать. Простые примеры нейрофаззи-моделей, как и суть происходящего, рассмотрены у Пегата, причем с картинками и на русском.

>>962348

>А про класс гипотез я как раз у тебя ничего не заметил.

Класс гипотез - это конкретная форма функционала минимизации эмпирического риска? Или что? Конкретные формулы у Вапника покажи.

Ну например: H = {полиномы степени < n}, H = {гиперплоскости в R^n} и т.п.

В терминологии Вапника (которая довольно корявая) - это множество функций Q, по которым минимизируется функционал эмпирического риска.

Алсо, я тут потолщу немного на тему генетической генерации алгоритма. ПРОБЛЕМА ОСТАНОВА

>потолщу немного на тему генетической генерации алгоритма. ПРОБЛЕМА ОСТАНОВА

Не, не потолстишь. В MLTT/CiC все функции вычислимы, это не тьюринг-полная система. Поэтому корректность программы в любом нормальном языке с зависимыми типами означает полную корректность, там иначе оно просто чекаться не будет.

Ну, если устроишься тимлидом, то помогут.

Вот я сейчас занимаюсь изучением, пока не так далеко продвинулся - изучил линейные модели, деревья, разные регуляризации и т.д. немного в нейронки смотрю. Но есть такой момент, что мои знания математики хоть и не на нулевом уровне, вроде более менее знаю тервер, алгебру, матан и прочее, читать книжки вроде The elements of statistical learning или похожие такого уровня мне бывает достаточно тяжело и иногда просто упираюсь в то, что не знаю целого важного раздела математики достаточно хорошо.

Собственно вопрос такой - как лучше всего подходить к этому и настолько ли важно знать хорошо прям все? То есть вам нормальные книжки из шапки давались легко или тоже вызывали жопную боль достатоно часто?

Что тебя мотивирует этим заниматься? Почему-то стало интересно, что вообще может мотивировать в дрочке матриц людей, особенно сидящих на дваче, лол

Я не он, но отвечу.

Вышмат не знаю. Дрочкой матриц занимаюсь, потому что интересно. Такое странное ощущение возникает, что ты создаешь что-то полуживое, полуразумное. Я, конечно, в глубине понимаю, что это просто тупой перебор, аппроксимация и минимизация ошибки, но результат вдохновляет. Как много-много лет назад, когда написал первую программу на Бейсике.

Ботов охуенно будет так делать для игр и не только, интересно играть с такими наверно.

В контре можно например сделать бота что все время стреляет в голову, но тяжело с ним играть, а так чтобы с экспертов доучивались дальше, поможет плавно прокачать скилл.

>интересно играть с такими наверно

Когда знаешь, что это бот - нет.

Ведь ты будешь понимать, что он может стрелять тебе точно в голову, и реагирует гораздо быстрее тебя, но его скилл искусственно занижен, чтобы ты, убогое протеиновое существо с ограниченными возможностями, не так остро ощущал свою ущербность.

>читать книжки вроде The elements of statistical learning или похожие такого уровня мне бывает достаточно тяжело и иногда просто упираюсь в то, что не знаю целого важного раздела математики достаточно хорошо. Собственно вопрос такой - как лучше всего подходить к этому

Медитируй до просветления. Нету там никаких важных разделов математики кроме матана, теорвера, линейной алгебры (на уровня всяких хуевертий с матрицами и векторами). Просто тема для тебя новая, только и всего. Такие книшки нужно не просто на сон грядущий почитывать, а перечитывать непонятные моменты, гуглить непонятное, местами даже конспектировать, выписывать формулы и прорешивать. Так и победишь.

>The elements of statistical learning

На самом деле довольно хуёвая книга. Многовато статистики, на которую всем вообще-то насрать на практике. Из-за этого часто возникает ситуация, что за деревьями не видно леса.

> The elements of statistical learning

> хуёвая книга

> Многовато статистики

> statistical learning

> Многовато статистики

>>963106

Не нужно повторять заученные мантры. ESL часто фокусируется на совершенно неважных вопросах. Например, в первой же главе дохуя болтовни про конфиденс интервалз для коэффициентов линейной регрессии. Что, много людей этим заморачиваются в практических задачах? Кажется, сам Вассерман - который "Всё о непараметрической статистике" - сказал, что Дэйта Сайнс есть суть смерть практической статистики. Потому что эта примордиальная ёботня с РАСПРЕДЕЛЕНИЕМ СТЬЮДЕНТА С 1488 СТЕПЕНЯМ СВОБОД и прочими ХИ КОКОКОКВОДРАТ ТЕСТОМ НА НЕЗАВИСИМОСТЬ реально никого не ебёт.

Те же лекции Нга, или книга Бишопа, или ещё дохуя материалов гораздо лучше написаны. А по стэйт-оф-зе-арт все равно нужно читать статьи и специализированные монографии.

>дохуя болтовни про конфиденс интервалз для коэффициентов линейной регрессии. Что, много людей этим заморачиваются в практических задачах?

Так тебе же суть объясняют происходящего. А ты ноешь, что "много буков, плохо сделали, тупо, вон у Ына лучше".

>Так тебе же суть объясняют происходящего. А ты ноешь, что "много буков, плохо сделали, тупо, вон у Ына лучше".

Ноуп. К теории обучения в смысле Вапника дрочево с конфиденс интервалз имеет очень слабое отношение. И, например, в доказательстве ключевых теорем ML всё это замшелое статистическое барахло не используется. А используется, например, неравенство Хёффдинга.

Такие дела. Читать эту муть (ESL) совершенно не рекомендую, уж если интересует теории Вапника - то и читать лучше оригинальную монографию Вапника. Чурка в видеолекциях тоже приемлемо объясняет.

За последние 15 лет мы ни на шаг не приблизились к настоящему интеллекту. Но сильно рванули вперёд в машинлернинге и имитации интеллекта. http://www.rogerschank.com/fraudulent-claims-made-by-IBM-about-Watson-and-AI

Шенк очень хорош тем, что изучает не только обучение компьютеров, но и обучение людей. Он же и психолог ещё.

а без роджера тебе нихуя не понятно?

Неправда. Вот тут много слов сказано http://stats.stackexchange.com/questions/6/the-two-cultures-statistics-vs-machine-learning

The biggest difference I see between the communities is that statistics emphasizes inference, whereas machine learning emphasized prediction. When you do statistics, you want to infer the process by which data you have was generated. When you do machine learning, you want to know how you can predict what future data will look like w.r.t. some variable.

Of course the two overlap. Knowing how the data was generated will give you some hints about what a good predictor would be, for example. However, one example of the difference is that machine learning has dealt with the p >> n problem (more features/variables than training samples) since its infancy, whereas statistics is just starting to get serious about this problem. Why? Because you can still make good predictions when p >> n, but you can't make very good inferences about what variables are actually important and why.

ML подход в конечном счете оказался более успешным, потому что unsupervized learning (и сильный ИИ в конечном счете) возможен только в формате простых предсказаний.

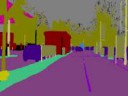

Подкорректировал немного твою картинку в соответствие с современными реалиями. Ты же не против?

Не совсем так. Уже сейчас шломо шекельберг начал подозревать, что на одних нейроночках далеко не уедешь. Поэтому соавторша вапника уже возглавляет исследовательский отдел гугла и именно там интересуются последними достижкниями ваппниковской теории, гугли deepboost. Нейроночки уже приблизились к пределу своих возможностей, дальше просто никаких кластеров не хватит для тысяч слоев этого хлебушка. Поэтому будущее за глубоким бустингом и стыкованными svm.

Я вот начал: Когнитрон, Перцептрон, Нейросеть, Нейрон, Матрица, Синапс, Дендрит, Пулинг, Свертка, Керас, Теано, Тензор, LeNet

Вроде просто распределенные генетические алгоритмы, пейпер с телефона не открывается, завтра посмотрю.

но там нескоько частей

муахахаха, дада матджава против питона, которая без библиотек, без возможностей, без сообщества, без единого адекватного проекта; какой дегенерат картинку нарисовал?

Мне вот вообще интересно, как можно заработать в данной сфере простому человеку и как можно конкурировать с компаниями одному простому почти нищему человеку? Найс идиотизм, что за школьнек-мечтатель фуфлогон?

Тебе сколько там лет? Ещё 20 нет, тогда ты ещё неадекватный человек, не создавай темы до 25, не отнимай время.

Всё это элементарная хуйня, которая обозначена незнакомыми словами только и всего.

Так всегда и везде, в любой науке.

Поверь мне, в этом мире всё просто. Единственная сложность - запомнить большой объём инфомрации.

Производная - это там где секущая никогда не станет касательной и неопределённость 0/0 может не раскрыться?

И ещё которая даёт неправильную мгновенную скорость в половине случаев?

Ты как будто на двачах впервые. Алсо, Джулия - до сих пор известный в академических средах язык. Не надо гнать.

Очевидно, что создав ИИ и задать ему целевую функцию нужную.

Что именно не получается? Напиши, может я что подскажу.

Короче, там очередное подтверждения моего тезиса, что сверточный нейроночки - далеко не единственный метод МЛ и в них все не уперлось. Суть там в том, что для настройки оптимального поведения в марковском процессе принятия решений (MDP) используют CMA-ES, это не совсем генетические алгоритмы. Авторы ссылаются на эту работу http://kyb.mpg.de/fileadmin/user_upload/files/publications/attachments/Neural-Networks-2010-Sehnke_[0].pdf Такими темпами скоро распиаренные на ровном месте авторы типа Ilya Sutskever откроют для себя меметические алгоритмы, которые поинтереснее реализаций CMA-ES десятилетней давности. Эти алгоритмы интересны тем, что неплохо аппроксимируют даже тысячемерные функции и не требуют для своей работы многотысячепроцессорных гугловских кластеров.

У тебя очень интересное мнение. Можешь еще что-то сказать? Что считаешь перспективным в этой области?

Считаю, что все. что вышло после ЛеНета (алекснет, гугленет и тд) - говен, который по сути клон нейросети Яна Ле Куна.

И помимо сверточных сетей, существует другое множество различных архитектур.

Да и вообще, что можно со свертчной сетью делать - только матрицы препроцессить. Это ведь не единственная проблема человечества.

Из-за хайпа вокруг сверточных сетей все как-то забыли, что МЛ гораздо более широкая тема. Многие области которой не развиваются из-за того, что не в моде. В частности, хуй капитально забит на fuzzy, intuitionistic fuzzy, rough, soft, neutrosophic - множества и их гибриды. Настолько капитально, что по большинству из них не существует ни одного алгоритма вывода в условиях неточности. Вообще, почему-то принято игнорировать, что вероятность - не единственная неточность из всех возможных. Дажк вапниковская теория статистического обучения касается только вероятности.

Ленет - неюзабельное говнецо, автор которого за двадцать с хуем лет не догадался использовать нелинейности, не вырождающие градиенты. Я молчу об отказе от pooling слоев и residual сетях - это для этого пердуна вообще рокетсаенс, хотя казалось бы, за 20-то лет можно было хотя бы попытаться. Основная проблема как раз в том, что сообщество никогда не верило в нейронки (потому что бумаги по поводу них много не изведешь) и всегда страдало хуйней типа перечисленной тобой. И огромной ошибкой будет опять начинать это бумагомарание. Фуззи-хуюззи, 30 лет не могли решить задачу отличить кошку от собаки, но зато грантов попилено я ебал.

"неплохо аппроксимируют даже тысячемерные функции" - ебанутый, тысяча измерений - это хуйня, у AlexNet 2562563-мерная функция и она не просто аппроксимирует training set - с этим вообще нет проблем, она предсказывает выход имея сраные 1000 образцов.

Кошку от собаки еще ART сети в 80х отличали, только ты про них даже не слышал, свидетель алекснета. Я даже не буду гоыорить, чтоо распознавание котов не единственная задача мл, для школоты это слишком сложное заявление.

>Кошку от собаки еще ART сети в 80х отличали

ты пиздишь хуиту.

>>965024

а ты прав. следующий хайп будет по вероятностным программам, уже виден кончик гигантского хуя это викинга. Но нужен датасет, который был бы непосилен обычным нейронкам.

В общем вопрос такой у меня - какой моделью лучше пользоваться для такой бинарной классификации и какую метрику юзать?

SVM с ренормализацией коеффициентов C

http://www.cs.ox.ac.uk/people/vasile.palade/papers/Class-Imbalance-SVM.pdf

Хочу читать бумагу. Где заказать бишопа подешевле?

Спасибо, попробую

ВЗАДПРОДВИГАНИЕ

ВЗАДПРОДВИГАНИЕ

ВЗАДПРОДВИГАНИЕ

двачую

сам купил вапника у пенсионера в проходе метро за 145 р.

в сортире поставил, ни о чём не жалею

С амазона на 4к выйдет. Слишком дорогое удобство.

Что за три кружка? Язык какой-то?

>говно говняное, а все юзаают

Ага, все идут не в ногу, один школьник с мейлру в ногу. Все пидорасы, школьник с мейлру Дартаньян. Я тебя понял. Открою секрет - если лично тебе какая-то хуитка без задач понравилась, это не повод считать ее лучше нормальных инструментов.

Имеет ли смысл учить алгоритмы МО и имплементировать их самостоятельно?

Их не учить надо, а понимать. Толку от вызубренной линейной регрессии не будет, а вот если сам сделаешь, сложные места найдёшь, то толку будет в разы больше.

Бамп вопросу

Вот появилась недавно мысль, написал пару простых алгоритмов, ничего не получил нового в плане понимания. Что-то новое, чтоб работало лучше других не напишу - там толпы математиков-погромистов писали годами против меня - студента.

поясните за idris. Где он вообще будет использоваться, будет ли вообще? Есть какой-нибудь реальный плюс использования такого, или это просто средство для становления псевдоинтеллектуалом 2 уровня?

Если ты не знаешь, что такое dependent types, то тебе он не нужен.

дифференцируемое программирование это имхо и есть НН. Посмотри на модели, там уже машины тьюринга, всякие модели с памятью и все такое. Но фишка в том, что чем сложнее модель, тем фиговее ее тренировать градиентом. А у вероятностных моделей в рукаве еще и монте-карло есть, когда градиент не работает.

Все, что можно пояснить за идрис - это ЯП с зависимыми типами, причем не сказать чтобы лучший. Пояснять надо за зависимые типы, а точнее за MLTT - конструктивную теорию типов за авторством пикрелейтед.

> у AlexNet 2562563-мерная функция и она не просто аппроксимирует training set - с этим вообще нет проблем, она предсказывает выход имея сраные 1000 образцов.

Пруфы?..

А что вообще можешь сказать об этом списке: https://www.quora.com/What-are-the-likely-AI-advancements-in-the-next-5-to-10-years/answer/Yann-LeCun ?

>>966643

>>966801

Я думал Мартин-Лёф это два человека. А тут один.

Ну, поясни, пожалуйста, тогда за зависимые типы (на простеньком примере типа палиндрома или чего-то такого) и mltt.

мимо

Долбаёб варга закинул

Варг причем вообще?

>>966804

>поясни, пожалуйста, тогда за зависимые типы (на простеньком примере типа палиндрома или чего-то такого) и mltt.

Это сложная тема, в 3х словах не пояснишь. Так-то зависимые типы даже на джаве делают http://beust.com/weblog/2011/08/18/a-gentle-introduction-to-dependent-types/ да и MLTT на одном листе можно уместить https://en.wikipedia.org/wiki/Intuitionistic_type_theory, но чтобы понять что вообще происходит, как минимум первые глав 7 этого http://www.cse.chalmers.se/research/group/logic/book/book.pdf нужно осилить.

Сложность вычисления градиента растет примерно как o(n), а сложность монте-карло примерно как o(exp(n)). Поэтому не взлетит. Ровно как не взлетит идея с генетическим программированием - там точно такой же комбинаторный взрыв.

>А что вообще можешь сказать об этом списке

почти полный список, но стоит учитывать что через 10 лет будут доступны большие квантовые компьютера с 100-200 кубитами и методы обучения скорее всего поменяются на статистические. В других списках ко всему прочему есть еще объединение нс с баесовскими методами, чтобы вычислять интервал конфиденциальности и оценивать распределение предсказаний. + в других списках есть еще построение теорий нейронных сетей.

>интервал конфиденциальности

Это называется доверительный интервал, чурка. И нет, не взлетит, потому что нахуй не нужно, как все то, на что дрочат статистики.

это тебе лично не нужно. но ты явно не в курсе про европейские регуляции на алгоритмы которые используются в области здравохранения.

Так ты в любом случае не будешь двигать, азаза

Был отправлен из треда про Big Data к вам. Поясните, пожалуйста, за термины:

1) Big Data

2) Data Analysis

3) Data Mining

Учусь, хочу вкатится туда, где будет много математики. Плачу негритянками.

>1) Big Data

Большие объемы информации.

Манипуляция ими.

>2) Data Analysis

Анализ данных. Тебе гугл транслейта не хватает?

>3) Data Mining

Такой анализ данных, при котором в данных ищут что-то интересное.

> где будет много математики

в математике довольно много математики, попробуй вкатиться в математику. нахуй остальное там маловато математики

Я дружу с английским и не только. Поясни, что такое 2?

>>967253

По поводу бигдаты. Обычно школьники кукарекают что-то уровня "меньше экзабайта не бигдата" и т.д. На самом деле бигдата - это все, что нельзя просто загрузить в оперативу из-за размера. Именно на этом месте начинаются изъебства, причем если у тебя скажем 8 гиг оперативы, методы бигдаты для тебя начнутся гигабайт с 5 в лучшем случае. И они ничем не будут отличаться от работы с терабайтным датасетом.

Яндекс, мейл, сбертех, крупные опсосы, всякие компании с биоинформатикой связанные шапку читать надо. Что делают можно в интернете найти

Спасибо

Извиняюсь, шапку прочитал невнимательно. Спасиб.

>Такой анализ данных, при котором в данных ищут что-то интересное.

Не "что-то интересное", а знания, сиречь скрытые закономерности в этих данных.

Дата майнинг и датаанализ не так-то просто различить, тут нужен не гуглтранслейт, а просто гугл.

Мимо, курсач через год ещё

Если пять гигабайт то лучше накатать bash-скрипт с нужными инструментами (типа grep, awk и прочая) и чуток подождать, а не поднимать hadoop.

Theano и tensorflow именно этим и занимаются, ты описываешь сетку в виде некоего графа средствами языка, далее этот граф оптимизируется и генерится уже быстрый код. Не хаскель, потому что хаскель нахуй никому не нужен, кроме распильных контор типа британских банков.

>>967676

Можно просто делать свопфайл на своем ссд.

Кто-нибудь знаком с pegasos? Там формула через кернел заставляет меня хранить весь датасет.

Потому что весы посчитать можно только через ФИ. А вот при умножении весов на входящий вектор - получается кернел. А для высчитывания (x,w) приходится поднимать весь обучающий датасет.

Какие есть способы не таскать его за собой? Есть же там какой-то online learning.

Уважаемый, поясни, будь добр.

Я уже знаю, что анализ даты это только часть работы с датой. Хотел бы вкатить хоть куда на работу, но не знаю где с ней работают и что нужно знать для такой работы. На самую простую, для начала, работу с датой. Конечная цель - майнить.

>Не "что-то интересное", а знания, сиречь скрытые закономерности в этих данных.

Нет, не знания ниразу. Наркоман.

Ищут ткнз скрытые переменные.

>Поясни, что такое 2?

Да все что угодно может там быть.

Это общие слова.

>>967268

>Где в Москве\России работают дата майнеры?

Финансы медицина крупный бизнес.

>Какую, к примеру, работу выполняют?

Пишут мартышкодерьмокод для анализа биржевых\медицинских\корпоративных данных.

>Всегда думал, что там нельзя быть мартышкой. С чем ты сравниваешь?

Все IT Это на 99% ctrl+c ctrl+v.

Есть небольшая прослойка высококлассных специалистов, которые занимаются, скажем так, наукой, и работают в ткнз R&D центрах.

Обычно чтобы получить подобную работу требуется ученая степень.

И раз ты задаешь подобные вопросы на харкаче, это скорее всего не для тебя.

В датамайнинг и прочий датааналлизис, тебя без профильного ВО то-же не возьмут.

Так что иди в университет для начала, на соответствующую специальность.

Статистика, на основе кучи всякого говна выбранного типа с гугл аналитикс или еще откуда, и делать из них таблички в икселе, находить зависимости, закономерности. Находишь зависимость, типа школота смотрит чаще на сайте айфоны, а нешколота смотрит самсунги, рисуешь красивый график показываешь начальству, и говоришь как на основе этих данных можно на сайте товары разместить и кому какую рекламу показывать. Хуета короче. Распознавание картинок это тоже статистика только в виде входящих данных - массив пикселей.

Ну и разные численные методы для статистических параметрических моделей: вектор-машины, перцептроны, PCA для распознавания еблищ и прочая хуета.

Мы о чем, бро?

>Ну не только же их.

Ну там еще выбросы можно детектить.

Но лучше детектить выбросы когда у тебя есть скрытые переменные.

Короче извлекать любую информацию которая может быть ценной.

>Стереотипы-стереотипчики.

Стереотипы потому и существуют, что имеют объективную основу в объективной реальности.

>И раз ты задаешь подобные вопросы на харкаче, это скорее всего не для тебя.

>В датамайнинг и прочий датааналлизис, тебя без профильного ВО то-же не возьмут.

Пиздец. Но я же у мамы молодец, лол. Расскажи, будь добр, подробнее. Профильное это ШАД?

>ШАД?

What?

>Но я же у мамы молодец, лол. Расскажи, будь добр, подробнее. Профильное это

Это любой университет со сколь нибудь вменяемым уровнем аккредитации.

This - >

>>968303

>бакалавриат, как минимум по математике/computer science

Но вообще, все хотят магистров.

А если R&D то докторов, или хоть аспирантов.

Идешь в МГУ например, и берешь полных список всех направление по computer science, выбираешь то, что ближе всего к интересующей тебя теме.

Но вообще, если уже выкладываешься в подобное, то имеет смысл сделать академическую карьеру, и уехать в германии или швеции на этом поприще.

>>968303

>>968302

Теперь я окончательно охуел.

То есть или я заканчивю ВМК МГУ \ ВШЭ по компьютерным наукам, или шансов нет?

>>ШАД?

>What?

Школа Анализа Данных при Яндексе. Даже это не избавит от академических мук?

>Но вообще, все хотят магистров.

Даже дерьмокодером нынче неберут без магистра.

Даже уборщицей.

Но есть лазейка в принципе, если у тебя есть опыт, и реальные прожэкты.

>Школа Анализа Данных при Яндексе.

Если она дает трудоустройство в яндексе, то на здоровье, если это то, что тебе нужно.

>Даже это не избавит от академических мук?

Если обучение для тебя мука, то это все не твое в принципе.

Я вообще сколько тебе там лет, но я вот мечтаю в универе всю жизнь учится.

Интересно, друзья гулянки любовь, молоденькие студентки.

Нет лучшей в жизни поры.

Еслиб еще молодость вернуть.

А там еще есть всякие кружки философские, а еще путевки всякие от государства. Кружки хорового пения.

Эх, Боже, какие же ламповые воспоминания.

Дружество и кипящее вино разлито по бокалам.

А после,

У всех уже своя дорога,

И некоторых людей так никогда до самого ты гроба

Уже не встретишь.

Будут только, воспоминания томить.

Короче пиздуй в универ и наслаждайся юностью.

>Школа Анализа Данных при Яндексе.

Если она дает трудоустройство в яндексе, то на здоровье, если это то, что тебе нужно.

>Даже это не избавит от академических мук?

Если обучение для тебя мука, то это все не твое в принципе.

Я вообще сколько тебе там лет, но я вот мечтаю в универе всю жизнь учится.

Интересно, друзья гулянки любовь, молоденькие студентки.

Нет лучшей в жизни поры.

Еслиб еще молодость вернуть.

А там еще есть всякие кружки философские, а еще путевки всякие от государства. Кружки хорового пения.

Эх, Боже, какие же ламповые воспоминания.

Дружество и кипящее вино разлито по бокалам.

А после,

У всех уже своя дорога,

И некоторых людей так никогда до самого ты гроба

Уже не встретишь.

Будут только, воспоминания томить.

Короче пиздуй в универ и наслаждайся юностью.

> друзья гулянки

Если ты в шараге им. Сутра Опохмелидзе, то да. Если ты не в шараге, то тоже да, только ничего полезного для себя из такой "учёбы" не извлечешь. Т.е. либо ты ебашишь, сократив "друзьягулянки" до охуенного минимума, либо ты очередной хуесос, который не по специальности пойдёт УНИВЕР НИЧЕГО НЕ ДАЛ, виня в этом всех, кроме себя

Глупое необоснованное мнение.

Всего должно быть в меру.

Что там в универе "ебашить" нужно, вообще непонятно.

Учись в свое удовольствие.

А друзья в универе, это основа всех твоих связей по жизни, которые дают социальные лифты.

Глупое необоснованное мнение.

Хочешь нормальных результатов в чём-то - никакого "всё в меру" не должно быть.

"Ебашить" в смысле постоянно заниматься, по возможности изучая что-то интересное лично тебе сверх программы.

Учился в своё удовольствие, ловил ни с чем не сравнимый кайф от учёбы.

А друзья и знакомые из универа не для каждого основа связей по жизни, мне больше помогли связи с друзьями друзей, которых я ещё со школы знал.

знакомая с параллельной группы, кстати, вообще на заправке, НА ЗАПРАВКЕ, блджад, с мат. образованием вуза дс2, работает, и таких примеров просто дохуя, зато в общажке весело бухала чуть ли не каждую неделю, сдавая экзамены тупой зубрёжкой, благо ещё преподы не очень жётские были

>Глупое необоснованное мнение.

Оукей...

>Хочешь нормальных результатов в чём-то - никакого "всё в меру" не должно быть.

Ох, ну как скажешь.

>знакомая с параллельной группы, кстати, вообще на заправке, НА ЗАПРАВКЕ, блджад, с мат. образованием вуза дс2

Такое повсюду в РФ, ценность ВО почти нулевая. И че?

Все зависит от тебя.

Кто-то уехал в Германию и стал там руководить лабораторией, а кто-то стал уборщицей, хотя окончил вуз с красным дипломом.

Все дело в том, что ты для себя извлекаешь из вуза.

>зато в общажке весело бухала чуть ли не каждую неделю, сдавая экзамены тупой зубрёжкой, благо ещё преподы не очень жётские были

И че?

Да ничё, забей, какой-то хуйнёй занимаемся в треде про машоб

задрачивал в университете, но он все равно ничего не дал

>Хочешь нормальных результатов в чём-то - никакого "всё в меру" не должно быть.

Должно. В вузе примерно 70% знаний не нужно, можно на них забить, и распределить время как 35% на дроч в свое удовольствие, 35% на пьянки-гулянки, чтобы не выгореть нахуй.

бамп реквесту

>Да читани ты сам, что такое датамайнинг в целом. Ты рассказываешь про то, в чём шаришь сам - это хорошо, но это не исчерпывающий ответ, неточный.

Ну так точных исчерпывающих ответов и не бывает (кроме школьных уроков математики).

Потому всякий статистический анализ, и дата майнинг, и существуют.

>Реальность на таком уровне переменчива.

Помню замечательную картинку-комикс, к статье о, по моему "достаточность доказательств".

В старом журнале химия и жизнь, вроде.

Там были две крысы.

Когда горит красная лампа их бьет током у кормушки, когда зеленая - можно есть.

Первый раз ударило током.

крыса 1 - "ебана когда горит красный бьет током!"

крыса 2 - "недостаточно фактов чтобы утверждать это, быть может сие было случайным"

Второй раз загорается красная лампа.

крыса 1 отпрыгивает в ужасе.

крысу 2 ебошит током. Крыса номер 2 говорит полуживая - "все еще мы не можем делать достаточно обоснованных выводов, быть может люди хотят обмануть нас, а быть может что-то совсем другое влияет на удар током"

Третий раз загорается красная лампа.

краса 1 отпрыгивает.

крыса 2 жарится. Дымится и бьется в конвульсиях, с трудом выдавливает из себя - "это не может считаться достаточным доказательством так как..." и в таком духе.

Надо бы ее найти...

А так да, реальность переменчива.

Хотел начать дообъяснять и спорить, потом понял, что всё равно по жизни крыса 2, чего уж там.

Что скажите об этой библиотеке машинного обучения? И если взять концептуально, то зачем там гомоморфизмы?

>Скоро до кого-нибудь дойдет, что в нейросети вообще нет ничего кроме стрелок и котягорий. Или лямбда-термов, кому как нравится

В нейросети нет ничего кроме матриц.

Наркоманы злоебучие.

Я конечно трезво понимаю, что из веба нужно выкатываться и как можно скорее, потому что это въёбывание, тупое въёбывание, где конкуренция растёт с каждым годом, а вкатывальщиков всё больше и больше.

Вокруг машоба я не вижу хайпа, хайп надуман, курсы потребляет очень мало человек, реально учиться и вкатывается 3.5 человека.

Перспективно, но для тех, кто сейчас поступает в универ и будет искать работу через 4-6 лет.

А вот мне щас, что делать? Отслушаю я месяц курсов, эт ос учётом того ,чт оу меня есть хорошая математическая база, а дальше куда?

Живу в Воронеже, вакансий по машобу нет, какие-то свои проекты в одичноку я не потяну, только переезд в мск.

В мск требуются специ за 300к, без опыта или с малым опытом есть, но всё очень мутно.

Что думатете по этому поводу, что мне делать?

Жалко потраченного времени на веб, но уходить рано или поздно придётся, ибо отрасль умирает, к тому же я работаю на фрилансе у меня не будет пенсии и других соц гарантий и по своему здоровью я вижу, что в 40 лет уже не смогу работать программистом ,а в машобчеке можно и карьеру по административной лестнице сделать.

300 к? без опыта? дурачок что ли? Я видел вакансии около 80-100 к на дата саентистов, но там я бы не сказал что без опыта.

Я хоть писать не умею, но ты вообще, по всей видимости не умеешь даже читать и видеть элементарную логику.

Внимательнее перечитай пост.

Не путай пидорство с девочкой внутри.

лучше расскажите истории трудоустройства для мотивации, поделитесь опытом.

Или тут одна студентота?

В смысле блять? Ты просто идешь в контору на собеседование. Тебя не берут. Ты говоришь ну и хуй с вами дебилы набирайте дальше макак из ПОХАПЭ треда. Пиздуешь в следующую контору.

Нет пути, если нет серьезной подготовки по математике и статистике. Короче хуй вкатишься если ты собачий хуй.

Несёшь хуиту, в вакансиях нет ничего про образование, хватит бакалвриата/магистратуры

Чтобы работать нужно иметь опыт работы в машоб, где его взять, если его нет?

Самый реальный вариант на мой взгляд - вакансии с опытом 1-3, где требуется какой-то смежный опыт, например бигдата, в бигдате можно получить опыт без опыта, просто выучить основы java/python и чуть чуть математики с первого курса любого технического факультета.

Т.е. те, кто имеет опыт в смежных областях - могут вкатиться в машоб и т.п., а просто с улицы или из веба, как в моей ситуации, - хуй.

Пройдёт несколько лет, будут требоваться джуны, но сейчас нет.

Я хочу вкатываться сейчас, а не через несколько лет.

Ну так вкатывайся, кто мешает? Проблема в том, что сайт нужен каждой заборостроительной конторе, а сеточки - чуть более чем никому.

>чт оу меня есть хорошая математическая база

>нет серьезной подготовки по математике и статистике

Ещё раз, прошу тебя, научись читать.

И математика, по-моему опыту, это гораздо более понятная, приятная и простая сфера, нежели, чем веб.

Потому что математика - это в первую очередь инструмент, который придумал человек для работы, для удобной работы под конкретные задачи.

А веб - это организм, выросший на деструктивной деятельности человека, при этом часто лишённый логики.

>Ну так вкатывайся, кто мешает?

Страх проиграть.

Жалость по тому, что было потрачено время на вкат в веб.

Отсутствие вакансий без опыта.

Я не могу бросить работу и полностью погрузиться в учёбу, параллельно с работой учиться тяжело.

>каждой заборостроительной конторе

Миф, опять же по-моему опыту, большая часть мелкого и среднего бизнеса не хочет иметь сайты, потому что их устраивает объём заказов, который получают через сарафанное радио и объявления.

Во-вторых, типо решения вроде сайта-визитки, объявления, лендинга и даже магазина клепаются конструктором.

Есть куча шаблонов, куча cms, куча решений дизайнерских и технических, многое из которого можно получить бесплатно.

А работа веб-мастера сейчас - это сродни сборщику мебели икея. Всё уже готово к тому, чтобы это собрали, инструкция есть в картинках для самых маленьких.

Серьёзной веб-разработки для конкретных индивидуальны, не типичных проектов, относительно всего рынка не так много.

Когда сайтостроение для крестьян станет доступным и автоматизированным, ну или хотя бы прост очень дешёвым, тысячи веб-разработчиклв побегут в более серьезную разработку, а там нет столько работы. 90% останется за бортом, и это случится при моей жизни.

Этим меня привлекает машоб, и вообще любые сложные вещи, которые на самом деле не сложные, просто считаются в народе сложными. Тут нет вкатывальщиков, есть перспективы.

Поверь, в этот ваш машоб на уровне слесаря-наладчика вкатиться проще, чем в веб, скоро любая бабулька будет сеточки с котиками обучать.

Ты академические работы читал? Цифры видел? Они же смешные, обучение без учителя это технология завтрашнего дня и бизнес за нее платить не будет.

Ну пробуй, я вот дропнул, осилил 1,5 курса специализации от яндекса и мфти, дальше я просто не смог.

На том и порешил, буду уделять по часу каждый день, глядишь к тому времни, когда веб всё, и перекачусь.

Был спор с аноном о том, как нужно общаться, чтобы нейросеть не могла идентифицировать твои тексты. Анон писал, что нужно изобретать свой язык с кодовыми фразами, короче, чтобы со стороны это выглядело как бред. А я думаю, что нужно наоборот писать без грамматических ошибок в общем стиле, тогда не будет понятно, где твой текст, а где не твой. Как вы думаете, кто из нас прав?

Просто берешь сетку и учишь ее подделывать тексты известных политических деятелей.

Ну тогда сетка товарища майора будет думать что это пост Владимира Жириновского а не Антона Безымянного.

Но писать то будет не сетка, а ты, лол. Или типа перед отправкой сообщения пропускать его через сетку Жириновского? НЕГОДЯИ! ПИДАРАСЫ!

А как это делать ты узнаешь, прочитав полугодовой курс по нейросеткам от ведущего российского ВУЗа - /pr/-университи.

https://2ch.hk/b/res/150641886.html (

https://2ch.hk/b/res/150638186.html (

Я уже сорцы и тензорфлоу качаю, кек. Не хотите поучаствовать?

Бля, ещё сципи нужон.

короче, вкатываться просто. Ботаешь xgboost, python или R и идешь решать задачи на Кеглю. Переезжаешь в ДС, ходишь на всякие тусовки и хакатроны, обрастаешь знакомствами. Параллельно участвуешь в разных российских хакатронах и соревнованиях от банков. Это все займет макс месяцев 12. Потом работа сама тебя найдет.

А я на днях вкатился в ML проект, чтоб разнообразить свои скиллы, вообще не зная ничего про ML =) Чисто за счет опыта работы с java, на которой написана система. Вообще, это частая связка, ML и java? Постоянно слышу про питон, R, скалу.

исходя из теории вероятности, информации и прочей шелухи, тебе нужно писать, как все, чтобы энтропию повысить, а по уникальному языку тебя сразу различат, так как тексты на уникальном языке все равно содержат информацию, повторения и тд. Но на самом деле нет, тебе просто нужно зашифровать свой текст хорошим алгоритмом и одноразовым шифром, короче, это уже криптография.

зависит. в сэйлсфос вроде как все юзают яву. но для машинного обучения это зашкварный язык, ибо приходится писать много с нуля.

>тебе нужно писать, как все, чтобы энтропию повысить

> а по уникальному языку тебя сразу различат, так как тексты на уникальном языке все равно содержат информацию, повторения и тд.

Вот! Мерси, вот это была моя точка зрения, только таких умных слов не знаю, так и думал, короче.

Ну не, про криптографию это уже не язык, получается, а шифровка, постоянно так общаться не выйдет.

Именно так!

сагаю отсталых даунов

Нинужно столько тупых машинных учителей. А если ты не тупой, то и сам разберешься. Вон на Кегле индусы с китайцами атакуют

>Так разные Tensorflow, Theano вообще пихают вычислительные графы

Я хз что это за звери, но нейросети это чистые матричные вычисления.

От чего их так приятно гонять на GPU, и от чего они вызывают боль у CPU.

Причем там кроме умножения сложения и вычитания матриц ничего нет в мат аппарате.

Ну разве что функция активации может быть кокой интересной очень. Но обычно это квадратичное что-то.

>их так приятно гонять на GPU

Есть у меня 680 жифорсина, для того, чтобы как следует обучить сеть нужно говнять её ~ 30 часов. Сам я её давно не юзал, примерно полгода после покупки забил хуй на игры, хуигры и прочее говно, потому что-то очково её на 30 часов запускать. Она не сгорит, анон? Может ну его нахуй? У тебя у самого сколько обучение идёт? В общем вопрос такой, не страшно ли видюхе будет столько времени без перерыва работать?

ну его нахуй, анон. ещё загорится

лучше не лезь ты в этот мл, нахуй тебе эти нейроночки

всёравно видюха старая, ещё хату спалишь, жена отпиздит, ненадо тебе это

Вот и я к этому склоняюсь.

На паузу ставить типа? Или там есть опция сохранения состояния.Не за неделю, почему, по 5 часов можно вполне, да и 30 это я по максимуму взял, а так 20 где-то.

>>971445

Погуглю, спс. А сами вы что юзаете? Или у всех теслы в сли стоят?

Там номер карты и телефон нужен.

>кул стори бро

>пиши есчё

Я серьезно.

Нейросети суть параллельные вычисления. Там магии то никакой нет.

Входной сигнал есть вектор.

Он вумножается на матрицу весов. Полученный вектор поэлементно ебошим через функцию активации, вуаля.

>>971418

>потому что-то очково её на 30 часов запускать. Она не сгорит, анон? Может ну его нахуй?

Зависит от охлаждения и настроек.

Если очкуешь, запусти оверклакерскую утилиту и понизь частоту GPU.

Производительность просядет немного, зато гораздо экономичнее и холоднее.

Производительность с частотой растет линейно, а энергопотребление экспоненциально.

>У тебя у самого сколько обучение идёт?

Зависит от. Можно и неделями считать. Если больше пары дней, то нужно искать железо помощнее.

Я хер знает на чем ты учишь. Если на кофе - то это называется snapshot: 1000

Если на чем-то другом то поищи как в твоей параше это делается

>Если больше пары дней, то нужно искать железо помощнее.

Чисто практическое ограничение.

Елси тебе что-то неделю обучать нужно, то нужно уж быть уверенным, что оно того стоит.

Ну да все так + идет настройка параметров, через обратное распространение ошибки все тем же векторным умножением, а нейронки маркетологи преподносят чуть ли не как искусственный мозг, который может все.

А гугл клауд использовал? Он карту с телефоном просит.

>>971466

tensorflow, это ты про сохранение прогресса?

В общем, я понял, я скорее всего задачу выбрал тяжёлую, потому не стоит удивляться таким срокам. Главное, что мозгов хватило посоветоваться, так бы поставил сейчас на 30 часов крутиться и без видюхи остался бы. Спасибо.

>А гугл клауд использовал? Он карту с телефоном просит.

Ноуп.

Я не любитель облаков.

Мне проще свой сервер сделоть. Или комп апгрейднуть.

Кстати говоря, у APUшек амудушных есть неплохой задел для нейрончиков, в виду общей для GPU и CPU памяти. Ну да есть ли там кокие фреймворки я не в курсе.

Да вот, нашёл уже скорее всего.

w1 = tf.Variable(tf.truncated_normal(shape=[10]), name='w1')

w2 = tf.Variable(tf.truncated_normal(shape=[20]), name='w2')

tf.add_to_collection('vars', w1)

tf.add_to_collection('vars', w2)

saver = tf.train.Saver()

sess = tf.Session()

sess.run(tf.global_variables_initializer())

saver.save(sess, 'my-model')

# `save` method will call `export_meta_graph` implicitly.

# you will get saved graph files:my-model.meta

restore model:

sess = tf.Session()

new_saver = tf.train.import_meta_graph('my-model.meta')

new_saver.restore(sess, tf.train.latest_checkpoint('./'))

all_vars = tf.get_collection('vars')

for v in all_vars:

v_ = sess.run(v)

print(v_)

>капитан

Нет, мне было неочевидно. Спасибо ещё раз.

Да есть уже нвидиа, специально покупать железо ради любопытства не хочется. Насчёт облаков хз, почитал, вроде годнота, но ни телефона ни карты нет, если даже в телеграмм хуй зарегаешься с фейковыми, то там и подавно, думаю. А жаль, позать гугложелезо было бы прикольно.

>Нет.

Ты анонимус очень, или какие причины?

Сейчас без телефона же тяжело, ни родным позвонить, ни друзьям, ни скорую вызвать.

А если там учится пойдешь, то унрил просто. Хелл мод.

Купи телефончик то, и будет все хорошо.

>ни родным

> ни друзьям

Ну ты понял. Учиться да, вот как отучился, так три года на полке и пылится. Если бы нужен был, то не пылился бы. А так какой смысл покупать, если всё равно не будешь пользоваться? Не, не анонимус, просто хз, так вышло, короче.

>Ну ты понял. Учиться да, вот как отучился, так три года на полке и пылится. Если бы нужен был, то не пылился бы. А так какой смысл покупать, если всё равно не будешь пользоваться? Не, не анонимус, просто хз, так вышло, короче.

А ты не из Украины?

Ну, карточка стоит копейки, а тел утебя есть.

В Беларуси сижу, сам из РФ, за обслуживание с граждан РФ тут бешеные бабки, абонплата типа, короче не стоит того, ща вот разберусь, как модельки сохранять загружать и перед сном буду запускать, пусть себе обучается потихоньку.

Да и тел есть, а карты нет. есть, но я ещё номер карты в интернет не отправлял. не горю желанием как-то.

да, загоняешь свое окружение, гоняешь его. Но, конечно, не бесплатно, если много гонять, то своя тесла выйдет дешевле.

http://www.deeplearningbook.org/

http://www.cs.ucl.ac.uk/staff/d.barber/brml/

Годно или в шапке лучше?

Имея ввиду тот факт, что сначала идут исследования по работе мозга, съём показаний, от этого строятся определённые выводы, и только отталкиваясь от этих исследований уже строятся простейшие математические модели.

>Входной сигнал есть вектор.

>Он вумножается на матрицу весов.

Как там, вышло чего после пикрила? http://dkws.narod.ru/linux/etc/optical/cpu.html

> промоделированная работа простейших нейронных сетей максимально диссоциировавшись от математики

Ты поехавший. Пиздец.

>Имея ввиду тот факт, что сначала идут исследования по работе мозга, съём показаний, от этого строятся определённые выводы, и только отталкиваясь от этих исследований уже строятся простейшие математические модели.

Я не понимаю тебя.

Совсем.

Нейронные сети, в инф технологиях, имею такое же отношение к работе мозга, как реактивные двигатели в самолетах, к крыльям птицы.

Вроде что-то где-то пилят, но не особо афишируют.

>как реактивные двигатели в самолетах, к крыльям птицы

Прекрасно. Итак.

Ты привёл в пример птицу и самолёт.

В данном случае выполняющие одну и ту же задачу. Полёт из пункта а, в пункт б. Верно? Верно.

Отталкиваясь от этой информации, если учитывать тот факт, что исследования по работе мозга уже проводились и были выявлены основные закономерности по его работе, под какую именно задачу он лучше всего подходит? Выявлена ли эта задача? Не хуярят же программистишки с учёными чего-то там наобум, правильно?

Выводы которые сделаны на основе снятия показаний о работе мозга, сравнимы с выводами о том, что хуйня светится, сделанными бабушкой, увидевшей айфон.

Значит ли это, что все созданные модели нейронных сетей - никак не связаны с реальным положением дел в реальном мире?

с моей точки зрения любые современные нейронные сети лишь занимаются, ничем иным как, брутфорсом в подмножестве.

плюс у них есть кэш. вот и весь дизайн.

>

любый современный и модные алгоритмы, все основаны на брутфорсе, в них нет логики, они нюхают все зачуханные углы и находят что-то, что удовлетворяет искомому условию.

очевидно, мозг так не работает.

>Прекрасно. Итак.

>Ты привёл в пример птицу и самолёт.

>В данном случае выполняющие одну и ту же задачу. Полёт из пункта а, в пункт б. Верно? Верно.

Ты в военкомате был?

Там психиатр, задает вопросы "абитуриентам", чтобы выявить их годность.

Популярный вопрос - "Чем птица отличается от самолета?".

Если чел будет отвечать что-то вроде того, что ты написал, его пошлют скорее всего на обследование в психушку.

>Отталкиваясь от этой информации, если учитывать тот факт, что исследования по работе мозга уже проводились и были выявлены основные закономерности по его работе

Да не особо.

Вначале думали что оно вот так.

Потом оказалось что оно вот сяк.

Потом стали думать что оно вот этак.

А с новыми инструментами и теориями посмотрели, и охуели совсем.

Ты русским языком объясни, чего тебе надобно?

Ты лабу пишешь, или чего?

>под какую именно задачу он лучше всего подходит? Выявлена ли эта задача?

Лучше всего он подходит для управления человеческими тушками.

Но с математической точки зрения, если обобщить, то нелинейная оптимизация.

>Не хуярят же программистишки с учёными чего-то там наобум, правильно?

Wrong.

>>972458

>Поясните что именно читать

Из твоего сумбурного бреда, я так понимаю, тебя интересует КИБЕРНЕТИКА.

Вот по ней книжки и читай.

>Прекрасно. Итак.

>Ты привёл в пример птицу и самолёт.

>В данном случае выполняющие одну и ту же задачу. Полёт из пункта а, в пункт б. Верно? Верно.

Ты в военкомате был?

Там психиатр, задает вопросы "абитуриентам", чтобы выявить их годность.

Популярный вопрос - "Чем птица отличается от самолета?".

Если чел будет отвечать что-то вроде того, что ты написал, его пошлют скорее всего на обследование в психушку.

>Отталкиваясь от этой информации, если учитывать тот факт, что исследования по работе мозга уже проводились и были выявлены основные закономерности по его работе

Да не особо.

Вначале думали что оно вот так.

Потом оказалось что оно вот сяк.

Потом стали думать что оно вот этак.

А с новыми инструментами и теориями посмотрели, и охуели совсем.

Ты русским языком объясни, чего тебе надобно?

Ты лабу пишешь, или чего?

>под какую именно задачу он лучше всего подходит? Выявлена ли эта задача?

Лучше всего он подходит для управления человеческими тушками.

Но с математической точки зрения, если обобщить, то нелинейная оптимизация.

>Не хуярят же программистишки с учёными чего-то там наобум, правильно?

Wrong.

>>972458

>Поясните что именно читать

Из твоего сумбурного бреда, я так понимаю, тебя интересует КИБЕРНЕТИКА.

Вот по ней книжки и читай.

Блять, лол. Наслушаются баззвордов в ютабе своем, а потом на двощи лезут. Умора.

>>с моей точки зрения любые современные нейронные сети лишь занимаются, ничем иным как, брутфорсом в подмножестве.

в удобном для соискателя подмножестве.

fixed.

> Чем птица отличается от самолета?

птица живая, самолёт бесдушная груда металла

птица кушает насекомых, самолёт заправляют бензой

птица-самец + птица-самка = много птиц и птенцов, самолёт + самолёт = катастрофа и расчлёнёнка

птицы эволюционировали из птеродактилей, самолёты из велосипедов

птица умнее чем самолет. нужно начать с этого. Она сама может найти горючку и найти удобное, для прибывания, место.

а отправляются в летное путешествие они, абсолютно, по разным причинам.

>самолёт заправляют бензой

А я вот тут недавно подумал, что эрудиция для человека - это не пустая бесполезная хуйня, как заявляют некоторые. Ну я и раньше это знал, но без доказательств. А тут прослеживается полная аналогия с нейросетью (что неудивительно, человек и есть нейросеть).

На ограниченном наборе данных сеть может научиться выдавать правильное решение, но на незнакомых данных зафейлит. Чем больше датасет, тем лучше генерализация сети. "Узкая специализация" в образовании - это путь к деградации.

птица наследует от самолёта или самолёт наследует от птицы?

Наследование требуется только для повторного использования кода. Что может использовать самолет от птицы, или птица от самолета?

>бортовые компьютеры самолёта порвут любую птицу

Нет.

Они во первых, даже твой смартфон не порвут.

Во вторых ученый даже мозг червя пидора не могут победить.

Вычислительная мощность птицы, это что-то около пары небоскребов плотно забитых видеокартами.

>нихуя

Ну вот ты и сам ответил. Наследование ради наследования нинужно. Наследуй обоих от MovingObject и не еби моск

Прежде всего птица, по сравнению с самолетом это идеал воздухоплавания, она может распознать сотни ситуаций которые помешают ей продолжить путешествие, у нее есть зрение, слух, обоняние. Самолет же это большая груда метала и говна, которое может рухнуть в любой момент из-за того, что переменная переполнилась и стала нулем или отрицательным значением, так в добавок там еще кто-то должен сидеть, с более продвинутым мозгом, чем птица, чтобы это хотя бы начло двигаться.

> Вычислительная мощность птицы, это что-то около пары небоскребов плотно забитых видеокартами

птица даже 2 и 2 не сложит

самолёт 2 и 2 может сложить триллиарды раз в секунду

>птица даже 2 и 2 не сложит

Сложит.

>самолёт 2 и 2 может сложить триллиарды раз в секунду

Это не интегральный показатель вычислительных мощностей.

Мозг птицы оптимизирован не для символьной арифметики.

Видеокарта даже операцию условного перехода сделать не может, а CPU миллион раз в секунду такое провернуть может, и что?

Тебе лет сколько, технократ мамин?

> Сложит.

нет, она даже само понятие int не осилила

> Это не интегральный показатель вычислительных мощностей.

> Мозг птицы оптимизирован не для символьной арифметики.

птицы используют символьную тригонометрию для вычисления траектории полёта

> Видеокарта даже операцию условного перехода сделать не может

может, я видел if в CUDA коде кернелов

> Тебе лет сколько, технократ мамин?

https://www.youtube.com/watch?v=AfIOBLr1NDU

первую читаю сейчас, у меня с математикой плохо, математику было сложно оттуда понимать, а так ее хвалят, вторую не знаю

1. КПД.

2. Неопределенно.

3. Рассказал. Я использую при работе ленивые вычисления. Когда спросите конкретней тогда и попытаюсь ответить.

4. Вообще бывают.

5. Есть.

6. По массе одинаковы, но по плотности и тяжести на усредненной среднестатистической планете Земля по выборке зоны златоволоски кирпич тяжелее.

7. Ощущение пустоты бытия, бесконечности Вселенной, постоянные крутящиеся боли, плохое зрение и возникающие из-за этого зрительные иллюзии (видел улыбающегося еврея сделанного из куртки) и приятные запахи несоответствующие реальности.

8. Апеннинский полуостров, на сколько я понял.

9. Ракетных.

10. Пытался лечь ночью в сугроб и замерзнуть говоря с Богом.

Я, если что, вот тут их нашёл:

https://github.com/open-source-society/computer-science

Там ещё и курсы по математике есть.

Ты здоров, можешь идти.

годен к службе родине

https://www.coursera.org/learn/vvedenie-mashinnoe-obuchenie

3blue1brown

курс китаёзыз на курсере (не стоит того)

>постоянные крутящиеся боли, плохое зрение и возникающие из-за этого зрительные иллюзии

Рак мозга?

ничего

нейронки это говно

на машине тьюринга принципиально невозможно сделать ИИ

теперь дальше соси форс гуглопидаров

как остальные школьники из этого даунотреда

У старпера подгорело, лол. Чето блять заканчиваю 6 курс и ничего о чем ты говоришь у меня особо не было. А пивасик с друзьями попить всегда можно

>У старпера подгорело

>и ничего о чем ты говоришь у меня особо не было

Ну, конечно сожалею тебе, но, не горит от сего факта нисколько.

Ага блять, я в 25 лет брошу работу и пойду обратно на шею к родакам садиться, чтобы еще джва года в вузе просрать.

Кем работаешь?

Какую видеокарту и проц брать для домашних опытов?

Радеон, как я понял, не катит — нужна нвидиа. 1070 хватит? Или 1080 ощутимо лучше?

?

Пичаль. Что же мне корменом давиться только чтобы уметь переводить дискретную алгебру в матан?

Это почему же на машине Тьюринга нельзя сделать ИИ? Считаешь, что в мозгу есть много всяких квантовых эффектов и непонятных штук?

>Это почему же на машине Тьюринга нельзя сделать ИИ?

Потому что школьник на мейлру так сказал, очевидно же. Ты что, школьникам не веришь?

>Считаешь, что в мозгу есть много всяких квантовых эффектов и непонятных штук?

АТО! Вот взять счеты пикрелейтед. Они состоят из молекул, атомов, в конечном счете из квантов. Значит, это квантовый вычислитель. Шах и мат.