Вы видите копию треда, сохраненную 16 августа 2018 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Продолжаем выяснять, кто двигает ноуку: толпы смузихлёбов или фундаментальные деды.

FAQ:

Я ничего не понимаю, что делать? Либо в тупую import slesarflow as sf по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/ | https://www.general-ai-challenge.org/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Архивач:

http://arhivach.cf/thread/340653/

http://arhivach.cf/thread/355442/

http://arhivach.cf/thread/360889/

Там же можно найти треды 2016-2017 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

Предыдущий тред: >>1176320 (OP)

Как называются такие диалоговые системы? Как их тренируют или это не НС ?

>спич рекогнишен.

Я спрашиваю не про распознавание речи, а обработке текста и выдачи ответа.

> а обработке текста и выдачи ответа.

Маркетинговое говно, на нормальных вопросах оно засыпится. У ИБМ есть Ватсон, но про него тебе не расскажут.

Аноны, вы тут за новостями следите? Я веб-макака и мне интересно, кто-нибудь занимается нейронками для оптимизиации orm'ов, что бы они могли выдавать более эффективные запросы в базу

Упс, это не тебе ответ, а вопрос всему треду

Чет в голосяндру, хотя конечно это грустно.

А у людей она слыхала,

Что это зло еще не так большой руки:

Лишь надо применить нейронОчки.

Все модные нейронОчки себе она достала;

Вертит нейронОчки и так и сяк:

То тренирует их, то стопицот слоев нанижет,

То их в ансамбль соберет, а то полижет;

НейронОчки не действуют никак.

"Тьфу пропасть! — говорит она, — и тот дурак,

Кто на ютубе смотрит врак:

Всё про нейронОчки индусы мне налгали;

А проку на-волос нет в них".

Мартышка тут с досады и с печали

Делитом так хватила их,

Что только файлы засверкали.

Т.е проблематика создания, основные концепции разработки, история, инструменты, и тд

Потому что смешно что никакие хитровыебаные алгоритмы не смогут сравниться с масс датасетом.

Читай ватника лол. Хипстер тупорылый

Ну ты соня. Уже Искусственный Интеллект изобрели и наступила технологическая сингулярность.

Первый серьезный вопрос ИТТ, ура! Не знаю, я бы не расчитывал на это. Он вообще довольно наколенный.

>Matplotlib plotting can handle float32 and uint8, but image reading/writing for any format other than PNG is limited to uint8 data

Вообще, взял да и запустил для проверки сам.

> Т.е проблематика создания, основные концепции разработки, история, инструменты, и тд

Что угодно по теме когнитивистики

Само сабой

Тысяч тридцать где-то.

493 Кб, 1527x2160

493 Кб, 1527x2160В гугле результатов овердохуя, глаза разбегаются. В каком направлении лучше копнуть?

Watson еще более маркетинговое говно, на хакерньюз бывшее прогеры айбиэм говорили

> Что реального в машоб принесли исследования?

Все вообще. Весь машоб это результат исследований.

Маняматика это тупые бесполезные неработающие алгоритмы типа регрессии и СВМ.

Все более-менее приличное (случайные леса, баггинги, сеточки), изобрели нормальные люди. Придумать "Ну как кароч человек думает" или "Смешаем все подряд и заебись станет" долбоеб-задротик не мог, он обмазывается малосвязанными с действительностью гомотопиями/гомологиями/деткими рисуночками/любой другой хуйней.

Как же у них горит, наверное, что все их "доказанные" методы (доказательства которых занимает десяток страниц) ирл не стоят выделенного яйца.

>Весь машоб это результат исследований

Можно конкретный пример, что было исследовано (а не найдено методом тыка) со времен Розенблатта?

> неработающие алгоритмы типа регрессии и СВМ.

Дальше можно не читать тупня.

>>191464

> Можно конкретный пример, что было исследовано (а не найдено методом тыка) со времен Розенблатта?

SVM, да все статистическое обучение Вапника, включая бустинг. Сверточные сети созданы на основе зрительного анализатора кошки (Нобелевская премия Хьюбела и Визеля), вся нечёткая логика, все векторное квантование, да и все остальное, достаточно почитать пейперы, нигде не написано "тип я потыкал и нашел", такого почти нет. Ну разве что т н магический коэффициент в проекции Сэммона, это да, методом тыка обнаружили.

То есть свёрточная сеть настолько сильно радикально отличается от полносвязной, что нужно было исследовать кошку чтобы её открыть, а не просто играясь с полносвязками? Которые ещё давно придумали?

>Сверточные сети созданы на основе зрительного анализатора кошки

Пиздос наркоманы. И какой там у ней анализатор? Я вот про ос читал, как им мозг ебали и изменяли ландшафт, так ваши сети даже близко не стоят к тому, какой анализ проводит оса.

>Сверточные сети созданы на основе зрительного анализатора кошки

Во-первых, это нейрофизиологические исследования. Во-вторых, это открытие было сделано случайно, даже в википедии описано. В чем тут заслуга математиков? Ну придумали перцептрон, доказали сходимость - ок. Дальше чем они занимались, ждали, пока кошке башку распилят? Даже не попробовали добавить инвариантность к сдвигу? (из этого логически вытекает сверточная сеть).

>нигде не написано "тип я потыкал и нашел", такого почти нет.

Читаю пейперы по нейронкам, там точно так и написано.

https://github.com/fizyr/keras-retinanet

Можешь, только возьми их претренированную модель, и дотренируй на своем датасете.

> Во-первых, это нейрофизиологические исследования. Во-вторых, это открытие было сделано случайно, даже в википедии описано. В чем тут заслуга математиков?

В том, что создали математическую модель. Пиздец, каким надо быть деревянным, чтобы такие вопросы вообще задавать. Что вообще значит "случайное открытие"? Если над какой-то темой работали целенаправленно, то о какой случайности вообще может идти речь? Даже если получили результат, который не ожидали, причём тут случайность? Вот почти везде пишут, что Хофманн случайно LSD вымутил. Да с каких хуев-то случайно, он делал средство для остановки маточного кровотечения, он его и сделал. Диэтиламид он делал тоже не случайно, а по аналогии с диэтиламидом никотиновой кислоты, который эта контора, сандоз, выпускала массово. Даже то, что вещество оказалось 5ht2a-агонистом это не случайность, просто в те времена об этом ничего не знали. Но исследования на то и нужны, чтобы узнавать что-то новое.

>Придумать "Ну как кароч человек думает" или "Смешаем все подряд и заебись станет"

Так это "работает" в том же смысле в котором танцы с бубном "работают" для вызывания дождя.

31 Кб, 452x342

31 Кб, 452x342>Что вообще значит "случайное открытие"?

Они занимались какой-то хуйней, и обнаружили, что нейрон активируется на определенную часть изображения (наклонную линию). Каким надо быть деревянным, чтобы самому не додуматься до декомпозиции?

А судя по тому, что для функции активации сначала использовали сигмоид ("патамушта хуйзнаит так в нийроне"), а потом ReLU ("патамушта болие лучше"), о вменяемой математической модели говорить не приходится.

>случайно LSD вымутил.

Маня, не случайно, это когда ты сел за стол, прчесал репу и на основании известгых тебе фактов и правил скрафтил йобу, а когда ты примерно знаешь вектор и рендомно смешиваешь всякие йобы, то это случайно. И да, большинство открытий происходит случайно, потому, что так работает ноосфера и сознание, все ответы витают в воздухе.

>сигмоид ("патамушта хуйзнаит так в нийроне"), а потом ReLU ("патамушта болие лучше")

Всё правильно. Шах и мат, шизик.

Есть другие варианты? Ноосфера кстати менее безбашенное объяснение работы сознания. А вот манятеории матанопетушни, это да.

> Ноосфера кстати менее безбашенное объяснение работы сознания

Для безграмотного опуща, не слышавшего о работах даже Павлова, безусловно.

Почитай Кастанеду перед сном. Мы живём в непостижимом мире. И только ЧСВ мешает нам это принять и понять.

> ноосферы Вернандского

Как будто ты читал хотя бы Вернадского, деградант. Ты не поверишь, что он имел в виду под ноосферой.

А у него вообщем-то нету идей. Есть некие тезисы, но в большинстве случаев просто фактический пересказ событий.

Да я-то пойду, я ж в этой хуйне не шарю, но интересно же.

> Мать твою ебал.

Тебе твоя-то не даст, лол. Ты насмотрелся всяких первых каналов с такими же икспердами по газификации луж, и как и остальные дегенераты, считаешь, что Вернадский что-то за какую-то шизотерику пиздел. У тебя даже не хватило ума усомниться, как это было возможно для ученого при его жизни без того, чтобы при этом не перестать быть ученым? У меня вот хватило. Насчет Павлова - все проблемы нейрофизиологии (основы которой в ее нынешнем виде он и заложил), в том, что почти все маняученые часто отказываются от его подхода к изучению высшей нервной дейтельности. Он таких при жизни обоссывал в любой речи на любой конференции, но что один человек может против толп дегенератов. Даже сейчас находятся темные долбаебы, верующие что вся нервная деятельность не сводится к взаимодействию нейронов. Ты-то ладно, но такие и в науке есть.

Нет, невозможен. Все дело в том, что любые компьютерные программы все-равно выполняются на бездушной железке, в то время как мозги людей подключены невидимым коннектом к магической сфере знаний, т.н. ноосфере.

>Даже сейчас находятся темные долбаебы, верующие что вся нервная деятельность не сводится к взаимодействию нейронов.

А вот дохтора биологических наук оказываются темные долбоебы.

з.ы. почему ты такой ебаный грубиян, ты Шариков?

https://youtu.be/dAF9J-NejcY

> А вот дохтора биологических наук оказываются темные долбоебы.

Сплошь и рядом. Только таких при жизни Павлова на заседаниях академии наук хуесосили (читал пример в избранных трудах), а потом скатились. Эта баба поди и в боженьку верует, о чем тут говорить вообще.

>таких при жизни Павлова на заседаниях академии наук хуесосили

Тото я смотрю современная медицина пробила дно. Грип то лечить научились?

ИТТ вводится карантин. Режим омега-4. Воздержитесь от постинга в течение следующих 72 часов. Следите за дальнейшими указаниями.

> Тото я смотрю современная медицина пробила дно. Грип то лечить научились?

Какой грипп, какая медицина, маня? Разговор о нейрофизиологии, ферштейн, нихт? Портфель иди собирай.

157 Кб, 554x439

157 Кб, 554x439> с колёсами и рукой чтобы могла мне дрочить и пиво из холодильника носить?

Для современных хипстерских нейроночек нет строгих доказательств сходимости, например, функций Ляпунова, критерия Попова итд. Поэтому эту хуйню на производстве никто использовать не будет, ибо хуй её знает, что она выкинет. Так что смотри, если нейротянка тебе письку оторвет и бутылку с пивандрием в анус вставит, сам будешь виноват.

>нейрофизиологии

Ок, озвуч неебаца прорыв в этой области, на который ты тилибонькаешь, ну там сращивание нервов и все такое, глаз искусственный, таблетку от Альцгеймера

>при жизни Павлова на заседаниях академии наук хуесосили

Господин прав, в том что наука скатилась в ёбаное говно и засилие никчёмных учёных. Ну это началось ещё в 80-е годы паралельно с упадком левого движения. А в 60-х был расцвет, когда реально хуесосили всяких долбоёбов на научных конференциях и правильно делали. Но хусосили, с уважением, не скатываясь до матерных слов.

>нет строгих доказательств сходимости, например, функций Ляпунова, критерия Попова итд. Поэтому эту хуйню на производстве никто использовать не будет

Получается кто первее отменит эти маразматические стандарты из глубины веков тот и рванёт вперёд? Ну то что это точно будет не наш совок к гадалке не ходи.

>кто первее отменит эти маразматические стандарты

Там на кону репутация матанопетушни, им хоть в глаза ссы, непозволят

> Получается кто первее отменит эти маразматические стандарты из глубины веков тот и рванёт вперёд?

Это не маразматические стандарты. Негров распознавать и котиков под Пикассо рисовать этот одно, а если контроллер доменного процесса сожгет пол завода или поезд в метро со всей дури в тупиковую призму уедет с сотней жертв, это совсем другое. Отвечать за это не хочет никто. А гарантировать, что такого не будет можно только если есть доказательства устойчивости модели. Где-то даже читал, что это обязательно должно входить в пакет документации алгоритма для внедрение на производство.

>Отвечать за это не хочет никто.

Это еще в 70х обосали, на заре Экспертных Систем, я вот считаю, что ЭС и закопали специально, подсунув нейронные сети. Рептилоидам спокойно, поскольку тупик очивиден, но и иллюзию работоспособности тоже можно показать. А вот то, что например диагностическая медицина на ЭС могла развится с 70х, это да, человечество проебалось...

А вот гудфеллоу в начале диплёрнинг книжки своей пишет что хуёво эс работали. Пиздит, хипстер?

Основное преимущество ЭС в том, что каждую ошибку можно воспроизвести и пофиксить, нейронки в это не могут

> делаю фит несколько раз и получаю разные результаты в пределах едва ли не целого процента

Это норма для нейроночек.

model.fit(shuffle=False)?

360 Кб, 473x575

360 Кб, 473x575Идея правильная, но задача эта неподьемная в такой постановке.

Никто не выжил.

Объясните, пожалуйста. Что такое input_size?

Вот я строю плотную сеть. На входе два нейрона, скрытый слой из трёх нейронов, и на выходе один нейрон.

model = Sequential()

densein = Dense(2, input_shape = (2, 1))

densehide = Dense(3)

denseout = Dense(1)

model.add(densein)

model.add(densehide)

model.add(denseout)

компиляем

model.compile(optimizer='rmsprop', loss='binary_crossentropy')

потом я хочу чтобы сеть получала массив из двух элементов и выдавала мне одно значение.

собираю банч на вход в сеть.

array = np.array([8, 4])

предикчю

result = model.predict(array)

И эта сука выдаёт мне такую хуйю:

Error when checking : expected dense_13_input to have 3 dimensions, but got array with shape (2, 1)

Какова хуя, когда в документации для Dense сказано:

The most common situation would be a 2D input with shape (batch_size, input_dim).

То есть батч сайз у меня 2, а input_dimension каждого семпла в батче 1!

Обьясни мне, дорогой, анон. что такое input_dim. И прав ли я что размер моего батча 2?

Вся надежда только на тебя, дорогой, мой милый анончик.

Короче я понял блять. Спасибо что помогли. В input_shape = (2, 1) мы вводим шейп нашего семпла. Какого хуя у Кераса такая кривая документация? Не понятно нихуя, пидоры.

Посоветуйте как вкатиться?

У само 2 года опыта в вебе пайтон и немного шарю С++.

В универе пердолился с ним, но времени четко заботать не было.

Любой курс на курсере. От стэнфорда или Яндекса.

Тащемата ничего сложного в этом нет. У тебя есть Питон. У питона есть куча инструментов, которые перегоняют битмапы в нампи. Перегоняй битмапы и прогоняй по сеточкам.

Вспомнил, погуглив.

>Choose a set of "feature" words that will be included in your vector. This should exclude extremely common words (aka "stopwords") like "the", "a", etc.

Тебе дадут ленту по которой едет картошка. Тебе надо приделать сверху него камеру и тречить картошку и запоминать на какой секунде едет бракованный корнеплод.

129 Кб, 620x466

129 Кб, 620x466>А сам то где работаешь?

Департамент ИИ и Компьютерного Зрения в Крошке-Картошке. Старший Научный Сотрудник.

Понятно. А я думал ты в мдк работаешь над рекурентными нейронками для генерации текстов своих пиздатых шуток.

n [7]: model = Sequential()

...: densein = Dense(2, input_shape = (2,))

...: densehide = Dense(3)

...: denseout = Dense(1)

...: model.add(densein)

...: model.add(densehide)

...: model.add(denseout)

In [8]: model.compile(optimizer='rmsprop', loss='binary_crossentropy')

То есть как я понимаю, сеть сейчас состоит из 6 нейронов. Два на входе, 3 в скрытом слое и один на выходе. То есть должно быть 9 весов. Но когда я прошу у модели веса:

In [18]: weights = model.get_weights()

In [20]: len(weights)

Out[20]: 6

Она отдаёт мне что их всего блять 6 КАРЛ

Где я проебался? ЧЯДНТ?

Картошечку детектишь?

А, то есть не каждый вес. Последний размерностью (3,1). Дело начинает проясняться.

Ты бы хоть попытался осмыслить, что ты вообще делаешь. Я не знаю, схему бы в пейнте нарисовал, прикинул бы что, как и зачем оно вообще делает.

908 Кб, 811x687

908 Кб, 811x687Ну, во первых, я изначально и нарисовал схему. Хочу чтобы из двух значений сетка мне лепило одно.

Вот есть у меня набор картинок 20x20 пикселей с изображением цифры два, например, черно-белые. Мне нужно натренировать сеть для их распознавания. Я делаю из картинок матрицы с нулями и единицами, подаю на вход обычному перцептрону. Теперь мне нужно аппроксимировать решение уравнения

Σ (от 1 до 400) wi * xi + b = 2?

Переобучение. Классификация вырождается в идентификацию. Значения обучающей выборки становятся единственным, что сеть принимает.

https://brohrer.github.io/blog.html

Там есть видево

63 Кб, 221x272

63 Кб, 221x272> Наткнулся на зашибенного чувака.

>эталонный хипстер из палаты мер и весов.

Почему я не удивлен?..

Ну какой же это хипстер. Это няша.

241 Кб, 400x310

241 Кб, 400x310>поехавшие и петросяны

>любители хипсторов

>секта вапника

>секта хейторов математики

>нюфани, которые не могут осилить документацию

131 Кб, 419x569

131 Кб, 419x569>поехавшие и петросяны

>любители хипсторов

>секта вапника

>секта хейторов математики

>нюфани,

А ты один весь в белом, да? Сам-то чьих будешь?

У тебя есть девушка? Оставь свою почту, няш.

Хватит ныть, скоро будешь в гулаге на кластере из краденных телефонов считать свои загнивающие западные нейронки.

Не буду я живу в процветающей Беларуси

Тогда ты перекатываешься туда куда нужно. Так как здесь опыт макакства сослужит тебе прекрасную службу.

104 Кб, 1112x549

104 Кб, 1112x549Да.

``

import numpy as np

import matplotlib.pyplot as plt

A = np.random.rand(28,28,4)

plt.imshow(A);plt.show()

``

В imshow подают числа из отреза [0,1]

Спасибо ананас. Макака благодарна тебе.

ты думашь шутки про негров и обезьян это просто так?

Я по причине нейросетей уже боюсь искать в гугле по картинке.

И тут я проснулся

http://cs231n.github.io/convolutional-networks/

Если я её прочитаю я превращусь из неосилятора в помидора машоб-боярена?

Накидайте литературы/курсов по математическим дисциплинам, чтобы был хороший бэкграунд для вкатывания.

Да

Можно, конечно))) но осторожно :D

Дело в том, что при переносе может произойти туннелирование квантовых векторов по принципу ватника-червячникуса, что приведет к неизбежному образованию канцероподобных тел в головных нейронах субъекта производящего перенос, что не есть хорошо

90 Кб, 862x543

90 Кб, 862x543Возьми любую веб-камеру с улицы, и будут тебе номера - и с грязью, и со шторками, и с прочими пидорахинскими приблудами

Дак эта уже не сложно. Яб сделал две нейронки. Одной посылаешь хай контраст номер, где капли изведены до точек, а второй нормальный в случае если номер чистый. Гораздо серъезней проблема если номер сфотографирован под уголом. тут повидимому понадобится серъезный препроцессинг изображение с тем чтобы номер задисторить до состояния плоскодонки.

По поводу самой распознавалке, думаю по классике в финале вываодится на 33 + 10 полносвязку с размерностью (2,), где первое значение номер символа, а втооое его индекс от начала.

Что происходит на гифке? Напомнило историю из детсва, когда одна собака стояла поперек другой и когда первая шагала, вторая шагала за ней. Я сначала подумал, что они прилипли друг к другу.

Оказалось, что это они так "неловко" сношались.

почти как в твоем детстве

В том то и дело, что не хочется так, потому что препроцессинг нужен, а потом ввод значения для обучения. Я же вот думаю, может сделать детектирование символов, как это было с табличкой? Правда разметка займет уйму времени, потому что минимум, думаю, 10к картинок надо будет разметить. А на это месяц уйдет.

я думаю в пропооцессинге ничего сложного нет. Должны быть на питоне либы которым посылаешь битмап и 4 координаты, а она отдает выровненную картинку. Не очень понимаю что ты имеешь ввиду под табличками. Есть какой либо пример?

>ты имеешь ввиду под табличками.

Номер машины на табличке нарисован же. Вот как размечал таблички, так размечать символы. Тогда можно будет распознавать не только 6-тизначные номера но если обучать дальше и набрать больше табличек, можно будет обучить и европейским номерам.

Блять для меня табличка эта таблица типа Ексель, теперь я понял что под табличкой ты подразумеваешь саму досточку на которой напечатан номер.

Посоветуйте что почитать на русском языке про мл.

> превосходный математический бекграунд

> опыт промышленной разработки

> на русском языке

Читай шапку и учи английский, макака.

73 Кб, 512x512

73 Кб, 512x512AI

Blockchain

Anime

When GAN meets Ethereum, we meet Crypko --- the next generation cryptocollectible game.

63 Кб, 823x937

63 Кб, 823x937> Я не хочу учить английский, твари.

В 21 веке не могущий читать на английском то, что ему интересно - неграмотен. Это факт. В любой современной науке / области знаний нехуй делать без знания английского. Вот даже с таким слесарством и второкультурным явлением как машобчик ты соснул, ибо на русском по теме нет нихуя интересного. И везде так же. Так что либо учи человеческий, либо сасай кудасай.

Зато я ебал твою мамашу.

Дуолинго пройди, тебя там как нейроночку обучают. Хотя, возможно, для технического есть методы попроще.

"Academic vocabulary in use". Вообще, со знанием предмета довольно легко читать, если у тебя хотя бы B1.

Нет, не один. Допустим, мне нужно активацию только на салатовом, как один слой с линейной функцией мне это даст?

> В любой современной науке / области знаний нехуй делать без знания английского

Слишком утрированно, 99,9% англовысеров семантический шум

> Слишком утрированно, 99,9% англовысеров семантический шум

Хуйню несешь. Английский де-факто официальный международный язык науки. Зная его, ты можешь не только читать о последних достижениях, но и общаться с исследователями. Похуй, чех это, голландец, француз или азиат, на английском ты с ним всегда пообщаешься. А на русском только эта подмывальня да алкаши у подъезда.

>Зная его, ты можешь не только читать о последних достижениях, но и общаться с исследователями.

Это не журнал Наука и Жизнь где печатались ноухау советских ученных, это говно написанное, поскольку пиндоховской ученой петушне в обязаловку нужно публиковаться. Если это работоспособно и охуенно, оно не публикуется, а закрывается патентами и стрижется бабло. Опровергни.

> Если это работоспособно и охуенно, оно не публикуется, а закрывается патентами и стрижется бабло. Опровергни.

Да весь машоб опровержение твоих фантазий. Покажи мне закрытые патентами ML проекты, на которых стрижется бабло.

Друг мой, прочитай про лицензии хотя бы немножк. Что бы что-то закрыть патентом надо обязательно это опубликовать. В общев в АЙТИ хуета не работает. Ты внатуре Лахта какая-то. Без обид. Все мы тут Лахты.

Да.

>В общев в АЙТИ хуета не работает.

Что не работает? Публикация в общих чертах, без открытия техдеталей и приправленная пиздежом, этого достаточно. Для патента никакие публикаций не нужны.

Ты Лахта, смирись с этим. Найди работу за бугром, поживи там маленько, и поймёшь какой каменный век у нас тут.

Кун Что бы что-то закрыть патентом надо обязательно это опубликовать.

Тянки с вконтача ответ.

> Что значит маленькая буква i под сигмой?

Суммирование по всем i. Выше же постили йобаматематику для машоба, там наглядно нарисовано.

Индекс Суммирования.

Подразумевается что w и x имеют одинаковые размеры, и их можно не указывать (Долго печатать, не важно и т. д.)

71 Кб, 600x799

71 Кб, 600x799Да.

75 Кб, 640x640

75 Кб, 640x640Божественный вопрос, ничего не скажешь.

На вскидку:

1. Scaling, Crop'ы. и прочая

2. Обрабатывать как есть и потом декодировать RNN-кой или механизмом внимания.

Спасибо, ты меня убедил, я вся твоя.

Я сейчас там частицы тречу в коллайдерах.

чет хуйня какая то по nlp, автономус вехиклс ваще нет, или там одна хипстота?

Давай, только я ничё не умею и с некроноутом сижу

Пизда короче. Эта задача известна как 15-я проблема Ватника. Сможешь решить - получишь миллион порций смузи и гироскутер от всемирной ассоциации искусственного интеллекта

В принципе, она элементарно решается двунаправленными картами Кохонена. Но я хочу что-то менее экзотическое, желательно вообще элементарное - регрессию там, минимальные квадраты.

У нас на работе используют Unreal Engine для тестировантия нашей реализации SLAM. Но это больше работа для content artists, а не для программистов.

А я и не хочу, нахуй таким говном заниматься?

Не помню, на русском или английском она была.

А все, нашёл, это про adversial examples.

А не, не опечатка же.

Да, у нас внезапно наняли левел дизойнера как раз для этих целей, потому что с реальными данными гемор из-за юристов ебаных.

мимо работаю в компании-производителе дверных звонков

tl;dr: какую архитектуру глубокой нейронной сети выбрать для распознавания людей?

В общем есть две взаимосвязанные задачи. Существует система, которая высирает видео с камеры. На этом видео нужно распознавать людей. В самой системе можно включить детекцию объектов по движению (1-й вариант работы), но нужно классифицировать объекты, является ли объект человеком. То есть сделать классификатор на нейронной сети, который будет поглощать вот эти обрезки по рамкам объектов и говорить про класс объекта с доверительностью. Тут обрезки эти могут получаться в низком разрешении.

Если детекцию в системе не включать, то в классификатор будет отправляться весь кадр в нормальном разрешении. Это второй вариант работы. Тут соответственно тоже нужно распознавать людей.

И вот нужно взять на выбор несколько архитектур, посмотреть как оно пойдет. Сейчас присматриваюсь и тестирую YOLO, пока вроде нормально, но интересны и другие варианты.

Вопрос заключается в том, какие архитектуры предпочтительнее выбрать для каждого из вариантов работы системы?

Пытался курить следующие статьи:

https://arxiv.org/pdf/1611.10012.pdf

https://arxiv.org/pdf/1803.09386.pdf

Но что-то оно плохо курится.

В любом случае буду благодарен за любые советы.

Работай с йолой, остальное нинужно.

> Покажи мне закрытые патентами ML проекты, на которых стрижется бабло.

Любой адекватный алгоритм ранжирования поисковой выдачи.

Любой адекватный финансовый скоринг.

Любая сота в прогнозировании временных рядов.

Не то чтоб обмазанное патентами, но вполне себе закрытое.

мимо-проходил

Это не отменяет того, что не знать английского и пытаться что-то поймать с передка науки это нонсенс. Сейчас на норм факультете не знающего английский из магистратуры погонят ссаными тряпками.

>Любой адекватный алгоритм ранжирования поисковой выдачи.

Ну компании типа гугла могут держать большие R&D и что-то придумывать принципиально новое и держать это закрытым. Тут примерно верю, хотя уверен, что общие принципы (и конкретные алгоритмы) хорошо известны.

>Любой адекватный финансовый скоринг.

Что ты имеешь в виду? Подбор весов и слагаемых в известный алгоритм, который считает одно, блять, число?

>Любая сота в прогнозировании временных рядов.

Тут сложнее, хуй знает. Мне кажется тут вопрос только в хорошем знании предметной области за временным рядом и подбор метода и параметров под это знание.

Кароче звучит так будто принципиальные схемы хорошо известны/публикуются, а в секрете держат только конкретный код и свободные параметры.

> Любой адекватный алгоритм ранжирования поисковой выдачи.

> Любой адекватный финансовый скоринг.

> Любая сота в прогнозировании временных рядов.

Хотя бы по одному примеру приведешь?

Откуда в России норм факультеты?

83 Кб, 977x1024

83 Кб, 977x1024>Напоминание ньюфагам: персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Блин а я думал, что-то понимаю в нейросетях. А как же сети петри, всякие многослойки с каким-то градиентным вычислением весовых коэффицентов? Это тоже все для школьников или используется в серьезных задачах?

Мимо хиккан 26 лвл, когда-то проходивший курс по искусственному интеллекту на инженерной специальности.

> Блин а я думал, что-то понимаю в нейросетях. А как же сети петри, всякие многослойки с каким-то градиентным вычислением весовых коэффицентов? Это тоже все для школьников или используется в серьезных задачах?

Что ты этих латентных сойбоев слушаешь? Вон, постом выше задача, вроде все просто аки 3 копейки, а кроме некоторых разновидностей карт Кохонена и применить нечего. Мусор середины прошлого века не нужон, говорили они, диплернинх все порешает, говорили они...

> Это добавили, потому что постоянно закатываются унтерменши из шараг, которые пытаются навертеть миллиарды линейных слоёв, а потом воют, что нихуя не работает.

Написал хуйню и рад. Как это связано с хуетой в оп-хуй посте про перцептроны?

ну если учитывать, что ОКР для какого нибудь деванагари это нерешаемый пиздец, то да

Поставить себе цель написать нейроночку, симулирующую работу реального психотерапевта.

Напиши нейроночку, оценивающую шансы на смерть после приема определенной дозы каког-нибудь вещества. И тренируй ее, собирая данные на себе.

120 Кб, 1280x1707

120 Кб, 1280x1707Как же мне не хватает статической типизации и нормального дебаггера для tf...

У numpy и scipy одинаковый формат, opencv это некролиба, а в размерах тензоров путаются только нубские лалки. В остальном рад за тебя.

Если их задают, значит отвечать на них смысленно. Не все разбираются в тонкостях. А подбор архитектуры так и не регламентирован.

Почему?

Расскажи, как в методе ближайшего соседа kNN находится/выбирается k? И какова общая суть этого метода?

Подготовка к ПхД 3-5 лет по "всем учебным материалам", либо получение магистра по специальности, ПхД 5 лет, 1-2 постдока 3-5 лет. Теперь можешь подаваться в Гугл Брейн, или если сильно повезет то в Дипмайнд, на исследовательские позиции. Все остальное это унылый макакинг, чистка данных, подготовка инфраструктуры для господ исследователей.

Гугл это топ1 в мире по нейроночкам, если что. Там работают только суперзвезды, производя статьи пачками. Они гребут как на галерах и получают миллионы. На топовых нейроконференциях сотни статей оттуда каждый год. Этот вопрос равносилен "сколько требуется времени чтобы поехать в Голливуд сниматься в главных ролях в самых высокобюджетных фильмах?" Только в Голливуд попасть попроще чем в Гугл.

353 Кб, 700x393

353 Кб, 700x393>Гугл это топ1 в мире по нейроночкам

Прям вижу как их гугломобиль отсасывает у гаражных васянов.

37 Кб, 866x211

37 Кб, 866x211На реддите обсуждали, поищи по старым темам.

Людям, работающим над differentiable neural computer, и дела нет до автомобилей и прочей инженерной мути. И естественно, кузьмичи во многих вещах могут превзойти гигакорпорацию с десятками тысяч сотрудников, это вообще ни к селу ни к городу. Рынок они никогда у гугла не заберут, предел их мечтаний это продать свои наработки подороже. Гугл только выигрывает от этого.

Толко у меня всё равно слетает загрузка видосов с ютуба при перемещении на более раннюю точку видео. Что скажешь на это, гугл? Алсо гугл реально нихуя не сделал кроме инкубирования технологических решений и криков на весь мир, что он всемогущь.

>прочей инженерной мути

ах ну да, автономус вехикалс это же говно, вот бибизяна vs негр на пикче это огого, эгеге

26 Кб, 644x800

26 Кб, 644x800> ах ну да, автономус вехикалс это же говно,

Вот нейроночки для этого точно говно, т.к нет строгих доказательств их устойчивости. Я думаю, что и никогда не будет, ибо сойбои не осилят для всей этой ебалы сделать хотя бы функцию Ляпунова. А без этого не будет никакого внедрения, т.к нет желающих отвечать за последствия, если этот автономус вехикал кого-нибудь размажет по пешеходному переходу.

138 Кб, 1393x426

138 Кб, 1393x426>если этот автономус вехикал кого-нибудь размажет по пешеходному переходу

Уже куча трупов в США. Но юристы автопроизводителей похоже оценили жизнь пешеблядей в 2 цента и будут сбивать их пачками. До момента пока не собьют селебрити. А там зомбоящик промоет мозги муриканцам и эти авто запретят нахуй.

>А без этого не будет никакого внедрения,

Недавно новость была, убер сбил тян, приняв её за мусор.

>>201234

> Недавно новость была, убер сбил тян, приняв её за мусор.

В хиджабе была штоле?

>system software classified the pedestrian as an unknown object, as a vehicle, and then as a bicycle

Нейроночка соснула на частично освещенном объекте, какая неожиданность! (нет)

>According to Uber, emergency braking maneuvers are not enabled while the vehicle is under computer control

Нахер она тогда нужна без тормозов?

>что нельзя внедрять алгоритмы без доказательств их устойчивости

Внедряют то, что модно и молодежно, а не эти ваши устойчивости

> Внедряют то, что модно и молодежно, а не эти ваши устойчивости

Куколды одни и внедряют. Им-то хуле, от одного бабаха на грузовике или чёрной бабы (проектировавшей рухнувший мост без технического образования) пропагандирующей что математика - это инструмент угнетения белыми мразями негров, ущерба больше чем от всех нейроночек на убере. А вот у людей все иначе. В Японии когда делали автоматический поезд метро на нечетких контроллерах, с 1978 по 87 годы одних испытаний в реальных условиях было больше 3000, не считая всего остального. То, что теоретически все было строго обосновано, я вообще не говорю, это само собой разумеется.

>математика

Нахуй она нужна при строительстве моста?

>Японии

Хуевый пример, пездоглазы технологическое дно.

Если у тебя начались каникулы, это не значит что ты можешь гадить в интернетах, иди делай домашку на лето.

Да, ошибка из которой сделали выводы. Пездоглазы же ничего не сделают.

>А без этого не будет никакого внедрения, т.к нет желающих отвечать за последствия, если этот автономус вехикал кого-нибудь размажет по пешеходному переходу.

>>201205

>Так вроде уже

>>201234

>Недавно новость была, убер сбил тян, приняв её за мусор.

1. Нейронные сети, если в каком-то виде и присутствую в кибернетическим автотопозках, то за принятие решений не отвечают 100%.

2. Нейронные сети таких дурацких ошибок как тот убер не делают.

3. С помощью нейронки можно сделать некий алгоритм, и постфактум мдоказать все что угодно. Подкрутив руками если нужно параметры.

Или наоборот, взять готовый алгоритм, и докрутить ему нейронкой оптимальные параметры.

Вентцель, "Теория вероятностей"

>нельзя внедрять алгоритмы без доказательств их устойчивости

Может гугл поэтому и не пустил в массовое производство что-то подобное, а всяким уберам похуй.

https://habr.com/post/225095/

18 Кб, 246x246

18 Кб, 246x246>нельзя внедрять алгоритмы без доказательств их устойчивости

Людей же внедряют, а для них тоже нет никаких доказательств устойчивости

Я похоже не совсем правильно понял принцип поиска оптимального хода. Т.е. уже на моменте обучения(игры меду двумя ботами) уже как-то надо использовать дерево, а я только и делаю что хожу рандомно и увеличиваю счетчики при выиграшном результате.

Это понятно, но я сейчас другое проверяю же. Можно и перебором делать.

Что ты обучаешь? В МКТС ничего не обучается, это просто алгоритм игры, вроде альфа-бета поиска. Или ты с АльфаГо/АльфаЗеро перепутал?

Алгоритм поиска оптимальных ходов, тогда уже, если для игры рассматривать. Когда мы настраиваем НС, то там тоже идет поиск оптимума.

>Демидович

>для машинки

Лол. Это слишком жирно. Макака разочаруется ещё, что его макакство настолько лёгкое по сравнению даже с математикой 19-го века.

Что может быть сложного в конкретно изложенных примерах, если нет необходимости воссоздавать алгоритм?

Я не говорю, что Демидович сложен, я говорю, что там уровень выше. Не говоря уже о том, что он вообще слабое отношение к машобу имеет

>Что может быть сложного

Некоторым банально сложно привыкнуть к матану, не хватает усидчивости или сообразительности.

Демидович - это же залупа на угадывание, не? Весь челлендж - придумать хитровыебанное преобразование, которое сведёт пример к одному из каноничных типов

Ну да. Там есть задачи, которые сводятся к предыдущим задачам из него же. Он чисто на выдрочку матана направлен. Когда в универе решаешь сам, потом очень долгое время тебя хуй удивишь чем-то этаким на практике.

Первая аксиома программирования

Хз, мне как раз из-за этого не вкатило. То ли я дурак, то ли фантазия не в ту сторону работает, но помнить наизусть все преобразования из тригонометрии, разложения рядов и ещё какую-только угодно залупу только для прорешивания задач мне не вкатило. Я семестр попердолился с ним, а потом на решебники перешёл.

>Не говоря уже о том, что он вообще слабое отношение к машобу имеет

В смысле? Там есть много значков суммы и интеграла.

>3. С помощью нейронки можно сделать некий алгоритм, и постфактум мдоказать все что угодно. Подкрутив руками если нужно параметры.

>Или наоборот, взять готовый алгоритм, и докрутить ему нейронкой оптимальные параметры.

Начнём с того, что ты не понимаешь смысла слова "доказать".

Как? Как, блять, эта ебола работает? Как найти градиент? Из чего? Является ли пространство размерностью колличества измерений выходного вектора скалярным пространством градиента? Пожалуйста помогите.

Курсы MIT - ок, 3blue1brown хороший канал, но хз как в плане обучения чему-либо. Индус на втором месяце - странный выбор, видел пару его роликов, не сказал бы, что он прям охуенен для новичков. 3 месяц - нахуй, читай шапку.

Как скажешь, дарагой! Медитацию попробуй.

Про машоб не знаю, но смотрел несколько видео из курса Ына по диплёрнингу - по-моему, доходчиво объясняет.

22 Кб, 528x151

22 Кб, 528x151Вопрос по SDL 2. Юзаю Eclipse IDE с Mingw для крестов, но это не важно.

Крч, в SDL 1,2 можно было засунуть файлик динамической либы в папку сисвов64 и можно забить хуй, спокойно запуская приложения после билда, а не засовывать длл в каждый проект.

Я решил так же сделать с 2й версией SDL, но у меня вылезает пикрелейтед. Я чёт подустал и залипаю с шаманством, и мне интересно, ЧЯДНТ? Мне хочется по старинке. Есть предположение, что я юзаю 32битные либы SDL и засунул SDL2.dll в папку SysWoW64. То есть мне нужно или закидывать просто в system32 или менять разрядность либ, как я понял.

Вообще, поясните за необходимость юзания 32 и 64 битных либ. Есть какие-то нюансы, что юзают и на что идёт приоритет в разработках? Или можно забить хуй и спокойно юзать 64 битные?

В tf попробуй сделать.

Чем тебя не устраивает объяснение на педивикии? Один из простейших методов для поиска минимума, его студентам на 1-2 курсах дают.

Мне это все говорят, но это не правда. Я попросил объяснить. Наверное, надо было добавить что простым языком.

>Начнём с того, что ты не понимаешь смысла слова "доказать".

Какие еще интимные подробности моей жизни известны школьному телепату?

В чём смысл твоих высказываний? А если, например, нужно для тренировки своих навыков такое писать?

Просто охуенно идет, готовься.

> этот вопрос не всегда сводится к регрессии.

Всегда сводится, солнышко. Вот только вы тута настолько дремучие деграданты, что не зная самых азов лезете пердолить слои в керас. Проблема только в построении адекватного задаче датасета. Даже семантику текстов можно свести к линейной алгебре и в итоге к регрессии, что было показано Миколовым в виде т.н. лингвистических регулярностей.

Зато я ебал твою мамашу.

Каким образом? Для этого необходимо найти градиент. Но как можно найти градиент, если неизвестно где ошибка убывает?

Ну ты када ошибку посчитал - вычисляешь веса, чтобы ошибка ноль была, потом вычитаешь эти веса из текущих - получается градиент. Делаешь так много раз - градиент накапливается.

А ты вообще понимаешь, что такое "градиент"? Не в машобчике, а вообще в принципе?

20 Кб, 529x478

20 Кб, 529x478Тебя в детстве препод матана циркулем через Демидовича изнасиловал? Зачем ты так рвёшься каждый тред при любом упоминании математики?

И интересно, ты один, или вас несколько.

>А какое заклинание чтобы веса правильные получались?

Ну там есть какая-то умная формула, но на практике на нее забили хуй и считают упрощенно:

градиент=вход*ошибка

Я правильно понимаю, что, когда его усредняют (для тысячи обучающих примеров например), то, усредняют именно дельты весов?

Ну то есть вот матрица, с усредненным градиентом, она равна матрице весов? И так для каждого слоя?

Усредняют градиенты одного батча, умножают на learning rate, и прибавляют к весам.

>Усредняют градиенты одного батча, умножают на learning rate, и прибавляют к весам.

Градиенты имеют ту же размерность что и веса?

То есть, нужно в 2раза больше памяти, и для весов, и для градиентов?

Так и педагогов нет, если подумать. Я даже не уверен, есть ли такая специальность как педагогика для ВУЗов.

>Градиенты имеют ту же размерность что и веса?

да

>нужно в 2 раза больше памяти

лол, хочешь свой фреймворк написать для нейроночек?

Подожжи. Градиенты имеют ту же размерность, что и веса одного нейрона или весь тензор весов всех нейронов?

Может, у него АМуДе и Винда. Я тоже думал такое написать, да чот лень.

Ты же понимаешь, что это ну совсем не годится? Помимо того есть и другие формулы вычисления, гораздо более точные, чем просто ошибку со входом перемножить. Это же не только статистику убивает, но и весь функционал по пизде пойдёт.

83 Кб, 852x1200

83 Кб, 852x1200>Тогда ещё больше непонятно как его вычислить.

https://ru.m.wikipedia.org/wiki/Дельта-правило

Наркоман.

>есть и другие формулы вычисления, гораздо более точные

Ты поумничать решил, или что? Считай тогда по своим охуенным формулам, а нормальные люди считают как я описал

102 Кб, 743x1075

102 Кб, 743x1075>CUDA

И причем тут C++?

И в чем отличие от OpenCL?

>AMP

И в чем отличие от OpenCL?

Кроме того, что это виндовс онли микрописька? Да еще протухшая 10 раз.

Ты потроллить решил?

>причем тут C++

Потому что с её помощью можно писать на плюсах?

>в чем отличие от OpenCL?

Нет проёбов вроде того, как когда опенсиэль при встрече со сферическим объектом работает медленнее CPU. Нормально оптимизировано. Родная для невидии.

>протухшая 10 раз

Если АМП протухла 10 раз, то сколько раз уже протухла опенсиэль? В твоём фреймворке на древних иероглифах поди адаптивности для неподходящих под видеокарту команд нету?

>C++ AMP

А на нём кто-то пишет? По бенчмаркам он вроде хуже OpenCL и CUDA был, да и люди начали носами воротить, мол, говно какое-то, как будто для APU сделано.

60 Кб, 500x271

60 Кб, 500x271>Потому что с её помощью можно писать на плюсах?

Что ты несешь?

В куде свой сиподобный язык, как и в OpenCL

С++ причем? Зачем он?

В чем именно ты противопоставляешь C++ и OpenCL?

Ты понимаешь что C++ это ЯП, а OpenCL CUDA - это API?

>то сколько раз уже протухла опенсиэль?

Stable release

2.2-7 / May 12, 2018; 20 days ago

>В твоём фреймворке на древних иероглифах поди адаптивности для неподходящих под видеокарту команд нету?

Что сказать то хотел, юродивый?

Там навигация по аскелерометру+камере, без предолингов с BLE/Wi-Fi и магнетометрами

Я хочу в робототехнику, ИИ, вот это вот всё, но не знаю как подступиться. Местные клубы тупо склеивают китайские запчасти и копипастят питонокод. Я решил такую вот йобу попытаться сделать. Сначала чутка обосрался, потому что Xamarin - какое-то говнище ебаное, поэтому пришлось перекатиться на десктопный прототип, который пока будет работать по записанным данным. А тут ещё шарага проебала сроки оплаты и матлаб отвалился.

>стандарт инженерный

А кафедра математического моделирования. Обычно узкоспециализированные темы прокатывают, если у тебя какой-нибудь йоба-профессор из местного отделения РАН, но тут таким не занимаются, пришлось из молодых-шутливых аспирантов рецензента искать, лол.

>Либо дуй в топ вуз спб/мск, либо в европку

На европку я бы ещё собрал шекелей для магистратуру, но изначально в топ вуз я бы хуй поступил - в математике тупенький, олимпиады не задрачивал никогда.

Закончили колледж и сразу идут учить математике.

>тупенький

Ты уверен? Калман это не особо простая штука. Насколько помню, там и диффуры с устойчивостью знать надо, и в теорвере разбираться. Если ты, конечно, правда разобрался.

>олимпиады

Не нужны. В том же СПбГУ, если правильно помню, на матмехе есть кафедра кибернетики, а на примате - теории управления. Знакомые и без олимпиад поступали, 250-260 баллов, потом всегда можно перевестись на более крутое направление, сдав разницу тем более кафедра не зависит от направления обычно.

>не особо простая штука

Хз, всё в той же работе из курса по Cognitive Science у MIT довольно просто объяснено. Там он конечно примитивный - том плане, что ориентиры рассматриваются по одному и до внесения новых в вектор состояния, но для начала - почему бы и нет?

>250-260

хехмда, у меня 181, если математика-русский-информатика и 193 если математика-русский-английский, так что я в любом случае в пролёте.

> матлаб

Сам виноват что подсел на проприетарщину. Стандарт в области это питон или R, будущее может быть за джулией.

>>204728

Есть куча стипендий, тем более для магистратуры. Университетские или из частных фондов (особенно если ты тян и пытаешься в STEM, тогда тебя ими просто завалят), если у тебя хорошие оценки, проекты и всякие участия в хакатонах от разных фирм (за лето вполне реально набить на десяток строк резюме) то с этим проблем не будет. Если проблемы будут, после поступления можно сказать что ты из нищей страны и тебе сделают скидку вплоть до полной суммы обучения. Всегда есть смысл пытаться в европку.

Ещё одна жертва сойбойства от машоба. Что не так с svm? Вапник без бороды?

Бишоп, "Neural networks for pattern recognition". Я на неё ссылался.

В сети "Интернет".

20 Кб, 351x351

20 Кб, 351x351> Где теорию по нейроночкам почитать? не по машобу, а конкретно по инс, а то на дипломе будут ебать.

Вся суть образованца. Пишет диплом по нейроночкам @ спрашивает, что почитать по теории.

Услышал в курилке, что другие студенты обсуждают нейроночки, решил что это круто, надо быть в тренде. Но разбираться, книжки какие-то там читать, я вам че батан чтоле? Голова не казенная, забивать ее всякой мутью. Код - 100 строк на тф - спастил из интернета, а теперь главное термины немного вызубрить, чтоб не завалили на защите.

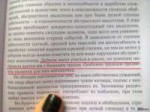

1,6 Мб, 1000x682

1,6 Мб, 1000x682Олег Леонидович это вы?

Начал я тут задачу вот такую решать. Грубо говоря, выделить все все прямоугольники и их пересечения (могут и не пересекаться вовсе, а в разных частях располагаться + шум + разная жирность и контраст контуров и пр)

По началу на OpenCV ковырял: dilation, Hough transform, edge detection, medial axis, дальше топология и прочее старье.

Но попался на глаза Yolo и заставил задуматься. Пытаюсь понять, подойдет ли он тут вообще. Его тогда надо будет на тех кусках, что я красным выделил тренировать или еще как-то (меня эти части больше всего интересуют)? С учетом того, что корреляция между кусками может быть приличной, не будет ли слишком близкой вероятность обнаруженных регионов, так что и отличит их сложно будет?

Практики в ML пока 0, но всякие си с крестами и питонами пилил в продакшене годами. Глянул, что darknet их доступен, да и аналоги на tensorflow имеются.

В ту я вообще сторону смотрю или смузи в голову ударил просто?

Да тут вроде задача решается в лоб простым алгоритмом.

Находишь пересечения и углы, и по этому выводишь где там прямоугольник у тебя.

Раз у тебя там шум, и контуры, то вначале убираешь шум и боке.

Выкручиваешь в общем контраст, прогоняешь через филтр шарпнеса.

Ну а дальше тривиально.

Нейроночки помогут справиться с шумом и разной толщиной, правильно найти углы. Остальное лучше закодить.

Стоит отметить, что я упростил постановку. Там еще немало других типов объектов может появляться и не хочется для каждого искать свои features, крутить пороговые значения и пр.

Подумал, что тренить было бы проще, чем постоянно самому через эти тернии и по мере расширения датасета разных примеров отгрузить это все на откуп обучению.

Т.е. для начал бы хотелось пощупать нейросети на практике, но не уверен, что стоит тратить время на этой задаче. За сим ищу совета

Т.е. грубо говоря, мне тренировать на вот таких регионах (+ нагенерить разного масштаба для симуляции толщины + шума)?

Не будет ложных классификаций типа feature с учетом того, что у отдельных фрагментов высокая корреляция?

>Насчет Павлова

тото в совке так дрочили на Павлова что в открытие гемато-энцефалического барьера не верили. А ученую которая открыла засрали.

84 Кб, 350x486

84 Кб, 350x486>Стоит отметить, что я упростил постановку. Там еще немало других типов объектов может появляться и не хочется для каждого искать свои features, крутить пороговые значения и пр.

>Подумал, что тренить было бы проще, чем постоянно самому через эти тернии и по мере расширения датасета разных примеров отгрузить это все на откуп обучению.

>Т.е. для начал бы хотелось пощупать нейросети на практике, но не уверен, что стоит тратить время на этой задаче. За сим ищу совета

Ну ты бы определился нормально с задачей для начала.

Что у тебя там за волшебные объекты другие.

Если ты делаешь управление для пром процесса, то отдавать все на откуп нейронке не стоит.

Вот этот верно говорит. >>206878

И тебе не очень то и нейронка нужна.

Обычный фильтр попиксельно прогонять.

>>206881

>Т.е. грубо говоря, мне тренировать на вот таких регионах (+ нагенерить разного масштаба для симуляции толщины + шума)?

>Не будет ложных классификаций типа feature с учетом того, что у отдельных фрагментов высокая корреляция?

Ну ты что, хочешь чтобы было лучше человека?

Если там информации нет, так тебе никто кроме Аллаха не скажет угол там или черти православные.

Научись определять толщину в конце концов и уровень шума.

Если для тебя все это слишком сложно, попробуй обратится к кому-то для кого нет.

Готового всем известного решения для твоей конкретной задачи - нет.

Используй индукцию и придумывай свой алгоритм.

84 Кб, 350x486

84 Кб, 350x486>Стоит отметить, что я упростил постановку. Там еще немало других типов объектов может появляться и не хочется для каждого искать свои features, крутить пороговые значения и пр.

>Подумал, что тренить было бы проще, чем постоянно самому через эти тернии и по мере расширения датасета разных примеров отгрузить это все на откуп обучению.

>Т.е. для начал бы хотелось пощупать нейросети на практике, но не уверен, что стоит тратить время на этой задаче. За сим ищу совета

Ну ты бы определился нормально с задачей для начала.

Что у тебя там за волшебные объекты другие.

Если ты делаешь управление для пром процесса, то отдавать все на откуп нейронке не стоит.

Вот этот верно говорит. >>206878

И тебе не очень то и нейронка нужна.

Обычный фильтр попиксельно прогонять.

>>206881

>Т.е. грубо говоря, мне тренировать на вот таких регионах (+ нагенерить разного масштаба для симуляции толщины + шума)?

>Не будет ложных классификаций типа feature с учетом того, что у отдельных фрагментов высокая корреляция?

Ну ты что, хочешь чтобы было лучше человека?

Если там информации нет, так тебе никто кроме Аллаха не скажет угол там или черти православные.

Научись определять толщину в конце концов и уровень шума.

Если для тебя все это слишком сложно, попробуй обратится к кому-то для кого нет.

Готового всем известного решения для твоей конкретной задачи - нет.

Используй индукцию и придумывай свой алгоритм.

50 Кб, 960x492

50 Кб, 960x492>Как так получилось

Лол, рабочии технологии не выгодны буржуазии, ну это типа как водородный двигатель, альтернативная энергия и все такое.

Надо обучать нейроночкостроению в колледжах, тогда будет норм.

Еще про обобщение CNN.

Скорее всего, тот алгоритм, который ты пытался описать, не работает. Идеальное сопоставление это задача присваивания, решается венгерским алгоритмом за О(N^3). Тебе скорее всего подойдет жадный алгоритм, каждый раз выбирающий лучшее присваивание, это О(N^2).

>венгерским алгоритмом

Мне кажется тут немного другая задача - мало того, что матрица получилась бы неквадратной, так ещё и не гарантировано, что есть хоть одна пара.

>матрица получилась бы неквадратной

Добавляй строки и/или столбцы, соответствующие отсутствию матча.

>не гарантировано, что есть хоть одна пара

Ограничивай вес совпадения снизу. Еслидва дескриптора совпадают меньше порогового значения - ставь вес меньше, чем вес отсутствия совпадения, чтобы эта пара никогда не была выбрана.

Блядь, какой же я дебил. Вместо перебора можно ведь и правда ебануть матрицу со всеми расстояниями между дескрипторами. Мозги уже совсем того, пора в крошку-картошку уже.

26 Кб, 644x800

26 Кб, 644x800> Имеет смысл сейчас читать книги по машобчику типа Бишопа, или уже устарело и трата времени?

Вы заебали со своим "устарело". Что там блять может устареть вообще? Вот с такими идеями, не зная даже линейной регрессии, сразу начинаете с сойбойского прохода в диплернинх и закономерно сасаете, т.к не имеете ни малейшего представления что вообще происходит.

Вопрос имеет ли смысл углубляться в классическое машинное обучение вместо дип лернинга. Так-то основы машобчика есть в книге из шапки, а я даже в градиентный спуск умею.

Зависит от задачи, порой диплернинг тащит, порой нет. Модель это тоже гиперпараметр.

В деталях разбирать устаревшее говно вроде SVM нет никакого смысла. Линейную регрессию неплохо бы разобрать. Бишоп устарел на 90%, сейчас он нужен только ради каких-то специфичных тем, вроде вероятностных моделей (на практике они не используются, впрочем). Никаких мифических "основ машобчика" там нет. Из старых моделей единственное что выжило это градиентный бустинг, про него в Бишопе нет ни слова.

А что ты хочешь? После диплернингбук никаких откровений больше не будет. Читай статьи по интересующей тебя теме, если хочешь прям до переднего края доползти.

То есть можно только диплернинг буком обойтись? Перед этим читать ничего не надо (математику уже знаю)?

Никакой особой "подготовки" к DLB не нужно, если ты об этом. Там даже в первой главе немного мат. аппарат описывают (недостаточно, конечно, но если ты два года хотя бы отучился в вузе, ты уже все необходимое знаешь).

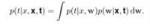

7 Кб, 404x65

7 Кб, 404x65>application of the sum and product rules of probability

чтобы получилась вот такая формула:

Очевидно же. p(t|x, w)p(w|x,t) - умножение, а интеграл - суммирование, само уравнение записано в виде функционала.

Я примерно так и думал, но

>p(t|x, w)p(w|x,t) - умножение

Тут умножения в упор не вижу. Возможно мне трудо адаптировать классическую формулу P(A, B) = P(A|B)P(B) для многомерного случая.

Ебать ты тралебасер.

Имхо фейк. Сцены они надергали сами, "сюжет" тоже, прошлись рандомно по кадрам дипфейком.

p(t|x,w)p(w|X,T) = p(t,w|x,X,T), так как w зависит только от X и T.

> Знак умножения часто просто опускают, оно по умолчанию подразумевается.

К слову, этот факт еще в средней школе проходят. Это к вопросу уровня развития большинства тутошних горемык.

vps - где умнажения а где vp или ps или vps?

*

Ты недооцениваешь мощь нейросетей.

правильно, вся эта маняматическая поебота нинужна

Абу, блядина мразотная, я не пощу "слишком быстро"

ПЕРЕКАТ

>>1209084 (OP)

>>1209084 (OP)

>>1209084 (OP)

Вопрос к знатокам.

Хочу использовать colab не для обучения игрушечных моделей на mnist-е, а для чего-то более приближенного к реальности.

Соответственно, есть проблема: надо уместить датасет с фотографиями 224224 в количестве около 2 миллионов в этот самый cloab...

Как это сделать?

На ум приходят только генеративные модели...

Насколько реально воспользоваться DCGAN-ом для генерации изображений для подачи на вход обучаемой модели?

Есть ли предобученные GAN-ы, которые могут выдать что-то вроде imagenet в разрешении 224224?

Сук разметка поехала

Вы видите копию треда, сохраненную 16 августа 2018 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.