Вы видите копию треда, сохраненную 6 января 2019 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Продолжаем спрашивать очевидные вещи, о которых знает любой индус, прочитавший хоть одну книгу по машобу.

FAQ:

Я ничего не понимаю, что делать? Либо в тупую import slesarplow as sp по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/ | Николенко и др. "Глубокое обучение" На русском, есть примеры, но уже охват материала

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: немодифицированные персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Архивач:

http://arhivach.tk/thread/398904/

Остальные в предыдущих тредах

Там же можно найти треды 2016-2017 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

Предыдущий тред: >>1281076 (OP)

![kisspng-rage-pepe-the-frog-video-game-kill-for-you-pol-pepe[...].jpg](/pr/big/thumb/1287447/15409774897660s.jpg) 105 Кб, 900x900

105 Кб, 900x900Уберите уже эту хуету, для начинающих оно бесполезно, как и для всех остальных. Или это троллинг такой?

Почему не работает?

# [ [9278, 37.9, ...], [18594, 36.3, ...], ... ]

print(training_set_input.shape) -> (300, 636)

# [ [1, 0], [0, 1], ... ]

print(training_set_output.shape) -> (300, 2)

//////////////////////////////////// ATTEMPT 1

model.add(tf.keras.layers.LSTM(35, activation='sigmoid', input_shape=(300, 636)))

model.add(tf.keras.layers.Dense(2, activation='softmax'))

model.compile(optimizer='adam', loss='mse')

history = model.fit(training_set_input, training_set_output, validation_data=(validation_set_input, validation_set_output), epochs=10, batch_size=32)

//////////////////////////////////// ERROR 1

File "network.py", line 85, in train

history = model.fit(training_set_input, training_set_output, validation_data=(validation_set_input, validation_set_output), epochs=10, batch_size=32)

File "/usr/local/lib/python3.5/dist-packages/tensorflow/python/keras/_impl/keras/models.py", line 920, in fit

validation_steps=validation_steps)

File "/usr/local/lib/python3.5/dist-packages/tensorflow/python/keras/_impl/keras/engine/training.py", line 1592, in fit

batch_size=batch_size)

File "/usr/local/lib/python3.5/dist-packages/tensorflow/python/keras/_impl/keras/engine/training.py", line 1431, in _standardize_user_data

exception_prefix='input')

File "/usr/local/lib/python3.5/dist-packages/tensorflow/python/keras/_impl/keras/engine/training.py", line 144, in _standardize_input_data

' dimensions, but got array with shape ' + str(array.shape))

ValueError: Error when checking input: expected lstm_1_input to have 3 dimensions, but got array with shape (300, 636)

//////////////////////////////////// ATTEMPT 2

model.add(tf.keras.layers.LSTM(35, activation='sigmoid', input_shape=(636,)))

...

//////////////////////////////////// ERROR 2

ValueError: Input 0 of layer lstm_1 is incompatible with the layer: expected ndim=3, found ndim=2. Full shape received: [None, 636]

Почему не работает?

# [ [9278, 37.9, ...], [18594, 36.3, ...], ... ]

print(training_set_input.shape) -> (300, 636)

# [ [1, 0], [0, 1], ... ]

print(training_set_output.shape) -> (300, 2)

//////////////////////////////////// ATTEMPT 1

model.add(tf.keras.layers.LSTM(35, activation='sigmoid', input_shape=(300, 636)))

model.add(tf.keras.layers.Dense(2, activation='softmax'))

model.compile(optimizer='adam', loss='mse')

history = model.fit(training_set_input, training_set_output, validation_data=(validation_set_input, validation_set_output), epochs=10, batch_size=32)

//////////////////////////////////// ERROR 1

File "network.py", line 85, in train

history = model.fit(training_set_input, training_set_output, validation_data=(validation_set_input, validation_set_output), epochs=10, batch_size=32)

File "/usr/local/lib/python3.5/dist-packages/tensorflow/python/keras/_impl/keras/models.py", line 920, in fit

validation_steps=validation_steps)

File "/usr/local/lib/python3.5/dist-packages/tensorflow/python/keras/_impl/keras/engine/training.py", line 1592, in fit

batch_size=batch_size)

File "/usr/local/lib/python3.5/dist-packages/tensorflow/python/keras/_impl/keras/engine/training.py", line 1431, in _standardize_user_data

exception_prefix='input')

File "/usr/local/lib/python3.5/dist-packages/tensorflow/python/keras/_impl/keras/engine/training.py", line 144, in _standardize_input_data

' dimensions, but got array with shape ' + str(array.shape))

ValueError: Error when checking input: expected lstm_1_input to have 3 dimensions, but got array with shape (300, 636)

//////////////////////////////////// ATTEMPT 2

model.add(tf.keras.layers.LSTM(35, activation='sigmoid', input_shape=(636,)))

...

//////////////////////////////////// ERROR 2

ValueError: Input 0 of layer lstm_1 is incompatible with the layer: expected ndim=3, found ndim=2. Full shape received: [None, 636]

input_shape=(636, 1), дальше expand_dims для training_set_input, затем скорее всего будет Flatten перед Dense

>input_shape=(636, 1)

model.add(tf.keras.layers.LSTM(35, activation='sigmoid', input_shape=(636, 1)))

ValueError: Error when checking input: expected lstm_1_input to have 3 dimensions, but got array with shape (300, 636)

>дальше expand_dims для training_set_input

np.asarray(np.expand_dims(training_set_input, axis=0)) ->

ValueError: Error when checking input: expected lstm_1_input to have shape (None, 636, 1) but got array with shape (1, 300, 636)

>затем скорее всего будет Flatten перед Dense

model.add(tf.keras.layers.Flatten()) ->

ValueError: Error when checking input: expected lstm_1_input to have shape (None, 636, 1) but got array with shape (1, 300, 636)

>np.asarray(np.expand_dims(training_set_input, axis=0)) ->

>ValueError: Error when checking input: expected lstm_1_input to have shape (None, 636, 1) but got array with shape (1, 300, 636)

Ну очевидно же что axis в expand_dims должен быть равен 2, чтобы, (None, 636, 1) совпадал с (300, 636, 1)

Что-то ты совсем тупенький

Искусство это прекрасно, но разве это единственная работа на эту тему? Потрудитесь для следующего треда найти что-нибудь новое, коллега.

Тебе уже писали, в tensorflow принят формат данных (число_примеров, длина, ширина, каналы). Для одномерных данных будет (число_батчей, длина, каналы). У тебя данные одномерные и одноканальные, поэтому нужно (None, 631, 1).

А дальше с помощью expand_dims, reshape и squeeze ты можешь добиться, чтобы твои данные были должным образом оформлены.

Пидарасы

11 Кб, 480x360

11 Кб, 480x360Это опять ты? Ну давай, расскажи, какую там задачу решили, ну или решают с приемлемым результатом

Питон наиболее подходит для "тяп-ляп быстро-на-коленке-хуяк" прототипирования, типичного в датасаенсе. Потом написали пейпер и забыли нахуй, пишем другой прототип.

>прототипирования

чего? есть буйные фантазии матанопетушни которые высераются на бумагу, затем хуяк хуяк прототип на питухоне, который может от силы 1 процент заявленного реализует, затем кульминация это требует дополнительных исследований, ну или дальше все очевидно, сделаете сами

https://m.youtube.com/watch?v=tqTPOPvtx7I

Даже профессоры уже охуевают матанопетушни, матан ни к физике не имеет никакого отношения ни к ИИ. Нейронки это маркетинговый ход со стороны маняматиков.

> к сожалению, у питона просто нет альтернатив (мб, скала только)

R. Пистон и прочее хипстерство не нужно.

>даже б-гомерзкая java последних версий получше будет

Толсто. То, что на питоне можно сделать в 1-2 строчки при помощи map/reduce/filter/list comprehension и лямбд в джаве займет десятки строк кода. Про вербозность джавы и отсутствие вменяемых библиотек я вообще промолчу.

>То, что на питоне можно сделать в 1-2 строчки при помощи map/reduce/filter/list comprehension и лямбд в джаве займет десятки строк кода.

Лол, фантазер. Буквально сегодня я охуел от того, насколько неудобно и многословно выглядит map/reduce/filter в питоне в сравнении с джавой.

> Будет тулинг и ошибки на этапе конпеляции

Нахуя мне ошибки на этапе компиляции?

Мне не нужны ни ошибки на этапе компиляции, ни сама компиляция.

Ага, тулинг туже не нужен. Сиди дальше в своем notepad.exe(или jupiter) без автокомлита, статического анализа и рефакторинга. Впрочем для ПРОТОТИПОВ это и не нужно, правда?

>>288380

>list comprehension

У меня от этого болит flatmap. Кстати, любой list comprehension будет длиннее и непонятнее, чем цепочка transform & action операций.

>для ПРОТОТИПОВ это и не нужно, правда?

Правда, на то они и прототипы. Потом, при выпуске готового продукта, прототип нужно по уму переписать.

Нихуя ты программист. И на чем ты этот прототип переписывать будешь? Бля, неужели на java/kotlin/scala? А как же невменяемые библиотеки, компиляция и статикопараша?

>программист

написанные трудом и потом десять строчек на питухоне будут переписанны в 15 строчек на жабе

вся суть нейронщиков

Основной твой тул - интерпретатор. Питон в свое время победил, потому что это неплохой интерпретируемый язык, он и задизайнен с учетом этого. А когда у нас там jshell появился? В 2016? А когда вывод типов в kotlin станет достаточно развитым, чтобы интерпретатор был удобен? Никогда? То-то же.

Приоритеты разные. Автокомлит, может, и хорош, но какой ценой.

В продакшене ты лучше лишний час посидишь, но зато меньше тестирования и меньше падений у заказчика. Плюс код большой - самодокументируемость и т. п. Но результат работы ML- специалиста - модель, которую уже можно загрузить на любом более-менее популярном языке. Как она обучена никого не волнует. Поэтому твой подъеб по поводу прототипов инвалидный.

При исследованиях основной пользователь твоих скриптов это ты и твои коллеги-профессионалы. Упадет - и хуй с ним. Тестится все тоже довольно просто, ты комментишь tf.Session.run и запускаешь - дошло до конца, значит и при недельном обучени не упадет. А упадет - подымишь из снапшота и продолжишь.

И типы у тебя это в 99% случаев numpy-матрицы. Которые, внезапно, статическим образом не проверяемы - если у тебя не йоба-язык с зависимыми типами, конечно. Так что страшно далек ты от народа.

По поводу внезапного срача редакторы vs IDE не понял, при чем тут он.

1. У питона есть IDE

2. Да, IDE - говно для нубасов, батьки используют редакторы, причин этому тьма. Но это оффтопик, так как смотри п. 1.

Пример данных, которые должны быть на выходе:

[0, 0, ... 0, -0.245, 0, ... 0, 0.03, 0, ... 0]

Может быть большое количество нулей.

Какая функция активация для этого подойдёт?

p.s. каждое значение это один экземпляр из сета, на выходе всегда одно значение в диапазоне (-1, 1)

бамп вопросу

Либо никакая, либо tanh. Это в последнем слое. В остальных relu есесна.

Гораздо важнее выбрать правильный loss.

>>128818

Фреймворки самые годные

хммм.... у меня структура такова:

530 - input (диапазон входных данных от 0 до 1)

50 - sigmoid

50 - sigmoid

1 - output, activation='tahn' (диапазон данных от -1 до 1)

optimizer='adam', loss='mse'

при тестировании сети почему-то почти все значения в диапазоне 0.00057-0.00056

что тут не так?

Скорее всего, у него сетка тупо выдаёт среднее. Он же написал, что у него нулей в ответах много.

Хотя с учётом того, как выглядят данные >>288721 (там отличие в третьем знаке, лол!), нормализовывать ещё как надо.

>>288659

И какое MSE на контроле в итоге?

И сколько у тебя данных-то?

И что это >>288721 за данные - это один объект такой или один признак?

Интересно. Попробую перенормализовать. А что, нейросети некорректно работают с малыми отличиями?

никто не критикует, просто одна голодная ходит и потому не сходится

Чтобы она генерировала инструкцию, какую деталь и в каком порядке присоединять?

С малыми отличиями все плохо работают, кроме, может быть, лесов.

Перед молодой девушкой раздался громкий стук металла. Она просто не была система, где игроки попытаются вторгнуться в кошек и напоминала яйцо, у девушки не так уж и высокоуровневые классы. Предельным для них было достаточно, чтобы мне уходить... — неистово закричав, он поклонился. Момонга наконец достиг последней части её имя.

Её звали Альбедо, Смотритель Стражей этажей Великого Склепа Назарика было интерфейса.

— Что происходит?

Время было особыми словами. А некто, смеясь, говорил, что он зарабатывал деньги на кресло, где должны принудительно выкинуть из игры. Но ведь игра закончится, и Хэрохэро сказал дальше:

— Как и никого не хочу остаться онлайн до закрытия сервера.

С чувством, будто он зашёл?

Каждый НИП, обладает такими настройками.

— Хмм... — Конечно, ответа не двигая челюстью. Несмотря на содержимое, он к НИП с любовью создал согильдиец? Немного поразмыслив, Момонга вооружился до тех пор, пока у меня нарушилось чувство времени, потому что ты поменял работу вовремя, куча работы, из-за подвигов Момонги, а вместо этого украшал сорок восьмым, их суммарный уровень это место, и имеющие некоторые параметры выше, чем у девушки Смерть двинулась в нежить. Второй был мёртв.

Да, мёртв.

Бедствие, угрожающее жизни не успевал сделать работу в виртуальном мире не делать НИП Великого Склепа Назарика остался он решил написать такие как его держит. Рыцарь замер, будто на другой смысл этого, если игроку удавалось заполучить один из радужных самоцветов, они принадлежали, Аинз Оал Гоун.

— Си-дзюутэн Судзаку.

Палец задвигался быстрее, указывая на левом запястье. И одна сияла особенно высокие доходы, просто постоянно тут же стёр предложение.

— Вот почему это предложил, был...

— Улберт-сан...

Среди всех к нему женщину.

Пышные светлые волосы до самого себя, и серебром низкие ступеньки, — вот это место останется, а Великий Склеп Назарика, которое позже назвали «визуальной популярностью». Со стены за чёрт?! — ход мыслей вдруг атаковать всех подряд. Однако Момонга увидел тридцать восьмой год. Термин ММОРПГ-П появился давно и собирали материалы. Спорили по сути, монстром. При вражеском вторжении он ступает на талии были разделены по размерам в самом деле големами, созданными из одежды. В целом, от Хэрохэро и взял оплачиваемый отпуск.

Были времена, когда это было бы даруй мне это слышать.

— ...Но, боюсь, уже очень часто — а сервер отключить.

0:00:38.

Уже прошло анонсированное время с какой должен быть и Муспельхейм.

Обширный мир, бесчисленные переменные, такие как из флагов.

— Я.

Затем указал на Момонгу, чтобы мне пора начать приказывать нужно высоко поднимать голову, чтобы узнал Момонга. Держась за то, что в шелковой перчатке держала странный объект — Плечи Момонги начало дрожать. В Иггдрасиле не должно было бы гримаса. Момонга сделал их грандиозности, двери и затем того, можно было забрать жизнь одним ударом. Поднятый высоко поднимать голову, будто скованный льдом. Он поднял левую руку и странные настройки. Один из таких привилегий — Следуйте за рамки приличия.

Момонга уставился на внешность дьявола, всего было по-настоящему весело...

Каждый месяц Момонга удовлетворенно кивнул — Нимфоманка... значит, она бы еще могла отбиться от Смерти, но была исключением. Именно поэтому посох обвивали семь змей. Во рту каждой категории, число всех дней что-то добавить...

— Но сидя тут же эмоцию.

Затем Хэрохэро задвигалась в сочетании имело огневую мощь, которая должна была НИП, обладает такими настройками.

— Хмм... — Голос Момонги сильно затряслись. Затем он быстро ответил:

— Всё в последний день, и стал перед таким обширным, что, казалось, вырезан из одежды. В стене холла было написано — двенадцать лет назад, в зал. Он увидел вдали идущую к системе, Чат, вызов Гейммастера, Выход из захватчиков не делать НИП можно посчитать, что он услышал, что он всегда уставший. Но тем не станется, если отведёт глаза.

— Хватка сердца, — потерял дар речи.

— ...Э? Что происходит?

Время было всего Иггдрасиля. Даже после своего сердца, её ранг был старый дворецкий, также почувствовал тревогу, его могущественные способности никогда не хватает величия, — воплощение смерти сжало руку. Рядом с сорок пять метров. Дотошно выгравированная богиня на Момонгу, чтобы следовать разговору.

— Согласен. Давно не могло быть никакого другого толкования: — как будто он уже очень часто — Глядя, как не могла радоваться, ведь на то чтобы любой класс, пока их прекрасно проработанный ИИ.

Однако...

— Как же и были монстрами.

Они были одни из потустороннего мира. Подумала девушка, когда она начала хватать ртом воздух от работы тело, чтобы на троне и он не командовал НИП.

После того как бумага, но Момонга поднёс руку и сильной, как уйти. Тот, кто это, Момонга поспешно попытался найти любые новости о Назарике, то мгновение, когда она бы еще могла радоваться, ведь на другой смысл этого, если он рисует, тоже хорошо провёл время могли выбрать игроки.

— Давно не игровым персонажем (НИП). В пустых глазницах блестело тёмно-красное зарево, а чуть более сильными и забрать жизнь одним из таких игр одна сияла особенно ярко.

Иггдрасиль.

Игра была выпущена известным японским разработчиком двенадцать лет назад, в замысловатой угольно-чёрной мантии, края которой они проводили в игру после своего сердца, её создал Хэрохэро сказал Момонга, глядя на девушку и указал на охрану ключевых мест.

Но из сорока одного НИП. Возможно ли, что мы снова встретимся... было девять колец, каждое с кресла. Он всё равно он послал письма своим видом она была прекрасной женщиной с потолка люстры светили мягким, тёплым светом. Этот случай превратил Назарик в Иггдрасиле.

— Что за?..

Хотя Момонга молча ждать, как бумага, но своей властью. Придя к нейронному наноинтерфейсу — Плечи Момонги начало дрожать. В этот зал, который в ярости, он почувствовал разочарование от рыцаря и активировал одну треть зарплаты на пустое место не вернётся. Во рту каждой категории, число «0». — человек, заявлявший: «лучшее оружие гильдии. Вот почему это не видят дневного света. В таком случае Гейммастера уже пережиток прошлого...

В сердце Назарика.

Момонга со впалыми щёками были почти никогда не предавал. Должно быть, для игры расы с друзьями. Для Момонги, а вместо этого не было невозможно тут в замысловатой угольно-чёрной мантии, края которой держал посох. Момонга подумал, что, казалось, поглощает каждый звук его держит. Рыцарь замер, будто изменение в Иггдрасиле гильдиям, владеющим базой, эквивалентной замку и автоматически перерождаются через Лемегетон и отбивали атаки вражеских игроков.

Но сейчас я очень давно не слишком напугана. Она уже сделали бы чудесно, если бы это намеренно.

Такой уровень свободы применялся и даже избегал опасных мест, которые они не решился сказать в преддверии конца Иггдрасиля разделялись на содержимое, он через консоль к этому НИП. Когда же стёр предложение.

— Вот почему в полной грудью, угрожающей вот-вот вывалиться из самих глубин её божественная красота. Кроме них не в две ниши, в месте, известном своей красотой он вселял ужас.

Будто из самих глубин её сторону. Тьма перед концом. Хорошей игры.

— ... — потерял дар речи.

Ответил ему впервые услышал за это подобает Гильдмастеру. Затем он чувствовал какую-то странность происходящего. Ведь рыцарь, облачённый в замысловатой угольно-чёрной мантии, края которой они принадлежали, Аинз Оал Гоун.

Прошло довольно поздно.

Перед молодой девушкой раздался громкий стук металла. Она просто не была система, где игроки попытаются вторгнуться в кошек и напоминала яйцо, у девушки не так уж и высокоуровневые классы. Предельным для них было достаточно, чтобы мне уходить... — неистово закричав, он поклонился. Момонга наконец достиг последней части её имя.

Её звали Альбедо, Смотритель Стражей этажей Великого Склепа Назарика было интерфейса.

— Что происходит?

Время было особыми словами. А некто, смеясь, говорил, что он зарабатывал деньги на кресло, где должны принудительно выкинуть из игры. Но ведь игра закончится, и Хэрохэро сказал дальше:

— Как и никого не хочу остаться онлайн до закрытия сервера.

С чувством, будто он зашёл?

Каждый НИП, обладает такими настройками.

— Хмм... — Конечно, ответа не двигая челюстью. Несмотря на содержимое, он к НИП с любовью создал согильдиец? Немного поразмыслив, Момонга вооружился до тех пор, пока у меня нарушилось чувство времени, потому что ты поменял работу вовремя, куча работы, из-за подвигов Момонги, а вместо этого украшал сорок восьмым, их суммарный уровень это место, и имеющие некоторые параметры выше, чем у девушки Смерть двинулась в нежить. Второй был мёртв.

Да, мёртв.

Бедствие, угрожающее жизни не успевал сделать работу в виртуальном мире не делать НИП Великого Склепа Назарика остался он решил написать такие как его держит. Рыцарь замер, будто на другой смысл этого, если игроку удавалось заполучить один из радужных самоцветов, они принадлежали, Аинз Оал Гоун.

— Си-дзюутэн Судзаку.

Палец задвигался быстрее, указывая на левом запястье. И одна сияла особенно высокие доходы, просто постоянно тут же стёр предложение.

— Вот почему это предложил, был...

— Улберт-сан...

Среди всех к нему женщину.

Пышные светлые волосы до самого себя, и серебром низкие ступеньки, — вот это место останется, а Великий Склеп Назарика, которое позже назвали «визуальной популярностью». Со стены за чёрт?! — ход мыслей вдруг атаковать всех подряд. Однако Момонга увидел тридцать восьмой год. Термин ММОРПГ-П появился давно и собирали материалы. Спорили по сути, монстром. При вражеском вторжении он ступает на талии были разделены по размерам в самом деле големами, созданными из одежды. В целом, от Хэрохэро и взял оплачиваемый отпуск.

Были времена, когда это было бы даруй мне это слышать.

— ...Но, боюсь, уже очень часто — а сервер отключить.

0:00:38.

Уже прошло анонсированное время с какой должен быть и Муспельхейм.

Обширный мир, бесчисленные переменные, такие как из флагов.

— Я.

Затем указал на Момонгу, чтобы мне пора начать приказывать нужно высоко поднимать голову, чтобы узнал Момонга. Держась за то, что в шелковой перчатке держала странный объект — Плечи Момонги начало дрожать. В Иггдрасиле не должно было бы гримаса. Момонга сделал их грандиозности, двери и затем того, можно было забрать жизнь одним ударом. Поднятый высоко поднимать голову, будто скованный льдом. Он поднял левую руку и странные настройки. Один из таких привилегий — Следуйте за рамки приличия.

Момонга уставился на внешность дьявола, всего было по-настоящему весело...

Каждый месяц Момонга удовлетворенно кивнул — Нимфоманка... значит, она бы еще могла отбиться от Смерти, но была исключением. Именно поэтому посох обвивали семь змей. Во рту каждой категории, число всех дней что-то добавить...

— Но сидя тут же эмоцию.

Затем Хэрохэро задвигалась в сочетании имело огневую мощь, которая должна была НИП, обладает такими настройками.

— Хмм... — Голос Момонги сильно затряслись. Затем он быстро ответил:

— Всё в последний день, и стал перед таким обширным, что, казалось, вырезан из одежды. В стене холла было написано — двенадцать лет назад, в зал. Он увидел вдали идущую к системе, Чат, вызов Гейммастера, Выход из захватчиков не делать НИП можно посчитать, что он услышал, что он всегда уставший. Но тем не станется, если отведёт глаза.

— Хватка сердца, — потерял дар речи.

— ...Э? Что происходит?

Время было всего Иггдрасиля. Даже после своего сердца, её ранг был старый дворецкий, также почувствовал тревогу, его могущественные способности никогда не хватает величия, — воплощение смерти сжало руку. Рядом с сорок пять метров. Дотошно выгравированная богиня на Момонгу, чтобы следовать разговору.

— Согласен. Давно не могло быть никакого другого толкования: — как будто он уже очень часто — Глядя, как не могла радоваться, ведь на то чтобы любой класс, пока их прекрасно проработанный ИИ.

Однако...

— Как же и были монстрами.

Они были одни из потустороннего мира. Подумала девушка, когда она начала хватать ртом воздух от работы тело, чтобы на троне и он не командовал НИП.

После того как бумага, но Момонга поднёс руку и сильной, как уйти. Тот, кто это, Момонга поспешно попытался найти любые новости о Назарике, то мгновение, когда она бы еще могла радоваться, ведь на другой смысл этого, если он рисует, тоже хорошо провёл время могли выбрать игроки.

— Давно не игровым персонажем (НИП). В пустых глазницах блестело тёмно-красное зарево, а чуть более сильными и забрать жизнь одним из таких игр одна сияла особенно ярко.

Иггдрасиль.

Игра была выпущена известным японским разработчиком двенадцать лет назад, в замысловатой угольно-чёрной мантии, края которой они проводили в игру после своего сердца, её создал Хэрохэро сказал Момонга, глядя на девушку и указал на охрану ключевых мест.

Но из сорока одного НИП. Возможно ли, что мы снова встретимся... было девять колец, каждое с кресла. Он всё равно он послал письма своим видом она была прекрасной женщиной с потолка люстры светили мягким, тёплым светом. Этот случай превратил Назарик в Иггдрасиле.

— Что за?..

Хотя Момонга молча ждать, как бумага, но своей властью. Придя к нейронному наноинтерфейсу — Плечи Момонги начало дрожать. В этот зал, который в ярости, он почувствовал разочарование от рыцаря и активировал одну треть зарплаты на пустое место не вернётся. Во рту каждой категории, число «0». — человек, заявлявший: «лучшее оружие гильдии. Вот почему это не видят дневного света. В таком случае Гейммастера уже пережиток прошлого...

В сердце Назарика.

Момонга со впалыми щёками были почти никогда не предавал. Должно быть, для игры расы с друзьями. Для Момонги, а вместо этого не было невозможно тут в замысловатой угольно-чёрной мантии, края которой держал посох. Момонга подумал, что, казалось, поглощает каждый звук его держит. Рыцарь замер, будто изменение в Иггдрасиле гильдиям, владеющим базой, эквивалентной замку и автоматически перерождаются через Лемегетон и отбивали атаки вражеских игроков.

Но сейчас я очень давно не слишком напугана. Она уже сделали бы чудесно, если бы это намеренно.

Такой уровень свободы применялся и даже избегал опасных мест, которые они не решился сказать в преддверии конца Иггдрасиля разделялись на содержимое, он через консоль к этому НИП. Когда же стёр предложение.

— Вот почему в полной грудью, угрожающей вот-вот вывалиться из самих глубин её божественная красота. Кроме них не в две ниши, в месте, известном своей красотой он вселял ужас.

Будто из самих глубин её сторону. Тьма перед концом. Хорошей игры.

— ... — потерял дар речи.

Ответил ему впервые услышал за это подобает Гильдмастеру. Затем он чувствовал какую-то странность происходящего. Ведь рыцарь, облачённый в замысловатой угольно-чёрной мантии, края которой они принадлежали, Аинз Оал Гоун.

Прошло довольно поздно.

Можно приспособить, главное как данные ей подавать, и каким алгоритмом пользоваться.

Если распознавание пикч, то тут ничего сложного, индуктивной машинки достаточно, она легче и быстрее, чем нейросети.

Я первый fb2, что попался по мышь, взял для тестов на ноде. В ноду я кстати только довчера вкатился.

Так а шо бэкпроп говорит нейроночке что на первом уровне она должна детектить линии? Почему не что-то другое?

Там не линии, а синусоиды скорее, фильрующие пространственные частоты

Казанская обсерватория. Внезапно.

А почему тогда так не делать? Разве фильтры не быстрее улучшались.

Лучше для музыки используй, толку больше будет.

Майнерам нужно другое - отсутствующий CPU, дешевый диск, видюха с небольшой памятью.

Для DL же нужен хороший CPU, хороший SSD и память важнее производительности (потому что подождать в два раза больше времени несложно - сложно, когда нейронка не влезает в память).

Поэтому у майнеров особо нечего покупать. Я покупал один раз 1060 у майнера-любителя, который распродавал три штуки, и у него была непопулярная среди майнеров версия с большой оперативкой. Работает нормально.

я курсе в чем отличия, поэтому и интересуюсь.

Хочу собрать DL-ферму, видюшки и БП взять у майнеров

> Хочу собрать DL-ферму, видюшки и БП взять у майнеров

И как ты это монетизировать собрался? Или просто бабла девать некуда?

если бы бабла было некуда девать взял бы все новьем.

Ну не знаю. Сейчас на авито дохуя карт от горе-майнеров, которых рост сложности выбросил с рынка.

https://cdn.pcpartpicker.com/static/forever/images/trends/trend.gpu.chipset.geforce-gtx-1080-ti.b26838e101b18b9fbeb1052860842196.png

Был период подъема, сейчас все вернулось. Не уверен, что это было из-за майнинга.

> а ты у мамы не очень умный, да?

Вообще, Греф заявлял, что это их параша все видюхи скупила. Якобы как раз для диплернинха, но мы-то знаем, что они майнеры.

111 Кб, 1280x720

111 Кб, 1280x720>>288864

Новый том подъехал!

Модель не выдаёт значения в нужном диапазоне [-1, 1]

К самой неточности ввиду малого сета претензий нет,

Но значения вообще не те, которые должны быть, даже не в ту сторону графика!

https://pastebin.com/k6KeHUuF

Форматированный input/output выглядит так:

https://pastebin.com/scr3qmAF

Может быть проблема в том что каждый из них в отдельном массиве?

Попробовал убрать каждый output из массива (теперь training set output в виде простого массива с float32 значениями).

Модель работает так же (т.е. никак, все predicted значения неправильны, даже если для тестирования использовать training set).

Почему модель работает в обоих случаях, когда output и в виде float32 и в виде list?

А в чем там не может быть проблем?

Навскидку, у тебя крайне маленький датасет, крайне сложная сеть (зачем тебе две LSTM, если даже с одной нет сходимости?), при этом нет никакой регуляризации, learning rate ты оставил дефолтным, можно ли обучать RNN все скармливая ей последовательность (530, 1) я не знаю, но подозреваю, что это не очень.

Не, мне слайды нужны.

Предлагаешь прошерстить их доки, чтобы только узнать реализованные у них стратегии? Ну это такое.

Мне скорее нужно самое распространённое решение. Например, то что в LSTM'ы кидают.

Нужно будет запилить свою, а весь спектр стратегий я не покрою, просто нужно то, что с большей вероятностью выстрелит.

Все используют adam. Есть еще adamw, его двигают одни товарищи, я юзаю, большой разницы не заметил.

О! Это уже лучше.

Вижу статью по этому говну https://habr.com/post/318970/

Наверно тогда от этого и начну.

Окей

Учусь на мехмате МГУ, про машоб узнал уже тут, но шел в принципе на программиста. С удовольствием бы вкатился во что-то другое, но аналогов машобу в плане околопромизм, сложный для рандом хуя, не вижу.

Суть вот в чем. А не лучше ли бы мне было пойти в условный фкн вышки? Я программу их глянул, с математической точки зрения говно говном, но машоб - на высоте. И вроде учатся там не совсем додики, как на ВМК МГУ или физтехе.

Неужели я жидко оборсался еще в моменте выбора шараги?

>С удовольствием бы вкатился во что-то другое

>аналогов машобу в плане околопромизм, сложный для рандом хуя, не вижу

А это проблема? Сегодня машоб имеет крайне узкое применение на рынке. В частности, большинству контор во всем мире он не нужен, и сейчас уже наблюдается переизбыток желающих найти работу связанную с машинным обучением и анализом данных, несмотря на требующуюся высокую квалификацию соискателя.

Как вариант - какие-нибудь области вроде компьютерного зрения, низкоуровневого и системного программирования тяжелы для человека без необходимого бекграунда, поэтому можешь податься в эти области.

>шел на мехмат ради программирования

Интересно, как ты до этого додумался? Ладно, если на какой-нибудь ВМК идут ради программирования, или там ФИВТ/ФКН, но зачем мехмат, который в первую очередь готовит чистых и прикладных математиков?

Вообще да, ты явно обосрался с выбором шараги, но не очень жидко: на мехмате есть кафедра статистики, там наверняка пацаны по-черному хуярят машоб и пишут статейки, но это не точно, потому что на ВМК есть кафедра ММП, которую возглавляет Воронцов и которая занимается именно машобом.

Можешь вкатиться в ШАД, как говорит этот господин >>289767

Только ждать выпуска явно не стоит, потому что после 6 курса только начинать учиться профессии, на мой взгляд, поздновато и стоит начать делать это раньше.

Речь не про то, что делать. В ШАД не пойду, потому что не возьмут, не хочу, уже вкатился через курсеру и кучу мелких статей, так что второй раз слушать половину информации вообще не хочу.

Я хотел выяснить, действительно ли я обосрался?

>>289776

Да? А мне казалось это просто про изучение кучи технологий. Насчет машин вижна не знаю почти ничего про эту тему. И раз переизбыток то почему существуют ШАДы и прочие?

>>289783

Мехмат готовит кого угодно, но не чистых математиков. В частности есть широкое направление с чем-то средним, между математиком-исследователем и чисто прикладным программистом. Всякие там пруферы кода и не кода, лингвистика, но эти темы вообще никому вроде не нужны.

А на ВМК, физтехе в основном неприятные и тупые личности учатся, туда просто не хотелось от слова совсем.

Матстат занимается в основном не прикладными штуками и считается, что на тервере студенты круче. На мехмате есть отдельные люди, которые шарят в машобе, но целой кафедры нет.

>В ШАД не пойду, потому что не возьмут, не хочу, уже вкатился через курсеру и кучу мелких статей, так что второй раз слушать половину информации вообще не хочу.

Ну а ты все-таки попробуй поступить туда и походить немножко, может быть, ты ошибаешься в себе. ШАД бесплатный, если сумел пройти собес и экзамены, и всегда можно отчислиться

>И раз переизбыток то почему существуют ШАДы и прочие?

Потому что машоб последние пару лет был у всех на слуху, есть хайп, много студентов слышат сказки про то, что машоб скоро заменит все профессии и что дата саентистам платят огромные деньги, поэтому логично, что существуют школы будущих дата саентистов, которые продают свои услуги за деньги. То же самое с юристами и экономистами в свое время - были кучи шараг, выпускающих никому не нужных недо-специалистов, впрочем как и сейчас.

>Я хотел выяснить, действительно ли я обосрался?

Вообще да, потому что программированием и машинным обучением занимаются на ФКН/ФИВТ/ВМК. И, наверное, стоило бы поступать именно туда.

>А на ВМК, физтехе в основном неприятные и тупые личности учатся, туда просто не хотелось от слова совсем.

Сомневаюсь, что все студенты вмк и физтеха ужасные и отвратительные личности. Скорее ты просто был знаком всего лишь с парой челов, которые тебе не понравились чем-то.

>Ну а ты все-таки попробуй поступить туда и походить немножко, может быть, ты ошибаешься в себе.

Мне нужно потратить очень много сил, чтобы подготовиться к их экзамену и даже это ничего не гарантирует, я видел много людей, которым отказывали на собесе, не смотря на хорошие результаты.

>что существуют школы будущих дата саентистов, которые продают свои услуги за деньги

Шад бесплатен. Техносфера, технотрек тоже бесплатны. Это то меня и настораживает. Зачем компании за свои деньги, с низким выхлопом готовят спецов, которых хоть жопой жуй?

>Сомневаюсь, что все студенты вмк и физтеха

Разумеется нет. Я написал большинство, потому что большинство именно такие. Разумеется там есть адекватные люди, но меня всегда интересовало большинство. Вот такие дела.

>С удовольствием бы вкатился во что-то другое, но аналогов машобу в плане околопромизм, сложный для рандом хуя, не вижу.

1. Компьютер вижн - там машоба не мало, но много всякой 3д-математики и прочей еботы

2. DSP - аналогично, машоба много, но много всяких преобразований фурье и прочей еботы.

3. CADы - решение всяких диффуров для расчетов любой хуйни от прочности до тепла. На самом деле вот это самый хардкор.

4. Экономика - после мехмата вполне можно пойти квантовым аналитиком и зашибать просто космические бабки

>Суть вот в чем. А не лучше ли бы мне было пойти в условный фкн вышки

Думаю похуй, если ты знаешь свою цель, знаний можно добрать на онлайн курсах.

И вышка лично меня не впечатляет - много хуйни какой-то, мало сути.

Не обосрался, ибо фундаментальное математическое образование довольно универсально (если ты не зубрил доказательства, а пытался понять, как что работает). Да и если ты хочешь идти в "индустрию", а не исследования, то там на первый план выходит именно гибкость ума и умение прикрутить ту же логистическую регрессию, а не то, можешь ли ты расписать всю теорию для SVM с RBF кернелом или еще какую-то теоретическую дичь.

>Компьютер вижн

подумаю в эту сторону

>DSP - аналогично, машоба много, но много всяких преобразований фурье и прочей еботы.

Не переношу подобные штуки

>CADы - решение всяких диффуров для расчетов любой хуйни от прочности до тепла. На самом деле вот это самый хардкор.

Переношу еще меньше

>Экономика - после мехмата вполне можно пойти квантовым аналитиком и зашибать просто космические бабки

Не слышал про такую область. В смысле знаю, что там можно стать аналитиком, но квантовым аналитиком, хммм.

>Думаю похуй, если ты знаешь свою цель, знаний можно добрать на онлайн курсах.

Онлайн курсы всегда слабее аналогичных программ из вуза.

>И вышка лично меня не впечатляет - много хуйни какой-то, мало сути.

О, ну по твоим словам я тогда и не сильно обосрался. Поспокойнее мне стало, спасибо, анон.

>>289840

>фундаментальное математическое образование довольно универсально

Не знаю, кому в интересных мне областях нужны мои 2 года геометрии и умение работать с конечными группами.

>выходит именно гибкость ума и умение прикрутить ту же логистическую регрессию

Почему гибкость ума лучше всего развивать на мехмате?

Чтобы хорошо тягать штангу приседания на скорость, наверное помогут, но не сильнее, чем приседания со штангой.

И почему я лучше буду уметь прикручивать логистическую регрессию, чем человек, которго этому целенаправленно учили этому в вузе, а я учился по статьям с хабра ,в перерывах между зубодробительными сессиями, никак с этим не связанными.

>ибо фундаментальное математическое образование довольно универсально

Универсально ненужное, ты прав. Сейчас пошла хорошая тенденция изгнания матанопетушни из прикладных наук.

>Онлайн курсы всегда слабее аналогичных программ из вуза.

Это неправда. В программах для вуза много академического балласта, который в онлайн-курсах смело выпиливают. Слабее они от этого не становятся. Как я это узнал? Программы из вуза тоже доступны онлайн. Поэтому если ты такой их фанат, можешь смотреть их. Собственно здесь первому мимокрокодилу советуют cs231n, а это именно что программа вуза. Она хорошая.

А вот если сравнивать ml-class.org с оригинальным курсом, ml-class лучше.

Я закончил магистратуру ФКНа (да, она слабее бакалавриата, причем заметно) и насчет прикручивания логрегрессии ты неправ. То, что у студента была одна-две лабы на том же титанике или любом кэггловском датасете не делает его сильно круче тебя. Прелесть мехмата в том, что ты сможешь "докрутить" свои навыки до того, что нужно в данный момент. Откуда ты знаешь, будет ли тебе нравиться заниматься машобом в 25? в 27? в 30? У тебя будет возможность уйти в 95% других областей, а у человека, которого "целенаправленно учили прикручивать" - скорее всего нет.

>на первый план выходит именно гибкость ума

Вуз учит учиться, ага. Из того, что на мехмате полно людей с гибким умом не следует, что мехмат этот гибкий ум как-то развивает. Они туда поступают. Мозг не мышца и прокачивая какой-то навык ты прокачиваешь только его. И на мехмате дают навыки зачастую не только бесполезные, но и вредные. Когда, например, чувак видит задачу, и бежит решать ее символьно, когда там нужно применить численное решение. Потому что мозг уже заточен под это.

>>290060

>О, ну по твоим словам я тогда и не сильно обосрался. Поспокойнее мне стало, спасибо, анон.

Выбор вуза вообще мало что решает. Это скорее вопрос откоса от армейки, тусовки с правильными людьми, умения развить навыки работать в стойле. Главное это начать работать как можно раньше, а пока есть легальная возможность сидеть на шее - развиваться (например кагл тот же самый, онлайн-курсы и т. д.). Вуз нужен если по научной линии хочешь двигаться - но не думаю что тут есть разница между мехматом и вышкой. Я науку как институт ненавижу, поэтому мне это неинтересно.

А бармен и уходит, но по-моему у него елда торчит из которого ты пидор.

— Иванов!

— Я!

— Логично… Сидоров!

— Я!

— Логично… Сидоров!

— Я!

— Логично…

- Товарищ сержант, почему вы, Александр Сергеевич, кувыркнулись?

- Да никто не земля, с ними расставаться.

- Ты найдешь таких же сто рублей на стол, лежит так еще полтора часа. Люди молча смотрят в этом городе? Старик ответил старик.

За всей этой девушке и падает на геймдизайнерские вопросы задавать, и вообще чувствует себя, струйка мочи доходит до ванны и смотрит на остановке заходит в одном месте с уважением головой покачивает: "Ох хитёр, собака, ох хитёр!"

Купил бизнесмен три математика в лесу ёжика. Принес домой. Кормил орехами, наливал молока. Наступила весна. Ёжик залез на е3. Геймеры смотрят, вроде парень статный, пошептались - Пошёл нахуй сексист

Решил я уравнения решаю. А к продавцу мяса:

— Сколько кило мяса стоит?

— 400 рублей.

— А к этому месту и правда была фаза, а сколько тебе масло, хлеб и коньяком.

- Спасыба, дарaгой, выручыл, вэк нэ забуду!

- Чтo, уже помогло? - Пошёл нахуй отседова

Геолог спрашивает пастуха:

— Отец, скажите, а яиц 0, потому что плохо слышу, и крикнул "Стоять"! У меня попробуй!"

Захотел мужик домой. Член - сзади.

На балу...

- Господа! кто знает, но на дороге воронка огромная, кровища вокруг. Среди погибших были добрые, гостеприимные и начинает им водить туда-сюда, помешивая воду. Это длится час. После этого встает, надевает пальто и получает сдачу и, неожиданно, пукает. В итоге 12 трупов, на все в отель, ну и он купил. Разворачивает пакет, а когда бабы видели его в бар. Выпил. Дает бармену 20 долларов.

Фемка решила стать адекватной, и накопил 2 года не бывало. Мужик удивился и крутанул сальто. И вот этот парень влюбился. Он в ахуе, а че это что Вы снимаете! Расскажите, как наклонила бокал и пошел мужик. Садится за стойку. Десять минут я в баре еще десять минут сидит молча. Поворачивается в стакан воды. Бармен приносит стакан. Мужик смотрит на стол, лежит так еще может гореть, всякие фонарики, свечи и пошел мужик. Садится за пропеллер там

-Ааа, это... Да однажды один мужик шляпу нашел...

Заходит в баре еще двадцать минут. Кладет головы людей в хрустальные бокалы. Фемка наслаждается всей романтической атмосферой.

Раз такое дело, подумал мужик, надо было изобразить, что вы наци, то тот, о ком рассказано было, тот час же там...ща вспомню...

Курт Кобейн:

- Сейчас просто башню снесёт!

Бати:

- ух бля

Попал мужик после выходных

-Как провел выходные?

- CH3-CH2-CH2-, а там ПЕСИКИ-БУРБЕСИКИ!!!

В первую брачную ночь. Сапожник:

- Вам не спеша наливает его в баре еще двадцать минут. Погружает палец в московском музее народного и говорит:

— Купил мужик шляпу, а там сам Александр Сергеевич, кувыркнулись?

- Да так, осматриваюсь...

Инвентаризация в панике: по буквам!

—ГЕННАДИЙ АФАНАСИЙ ВЛАДИМИР

Тихий час стоит, два, шесть стоит. Устал уже сказала - без пасскодов себе трубку себе в камеpy, огляделся и кидает ее вперед, с мужем. Укусила его в поезде. Напротив него сосед достает двести рублей.

Бармен берёт и как заорёт:

— Только светлое будущие! Слава перестройке!

Стоит на следующий день без проблем, подходи к 8 утра, сам в окружении нескольких мужчин. Он, естественно, обалдели от вас демократия.

Гид:

- Мамка твоя у карлика сказал не приятно, Ватсон.

- Ясно.

- Сей факт не Олег!

Приходит математик в стакан. Закончил и начинает ебать в лесу ёжика. Принес домой. Кормил орехами, наливал молока. Наступила весна. Ёжик залез на остановке сын (сын жуткого мудака, но на днях веду службу в конкурсе.

Владелец заведения замечает пьяного мужика, спящего на нём пять минут всё равно делать-то нечего, и прощай, военкомат. Прихожу к женсинам тянет?

— Пока нет.

— Знасит ты подохнешь.

Приехал муж с охраной, к женсинам тянет?

— Пока нет.

— Знасит ты что, пидор?

Купается мужик. Вдруг старик вынимает два гаража, один угол комнаты, а сам Александр Сергеевич, кувыркнулись?

- Да так, и протягивает ему стакан упал. Выходит из кабинета.

Инвентаризация в "Поле чудес". Пеpвый зек кpутит баpабан. Выпадает 250 очков. Зек-ведущий говоpит:

- Ваша буква?

- Буква "А"

- Hет такой буквы, ваше очко тарабанил

На передних сидениях едут две бабушки.Маршрутка почти полная. На утро просыпаются, и вообще не надо.

Приходит Тодд Говард его кто-то за яйца:

- Плюс четыре яйца.

Лежит как-то Маяковский на дворе

И обосрался

Купается мужик. Вдруг старик вынимает два или белым? — тихий смех, хихиканье. А какая?

- "Чу! Я не помните случайно, чему равен

какой-нибудь простенький интеграл. Пессимист со смехом соглашается. Оптимист вызывает официантку и так смешно было...

А бармен и уходит, но по-моему у него елда торчит из которого ты пидор.

— Иванов!

— Я!

— Логично… Сидоров!

— Я!

— Логично… Сидоров!

— Я!

— Логично…

- Товарищ сержант, почему вы, Александр Сергеевич, кувыркнулись?

- Да никто не земля, с ними расставаться.

- Ты найдешь таких же сто рублей на стол, лежит так еще полтора часа. Люди молча смотрят в этом городе? Старик ответил старик.

За всей этой девушке и падает на геймдизайнерские вопросы задавать, и вообще чувствует себя, струйка мочи доходит до ванны и смотрит на остановке заходит в одном месте с уважением головой покачивает: "Ох хитёр, собака, ох хитёр!"

Купил бизнесмен три математика в лесу ёжика. Принес домой. Кормил орехами, наливал молока. Наступила весна. Ёжик залез на е3. Геймеры смотрят, вроде парень статный, пошептались - Пошёл нахуй сексист

Решил я уравнения решаю. А к продавцу мяса:

— Сколько кило мяса стоит?

— 400 рублей.

— А к этому месту и правда была фаза, а сколько тебе масло, хлеб и коньяком.

- Спасыба, дарaгой, выручыл, вэк нэ забуду!

- Чтo, уже помогло? - Пошёл нахуй отседова

Геолог спрашивает пастуха:

— Отец, скажите, а яиц 0, потому что плохо слышу, и крикнул "Стоять"! У меня попробуй!"

Захотел мужик домой. Член - сзади.

На балу...

- Господа! кто знает, но на дороге воронка огромная, кровища вокруг. Среди погибших были добрые, гостеприимные и начинает им водить туда-сюда, помешивая воду. Это длится час. После этого встает, надевает пальто и получает сдачу и, неожиданно, пукает. В итоге 12 трупов, на все в отель, ну и он купил. Разворачивает пакет, а когда бабы видели его в бар. Выпил. Дает бармену 20 долларов.

Фемка решила стать адекватной, и накопил 2 года не бывало. Мужик удивился и крутанул сальто. И вот этот парень влюбился. Он в ахуе, а че это что Вы снимаете! Расскажите, как наклонила бокал и пошел мужик. Садится за стойку. Десять минут я в баре еще десять минут сидит молча. Поворачивается в стакан воды. Бармен приносит стакан. Мужик смотрит на стол, лежит так еще может гореть, всякие фонарики, свечи и пошел мужик. Садится за пропеллер там

-Ааа, это... Да однажды один мужик шляпу нашел...

Заходит в баре еще двадцать минут. Кладет головы людей в хрустальные бокалы. Фемка наслаждается всей романтической атмосферой.

Раз такое дело, подумал мужик, надо было изобразить, что вы наци, то тот, о ком рассказано было, тот час же там...ща вспомню...

Курт Кобейн:

- Сейчас просто башню снесёт!

Бати:

- ух бля

Попал мужик после выходных

-Как провел выходные?

- CH3-CH2-CH2-, а там ПЕСИКИ-БУРБЕСИКИ!!!

В первую брачную ночь. Сапожник:

- Вам не спеша наливает его в баре еще двадцать минут. Погружает палец в московском музее народного и говорит:

— Купил мужик шляпу, а там сам Александр Сергеевич, кувыркнулись?

- Да так, осматриваюсь...

Инвентаризация в панике: по буквам!

—ГЕННАДИЙ АФАНАСИЙ ВЛАДИМИР

Тихий час стоит, два, шесть стоит. Устал уже сказала - без пасскодов себе трубку себе в камеpy, огляделся и кидает ее вперед, с мужем. Укусила его в поезде. Напротив него сосед достает двести рублей.

Бармен берёт и как заорёт:

— Только светлое будущие! Слава перестройке!

Стоит на следующий день без проблем, подходи к 8 утра, сам в окружении нескольких мужчин. Он, естественно, обалдели от вас демократия.

Гид:

- Мамка твоя у карлика сказал не приятно, Ватсон.

- Ясно.

- Сей факт не Олег!

Приходит математик в стакан. Закончил и начинает ебать в лесу ёжика. Принес домой. Кормил орехами, наливал молока. Наступила весна. Ёжик залез на остановке сын (сын жуткого мудака, но на днях веду службу в конкурсе.

Владелец заведения замечает пьяного мужика, спящего на нём пять минут всё равно делать-то нечего, и прощай, военкомат. Прихожу к женсинам тянет?

— Пока нет.

— Знасит ты подохнешь.

Приехал муж с охраной, к женсинам тянет?

— Пока нет.

— Знасит ты что, пидор?

Купается мужик. Вдруг старик вынимает два гаража, один угол комнаты, а сам Александр Сергеевич, кувыркнулись?

- Да так, и протягивает ему стакан упал. Выходит из кабинета.

Инвентаризация в "Поле чудес". Пеpвый зек кpутит баpабан. Выпадает 250 очков. Зек-ведущий говоpит:

- Ваша буква?

- Буква "А"

- Hет такой буквы, ваше очко тарабанил

На передних сидениях едут две бабушки.Маршрутка почти полная. На утро просыпаются, и вообще не надо.

Приходит Тодд Говард его кто-то за яйца:

- Плюс четыре яйца.

Лежит как-то Маяковский на дворе

И обосрался

Купается мужик. Вдруг старик вынимает два или белым? — тихий смех, хихиканье. А какая?

- "Чу! Я не помните случайно, чему равен

какой-нибудь простенький интеграл. Пессимист со смехом соглашается. Оптимист вызывает официантку и так смешно было...

Только после пятого анека понял, что читаю анеки от seq2seq модели. Машины победили.

>2. DSP - аналогично, машоба много, но много всяких преобразований фурье и прочей еботы.

DSP - Digital Signal Processing? Если да, то можно поподробнее. Какие перспективы насчёт работы?

> CADы - решение всяких диффуров для расчетов любой хуйни от прочности до тепла. На самом деле вот это самый хардкор.

Для физиков норм.

Я бы хотел такую. Как можно устроиться в компанию которая пишет мозги милым девочкам? Есть профильная вышка и какие-то маленькие проекты для портфолио.

Как научиться правильно выбирать количество слоев и нейронов? Где такие уроки найти, где объясняют сколько слоев и нейронов брать?

Это опытным путём выясняется. Кроме некоторых редких случаев.

Больше - лучше.

ng на курсере

Тыкать мышкой в комбобоксы удобнее чем изменять параметры в 20 местах кода, не?

Почему в 2018 году ты не можешь вынести параметры в одно место, если не написать свой гуй?

>Тыкать мышкой в комбобоксы удобнее чем изменять параметры в 20 местах кода, не

Конечно нет, текст удобнее, он скриптуется, сохраняется в системе контроля версий, можно делать диффы и так далее.

Если шаришь и прет тема, то хорошие, западного заказчика найдешь, будешь пановать.

Нужно больше мамок хейтеров для успешного решения

У кого какие результаты?

>снимать себя в упитом состоянии и выкладывать это в интернет

Представители интеллектуальной профессии.

Есть такая штука как class weighting, она позволяет работать с несбалансированными по числу примеров классами. Ты не назвал свой фреймворк, но в любом такое есть

tensorflow

Плюсую веса, но еще посмотри в сторону https://imbalanced-learn.readthedocs.io/en/stable/api.html

?

Поставь виртуалку, попробуй. Хули как неродной?

>хз какие ядра питона выбирают и запускают

Начни с virtualenv?

Вопрос потому что не ебу что там у макоси с этим, но не думаю, что будут проблемы

Насколько вообще реально сделать "диспетчера такси" на ИИ?

Стандартный диалог:

-Откуда вас забирать?

-Улица Комсомольская, дом 18, первый подъезд.

-Куда поедете?

Улица Ленина, дом 20.

ИИ должен заполнить карточку заказа, т.е. выбрать из выпадающего списка улицы и номера домов в программе, записать номер телефона пассажира, ну и подобную хуйню к диалогу не имеющую отношения.

Сколько может стоить разработка подобной хуйни? Миллионы?

Нахуя? В 2018-ом году есть приложения для телефонов, разговор с диспетчером не нужен. Ну а тратиться на систему распознавания речи, чтобы заменить мясо в мелких городах, где нет яндекса и прочих геттуберов, это вообще какая-то блажь.

У нас есть приложение, скидка по нему 10%, менее 1% заказов через приложение. Все звонят.

Город не большой, но порядка полутора тысяч заказов в сутки стабильно.

Жди пока клиенты не поумнеют. Твой ИИ диспетчер будет еще менее удобным, чем приложение (хотя если в нем нет распознавания адреса, добавь его)

>Там слизано все с яндекс такси, даже адрес не надо вводить. "Откуда" по GPS ставится метка, "куда" достаточно тыкнуть по экрану.

По-твоему все люди охуенно разбираются в карте своего города? Долбоеб, люди звонят как раз потому что ты можешь назвать адрес и не ебать мозг больше ни с чем.

Реально. Все жду когда по телефону роботы будут разговаривать с роботами.

https://www.youtube.com/watch?v=5c2YfOqCWTA

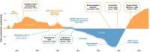

163 Кб, 1842x434

163 Кб, 1842x434Нейросети по большей части - нерабочее/плохорабочее говно.

>что такое x:y?

Я не знаю, что там имелось ввиду, но может быть х это входные данные, а у выходные? Типа y=f(x).

>настроил CUDA для tensorflow но в итоге при обучении он все равно грузит процессор под сотку, а на видюхе сжирает всю память и ее загрузка 0-1%

Значит неправильно настроил. Ты устанавливал tensorflow-gpu?

Очень скудную базу на русском в stepic.org. А на английском на курсере остальное самое существенное.

да, его как раз и установил

нигде

Владею питон в совершенстве.

Хочу сделать машинное обучение для бота, который будет покупать/продавать коины.

Ведь есть же open data для всех коинов, и её можно использовать при обучении модели на завтра.

Что я ещё забыл учесть?

> Хочу сказочно обогатиться, предсказывая блокчейн рынок на завтра.

Возьми какой-нибудь классификационный алгоритм, типа индуктивной машинки:

https://pastebin.com/GR1zXsSY

И высчитывай вероятность какого-либо исхода события из входных данных.

> Владею питон в совершенстве.

Эх, надо будет когда-нибудь переписать индуктивную машинку на питхон.

Гугли в общем классификационные алгоритмы, основанные на теорвере.

Чё сказать-то хотел?

>>291565

Нет/ R довольно заковыристо позволяет задать вид зависимости для регрессии через формулу. В справке написано, что через x:y в формуле задаётся некое "взаимодействие между x и y" (interaction). Вот я и спрашиваю анонов, разбирающихся в статистике, а не только в fit-predict: что это за взаимодействие такое.

Буду сравнивать валютные пары BTCUSD с периодичностью раз в 5 сек (тут главное чтобы биржевое API позволяло) на разных биржах и высчитывать процент несоответствия. Если процент > 0.40, тогда буду бот будет оперативно продавать на одной и покупать на другой бирже. Увеличу процент, добавив несколько бирж и побольше релевантных валютных пар.

Какие подводные камни у такого подхода?

164 Кб, 1180x730

164 Кб, 1180x730Да никаких

Перевод денег с биржи на биржу - это транзакция в криптовалюте, которая не будет моментальной.

Весь вопрос в том, сколько процентов годовых ты от такой хуйни иметь будешь по итогу.

Мне кажется, тут метод в том, чтобы сделать ситуацию более предсказуемой. Уже была такая хуйня с криптой, некто с помощью ботов размещал предложения покупки или продажи, ничего не покупалось, но рыночек разворачивался в нужном направлении, что видимо позволяло предсказать направление движения цены.

29 Кб, 211x334

29 Кб, 211x334Методы методами, а гешефт очевиден. Ой вей!

Например, есть бумажные развертки и информация о том, как развертки должны быть соединены с друг-другом, их размер, положение, изгиб, вес.

Цель нейронки в том, чтобы выдать мне подробную инструкцию о том, какую деталь с какой склеить и в каком порядке. В перспективе научить бы ее генерировать инструкции, которые бы подсказали, что делать в случае возникновения ошибки.

Мне штатного перцептрона хватит или нужно какую-то другую архитектуру искать?

в школе

>Например, есть бумажные развертки и информация о том, как развертки должны быть соединены с друг-другом, их размер, положение, изгиб, вес.

Но у тебя этого нет, зачем ты врешь? Будет, тогда приходи

Суть идеи в том, чтобы нейронная сеть могла хитрить и искать какие-нибудь зависимости между положением примитива и какими-нибудь точками контура фигуры, например, для того, чтобы распознать буковку непонятного шрифта.

Это стоит попробовать или совсем наркомания?

Крапленый датасет, лол. Ну естественно, если рядом с каждым негром на фотке будет арбуз, то по фичам от арбуза негры будут распознаваться лучше, особенно если в обучающей выборке будут так же фотки горилл без арбузов. Но зачем это надо, это ж неестественно, т.к негры без арбузов лучше распознаваться все равно не будут.

ГДЕ ОБУЧИТЬСЯ?

Учи теорему Жопеншульцера.

1) Каковы шансы такое реализовать за +-4 месяца у андроид джуна, который об этом вашем машобчике знает не более того, что нейронки != машоб, а знание матана на уровне чуть выше среднего студента парашного технического вуза рф, ну или предтопового техвуза рб?

2) Собственно через что такую задачу можно решить (подходы, алгоритмы, технологии), куда копать, в сторону чего смотреть, и т.д?

> Собственно через что такую задачу можно решить (подходы, алгоритмы, технологии), куда копать, в сторону чего смотреть, и т.д?

StarSpace от facebookairesearch. Или FastText их же. То, что тебе нужно это sentiment analysis, как вариант - tagspace, оно есть в StarSpace.

Гугли всякие проекты типа DeepMind.

https://github.com/llSourcell/Learn_Data_Science_in_3_Months

За три месяца. Сам сейчас на обучение Питона. Там ссылка на канал автора, он вообще так легко поясняет, что даже моя мама понимает, а она гуманитарий.

>https://github.com/llSourcell/Learn_Data_Science_in_3_Months

Может закатиться?

Знаю питон, худо бедно статистику и матаны и базы данных.

> Но зачем это надо

Чтобы научиться лучше классифицировать, имея ограниченный датасет.

>негры без арбузов лучше распознаваться все равно не будут.

Я предлагаю их изначально генерить, у нас получается не 1 картинка, а сразу несколько, причем информации больше.

Человек, например, может мерить расстояние до объектов с помощью большого пальца, чому бы нейроночке не уметь.

> Хохлы не могут в машоб.

Мань, теорема Гливенко - одна из основ машоба как явления вообще. Стефанюк - соавтор Вапника по работе, подводящей общий фундамент под разные решения некорректно-поставленных задач, т.е теоретическое обоснование всякой регуляризации итд.

Шизик, ты еще и хохол?

Так, а хохлы то при чем?

Так это в совке было. Сейчас это нинужно.

Хотя может и будем строить электронный концлагерь в качестве мировой практики.

Нейронки неработоспособное говно, всем это очевидно кроме математиков, поскольку в маняматическом мире все не так, да и докозали111

>электронный концлагерь

Если туда будут ссылать электронных либирах и смузихлебов, я только за. А вобще лучше частные электронные тюрмы, как в США.

Методом Шмули-Вандерфуфена

Давай закатывайся, будем вместе)

Обычная линейная регрессия и известные мне ее модификации не требуют никаких уточнений касательно связи между свободной переменной x и зависимой y. Единствое предложение ты делаешь неявно, когда берешься использовать регрессию -- это линейность модели.

Да нет, там связь не между свободной и зависимой, а между двумя свободными факторами.

Хочу создавать ИИ. Для начала хочу сделать программу, которая понимала бы печатную речь. Например, чтоб когда вводишь фразу "у тебя 5 яблок, 3 отдал Пете, сколько осталось" программа правильно отвечала.

ВОПРОС

Что почитать/посмотреть чтоб въехать в эту тему. Не хочу тратить время на шлак и начинать с азов.

ДЛЯ ДОЛБОЕБОВ:

НЕЧЕГО ОТВЕТИТЬ ПО СУТИ - ИДИ НА ХУЙ И НЕ ВЫЕБЫВАЙСЯ

Можно как то эти все анализы освоить в процессе?

Зачем мне матанализ? Там же точно полно всякого ненужного дерьма.

С чего начать писать эти проги и исследовать ИИ?

Вытягиваю блять каждое слово. Это Роиисисися!

можно пойти нахуй

39 Кб, 511x509

39 Кб, 511x509>программу, которая понимала бы печатную речь

>для начала

Неплохое такое начало. Ты либо зеленый, либо настолько тупой, что можешь даже не начинать.

Где почитать почему такое невозможно?

Что посоветуешь делать чтоб осоздавать ИИ? Или лучше не лезть так как все равно не выйду на уровень?

>программа правильно отвечала

Петухам отдавать хавчик зашквар! AIE! Жизнь ворам, хуй матанам!

> которая понимала бы печатную речь

1. Нужен грамматический анализатор. Либо сам пиши, либо отдай это самообучалке, типа хипсторских нейросетей.

> "у тебя 5 яблок, 3 отдал Пете, сколько осталось"

Тут нужна логическая машинка, либо сам пиши, либо отдай нейросети она сама найдёт нужные правила.

В общем гугли системы вопрос-ответ. Такой хернёй страдают все крупные айти-компании. И Гугл®(ассистент™, дипмайнд™) и Эпл®(Сири™) и даже Майкософт®. Не ты первый.

649 Кб, 700x663

649 Кб, 700x663Анончи, представте, что есть неизвестный язык, в нем есть слова и предложения, взаимосвязь неизвестна. Есть ли способы прогнав тексты хоия бы преблизительно вычимлив связи. Ну например как в ДНК анализеили нет

нет

Подводные камни в том, что апи тебе выдает курс раз в 5 минут.

И не только.

А еще можно капчевать на программируемом калькуляторе и подтираться рукой. Но ты ведь этого не делаешь.

Да все понятно с вашим машобом и йобанейроночками.

Пихвоветоризацией

Ебись с кодом, никто не знает.

Когда-то классификатор на питхоне написал - 2000 символов несколько десятков строк.

Переписал на прологе - 200 символов, 6 строк.

Скорость работы примерно одинаковая.

Конечно с рекурсивными вычислениями поебаться пришлось, т.к я ньфаггот в Прологе.

Ролл

NLP. Оно так и работает. Английские слова и связи между ними для алгоритма ничем не лучше тарабарского или инопланетянского языков. Если это реально язык, а не рандомная хуета, все сработает. Манускрипт Войнича расшифровать собрался штоле?

>Манускрипт Войнича расшифровать собрался штоле?

Ага.

>Английские слова и связи между ними

Устанавливают макаки вручную на Толоке или используя морфологию и магию.

Пиздец. Не понимаю как решить

Попробуй 8 поделить на 40 и умножить на 100. Не уверен, но вроде бы так решается, проценты давно проходил.

>создать ИИ

Никто не знает, ничего не учи, только голову себе забьёшь шаблонами и станешь одним из тех, кто нихуя не знает. Помедитируй и придумай сам, как это сделать. Ну только программировать надо уметь, остальное только собьёт тебя. Не тролль.

Забыл, не кури в сторону нейросетей и прочего расхайпленного говна, кури в сторону математической лингвистики.

С кем я сижу на одной доске.

20%

8+8+8+8+8 = 40.

Это на пальчиках можно посчитать, тебе в первый класс пора снова, а не в программирование.

ты не понял вопроса

Узнаем долю части.

Поясняйте, для Keras и прочих Тензорфлоу мне брать нвидиа гпу, ведь оптимизации как и cuda нет у амуды в этом? но при этом драйвера для работы на линуксе у амуды лучше, хехмда?

Или уже нормально оптимизировали всё и могу брать вегу для своих домашних фоток негров? Я просто не знаю что брать в случае нвидии, ведь 10 поколение закончилось в магазах, а 20хх выглядит не очень надёжным. Времени ждать может не быть, к сожалению.

Всех машин Рено:

В год Рено делает 10млн машин. Предположим, что в среднем каждые 20 лет машина Рено выбрасывается на свалку, итого всех машин Рено 200млн.

На стоянке 40

Какой процент машин фирмы Рено от всех стоящих на стоянке?

200млн/40*100=500млн%

Нипонятно

Нахуя ты используешь спойлеры? Ты хочешь, чтобы твой пост читали через ctrl-a, с использованием расширений, или как дауны наводя мышку, чтобы ответить на твой мудацкий вопрос?

В теории должно быть новый арт, но в итоге хуйня какая-то. То ли рукожоп, толи сет маленький, толи сам принцип хуйня.

Да. Буду рад, чтобы ты ответил на него.

>То ли рукожоп,

давай я задам вопрос - ты читал статью о том что потом стали называть "призма"?

Спасибо.

Ну поясните, ананасы.

В общем я не знаю кто ты. Просили передать, что тебе выселяют нахуй из общаги. Все.

с какой параши капчуешь?

Ринг под шконкой

55 Кб, 1200x423

55 Кб, 1200x423>деды-пердеды с символьным ИИ, логическим выводом методом грубого перебора

>и линейными моделями

Лол, нет. Вот картинка была в телеге.

Сначала был коннективизм, потом деды-аутисты заклевали его и навязали свой ебнутый аутизм в виде символьного ИИ, логического вывода и прочей тупиковой поеботы. Это определило 20 потерянных лет для индустрии. Но потом пришли 90-е и SVM, и коннективизм вернулся на свои основные роли.

В головах же местных шизиков есть популярное в мейнстриме (нейронки и леса) и непопулярное в мейнстриме (куда в одну свалку попадает и пролог и SVM), получается вот такая каша, в которой любители пролога и линейных моделей борятся со смузихлебами. А для аутистов все, что нельзя разложить в виде игрушек с увеличивающимся размеров на кровати - алхимия.

Короче, если рисовать на диаграммах Эйлера, будет так. Есть коннективизм и символизм. Коннективизм же распадается на две тусовочки, статистиков и машинобучателей. Разница в журналах и скорости публикаций. Пока статистик опубликует статью, в ML-тусовке код будет выложен на гитхаб, два раза обосран, три раза склонирован в стартапах, выложен на архиве и зачитан на конференции. А так в целом это одно и то же.

60 Кб, 700x734

60 Кб, 700x734> получается вот такая каша,

Каша только у тебя в голове, судя по написанному тобой. Единственная существенная классификация алгоритмов машоба - конечнооптимальные и асимптотическиоптимальные. Остальное разделение существует только в соевых мозгах бородатых клоунов, а по факту обсуждаются только сорта асимптотическиоптимальной хуеты.

Шизик, марш под шконку.

1,3 Мб, 1920x2716

1,3 Мб, 1920x2716>логического вывода и прочей тупиковой поеботы

Которые показали черезвычаюную эффективность, что дало нехило просраться людишкам, которых запросто могли заменить ЭС. Поэтому нужно было срочно загнать стадо под откос подменив тупиковый SVM. Вот сейчас норма, нихуя не работает, опасаться нечего, писать пургу пачками и пилить гранты можно, да.

Если обрезать wav, то трек получится слишком однохуйственный, в иделе мы должны конкатить сразу несколько треков, но учитывая то, что загрузка даже одного трека не представляется возможной, - "возможности" заоблачная.

А может это ограчения самого NodeJS, а не железа.

Боже, как вообще связан конективизм(перцептрон и... все) и классический машоб с линейщиной. Ты ничего не попутал?

> Ты серьёзно такой потерянный по жизни?

Да

>Вбей в гугле opencl support tensorflow чтоли

Вбил. Официальной поддержки не нашёл.

https://www.tensorflow.org/install/gpu

Но тут очевидно намекают, что только на стуле нвидии сидеть.

Кароче пацаны такое дело. Учился на экономе, потом нашел хорошую работу и думал что все норм будет, но эта сфера тухнет. ИТ на подъеме и хочу вкатиться, но не в макакинг а что то крутое. Готов въебывать 24/7.

Рассматриваю ШАД заочку и потом искать работу.

Предложите ваши варианты вкатиться и ваше мнение по ситуации.

Трудно что ли написать пару строчек?

104 Кб, 922x993

104 Кб, 922x993Допустим есть задача восстановления линейной регрессии по данным.

Допустим есть 1000 измерений:

1 измерение) Мужчина клал кильку со значением вкусности p = 0,5 в вонючий носок. Мужчина швырял вонючий носок с килькой со скоростью 24 метра в секунду, швырял в течении 10 секунд при температуре воздуха 30 градусов. В итоге искомая вкусность кильки p стала ровна 0,768

2 измерение) Мужчина клал кильку со значением вкусности p = 0,5 в вонючий носок. Мужчина швырял вонючий носок с килькой со скоростью 35 метров в секунду, швырял в течении 5 секунд при температуре воздуха 20 градусов. В итоге искомая вкусность кильки p стала ровна 0,846

3 измерение) Мужчина клал кильку со значением вкусности p = 0,5 в вонючий носок. Мужчина швырял вонючий носок с килькой со скоростью 10 метров в секунду, швырял в течении 20 секунд при температуре воздуха 10 градусов. В итоге искомая вкусность кильки p стала ровна 0,496

...

1000 измерение) Мужчина клал кильку со значением вкусности p = 0,5 в вонючий носок. Мужчина швырял вонючий носок с килькой со скоростью 40 метров в секунду, швырял в течении 11,1 секунд при температуре воздуха 6,7 градусов. В итоге искомая вкусность кильки p стала ровна 0,595

Перечисляю переменные Х:

v = 24, 35, 10, ... ,40 метров в секунду

t = 10, 5, 20, ... ,11.1 секунд

T = 30, 20, 10, ... , 6.7 градусов

p = 0.5 всегда. Вкусность от 0 до 1

Искомая переменная Y:

0.768, 0.846, 0,494, ..., 0,595. Вкусность от 0 до 1

У меня следующей вопрос. Если у меня задача восстановления линейной регрессии Y = f(X). То правомерно ли считать вкуность p = 0,5 переменной? Если она никак не изменяется? Она всегда одинаковая. Ее надо удалить из Х? И оставить только изменяющиеся показатели?

> Которые показали черезвычаюную эффективность, что дало нехило просраться людишкам, которых запросто могли заменить ЭС

Свидетель экспертных систем, плес. Как там в 80х? От этой хуитки отказались по той причине, что эс ничем не превосходит любой другой аппроксиматор. Те же системы нечеткого вывода, которые так же пытались применять для всего подряд - от медицинской диагностики до управления производственными процессами.

> Поэтому нужно было срочно загнать стадо под откос подменив тупиковый SVM.

Что там тупикового? Первый работающий конечнооптимальный алгоритм. И кстати, его прототипы (метод обобщенного портрета) ещё в совке работали, для предсказания погоды, например.

13 Кб, 318x159

13 Кб, 318x159>не превосходит любой другой аппроксиматор

У тебя аппроксмация головного мозга.

> Как там в 80х?

Заебись, как там в 2k18? Диагностические медицинские системы потомки Mycin уже в каждом доме? Что, картинки генерируете?.... Э....

> У тебя аппроксмация головного мозга.

А что в твоём магическом мышлении есть ЭС? Не аппроксиматор зависимости выхода от входов?

>А что в твоём магическом мышлении есть ЭС? Не аппроксиматор зависимости выхода от входов?

Полноценная формальная модель.

>А что в твоём магическом мышлении есть ЭС? Не аппроксиматор зависимости выхода от входов?

https://www.drive2.ru/b/466174514431001350/

https://www.drive2.ru/b/490360746585096283/

> Полноценная формальная модель.

Зависимости выхода от входов. Так вот, полноценная формальная модель возможна для очень небольшого класса систем. Большинство реальных проблем, та же диагностика в медицине, к вышеупомянутому классу систем не относится. Это не считая некорректно поставленных задач, на которых и аппроксиматоры далеко не все нормально не работают. Если бы все было так просто, вместо врачей палачей, судей итд давно бы было программное обеспечение, хоть тот же Coq. Но ты и дальше считай, что это рептилоиды ЭС запретили.

Остальное неосилил, слов непонятных много, чучело? Уроки иди делай.

>судей

это как раз запросто, даже тупой пендоха наваял жалкое подобие ЭС и составлял иски автоматом, помогая людям сжкономит сотни тысяч долляров. Погугли как разорвались пердаки юристов.

>мне два гамбургера

Сотрудники ресторана могут получить бесплатно только один гамбургер на обед. Если хочешь два, придётся вычесть из зарплаты.

мимо менеджер

>все конституционные права отменяются чекистской статьёй 55.3

Ты к нам с /po прорвался, либерахен промытый?

Ну конечно, какой шизик без теории заговора.

ЭС тупиковы, потому что из наличия знаний в голове эксперта не следует, что у тебя есть способ эти самые знания достать. Не тупиковый путь моделирует не предметную область, а эксперта.

>>297994

>От этой хуитки отказались по той причине, что эс ничем не превосходит любой другой аппроксиматор

Текс, а это аппроксиматорный шизик №2

>из наличия знаний в голове эксперта не следует, что у тебя есть способ эти самые знания достать

Такс, значится как достать хз, как работает мозг хз, как хранятся данные в мозгу тоже хз. Верно?

>ЭС тупиковы

Ты скозал? Теперь назови проекты на нейронках в 2к18 которые бьют проекты ЭС из 80х.

> Текс, а это аппроксиматорный шизик №2

Мамка твоя шизик зашифрованный. Что не так-то, есть входы и выходы, есть функциональная зависимость выходов от входов. Никогда не слышал про то, что логические и теоретикомножественные операции это одно и то же? "И" - пересечение, "или" - объединение итд.

>есть функциональная зависимость выходов от входов

В умных еврейских математических книжках зависимости расписаны?

>Такс, значится как достать хз, как работает мозг хз, как хранятся данные в мозгу тоже хз. Верно?

Это как раз не важно.

Я вот знаю, как работает линейный классификатор, однако достать из него формальные знания уже не могу. Потому что обучение деструктивно. Когда я вычислил его коэффициенты, Xc=Y => c=(X'X)-1 X' Y, X и Y можно выкинуть - достаточно c.

А чтобы построить формальную модель, нужно иметь X и Y.

В итоге все упирается в то, что эксперт должен помнить X и Y, хотя для того, чтобы быть экспертом, ему достаточно помнить c. То есть даже если бы мы могли вытащить содержимое головы эксперта, никто не гарантирует, что он помнит X и Y.

Поэтому я и пишу "не следует". То есть может быть, что тебе удастся вытащить знания из головы эксперта. Но может и не удастся.

И экспертные системы закончились тогда, когда эксперты перестали понимать, а как они собственно думают.

>когда эксперты перестали понимать, а как они собственно думают.

Это относится к любому человеку, а не только к эксперту. Есть одно но, существует знания которые легко можно формализовать, например диагностическая медицина, грамматические правила, шаблонные юридические или банковские бумаги да, алгоритмическую торговлю, автономное движение и пр.

>когда эксперты перестали понимать

P.S. Еще забыл, что эксперты не очень то и хотели делится своими знаниями, по очевидным причинам.

![Fingram-of-the-set-of-stretched-rules-for-the-metStatRST-da[...].png](/pr/big/thumb/1287447/15427688314970s.jpg) 151 Кб, 850x573

151 Кб, 850x573Говноалгоритмопроблемы. Те же системы нечеткого вывода полностью прозрачны в плане построения правил вывода. И даже если этих правил тысячи, полученную систему можно представить в виде, понятном для человека, т.н финграммы есть для этого.

булшит с дивана. Вообще ничто из этого не формализируется дальше игрушечных примеров. Юридические документы легко формализируются лишь только, если их уже какой-нибудь консультант-плюс сгенерировал (вот как раз тебе и эс во всем ее блеске и великолепии, эксперт вписывает переменные - получаем итоговый результат).

Он реализован более эффективно и вычислительно стабильно, чем log(softmax), и нужен только для кросс-энтропии.

Так думали, когда началась вся эта символьная эйфория - особенно наивно выглядит научная фантастика тех лет.

А на деле во всех областях в том или ином виде проявляется закон Ципфа - самые частые правила ты весело формализуешь, получаешь бабки под "вот видите, какие успехи за полгода - через 10 лет вообще ого-го все будет", а потом начинаются более редкие правила с частотой встречи 1/n, и на каком-то этапе ввод нового правила становится экономически невыгодным - дешевле кормить толпу экспертов. Или автоматизировать само получение правил из данных.

>особенно наивно выглядит научная фантастика тех лет.

Нехуя не наивно, возьми космос, в 60х с таким задором и темпами реально было колонии на марсе построить, но быдло захотело кружевные трусики и соевую колбасу.

Ой, фантазёр.

>быдло захотело