Вы видите копию треда, сохраненную 2 ноября 2019 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Я ничего не понимаю, что делать? Либо в тупую import slesarplow as sp по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/ | Николенко и др. "Глубокое обучение" На русском, есть примеры, но уже охват материала

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: немодифицированные персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Предыдущий:

https://2ch.hk/pr/res/1440632.html (

Архивач:

http://arhivach.ng/thread/412868/

Остальные в предыдущих тредах

Там же можно найти треды 2016-2018 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

Анон, обозначь список вопросов, которые затрагивают на собеседования для датасатанистов, как опытных так и не очень.

Если ты умеешь нормально кодить, то половина задачи сделана. Пройди пару курсов на курсере по машобу.

>можно где-нибудь посмотреть на пример разметки датасета для сегментирующей с

http://cocodataset.org/#home

859 Кб, 1290x642

859 Кб, 1290x642Ага, я понял, значит для Unet у меня картинка может быть как справа?

Ты никому не нравишься. Какой-нибудь студент задаст вопрос, а в ответ получит от тебя кучу говна под видом конфетки. Создаётся впечатление, что общаюсь реально с дедом за 60. У меня в универе был похожий препод. Профессор, а кроме Паскаля ничего не знал.

> У меня в универе был похожий препод. Профессор, а кроме Паскаля ничего не знал.

Ты и паскаля не знаешь, хуле уж.

Как мне разметить данные для нее?

Если по сути - это проблема object detection, ведь мне нужно классифицировать обьекты и найти расположение нужного обьекта.

Короче, возьму вот это https://github.com/dotnet/machinelearning-samples/tree/master/samples/csharp/getting-started/DeepLearning_ObjectDetection_Onnx

Потому что object detection выдает тебе прямоугольник, а сегментация красит отдельные пиксели. В случае задачи "отправить в гугл только нужное", сегмантация + небольшой денойзинг и дилатация сработает лучше, чем тупые прямоугольники.

Это глупый вопрос, типа "какой автомобиль лучше всего едет".

когда уже тян с самотыком сделают?

Хм, но мне было бы удобнее просто находить блоки текста и отправлять их в OCR, со всем остальным она уже сама справится.

Еще можно было бы реализовать нахождение текста по клику.

Я вот такую статью нашел, очень даже близко к тому, что я хотел

https://medium.com/saarthi-ai/how-to-build-your-own-ocr-a5bb91b622ba

В моем наборе с оригинальными классами едва ли что будет связано, если я хочу детектить текст.

Или там всякие низкоуровневые штуки могут быть, которые помогут классифицировать мои объекты?

>для чего нужны pre-trained weight?

>В моем наборе с оригинальными классами едва ли что будет связано, если я хочу детектить текст.

>Или там всякие низкоуровневые

Для трансферлернинга

3,6 Мб, 375x346

3,6 Мб, 375x346Бамп вопросу.

Спасибо.

Таки установил все, интересно, мне сотки примеров хватит для того, чтобы Yolov3 находил текст в манге и не только

Тервер, матан, матстат, линал, основы вроде "как работают деревья".

А дальше зависит от специальности и уровня (например, вот парень собрал вопросы с собеседований в ~20 разных компаний, связанных с self-driving https://docs.google.com/document/d/1YyA11GE_3wfvLrr4X0ozpJYXNLMs4yAga-tx42ARdqU)

Начал обучать, по быстрому разметил 30 картинок и решил проверить.

Если оно хотя бы треть на таких данных сможет найти, то размечу куда больше.

У нейроночки есть плюс перед opencvq, ведь можно классифицировать данные и размечать данные.

Спасибо, но "Файл не обнаружен. Возможные причины ошибки: указан неверный URL или файл не существует."

Нужно накодить что-нибудь самому

Короче, довёл количество данных до 110 и поставил subdivisions в 32 при batch 64.

Отключил рисование графика и теперь обучение происходит куда быстрее, в прошлый раз он вообще завис

Очевидно у тебя на маленьком сете будет что-то вроде 38% успеха, лол. Больше раз в десять - уже 62%, дальше ещё тяжелее.

погуглил, похоже что вот ссылка которая ведет на вопросы

https://docs.google.com/document/d/1YyA11GE_3wfvLrr4X0ozpJYXNLMs4yAga-tx42ARdqU/edit

>>74048

Я до 110 довел сет утром и таки понял, что на моем CPU считать вообще не варик.

Так что если кто не знал, аноны, у гугла есть Google Colab, который предоставляет GPU на 12 часов.

Таки зная, что и это не очень солидно разметил еще сотню картинок, ну теперь посмотрим.

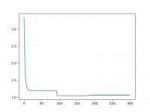

меняется learning rate

Хм, а на какой итерации это произошло?

У меня нейроночка сейчас учится, у нее learning rate ползет медленно

Погугли как adaptive lr реализован

13 Кб, 979x73

13 Кб, 979x73Или я в чем-то обосрался? Это Yolov3, если что

А, это я долбоеб и не так путь прописывал.

Нейронка справляется практически на 100%, очень хороший результат, стоило сразу ее взять.

Вот результат.

Стоит разметить еще как минимум 2к данных со всякими поворотами, фоновым текстом и прочим

регрессионная

До 3к планирую дотянуть.

Там есть еще версия tiny yolo, может она пошустрее и эффективность будет не хуже, у меня в приложении пользователи и на CPU будут, ведь не у всех нвидия, а так пару секунд - это уже многа.

Питон знаю, просто в вузе нужно сделать выбор между 2 вышеперечисленными. Склоняюсь к плюсам.

Пара секунд норм для нейронки, обычно юзер ждёт 3-4.

>Плюсы для выката в продакшен и имплементации готового решения

Библиотеки же и так на плюсх пишут. На питоне только верхушка для взаимодействия с юзером. Не?

Не, все сложнее.

Да, так. Не слушай этого долбоеба.

Чё порвался? Кого я заебал?

Инструмент, как numpy. Что ещё сказать?

https://www.coursera.org/specializations/machine-learning-data-analysis

Сам хорошо знаю C, немного Python. Из Computer Science тоже что-то знаю. Матан из универа +- помню, начало этого курса напомнит. Збс курс?

Главное на кагл зарегайся и в соревнованиях начни участвовать, необходимый минимум там есть, а вот уже паралельно можешь курить сторонние курсы. Ну и в слаку зайди

Пусть какой-то анон подтвердит вот этот пост. Всегда думал что кагл бесполезен

Какая кормушка для сетки лучше?

Как можно использовать такую фичу, кроме как используя уанхот энкодинг?

Участвовал бы в каглах - понял бы шутку

Примерно как спортивное программирование и программирование. Для азов норм, но потом пути расходятся, потому что KPI у кагла сильно отличается от того, что происходит в бизнесе.

1.Зачем нужен коэф. детерминации, зачем он... ну отношение "верных" прогнозов и что? Чем он отличается от среднеквадратичной ошибки в плане использования?

2.Каким образом лассо регрессия "зануляет" некоторые веса, почему вообще такое происходит?

1. коэффициент детерминации: http://www.machinelearning.ru/wiki/index.php?title=Коэффициент_детерминации

2. Lasso: добавление L1 регуляризации эквивалентно решению оптимизационной задачи в гиперкубе, диагонали которого находятся в осях координат и центр в точке 0, таким образом с большой вероятностью решение Lasso находится в вершине гиперкуба и часть коэффициентов зануляется.

Градиетный бустинг Catboost и LightGBM поддерживает категориальные признаки. Или OneHot + LogisticRegression. Или как-то еще кодировать категории.

Если расписать шаг градиентного спуска с L1 и L2 регуляризацией, то станет видно что L2 уменьшает вес тем медленней чем меньше сам вес, а L1 изменяет его на фиксированную величину приближая к нулю вне зависимости от веса. Поэтому L2 просто сначала быстро занижает веса, а потом почти не изменяет, а L1 упрямо забивает в ноль.

Почитал, офигел, к матану адекватно отношусь, иногда с любовью, а иногда с ненавистью, нужен матанский бекграунд чтоб такое адекватно воспринимать, тервер и матстат изучаю сам и вопрос в том что нормально ли подучивать матан по мере необходимости или для адекватного вкатывания нужно сначала ебшаить бекграунд??

спасибо

Нужен интеллект, в любой книжке по машинному обучению есть достаточно математики, чтобы понять ее с математикой первокурсника (т.е. семестр матана и линала)

Если тебе хочется заниматься чем-то наукообразным, но при этом лень/не получается освоить матёшку то тебе как раз прямая дорога в датасайнц

И тем не менее тебе надо поднимать интерпретатор питона. Для риалтайм-систем нереально.

Можно и быстрее. Машоб это именно про мозги, а не про опыт.

Почему, питон может в async, вычисления идут на видюхе, поэтому софт-риалтайм вполне возможен. Оверхед у нас был что-то типа 10%

Сам учил, но хуева. Работать пойду через пару месяцев грузчиком.

В матан иди, опыт работы со statistica будет плюсом в резюме

аллоооу додик, течё сказали, забей на маняматику

вся матёшка там всё равно либо примитивна, либо специальна и если ты всеръёз считаешь что то что ты на какую-то особую кафедру пойдёшь определит будешь ты её понимать или нет, то тебе маняматиком ресёрчером в любом случае не быть, так что лучше дрочи опыт решения реальных задач, с которыми обычные слесари датанюхи по жизне сталкиваются

Извини, дружок, собираю информацию, для дальнейшей обработки и получения информативных признаков с целью формирования модели подготовки для последующего трудоустройства.

Умный ты мужик конечно, мне бы твои мозги

Вышка математическая и чуток в кодинге бекграунд, вкатывался года 2 с перерывами. Сейчас за жрат и опыт по удаленке стажером с основной совмещаю, если все норм будет под новый год перееду в офис с норм зп

учил сам, когда отчислили с физмата. От начала самообучения до работы джуном чуть меньше года. Отказов 5 получил, потом взяли. Учил питон и алгоритмы, на кагле что-то начинал делать

Вдохновляет, сам в шараге сижу, но заваливают пиздец иногда сплю по 4 часа, спасибо за твой пост

>От начала самообучения до работы джуном чуть меньше года

Начинал с датасаенсе или с другой сферы? ДСы? Какая-то маняфантазия.

1) Полностью self-contained

2) Доведут меня с уровня "хуй с 3 классами образования" до бога, который перечитывает ESL ради удовольствия.

Пробовал стартануть с ESL и Бишопа, идет ну просто пиздец туго. Хоть Бишоп пишет, что мол знакомство с теорвером необязательно, он дает небольшой справочный огрызок математической базы, где за полстраницы доходит до плотности распределения вероятностей. Пиздабол короче этот Бишоп. Приходится идти проходить доп. мат курсы, а это заебывает, потому что не ясен объем необходимой работы, чтобы осилить ESL.

Теория групп не пригодится, иди на тервер и еби мужика, чтобы заниматься актуальными вещами. Так и скажи, хочу в ML, он скажет типа, не ебу что это, принеси ему пару пейперов и скажи, что что-то подобное хочу.

>Пробовал стартануть с ESL и Бишопа, идет ну просто пиздец туго.

Мозг нормального человека не может изучать абстрактную хуйню без морковки в виде того, что ей за это будет, а информация в этих книгах никакой морковки не предлагает.

Начни с практики, как только почувствуешь, что математику не тянешь, математика пойдет со свистом.

Нету такого. Если бы было, это был бы единственный курс и единственная книга по машобчику в принципе.

Проблема не в мотивации, а в том, что я тупо не понимаю смысла части выкладок. Я начинал с ололо практического курса от мфти на курсере, говно уровня: суешь эту хуйню в другую хуйню и ХУЯК - получается новая хуйня. Меня такие навыки не устраивают, я хочу хорошо понимать, нахуя это все, почему так, а не иначе и т.д.

>Начни с практики, как только почувствуешь, что математику не тянешь, математика пойдет со свистом.

Каггл?

>Нету такого. Если бы было, это был бы единственный курс и единственная книга по машобчику в принципе.

А есть что-то типа серии курсов/книг? Чтобы можно было последовательно въебать хорошую книгу с упражнениями по линеечке, потом по теорверу, необходимому матану, а потом неотвлекаясь на подтягивание математики хуячить статистическое обучение с хорошей практикой?

>Проблема не в мотивации, а в том, что я тупо не понимаю смысла части выкладок

А чем тебе это мешает? Мозг кричит "сложна" и мотивация пропадает.

Эти книжки концентрированные, если бы там автор все расписывал, то

1. Книга была бы в 10 раз толще.

2. Не факт, что интуиции автора подойдут тебе.

>Каггл?

Я на апворке делал домашки студентам по этим темам. Кагл не люблю

Ну да, ты прав. Некомфортно постоянно искать, где бы прочитать про math-name-хуню.

>>78452

>Мехмат + PhD в сколтехе

ммм, а можно не ждать до следующего лета, потом сдавать экзамены (или егэ), а потом 7 лет учиться, а ПРОСТО взять и изучить нужные разделы математики? У меня как бы уже есть вышка.

Короче раз нет одного охуенного курса, то может быть есть список книг/курсов, которые можно пройти последовательно и стать гуру?

В данных нет:

- ни единого индекса от external банков по поводу заемщика

- ни единого признака истории клиента (какие кредиты брал, как пользовался лимитами)

Зато дали ссаную информацию про:

- семью

- работу

- проживание

А ЭТИ ФИЧИ Я РАНЬШЕ ПРОСТО ОТБРАСЫВАЛ и на похуе работал с временными данными

Какая же мне пизда!

Вопрос:

Также даны данные поведения пользователя на сайте (браузер, id страницы на которую заходил, время на которое заходил)

Как думаете, как могут данные поведения в браузере повлиять на то, станет ли клиент плохим заемщиком, или всё с ним будет ок?

Нет, интерпретируемость не важна

Анон, а как бы ты пользовался данными поведения в браузере? Типа "больше сидит на сайте => больше раздумывает над кредитом => это взмешенный поступок => кредит отдаст", а если "мало сидит на сайте => как нарколыга которому нужна доза поскорее => необдуманный поступок => кредит не отдаст" - как думаешь, такое адекватно вообще?

В конце-концов всё-равно впихну всё в lgbm и буду надеяться что всё будет хорошо

Ничего себе

Что-то вроде "Сидел на странице 1,5 и 3" -> [1, 0, 1, 0, 1], а "Сидел на странице 1,2" -> [1, 1, 0, 0, 0] ?

Нет делаешь эмбеддинги сайтов типа Word2Vec или FastText, где сайт - это аналог слова. Затем по части истории человека усредняешь эмбединги по сайтам. Получается вектор размера эмбеддинга.

Благодарю, попробую

Может это просто игрушечная задача на применение стандартного классификатора какого-нибудь.

Вообще-то для такого есть тип эмбеддинга pagespace в пейсбуковском starspace, как раз для анализа поведения терпилы в интернетах. Сайт представлять в виде слова в эмбеддинге - натягивание совы на глобус.

>>78608

> Как думаете, как могут данные поведения в браузере повлиять на то, станет ли клиент плохим заемщиком, или всё с ним будет ок?

Если на двачах капчует, точно кинет ваш наебанк, лол.

> Скинули мне задачу по кредитному скорингу (подаюсь вроде как на начальный уровень)

В этой задаче главное выдавать 4 метрики (false/true positive/negative) и сдвинуть все так, чтобы был минимум false positive (то есть одобрения плохим людям). Если при этом будет дохуя false negative (то есть отказов хорошим людям), это не так плохо.

>Как думаете, как могут данные поведения в браузере повлиять на то, станет ли клиент плохим заемщиком, или всё с ним будет ок?

Хули тут думать, проверять надо.

>время на которое заходил

Время - однозначно, если чел заходит в рабочее время или вообще в будни ночью, значит он может быть безработным. Но в выходные это норм. Остальное вряд ли.

>как могут данные поведения в браузере повлиять на то, станет ли клиент плохим заемщиком, или всё с ним будет ок?

Если человек часами сидит в группе вк "как наебать коллекторов", то очевидно, как повлияет.

> если чел заходит в рабочее время или вообще в будни ночью, значит он может быть безработным.

Хуя ты Шерлок. А что мешает с работы заходить когда и куда угодно? С тилибона хотя бы. Вы тут сейчас намутите систему маняскоринга, которая половину перспективных заёмщиков через хуй прокинет, а всякую бичевню пропустит, лол.

> По поводу страниц - самое важное мне кажется с какого сайта переход. Я гугла или яндекса например.

Типа, если с Яндекса то патриот, а если с Гугла то агент госдепа переодетый? Ору с вас, зумеров.

Во-первых, ты делаешь данных гипотезы и проверяешь их. Не сработало - пошел дальше.

Во-вторых, любая система скоринга так и устроена. Тебе мир спасать или тест для банка сдать?

Зумеры у тебя под кроватью, шизик

Шелдона Акслера читай, будешь батей в линале

Не читай. Не знаю ни одного машобиста, осилившего эти книги дальше 2 главы. Говорят, что это сложно о простом и академщина, а на практике интуитивно все понятно. Изучай туториалы к фреймворкам и практические книги типа deep learning with python.

Ну объясни, зачем мне нужно знать, как устроен внутри оптимизатор Adam или RMSProp. Эта теория не дает ответ на вопрос, что выбирать для конкретной задачи. На практике все сводится к перебору доступных оптимизаторов, пока не найдется тот, что дает лучший результат.

Или, например, архитектура сети. Сколько слоев делать и сколько нейронов должно быть на каждом слое? Маняматика ответа не дает.

В общем, вся матеша нужна либо для разработки либ и фреймворков, либо для академических исследований, то есть в работе от нее толку нет.

>. Эта теория не дает ответ на вопрос, что выбирать для конкретной задачи.

Даст: нужно выбирать Адам.

>Маняматика ответа не дает.

Дает - похуй в широких пределах.

И мы имеем кучу вкатывальщиков, которые перебирают архитектуру всерьез, вместо того, чтобы заниматься важными вещами.

Пить пиво?

Нужна голосовая нейроночка чтобы озвучивать мои яойные новеллы. Куда вкатываться?

Ты-то не запомнил. Вообще же между крутым пейпером и реализацией в tensorflow может пройти 2 года. Не можешь реализовывать пейперы (в крайнем случае переписывать с MXNET китайца в гитхабе во фреймворк, на котором у тебя свой проект), соснешь.

На пайторч хабе все есть.

Не съебу, страдай.

tacotron, mimic2

wavenet, clarinet

хочешь с эмоциями? вкатывайся в какой-нибудь стенфорд за phd

100 Кб, 1711x433

100 Кб, 1711x433Я придумал только такое:

В CG1 перечислены числовые значения различного рода параметров,

можно найти строку, где количество таких параметров максимально, далее разбить столбец CG1 на столбцы число которых равно максимальному количеству этих параметров,

для тех строк, где количество параметров меньше максимального, для отсутствующих параметров надо поставить 0 или -1.

Из минусов - в тестовой выборке может оказаться больше параметров, чем в "максимальной" строке тренировочной выборки.

Ну а в столбце CG2 "nan" надо просто заменить на какое-то спец значение, например 0 или -1

Естественно, каждый полученный столбец надо нормализовать, например этим https://scikit-learn.org/stable/modules/generated/sklearn.preprocessing.StandardScaler.html способом

У тебя последовательности значений же!

Ты работай с ними, как с последовательностями/текстом.

Т.е. можно преобразовать в спарс и посчитать, например, tf/idf, PCA, можно попробовать обучить на них word2vec а дальше - lstm/трансформер/небо/аллах

Да, работа опять с японским текстом.

Или лучше свой алгоритм нашаманить?

https://github.com/taishi-i/nagisa

https://github.com/rakuten-nlp/rakutenma

Первые две ссылки в поисковике от копрорации бобра

Анемедауны не могут в поиск

Пердолюсь в tf object detection API, наткнулся на ошибку, с которой не могут помочь ни на github, ни на stackoverflow.

Единственное требование - возможность перевода разметки датасета в csv файле (генератор датасета, помимо изображений, на выходе дает этот файл с разметкой). Крайне желательна поддержка python, т.к. генератор написан на нем.

> помоги понять как работает L2 регуляризация.

Минимизирует ошибку исходя из гипотезы, что у твоих данных нормальное распределение.

См. https://stats.stackexchange.com/questions/163388/l2-regularization-is-equivalent-to-gaussian-prior

>На каждом слое надо добавлять квадрат весов с коэффициентом к градиенту, а потом докидывать веса с коэффициентом в ошибку следующему слою?

Бери tensorflow и не выебывайся. Твои детали реализации к тому, как она работает, не имеют никакого отношения.

>у твоих данных нормальное распределение

А если это не так то что использовать?

Хочу наговнокодить минимальный рабочий пример перед тем как практические задачи решать.

>А если это не так то что использовать?

Скорее всего это так. Алсо batch normalization вхуярь, да побольше

Вот это очень хорошая ссылка. Добра, анон.

2 Кб, 523x124

2 Кб, 523x124Пик, якобы и есть кодирование на гиперсферу, но по формуле в интернете - это формула нормирования.

Нормирование это когда l1, l2 или max норма вектора равна единице, то что на пике нормирование по max норме, если максимум берется по признакам объекта.

PS Тогда вектора представлены точками на сфере с центром в нуле, так как их норма 1

Тогда, получается кодирование на гиперсфере где вектора представлены точками на сфере с центром в нуле, можно назвать нормированием ?

У сферы длина всех векторов равна единице. То есть вектор делить нужно нужно на его евклидову норму

Человек с 20-летним опытом разработки, занимающийся нейронками, сказал, что все о языке знать невозможно, и поэтому он спорные моменты проверяет в REPL питона. Что это за хуйня? Как люди раньше писали машинный код по таблицам, как хацкеры оптимизировали шеллкоды, чтобы в них не было нулей и они были максимально компактными, как сишники писали оптимизации? Что за хуйня, блядь, происходит? Почему айти так стремительно тупеет? Здесь люди разучиваются даже код писать. Пиздец.

425 Кб, 931x682

425 Кб, 931x682Так раньше программирование было для элиты. А сейчас каждый первый тупой зумерок с кукареком на пустой башке, петушиной бородой из барбишопа, в петушиных лосинах, кедиках и клетчатой рубашке клиповым мышлением в эту тему лезет. А дальше закон Мерфи "создай что-то чем сможет пользоваться даже дэбил, и только дэбилы и будут этим пользоваться". Не зря же ещё фон Нейман говорил, что кроме машинного кода не нужно ничего, все высокоуровневые яп для барышень - телефонисток.

>Как люди раньше писали машинный код по таблицам, как хацкеры оптимизировали шеллкоды, чтобы в них не было нулей и они были максимально компактными, как сишники писали оптимизации?

Это риторический вопрос? Если нет то ответ простой: очень медленно и долго. Для современного рынка задачи требуется решать намного быстрее.

Просто когда жил и творил Нейман ещё не придумали каэнэн с каминсом.

А ювелирная работа и не нужна, если с успехом заменяется конвеерным производством.

>Как люди раньше писали машинный код по таблицам, как хацкеры оптимизировали шеллкоды, чтобы в них не было нулей и они были максимально компактными, как сишники писали оптимизации

Нахуя это делать, если оно всё автоматическое, а разработкой занимаются люди из другой сферы программирования? Ты таблетки давно принимал, скажи честно?

![kormushka-dlya-svinej-rukami-10[1].jpg](/pr/big/thumb/1473408/15693238501460s.jpg) 80 Кб, 700x522

80 Кб, 700x522Кормушка для рнн. Для всех ячеек цепи одновременно.

Они наверняка хуево работают, я прямо уверен, что любое разговорное сокращение им не под силу

Сфера единичная и она в сферы в смысле какой-то нормы не обязательно L2

А, ее и тренить можно, тогда другое дело

LaTeX/AMS-TeX OCR. Будешь первым в мире, кто сделал OCR для математической нотации.

> Я на апворке делал домашки студентам по этим темам.

С какого уровня знаний вкатился? Как готовился?

Математика в вузике (линал, матан, свертки+фурье, диффуры, тфкп), ml-class.org, пару лет на госзаводе месил говно в стиле "алгоритм компьютерного зрения, работающий на контроллере уровня 80-х годов". Большая часть этого не нужна.

>Как готовился?

Смотрел заказы, дальше изучал тему, тяну я, или нет, писал клиенту. Собственно я в ML вкатился не потому что хотел именно ML, меня рыночек порешал. Я первый год облизывался на доступность какого-нибудь бэкенда.

> Математика в вузике (линал, матан, свертки+фурье, диффуры, тфкп)

Что нибудь из этого пригодилось?

Что за наебанк таких сказочных специалистов нанимает? Пеньков поди? У него и звонари сброд какой-то...

e2e какое-нибудь напрямую из истории транзакций, для сравнения

Из всего я вынес примерно 10% сути, которая постоянно пригождается. Но если я эту суть кому-то пересказываю, никто нихуя не понимает, видимо это так не работает.

В целом чем больше ты знаешь, тем больше в мозге ассоциативная карта и тем быстрее ты учишься, понимаешь и запоминаешь чужие пейперы. Но если тебе нужно понять конкретный пейпер, допустим, за месяц, ты можешь за этот месяц прочитать все референсы из этого пейпера вплоть до учебников по математике и что-то родить.

Можно преобразовать историю транзакций из

[понедельник; +500; от васяна]

[пятница; -500; васяну]

в еботу виде

[500; эмбеддинг васяна;

0; 0;

0; 0;

0; 0;

0; 0;

-500; эмбеддинг васяна;

И скормить это дело CNN с архитектурой типа WaveNet. Может учиться побыстрее LSTM. Но в целом не думаю, что сработает e2e.

Обязательно ли знать матанскую кухню машобовских алгоритмов? Если да то насколько глубоко если цель вкатиться через одиночные проектики для бомжей в удаленку?

Блядь, мало жуликов в среде пхп-лендингов, ща еще и ML-фриланс засрете так, что перед тем, как тебя заапрувят на проект, будут или спрашивать пятилетнее портфолио, или заставлять поворачивать деревья.

Если ты ограничишь выход WaveNet одним нейроном, у тебя получится неплохой классификатор 1D-сигналов. Суть-то не в генерации, а в стеке dilated convolution'ов.

Говно. AMS-TeX не поддерживает.

Не собираюсь "жульничать" лол, я просто спросил про порог для фриланса, к чему такая агрессия?

93 Кб, 959x1280

93 Кб, 959x1280Я не работаю в DS, но судя по тому, что я читал , в большинстве случаев нужен уровень 1-2 курса, те ты понимаешь теоретическую часть матана, линала, тервера и матстата и ручками можешь решить шаблонные задачи.

Для примера вот ссылка на вступительный тест в новую школу анализа данных от mail.ru для специалистов с опытом

https://t.(убери эту вставку)me/kantor_ai/53

Автор канала - экс-сотрудник яндекса, преподает в ШАД

Куда тебе интернет, если с одним мессенджером разобраться не можешь

шваброхомячье можно только обосать, не более

Оба хуесоса, которые путают ряд Фурье и дискретное преобразование Фурье. ДПФ имеет конечное число коэффициентов. Формулы тоже какие-то кривые, но копаться в этом куске говна лень.

Да и нейронки сами это вообще какая-то залупа. Делаешь преобразования Фурье, а на деле твоя работа будет нужна для распознавания ебел каких-то унерменшей с гос структурах или для вычисления кредитного скоринга. При этом еще и разработчиком себя не чувствуешь и делаешь import slesarplow as keras

Нейронки это не исследования, а самая обычная область, где тебе платят за то, насколько качественно ты делаешь флюродрос бизнесу.

Что примечательно, есть задачи на нейронках, которые нужны государству. Но их реализуют все равно частники, ололо.

130 Кб, 650x471

130 Кб, 650x471>Ты нам из СССР пишешь?

Тот анон прав, чем занимается куча НИИ и ученых в говнемоченых? Всю эту теоретическую пидарасню с академии наук гнать саными тряпками, а то на одного робофедора сотня кукаретиков.

47 Кб, 326x281

47 Кб, 326x281Если зумер не понимает, чем занимаются учёные, значит они не нужны, и дебилы тоже учёные, а не зумер. Я тебя правильно понял? Вы себе реально мозги тайдом убиваете, https://en.m.wikipedia.org/wiki/Consumption_of_Tide_Pods или от рождения такие альтернативно одаренные?

>чем занимаются учёные

Выращивают новых ученых и пилят бабло, что сказать то хотел?

Британский математик доказал гипотезу Римана.

Гипотеза о распределении нулей дзета-функции Римана была сформулирована математиком Бернхардом Риманом в 1859 году.

Она описывает, как расположены на числовой прямой простые числа. Без этого доказательства человечеству был бы пиздец.

189 Кб, 1101x663

189 Кб, 1101x663>Я тебя услышал

А ты кто? Ноунейм ученый просравший всю жизнь в универе, который пытается доказать свою нулевую значимость доя социума? Хорошо слышно?

Не ври

>nearly 7,700 pod-related exposures to children age 5 years and younger

Причем тут вообще зумеры?

Как же ты серишь себе в штаны, пиздец.

Только если ты дод который не может загуглить чем кнн от кминс отличается. А так всё нормально, никакого комплекса неполноценности.

Хоспаде, сдвачевавшийся долбаеб с протекающей от тайда крышей, воюющий с воображаемыми врагами, называет кого-то додом. Ты же настолько дэбилен, что даже не понял суть того диалога про кнн, зато свое зумерское мнение имеешь.

Пытаюсь вкатиться в ml, но на моем макбук эире все занимает вечность.

Или лучше комп собрать?

Есть бюджетные варианты?

Слишком толсто и глупо. Называешь нас зумерами, а сам вечером пятницы не можешь найти своей персоне никакого достойного применения, кроме как пытаться в троллинг на дваче.

Фу, мне противно.

Кстати, это даже смешно. Я ни на секунду не сомневался, что ты начнешь аппелировать к тому, что я не понял каких-то аспектов статьи, хотя их не понял именно ты.

гугл колаб

178 Кб, 1080x1080

178 Кб, 1080x108013:05

https://youtu.be/gGce2JDbJAQ

18 Кб, 734x197

18 Кб, 734x197https://github.com/experiencor/keras-yolo3

Что-то маловато, но это ямбекс, что с них взять.

*почти нихуя

щито поделать, вылезаторствую потихоньку, на постдок надеюсь поехать за бугор

бака-мухгу-мага-дс-универ-пхд-якобы-топ-дс-универ

хх? прочие подобные сайты?

Конфа одс вообще нужна для такого?

Джунам в Яндексе платят от 50к до 120к независимо от направления, а после

этой отметки идут зарплаты мидлов. Ничего особенного, ради такой зп придется долго расти внутри компании.

Почему ебнутый сайкопат? По-моему он обычный быдломужик. В рашке таких много.

Ну процентов 80% таких русскех мужичков и есть психопаты, таскающие с ножами по улицам. В /b/ загляни, например.

DataOrientedDesign

70 Кб, 1170x598

70 Кб, 1170x598А почему очный экзамен не выкладывают? Обещали статью или типа того.

70 Кб, 640x570

70 Кб, 640x570Привет, двач. Есть у кого на примете годный курс лекций по алгоритмам? Знаю, что библией алгоритмизации считается книга Кормэна(потом по нисходящей идут Дасгупта и Бхагарва, тоже знаю) и мне нравится её полнота, однако, формальный язык очень и очень отталкивает, не способствуя пониманию. Да и вообще, формат лекций мне как-то ближе, нежели просто чтение книги. В общем, какие требования? Полнота(речь не об N-полноте, лол) Кормэна в сочетании с интересным, не сухоформально рассказывающим преподом. А, да, и чтобы на русском(знаю, что охуел). Подскажите чего по сабжу?

Наверное, чтоб можно было дать его в следующем году, кек

Ну а вообще, судя по этим постам, можно пройти и без письменного

478 Кб, mp4,

478 Кб, mp4,480x360, 0:08

Я только первую задачу решил за полтора часа, а они ее даже не учитывали.

Интересно, мне бы сказали на экзамене, что коммутатор это AB - BA? Я такой термин первый раз в жизни встречаю, хотя прочитал 2 книжки по линалу и эту задачу решил.

Из заданной последовательности чисел вывести число с максимальным количеством делителей.

390 Кб, 1080x1350

390 Кб, 1080x1350Звучит довольно просто, если в лоб решать, то для каждого n из последовательности в цикле от 1 до n делить и записывать в переменную кол-во успешных делений без остатка, если для нового n это число больше, то перезаписывать

Я словарь добавил.

.dict_ints = dict((c, 0) for i, c in enumerate(list_int))

.for i in list_int:

. numb = 0

. for j in range(1, i + 1):

. if i % j == 0:

. numb = numb + 1

. dict_ints = numb

.max_int = max(dict_ints.values())

Ответ на 1 задачу ((e - 1)^2) / 2?

говно, переделывай с поиском всех простых делителей до sqrt(n) и последующим подсчетом составных делителей

Блядь, какое же совковое говно. Нахуя спрашивать у поступающих что-то по теме, давайте устроим нерелевантный экзамен на математику и будем надеяться на корреляцию.

И я понимаю когда при поступлении в ВУЗ якобы требуют школьную программу (которая по сравнению с тем что нужно выдрачивается до уровня как в профессиональном спорте), потому что это внковая бюрократия, но что тут-то мешало нормально сделать.

>Нахуя спрашивать у поступающих что-то по теме, давайте устроим нерелевантный экзамен на математику

Макаке неприятно что его ценные знания по тому как сделать фитпредикт никого не интересуют, а на обучении профессии где нужно уметь думать проверяют внезапно умение думать.

Это в задаче "найти сумму ряда" нужно умение думать? Если ты так думаешь, то думать ты как раз не умеешь.

Что это были за книжки? Там наверно и про скобку Ли ничего не говорилось? Это не релевантно простому линалу, но где твой кругозор, анон? На экзамене было именно AB-BA≟E, но я просто по памяти напечатал как мне удобно.

>>84299

Ну что за глупости, не стали бы они повторять задания на следующий год. Даже с вариациями.

Сука, все сидят в телеграме, что за интернет в интернете, бесит.

По сабжу, подход вызывает уважение.

>>84718

Я согласен, но заебали во всём совок винить. Я не совкодрочер, но вот так, по делу и без дела - это не от большого ума. Везде так, вот везде, кроме каких-то единичных мест. Единственные известные мне примеры - когда дают задачки на основы теорвера, линала и статистики, когда проверяют знание SQL (привет, тинькофф). Но видишь ли какая проблема, дохрена нас таких, кто нормально знает основы. Нужно из этого дохрена (150) как-то отсеять нужное количество человек (допустим 50). Как это делать? Расскажи. Мне других способов проверить "креативность", кроме как надеяться на корреляцию с решением олимпиадных задачек не известно. Никому не известно, отсюда и эти странные задачи на собеседованиях в конторки типа гугла.

И то этот Кантор, судя по постам выше, оказался достаточно человечным, чтобы _попытаться_ уменьшить этот бредор.

Если в такой задаче тебе даже думать не надо, то в чём сложность её наличия? Берёшь и не думая всё сдаёшь. Изи. Даже помнить ничего конкретного не нужно, разрешается брать любые печатные материалы.

> думать ты как раз не умеешь

Спасибо, как-нибудь обойдусь без вердиктов макаки, которая в своём мухгу видела только механические однотипные задачи на сумму рядов и думает что ими всё ограничивается.

>Что это были за книжки?

Наверное какое-то старое говно для подготовки инженеров-слесарей, где под вершинами линейной алгебры обычно имеют ввиду кучу формул для перемножения матриц специального вида или ещё какой-то бред.

>Мне других способов проверить "креативность", кроме как надеяться на корреляцию с решением олимпиадных задачек не известно.

Самое банальное - спрашивать по теме учебы.

Потому что что подразумевается. Есть совковый школьник, он честно учится в совковой школе, на экзамен приходит, не готовившись, отвечает по программе, поступает. Все логично и просто.

На деле происходит следующее. Известная бюрократическая формула "как только что-то статистическое становится KPI, статистика перестает адекватно показывать действительность". Есть конкуренция, и есть люди, которые ради конкуренции начинают задрачивать подобное дерьмо. Проходят от этого, естественно, НЕ ТЕ люди, при чем они задрачивают какую-то рандомную пыль, которая родилась в мозгах бюрократа и является смесью случайности и его, бюрократа, синдрома утенка (типа: ну ЭТО-то все должны знать).

Можно поступать проще. Хочешь поступить - реши задачки из темы курса. Тогда хотя бы это будет не рандомная хуйня. Правда, мозг бюрократа от такого переклинит: мол, нахуя поступать если в итоге пройдут те, кто способен в самообучение. А как тогда оценивать эффективность самого бюрократа? Не, так не пойдет.

На самом деле, чем так, проще бросать рандомный кубик. Работать будет не менее эффективно.

> бюрократы

> бюрократы

> пропускают задротов а не меня умненького

> ну я умный на самом деле просто не савок

Макак, успокойся уже, каждому своё. Ну не родился ты достаточно умным, можешь работать обычным кодерком, они тоже совсем не бедно живут. В любом случае нечего каких-то рептилоидов-бюрократов придумывать, в шаде умненьких студентиков учат умненькие преподаватели, естественно порог получается повыше знания какого-то очередного фреймворка и умения простейшие задачи с монетками решать.

Тут такое дело... Этот школьник приходит, сдаёт экзамен на полный балл. И ещё 100 школьников сдают. А мест всего 10. Придётся в этот экзамен добавить нечто (назовём это "второй этап"), что отсеет из 100 школьников, которые знают программу, 10 школьников, которые могут что-то ещё (например, имеют железную жопу, чтобы задрочить применение своих навыков до олимпиадного уровня). В итоге профит: кого бы ни взяли, они всё равно знают необходимое (напомню, они прошли первый этап), так что совсем левых не возьмём.

Можно сделать, как ты говоришь. Добавить к этому второму этапу альтернативный второй этап, который проверит знание релевантных программе вещей. И отбирать будем и по нему.

Ой, погоди-ка, но ведь Кантор так и сделал. Первый (заочный) этап, второй олимпиадный (очный) (на самом деле задачи для олимпиадников там простые) и альтернативный второй - контест по анализу данных (куда уж релевантнее).

Так в чём проблема? Как можно ещё улучшить?

>Макак, успокойся уже, каждому своё. Ну не родился ты достаточно умным, можешь работать обычным кодерком, они тоже совсем не бедно живут.

Ты обо мне не знаешь нихуя и сводишь аргументацию к "не служил - не мужик".

>в шаде умненьких студентиков учат умненькие преподаватели

Да вообще-то нет. В шаде случайных студентов учат туповатые преподаватели, не способные создать нормальный вступительный тест, будучи статистиками по профессии. То, что на этом фестивале тупости они друг другу надрачивают, не делает никого в этом процессе умными. Во всяком случае, мозгов доказать это у тебя точно нет.

>В итоге профит: кого бы ни взяли, они всё равно знают необходимое (напомню, они прошли первый этап), так что совсем левых не возьмём.

Сомнительный профит, исходящий из того, что KPI бюрократа - это средний балл, и левый двоечник для такого наамного страшнее, чем десяток посредственностей. Поэтому сначала ты создаешь подобную говносистему в виде лучшего в мире советского образования, а потом создаешь систему спецшкол, в которую берешь людей с детства, потому что данная система тебе не может дать нормальных специалистов.

Это - в оригинале (и совок правда не при чем, просто подобные эпитеты показывают, что я имею в виду), потому что тупой корпоративный мозг мейлрушников просто подобную поебень воспроизводит, не задумываясь. Так повелось, хули.

>Так в чём проблема? Как можно ещё улучшить?

Не спрашивать нерелеватное говно. Если ты собираешься учить людей линейной регрессии, спрашивай у них про линейную регрессию. Тогда на лекциях придется иметь дело не с унылым зачитыванием учебника (люди сами изучили основы при поступлении), а, не теряя времени, объяснять то, что самостоятельно можешь пропустить.

В идеале вообще сделать онлайн-курс и тех, кто его сдал хорошо (по результатам оффлайн экзамена, мы же не за жуликов), звать на курс для продвинутых.

Те же интегралы и ряды, например, - это отрыжка МЕХмата. Когда-то, между 30-ми и 70-ми, государство платило за них, чтобы можно было делать ракеты (нужны были сотни макак, умеющие брать интегралы), дальше эти макаки начали вариться в собственном соку, навыдумывали задачек, и теперь это считается типа латыни в медицинских рецептах, нахуй не нужно, но ЕСЛИ УМЕЕШЬ ДУМАТЬ ТО РЕШИШЬ ЕПТ.

Ещё раз. К тебе пришло 200 человек, из них 100 ответили тебе линейную регрессию, а мест 10.

Что ещё делать, как не спрашивать что-то дополнительное, релевантное в той или иной степени? Вот как?

> Да вообще-то нет. В шаде случайных студентов учат туповатые преподаватели

Аргумент. Да вообще-то да, а фантазии макаки которую не пустили и она теперь обидки кидает придумывая на пустом месте всякую хуйню никого не интересуют, напомню.

Спрашивать по кишочкам кераса, естественно. Выпускать же нужно макакичей, которые матиматики не знают, но умеют правильно заимпортить хуйню из библиотеки.

>Что это были за книжки?

LADW, LADR + лекции 18.06 MIT.

>>84751

>кучу формул для перемножения матриц специального вида

Именно этого мне не хватает. Я много олимпиадных задач по линалу видел, которые решаются хитрыми формулами типа инверса блочной матрицы. Решаю дома, гугля развороты с формулами на все случаи жизни. В задаче на совместную обратимость M и N, например, нужно было использовать формулу детерминанта блочной матрицы для случая коммутирующих блоков (возможно и иначе можно было решить). На экзамене бы отсосал, потому что в вызубривании спецформул не силен.

>вызубривании спецформул не силен

Ты наверное не понял, это не есть линейная алгебра.

Линейная алгебра это наука о модулях над кольцом.

Ты наверное не понял мой пост.

>Линейная алгебра это наука о модулях над кольцом

С точки зрения теоретической математики? Формулы детерминанта блочных матриц оттуда?

В каком смысле с точки зрения? Линейная алгебра - это бОльшая часть математики. Что такое детерминант блочных матриц не знаю.

37 Кб, 893x271

37 Кб, 893x271Ладно, признаю, книжки не дно. Может, я зря на своём мунспике назвал коммутатор коммутатором, потому что как отдельный объект вне алгебр Ли он наверно и правда не особо рассматривается. У нас, физиков, коммутатор операторов - обычная штука в квантовой механике.

На счёт кучи формул для перемножения матриц специального вида - мб подразумевается, что ты можешь их родить, если посидишь часок над задачкой. Так-то и правда есть сборники-справочники всякие. У меня вот в электронном виде есть такой, на 750 страниц.

Расскажи как решать 4 задачу, если случайно помнишь прикреплейтед формулу?

>Что ещё делать, как не спрашивать что-то дополнительное, релевантное в той или иной степени?

На колу мочало, начинай сначала. Вот здесь >>84230 нет ничего релевантного. Если ты пытаешься поступить куда-то, есть вероятность, что ты этого не понимаешь. Но это так.

Подобная хуйня имеет смысл, когда на дворе 19 век, спецлитературы нет, а тебе нужно отсеить школьников. Приходит на помощь школьная программа. Сейчас же тебе откровенно похуй, учить нерелевантные формулы общевузовской высшей математики, или что-то релевантное. Но тебя заставляют учить нерелевантное. Просто потому что ТАК ПОВЕЛОСЬ.

>>84843

>Аргумент

Ты так и не принес пруф на то "в шаде умненьких студентиков учат умненькие преподаватели". Равно как и на то, что я макака.

Дальше бессмысленно. Ты считаешь, что нерелевантно, я считаю что релевантно. Всё, дискуссии больше, видимо, не будет. Ну лан.

Дальше ты должен доказать наличие: раздел программы обучения, где это релевантно. Начни с рядов, бггг.

23 Кб, 961x112

23 Кб, 961x112По-моему 4-я задача следует из этой формулы из русской википедии. Она наверное пиздецки известная, если она есть в русской википедии, лол.

Ботаны, го в попчан няшится!

Хули тебе ясно стало, пришел с предубеждением, высказал ноль аргументов, кроме "ряяяя, тебя не взяли ты и бомбишь))))", и дальше довольный продолжил демонстрировать свое предубеждение, что объект твоего религиозного поклонения могут критиковать только макаки и неосиляторы. Ты даже осознать глубину своей ригидности не можешь.

Я уже устал и мне лень думать, но вроде бы ещё надо доказать, что если D-CB обратима, то и D-BC обратима. Как это сделать?

Зачем. Если формула верна, то для обратимости матрицы

A B

C D

данного вида (A и D - квадратные матрицы) достаточно обратимости матрицы A. У нас A=eye().

А, нужна еще линейная независимость строк матрицы [C D]. Да, не подходит в лоб формула.

Двойка по гугл-фу.

иди в гугл и напиши "LADW linear algebra" или "LADR linear algebra"

господи, какие иногда беспомощные встречаются, и даже не знаешь, это молодёжь тупая или старые пердуны не могут в гугл (хотя оба варианта вероятны)

>> [E A; B C]

ans =

1 0 1 1

0 1 1 1

1 2 1 2

7 8 1 2

>> [E B; A C]

ans =

1 0 1 2

0 1 7 8

1 1 1 2

1 1 1 2

Контр-пример. Нде, ну и задача.

А как подбирал?

Значит, нужно подобрать такой случай, чтобы строки B C было линейно-независимыми, а A C - линейно зависимыми (равными в простейшем случае).

ваша макака

где

>Но видишь ли какая проблема, дохрена нас таких, кто нормально знает основы. Нужно из этого дохрена (150) как-то отсеять нужное количество человек (допустим 50).

а зачем? это же не работа а учеба

Ничем, ты же обратным распространением меняешь веса в соответствии с ошибкой между желаемым и полученным

Начнем с того, что определитель имеет смысл только для квадратной матрицы. Ты часто видел квадратные матрицы весов?

Ошибка у тебя одна, это скаляр. Далее ты вычисляешь частную производную этого скаляра по каждому весу, и апдейтишь каждый вес так, чтобы ошибка уменьшилась (то есть на направлению, обратному этой самой частной производной). Называется это градиентный спуск. Никакого линала тут нет, сплошной матричный матан.

>Хули тебе ясно

Про таких как ты - всё, достаточно только лишь бросить взгляд на твои простыни, полные провинциальной ресентиментарной хуйни про злых бюрократов в спецшколах, берущих букашек-посредственностей вместо Гения в белом пальто.

Опять вагон предубеждений. Я хорошо понимаю как те задачи, которые там описаны, так и профессию, чтобы заявлять об отсутствии связи. Если ты в это говно поступаешь, значит ты не понимаешь профессии, мал еще. Если ты не смог решить 4-ю задачу, то ты и в задачах этих ничего не понимаешь.

Ну и опять же, если ты уверен, что решение 4-й, допустим, задачи, так важно, почему ты ее не решил? Получается ты тупее меня в твоей же системе координат.

Окно свертки.

>значит ты не понимаешь профессии

В третий раз, шад и не нацелен на то чтобы выпускать макак и датаслесарей типа тебя (хотя там есть пара отделений специфических вроде). "Профессию" твою любой человек не с двухзначным айкью освоит за пару дней, там же в основном готовят дата саенс и мл ресёрчеров, от таких людей требуется умение думать, а не знание того что нужно заимпортить из склерна для линейной регрессии. Ну тебе это уже несколько людей сказало, но всё как об стенку горох, потому что с ресентиментом и эмоционально мотивированной позицией никакие аргументы не справятся.

> шад

Инфоцыгане, впаривающие чудодейственные курсы по цене 130к/семестр. Покажи хоть одного работающего исследователя из их выпускников.

>от таких людей требуется умение думать, а не знание того что нужно заимпортить из склерна для линейной регрессии

Еще бы маня типа тебя знала, что мне требуется на работе. Рессентимент как есть - это не я тупой, это датамакакам повезло, что им по 400к платят, а они при этом на дваче сидят. Ты тот шизик, который knn и kmeans путает, или другой?

Вот это >>85037 - умение думать. А "я прорыл кучу учебников в поисках спецформул и все равно слооожна блядь", обернутое в пафосные речи - это попытки тупой маньки съехать на зубрежку формул вместо мышления. И, что характерно, эти формулы даже в работе не помогут, потому что сейчас бы обратные матрицы искать на серьезных щщах.

Создают теорию нейросетей те, кто знает математику. А не те кто подбирает значения методом тыка.

14 Кб, 529x110

14 Кб, 529x110Вопрос по svm'ке, пожалуйста объясни как для дибила, на пальцах

то что мы пытаемся минимизировать длину вектора w, я понимаю это для увеличения "зазора" между двумя опорными векторами, t в скрине это метка для классов(1 - положительный, -1 - отриц.), на второй строке творится непонятное, почему такое условие?

> на второй строке творится непонятное, почему такое условие?

Линейная, точнее аффинная функция y=ax+b, разделяющая классы.

Спасибо.

1,7 Мб, webm,

1,7 Мб, webm,400x224, 0:16

Бамп вопросу.

>Еще бы маня типа тебя знала, что мне требуется на работе. Рессентимент как есть - это не я тупой, это датамакакам повезло, что им по 400к платят

Макак, к чему это кокетство? Обосравшись, пальцы веером тут раскидывать не стоит, лучше давай ещё какой-нибудь дурацкий сентиментальный пассаж про дядек-бюрократов, обижающих гениального мальчика.

>умение думать. А "я прорыл кучу учебников в поисках спецформул и все равно слооожна блядь", обернутое в пафосные речи - это попытки тупой маньки съехать на зубрежку формул вместо мышления

У макак всё с ног на голову: закодить брутфорс это умение думать, нестандартные задачки на умение соображать где ничего сильнее стандартного курса знать не надо - тупые ботаны, задрочили и прошли. Профессиональная деформация, видимо, или может распалённый пердак думать мешает.

Бамп, зачем ограничитель(2-я строка)?

Откуда метод наименьших квадратов в SVM, чё несешь-то?

20 Кб, 517x290

20 Кб, 517x290Смотри на картинку.

||w||=w' w , это первое условие.

Далее подставь t=-1,1, подели обе части на t, знак уравнения в случае -1 сменится, получишь, что твоя вторая строка это то же самое, что (wx+b)>=1, (wx+b)<=-1. То есть это условие указывает, с какой стороны от разделяющей плоскости должны находиться твои классы.

>Обосравшись, пальцы веером тут раскидывать не стоит

Действительно. ML-тред привлекает шизиков, которые, с одной стороны, уверены, что ML очень прост, с другой - путаются в базовых понятиях и не могут не только решить задачи по линейной алгебре, но и даже въехать в решение (оказывается, это был метод тыка, лол). Вместо этого они несколько часов ищут нужную формулу в книжке.

Маня, если я критикую вступительные куда-то, это не значит, что я не могу их решить. Но до тебя это никогда не дойдет.

ШАД нужен для хедхантинга толковых студентов, больше ни для чего он не нужен

я хотел попробовать попасть в их шри, узнал что надо иметь дело с бэм и сказал ебитесь вы конем

А с универами/школами это тоже работает? и нахуя вообще тогда из пизды вылезать?

> вам никогда не понять..

Ну в общем я понял, ты всё будешь продолжать обсираться постя одну и ту же хуйню раз за разом. Остужайся, макакен.

Большое спасибо, как я понимаю такое ограничение сделано для удобства расчетов, чтоб при минимизации wTw(увеличении зазора) не возникали в уравнении (wTx + b) величины близкие к нулю, для удобства пусть выражение в скобочках для x-ов (а именно объектов) которые стоят у самой границы равняется 1 или -1.

Ядро нелинейно искривляет пространство, делая изначально линейно неразделимую задачу линейно разделимой.

Охуенно. Какую книгу почитать, чтобы в этом разбираться? Начинал Aluffi, но там немного не про то.

ISLR наверни, 9ая глава про SVM. Вапника тоже можно, Vladimir N. Vapnik "The Nature of Statistical Learning Theory" , но он не для начинающих, нотация сложнее чем в ISLR.

Ну вышел ты на пенсию — отдыхай. Нет, не хочу. Хочу говно молодняку в глотки пихать.

Ну долбаеб ты — отдыхай. Нет, не хочу. Хочу другим указывать.

Но тогда где он проебался, если очень кратко то ядра как я понимаю, "генерят" новые признаки, которые в некотором другом n пространстве разделимы n-1 гиперплоскостью, ответь без эмоций пожалуйста.

Откуда такие познания?

>если очень кратко то ядра как я понимаю, "генерят" новые признаки, которые в некотором другом n пространстве разделимы n-1 гиперплоскостью

Не ядра. Мы неявно вводим преобразование phi, такое, что в phi(x) задача будет линейно разделимой.

Но именно что неявно. Ядро - это такая функция K, что

K(x, x')=(phi(x), phi(x')), phi - неявное преобразование, а (,) - скалярное произведение

>Мы неявно вводим преобразование phi, такое, что в phi(x) задача будет линейно разделимой

Это и называется "новые фичи", внутреннее представление,

import numpy as np

import time

from sklearn.datasets import make_blobs

from matplotlib.colors import ListedColormap

X_D2,y_D2=make_blobs(n_samples=30,n_features=2, centers=2,

cluster_std=1.3, random_state=0)

plt.figure

plt.scatter(X_D2[:,0],X_D2[:,1],c=y_D2,marker='o',

s=50,cmap=ListedColormap(['#FF0000','#00FF00']))

def logisticFunction(X,theta):

h=1 / (1 + np.exp(-X[0]))

return h

theta=np.array([0.5,0.5])

print(logisticFunction(np.array([1,1]),theta))

def logisticRegressionByNumpy(X,y):

print('Logistic regression')

m=y.size

#print('m=',m)

on=np.ones([m,1])

#print('on=',on)

X=np.concatenate((on,X), axis=1)

#print('X=',X)

theta=np.array([0.1, 0.5, 0.7])

h=logisticFunction(X,theta)

#print(np.concatenate((X,y.reshape(-1,1),h.reshape(-1,1)),axis=1) )

alpha=0.05

iter=150

for i in range(iter):

theta=None

h= None

print('Result')

h=None

print(np.concatenate((X,y.reshape(-1,1),h.reshape(-1,1)),axis=1) )

return theta,h

theta,h=logisticRegressionByNumpy(X_D2,y_D2)

#print(logisticRegressionByNumpy(X_D2,y_D2) )

out:Logistic regressionResult[[ 1. -0.16288373 3.43367167 1. 0.11541267][ 1. 1.55329228 4.73756395 0. 0.08331115][ 1. -0.04279968 0.6211013 1. 0.56079306][ 1. 1.60298173 1.10091732 1. 0.62472714][ 1. 1.38325809 3.19346287 0. 0.22468078][ 1. 1.17770173 4.7953986 0. 0.0696791 ][ 1. 2.96888306 6.21395373 0. 0.04676088][ 1. 1.39122084 -0.63715818 1. 0.85898989][ 1. 0.89116099 1.40063691 1. 0.49801373][ 1. 2.91857287 4.03708158 0. 0.21321711][ 1. 0.42663355 1.90840112 1. 0.35579437][ 1. 3.40409547 3.03332608 0. 0.42122543][ 1. 2.01863062 1.45449509 1. 0.59678372][ 1. 0.84208557 4.83756538 0. 0.05969651][ 1. 3.65464541 2.46075746 1. 0.55858148][ 1. -2.34261668 5.1534915 0. 0.01394478][ 1. 1.03575615 4.06044832 0. 0.11267961][ 1. 3.92695109 2.41311195 0. 0.59391987][ 1. 1.96561912 4.46196485 0. 0.11739231][ 1. 2.21138502 4.10702296 0. 0.16261045][ 1. 2.10003714 3.3389728 0. 0.25489858][ 1. 2.14173991 1.29087713 1. 0.63885129][ 1. 0.99817735 -1.34650372 1. 0.90167225][ 1. 1.55174266 0.50467008 1. 0.72374108][ 1. 1.39271969 0.32816707 1. 0.73900903][ 1. 1.18106894 0.43024455 1. 0.7061229 ][ 1. -0.17785139 1.72875192 0. 0.33439181][ 1. 0.69214867 -0.94835966 1. 0.85563972][ 1. 1.16352672 6.19434289 0. 0.02393286]

[ 1. 1.2306488 0.42610014 1. 0.71082439]]

Ананасы, что идет в None?

import numpy as np

import time

from sklearn.datasets import make_blobs

from matplotlib.colors import ListedColormap

X_D2,y_D2=make_blobs(n_samples=30,n_features=2, centers=2,

cluster_std=1.3, random_state=0)

plt.figure

plt.scatter(X_D2[:,0],X_D2[:,1],c=y_D2,marker='o',

s=50,cmap=ListedColormap(['#FF0000','#00FF00']))

def logisticFunction(X,theta):

h=1 / (1 + np.exp(-X[0]))

return h

theta=np.array([0.5,0.5])

print(logisticFunction(np.array([1,1]),theta))

def logisticRegressionByNumpy(X,y):

print('Logistic regression')

m=y.size

#print('m=',m)

on=np.ones([m,1])

#print('on=',on)

X=np.concatenate((on,X), axis=1)

#print('X=',X)

theta=np.array([0.1, 0.5, 0.7])

h=logisticFunction(X,theta)

#print(np.concatenate((X,y.reshape(-1,1),h.reshape(-1,1)),axis=1) )

alpha=0.05

iter=150

for i in range(iter):

theta=None

h= None

print('Result')

h=None

print(np.concatenate((X,y.reshape(-1,1),h.reshape(-1,1)),axis=1) )

return theta,h

theta,h=logisticRegressionByNumpy(X_D2,y_D2)

#print(logisticRegressionByNumpy(X_D2,y_D2) )

out:Logistic regressionResult[[ 1. -0.16288373 3.43367167 1. 0.11541267][ 1. 1.55329228 4.73756395 0. 0.08331115][ 1. -0.04279968 0.6211013 1. 0.56079306][ 1. 1.60298173 1.10091732 1. 0.62472714][ 1. 1.38325809 3.19346287 0. 0.22468078][ 1. 1.17770173 4.7953986 0. 0.0696791 ][ 1. 2.96888306 6.21395373 0. 0.04676088][ 1. 1.39122084 -0.63715818 1. 0.85898989][ 1. 0.89116099 1.40063691 1. 0.49801373][ 1. 2.91857287 4.03708158 0. 0.21321711][ 1. 0.42663355 1.90840112 1. 0.35579437][ 1. 3.40409547 3.03332608 0. 0.42122543][ 1. 2.01863062 1.45449509 1. 0.59678372][ 1. 0.84208557 4.83756538 0. 0.05969651][ 1. 3.65464541 2.46075746 1. 0.55858148][ 1. -2.34261668 5.1534915 0. 0.01394478][ 1. 1.03575615 4.06044832 0. 0.11267961][ 1. 3.92695109 2.41311195 0. 0.59391987][ 1. 1.96561912 4.46196485 0. 0.11739231][ 1. 2.21138502 4.10702296 0. 0.16261045][ 1. 2.10003714 3.3389728 0. 0.25489858][ 1. 2.14173991 1.29087713 1. 0.63885129][ 1. 0.99817735 -1.34650372 1. 0.90167225][ 1. 1.55174266 0.50467008 1. 0.72374108][ 1. 1.39271969 0.32816707 1. 0.73900903][ 1. 1.18106894 0.43024455 1. 0.7061229 ][ 1. -0.17785139 1.72875192 0. 0.33439181][ 1. 0.69214867 -0.94835966 1. 0.85563972][ 1. 1.16352672 6.19434289 0. 0.02393286]

[ 1. 1.2306488 0.42610014 1. 0.71082439]]

Ананасы, что идет в None?

Вот все это сочинение-простыня на тему "как я просрал время" ради регрессии? Пистон слишком костыльная параша для анализа данных.

Байтоёб, ты?

4 Кб, 48x42

4 Кб, 48x42Ок , спасибо, но почему неявно? Объясни пожалуйста на пальцах, почему не легче изменить напрямую признаки(нагенерить новые в матрице объекты-признаки)?

В самом алгоритме все явно. Кернелом трансформируются входные данные. Ты возьми да посмотри ручные реализации SVM, что там пошагово происходит.

http://tullo.ch/articles/svm-py/ вот ссылка, посмотрел охренел, с виду понятна задача оптимизации(1 пик), но что происходит у него не понятно, капец еслиб были ресурсы для дибилов было б офигенно, у него в коде ничего не ясно , спаси сохрани

Так удобней решать задачу оптимизации, признаков становиться слишком много при таком преобразовании, к тому же в случае гаусовского ядра размерность пространства бесконечна.

Код смотри, разберись что там делается с входами и выходами, для чего используется кернел, солвер квадратичных задач оптимизации. Саму математическую нотацию смотри в ISLR, говорю же там проще материал даётся.

156 Кб, 260x496

156 Кб, 260x496П0wEJl HAxyu*, gJl9 -)T0r0 EcTb ryrJl

Интересная идея, пройдись по трендам ютуба и полит роликам

Был контест такой как-то, вроде на ML Trainings разбирали, напиши челикам.

paesh gavna

Вообщем, пришел к выводу что джуну это врядли надо, с ядром разобрался, как реализовать свм в чистом виде - нет, лучше попрактикуюсь на кегле, спасибо за внимание

Бамп

sosi hui bydlo

Спрашивают обычно основы. Как работают градиентный спуск, регуляризации и т.п.

зачем столько мега сложных графиков и т.д, объясните нубу, пожалуйста

Рынки - это шум, а этот тред - магнит для шизиков типа тебя

ок, я в принцие знал это. Но можно же зарабатывать на дёргании котировок, похуй куда цена пойдёт (тут уже больше речь о математических моделях и скорей всего они тупо будут основаны на мартине)

И вообще, насколько там сильная конкуренция? А то вкатишься туда, выучишь всё, а окажется что задротов-математиков в мире нихуя не меньше, чем индусов-школьников-кодеров, дышащих в спину.

> очкую что нейросети и рыночек готовых решений лет через 10 порешают весь этот кодинг

Ты ебнулся, даже естественный сильный ИИ под названием человек программировать, в среднем не умеет. Только отдельные уникумы, каждый десятый в лучшем случае. А ты считаешь, что за 10 лет будет создана нейросеть, получше.

Максимум, кого порешают за 10 лет - это переводчиков и художников, да и то не более, чем их уже технологии порешали. Просто художник будет пользоваться нейросетями, реализуя свои концепции.

Другой вопрос, что и без нейросетей в IT есть кому кого решать.

>Другой вопрос, что и без нейросетей в IT есть кому кого решать.

ну вот я и говорю - или рыночек или нейронки (они растут по экспоненте, поэтому не стоит их отбрасывать тоже)

Так я и не про тех анализ, а про математическую модель, которая никак его не учитывает, которая не на целена на предсказания, а лишь сёрфит по волнам котировок делая ставки как в казино (но на финансовых рынках всё же можно свести мат ожидание в свою пользу + гарантированные выплаты).

ну как модель... тупо на мартингейле пусть зарабатывает робот, единственно, что нужно сделать такую логику, чтобы не проебаться (возможно на новостях даже придётся торговать, чтобы снизить риск проебать котлету, т.к. новости пока ещё работают)

теханализ это уровни

В каком трейдинге? HFT шаманство чистой воды, а в нормальном трейдинге крутятся реальные деньги, следовательно нужны реальные статистические оценки на риск и интерпретируемые модели, а не "натренил state of the art на 99% точности".

Алсо, вопрос, есть смысл с ворлд квантом связываться?

Бамп

> пусть зарабатывает робот

>единственно, что нужно сделать такую логику, чтобы не проебаться

А ты забавный

я имел ввиду, чтобы не чистый мартин был, а какой-то доп. алгоритм, который бы не дал спуститься ниже 10-го колена. Тот, кто придумает такое, естественно, станет миллиардером

объясняю

тупо натренировать модель на исторических данных равносильно в принципе древней фигне вроде подбирания наилучшей за какой-то промежуток длинны двух скользящих средних на пересечении которых надо покупать или продавать

проблема в том что эти наилучшие коэффициенты или веса наилучшие только на истории

у рыночных данных нет прогнозной силы т.е. цена не зависит или мало зависит от своего поведения в прошлом

Пук

и ты свято веришь что твоя предиктивная модель работает на реальных данных так же как и на тестовой выборке?

А ты задумывался над тем какие данные использовать для предсказания?

Для затравки: да, такие модели используются в HFT

32 Кб, 600x683

32 Кб, 600x683та ну не, на интервалах в 0,3-0,7 секунд предсказывать движение можно, тот же ордер флов инбаланс или ордер бук инбаланс. можно на поводырях модель строить. это широкая и обширная тема.

>никак не зависит от состояния рынка, от этих действий, что это шум и рандом. Как называется эта болезнь?

Маняматика головного мозга.

>на интервалах в 0,3-0,7 секунд предсказывать движение можно

две строчки кода на любом ЯП встроенном в терминал трейдера, твое нейроговно там не нужно как впрочем и в других областях

425 Кб, 931x682

425 Кб, 931x682>>89612

Тебе на матеше в портфель ссали всем классом?

В среденесрочной перспективе если центральные банки развитого мира понижают ставки, то появляются условия для надувания финансовых пузырей. Если наоборот повышают, то инвесторы бегут в облигации. Можно еще ловить отскоки после коррекции - скальпирование, но там нужен быстрый брокер с низкой комиссией. При этом при скальпировании вырываются вперед алгоритмы на низкоуровневых языках.

да лааадно, рынок имеет благоприятные состояния и неблагоприятные? А рынок то и не знал об этом

съебись в форекстред

![2038449182dd6b447329301de01b51659105dfa0e800[1].jpg](https://2ch.life/pr/thumb/1473408/15703598448000s.jpg) 36 Кб, 363x375

36 Кб, 363x375Рынок остался только в странах 3 мира. В 1 мире он сохранился только на низовом потребительском уровне. На уровне макроэкономики там давно уже коммунизм для богатых - кейнсианство.

https://ru.wikipedia.org/wiki/Неоклассический_синтез

>детекции состояний рынка

Пиздос, ты заебал своей детской кукаретикой, может пойдешь на хуй к брокеру и спустишь мамкину пенсию для начала.

Ты вместо того чтобы нести хуйню, лучше ещё раз перечитай мой пост. Если уж решил ответить. Если нет, просто мимо иди.

А ты это че раскомандовался тут?

Не маневрируй макакен, думаешьм своими дешёвыми ужимками заставишь всех забыть как ты пролюдно обосрался?

Когда ты начал какие-то формулы гуглить для элементарной задачки а потом заключил ВЫ ВСЕ БОТАНИКИ ТУПЫЕ ВОТ Я ФОРМУЛ НИУЧУ МНЕНИНАДА

63 Кб, 320x180

63 Кб, 320x180И.е это я виноват, что ты долбаеб и понятие системы и идентификации системы тебе ни о чем не говорит?

Я начал гуглить? Ты обкурился?

>ВЫ ВСЕ БОТАНИКИ ТУПЫЕ ВОТ Я ФОРМУЛ НИУЧУ

Формул-то я побольше тебя знаю, потому что знаю, как они выводятся.

Новости это такая хрень...

В большинстве пейперов про "ANALYZING NEWS/TWITTER/REDDIT/... FOR XXX PREDICTION" очень много упоминаний такой фразы: "CORRELATION IS NOT CAUSATION"

Хотя интересная тема , у тебя что-то по ней есть?

>системы и идентификации системы

Сходи к успешным трейдерам со своим матаноговном, пусть они посмеются.

А чем тогда на пальцах оно является? И почему Python лучше в этом других "модных" языков?

> А чем тогда на пальцах оно является?

Разновидностью expectation maximization (EM).

> И почему Python лучше в этом других "модных" языков?

Сойбои кроме пистона ничего не умеют. Надо соответствовать.

У питона шикарные инструменты для взаимодействия с си и си++, прекрасные инструменты для написания типизированного кода (cython), а также кода с выводом типов и jit-компиляцией (numba), а современные фреймворки это сложные системы компьютерной алгебры, где питон это просто язык для описания графов.

Кроме того, библиотеки на нем написаны профессионально и взаимозаменяемо (типа pyopencv работающий с массивами numpy как с родными).

На самом деле основной гемор питона не его тормоза, а GIL.

Там тебя научат отличать knn и kmeans

>Про R

Я с ним не знаком, но питухоноговно где навязано ООП и отсутпы табами, за язык не считаю.

>где навязано ООП

Ты сказал? В той же джаве оно навязано гораздо больше.

>и отсутпы табами

Пробелами.

>современные фреймворки это сложные системы компьютерной алгебры, где питон это просто язык для описания графов

Хм, спасибо, ясно.

Ооп в питоне если и навязано, то смоллтокоподобное, динамическое. Но оно там не навязано, можно писать как хочешь, разве что хардкор ный фп код не приветствуется что хорошо

>А к хаскелю ты как относишься?

Не смотрел на него, он мне не нужен

> В той же джаве оно навязано гораздо больше.

Жаба хотябы не тормозит как говнопитон

>Жаба хотябы не тормозит как говнопитон

Жаба тоже тормозит и еще вдобавок жрет память как ненормальная. Да и какая тебе разница, если основную работу будут выполнять библиотеки, написанные на крестах?

>если основную работу будут выполнять библиотеки, написанные на крестах?

Знаешь Жабу, знаешь Кресты и наоборот, а питухон детектор неосилятора.

>а питухон детектор неосилятора

Какой еще нахуй детектор? Питон идеален для быстрого написания прототипов, благодяря своему синтаксису и куче библиотек на все случаи жизни. Или ты из тех, кто бекпропагацию каждый раз пишет руками?

>Жаба хотябы не тормозит как говнопитон

Жаба даже в перегрузку операторов не может. То есть банальный код типа ReLU(W*Input) для жабы - недосягаемый рокетсайнс. Не говоря уже об удовольствии работы с компьютерной алгеброй на статическом языке без вменяемого вывода типов. Ты еще сопляк гнать на питон, да еще и детектировать неосиляторов где-то.

> работы с компьютерной алгеброй на статическом языке без вменяемого вывода типов.

На агду надо весь машобчик перевозить, чтобы вы зумера соснули без знания mltt. А то каждое школьное попандопуло себя программистом считает.

> нет ты абасрался нет ты

Всегда забавно как школьники на сосаке любят строить крутую мину при плохой игре как будто никому не заметно

Ага, все побежали переносить, чтобы у великовозрастного борщехлеба меньше бомбило от того, что он девственник

>перегрузку операторов не может

Нинужно, эта ООП шиза в С++ всегда забавляла, когда два объекта класса складывают

>для быстрого написания прототипов

Какого на хуй прототипа, дерганья крестовой либы?

Двачую. Заебало, что каждый молодой бородач вкатывается в нейронки даже без знания матчасти. А те, кто знает матчасть на уровне первого курса вуза, попадают в мейлру. Пиздец хайп среди убогих.

Ты сам-то матчасть знаешь, чтобы оценивать, кто как ее знает?

>Нинужно

Сейчас бы кукареканье программистишки слушать о том, кому что нужно. Ты как в этот тред залетел, голубчик?

А я не знаю, нахуя ты ее строишь. Простейшую задачу не смог решить. И даже не понял решение. А гонору, как будто не борщи ешь в своем нии.

Плати мне $50 в час, буду рассказывать, что потребуешь. Только не менее 100 часов, за более мелкие проекты не возьмусь.

Вот тебе строчка из реального проекта: y_true = y_true[:, 0, :, 0:1]. Как она будет выглядеть на жабе? Ну или любом другом языке без перегрузки.

>y_true = y_true[:, 0, :, 0:1].

>--<-<<+[+[<+>--->->->-<<<]>]<<--.<++++++.<<-..<<.<+.>>.>>.<<<.+++.>>.>>-.<<<+.

лол

Слесарьплов давно есть, как и керас.

https://www.youtube.com/watch?v=mWl45NkFBOc

Рычи, двигай тазом, и представляй, что ты уже делаешь distributed learning на облачных мощностях гугла.

425 Кб, 931x682

425 Кб, 931x682> autoML

Походу, зумеров вкатывальщиков уже порешали? Оправдывайтесь, макаки. Импорт слесарьплов и подбор эвристик уже работает лучше, чем зумер с кукареком на пустой башке из барбишопа и "знаниями" уровня курсов от инфоцыган типа шада. Вы понимаете, что не сделаете лучше чем сделает automl без вас? А это только первое такое решение.

Любой человек это нейросеть. В ЦНС больше ничего толком и нет. Я говорю о том, что с нынешним прогрессом в машобчике через пару-тройку лет средний вкатывальщик будет бибу сосать, т.к все что может он, может и без него облачный сервис от Гугла, к тому же это в разы дешевле, чем платить по 120к каждому начинающему мартыхану. И это правильно, либо знаешь нужную математику и можешь в уровень исследователя, либо сразу в Макдак кукарекать "свободная касса!!11".

Это нужно делать согласно стайл-гайду для питона в основном используют либо pep8, либо Google, в обоих отступы пробелами.

2 Кб, 273x125

2 Кб, 273x125КАК ЖЕ ВЫ ДАУНЫ ЗАЕБАЛИ

ЗУМЕРЫ БЛЯДЬ

ХУЮМЕРЫ

ПИЗДУЙ ЧИТАТЬ ПРО IEEE 754 НЕЗУМЕР ТЫ ЕБАНЫЙ

Пиздец блядь. Что за мода пошла така, в случае полной умственной неполноценности вспоминать каких-то зумеров. Отныне употребление слова зумер итт - мгновенный зашквар. Потому что нет гарантии, что это не подобное одноклеточное пишет.

Вот скажи честно, ты дегенерат? Ты вообще программировал когда нибудь? Или ты троллишь тупостью?

И вообще, что лучше всего работает из коробки?

некорректно использовать знак равенства при сравнение чисел с плавающей запятой, из-за ошибок округления, нужно использовать math.isclose

Если стандарт плох, то его надо слать подальше как целое. Брать только лучшее.

>>91706

Всякий раз, когда вижу на гитхабе отступы табами и выравнивание пробелами (тот же пайчарм так умеет) - думаю: "о, для этой планеты ещё не всё потеряно"

Потому что какие есть реальные минусы от табов? Ну, мололетние дибилы не умеют настроить свою IDE, а ещё?

Всякий раз, когда вижу как очередной дебил на полном серьезе обсуждает табы-vs-пробелы, думаю, "как же вы заебали, макаки, у вас других забот нет что ли?"

бляятььььь да какая разница-то , а -_-

В отличие от того что макакены думают, машоб это не магия и никакого полностью автоматического машоба никто не допуститв ближайшее время не предвидится. Учи нормальную математику, короче, как деды, и всё будет в порядке, а как импортить хгбуст по мере нужд подучишь.

Теплые слова, спасибо, все равно большая часть работы это пайплайны и тд(работа с данными вообщем). В крайняк пойду в науч. МашОб, матан нравится, но иногда он страшный.

IBM WATSON

>Я до 110 довел сет утром и таки понял, что на моем CPU считать вообще не варик.Так что если кто не знал, аноны, у гугла есть Google Colab, который предоставляет GPU на 12 часов.

Проще свою видеокарту купить.

90 Кб, 1159x665

90 Кб, 1159x665> никакого полностью автоматического машоба никто не допуститв ближайшее время не предвидится.

Уже допустили и уже предвидится. Причем, уже сейчас в виде решения, пригодного для использования в продакшене, а не просто как соевый стартап. Кроме Гугла аналоги аутомл выкатят все остальные крупные игроки на этом рынке, можешь скринить, уже к весне 2020 будут аналоги от Амазона и мокрософт на базе azure. Скажи ещё что алгоритм не может фичи отбирать. Какая ирония, машобчик, призванный порешать мартышек, первыми порешал мартышек от машобчика.

Предсказывать будущее и я могу, откуда такая уверенность? Без обоснований ты кажешься просто обиженкой.

> откуда такая уверенность?

Видно же, в какую сторону движется это направление. В последнее время не столько новые алгоритмы, сколько автоматизация работы с имеющимися, даже в вашем пистоне это auto sklearn, auto keras. И.е машобчик для пользователя превращается просто в фишку яп, не требующую специфических знаний. Как для работы с любым соевым яп не требуется знать регистры и уметь обращаться к ним, а в машинный код вообще не может никто кроме дидов байтоебов из ещё совковых НИИ.

А, ну и главное - у этого явления рыночные механизмы, так как машоб-мартышки требуют все больше деняк за "импорт слесарьплов ас сп", при том, что задачи они решают довольно однотипные. Конечно, сама профессия датасатаниста никуда не денется, но спрос на таких будет только в случае нестандартной задачи, не решающейся тривиально аутомлом. Ну и требования будут на уровне - мехмат, пхд, портфолио.

Конечно-конечно, утешай себя. Ты знаешь что такое кнн, закончишь шад, устроишься в Яндекс на 120кк/сек, все у тебя будет хорошо нет

Там мне не нужно чего-то гадать и утешать, ты сам своей безграмотной болтовнёй все карты раскрываешь.

Ага, держи в курсе. Про кнн не забывай писать.

А какие библиотеки C++ юзаете для машинок и нейронок?

Вы видите копию треда, сохраненную 2 ноября 2019 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.