Вы видите копию треда, сохраненную 8 августа 2019 года.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Я ничего не понимаю, что делать? Либо в тупую import slesarplow as sp по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/ | Николенко и др. "Глубокое обучение" На русском, есть примеры, но уже охват материала

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: немодифицированные персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Предыдущий:

https://2ch.hk/pr/res/1373612.html (

Архивач:

http://arhivach.ng/thread/412868/

Остальные в предыдущих тредах

Там же можно найти треды 2016-2018 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

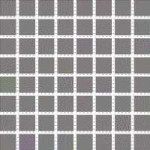

Пробую визуализировать фильтры сверточных слоев.

Слева - то, что должно быть, стандартная сеть VGG16.

Справа - моя сеть, MobilenetV2.

Почему выдает только начальный рандомный шум?

Я думал, может дело в том, что не все каналы участвуют в предсказании, но пробовал другие и другие пачки по 64 фильтра из одного и того же слоя - везде такая же фигня.

Сам алгоритм отсюда: https://github.com/fchollet/deep-learning-with-python-notebooks/blob/master/5.4-visualizing-what-convnets-learn.ipynb

плохо обучил или датасет маленький

Когда вы уже начнете со своими сетями перемогать?

Попрошайки ответ.

>Почему выдает только начальный рандомный шум?

Это не так. У тебя какие-то точечные пиксели стали сильно белыми. На этом все и застревает. Увеличивай регуляризацию

Сущесутвуют инвойсы, иными словами, документы счёт-фактура.

На пике типичный инвойс.

Счёт-фактура выставляется (направляется) продавцом (подрядчиком, исполнителем) покупателю (заказчику) после окончательного приема покупателем (заказчиком) товара или услуг

Часто случается так, что эти счета-фактуры по ошибке дублируются или продавец накосячит, как итог, оплачиваются дважды-трижды и компании несут большие убытки.

Как можно применить подход машинного обучения к решения проблемы, а именно, выявление потенциально дублированных счетов-фактур?

Я читал вот это:

https://ctmfile.com/story/payrank-an-algorithmic-approach-to-invoice-payment

В статье говорится о ранжировании и упоминается модель word2vec, которую кормили большими объемами текста. В итоге, она может превращать текст в набор ассоциаций или кластеры, которые, видимо, сравниваются, однако, все равно не понятно как всё работает. Все доступные Счёта-фактуры превращаются в набор ассоциаций и это набор сравнивается со всеми остальными и ищутся схожести?

Заранее спасибо.

Epoch 1/10

2000/2000 [==============================] - 346s 173ms/step - loss: 0.0367 - acc: 0.9924 - val_loss: 0.1006 - val_acc: 0.9819

Epoch 00001: val_loss improved from inf to 0.10056, saving model to /content/drive/My Drive/last_result/linknet_model.hdf5

Epoch 2/10

2000/2000 [==============================] - 337s 169ms/step - loss: 0.0066 - acc: 0.9979 - val_loss: 0.0146 - val_acc: 0.9947

Epoch 00002: val_loss improved from 0.10056 to 0.01463, saving model to /content/drive/My Drive/last_result/linknet_model.hdf5

Epoch 3/10

2000/2000 [==============================] - 337s 169ms/step - loss: 0.0048 - acc: 0.9984 - val_loss: 0.0163 - val_acc: 0.9964

Epoch 00003: val_loss did not improve from 0.01463

Epoch 4/10

2000/2000 [==============================] - 337s 168ms/step - loss: 0.0052 - acc: 0.9984 - val_loss: 0.0299 - val_acc: 0.9947

Epoch 00004: val_loss did not improve from 0.01463

Epoch 5/10

2000/2000 [==============================] - 337s 169ms/step - loss: 0.0044 - acc: 0.9985 - val_loss: 0.1095 - val_acc: 0.9860

Epoch 00005: val_loss did not improve from 0.01463

Epoch 6/10

2000/2000 [==============================] - 337s 169ms/step - loss: 0.0042 - acc: 0.9986 - val_loss: 0.0537 - val_acc: 0.9930

Epoch 00006: val_loss did not improve from 0.01463

Epoch 7/10

2000/2000 [==============================] - 337s 168ms/step - loss: 0.0039 - acc: 0.9986 - val_loss: 0.0393 - val_acc: 0.9940

Epoch 00007: val_loss did not improve from 0.01463

Epoch 8/10

2000/2000 [==============================] - 337s 168ms/step - loss: 0.0043 - acc: 0.9986 - val_loss: 0.0438 - val_acc: 0.9935

Epoch 00008: val_loss did not improve from 0.01463

Epoch 9/10

2000/2000 [==============================] - 337s 168ms/step - loss: 0.0041 - acc: 0.9987 - val_loss: 0.0295 - val_acc: 0.9918

Epoch 00009: val_loss did not improve from 0.01463

Epoch 10/10

2000/2000 [==============================] - 338s 169ms/step - loss: 0.0038 - acc: 0.9987 - val_loss: 0.0698 - val_acc: 0.9911

Epoch 00010: val_loss did not improve from 0.01463

Как я понял, идет переобучение(?), как с ним можно бороться?

Epoch 1/10

2000/2000 [==============================] - 346s 173ms/step - loss: 0.0367 - acc: 0.9924 - val_loss: 0.1006 - val_acc: 0.9819

Epoch 00001: val_loss improved from inf to 0.10056, saving model to /content/drive/My Drive/last_result/linknet_model.hdf5

Epoch 2/10

2000/2000 [==============================] - 337s 169ms/step - loss: 0.0066 - acc: 0.9979 - val_loss: 0.0146 - val_acc: 0.9947

Epoch 00002: val_loss improved from 0.10056 to 0.01463, saving model to /content/drive/My Drive/last_result/linknet_model.hdf5

Epoch 3/10

2000/2000 [==============================] - 337s 169ms/step - loss: 0.0048 - acc: 0.9984 - val_loss: 0.0163 - val_acc: 0.9964

Epoch 00003: val_loss did not improve from 0.01463

Epoch 4/10

2000/2000 [==============================] - 337s 168ms/step - loss: 0.0052 - acc: 0.9984 - val_loss: 0.0299 - val_acc: 0.9947

Epoch 00004: val_loss did not improve from 0.01463

Epoch 5/10

2000/2000 [==============================] - 337s 169ms/step - loss: 0.0044 - acc: 0.9985 - val_loss: 0.1095 - val_acc: 0.9860

Epoch 00005: val_loss did not improve from 0.01463

Epoch 6/10

2000/2000 [==============================] - 337s 169ms/step - loss: 0.0042 - acc: 0.9986 - val_loss: 0.0537 - val_acc: 0.9930

Epoch 00006: val_loss did not improve from 0.01463

Epoch 7/10

2000/2000 [==============================] - 337s 168ms/step - loss: 0.0039 - acc: 0.9986 - val_loss: 0.0393 - val_acc: 0.9940

Epoch 00007: val_loss did not improve from 0.01463

Epoch 8/10

2000/2000 [==============================] - 337s 168ms/step - loss: 0.0043 - acc: 0.9986 - val_loss: 0.0438 - val_acc: 0.9935

Epoch 00008: val_loss did not improve from 0.01463

Epoch 9/10

2000/2000 [==============================] - 337s 168ms/step - loss: 0.0041 - acc: 0.9987 - val_loss: 0.0295 - val_acc: 0.9918

Epoch 00009: val_loss did not improve from 0.01463

Epoch 10/10

2000/2000 [==============================] - 338s 169ms/step - loss: 0.0038 - acc: 0.9987 - val_loss: 0.0698 - val_acc: 0.9911

Epoch 00010: val_loss did not improve from 0.01463

Как я понял, идет переобучение(?), как с ним можно бороться?

>Как я понял, идет переобучение

Далеко не факт, у нейронок большое значение дисперсии метрик.

>как с ним можно бороться

Регуляризацией или уменьшением сложности нейронки.

К тому же у тебя нейронка не до конца сошлась (лосс на обучении болтает), уменьшай скорость градиетного спуска динамически на плато https://keras.io/callbacks/#learningratescheduler

max_len = max(len(sentence) for sentence in corpus)

corpus_padded = [sentence + ["#PADDING#"] * (max_len - len(sentence)) for sentence in corpus]

спасибо

25 Кб, 581x224

25 Кб, 581x224>Не может такого быть

ВРИОТИ, швитые дип нейроночки это как мозг почти что

https://arxiv.org/abs/1607.08366

Что, собственно элементарно решается аугментацией. Только для большинства практических применений и не нужно.

Слышь, не раскачивай лодку, нам ещё лохов на нейронки обувать

Ты хочешь, чтобы GoogleNet за тебя сам выделил объекты, выделил их фичи, и сравнил? Дохуя хочешь.

489 Кб, 1500x1073

489 Кб, 1500x1073https://daily.afisha.ru/news/27307-neyroset-ot-microsoft-napisala-abstraktnuyu-kartinu-na-osnove-pesni-na-zare/

> Нейросеть от Microsoft написала абстрактную картину на основе песни «На заре»

> Microsoft разработала нейросеть, основанную на принципах синергии музыки и живописи, описанных абстракционистом Василием Кандинским. Алгоритм смог нарисовать картину по мотивам песни «На заре» группы «Альянс». Об этом «Афише Daily» рассказали в «Microsoft Россия».

> Нейросеть обучили на картинах Кандинского и музыкальных произведениях, которые его вдохновляли. Проанализировав принцип взаимосвязи между музыкой и живописью, ИИ реализовал его на примере песни «На заре».

> В Microsoft сказали, что выбрали именно эту песню, поскольку она сочетает традиции с современностью и не теряет своей актуальности. Кроме того, разработчики хотели создать картину на музыку, которую никогда не слышал Кандинский.

54 Кб, 493x747

54 Кб, 493x747Именно, самое главное сделал я. А потом кто-то из DeepMind спиздил мою идею и даже не указал этого

>абстрактную картину

Как они мазню хитро назвали и вот уже не хуета, а картина, а вы ничего не понимаете.

> Как они мазню хитро назвали и вот уже не хуета, а картина, а вы ничего не понимаете.

Мамкин искусствовед прохудился.

Вот давай мне подобие Шишкина или Айвазовского, а не эту рендомную залупу, которая для эстетов и прочих поехавших.

> Вот давай мне подобие Шишкина или Айвазовского

Любой фотоаппарат + пара фильтров в Фотошопе. Ещё пару лет назад делали нейроночки, которые по тексту рисуют картинки. Это все хуйня. А вот нарисовать картину по музыке, исходя из принципов синергии Кандинского, это достижение.

Нет конечно, какая семантика.

Есть в тексте слово коты - нахуячим кота, есть стол - стол заебнём.

А если вместо кота напишешь "мохнатый пидарас" будет селфи гудфеллоу.

>кто-то на свете понимает вообще эту шизофазию

Ты не ценитель искусства? Там примерно так и объясняется, что это мол не говно и мазня, а великий шедевр имеющий глубокий тайный смысл.

>великий шедевр имеющий глубокий тайный смысл

После унитаза дюшана эти высеры для меня имеют смысла столько же, сколько свежевысранный бомжом кусок кала.

Вот классическая музыка - да, это топчик.

>Вот классическая музыка - да, это топчик.

Сорта говн, мне 99.9% классики не заходит, вот такое гонво еще можно слушать

https://youtu.be/bZ_BoOlAXyk

но это не тру классика

86 Кб, 1140x413

86 Кб, 1140x413Судя по периодичности напрашивается преобразование Фурье (STFT) и посчет энергии высоких частот. Если их дохуя, значи много шума.

Я понимаю. Кандинский охуенен.

А сгенерированное нейронками это примерно как сгенерированное нейронками порно. Мельком взглнешь - вроде что-то пошлое, приглядишься к деталям - ошметки какой-то хуиты и ни одного хуя даже нет.

Элементарно это не решается, только брутфорсом. Для решения этой проблемы Хинтон даже капсульные сети попробовал запилить. Получилась хуита (а когда у него была не хуита?).

Другой вопрос что человек например тоже хуево подобные задачи решает, он не может взять и одним взглядом определить то или не то, нужно сидеть и думать. Фактически это значит что нужна RNN с модулем внимания.

> А сгенерированное нейронками это примерно как сгенерированное нейронками порно. Мельком взглнешь - вроде что-то пошлое, приглядишься к деталям - ошметки какой-то хуиты и ни одного хуя даже нет.

Так в этом и смысль! Нейроночка из датасета с поревом учится выделять саму суть порно. В итоге человек на сгенерированном контенте однозначно видит порно, хотя по факту там даже ни хуя ни пизды нет. Это и есть истинный абстракционизм.

Истинный абстракционизм не в том. Нейронка может сделать style transfer и любой провинциальный художник может сделать картинку "под кандинского". Но изначально выдумать свой стиль, который будет узнаваем, быть приятным для глазу иметь какую-то семантику и т. д. - вот это творчество.

>натаскивают разные параметры

Да, здорово.

Вся математика это суть одна задача, просто с разными параметрами.

> Весь машоб - это штук десять задач, на которые натаскивают разные параметры.

Ровно две - регрессия и классификация. Причем, при желании классификацию можно рассматривать как дискретную регрессию, а регрессию как непрерывную классификацию.

А что такое робастная оценка дисперсии ряда?

Вся математика = все математические задачи

42 Кб, 753x816

42 Кб, 753x816Все мы знаем, что нейросети, чтобы обучиться, надо дохуища примеров. Если есть дообучается, то меньше, но один хуй много.

Для сложных объектов вроде разных пород котов или разных моделей автомобилей - не менее нескольких сотен.

Что, если я скажу, что можно создать сеть, которая будет обучаться на 5-10 примерах для каждого класса?

Важный нюанс! Многие об этом забыли. Дело в том, что человек живет в трехмерном мире, но зрение у него двухмерное.

Человек не видит "вглубь" предметов.

Он всегда видит лишь двухмерную проекцию трехмерного мира.

Но!

При взгляде на абсолютно любой предмет у человека в мозгу сразу же возникает 3D-модель этого объекта.

Это хуйня работает настолько быстро и автоматически, что люди вообще забывают, что вообще-то не видят реальный трехмерный мир. Но им это не мешает, ибо мозг сразу же создает полноценную 3D-модель того, что видит. Трехмерная сцена комнаты, трехмерный шкаф, трехмерный стул. Даже если человек не видит обратной стороны шкафа, он знает, что она там есть.

Так и работает зрение. Мы видим тигра. Мы видим ТИГРА. Не его 2D-проекцию, нет, мы видим всего тигра целиком, хотя мы видим только морду тигра, но не его жопу. Но тем не менее, жопа тигра тоже постоянно присутствует в нашем сознании.

Так вот, к чему я веду. Нейросети должны делать точно так же. При виде двухмерной картинки, они должны тут же составлять полноценную 3D-модель всего, что видят. Модель всей сцены, модель каждого знакомого объекта в ней.

И даже незнакомого. Человек способен с высокой точностью предсказать 3D-вид объекта, даже если он в первый раз в жизни его видит и еще не видел со всех сторон. Его сознание дорисует недостающее. Сетки тоже так умеют, но для 2D.

Так вот, эта хуйня полюбасу должна повысить точность сетей.

Вместо тупого анализа 2D-проекции, сеть должна построить 3D-модель и анализировать ее.

Это потребует значительных вычислительных ресурсов. Полагаю, даже текущие немаленькие сетки вырастут в размерах еще в десятки раз. Производительность тоже потребуется соответствующая.

Можете скринить, через 5 лет выкатят сеть, которая будет работать в точности, как я сказал.

42 Кб, 753x816

42 Кб, 753x816Все мы знаем, что нейросети, чтобы обучиться, надо дохуища примеров. Если есть дообучается, то меньше, но один хуй много.

Для сложных объектов вроде разных пород котов или разных моделей автомобилей - не менее нескольких сотен.

Что, если я скажу, что можно создать сеть, которая будет обучаться на 5-10 примерах для каждого класса?

Важный нюанс! Многие об этом забыли. Дело в том, что человек живет в трехмерном мире, но зрение у него двухмерное.

Человек не видит "вглубь" предметов.

Он всегда видит лишь двухмерную проекцию трехмерного мира.

Но!

При взгляде на абсолютно любой предмет у человека в мозгу сразу же возникает 3D-модель этого объекта.

Это хуйня работает настолько быстро и автоматически, что люди вообще забывают, что вообще-то не видят реальный трехмерный мир. Но им это не мешает, ибо мозг сразу же создает полноценную 3D-модель того, что видит. Трехмерная сцена комнаты, трехмерный шкаф, трехмерный стул. Даже если человек не видит обратной стороны шкафа, он знает, что она там есть.

Так и работает зрение. Мы видим тигра. Мы видим ТИГРА. Не его 2D-проекцию, нет, мы видим всего тигра целиком, хотя мы видим только морду тигра, но не его жопу. Но тем не менее, жопа тигра тоже постоянно присутствует в нашем сознании.

Так вот, к чему я веду. Нейросети должны делать точно так же. При виде двухмерной картинки, они должны тут же составлять полноценную 3D-модель всего, что видят. Модель всей сцены, модель каждого знакомого объекта в ней.

И даже незнакомого. Человек способен с высокой точностью предсказать 3D-вид объекта, даже если он в первый раз в жизни его видит и еще не видел со всех сторон. Его сознание дорисует недостающее. Сетки тоже так умеют, но для 2D.

Так вот, эта хуйня полюбасу должна повысить точность сетей.

Вместо тупого анализа 2D-проекции, сеть должна построить 3D-модель и анализировать ее.

Это потребует значительных вычислительных ресурсов. Полагаю, даже текущие немаленькие сетки вырастут в размерах еще в десятки раз. Производительность тоже потребуется соответствующая.

Можете скринить, через 5 лет выкатят сеть, которая будет работать в точности, как я сказал.

Насколько я знаю, человек может распознавать глубину из-за того, что у него два глаза в разных местах, то есть он получает две слегка разных картинки.

Нет, эта хуйня. Ты вторым глазом видишь заднюю поверхность шкафа?

Дело в мозге. Мозг создает 3D-модель.

Бинокулярное зрение - лишь аппаратный финт, помогающий быстро и более точно динамически оценивать расстояние до объектов.

Тип тигр в пяти метрах или в трех.

Ты можешь все то же самое и с одним глазом. Да, будет чуток похуже, но лишь чуток.

Я думал, может глубокие сети, за счет выявления все более высокоуровневых признаков, имитируют создание 3D а то и 4D и 58D-модели?

НЕТ, НИХУЯ.

Погляди на любую сверточную сеть - тупо набор двухмерных фильтров.

Сеть в принципе не анализирует 3D-информацию, она всегда видит сраное 2D.

Тот же хуй, только в профиль.

закрыл один глаз и все плоским стало

Короче, первые несколько слоев должны делать конвертацию 2D->3D, а далее все как обычно, но трехмерное ядро свертки ездит уже по трёхмерной пикче.

Фильтры получаются трехмерные.

Пушка же!

Ближе к мозгу - не значит хорошо. Зависит от задачи. В мозгу скорее всего дохуя избыточности, всяких контекстов. Работает, конечно, охуенно, хотя и не без косяков, но это все же косо-кривая биологическая система, собранная слепой природой. В идеале, чтобы выжать максимум из компов, у них должна быть какая-то особая логика, вполне вероятно отличная от человеческой.

Запилить-то мб запилят, мб даже сейчас кто-то пилит, но сомневаюсь, что будет какой-то прорыв. Прорыв будет ровно настолько, насколько затратнее оно станет.

Да один хуй, попробовать стоит.

Не получится - ну и похуй.

Зато если получится - будет охуенно.

Неужели никто не делал ничего подобного?

Знаю, есть сети, которые строят 3D-модель объектов.

Но неужели никто не пробовал совместить это с обычными сверточными сетями?

Полюбасу же теряется трехмерная информация.

Возможно, чтобы извлечь важные признаки из 2D-картинки нужно больше примеров обучающей выборки, чем из 3D-картинки.

Допустим, сесть построила сперва 3D-пикчу. А тут хопа - и сразу видны отличительные признаки класса.

А может и вовсе быстрее вычисляются со слоями, высокоуровневые представления быстрее извлекаются.

Смотреть на 2D-проекцию 3D-мира - тупиковый путь.

Если нет сразу 3D-данных, то строить их автоматически и анализировать именно их, а не сраное 2D.

Теперь будет аж 3 стадии обучения.

1. Сеть, которая строить 3D по 2D. Такие могут даже отдельно обучать на каких-то своих данных.

2. Обучение обычной большой выборке вроде ImageNet.

3. Обучение твоей целевой выборки.

>Возможно, чтобы извлечь важные признаки из 2D-картинки нужно больше примеров обучающей выборки, чем из 3D-картинки.

Если модель воксельная, то нихуя не поменяется, только сложность в 1.5 раза увеличится. Если полигональная модель, то хуй ты че предскажешь, там уже свертку не применишь просто так.

>Если модель воксельная, то нихуя не поменяется, только сложность в 1.5 раза увеличится

Пруфы?

Ну ок, не в 1.5, а даже больше. Свертки в степень 1.5 увеличатся, плюс затраты на саму генерацию модели и прочую хуйню.

voxelnet и 3D cnn уже существуют так-то

17 Кб, 474x237

17 Кб, 474x237>Все мы знаем, что нейросети, чтобы обучиться, надо дохуища примеров.

А человеку не нужно? Новорожденный год срет под себя и пускает пузыри, фактически реализуя генетическую программу. Говорить он начинает только через пары лет в среде. При этом обучается он непрерывным видеопотоком, гигабайтами информации ежечасно. Уже доказано, что если держать котят слепыми первое время жизни, они не научатся видеть никогда.

Очевидно, что все, что мозг делает - это файнтюнинг того, что было наработано в детстве. Поэтому и возникает иллюзия быстрого обучения. А на самом деле достаточно, например, заняться чем-то принципиально новым, например, игрой на гитаре, чтобы понять, насколько мозг на самом деле медленный и неэффективный.

При чем именно сверточность сетей как раз очевидна по тому, как работают оптические иллюзии типа пикрелейтед. Некоторые женщины даже карту в уме повернуть не могут.

>Дело в том, что человек живет в трехмерном мире, но зрение у него двухмерное.

А еще цветное зрение это только поле примерно в 2 градуса, а еще у глаза дикие аберрации. Поэтому все, что реально поступает со зрением - это рандомные куски картинки 2х2 градуса, которые глаз сканирует за счет непроизвольных движений. В этом плане нейронка, которая может взять картинку в 16384х16384 пикселей и за один проход через U-Net хуйнуть сегментацию каждого пикселя - для мозга это просто рокет саенс.

Вообще же твоя идея не нова, читай Хинтона про капсульные сети. Я считаю, что это тупиковый путь по описанным выше причинам, но тем не менее.

21 Кб, 640x538

21 Кб, 640x538удваиваю

> Сеть в принципе не анализирует 3D-информацию, она всегда видит сраное 2D.

Это она тебе когда бухали вместе выдала всё как на духу?

А GAN это классификация или регрессия?

Не только. Есть еще я.

411 Кб, 512x512

411 Кб, 512x512Напомнило вот эти видео:

https://www.youtube.com/watch?v=IOHayh06LJ4

https://www.youtube.com/watch?v=8VdFf3egwfg

47 Кб, 533x800

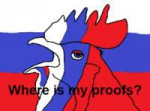

47 Кб, 533x800Подумываю перекатиться из enterprise в нейросети, но пока что неясен рынок труда в РФ

Аж целый тред "мы вам перезвоним".

https://www.rbc.ru/technology_and_media/04/06/2019/5cf50e139a79474f8ab5494b

По-моему, такой хуйни вообще нет. Недообучение есть, пере - нету.

Переобучение - недостаток обобщения. Вполне себе бывает в жизни, человек задрочил факт, и если поменять переменные в нем, он уже не может разглядеть его.

Действительно.

Эффект тетриса?

Эти ебаные окончания, падежи, спряжения, формы числительных и т.д. и т.п. Да тут блядь двух одинаковых слов в предложении не бывает.

Во всех (английских, разумеется) статьях по NLP токенизация выполняется тупо разделением по пробелам и этого оказывается достаточно для большинства простых задач.

Но в русском языке такое говно по дефолту не прокатит.

Че делать?

10 Кб, 254x190

10 Кб, 254x190Спасибо, анон, это будет хорошей отправной точкой

126 Кб, 419x249

126 Кб, 419x249Повторяется история с перцептрончиками, тогда тоже все скисло на всякой дрочьбе вприсядку из-под ноги типа OBD, OBS (optimal brain damage / surgery). После чего сверточные нейроночки торжественно определят в петушиный угол и найдут что-то другое, на основе statistical learning theory

Тебе нейронки для такой задачи не нужны, OpenCV хватит

>на основе того, что очередные фокусники из гугла для лулзов протестят очередной высер на своем кластере, а он возьмет, да выстрелит

>а потом быстро накатают под это статейку, мол они сверхразумы, вели тщательные исследования и мол так и было задумано, никаких случайностей

Просто вызвать как GradientDescentOptimizer().minmize(loss) нельзя?

Выдаёт ошибку TypeError: __init__() missing 1 required positional argument: 'learning_rate'

Насколько хорошо нужно знать дискретную математику и теорию графов в бигдате и машинном обучении?

Не факт, тут уж как повезет, зависит от данных и от "модели".

594 Кб, 840x854

594 Кб, 840x854> Нет, нечеткий петух, история не повторяется,

Повторяется. Генерация несуществующих сельдей и котов уже никого не удивляет, а новых достижений что-то не завезли.

Откуда ты можешь знать, что там завезли или не завезли, если ты не следишь за темой и не читаешь пейперы (для чтения которых у тебя отсутствует математическая база)?

> Откуда ты можешь знать, что там завезли или не завезли, если ты не следишь за темой и не читаешь пейперы (для чтения которых у тебя отсутствует математическая база)?

Ну ты расскажи. Ты ж умный, телевизор поди смотришь.

Ясно, понятно. Как всегда, одни кукареканья и пердёж в лужу без всякой конкретики.

Родители твои быдло. Ты ж даже слиться нормально не можешь, какие-то ебланские маневры ни для чего. Передо мной можешь не выебываться, ты мне никто. А перед самим собой давно стоило бы признать, что ты дебил.

if hash(invoice) == hash (invoice[j]) and invoice.title == invoice[j].title:

_____invoice.is_valid = '?'

_____questionable.append(invoice)

Добавлять машинное обучение сюда просто идиотия.

9 Кб, 316x317

9 Кб, 316x317>не совсем понимают как оно работает

Лол. С помощью import keras можно решать 90% задач, а понимают пусть умники всякие в гуглах

12 Кб, 380x443

12 Кб, 380x443Но это же шаманство в чистом виде, даже веб-макакены обладают большим пониманием своей области

>Генерация несуществующих сельдей и котов уже никого не удивляет

Кого - никого? Тебя ведь это никогда не удивляло. Сколько лет ты рассказываешь о том, что нихуя нового нет, и что мол никого не удивляет. Удобный манямирок создал и живешь в нем.

А за это время люди типа меня пейперы доводят до продакшена и устанавливают на каждом утюге. Ты как протопоповец-девственник, который пытается доказать, что тянок ебать нужно вовсе не так, и вообще секс это скучно.

>типа меня пейперы доводят до продакшена и устанавливают на каждом утюге

Довай ссылу, посмотрим на твою йобу.

Иди нахуй

> ы как протопоповец-девственник, который пытается доказать, что тянок ебать нужно вовсе не так, и вообще секс это скучно.

Причем тут это? Я говорю, что нынешние нейроночки это путь в никуда по вполне очевидным причинам. Я это говорил во время хайпа, я и сейчас это говорю, когда хайп уже начал сдуваться.

Да я помню, что ты говоришь. Уже года три, наверное. Только вот такая твердолобость это не показатель ума, совсем.

Извини компутер, я не хотел тебя обижать =) ну если так то можешь порекомендовать чтива по этому поводу? можно конечн она дижиталфлоу сделать себе собеседника, но я хочу как папакарло выстругать \ту дрять самостоятельно(конечно не самомстоятельно а просто спиздить готовый код)

Читай в сторону от дифференцируемых функций.

А вообще, у нас кудахтеры очень слабые.

Тут даже микросетку по распознаванию собачих анусов неделю обучают.

> Только вот такая твердолобость это не показатель ума, совсем.

А это не твердолобость, это понимание вопроса. Все эти нейроночки только за счёт закона Мура ещё на плаву держатся. Действительно умных решений типа иерархического софтмакса единицы, в основном все решается методом "наебенить побольше слоев / нарастить кластер". Будущее за квантовыми вычислениями, а квантовая логика считай другое название нечеткой и любой квантовый вычислитель де-факто суть fuzzy inference system.

>Будущее за квантовыми вычислениями, а квантовая логика считай другое название нечеткой и любой квантовый вычислитель де-факто суть fuzzy inference system.

Спасибо, мы вам перезвоним.

> Хуйня в кубе, еще больший попил чем нейронки.

Если бы это был только попил, на этой теме пилили бы только госконторы, в том числе в Блинолопатии. А этого нет. Тому же Брину какая от этой темы польза, он что на пентагоновских госконтрактах сидит? А почему до сих пор нет "роскванта" с Чубайсом во главе? Думаешь, он хуже тебя в распилах понимает?

16 Кб, 400x400

16 Кб, 400x400Нейросеть ведь нельзя тренировать после наступления эффекта переобучения?

Иначе она высосет слишком много нерелевантных данных из обучающей выборки, верно?

И на новых данных будет пытаться их найти, ухудшая качество на данных, которых никогда не видела прежде.

>1. Сеть, которая строить 3D по 2D. Такие могут даже отдельно обучать на каких-то своих данных.

Такое уже есть

однако все еще проходят подобные мероприятия http://opentalks.ai/ru/turing-test

значит проблема осталась

>>12949

Пасяб

>Ебут в жопу красноглазиков с матфаков, которым не хатает социальных навыков самостоятельно выступать на конфах и зарабатывать бабло.

Ты можешь на изи проверить свою идею. Берёшь к боттлнек слою vgg16 прикручиваешь несколько deconv+batch norm слоёв. И тренируешь одновременно две задачи - классификация изображения и построение карты глубины изображения. Дальше на валидационном сете проверяешь точность классификации. Если она выше, чем без auxiliary task, то публикуешься и начинаешь искать нормальную архитектуру для deconv слоёв.

Как-то слишком сложно звучит, я больше по части высказывания всяких шизоидных высеров, а не программированию

ну попробуй этот таск решить своим реснетом или вгг, однохуйственно

Тестю вручную на тех же валидационных данных - нихуя, блядь, не распознает, точнее точность гораздо ниже 80%, по ощущениям процентов 30.

Как это возможно вообще?

Ах ты ж блядь, сильно похоже, что я перепутал лейблы.

Питон же грузит папки в своей маня-сортировке.

И порядок классов в итоге при flow_from_directory получается ДРУГОЙ.

Ща протестю и напишу, если это так

Ах ты ж блядь, да, это так.

Ебаный порядок классов.

Я 2 месяца юзал сеть с перепутанным порядком классов.

А она все это время хорошо работала.

Да моя сеть на новых данных работает еще пизже, чем на валидационных.

> Я 2 месяца юзал сеть с перепутанным порядком классов.

И норм было. Вся суть практического использования ваших нейроночек. Простой рандом и то работал бы лучше.

>И норм было

На самом деле нет, но я это скрывал. Я все это время думал, что я допустил какой-то фатальный недостаток вроде переобучения и сама сеть - говно.

А она была заебись, просто я даун и не проверил порядок классов.

Теперь все сходится, я все это время был прав, все было заебись

Ну какг бэ на кагле свои виртуалки, где в итоге тестится проект.

Но никто тебе не мешает использовать любое железо.

Есть ~500 обработанных вордовских страниц оргинал | перевод, дальнейшие тексты примерно похожей тематики и терминологии.

Реально вообще хоть немного облегчить и автоматизировать свой труд или я что-то упускаю?

По поводу машинного перевода нужно смотреть в сторону поделий от Facebook ai research. Они единственные занимаются архитектурами, которые в такое могут или почти могут. Посмотри ихний гитхаб с описаниями проектов, точно что-то такое там попадалось. Все остальное типа seq2seq для твоей задачи хуета полная.

Если сделать оценщик адекватности, то можно запускать adversarial learning, так ведь?

На объектах есть технические пометки, типа "ТП 2008-10" "ПГ 1007-16" и т.д. Формат всегда один и тот же. Помогите правильно составить вектор Y (метки)

Формат: (буква, буква, 4хцифры - цифра, цифра)

я правильно понимаю, что Y должен быть ([Y1а, Y1б, Y1в ....][Y2а, Y2б, Y2в][Y30, Y31...Y39][Y40...Y49]...[Y80...Y89]), где все эти Y - или 0, или 1?

>>16329

Если ТП, ПГ, 2008, 1007 итп это категории (т.е. у тебя конечное и очень ограниченное количество вариантов из двух букв/из четырёх цифр, встречающихся в данных) то лучше просто для каждого варианта сделать свой выход и тренировать сеть чтобы она вероятностные распределения на этих категориях предсказывала.

нет, там 36 возможных букв и 10 возможных цифр. То есть бывают и варианты "АА 7777-15" и т.д.

Это уже распознавание текста. То есть сначала тебе надо найти текст на изображении - это похоже на предсказание bounding box, а потом его распознать - это задача сродни image captioning. Хотя ещё разумнее, как мне кажется, искать отдельные цифры и буквы и их распознавать отдельно. Сколько у тебя вообще данных есть? Как выглядит типично изображение?

данных очень мало, не для всех классов.

Согласен, тут скорее распознавание текста.

Шарить типичное изображение не могу, увы, но изображение всегда четкое и всегда падает один и тот же свет, с этим никаких проблем.

Проблема только в том, что нет данных для всех возможных классов, так как не все объекты пока существуют (не построены)

Спасибо за подсказку

о, моя задача очень похожа на распознавание номеров

Ее тоже решают через OCR, не через классификацию?

40 Кб, 1177x662

40 Кб, 1177x662Тип прадакшена стало больше, стали более лучше распознавать негров, овощи там, рожь, вот это все, стартапы ненужны. Ясно, понятно. Рулю пизда, из нейроночек больше не выжать, их использование усложняется, системные требования растут лавинообразно. Года 2-3 назад для проекта хватало двух сойбоев - друзей по жопе, сейчас нужна мощная команда + немаленькие влошения. Собственно, приплыли. Скоро до всех дойдет, что нужно искать что-то ещё.

Кто вкатился - будет на коне, время, когда для первой работы достаточно ввести import keras кончилось

88 Кб, 454x600

88 Кб, 454x600И будет он всегда выдавать "человек" на любых данных. Нет, тут надо посложнее.

>Скоро до всех дойдет

>Скоро, скоро

Шел очередной год вечеринки, на которую нечеткого петуха не пригласили.

он не будет всегда выдавать "человек" на любых данных, он будет выдавать % того, что на картинке человек...

Такое время было только в маняфантазиях посетителей этого треда, никто из которых работу, что характерно, не нашел.

Ирл знаю людей, которые в проде тупо скачивают модели с торч хаба, меняют целевую функцию и деплоят. Зарабатывают побольше всяких программистов, от чего чсв выше крыши.

Там же, где работают всякие бестолковые кодеры, которые искренне удивляются задачам на вечерние деревьев в крупных ит-компаниях — в ноунейм стартапах и прочем малом бизнесе.

Представляю ваш диалог

- Я работаю над мл в таком-то стартапе

- Гыы-гы-гы, лол, качаешь модельки, а сам нихуя не делаешь)))

- Иди нахуй

- Ыыы. лалка у тебя чсв выше крыши)))

Я спрашивал о деталях. А когда спросил "а как же математика и все такое", мне сказали, что это для задротов и в нейронках достаточно интуитивного понимания.

https://www.tensorflow.org/tutorials/keras/basic_classification

только на последнем слое 1 выход и функция sigmoid

А как "всё остальное" набрать? Вот у нас в датасете - только фотографии людей. Что делать? Качать ещё один? То есть такой подход (+ использовать неправильно классифицированные фотки как дополнительные негативные примеры) понятен, он уже старый, ещё до нейронок был известен. С тех пор других идей не появилось?

>А как "всё остальное" набрать?

Да как хочешь.

>Качать ещё один?

C dial up сидишь?

>С тех пор других идей не появилось?

Предложи свои

Если почитать Фейнмана, может сложиться такое же впечатленеие - физика это просто и интуитивно, вообще раз плюнуть. Вышел и нобелевку получил.

>С тех пор других идей не появилось?

Появилась, GAN называется. Генератор учится генерировать что-то похожее на твой датасет, дискриминатор отличать датасет от не-датасета. Потом генератор ты выкидываешь, а дискриминатор используешь для классификации.

Правда негативные примеры все равно будут работать лучше.

> Появилась, GAN называется.

Ровно одно сомнительное достижение с ограниченным применением типа нагенерить несуществующих сельдей по набору существующих.

Можешь и дальше отрицать реальность, хотя вон выше даже графики подвезли. Все происходящее закономерно, я вообще ничего удивительного в этом не вижу, это вы итт наяривали из-под ноги на всемогущие нейроночки когда я уже говорил, почему не взлетит.

Мне кажется, там самое ценное - идея adversarial training. По идее, в задачах генерации сложных объектов она на ура зайдёт. Например, при генерации текстов - тут и перевод, и captioning.

Сейчас бы с петухами, которые судят о ганах по статьям на хабре, обсуждать их применение.

>>16702

Происходящее очень закономерно: новая индустрия растет и крепнет, на место ученым приходят инженеры, которые берут разработки и выжимают из них максимум, что ученым не очень интересно. Как жаль, что ты настолько тупой, что тебе остается только рассказывать о том, как мы тут тензорфлоу импортируем.

Самое ценное - идея того, что любую функцию в пайплайне нейронки можно заменить другой нейронкой. Например, типичная ситуация: у тебя есть датасет, но он маленький. Тебе нужно аугментировать данные. Ты можешь сделать это вручную (сдвиги-повороты, хуе-мое). А можешь сделать аугментатор в виде нейронки, у которой на входе картинка из датасета и случайный вектор и целевой функцией так саугментировать, чтобы наебать твой классификатор, но не слишком сильно.

Или, наоборот, если ты проектируешь генератор, то дискриминатор - это на самом деле продвинутый самообучаемый лосс.

Есть для машинного перевода без учителя, но там адверсарная часть сидит на выходе кодировщика в промежуточное представление: https://openreview.net/pdf?id=rkYTTf-AZ

33 Кб, 405x552

33 Кб, 405x552>NLP

>Рычи, двигай тазом.

Ты там для какого языка делаешь, если для аналитического англоговна то более менее создат иллюзию, если для нормальных языков то соснешь, не мучайся.

он только в нечеткие модели и экспертные системы верит. Русске вообще шизики. Заходишь в комментарии на каком-нибудь хабре - а там перепись нечетких дегенератов. https://habr.com/ru/company/recognitor/blog/455676/

(наш нечеткий петух тоже звезда хабра)

Зумера нихуя не понимают, но свое зумерское мнение имеют. Посмотри хоть в гуглопереводчике значение.

251 Кб, 459x393

251 Кб, 459x393Можно ли обучать модель из временных хранилищ? Например спарсил 1 тб пикч -> прогнал нейронкой -> удалил и спарсил еще 1 тб других, и т.п. пока не выкачаю все интернеты, лол?

> Как расчитывать место, которое займет модель после обучения?

Что ты имеешь в виду?

> Можно ли обучать модель из временных хранилищ? Например спарсил 1 тб пикч -> прогнал нейронкой -> удалил и спарсил еще 1 тб

Обычно объем обучающей выборки в несколько раз меньше.

>>17647

Да,я прочитал,там охуеть какие требования.

Вопрос вот такой, я собираюсь идти в бакалавриат, но не могу выбрать направление. Конкретно нужно,чтобы не потратил время зря, ведь я хочу заниматься машобом. Вот список:

Математика и компьютерные наук

Механика и математическое моделирование

Информатика и вычислительная техника

Прикладная информатика

Спасибо за консультацию,но поступать в вшэ не планирую.

Олимпиаду я не смог затащить,а по егэ планирую не больше 270(сейчас жду инфу,математика+русский = 184). А там на бюджет надо 290+.

Или мой вопрос идиотский и надо "просто делать"?

если есть пример кода с прочтением фоток, дайте линк, очень прошу

В таком случае тебе в "Математика и компьютерные науки" или "Прикладная математика" вместе с курсами в сети (читай: ссылками в шапке треда) и занятиями в свободное время. Это, пожалуй, максимально независимый от университета путь.

Спасибо)

учусь на ивт, брат жив. Есть математика и железо (часть нахуй не нежна, часть довольно полезна). Есть предметы с сетками, но тут довольно скудно

Ты должен прекрасно понимать, что тебе надо от универа. Мне расписывать лень, но знай, что универ не всегда может дать актуальные/полезные знания. Будь к тому готов

Он известен заранее ещё до обучения

8 Кб, 716x289

8 Кб, 716x2891) Масштабируемый (500к векторов по 10 компонент)

2) Не зависит от параметров (не надо указывать число сообществ или волшебные константы, которые всё меняют).

3) Есть на Кэггл.

???

SOM Кохонена. В оригинальном варианте не для кластеризации, но в том же R полно разновидностей и для работы с кластерами. За зумерский кагл не знаю, есть ли там что-то полезное.

Манюня, пиздеть - не мешки ворочить. Ты хотя бы блоксхему попробуй сделать с деталтным описанием процесса для начала, а не смеши людей своими маняфантазиями. Пока что твои "умозаключения" смахивают на истерику избалованного ребенка, кукарекающего что-то в духе "мам пицу!".

К любому учителю русского языка средней школы подойди, он тебе долбоебу напомнит про члены предложения и словообразование.

Может их в векторы как-то трансформировать?

бля, не консультанту, а DS.

Мейби через скользящие средние.

Взять одну с большим периодом, а вторую с маленьким. Если малая пересекает большую снизу, то это начало восходящего тренда.

спасибо, сейчас попробую

Локальный пик это высокочастотный всплеск. Соответственно тебе нужен фильтр высоких частот, сигнал которого выше порога и будет говорить о пике. Классическая DSP короче

117 Кб, 604x544

117 Кб, 604x544Какой же ты убогий. Демагогическая позиция "все говно, потому что ваша идея не новая" - это очень убогая позиция повыебывайся. Не выебывайся.

3,6 Мб, mp4,

3,6 Мб, mp4,1280x720, 0:23

Я не говорю, что говно, я говорю, что зумера в восторге от новизны идеи, которая всерьез обсуждалась еще когда мамки зумеров целками были.

Я правильно понимаю, что fc_v_logits автор где-то проебал?

>NameError: name 'fc_v_logits' is not defined

Что, теоретически там должно быть?

Поздравляю, ты уже превратился в батю в проперженных труханах, который пиздит что-то подобное о любой вещи, которая появилась в те времена, когда у него еще хуй стоял.

По логике вместо fc_v_logits должно было быть написано visible_logits. Видимо он сначала обозвал перменную первым образом (fully connected visible logits), а потом переименовал

> Какие есть методы анализа временных рядов, кроме "натравить ARIMA" и "засунуть в рекуррентную нейронку"?

State-space методы, в наиболее запущенном случае - динамический хаос и всякие векторы Такенса. Но если даже арима не осилил, в это точно лезть не стоит.

О мудрейший, а можешь рассказать полный процесс подбора гиперпараметров аримы и саримы?

в великое савецкое время и ни такое предумывали!

многае еше пылыиться где-то в потайенном архиве, в толстых связаных ниткой от торта стопках бумаги на которые ставят чай (обязательно в стакане и подстаканики)

где-то там далеко-глубоко в опечатанных комнатах на мехмати ждет ДРЕВНЕЕ ЗНАНИЕ

а тем временем человечества дечаит и ПОПСЕЕТ постипенно утрачивая сам язык на которром говориле ВЕЛИКИЕ

берешь считаеш количество параметров умножаешь на 16, 32 в зависимосте от того какой тип даных испольщуешь (скорее всего 32)

посчитать параметры легко для полносвязаных слоев это ВЫСОТА Х ШИРИНА, а для свернутых слоев все хитреи xyzk

xy - площать ядра

z - глубинавходного тензара

k - глубина выходного тензара

потом сумируешь все размеры всех слоев умножаешь как я говорил и все

ну и еще оверхет будет какой то но этим можноп ренеребреьечь

очень не советую ийти на /ba/data там лжеалегбраисты сидят (и пьют ХИМОЗНЫЙ ЧАЙ а потом всем другим его же и придлагают)

все самыи умные приподователи и ученики на /ba/ami там лучше учебная програма очень вежливые в учебной части

по карйний мере когда я бы л перпродавателем в высшке быоло так сейчас не берусь судить

есть такой алгоритм тебе понадобядся енпараметрические байес и стохастический вывод

например - процесс дирихле + стохастический вариационый инференс

там легнк о запутаться но ты апиши я все обьясню а пока вот тебе две три ссылки

http://mlg.eng.cam.ac.uk/pub/pdf/GoeRas10.pdf

http://www.columbia.edu/~jwp2128/Papers/HoffmanBleiWangPaisley2013.pdf

Ты даже не сказал, что за среда...

142 Кб, 512x512

142 Кб, 512x512> где-то там далеко-глубоко в опечатанных комнатах на мехмати ждет ДРЕВНЕЕ ЗНАНИЕ

Вот ты петросянишь, а я находил пейперы 80х годов про логические вентили и аппаратные нейросети на основе каскадных реакций между ферментами. По-сути готовые реализации биочипов, как в киберпанке и даже автор был японец. Вот увидишь, лет через -дцать такое будет подаваться как сверхсовременный аналоговнет и малолетние дегроды будут восхищаться наступившим будущим.

>Вот ты петросянишь, а я находил

Ну ты ведь хуесос, который не понимает, как распространяются знания. Принципы паровой машины были известны грекам, а америке не использовали колесо, несмотря на то, что были игрушки с колесными осями. Какой-то обоссанный пейпер, в котором сделали 2% наработок и закопали где-то в архиве обоссаных пейперов, не стоит нихуя.

Только долбоебы типа тебя считают, что если они нашли какую-то банальную мысль в работе полувековой давности, это позволяет им распираться от гордости по поводу того, что они-то знают все, а вокруг все нихуя не понимают, что будущего-то на самом деле нет.

> какую-то банальную мысль

> банальную

Забавное невзначай проскочило у зумерка в порыве гнева. В стадию принятия т.е. уже переходим потихоньку, лёд тронулся, это хорошо.

Есть какие-то общепринятые библиотеки, или только самому васяно-сборки искать?

Любая мысль, которую ты способен осилить - банальная. Потому что ты тупой. Был бы умный - спустился бы со своих небес и нашел бы удаленную работу хотя бы на $100К, ведь нейронки это так просто и в них прогресса нет. Это же заметная хуйня, что как только здесь начинается какой-то разговор по существу (типа >>21860), ты сливаешься, потому что даже в пятистрочном скрипте на керасе разобраться не в состоянии.

Все твои аргументы сводится к демагогии вокруг идеи и реализации. Типа "я нашел пейпер, что транзистор изобрели в 40-е, значит ваш прогресс не прогресс нихуя". У нейросетей на основе химии есть фундаментальные ограничения, с которыми не понятно, что делать. Объяснять нужно, какие, или ты умнее куска дерева? Когда будет понятно - это будет прогресс и будущее. Но всегда найдется хуесос типа тебя, который скажет, что, вообще похуй на этот процесс, главное, что я читал пейпер, где описана банальная идея, а на процесс ее реализации положить вообще, потому что реализация сложных вещей в твой мозг не помещается.

ОП пидор, даже шапку нормальную не осилил сделать, где еще куча бесплатных курсов!?

О как двачного зумера разворотило, лол. Набивайте кашей нового. А это ведь даже не мой пост был. Ну давай, излагай, какие есть фундаментальные ограничения у нейросетей на основе химии.

>какие есть фундаментальные ограничения у нейросетей на основе химии.

То есть ты и правда не понимаешь

Хуево быть олигофреном (тобой).

Грекам были неизвестны эти принципы, они даже до понимания давления пара не дошли, а двигатель Герона был лишь развлекалочкой

>При взгляде на абсолютно любой предмет у человека в мозгу сразу же возникает 3D-модель этого объекта.

Ну мозг же не видит это сразу, он это синтезирует.

У нас несколько колонок есть в коре головного мозга, которые весьма ебануто обрабатывают входящее изображение: сначала они воспринимают полоски, потом синтезируют их в фигуры и т.д.

Вообще мозг очень много чего добавляет к изображению, которое попадает на сетчатку, перед тем, как ты его увидишь.

Самый банальный пример - он его переворачивает.

Если посложнее, то в принципе часть изображения, которое ты видишь на самом деле рисует тебе мозг, фотоны на сетчатку не падают (например, мозг сам закрашивает тебе слепое пятно, или делает заливку цветом сплошных поверхностей).

337 Кб, 1920x1318

337 Кб, 1920x1318все дело в том что в науке есть ЦИКЛЫ (как у женщинь хехехе) мы ходем по кругу развевая уже существующеи идеи

реально же унекальных идей очень мало в основном это разные вареации и проекции неких прото идей на канретные предмедные области и языки

могу привезти простой премер - псле 9 класа до 11 класа ты учишь тоже что и до 9 класа но тебе расказывают БОЛЬШЕ и ГЛУБЖЕ (хехехе)

а потом в институте ты прходишь уже вышую математику и математическую физеку которая на ней основывается поэтому постинаешь суть еще глубже

становится ли при этом простая школьная математика какойто ненужной или плохой? НЕТ!

она по прежгнему замечатильная милая хрошая и может многое ни часто умнее нек нужно

но ВЫСШАЯ МАТЕМАТИКА все равно выше и глуюже без нее самолет может и взлетил но НЕ КОСМОЛЕТ

надеюсь всем все объяснил теперь можем дальше жить ДРУЖЕНО

>но ВЫСШАЯ МАТЕМАТИКА все равно выше и глуюже без нее самолет может и взлетил но НЕ КОСМОЛЕТ

Школьник, уходи. Космолет бля

>идея, а на процесс ее реализации

Хе-хе, "добавить слоёв от балды, нарастить мощностей, захуярить побольше данных и как-нибудь заработает))" называть процессом реализации как-то слишком громко. Ещё нелепей кого-то пафосно обвинять в том что детали данного тупикового пути ему не интересны.

143 Кб, 1024x674

143 Кб, 1024x674если ты будеш больше и глубже вдумываться в СУТЬ слов и меньше придираться то может быть ты поумнеешь

я между прочем пенсею с 15 лет получаю а ты говориш "школьник"

Судя по уровню грамотности, он действительно инвалид умственного труда.

ИИ которое мы заслужили.

Лол, а ведь в треде кто-то это предлагал, его на смех подняли.

Это и есть скучное задротство. Нейронки это бухгалтерия.

Основное применение для решений с помощью машинлёрнинха - попил инвесторских денег (для мелких фирм и стартапов) или возможность отчитаться об "сследованиях" перед начальством и поддержании престижа (крупные корпорации). Для этого всё это развлекалово с неграми, вангогами и котами подходит лучше некуда.

>>23682

Ну вам жи онскозал. Если не видишь ничего революционного и прорывного в перерисовывании котов под Ван Гога, а тем более если закрадывается мысль что все это наебалово с целью развести инвестора или работодателя, то ты нечеткий петух. И похуй, что по факту пока ничего интереснее приложения для онанистов за 50$ не создали.

>Хе-хе, "добавить слоёв от балды, нарастить мощностей, захуярить побольше данных и как-нибудь заработает))" называть процессом реализации как-то слишком громко.

Откуда ты, блядь, это знаешь. Из хайповых постов в интернете.

Программистом, знаешь ли, еще проще работать: набиваешь какие-то английские слова в компьютер, а тебе платят 300к.

>Кроме кучи сайтов "загрузи фотку, и мы переделаем её под ван Гога". По виду - чисто развлекательная вещь.

Чтобы переделать что-то под Ван Гога, нужно понять, а что такое этот Ван Гог, то есть формализовать понятие стиля картины, и отделить стиль от контента. Поэтому везде, где у тебя есть задача разделить твое изображение на контентную (пространственно переменную) и стилевую (фактически - любую пространственно инвариантную), тебе есть смысл смотреть, какой state or art решения этой задачи и применять его.

>где у тебя есть задача разделить твое изображение на контентную и стилевую

Так я и спрашиваю, где возникает в реальности такая задача! Пока что я нашёл только мысль, что эту штуку можно использовать для аугментации данных ы других задачах.

>понять, а что такое этот Ван Гог, то есть формализовать понятие стиля картины, и отделить стиль от контента

Ага, щас. Вставить просто все данные по пикселям и как-то так оно там заработает))

Вот есть у меня корреляционная матрица для параметров а,б,с. Нахожу я значит её собственные векторы, а как узнать к какому параметру соотвествует каждый вектор, ведь компутер просто мне выдаст вектор отсортированные по собственным значениям. Или это ещё можно узнать через свд?

a,b,c - это что, скаляры, векторы?

Эти вектора соответствуют главным компонентам, а не параметрам исходной задачи.

не непорядок что значит собств вектора соотв параметрам?

объясни расскажи зачем тебе что ты собираешься получить

У меня четыре функции генератора картинок (через PIL), которые возвращают массив пикселей или что-там (вообще не ебу что). Я создаю нейронную сеть, потом беру картинку из одного генератора картинок. Потом эту картинку скармливаю нейронке, она мне даёт на выходе какие-то четыре циферки (по одной циферке на каждый класс). Если я вижу, что нейронка неправильно классифицировала, то вызываю метод ты_не_права_на_самом_деле_класс_такой(индекс_класса). Если же я вижу что нейронка правильно классифицировала (на нужном выходе коэффициент более 0.5), вызываю метод молодец_нейронка_правильно_узнала_класс(индекс_класса). Я повторяю это 100к раз и у меня получится нейронка, которая классифицирует с хорошей точностью. ТАК Я СЕБЕ ВСЁ ПРЕДСТАВЛЯЛ.

А НА САМОМ ДЕЛЕ:

1. открыл исходник https://github.com/keras-team/keras/blob/master/examples/mnist_mlp.py

2. увидел

>(x_train, y_train), (x_test, y_test) = mnist.load_data()

Сразу пошла какая-то магия. Метод ОТКУДА-ТО ГРУЗИТ данные и выдаёт pair из двух массивов, в каждом из которых какие-то непонятные объекты. Просто какая-то магия

3. потом какие-то вычисления непонятно зачем. В общем, опять МАГИЯ

4. потом вижу создание сетки и её компиляцию. Тут мне понятно.

5. Потом какой-то метод fit, который вообще ни о чём мне говорит. Но по параметрам я вижу, что это наверно обучение

6. Потом

>score = model.evaluate(x_test, y_test, verbose=0)

как я понял, это само использование сетки

Бля, это пиздец. Какой-то код для питоно-имбецилов, которые привыкли копипастить какую-то магию и радоваться как дети после того как это заработает. НО! Я не хочу сраться. Мне нужна простая хуйня. Где взять пример, который бы демонстрировал обучение и использование нейронки по принципу постоянного обучения, когда я на каждом одиночном примере говорю ты_не_права_на_самом_деле_класс_такой(индекс_класса) или молодец_нейронка_правильно_узнала_класс(индекс_класса)? Чтобы моя программа, например, брала результат от нейронки, использовала его в своих целях, а потом через какое-то время сказала нейронке "вот тут ты была права, а вот тут нет" и чтобы нейронка дообучалась на лету во время использования.

У меня четыре функции генератора картинок (через PIL), которые возвращают массив пикселей или что-там (вообще не ебу что). Я создаю нейронную сеть, потом беру картинку из одного генератора картинок. Потом эту картинку скармливаю нейронке, она мне даёт на выходе какие-то четыре циферки (по одной циферке на каждый класс). Если я вижу, что нейронка неправильно классифицировала, то вызываю метод ты_не_права_на_самом_деле_класс_такой(индекс_класса). Если же я вижу что нейронка правильно классифицировала (на нужном выходе коэффициент более 0.5), вызываю метод молодец_нейронка_правильно_узнала_класс(индекс_класса). Я повторяю это 100к раз и у меня получится нейронка, которая классифицирует с хорошей точностью. ТАК Я СЕБЕ ВСЁ ПРЕДСТАВЛЯЛ.

А НА САМОМ ДЕЛЕ:

1. открыл исходник https://github.com/keras-team/keras/blob/master/examples/mnist_mlp.py

2. увидел

>(x_train, y_train), (x_test, y_test) = mnist.load_data()

Сразу пошла какая-то магия. Метод ОТКУДА-ТО ГРУЗИТ данные и выдаёт pair из двух массивов, в каждом из которых какие-то непонятные объекты. Просто какая-то магия

3. потом какие-то вычисления непонятно зачем. В общем, опять МАГИЯ

4. потом вижу создание сетки и её компиляцию. Тут мне понятно.

5. Потом какой-то метод fit, который вообще ни о чём мне говорит. Но по параметрам я вижу, что это наверно обучение

6. Потом

>score = model.evaluate(x_test, y_test, verbose=0)

как я понял, это само использование сетки

Бля, это пиздец. Какой-то код для питоно-имбецилов, которые привыкли копипастить какую-то магию и радоваться как дети после того как это заработает. НО! Я не хочу сраться. Мне нужна простая хуйня. Где взять пример, который бы демонстрировал обучение и использование нейронки по принципу постоянного обучения, когда я на каждом одиночном примере говорю ты_не_права_на_самом_деле_класс_такой(индекс_класса) или молодец_нейронка_правильно_узнала_класс(индекс_класса)? Чтобы моя программа, например, брала результат от нейронки, использовала его в своих целях, а потом через какое-то время сказала нейронке "вот тут ты была права, а вот тут нет" и чтобы нейронка дообучалась на лету во время использования.

У тебя представление неправильное. Нет таких функций, через которые ты говоришь нейронке, правильно она классифицирует или нет. Есть одна функция ошибки, которая должна быть непрерывной, чтобы ее можно было оптимизировать. Она выдает большие значения при ошибках и маленькие при правильных ответах. Вот вроде бы ты плюсовик, элита общества. Я думал мы все искатели, которых интересует, как реально вещи устроены, а ты даже книжку не удосужился почитать. Попробуй написать на чистых крестах простую нейронку с фиксированным числом слоев и нейронов на слое, которая по честному вычисляет градиенты и обновляет веса, тогда все поймешь.

Ты просто тупенький, не способный прочитать азы теории и документацию библиотеки.

70 Кб, 760x551

70 Кб, 760x551Год назад я кодил на С хеллоуворлдную сеточку на основе вот этой хуйни https://github.com/libfann/fann

Я сделал 8-слойную сетку (не понимаю зачем 8 слоёв). На пикрелейтеде кусок кода. Вот там

>fann_type* result = fann_run(san, &source);

получение результата

>get_check_result_and_get_desired(source_handle, result, &desired);

>fann_compute_MSE(san, &desired);

>fann_backpropagate_MSE(san);

>fann_update_weights(san);

я уже не помню, что это и зачем, но судя по всему, это дообучение сетки на лету. Я точно помню, что работало всё охуенно и обучалось просто на ура и я достигал результата 99%.

Вот, как видишь, у меня была нейронка которая дообучалась на лету.

Это можно сделать, но я не уверен, что с tensorflow у тебя получится. Там у данные должны быть заранее размечены, а ты хочешь размечать их по ходу дела. Попробуй pytorch. И я все еще предлагаю написать тебе нейронку на чистом cpp (без сторонних либ, только stl и мб boost), чтобы ты не думал, что это какая-то магия.

Интересное бизнесу - может быть, хотя сейчас бизнес уэб интереснее мне кажется, но это смотря какой бизнес.

Интереснее людям - только если ты отбитый ментальный инвалид, как супчик выше.

А в чём основная разница в возможностях между тензоркерасом и торчем?

В реальности это все так или иначе связано с обработкой изображений, то есть пригодилось бы для художников, и т. п., но им не интересен глобальный перенос стиля. Поэтому там решают алгоритмы типа CycleGAN и т. п. При этом людей в теме очень мало, вопреки кукарекам о хайпе, поэтому я оцениваю появление алгоритмов в фотошопах и т. п. только лет через 5.

>Пока что я нашёл только мысль, что эту штуку можно использовать для аугментации данных ы других задачах.

Для того, чтобы нейронка училась классифицировать контент, а не текстуры, есть и более удобные способы регуляризации на лету. Проблема в том, что, опять же, на вершине айсберга сплошные имейджнеты и кагглы, где идет соревнование между готовыми датасетами. Аугментация на лету намного более востребована, но менее интересна.

да, для аугментации как тут https://www.youtube.com/watch?v=eUBiiBS1mj0 (или наоборот, чтобы уменьшить количество данных для модели)

или типа того (не совсем, но близко) https://www.youtube.com/watch?v=PCBTZh41Ris

> Если я вижу, что нейронка неправильно классифицировала, то вызываю метод ты_не_права_на_самом_деле_класс_такой(индекс_класса). Если же я вижу что нейронка правильно классифицировала (на нужном выходе коэффициент более 0.5), вызываю метод молодец_нейронка_правильно_узнала_класс(индекс_класса)

Это называется reinforcement learning. Так классификаторы не учат. слишком медленно.

>Какой-то код для питоно-имбецилов, которые привыкли копипастить какую-то магию и радоваться как дети после того как это заработает. НО! Я не хочу сраться.

Ха-ха-ха. Чувак, ты сейчас доебался до того, что в printf("hello, world\n") сплошная магия, \n какой-то, и никто не объясняет, как система рисует тебе окно cmd.exe. Или нахуй, не имбецил, в общем.

> Я точно помню, что работало всё охуенно и обучалось просто на ура и я достигал результата 99%.

Неимбецил добился оверфита и радуется.

С чего ты взял, что там подкрепление? Данные просто размечаются не перед обучением, а незадолго до вычисления ошибки. Наверняка подойдёт обычная кросс-энтропия. Главное, чтобы для каждого инпута был единственный желаемый результат, иначе получится шляпа. Ну и естественно это будет очень медленно обучаться, так как за раз будет прогоняться один пример, и в процессе будет еще какое-то стороннее вычисление, которое будет узнавать реальный класс. Лучше конечно разметить заранее.

Бизнес-дебил, ты? Уже посчитал, какой прирост в кликах вашему говносайту дала готовая нейронка с пайторча?

С моим говносайтом всё в порядке, лавешка мутится, спасибо за интерес. А у вас как там в котельной, слесарёк? Мужичьё ещё не всё спилось?

115 Кб, 570x626

115 Кб, 570x626Считаю, что нейронки говно, сам маг Экспертных Систем, так вот, можно ли как автоматом генерировать правила для ЭС, ну там статистика или какая у вас магия еще есть?

Скорее всего, придётся заново. Так что сохраняй промежуточные веса.

> Считаю, что нейронки говно, сам маг Экспертных Систем, так вот, можно ли как автоматом генерировать правила для ЭС, ну там статистика или какая у вас магия еще есть?

Ну и как там в 70х? Можно конечно, любой метод идентификации систем на выбор. Те же модели нечеткого вывода не только автоматом генерируют такие правила, но и делают это полностью прозрачно и в готовом лингвистическом виде. Даже если система описывается десятками тысяч правил, все равно есть методы представить их в виде, пригодном для анализа человеком.

>Ну и как там в 70х?

Заебись, ИИ типа MYCIN реально работало, поджигая пердаки докторишкам, а не эти ваши котики.

>есть методы представить

Кокие? Мне типа поиск скрытых закономерностей или типа того.

Крестодебилы привыкли дрочить указатели и контролировать каждый чих, а тут либа сама за тебя всю рутину делает! Охуеть, что творится, люди добрые, как так можно-то!? Так ведь и программисты станут не нужны.

141 Кб, 800x450

141 Кб, 800x450К сожалению, индустрия существенно отупела. Теперь даже умственно отсталые вроде тебя могут на коленке написать сетку и самоутверждаться в интернете.

Если брейнлет, то матрица корреляций, PCA и регрессия. Если нормальный пацан, то статистические тесты на зависимость.

> Если нормальный пацан, то статистические тесты на зависимость.

Ага, и будет результат как в классическом примере - продажи мороженого на пляже увеличивают количество нападения акул, заебись выявили закономерность. Нет, это так не работает. Если не брейнлет и в датасете больше 5-10 переменных, то датамайнинг нужен. Для начала карты Кохонена и decision tree, а дальше по обстоятельствам.

Так оно и есть. Говно для мартышек. Вообще не советую начинать с тензорплова, лучше pytorch. Но если ты хочешь всё понять и разобраться как оно и что, то придется копаться в документации или на крайняк полностью учить как вообще эти нейронам устроены.

Данные, которые выгружаются можно преобразовать из обычного списка, вычисления там простые и все они не происходят в коде, а компилируются как сама модель. Метод обучения автоматический, я вообще не ебу каким образом они его связали. Все эти библиотеки и фреймворки действительно магические, работают по нажатию кнопки, нигде нет информации о том, как волшебная функция определяет где какой слой и как интерпретировать мою хиленькую звёздочку умножения, да так что оно всё работает. Честное слово, будто по велению господа вся эта каша собирается в упорядоченный граф. Вообще ебать. Я не понимаю этого.

>Нет, это так не работает.

>карты Кохонена и decision tree

Ха-ха-ха. Когда ты переходишь от линейных моделей к нелинейным, то шансы найти ложную закономерность только выше.

К несчастью, то ж бывает у людей:

Как ни полезна вещь, — цены не зная ей,

Невежда про нее свой толк все к худу клонит;

А ежели невежда познатней,

Так он ее еще и гонит.

Или лучше освоить полностью Python?

Выучи и то, и другое. И библиотеки посмотри, есть надежда, что пакеты R перенесут в питон полностью и наконец-то закроют этот ублюдочный язык.

А причём здесь множественная проверка? Он же про косвенную корреляцию.

> есть надежда, что пакеты R перенесут в питон полностью и наконец-то закроют этот ублюдочный язык.

Лол. R изначально язык обработки данных, в отличие от каличного письтона, где подобное возможно только через костыли. Для того, чтобы работать в R, его просто нужно поставить из инсталлятора и все, он блядь просто работает. Не тащит какие-то ебучие гигабайты зависимостей, а просто работает. Пакет в нем поставить можно просто распаковав архив вручную в каталог с либами, и оно будет работать! Ему похуй на русские буквы в путях, похуй вообще на все. Я ещё ни разу не сталкивался с проблемой что в R что-то не работает, этого просто нет, неважно откуда у тебя руки. Если нужны разные версии, просто тупо ставишь в два клика все нужные и они просто работают! В R надо реально тыкать еблом всех разработчиков языков программирования как в недостижимый идеал. Про пакеты я вообще молчу, там реализовано просто вообще все для любой работы с любыми данными. Ни в каких письтонах этого не будет никогда.

Говно нечиотко петух кок заебал найди работу говно ублюдочность ниронки

А зачем? Скажем, есть датасет, с ним нужно что-то сделать. Допустим, сделали. Для чего это решение куда-то встраивать, в какое-то приложение? Приведи пример что ли, когда, кому и для чего это нужно.

мб кластеринг запусти с разным колличеством классов, и в классе уже можно что-то глянуть. А так pca t-sne всякие, выбросы можно глянуть, стат тесты запустить

1,9 Мб, 320x240

1,9 Мб, 320x240Если строится модель (какая угодно простая,хоть линейная регрессия), то она уже направлена на то, чтобы предсказывать некий результат на новых данных, которые ей подают пользователи - а значит, её нужно встроить в какое-то приложение для пользователей. Банк хочет кредитный скоринг? Классификатор нужно встроить в приложение, в которое девушка-операционистка будет вбивать данные. Банк хочет предсказывать курсы валют? Модель временного ряда нужно встроить в торгового робота. Хотя бы через доступ к серверу, где эти модели крутятся. Одна из целей машоба - автоматизация принятия решений, чтобы не пришлось каждый раз человека привлекать на исследование.

> Хотя бы через доступ к серверу, где эти модели крутятся

С этим проблем точно нет. Неоднократно попадались R пакеты с интерфейсом через браузер. Как я понимаю, при желании это можно к чему угодно прикрутить.

>Банк хочет предсказывать курсы валют

Ебать, еще один кукаретик с гениальной идеей "А ДАВАЙТЕ КУРХС В НЕЙРОНКУ ПАМЕСТИМ И БУДИМ ЗАРАБАТЫВАТЬ ЫЫЫ". Как же вы заебали.

Японские свечи вполне можно детектировать и автоматизировать мащобчиком, как и многое другое.

Ты вообще не понимаещь, какой бред ты несешь как и 95% машобщиков с нулевым пониманием предметной области

Если ты умеешь прогнозировать курс, предлагаю выкладывать в тред результаты предсказаний, а еще лучше торговать на свои деньги с пруфами.

У меня есть компетенции только по второму вопросу.

Да и там скорее всего тоже пиздешь, ты же явно простой кукаретик.

> У меня есть компетенции только по второму вопросу.

Рассказывай. Почему курс нельзя предсказать? Типа там случайное блуждание, совсем-совсем случайное, прямо как в TRNG, вот это все. Или что?

Так поделись, лишним не будет. Я слышал, что алгоритмическая торговля в основном направлена на автоматизацию крупных сделок, а не на прибыль, но есть же black box trading?

Смотря какое будущее, Мань. Если ты навернешь несвежего хавчика, твое ближайшее будущее очень несложно предсказать. Чаще всего проблемы с предсказанием сводятся к недостаточной точности и сложности построенной для предсказания модели системы.

>Ебать, еще один кукаретик с гениальной идеей "А ДАВАЙТЕ КУРХС В НЕЙРОНКУ ПАМЕСТИМ И БУДИМ ЗАРАБАТЫВАТЬ ЫЫЫ". Как же

>>25283

>У меня есть компетенции только по второму вопросу.

Читай: еще один кукаретик обосрался и уверен, что раз у него не получилось слезть с мамкиной шеи со своей гениальной идеи, то у него теперь есть КОМПЕТЕНЦИИ и способности кукарекать о том, что торговых ботов не существует.

SVM наверно, лол

> Потому что линейно разделимых задач меньшинство.

Ещё один иксперд. SVM уже в 90х использовали для нелинейных задач, линейный пример просто для описания идеи, ты дальше этого педивикию и не осилил, да?

Все зависит от определения. Для нормальных людей SVM это линейный классификатор с особым лоссом. Петухи начинают вспоминать про кернел-трики. Проблема в том, что я могу взять ResNet-9000 с 9000 слоями, захуярить в конце hinge loss и звявить, что это у меня кернел трик такой, а так это SVM.

Но это нужно конченным петухом быть.

> Все зависит от определения. Для нормальных людей SVM это линейный классификатор с особым лоссом. Петухи начинают вспоминать про кернел-трики.

SVM это типичный пример кернел-метода, все остальное просто особый обвес. Тут принято R хейтить, а там есть очень наглядная реализация кернел-методов, kernlab, частный случай которых SVM.

> Проблема в том, что я могу взять ResNet-9000 с 9000 слоями, захуярить в конце hinge loss и звявить, что это у меня кернел трик такой, а так это SVM.

За такое тебя бы даже зумера на коворкинге засмеяли. Суть именно SVM в том, что там зануляется и не используется в обучении все кроме примеров на границах классов. А обычная нейроночка это квадратно-гнездовое окучивание всего вообще датасета.

>SVM это типичный пример кернел-метода, все остальное просто особый обвес.

Как и моя нейронка с 9000 слоями.

>Суть именно SVM в том, что там зануляется и не используется в обучении все кроме примеров на границах классов.

Ты про hinge loss? Да ладно, никогда не слышал об этом. Даже забыл упомянуть в своем посте.

На чем свои нейронки пишете, парашники? Все ещё на питоне?

Когда будет первый искусственный интеллект на fpga?

FPGA хуево дружат с floating point вычислениями. ASIC который хорошо с ними дружит на данный момент называется GPU

Математика не нужна. Все успешные машобисты, которых я знаю, хуй клали на матешу в вузе и задрачивали фреймворки.

>Насколько интересна математика для нейронок?

Это инжинерия прежде всего, так что ни насколько.

>>26220

>В этой области применяется теория категорий, топология, коммутативная алгебра и алгебраическая геометрия с разными абелевыми многообразиями?

Только у малой части исследователей, которые очень хотят прикрутить гамалогии хоть куда-нибудь. Есть topological data analysis, persistence modules, кто-то даже занимается algebraic statistic где пытается алгемчик свой как-то всунуть. Но это всё больше болтовня чем реальное дело.

>>26220

>но рутины и хардкора будет столько, что говно из ушей полезет?

Да, как и везде.

Математика, необходимая для машобчика это дискретка. Более высокие материи теоретически применимы, разумеется, но практически ни у кого кроме Вапника для этого мозгов недостаточно.

>>26160

И.е ты хочешь сказать, что современные нейроночки пытаются незаметно превратить в SVM, но так чтобы никто не догадался и не стал ржать из-за того, что умные люди ещё в 70е этот путь предлагали, а всякая хипстота только сейчас понемногу начинает догадываться, что других путей все равно нет?

Алсо, все эти xgboost'ы, deepboost'ы и иже с ними так же исконный статистикал лернинг. Как жи так-то, это что жи делается, люди добрые? Куда в современном машобчике ни плюнь, везде в Вапника попадешь!

>Математика, необходимая для машобчика это дискретка

Журавлёв, идите нахуй и дискретку свою заберите. В рот ебал Вашу программу экзаменов, в которой половина - сраный маткиб, а теорвера и матстата нет вообще. АВО были ошибкой.

Почти везде дают. Там (якобы) нужен базовый матан, линал и теорвер, опционально матстат.

>Почти везде дают. Там (якобы) нужен базовый матан, линал и теорвер, опционально матстат.

Матан дают, но практика там это бесконечный дроч хитровыебанных интегралов. А на самом деле нужно знать основы дифференцирования, и, самое главное - как дифференцировать матрицы, суммы, свертки и прочий matrix calculus. Я вот не умею этого, но благо запилили www.matrixcalculus.org и не нужно запускать символьные пакеты.

>линал

В том линале по-моему даже SVD нет, просто показывают пару алгоритмов типа Грамма-Шмидта без описания того, нахуя они нужны.

>теорвер

Какие-то фриквентистские азы даются

Помимо этого было дохуя обыкновенных диффуров, диффуров в частных производных, тфкп (что немного полезно для цифровой обработки сигналов, но в целом из пушки по воробьям), ебучие теоремы Гаусса и Стокса и прочая поебота для проектирования двигателей ракет, а не машоба.

Самое толковое, что было у меня - численные методы.

33 Кб, 600x400

33 Кб, 600x400Нечёткопетух, уймись. Уже и самобеглые повозки обучают, и роботы более-менее ходят, и в смартфонах голосовые помощники есть, и котов охотиться учат, и девушек раздевают, а ты всё вопишь, что нейронки не нужны.

> Уже и самобеглые повозки обучают,

Беспилотное такси унтер Убер, которое размазало пешехода по переходу?

> и роботы более-менее ходят,

Робот Федор?

>Беспилотное такси Убер, которое размазало пешехода по переходу?

Беспилотные такси на нечёткой логике и другом устаревшем говне даже с места не сдвинулось, так что чья б корова мычала.

>Робот Фёдор?

Роботы Бостон динамики.

Остальное ты ожидаемо проигнорировал, потому что возразить нечего.

>Роботы Бостон динамики.

Там никакого машоба нет, кстати, всё руками кодят. Потому и работает.

> Беспилотные такси на нечёткой логике и другом устаревшем говне даже с места не сдвинулось,

Их никто и не разрабатывал никогда. Поезд метро на нечеткой логике был запущен в серию в 1987, вроде бы работы начались ещё в 1979. Больше 3000 испытаний только в реальных условиях реальных локомотивов, сколько всего остального, история умалчивает. Стоимость проекта так же неизвестна, но наверняка всю Блинолопатию можно было купить. Это если все по уму делать, а не засунуть в машину сойбойскую поебень, пусть людей давит, хуй на них, все равно дотационные были)))

871 Кб, 1366x768

871 Кб, 1366x768Инженер Amazon создал блокирующее устройство с ИИ, которое не пускает в дом кота с уличной добычей

> Инженер Amazon создал блокирующее устройство с ИИ, которое не пускает в дом кота с уличной добычей

Эта шайтан-машина при блокировке кота ещё автоматом донатит сжв конторе по защите диких животных от котов. Я о чем и говорю, совсем уж сойбои кукухой ебнулись.

А есть какие-нибудь годные ресурсы по pattern recognition для time-series данных?

>Поезд метро на нечеткой логике был запущен в серию в 1987, вроде бы работы начались ещё в 1979. Больше 3000 испытаний только в реальных условиях реальных локомотивов, сколько всего остального, история умалчивает. Стоимость проекта так же неизвестна, но наверняка всю Блинолопатию можно было купить.

Ну то есть сраный поезд, который ездит по сраным рельсам по сраному расписанию не нуждается ни в каком компьютерном зрении, и самая большая проблема которого не прижать дверями пассажиров, разрабатывали 8 лет, проебали кучу денег, и на выходе получили хуиту, которая даже не масштабируется даже на сраный трамвай.

Даже интересно, почему это никто беспилотные такси на этой базе никто не разрабатывал.

Ты дрочишь на мертвую технологию, потому что считаешь, что якобы 10000 правил это просто и понятно. Так эти долбоебы и рассуждали. Хули, введем всеобщее высшее, образуем миллиард инженеров, каждому дадим по сто правил, и хуяк-хуяк вот оно будущее. А оказалось, что эта хуйня вообще не масштабируется. Если сто правил в голове помещается, а десять тысяч - нет, то оно не помещается в голове ни у кого, и никто в конторе не знает, как работает сумма того, что разрабатывается. И привет.

Повелись недавно на модную тему значит, решили нанять датамакак. То что все продемонстрированные роботы на классических алгоритмах работают это общеизвестный факт, гугли.

> нагуглил курсы форексамошонлёрненх в финансах

> соси педораха обтекай еблан я зароботаю меллеарды))

Чем бы дитя не тешилось))

Только кредит под залог мамкиной хаты не бери

Как классно быть промыткой. Факт потверждает твою точку зрения - о, молодцы, я прав, вы все в треде сосете. Факт опровергает - повелись на модную тему, а я все равно прав.

>То что все продемонстрированные роботы на классических алгоритмах работают это общеизвестный факт, гугли.

Ага, в компании, в которой все секреты защищены пятью слоями NDA, а безопасники следят за тем, чтобы китайцы ничего не спиздили, каждый хуй в блогах для сойбоев (которые для тебя основной источник информации о мире) знает 100%, как оно все устроено.