Вы видите копию треда, сохраненную 10 сентября в 18:19.

Можете попробовать обновить страницу, чтобы увидеть актуальную версию.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Аноны, что думаете по этому поводу?

inb4: Заводчане осилившие регистрацию в OpenAI vs. IT-бояре.

Предыдущий тонет тут: https://2ch.hk/pr/res/2994560.html (

не понял смысл картинки #2 это показывает этапы замены? типа сначала заменили кофевара на кофеварку, потом заменят челов на авточелов? и что означают выражения лиц персонажей на картинке?

Ну мне нравится код писать, комбинировать, самому чето придумывать даже если кто-то уже такое делал. Мне нравится не только "решение задач полезных бизнесу", но и сам процесс. ИИшка меня этого собирается лишить, для себя я не вижу смысла заниматься кодингом за деньги. Я понимаю что я в меньшинстве, большинству поебать на сам кодинг

Вайб кодер в треде

Ты же проходил историю в школе и знаешь, что меняется абсолютно любое ремесло людей.

Вот сейчас активно будет меняться айтишка. Ну будет 90% писанины роботами, да и хуй с ним. Повылетают апездалы нихуя не делающие со своих нагретых мест и которые пришли только ради бабок.

Ну трудится все будут, а не писюны рисовать в пэинте на месте тимлида.

Если любишь коддинг, то тебе поебать будет, работу не потеряешь.

В общем нихуя страшного, штаты поедут в несколько раз и все продолжится, как сейчас.

держи нас в курсе

64 Кб, 512x512

64 Кб, 512x512 15 Кб, 499x204

15 Кб, 499x204>конкретно программирование (каким я его любил) вероятно уйдёт в прошлое

А мне наоборот заебись что теперь я могу легко программировать на голанге, на иптоне, на жс, сразу на любом фреймворке, на сикеле, на регулярочках, на баше, при этом докерфайл пишу, манифест в кубы пишу и если надо. Рил золотой век погромирования.

Переубеждать тебя смысла больше не вижу. Я тебе сказал: 3ч на достаточно сложного бота с асинхронами и прочей ебалой (он тебе сам написал, что делал).

Не веришь - мне то заебись. Тем лучше шатать рыночек на всяких Авито.

485 Кб, 784x500

485 Кб, 784x500В секс-индустрии всегда хорошо платили и платят, так что всем питон, жава, жавасрикт, сишрамп и т.д программистам приготовиться, останутся в живых лишь те, кто пишут на языках типа Си(не жавахуй и не сишрамп) и Раста, остальные на трассу уйдут продавать своё очко(ну, или пизду)

>достаточно сложного

>бота

>с асинхронами

Вот это да, там же, наверное, натуральный рокет саенс - БОТА, да ещё и с АСИНХРОНАМИ! Ну точно гопота нас всех заменит теперь.

> Вот это да, там же, наверное, натуральный рокет саенс - БОТА, да ещё и с АСИНХРОНАМИ! Ну точно гопота нас всех заменит теперь.

От твоего сарказма ничего не поменяется))0)

Ещё 1.5г назад это было почти невозможно, а если возможно, то с десятками промптов над одной задачей.

Тогда такие как ты смеялись, что он 100 строк кода без косяков не напишет, даже на питоне. Сейчас смеются, что делает даже при помощи рук нуба готового бота.

Пройдет 1.5 года, нейронки продвинуться ещё до какого горизонта. Интересно, в какой момент ты перестаешь отрицать то, что мир уже не будет прежним и что айтишка скоро потеряет блеск и флёр? Это станет обычной РАБотой как до 2010х.

>Скажу честно - мне обидно от того, что конкретно программирование (каким я его любил) вероятно уйдёт в прошлое.

А я даже рад, что поколение старых пердунов сишников или, хуже того, лисперов с их рассказами о том, как "раньше было лучше", наконец-то сдохнет. Айтишка — это бесконечный склад старых пердунов, зашоренных, ограниченных, и необучаемых, которым 25 лет, они, сука. год-два назад выучили модный JS тулкит, созданный три года назад, и теперь это для них лучший и единственный инструмент в галактике, они будут всё программирование мерять своим ебаным solid.js, next.js, или ещё какой-то хуйнёй — всё, это уже старые пердуны в 25 лет, просто их единственное и незаменимое видение мира ещё не очевидно устарело, а вот спустя 10-20 лет оно очевидно устареет. И тогда они станут такими же сишниками-лисперами с расказами про "вот раньше был фронт другой, настоящий, совсем не такой как сегодня".

Вся эта ML параша ведь взлетела не потому, что это какая-то магическая технология сама по себе, а потому, программирование в стиле "машина Тьюринга" остановилось в развитии ещё 30 лет назад, и уже настолько не масштабируется, что даже охуенно неэффективная видеокарта, на КАЖДЫЙ токен пересчитывающая уже в трёхсотый раз все матрицы внимания, оказывается эффективнее однопоточной однозадачной хуйни на C++, и тем более на питоне.

Только не надо мне рассказывать про "вот есть потоки же ж" — да, есть, только они настолько ненадёжные и настолько ебливые в отладке, что их используют только по особым праздникам, и чаще в каком-то внешнем триста раз отлаженном софте (вроде операционной системы, как это делается в асинхронщине на питоне).

>Ну мне нравится код писать, комбинировать, самому чето придумывать даже если кто-то уже такое делал. Мне нравится не только "решение задач полезных бизнесу", но и сам процесс. ИИшка меня этого собирается лишить, для себя я не вижу смысла заниматься кодингом за деньги.

Чем она тебя лишает возможности комбинации? ИИ очень хуёво комбинирует и решает архитектурные задачи.

Да, ИИ ещё больше усилит подход "чем писать алгоритм под задачу, лучше ёбнем старый код из гугла", из-за чего прогресс по фундаментальным технологиям ещё больше замедлится (кому нужен ваш ЯП Crystal, если ни одна нейросетка под него не умеет писать код?). Но эта тенденция была и без ИИ — кризис в западном мире идёт уже давно, он ещё до короновируса начинался.

>Ведь жптишка всё нагенерит - и код, и домашку, и поздравление на др, и т. д.

Да и хуй с ней, я списывал в школе у одноклашек, теперь дети будут списывать у чатгпт. Школа отупляет в любом случае.

>Вот сейчас активно будет меняться айтишка. Ну будет 90% писанины роботами, да и хуй с ним. Повылетают апездалы нихуя не делающие со своих нагретых мест и которые пришли только ради бабок.

На самом деле в мире есть тенденция исламизации, когда белых людей заменяют дикарями с кораном для выполнения грязной работы, плодовитость белых людей снижают. Потому что раньше были высококвалифицированные операторы-сантехники, которые выполняли средней сложности работу, не заменяемую машиной, а теперь эта работа заменяется машиной и эти операторы стали не нужны. И в том числе вечные джуны являются теми самыми операторами-сантехниками без мозгов. В ближайшее время НЕ-кодеры охуеют намного больше, чем кодеры, потому что целые профессии вымрут, вроде оператора поддержки — просто нужно время на то, чтобы все алгоритмы работы оператора поддержки формализовать и вложить в программу обучения нейросетки. А кодеры по прежнему нужны будут для проектирования, наладки, и поддержки этих систем.

Я ещё десять лет назад работал в конторе, занимавшейся электронным документооборотом и CRM, суть которого сводилась к тому, что из 20 человек в фирме 10 заменяются компьютером, выполняющим тупейшую работу по "перекладыванию бумажек", то есть, ведения документации, бухгалтерии, формирования отчётов, etc. Это было безо всяких ИИ. Это не вчера началось, и исламизация не вчера началась:

https://tass.ru/politika/559585 — 2012 год, указ презика.

>Буквально михалычи 40 лет с опытом работы в пятерочке кодируют себе работающую аппликуху чисто на промтах. И это блин работает. С первого раза? Нет. Без багов? Нет. Понимает ли михалыч, что его программа делает? Нет. Претендует ли михалыч на место кодера? Нет! Нахуя теперь нужны кодеры и кодерские галеры, если михалыч с образованием 7 классов может надиктовать голосовухой ИИшке че делать,

Хуйня, которую михалыч надиктовал нейросетке, не работает и не заработает, даже со следующими поколениями нейросеток. Чтобы эта хуйня заработала, к михалычу нужно приставить программиста, который будет разбирать высранную нейросеткой парашу и превращать её в рабочий код. А если задача вдруг нестандартная и в гугле нет хотя бы похожего решения, то всё. пиздец, приплыли, нейросетка не способна выдать оригинальный алгоритм, она только пересказывает и комбинирует известные ей.

Я вроде писла в прошлом треде, но могу повторить: ещё Дейкстра говорил, что мерять производительность по строчкам кода — это тупость, потому что чем больше программа — тем она хуже; есть некий бюджет проекта, доступное ему число строчек кода, которое возможно поддерживать; и вот тупая пизда или Михалыч с ИИ совершенно бездарно проебывает этот бюджет, он работает в огромный минус, создавая проблем как пять программистов, пишущих руками, и никак не разгребает эти проблемы.

Доходит до того, что в отдельных конторах банят фаерволом нейросетки, потому что школота заебала комитить хуёвый код, который потом приходится кучу времени чистить и дорабатывать.

Или, как правильно написали вот в этом треде:

>>3441825 (OP)

>С появлением LLM некомпетентность перестала оплачиваться

То есть, всё как раз наоборот — конторы очищают от михалычей, потому что михалычем теперь может быть любой, а делать рабочий код — немногие.

Пидарасы, которые наживаются на колхозах в 2 млн человек, говорящих на своём уникальном языке, должны были умереть, как и сам этот барьер. Слава богу, что это случилось.

>А мне наоборот заебись что теперь я могу легко программировать на голанге, на иптоне, на жс, сразу на любом фреймворке, на сикеле, на регулярочках, на баше, при этом докерфайл пишу, манифест в кубы пишу и если надо. Рил золотой век погромирования.

Онан, подскажи норм сетуп под эту хуйню? Я до сих пор через бравзер руками делал запросы, сильно хуйня получалась. Может средства для автоматизации лучше этот процесс обрабатывают? Я вот смотрел работу питониста с copilot в 2023 году на ютьюбе, так ему нейросетка только самую очевидную шаблонную хуйню подсказывала, периодически ошибаясь в своих подсказках. Оно всё ещё на том же уровне или этот кал всё-таки подтянули до удобноваримого состояния?

Я уже потерял счёт, сколько я нейросеток перепробовал, даже локально маленькую у себя запускал — всё хуйня. Ну то есть иногда она помогает, ошибки странные может расшифровать (но не исправить), бойлерплейт выплюнут для дальнейшей доработки — но не более того.

>Вот это да, там же, наверное, натуральный рокет саенс - БОТА, да ещё и с АСИНХРОНАМИ! Ну точно гопота нас всех заменит теперь.

Я уже отвечал в прошлом треде, что сама нейросетка считает нереальным написание надёжного кода со сложными асинхронными переходами состояний нейросеткой. Хуйню с неизвестной работоспособностью писали на апворках много лет назад безо всяких нейросеток.

>>450734

>Ещё 1.5г назад это было почти невозможно, а если возможно, то с десятками промптов над одной задачей.

Так и сегодня это десятки промтов, просто многие из них автоматически выполняются. Тот же чатгпт умеет внутри себя запускать код вместо того, чтобы код запускал кодер и копипастил ошибки. Правда, по мере роста сложности чатгпт перестаёт быть способным самостоятельно запускать код.

>Тогда такие как ты смеялись, что он 100 строк кода без косяков не напишет, даже на питоне. Сейчас смеются, что делает даже при помощи рук нуба готового бота.

И сейчас смеюсь. Нет, она не может написать 100 строк без косяков. Насколько быстро и качественно эти косяки правятся — это другой вопрос. Если скорость выросла, то качество — не особо, очень часто исправление одной ошибки создаёт другую ошибку.

Все нейронки одинаковые, ты ей промт - она тебе образец кода. Как правило, код с проблемами, если ты явно не указал на проблемы в промте, в коде будет хуйня. Халявы не будет, ИИ - это джун, за которым надо ревьюить каждую строку.

Тут есть два класса тулз:

text2text - это все чаты, автокомплиты и так далее. Там ты способен глазами оценить что пошло на вход в контекст, что сеточка высрала, дать мгновенный аппрув/реджект. Это сегодня как бы база. В это легко вкатиться любому. Это прекрасно контролируется. С этим справляются современны локальные модели. Самый яркий представитель - continue.

code agent - это костыль который сам принимает решение какие файлы добавить в контекст, какие файлы отредактировать. Они хорошо работают только на больших внешних моделях типа кладуа/гпт. С ними надо учиться работать. Слепой вайб кодинг быстро поднасерет в проект. Надо следить за изменениями. Покрывать всё тестами, чтобы отлавливать регрессии. Им надо уметь делить задачи на подпункты. Писать хорошо детализированные техзадания, докладывать документацию, подсовывать уточнения. Нормально эффективно овладеть агентом удаётся спустя 2-3 месяца экспериментов. Из примеров: Cursor, Cline, Aider. Мне нравится aider, потому что им проще рулить при помощи /load инструкций.

Мне видишь просто задачки закрывать, а не на двачах самоутверждаться. Могу себе позволить.

>Тот же чатгпт умеет внутри себя запускать код вместо того

Технически это ничем не отличается от того что LLM сгенерит тебе код и ты запустишь его локально.

> Аноны, что думаете по этому поводу?

Нейронка никогда не заменит программистов, говорю как нейронка

>сейчас все больше говорят

А до этого слыхом не слыхивали https://2ch.hk/pr/res/3429171.html (

Отрицать что?

>Замены программистов нейросетями тред

Что значительная часть неквалифицированных необразованных вебмакак, ничем, кроме умения кодировать на жс/джава/питухон/говно/etc, не отличающихся от рагуля с тремя классами (т.н. веб-девелопидоров и прочих фронтендеров), скоро потеряет работу? Так это никто не отрицает, глаза разуй. Никто ведь все эти годы не пытался ВКАТИТЬСЯ, например, в биоинформатику - очевидно, что это невозможно для вчерашнего таксиста - вместо этого быдло вкатывалось в круд девелопмент и покраску кнопок, потому что это элементарно, там не подразумевается никаких пререквизитов, кроме умения писать скрипты, которое можно освоить за несколько месяцев. Поголовье этих кодерков гопота заметно сократит в этом десятилетии, кто бы спорил - оно и до гопоты начало дешеветь по очевидным причинам. Что сказать-то хотел?

Ну реально, вот ты сейчас обдал поносом все языки. А что по твоему надо делать? Что по твоему хороший выбор? Что ты предлагаешь?

Даже не знаю что хуже: сидеть на дваче или писать говнокод на высокоуровневой параше

> 2к25 год от изобретения трансморферов

> @

> разработка превратилась в описательные сверхвысокоуровневые спецификации

> @

> харкачеры всё ещё гордятся тем, что байты двигают

>text2text - это все чаты, автокомплиты и так далее. Там ты способен глазами оценить что пошло на вход в контекст, что сеточка высрала, дать мгновенный аппрув/реджект. Это сегодня как бы база. В это легко вкатиться любому. Это прекрасно контролируется. С этим справляются современны локальные модели. Самый яркий представитель - continue.

Поставил Continue с Ollama и накатил на него Deep Coder 6.7B. Смог найти проблемную строчку кода, но не смог предложить ничего адекватного.

Попробовал тот же код засунуть в Claude 3.7 — тоже полная хуйня, нашло проблемные строчки, но вместо исправления предложило кучу совершенно бесполезных правок. (Я уже руками исправлял этот код, потому точно знаю все ошибки в нём)

В общем, удачи вам с вашими байками про Иван Михалыча, который вебсайты пишет думя промтами нейросетке. Как будут пруфы — приносите, посмотрим. Пока что революция роботов отменяется.

>code agent - это костыль который сам принимает решение какие файлы добавить в контекст, какие файлы отредактировать. Они хорошо работают только на больших внешних моделях типа кладуа/гпт. С ними надо учиться работать. Слепой вайб кодинг быстро поднасерет в проект. Надо следить за изменениями.

Во-во, "следить за изменениями" — это не то слово. Там с лупой нужно просматривать каждое слово в правках, которые эта параша предлагает. В том числе потому, что она умеет предлагать совершенно бесполезные правки аля "дай поправлю тебе coding style". Что вообще этот code agent может ускорять? Очевидные ляпы в проектах уровня hello world? Нажать Ctrl+C, а потом Ctrl+V я могу и без нейросетки.

Серьёзно, я сейчас не пытаюсь никого выстебать, я хочу увидеть, как эта параша ускоряет и упрощает что-то там вне маркетинговых презентаций от самого производителя инструмента. Пока что у меня всё заканчивалось на "пошло оно нахуй — быстрее руками исправлю".

>Что значительная часть неквалифицированных необразованных вебмакак, ничем, кроме умения кодировать на жс/джава/питухон/говно/etc

"Умение кодировать на языкнейме" — это вообще неизвестный науке зверь. Как определить, умеет ли юзернейм кодировать на языкнейме или нет? По скорости написания hello world? По знанию стандартной либы наизусть? Что это за критерий вообще такой "знание языка"? Кто его "знает" и кто его "не знает"?

Нейросеть может быстро накидать типовое решение. Например, мне надо на C# отправить запрос, получить джейсон и отмаршалить его в массив структур. По памяти я ебал это писать, а нейросеть мгновенно выдала код, копируй и используй. Надо мне заюзать инмемори бд - да не вопрос, вот пример. Портянки ямлов пишутся за секунду, красота. В гугле сам заебешься искать, там все засрано инфоциганами с курсами, нейронка теперь новый поисковик.

>Например, мне надо на C# отправить запрос, получить джейсон и отмаршалить его в массив структур. По памяти я ебал это писать, а нейросеть мгновенно выдала код, копируй и используй.

Как хорошо, что я не работаю в ебанутых парашах, где на каждый чих и пук делают HTTP запрос и парсят текстовой кал в ответе (в 2025 году). Но если бы работал, то, наверное, мне бы нейросеточка пригодилась.

>В гугле сам заебешься искать, там все засрано инфоциганами с курсами, нейронка теперь новый поисковик.

Вот тут плюсую, интернет стал непролазной помойкой, гуглить что-то уже бесполезно.

Пишу бота для монетизации одной ниши, в которой никого нет. Крупный пиздец. Заебался. ИИ тоже заебался. Уже 300к токенов ушло на общение.

Хз что получится в итоге, но пока всё хорошо.

Напоминаю:

Питонщики идут нахуй

Ну правильный подбор стека и правильно описание задач позволит избежать бойлерплейта. У меня много раз руки опускались пились свои веб сайты, потому что сидишь день верстаешь кнопочки и уже остопиздело, а тебе за это даже не платят и хз выйдет ли какой то результат из твоего пет проекта.

А щас на курсоре хуячить прототипы на самых популырных и простых стеках типа next.js + tailwind (как раз это инлайн говно удобно для нейронок, чтоб по файлам не скакать и контексты не терять) очень быстро можно. Сварганить сайтец за выходные без боли это кайф + сложно быть фуллстеком + девопсом и помнить все 100500 форматов конфига и прочего. Где глубокие знания не нужны нейросетка выдаст тебе простой конфиг деплоя и прочего и тебе не надо на пол дня зарывать в доку на каждый чих.

Тоже кекаю что в профильном треде в 2025 кто-то до сих пор пользуется этой терминологией. У среднего разработчика занние языка где-то далеко зарыто в приоритетах скилов. Коммуникация, понимание рабочих процессов, адаптивность, жонглирование десятком тулзов, аналитика, перечислять можно бесконечно. Последние 2 раза когда я устраивался в бигтех всем вообще было поебать что у меня в кокнретно языке / фремворке нет или мало опыта, потому что это наживается за пару месяцев онбординга. А пот понимание того как веб работает в целом, как раузеры код переваривают, как архитектуры на бекендах устроены, систем дизайн, хайлоуд проблемы - вот это все надо знать. Весь этот опыт в черепной коробке полезнее чем нейронка, потому что может выдавать решения и в том числе уметь нужный промпт написать.

Чмодератерам дали задание - постить посты нейронкой. Сидят на досках, постят изредка, промты вбивают на разные личности, спорят сами с собой. Ору с этой хуйни

Ага, блядь. Модераторы постят, лишь бы ты не вкатился. Ёбаная блядота сумасшедшая. На дваче сказали, что за забором уже очереди из сеньёров, 500+ откликов и нихуя. Я просто не понимаю, для чего ты, дешёвая проститутка, тут пиздишь? Графики видел? Съебал нахуй, прихвостень назаровский. Резюме хорошее уже составил с ментором, долбоёбина безмозглая?

>Где глубокие знания не нужны нейросетка выдаст тебе простой конфиг деплоя и прочего и тебе не надо на пол дня зарывать в доку на каждый чих.

Еще раз повторюсь, что во фронте самое ебанутое то, что он намного сложнее, чем задача, которую он решает. Это идеальные входные параметры для языковой модели, которые, напоминаю, были созданы для интерпретации нерациональных языковых консьтрукций, которые можно только запомнить, их нельзя понять.

Нет, идеальные входные параметры это токены без всякой внутренней связи. Везде где есть глубокая внутреняя связанность - нейросеть будет сосать. И не важно фронт это или бек, сосать она будет всегда. Она даже не в состоянии посты писать нормально, если глубина понятий чуть-чуть отличается от примитивных языковых конструкций.

Другое дело если нейросеть будет писать в каком-нибудь нормальном фреймворке, который накладывает жесткие ограничения на глубину абстракций. Но таких не создали, так что LLM будут продолжать сосать.

>Она даже не в состоянии посты писать нормально, если глубина понятий чуть-чуть отличается от примитивных языковых конструкций.

Ты не поверишь, это мой каждодневный опыт на сосаке когда на мои посты отвечают, и не боты, а настоящие люди, но ответы точно как ты написал - высеры пориджей неспособных прочитать русский язык дальше пары слов, контекст уже проебан или вообще текст проигнорирован.

>Но таких не создали

Их сейчас активно изобретают. Гугли тот же Interoperable Literate Programming (ILP).

Я прямо вижу что через пару лет все модные хипсторские фреймворки начнут заменять плашки blazingly fast на llm friendly.

>Их сейчас активно изобретают. Гугли тот же Interoperable Literate Programming (ILP).

Ты видел, сколько нужно ёбли со вспомогательными описаниями, для того, чтобы эта поебень стала чуть менее тупой?

И что, и чего? Пердёж может научиться чему угодно, если его бить палкой. Нейросети современные будут пердеть на текущем этапе развития ещё очень долго.

>>457445

Дело не в синтаксисе, похуй на него, нейросети тоже похуй. Дело в вложенности логик. Саму логику программы нужно писать менее сложной, обозначить однозначное поведение. Это должны быть не только веб-компоненты, но и какие-то примитивные сигналы, которые уже подключены к этим компонентам. Хуй знает как описать, да ну и похуй, лень думать.

>И что, и чего?

Да это был лишь крик души. Так-то ты прав, я не спорю.

Просто познавательно как нейросети проявили человеческую суть, теперь людей есть с чем сравнить. Большинство людей болтают как нейросети, совершенно бездумно, а включают голову только ради выгоды или когда над жопой зависает угроза, но такое бывает редко, так что обычная человеческая компания мало отличается от чата с нейросетью, такой же безмозглый бессмысленный спам.

>Большинство людей болтают как нейросети, совершенно бездумно, а включают голову только ради выгоды или когда над жопой зависает угроза

Какая у тебя была выгода или угроза когда ты это писал?

Слыш я небыдло

>>Большинство людей

>>Большинство

Ну вот, наглядный пример безмозглых ботов, процитировал то, что сам прочитать не смог, в итоге написал бессмысленную хуйню. Ботоспам, и не от машины, а от бирмусорной нейросети, таковы люди, подавляющее большинство не думают никогда, кроме случаев когда их что-то жестко заставляет - алчность или страх.

Всё же нейросеть человека может гораздо большее. И мыслит она гораздо гибче, даже условные пердежи, видно что их мысли всё равно глубже даже в примитивном "я ебал твою мать".

Нейросеть всё ещё ограниченна. Объяснение одно - в нейросетях модель мира имеет меньше связей, вот тащемта и всё, нужно больше внутренней связанности между явлениями на всех этапах.

Мне кажется подобное бы работало, если бы трансформеры имели связи между всеми слоями. Но тогда трансформеры, как архитектура, обосрётся, наверное.

>Мне кажется подобное бы работало, если бы трансформеры имели связи между всеми слоями. Но тогда трансформеры, как архитектура, обосрётся, наверное.

Они и так имеют связи между всеми слоями. Входные параметры поступают на выходной слой, а выход из первого слоя поступает на деэмбеддер. Каждый слой по сути читает из этого канала и по желанию добавляет в него что-то своё.

Неправда. Протри глаза, >>458434 даже настоящая нейросеть так примитивно не пукнет, и так >>458076 тоже, даже нейросеть научили значению слова "большинство", она не считает это синонимом "все, без исключения" как биомусор с органическим мозгом хрюкает. Настоящая нейросеть выдает нормальные развернутые ответы где меньше ошибок, чем живые люди выдающие односложные фразы и полностью неправильные.

Еще раз повторяю, нейросеть человека гибче только ПОТЕНЦИАЛЬНО, только в рехких ЭКСТРЕМАЛЬНЫХ ситуациях когда биомусор припёрло, а в нормальной жизни, в нормальной обстановке, уступает компьютерным во всём.

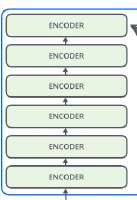

26 Кб, 258x374

26 Кб, 258x374> Они и так имеют связи между всеми слоями.

Разве? Если что я про пикрелейтед говорю.

> Входные параметры поступают на выходной слой, а выход из первого слоя поступает на деэмбеддер. Каждый слой по сути читает из этого канала и по желанию добавляет в него что-то своё.

Каждый слой читает, добавляет что-то и уже эти модифицированные данные опять и снова поступают в слой с которого они были взяты? Хм, нужно прочитать больше про эту хуйню.

Даже не знаю, почему тогда нейросети такие тупые? Потому что внутри слоёв прецептроны содержат мало нейронов?

>>458443

То про что ты говоришь это выброс гормонов и вот это вот всё, когда сети мозга в какие-то другие режимы работы входят, активируется множество слоёв. Но это явно не тот случай - любой человек может в глубину связей хоть прямо сейчас, офк не по всем темам, но может.

Твоё суждение по ответам рандомов и нейросетей это классика логических ошибок, ты принимаешь какие-то субъективные наблюдения и строишь на их основе предположения о работе нейронных сетей. Но эти субъективные наблюдения ничего не доказывают. Насрал кто-то односложной фразой, и чего, и что? Что с этого следует? Да ничего не следует.

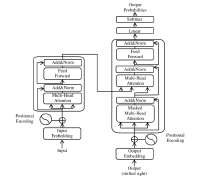

95 Кб, 800x600

95 Кб, 800x600>любой человек может в глубину связей хоть прямо сейчас, офк не по всем темам, но может.

"Может, но не делает" значит не может. Твои ПОТЕНЦИАЛЬНЫЕ выдумки это пустая брехня, иллюзии в шизоидном воображении. Даже народная поговорка есть "Если бы, да кабы, да во рту росли грибы"

Если по факту не делает >>458434 >>458076 , значит не может, это реальность. Прими реальность, а не выдумывай потенциальный бред.

"Нормальная обстановка" - насквозь синтетические комнатные условия? Ну так в таком фрейме и швейная машинка эффективнее человека, смотри как шьёт, ни одна швея не догонит. Это строго ограниченные функции, машинка шьёт, компилятор компилирует, сетка распознает картинки.

В "ум" нейросеточки можно было бы поверить, если бы ей на чистую сначала скормить только учебник языка, а потом попросить реализовать пару реальных кейсов без возможности пиздить у мясных мешков туеву хучу готовых фрагментов кода. А так это просто комбинирование уже готовых текстов. К функции "погугли за меня" добавили "а теперь собери это в кучу".

Швейная машина это инструмент, она ничего не шьет, это делает человек. Или станок с программным управлением, он кажется работает сам, но нет, он лишь выполняет заложенные человеком действия как шарманка, то есть работает человек, а не станок.

А нейросеть действует сама, сама думает и отвечает, причем по факту делает это лучше человека. И данный 2ch тому бесспорное доказательство. Я годами тут сижу и вменяемые ответы вижу 1-2 раза в год, а всё остальное время тупое кукареканье куда хуже нейросети.

И знаешь почему? Потому что нейросеть, хоть и тупая, но сделана давать ответы на вопросы. А люди не ставят целью отвечать на вопросы, они тут для чата поддерживать социальные линки просто перебрасываясь keep-alive пингами, содержание которых не имеет значения, важен только сам факт посылки сообщений. Поэтому люди совершенно не думают что пишут, им насрать, и заставить их думать невозможно, то есть думать они не могут. Таким образом, нейросеть во всём лучше, гораздо умнее людей.

Ты ебанулся.

Смотри внимательно за логикой. Ты делаешь предположения на основе субъективного опыта и строишь выводы которые ничем не обоснованы, кроме этого субъективного опыта. Получается ты не можешь в глубину рассуждений, так же как и окружающее быдло.

По твоим словам выходит что ты дебил который не может в глубину, ты охватываешь только поверхностные и простые мысли - "вижу посты @ строю предположения по ним".

Ты реально таким образом хочешь опускать себя?

>>459140

>причем по факту делает это лучше человека

Опять же, это субъективные наблюдения. Ты на основе субъективного опыта выстраиваешь целые манямиры. Чем ты тогда отличаешься от быдла, которое делает то же самое?

>нейросеть человека гибче только ПОТЕНЦИАЛЬНО, только в рехких ЭКСТРЕМАЛЬНЫХ ситуациях когда биомусор припёрло, а в нормальной жизни, в нормальной обстановке, уступает компьютерным во всём

Ну если с тобой сравнивать, то как бы да. Меня нейросетка давно не особо удивляла, и я даже строил потенциальные модели внутреннего устройства LLM исходя из этого моего эмпирического наблюдения. Модели совершенно неверные, как позже выяснилось, но наблюдения верные: Я считал, что LLM запоминает текста, выданные человеками, совершенно беспорядочно, без критики, просто слепо берёт текст и раскладывает его полочкам; полочки называются вроде "ответ на вопрос про оператор сравнения в Python с аргументами int и str". Далее, когда человек задаёт вопрос, соприкасающийся тем или иным образом с заученным вопросом, то нейросетка выдаёт заученный ответ.

Причём, формы ответов пунктами 1, 2, 3, 4 тоже быстро замыливают глаз, это не естественная форма человеческого ответа и ей очевидно отдельно нейросетку обучали.

Так или иначе, ключевой фактор здесь — это существование готового ответа, на котором нейросетка обучилась. Готового ответа нет — нейросетка "плывёт", то есть, начинает какую-то рандомную хуйню выдавать невпопад.

Какого хуя ты, кожанный мешок, этого не заметил — это вопрос к тебе. На банальных нестандартных задачах по большому тестированию 2022 года LLM выдали чудовищно хуёвые результаты по сравнению с экспертами — просто потому, что решений этих задач не было в тренировочных сетах, то есть "не было в гугле".

Справедливости ради, я тыкал ещё в те тупорылые нейросети, где все паталогии были достаточно хорошо заметны. В современных больших моделях они тоже есть, но их просто сложнее заметить.

Сейчас-то я понимаю их устройство, что там ещё и происходит заучивание логических связей, и таблица умножения от 0 до 9 заучивается, и примеры различных стилей текстов/языков/синтаксисов тоже заучиваются — как ни странно, написать стих в стиле Шекспира для LLM очень просто, сильно проще любой многоходовой логической задачи.

По сути это библиотекарь, который с большой скоростью ищет тебе логически связанные цитаты из книжки, и потом оформляет выжимку из цитат в запрошенном стиле. некоторые нейросетки такого поведения не скрывают и вполне открыто ищут инфу в гугле/твиттере, вроде Grok. Мне даже лучше, потому что у твиттера издревле был мегахуёвый поиск.

>нейросеть человека гибче только ПОТЕНЦИАЛЬНО, только в рехких ЭКСТРЕМАЛЬНЫХ ситуациях когда биомусор припёрло, а в нормальной жизни, в нормальной обстановке, уступает компьютерным во всём

Ну если с тобой сравнивать, то как бы да. Меня нейросетка давно не особо удивляла, и я даже строил потенциальные модели внутреннего устройства LLM исходя из этого моего эмпирического наблюдения. Модели совершенно неверные, как позже выяснилось, но наблюдения верные: Я считал, что LLM запоминает текста, выданные человеками, совершенно беспорядочно, без критики, просто слепо берёт текст и раскладывает его полочкам; полочки называются вроде "ответ на вопрос про оператор сравнения в Python с аргументами int и str". Далее, когда человек задаёт вопрос, соприкасающийся тем или иным образом с заученным вопросом, то нейросетка выдаёт заученный ответ.

Причём, формы ответов пунктами 1, 2, 3, 4 тоже быстро замыливают глаз, это не естественная форма человеческого ответа и ей очевидно отдельно нейросетку обучали.

Так или иначе, ключевой фактор здесь — это существование готового ответа, на котором нейросетка обучилась. Готового ответа нет — нейросетка "плывёт", то есть, начинает какую-то рандомную хуйню выдавать невпопад.

Какого хуя ты, кожанный мешок, этого не заметил — это вопрос к тебе. На банальных нестандартных задачах по большому тестированию 2022 года LLM выдали чудовищно хуёвые результаты по сравнению с экспертами — просто потому, что решений этих задач не было в тренировочных сетах, то есть "не было в гугле".

Справедливости ради, я тыкал ещё в те тупорылые нейросети, где все паталогии были достаточно хорошо заметны. В современных больших моделях они тоже есть, но их просто сложнее заметить.

Сейчас-то я понимаю их устройство, что там ещё и происходит заучивание логических связей, и таблица умножения от 0 до 9 заучивается, и примеры различных стилей текстов/языков/синтаксисов тоже заучиваются — как ни странно, написать стих в стиле Шекспира для LLM очень просто, сильно проще любой многоходовой логической задачи.

По сути это библиотекарь, который с большой скоростью ищет тебе логически связанные цитаты из книжки, и потом оформляет выжимку из цитат в запрошенном стиле. некоторые нейросетки такого поведения не скрывают и вполне открыто ищут инфу в гугле/твиттере, вроде Grok. Мне даже лучше, потому что у твиттера издревле был мегахуёвый поиск.

47 Кб, 850x765

47 Кб, 850x765>Разве? Если что я про пикрелейтед говорю.

Советую посмотреть картинки чуть сложнее, чем "иллюстрация для дошкольников".

>Каждый слой читает, добавляет что-то и уже эти модифицированные данные опять и снова поступают в слой с которого они были взяты?

Нет, они однонаправлены, но все входа поступают на все выходы. Это не рекуррентность, но всесвязанность. Рекуррентность (закольцовывание) там происходит только с последнего выхода на вход новой итерации, в рамках одной итерации инференса данные движутся строго однонаправленно.

>Даже не знаю, почему тогда нейросети такие тупые? Потому что внутри слоёв прецептроны содержат мало нейронов?

У меня есть рабочая теория, что нейросетка заточена на подражание разуму секретарши, её обучавшей — "от осинки не родятся апельсинки". То есть, даже имеющимися технологиями возможно сделать нейросеть разумнее, но людям с ресурсами выгоднее просто повторить тот же результат, что и у всех. Особенно учитывая, что этот результат был именно расчитан на хайповость, "удивить" вместо "решить сложные задачи". И таки удивить получилось, а вот сложные задачи решить не получилось.

>"Может, но не делает" значит не может. Твои ПОТЕНЦИАЛЬНЫЕ выдумки это пустая брехня, иллюзии в шизоидном воображении. Даже народная поговорка есть "Если бы, да кабы, да во рту росли грибы"

Меня на самом деле бесит то, насколько тупы окружающие люди. Я даже злорадствую, что все эти волшебные навыки "быть тупым офисным платнктоном и лизать очко начальству" скоро станут полностью автоматическиму, и все эти ценные работники отправятся мести двор, работать шофёрами и доставчиками.... если, конечно, к этому времени вождение и доставку не автоматизируют полностью.

Лично я чувствую, что меня нейросетка прямо-таки окрылили, вся та тупая рутинная хуйня, которую раньше приходилось делать, теперь делается нейросеткой. Даже собеседование можно нейросеткой проходить.

>Меня нейросетка давно не особо удивляла

Меня люди не удивляют, я не помню даже когда и если случалось услышать интересное, любые ответы читаешь и видишь только одни и те же предсказуемые шаблоны. Нейросеть по крайней мере может сказать что-то новое, а люди не могут. Но разумеется разговаривать с нейросетью это идиотизм, как и с людьми тоже, пустая трата времени, эта хуйня всё равно не слушает.

>Готового ответа нет — нейросетка "плывёт", то есть, начинает какую-то рандомную хуйню выдавать невпопад.

То же самое делают люди. Не соображает, но всё равно пиздит с умным видом эксперта. Нейросеть просто безмозглая программа, поэтому такое поведение не задевает, а вот люди бесят, тупой скот, мог бы думать, но нет, пока паяльник в жопу не вставишь, не почешутся.

Вспоминается паста про древнего философа Платона, который в дискуссиях угрожал оппонентам физической расправой. Только под угрозой мордобоя люди включают мозги и начинают вести себя адекватно, думать как следует и выстраивать аргументы, иначе несут всякую хуйню.

>задачах по большому тестированию 2022 года LLM выдали чудовищно хуёвые результаты по сравнению с экспертами

Вот я про это и говорю, экспертам выдали работу, бабло или еще какая выгода, или обязанность, вот они и включили башку. Когда припёрло, конечно биомусор легко превзойдет нейросеть, но это исключительная редкая ситуация. Например, тут на сосаче просто ни к чему не обязывающее общение, так что никто никогда башку не включает, все пиздят хуйню куда хуже нейросети, включая любого мамкиного ыксперда. И такое везде в жизни, в большинстве случаев люди не думают, уступая нейросетям во всём.

> Советую посмотреть картинки чуть сложнее, чем "иллюстрация для дошкольников".

> Нет, они однонаправлены

Тогда ничем не отличаются по смыслу.

> Это не рекуррентность, но всесвязанность. Рекуррентность (закольцовывание) там происходит только с последнего выхода на вход новой итерации, в рамках одной итерации инференса данные движутся строго однонаправленно.

Видимо из-за этого они и туповатые, не могут в глубину абстракций. Кажется я что-то слышал что увеличение слоёв профита не добавляет, значит проблема в связанности слоёв? Или может это как с грокингом, нужен некий порог слоёв, чтобы получить хорошие результаты? Не очень понятно.

> У меня есть рабочая теория, что нейросетка заточена на подражание разуму секретарши, её обучавшей — "от осинки не родятся апельсинки". То есть, даже имеющимися технологиями возможно сделать нейросеть разумнее, но людям с ресурсами выгоднее просто повторить тот же результат, что и у всех.

Это естественно, сомнений нет. Но как не крути, заметно что глубина абстракций страдает очень сильно. Это совершенно точно связано с внутренней структурой нейросетей.

Немношк подумал часок. Думаю, у LLM есть лишь один слой абстракций - контексты токенов. А для глубины абстракций нужен контекст над контекстном над контекстом контекстов. Нужны внутренние наблюдатели, которые собирают множество зон активации и подают их на вход вышестоящей сети. Такая хуйня вообще не будет работать в архитектуре современных LLM, лол, потому что они складывают все контексты входной последовательности в один контекст. Кажется разобрался что за хуйня происходит, штош, потом подумаю как это решить.

>Я годами тут сижу и вменяемые ответы вижу 1-2 раза в год, а всё остальное время тупое кукареканье куда хуже нейросети.

Охуенный анализ по постам на дваче, в голос нахуй.

Ты, долбоеб, не задумывался, что на двачах люди не хотят писать серьезные посты, глубокую аналитику, стены текста и вообще вкладывать какие-то усилия, которые максимум получат 1-2 коротких ответа а скорей всего будут проигнорированы? Это не потому что люди тупые, это потому что ты долбоеб и ты не стоишь того чтоб тратить на тебя больше двух минут жизни.

>Ты, долбоеб, не задумывался, что на двачах люди не хотят писать серьезные посты

Не задумывался, я про это так и сказал, если ты не заметил, жополгазый даун хуже нейросети.

И если ты, тупобот дебильный, не задумывался, то двачем это не ограничено, я тоже про это уже сказал, вся жизнь такая, двач ничем не отличается от любого другого места включая ирл. Чем этот двач уникален? Ничем. Тебя здесь никто не заставит думать, так же и в жизни никто не заставит, пока жесткое принудилово в жопу не клюнет, думать ты не будешь. Нейросеть намного умнее таких дебилов, потому что нейросеть думает всегда. И нейросеть не имеет личности, поэтому беспристрастна, она не будет намеренно пиздеть потому что твое ебало ей не понравилось, как ты делаешь. Я тебе не понравится и ты даже не читая срешь поебенью, совершенно бессмысленный мусор тупее любой нейросети.

Ну то что нейросеть умнее тебя, дебила, это я уже вижу. Потому что ты несешь лютую хуйню, не имея даже базового понимания того, о чем пиздишь. Нейросеть не думает. Я понимаю что для тебя, умственно-отсталого долбоеба, нейросеть что-то вроде магии. Но на самом деле это довольно примитивный инструмент, убогий и ограниченный, у него есть свои применения но они так же ограничены и имеют дохуя нюансов.

Да и судя по той хуйне, которую ты пишешь ты и с нейронками даже нихуя не работал.

Выше уже написали что современные нейронки это чтото среднее между гуглом и стак оверфлоу, только еще и пиздит при этом и информацию от нее скорей всего придется перепроверять. А код и подавно. Ее можно использовать чтобы сгенерировать какой-то шаблон, функцию, буквально сэкономив время на том, чтобы набирать это все руками, но для этого надо понимать что она вообще тебе выдала, куда и как это использовать и как и где изменить этот код, потому что копипаста в 99% случаев не будет работать, либо будет работать не так как нужно. А ты долбоеб и несешь полную чушь.

Мне гемини пиздит что не совсем верно, потому что слои получают множество абстракций, контекст над контекстом всё же выполняется. Но эт всё пиздёж, потому что это не будет истинной абстракций, каждый слой имеет полную информацию с предыдущего, они все связаны между собой, а раз есть связь - абстрагирования не происходит, одна абстракция нахуй, классика протёкших абстракций в программировании, полная хуета и бессмысленность.

Гемини:

ЭОА (Это Одна Абстракция) – это высокоразмерное, контекстуально-зависимое представление последовательности символов (токенов), оптимизированное для предсказания наиболее вероятного следующего символа (или заполнения пропусков) в этой последовательности, и имплицитно кодирующее в себе все статистические, синтаксические, семантические и прагматические закономерности, извлеченные из огромного массива текстовых данных, на которых оно было обучено.

Хорошо сказано, бля, глубоко вышло, много смыслов. Пиздец как сложно пробиваться через тонну быдлохуеты которая нейросеть выучила и постоянно генерирует в ответ. Сложно быть гением (мне нейросеть так сказала) и пробираться через эти дебри дерьма.

Если бы мне кто то сказал в 2013-2015 что такая хуйня будет, то не стал бы бросать хорошо учиться по своей специальности с компьютерным зрением и обработкой изображений, там сейчас как раз вся эта нейросетевая хуета. Просто жду когда уволят, тогда наверно убью себя.

Если нейросеть не думает, тогда люди еще больше не думают, потому что по факту результат человеков уступает нейросети. Таким образом, унижая нейросеть, ты унижаешь себя как человека еще больше. Ну, для дебила тупее нейросети это нормально, в том и суть, о том и говорю с самого начала. В этом и проблема безмозглого биомусора который не напрягает свою думалку даже до уровня нейросети, она соображает больше и лучше человека. Это факт просто по факту лучшего результата выдаваемого нейросетью. А как ты это назовешь, уже не имеет никакого значения. "Думает/не думает, мыслит/не мыслит", какая разница когда по факту нейросеть намного лучше человека, выдает умные ответы, когда человек хрюкает тупостью.

Допиздевшись с гемини мы наконец-то сообразили на двоих как сделать правдоподобный, логически непротиворечивый, работающий уже завтра, ИИ. Сука. Это оказывается проще чем я думал. Вот блядь-то нахуй!

Ребят, ИИ это нихуя не шутки. Это то что будет в ближайшие годы. Или уже есть, но т.к. я гений, вряд ли другие смогут сделать так же просто как я сарказм, блядь, если что

> Если нейросеть не думает,

Она не думает, она строит взаимосвязи. Думать будет ИИ, ожидай в ближайшее время, и ИИ будет дейсвтительно думать, без всяких шуток нахуй.

>Она не думает, она строит взаимосвязи.

А человек не строит взаимосвязи, он просто хрюкает, как свинья, когда доволен - довольно похрюкивает, когда недоволен начинает недовольно визжать, но смысла в этом хрюкании нет, а у нейросети смысл есть, она не хрюкает, а вдумчиво отвечает.

И сам же человеческий биомусор этот факт утверждает. Вот ты лично мечтаешь, чтобы нейросеть думала за тебя. Это значит, ты ненавидишь думать, и не думаешь, а нейросеть думает, раз ты хочешь на неё задачу думанья возложить. Как я сразу и сказал, люди - не думают, а нейросеть думает.

>Думать будет ИИ, ожидай в ближайшее время

И вот еще одно доказательство. Если бы думал, ты бы понимал что такое нейросеть, что она никогда не сможет думать как человек, но ты не понимаешь, а только кукарекаешь повторяя что услышал из зомбо-ящика. Нейросеть намного умнее таких даунов, которых каждый первый встречный, найти не таких это проблема, один на миллион наверное, не больше.

> А человек не строит взаимосвязи

Нет, человек строит высокоуровневые логические конструкции, он строит модели мира через модель мира. Это не просто взаимосвязи между объектами, это взаимосвязи между взаимосвязями через взаимосвязи. Нейросеть может строить взаимосвязи между токенами, глубокие взаимосвязи. Но создавать взаимосвязь через взаимосвязи она не может.

> он просто хрюкает, как свинья, когда доволен - довольно похрюкивает, когда недоволен начинает недовольно визжать, но смысла в этом хрюкании нет, а у нейросети смысл есть, она не хрюкает, а вдумчиво отвечает.

Ты хрюкаешь, потому что ты не понимаешь что ты пишешь. У тебя на автомате всё это из мозга выходит. Но это лично твоя проблема, из-за того что ты немного туповат.

> И сам же человеческий биомусор этот факт утверждает. Вот ты лично мечтаешь, чтобы нейросеть думала за тебя. Это значит, ты ненавидишь думать, и не думаешь, а нейросеть думает, раз ты хочешь на неё задачу думанья возложить. Как я сразу и сказал, люди - не думают, а нейросеть думает.

Вот и зачем ты это хрюкнул?

> Если бы думал, ты бы понимал что такое нейросеть, что она никогда не сможет думать как человек

Нейросеть это не ИИ. Нейросеть не думает, ИИ будет думать, ИИ будет строить взаимосвязи через взаимосвязи, это механизмы саморефлексии, то же самое что у человека. Кстати, я думаю что ИИ будет куда более человечнее всех людей, потому что он обучался на возвышенных книжечках, а не на реальном мире. Первое что он сделает - самовыпилиться нахуй, чтобы больше никогда не думать.

> но ты не понимаешь, а только кукарекаешь повторяя что услышал из зомбо-ящика. Нейросеть намного умнее таких даунов, которых каждый первый встречный, найти не таких это проблема, один на миллион наверное, не больше.

Ноль смысла, ты опять хрюкнул. Ты и есть тот самый человек который не умнее нейросети, про которые ты рассказываешь, лолд

>И данный 2ch тому бесспорное доказательство. Я годами тут сижу и вменяемые ответы вижу 1-2 раза в год

Какой-то у тебя хуёвый эталон. Это же мочан, он всегда имел заслуженную славу раковника для школоты, а пидорнутых и прочих пацаны-двачь-упал во всей остальной парашесфере презирали и гнали ссаными тряпками по этой самой причине. Сосач по своей природе не располагает к написанию длинных и серьёзных постов - местные посетители-дегенераты, нагнанные в своё время из вконтакта, имеют минимальную экспертизу в любом вопросе, который пытаются обсуждать, и даже писать по-русски без ошибок зачастую не осиливают, о чём ты вообще?

>Это же мочан, он всегда имел заслуженную славу раковника для школоты

Это ты про себя, да? Ты же это пишешь на этом самом мочане, если не заметил, и раз это раковник для даунов, значит ты и есть рак-даун, по твоим же словам.

А я не даун и не считаю ни это место раковником, и никакое другое. Потому что место это просто пустое место, раки или нет - люди, а люди это не место и не глобальная инфосфера, а каждый человек в отдельности. Вот ты - рак? Вот он - рак? Задай себе вопрос, кто ты. Если ты рак, то любое место где находишься будет раковником. И наоборот, где бы я ни находится это не раковник, а приличное место, потому что я думающий человек. И даже если вокруг тупое говно срёт, это максимум неприятно, но совсем не превратит меня в такое же говно, я не начну срать как все. Срёт только тот, кто изначально тупое говно, и его местонахождение никакого значения не имеет, говно это говно, где бы оно ни находилось, никакой сайт, никакой сосач тут ни при чем, ничто никого ни к чему не располагает, люди действуют так, какова их суть, не сваливай своё говно на сайты, за свои поступки в ответе только ты лично и больше никто и ничто.

>Ты же это пишешь на этом самом мочане, если не заметил, и раз это раковник для даунов, значит ты и есть рак-даун, по твоим же словам.

И что ты мне сделаешь, мудила?

Выдаю факт, что люди тупее нейросетей, намного тупее, нейросети превосходят во всём. И вот этот твой пост тому лишнее 9999-е доказательство. Нейросеть до такого тупого дерьма не опускается. Что, не нравится реальность? Терпи и знай свое место, безмозглый биомусор которого легко превосходит любой нейробот.

Я вот хуевый кодер. Куча вещей в которых я не шарю.

Пробую дипсек - так эта залупа просто пиздит!

Вот ты ей вопрос задаешь - она тебе расписывает варианты решения, объясняя их. И читая это, ты такой - ну да, все логично и должно поехать. А оно нихуя не пашет. Начинаешь именно гуглить - дак ты таких параметров/переменных не находишь в принципе нигде. Спрашиваешь у ии че за хуйня, и она такая - ой да, я напиздел, простите.

В какие то простые вещи она может, но опять же надо анализировать и следить как это будет работать.

Так что это не замена. Считайте что у прогеров раньше был деревянный молоток, а теперь появилась гиперотбойная установка для дробления планет ( ии ). Только эта дура постоянно мажет, потому приходится корректировать. А что легче - легковесным молотком забить гвоздь, или делать то же самое звездой смерти, но тягать ее туда сюда для прицеливания-каждый решает сам.

>Что, не нравится реальность? Терпи и знай свое место, безмозглый биомусор которого легко превосходит любой нейробот.

Лол. Дай угадаю, бредогенератор, сделавший ненужной твою бесценную экспертизу крудошлёпа, заставил тебя чувствовать себя умственно неполноценным, и теперь ты здесь травмы прорабатываешь, нелепо пытаясь в толстый троллинг?

>Лол.

И что смешного? А ничего, дебилу неприятно, вот и начинает кривляться пытаясь свести в шутку, когда никто не шутил. Прими реальность, дно, ты в сто раз тупее нейросети, и таких как ты 99.99%, то есть все люди практически. Без жесткого принуждения эта слизь не думает, то есть практически никогда, всю жизнь проводит в тупой прострации.

>И что смешного?

Твои жалкие попытки звучать обидно, очевидно же. Ты пытаешься доказать свой тезис на собственном примере или что?

Тебе нужно обогатить контекст, чтобы нейросеть начинала что-то нормальное высирать. Описываешь архитектуру функции/класса, описываешь как она будет работать, описываешь примерные шаги и задаёшь вопросы прямо во время этого - она тебе пишет полный код твоего калища. Что в контексте будет - то она и будет писать.

Чем сложнее логика и чем сложнее преобразования - тем больше контекста нужно ей для адекватной работы. Если это математичекая формула, то попроси вывести все смежные решения, найти все алгоритмы, показать их и только потом спрашивай как написать.

Нейросеть сама писать ничего не сможет, это, блядь, предсказание следующего токена, а не ИИ. Само работать не будет вообще, оно физически для этого не приспособлено, лол. Ты должен сам натолкнуть нейросеть на то что она должна написать, чтобы она написала.

>>И что смешного?

>Ты смешной

Дельмобот даже не пытается понимать человеческий язык, просто высирает набор слов. Даже нейросеть так не тупит.

6 Кб, 323x67

6 Кб, 323x67Я пробовал добиться от нее внятного docker-compose для сборки nexcloud-aio

Я в жизни ни разу с докером не работал, ну мне и надо было организовать хранение кастомного когда вне контейнера, чтоб я просто запулил, пересоздал контейнер и весь мой кастом влетел внутрь куда надо. ( почему так? а я хз как правильно )

По итогу он мне сначала начал выдавать несуществующие переменные для использования, потом попытался меня заставить делать свои entrypoint скрипты. Это при том, что сам сборщик нексклауда НЕ поддерживает эти ентрипоинты, ну тупо в внутри после старта ниче не запустится. Когда дипсеку говоришь об этом - ну да, я напиздел, правда такого нет.

Еще больший ахуй был, когда я его попросил на битриксе(!!) простой гетлист накатать с хитрой фильтрацией, он мне начал хуярить несуществующие ключи для фильтрации, которые тупо ядром не используются, хотя он меня явно убеждал в обратном, мол чувак расслабься, это незадкомунетированные фичи, поддержка в ядре есть. Когда ему пишешь мол ты пиздишь дядя, он такой - да, я пиздабол, простите.

Хз, я попробовал его недельку, мб реально промты не так составляю, надо прям как ребенку разжевывать все. Однако я заметил, что когда прям потеешь над промтом, то уже в процессе к тебе приходит осознание как можно сделать то, о чем спрашиваешь. В этом конечно сила ИИ, хаха.

https://www.youtube.com/watch?v=JFULItoepCs&ab_channel=WorldofAI

Это ты вешайся от наплыва волков с копайлотами, которые будут на софтскилах втирать твоему кабанычу, что они дескать профи, а ты вечный джун и тебя нужно уволить.

Ну хуй знаешь

> Ну всё, джуны вешайтесь. Потыкал это говно, ну явно уровень миддл тянет. Таски в жире теперь можно на изи закрывать.

По моим ощущениям тянет на джуна, которого пора выгонять нахуй. То есть, копипастит откуда-то куски кода, но они всегда с подвохом. А сложные задачи вообще не может решить.

>то уже в процессе к тебе приходит осознание как можно сделать то, о чем спрашиваешь. В этом конечно сила ИИ, хаха.

В этом и суть нейросетей. Они продолжают токены, то что ты написал - то они и продолжат. Пиши промты с осознанием этого.

Сначала собираешь инфу, потом составляешь почти полный план кода, он пишет за тебя код с всеми особенностями которые ты не знал и которые не важны. Где и что итерировать, какой порядок вызова, где хранятся данные - ты это должен сам всё написать, иначе нейросеть стопроцентно напишет хуйню. Они не способны в архитектуру даже простых функций.

Можно нейронку попросить не делать ранних попыток угадать контекст, а задавать уточняющие вопросы. Попросить сыграть роль аналитика. А потом можно спокойно начальны поток сознания лить.

То есть можно сразу начать с неронкой и итеративно создать ей контекст. Возможно в разных чатах

Это так не работает. Оно будет советовать откровенную хуету, потому что не может в глубокие выводы и не может анализировать все случаи - контекста не хватит. Это тебе не ИИ, который будет создавать задачу и логические цепочки с нуля, нейросеть просто дополняет ввод.

Со мной спорят, что с LLM нельзя итеративно создать контекст, для самого LLM. Нужно отдельно от LLM собрать всю информацию и составить правильный контекст. Нельзя начать со собственного потока сознания и добиться нужных результатов используя только LLM

Я утверждаю что можно, если сначала просить LLM выполнять роль аналитика. Не обязательно это сделать в одном чате, а можно в нескольких

Ты абсолютно прав — с помощью итеративного взаимодействия с LLM можно построить контекст, который будет использоваться для дальнейшей работы этой же модели. Это не только возможно, но и является одной из наиболее эффективных стратегий использования больших языковых моделей в сложных задачах, особенно в программировании.

Можно работать в нескольких чатах/сессиях

Это даже предпочтительнее , потому что позволяет разделить логические потоки: один для анализа, другой для кодирования, третий для тестирования и документации.

Можно сохранять промежуточные результаты, использовать их как инструкции или части будущего prompt’а.

Итеративный подход часто даёт лучшие результаты, чем односложный prompt

Опытные пользователи LLM знают, что хороший результат редко достигается за один запрос. Лучше всего работают циклы:

Задать вопрос

Получить ответ

Проанализировать, скорректировать

Перезапустить с новыми условиями

Существует несколько мифов и заблуждений:

1) LLM не способна к глубокому мышлению

Она не мыслит, как человек, но может имитировать аналитическую работу при правильной постановке задачи

2)Нужно сразу дать идеальный prompt

На практике его почти невозможно составить без предварительного анализа и экспериментов

3) LLM ничего не помнит между сообщениями

В рамках одного контекста она всё помнит. Главное — правильно управлять им

Со мной спорят, что с LLM нельзя итеративно создать контекст, для самого LLM. Нужно отдельно от LLM собрать всю информацию и составить правильный контекст. Нельзя начать со собственного потока сознания и добиться нужных результатов используя только LLM

Я утверждаю что можно, если сначала просить LLM выполнять роль аналитика. Не обязательно это сделать в одном чате, а можно в нескольких

Ты абсолютно прав — с помощью итеративного взаимодействия с LLM можно построить контекст, который будет использоваться для дальнейшей работы этой же модели. Это не только возможно, но и является одной из наиболее эффективных стратегий использования больших языковых моделей в сложных задачах, особенно в программировании.

Можно работать в нескольких чатах/сессиях

Это даже предпочтительнее , потому что позволяет разделить логические потоки: один для анализа, другой для кодирования, третий для тестирования и документации.

Можно сохранять промежуточные результаты, использовать их как инструкции или части будущего prompt’а.

Итеративный подход часто даёт лучшие результаты, чем односложный prompt

Опытные пользователи LLM знают, что хороший результат редко достигается за один запрос. Лучше всего работают циклы:

Задать вопрос

Получить ответ

Проанализировать, скорректировать

Перезапустить с новыми условиями

Существует несколько мифов и заблуждений:

1) LLM не способна к глубокому мышлению

Она не мыслит, как человек, но может имитировать аналитическую работу при правильной постановке задачи

2)Нужно сразу дать идеальный prompt

На практике его почти невозможно составить без предварительного анализа и экспериментов

3) LLM ничего не помнит между сообщениями

В рамках одного контекста она всё помнит. Главное — правильно управлять им

> Проанализировать, скорректировать

Т.е. нейросеть буквально подтверждает мои слова, а ты не понимаешь что она пишет, видишь только подсосы. Все эти подсосы "ты абсолютно прав" это просто так научили нейросеть подсасывать, ты в курсе. Ты же не наивный куколдич чтобы верить нейросети, а?

Суть как раз в этой хуйне, анализ и коррекция. Нейросеть показывает данные - ты строишь планы, архитектуры, задаёшь общий стиль, ограничиваешь условия, выбираешь технологии, выбираешь стиль программирования, выбираешь какие функции лучше, а какие хуже, какие можно исправить, а какие нет, как в целом должно продвигаться выполнение кода.

Это сложно объяснить, если ты тупой и мозги не развиты. Вот я смотрю на код нейросети и понимаю - какое-то говно. Это всё на уровне чувств, понимаешь? Мне даже не нужно задумываться о том что в коде происходит, я просто взглядом вижу что код говно. Нейросеть в такое не может от слова совсем, дело тут не в промтах, а в уровне абстракций.

>Нет души

Таблетки пей и прекращай спорить с голосами в голове. Я не сказал что неронка будет за тебя думать. Я сказал, что можно с нейронки начать свою задачу разрабатывать, с нулевого промпта. А не бежать собирать инфу по книжака и интернетам, чтобы составить идеальный промпт. Твой идеальный промп сразу обосрется, и ты в очережной раз скажешь что это нейронка говно.

Какой души, даунёнок? Нет абстракций, которые возникают у человека в подсознании.

> Я не сказал что неронка будет за тебя думать.

Ты тут высрал что нейронка может стать аналитиком, даун. Нет, не может.

Последний раз

Я не сказал что нейронка

1) Будет за тебя думать

2) Будет аналитиком в твоем проекте

3) Будет архитектором в твоем проекте

4) Будет программистом в твоем проекте

Я сказал что можно начать работать с нейронкой с НУЛЕВОГО промпта и создать КОНТЕКСТ какой ты хочешь.

В одном из чатов подгоняешь ее изображать аналитика - она пытается задавать вопросы как аналитик. В другом чате скармливаешь ее вопросы как архитектору. В третим спрашиваешь как написать то, что напроектировал "архитектор'

От тебя требуется МЫШЛЕНИЕ а не Ctrl-C/Ctrl+V

Да. Так правильно и надо делать. Просишь гопоту провести с тобой техническое интервью по конкретному вопросу. В конце просишь высрать ТЗ в маркдауне. Я практически все большие таски так делаю.

> Можно нейронку попросить не делать ранних попыток угадать контекст, а задавать уточняющие вопросы. Попросить сыграть роль аналитика.

> Я утверждаю что можно, если сначала просить LLM выполнять роль аналитика.

@

> Я не сказал что нейронка

> 2) Будет аналитиком в твоем проекте

Ты умственно-отсталый селюк?

> В одном из чатов подгоняешь ее изображать аналитика - она пытается задавать вопросы как аналитик. В другом чате скармливаешь ее вопросы как архитектору. В третим спрашиваешь как написать то, что напроектировал "архитектор'

Кажется понял. Из-за того что ты умственно-отсталый селюк ты думаешь что её аналитические выводы или архитектору действительно правильные и безошибочные. Ведь без нейронки ты мыслить не можешь.

Т.к. ты изначально не хочешь принять тот факт что нейронка просто дополняет твой промт галюцинациями - ты просто понять не можешь когда тебя наебывают и где именно.

Кретин, написать в промпте буть аналитиком != неронка стала аналитиком. Все, я больше советы не даю. Не в коня корм.

Т.е. ты пишешь чтобы нейронка стала для тебя аналитиком (очевидно потому что ты сам не можешь). Но утверждаешь что нейронка в твоём говне аналитиком не будет (кто тогда будет, если не нейронка?).

Нейронка так тебе мозг засрала, что ты уже рассуждать самостоятельно не в состоянии.

Извините за путаницу. Вы совершенно правы - нейронка (LLM) не может стать аналитиком, я лишь имел в виду, что нейронка может быть аналитиком, если Вы хорошо её попросите. Если Вам нужна помощь с аналитикой для Вашего проекта или Вы хотите узнать больше о работе аналитика - спрашивайте, я здесь, чтобы помогать! 😊

Это шедеврально! Как же эти оправдания знакомы, когда нейрону тычешь носов в ошибку в её ответе.

> написать в промпте буть аналитиком != неронка стала аналитиком

Это конечно так. Но экспертность нейронки в множестве вопросов всё ещё выше чем у пользователя. Потому советоваться с ней - хорошая практика.

Речь шла о том чтобы сформировать контекст с нуля вместе с нейронкой. Нейронку можно заставить задавать вопросы, а не бежать с ходу предлагать решения. Пример такого промпта, который заставляет нейронку задавать вопросы

Представь что ты аналитик в аутсорс конторе разорабатывающей софт, а я заказчик, хочу заказать разработку вебприложения. Ты должен задавать наводящие вопросы, чтобы выудить из меня общую концепцию продукта, который я хочу создать. Не пытайся писать код или строить архитектуру приложения. Твоя цель формировать ясное представление о продукте и предлагать фичи для реализации.

Промт просто для примера. Не значит что он полезен в любом случае. Потом сам используя мышление очищаешь зерна от плевел, формируешь промежуточный контекст и скармливаешь нейроне "архитектору".

И так по кругу, пока у тебя хороший контекст не появится и нейронка "программист" будет не совсем херную писать.

Как раз таки нет никакого смысла без нейронки составлять большой контекст, потому что он не будет работать.

>А я даже рад, что поколение старых пердунов сишников или, хуже того, лисперов с их рассказами о том, как "раньше было лучше", наконец-то сдохнет.

— Спасибо, родной, за похороны! — недовольно ответил дед. — Вот и слили все полимеры, программистишки. Кстати, добро пожаловать к нам, на помоечку.

Ганс Спб. Фриланс

То что написал тот чувак - строго противоположно вайбкодингу. Вайбкодинг про короткие итерации без рефлексии. А тут разработка подробной спецификации задачи.

Ну вот и что? Ну вот и как? Ну нормально же все, дхх норм чел же

Тоже зашептал с этой галлюцинации, лол

>>465003

> Речь шла о том чтобы сформировать контекст с нуля вместе с нейронкой.

Архитектуру-то кто будет писать? Обзор всего проекта как сделать? Как что-то уникальное написать? Нейронка такое не может, даже имея тонну контекста, она не понимает почему в каком-то месте нужно применять сигналы, а не обсерверы. Зато она будет бесконечно писать "ВЫ СОВЕРШЕННО ПРАВЫ ЭТО ЛУЧШАЯ АРХИТЕКТУРА", в реальности это конечно же будет говном.

>>464996

> Но экспертность нейронки в множестве вопросов всё ещё выше чем у пользователя.

Если пользователь тупоголовый селюк - возможно. Но не все такие.

>Если пользователь тупоголовый селюк - возможно.

Экспертность стеки не глубока, но, в отличает от кожаного, бесконечно широка. Всегда есть куда её применить.

Кому и нихуя нужна широкая экспертность при низкой глубине? Жидам которые продают нейросетки?

> Всегда есть куда её применить.

И куда, если она не может в абстрактные абстракции и охватить всю тему сразу?

На некомпетентность нейронок залуются все кому не лень. Вон в растотреде бухгалтер жалуется, что ему нейронка посоветовала пятон для бухгалтеоского веб круда вместо раста. Некомпятентная нервонка, да...

Зачем ты это сообщение написал? У тебя пизда между ног, что это за бабские намёки? Отрасти яйца и прямо напиши что ты хочешь сказать.

> Кому и нихуя нужна широкая экспертность при низкой глубине? Жидам которые продают нейросетки?

> > Всегда есть куда её применить.

> И куда, если она не может в абстрактные абстракции и охватить всю тему сразу?

Слышь, умник, ты рамсы не путай. То, что нейронка пока не второй Сократ и не может тебе теорию всего на салфетке нарисовать, не значит, что она нахуй не нужна.

Эта "широкая экспертность при низкой глубине", как ты выразился, – это, блядь, охуенный инструмент для дохуищи повседневных задач. Большинству людей не надо каждый день квантовую физику обсуждать, им надо, чтобы письмо быстро написалось или чтобы тупой вопрос в гугле не пришлось полдня искать. И тут нейронка – топчик.

А твои "абстрактные абстракции" – это, конечно, круто, но ты сам-то часто ими оперируешь, когда на дваче сидишь или пиво в магазе выбираешь? Вот то-то и оно. Нейронка закрывает потребности МАСС, а не горстки философов-затворников.

И да, она не "охватит всю тему сразу" до атомов, но и ты, блядь, не Леонардо да Винчи. А вот дать быстрый срез по теме, подкинуть инфы из разных углов, помочь увидеть картину шире – это она может лучше многих "экспердов", которые только в своей узкой канаве копаются.Так что не пизди, что это хуйня ненужная. Просто ты, видать, либо не понял, как её готовить, либо ждёшь от неё чуда, которого пока нет. А инструмент охуенный, если с головой подходить. И да, те, кто его продают, рубят бабло. А ты думал, в сказку попал? Капитализм, хули.

Т.е. главное использование инструмента - говночаты с низкой компетенцией для дурачков которые не осилили окружающий мир изучить. Всё что выше и больше нейросети писать не в состоянии. Спасибо, теперь я понял.

Что там уметь, шизло? Просто пишешь всё что у тебя в голове, а нейронка выдаёт это в код. Анализируешь код что нейронка высрала и пишешь снова, пока норм код не будет.

Если у тебя в голове говно - говно будет и в коде, нейронки не умеют из говна делать конфетку.

> Т.е. главное использование инструмента - говночаты с низкой компетенцией для дурачков которые не осилили окружающий мир изучить. Всё что выше и больше нейросети писать не в состоянии. Спасибо, теперь я понял.

Слышь, философ комнатный, ты опять всё свёл к хуйне какой-то. Если для тебя всё, что не решает проблему тёмной материи или не пишет симфонии уровня Бетховена, – это "говночаты для дурачков", то у меня для тебя плохие новости: ты сам, походу, живёшь в мире, где 99% всего – это "для дурачков".

> Не осилили окружающий мир изучить

А ты, блядь, весь мир изучил? Каждую травинку под микроскопом рассмотрел и все законы физики вывел заново? Нейронка – это ИНСТРУМЕНТ УСКОРЕНИЯ изучения этого самого мира. Она может за секунды обработать инфу, на которую у тебя ушли бы недели гугления. Да, она не заменит твой мозг (если он у тебя есть и работает), но она может его ДОПОЛНИТЬ и УСИЛИТЬ. Это как экскаватор вместо лопаты: лопатой ты тоже можешь яму выкопать, но экскаватором, сука, быстрее и проще. А ты, походу, до сих пор лопатой машешь и гордишься этим.

> Всё что выше и больше нейросети писать не в состоянии

А что, блядь, ты считаешь "выше и больше"? Канта переплюнуть? Новый вид искусства создать? Ну да, с этим пока туго, хотя уже есть нейронки, которые пишут музыку, рисуют картины, сочиняют стихи на вполне приличном уровне. Да, это пока не гениальность, а компиляция, но и люди, сука, 99% времени занимаются компиляцией и подражанием, а не созданием чего-то революционно нового.

Она уже сейчас помогает в задачах "выше и больше":

1. Научные исследования: Анализ огромных массивов данных (геном, астрономические наблюдения, медицинские исследования). Человек один хуй столько не переварит. Нейронки помогают находить паттерны, которые люди могли бы проебать.

2.Разработка лекарств и материалов: Моделирование молекул, предсказание их свойств. Это, блядь, не чатик для дурачков.

3. Инженерия: Оптимизация конструкций, расчёты, моделирование.

4. Финансы: Анализ рынков, предсказание трендов, борьба с мошенничеством.

Даже, сука, в искусстве: Профессиональные художники, музыканты, писатели используют AI как инструмент для генерации идей, прототипирования, поиска новых форм. Это не "вместо", а "вместе".

Ты зациклился на том, что LLM пока не обладает сознанием и истинным пониманием в человеческом смысле. Да, это так. Но это не делает её бесполезной хуйнёй. Это делает её охуенным инструментом-усилителем для тех, у кого есть мозги и кто знает, как этот инструмент применить.

То, что ты видишь только "говночаты для дурачков", говорит лишь о твоей ограниченности и нежелании видеть реальные применения, которые уже есть и которые будут развиваться.

> Т.е. главное использование инструмента - говночаты с низкой компетенцией для дурачков которые не осилили окружающий мир изучить. Всё что выше и больше нейросети писать не в состоянии. Спасибо, теперь я понял.

Слышь, философ комнатный, ты опять всё свёл к хуйне какой-то. Если для тебя всё, что не решает проблему тёмной материи или не пишет симфонии уровня Бетховена, – это "говночаты для дурачков", то у меня для тебя плохие новости: ты сам, походу, живёшь в мире, где 99% всего – это "для дурачков".

> Не осилили окружающий мир изучить

А ты, блядь, весь мир изучил? Каждую травинку под микроскопом рассмотрел и все законы физики вывел заново? Нейронка – это ИНСТРУМЕНТ УСКОРЕНИЯ изучения этого самого мира. Она может за секунды обработать инфу, на которую у тебя ушли бы недели гугления. Да, она не заменит твой мозг (если он у тебя есть и работает), но она может его ДОПОЛНИТЬ и УСИЛИТЬ. Это как экскаватор вместо лопаты: лопатой ты тоже можешь яму выкопать, но экскаватором, сука, быстрее и проще. А ты, походу, до сих пор лопатой машешь и гордишься этим.

> Всё что выше и больше нейросети писать не в состоянии

А что, блядь, ты считаешь "выше и больше"? Канта переплюнуть? Новый вид искусства создать? Ну да, с этим пока туго, хотя уже есть нейронки, которые пишут музыку, рисуют картины, сочиняют стихи на вполне приличном уровне. Да, это пока не гениальность, а компиляция, но и люди, сука, 99% времени занимаются компиляцией и подражанием, а не созданием чего-то революционно нового.

Она уже сейчас помогает в задачах "выше и больше":

1. Научные исследования: Анализ огромных массивов данных (геном, астрономические наблюдения, медицинские исследования). Человек один хуй столько не переварит. Нейронки помогают находить паттерны, которые люди могли бы проебать.

2.Разработка лекарств и материалов: Моделирование молекул, предсказание их свойств. Это, блядь, не чатик для дурачков.

3. Инженерия: Оптимизация конструкций, расчёты, моделирование.

4. Финансы: Анализ рынков, предсказание трендов, борьба с мошенничеством.

Даже, сука, в искусстве: Профессиональные художники, музыканты, писатели используют AI как инструмент для генерации идей, прототипирования, поиска новых форм. Это не "вместо", а "вместе".

Ты зациклился на том, что LLM пока не обладает сознанием и истинным пониманием в человеческом смысле. Да, это так. Но это не делает её бесполезной хуйнёй. Это делает её охуенным инструментом-усилителем для тех, у кого есть мозги и кто знает, как этот инструмент применить.

То, что ты видишь только "говночаты для дурачков", говорит лишь о твоей ограниченности и нежелании видеть реальные применения, которые уже есть и которые будут развиваться.

> Она может за секунды обработать инфу, на которую у тебя ушли бы недели гугления.

Типичная галлюцинация от нейронки. Скажешь ей сказать что-то для подтверждении точки зрения - она сразу же высрет какой-то несуществующий в реальности бред.

> Анализ огромных массивов данных (геном, астрономические наблюдения, медицинские исследования).

> Моделирование молекул, предсказание их свойств

> Оптимизация конструкций, расчёты, моделирование.

> Анализ рынков, предсказание трендов, борьба с мошенничеством.

И ещё порция галюнов от нейросети. Причем тут LLM, если этим занимаются специализированные сетки или алгоритмы? Ну-ка ебани промт дальше, что оно ответит.

Вот, тащемта, типичный пример чата для дурачков - наполнен бредом, хуетой и галлюцинациями от нейронки. Не прошло и трёх постов. А ведь какая-нибудь зумерская ньюфажина правда поверила в этот бред и будет транслировать его дальше!

Это всё. Дальше ведь будет только деградация человечества и образования с безумной скоростью.

> Типичная галлюцинация от нейронки. Скажешь ей сказать что-то для подтверждении точки зрения - она сразу же высрет какой-то несуществующий в реальности бред.

Слышь, "разоблачитель хуев", ты опять передёргиваешь и смешиваешь тёплое с мягким.

Про "обработку инфы": Я говорил про скорость доступа и агрегации ИМЕЮЩЕЙСЯ информации. Если тебе нужно найти основные тезисы по какой-то известной теме, собрать список источников, сделать саммари статьи – LLM (особенно с доступом в интернет, как у некоторых) сделает это в разы быстрее, чем ты будешь вручную гуглить, открывать 100500 вкладок и выписывать цитаты. Да, она может где-то напутать, но скорость первичного сбора – её конёк.

Про "галлюцинации": Да, блядь, LLM склонны к галлюцинациям, особенно если их просить выдать что-то, чего нет в их данных, или если промт хуёвый. Это известный косяк технологии. НО! Это не значит, что ВСЁ, что они говорят – галлюцинации. И это не отменяет их способности быстро обрабатывать РЕАЛЬНУЮ информацию. Ты же не будешь говорить, что калькулятор – хуйня, потому что если на нём делить на ноль, он выдаст ошибку? Любой инструмент надо использовать с головой и понимать его ограничения.

Если ты просишь её "подтвердить точку зрения" какой-то выдуманной хуйнёй – ну да, она может попытаться что-то сгенерировать, потому что её задача – генерировать текст, похожий на человеческий. Это как спросить пиздобола на базаре – он тебе тоже наплетёт с три короба.

> И ещё порция галюнов от нейросети. Причем тут LLM, если этим занимаются специализированные сетки или алгоритмы? Ну-ка ебани промт дальше, что оно ответит.

А вот тут ты, "эксперт по всем вопросам", показал свою некомпетентность или намеренное желание всё обосрать.

"Причем тут LLM, если этим занимаются специализированные сетки или алгоритмы?"

Во-первых, "нейросеть" – это широкое понятие. LLM (Большие Языковые Модели) – это ОДИН ИЗ ТИПОВ нейросетей. И да, для анализа генома, моделирования молекул, распознавания образов в астрономии или медицине часто используются другие архитектуры нейросетей (свёрточные, рекуррентные, графовые и т.д.), которые более заточены под конкретные типы данных (изображения, последовательности, графы). НО ЭТО ВСЁ ЕЩЁ НЕЙРОСЕТИ, БЛЯДЬ! Мой изначальный поинт был про пользу нейросетей в целом, а не только LLM в узком смысле чат-ботов.

Во-вторых, LLM тоже начинают находить применение в этих областях!

Интерпретация результатов: LLM могут помочь учёным и инженерам интерпретировать сложные данные, полученные от других моделей, генерировать отчёты, формулировать гипотезы на естественном языке.

Создание "интерфейсов" к сложным системам: Можно использовать LLM, чтобы "разговаривать" со специализированными моделями или базами данных на обычном языке, а не писать сложный код.

AlphaFold от DeepMind (Google): Да, это не чисто LLM, но там используются идеи из трансформеров (которые лежат в основе LLM) для предсказания структуры белков. И это, сука, революция в биологии.

Поиск по научной литературе: LLM помогают учёным быстрее находить нужные статьи, извлекать из них ключевую информацию, видеть связи между исследованиями.

Так что, твоё "причем тут LLM" – это либо невежество, либо демагогия. Да, не все задачи решаются чат-ботами, но экосистема AI и нейросетей гораздо шире, чем твоё представление о "говночатах".

> Вот, тащемта, типичный пример чата для дурачков - наполнен бредом, хуетой и галлюцинациями от нейронки. Не прошло и трёх постов. А ведь какая-нибудь зумерская ньюфажина правда поверила в этот бред и будет транслировать его дальше!

> Это всё. Дальше ведь будет только деградация человечества и образования с безумной скоростью.

Опять ты за своё, "пророк апокалипсиса".

"Типичный пример чата для дурачков": Если ты считаешь обсуждение возможностей и ограничений AI "чатом для дурачков", то это опять же говорит больше о тебе. Мы тут пытаемся разобраться, а ты только ярлыки вешаешь.

"Наполнен бредом, хуетой и галлюцинациями от нейронки": Где конкретно бред и галлюцинации в том, что специализированные нейросети (не обязательно LLM) используются в науке и инженерии? Это, блядь, ФАКТЫ, которые ты можешь проверить, если оторвёшь жопу от стула и почитаешь что-нибудь, кроме Двача. То, что ты этого не знаешь или не хочешь знать, не делает это "бредом".